MOFA Video: Motion Field Adaptation Technologie konvertiert Standbilder in Video

Allgemeine Einführung

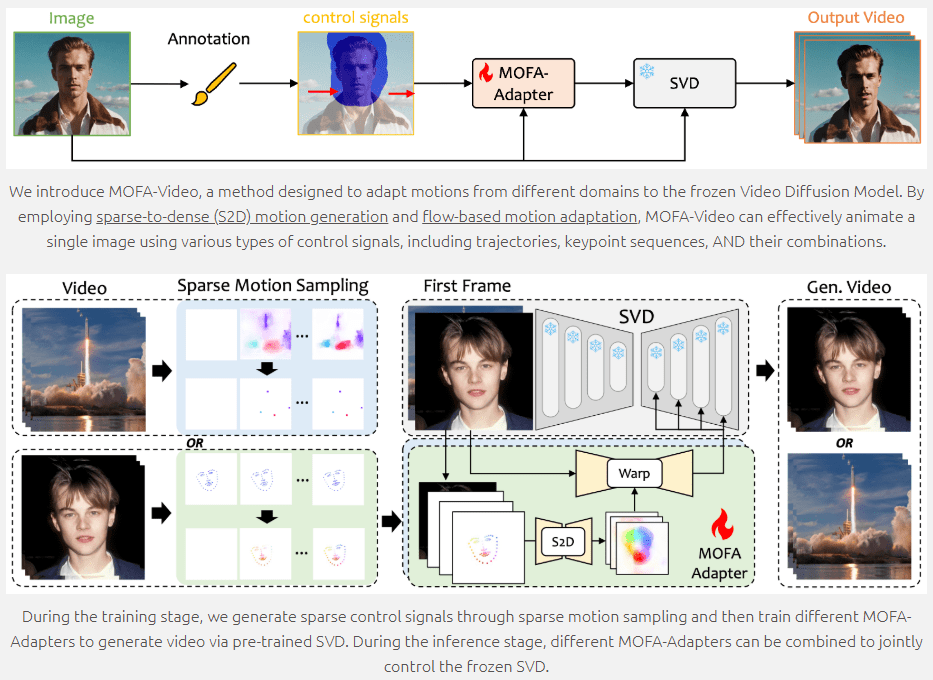

MOFA-Video ist ein hochmodernes Werkzeug zur Erzeugung von Bildanimationen, das generative Techniken zur Anpassung von Bewegungsfeldern verwendet, um statische Bilder in dynamische Videos umzuwandeln. MOFA-Video, das in Zusammenarbeit mit der Universität Tokio und dem Tencent AI Lab entwickelt wurde und auf der ECCV 2024 vorgestellt werden soll, unterstützt eine Vielzahl von Steuersignalen, darunter Trajektorien, Keypoint-Sequenzen und Kombinationen davon, und ermöglicht so eine hochwertige Bildanimation. Benutzer können über das GitHub-Repository auf den Code und die zugehörigen Ressourcen zugreifen, um einfach loszulegen.

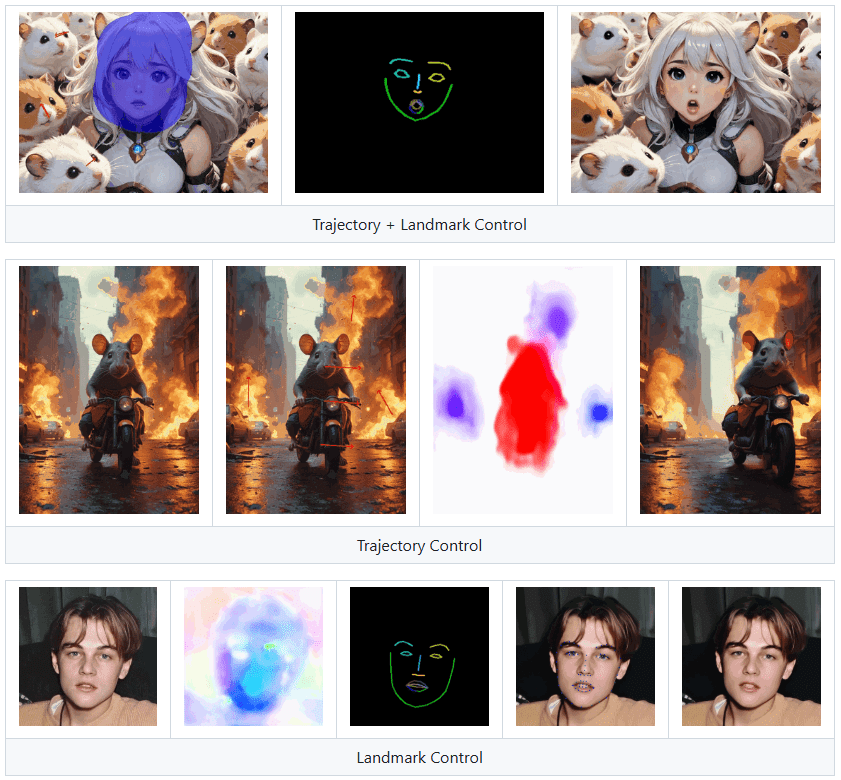

Landmark Control kann Personen auf Bildern zum Sprechen bringen, eignet sich aber nicht für den Einsatz als Klon einer digitalen Person.

Funktionsliste

- Image Animation Generation: Konvertiert Standbilder in bewegte Videos

- Mehrere Steuersignale: unterstützt Bahnkurven, Schlüsselpunktsequenzen und Kombinationen davon

- Bewegungsfeldanpassung: Animation durch spärliche bis dichte Bewegungserzeugung und flussbasierte Bewegungsanpassung

- Skripte für Training und Inferenz: Bereitstellung des vollständigen Codes für Training und Inferenz

- Gradio-Demos: Online-Demos und Checkpoint-Downloads

- Open Source: Code und Ressourcen auf GitHub öffentlich zugänglich machen

Hilfe verwenden

Umgebungseinstellungen

- Klon-Lager

git clone https://github.com/MyNiuuu/MOFA-Video.git

cd ./MOFA-Video

- Erstellen und Aktivieren einer Conda-Umgebung

conda create -n mofa python==3.10

conda activate mofa

- Installation von Abhängigkeiten

pip install -r requirements.txt

pip install opencv-python-headless

pip install "git+https://github.com/facebookresearch/pytorch3d.git"

- Checkpoints herunterladen Laden Sie Checkpoints aus dem HuggingFace-Repository herunter und platzieren Sie sie im Verzeichnis

./MOFA-Video-Hybrid/models/cmp/experiments/semiauto_annot/resnet50_vip+mpii_liteflow/checkpointsKatalog.

Demo mit Gradio

- Audio zur Steuerung von Gesichtsanimationen verwenden

cd ./MOFA-Video-Hybrid

python run_gradio_audio_driven.py

- Fahrende Gesichtsanimation mit Referenzvideo

cd ./MOFA-Video-Hybrid

python run_gradio_video_driven.py

Auf der Gradio-Oberfläche werden die entsprechenden Anweisungen angezeigt. Bitte folgen Sie den Anweisungen auf der Oberfläche, um den Argumentationsvorgang durchzuführen.

Ausbildung und Argumentation

MOFA-Video bietet vollständige Trainings- und Inferenzskripte, die nach Bedarf angepasst werden können. Detaillierte Anweisungen finden Sie in der README-Datei im GitHub-Repository.

Hauptfunktionen

- Generierung von Bildanimationen: Laden Sie ein statisches Bild hoch, wählen Sie die Steuersignale (Trajektorie, Schlüsselpunktsequenz oder eine Kombination daraus) und klicken Sie auf die Schaltfläche Generieren, um ein dynamisches Video zu erzeugen.

- Mehrere Steuersignale: Benutzer können verschiedene Kombinationen von Steuersignalen wählen, um reichhaltigere Animationseffekte zu erzielen.

- Bewegungsfeldanpassung: Gewährleisten Sie sanfte und natürliche Animationseffekte durch spärliche bis dichte Bewegungserzeugung und fließende Bewegungsanpassungstechniken.

MOFA-Video bietet reichhaltige Funktionen und detaillierte Anleitungen für die Erstellung von Bildanimationen und die Anpassung des Trainings an die eigenen Bedürfnisse. So lassen sich auf einfache Weise hochwertige Bildanimationseffekte erzielen.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...