Mochi 1 Videogenerierungsmodell: SOTA in Open-Source-Videogenerierungsmodellen

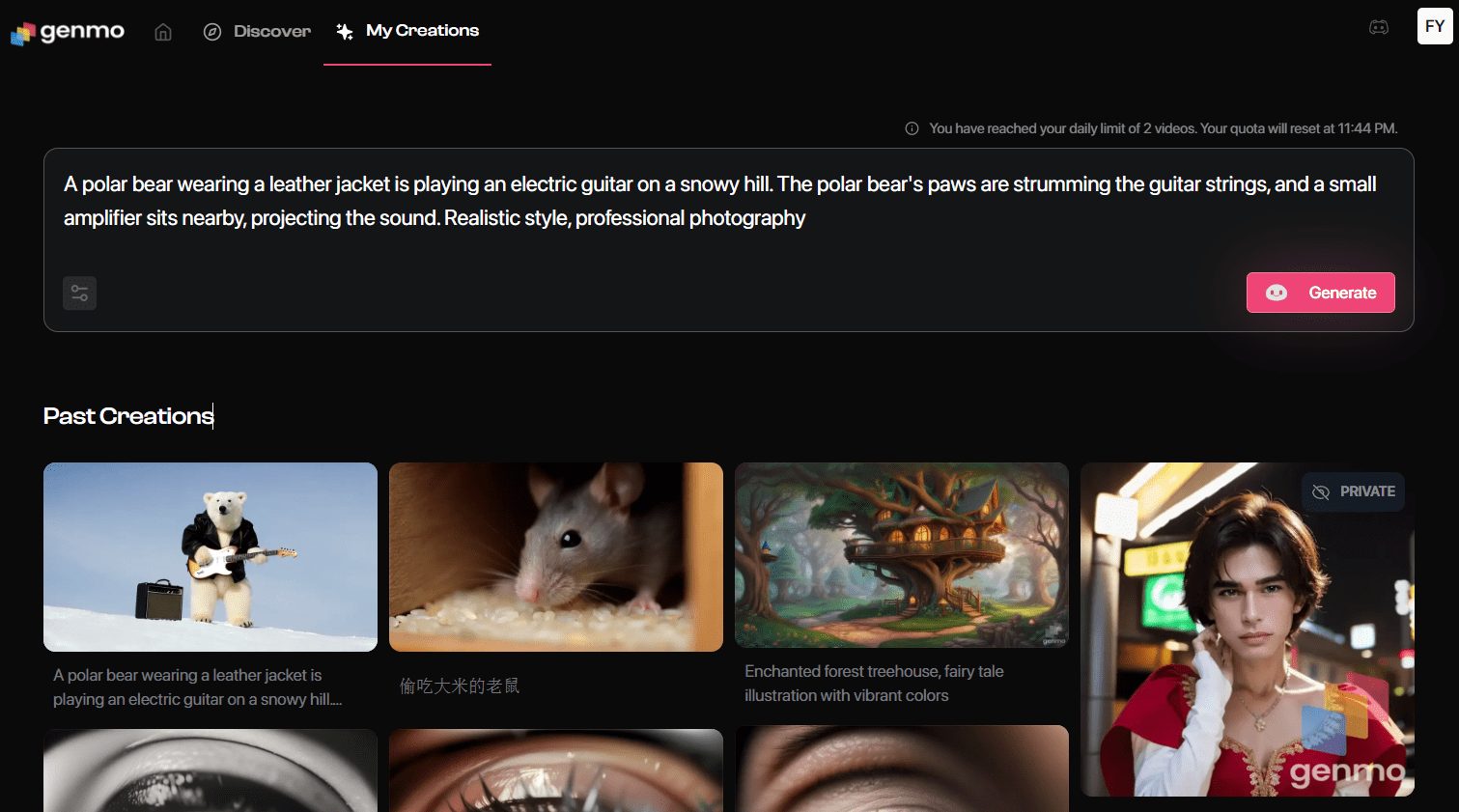

Genmo AI ist ein hochmodernes Labor für künstliche Intelligenz, das sich der Entwicklung modernster Open-Source-Modelle zur Videogenerierung widmet. Das Flaggschiff, Mochi 1, ist ein Open-Source-Videogenerierungsmodell, das in der Lage ist, qualitativ hochwertige Videos aus textuellen Hinweisen zu generieren.Genmos Ziel ist es, die Innovation im Bereich der künstlichen Intelligenz durch Videogenerierungstechnologie voranzutreiben und unbegrenzte Möglichkeiten für die virtuelle Erforschung und Erstellung zu bieten.

Models ist eine Open-Source-Bibliothek von Modellen zur Videogenerierung, die die neuesten Mochi 1-Modelle enthält. Mochi 1 basiert auf Asymmetric Diffusion. Transformator (AsymmDiT)-Architektur ist mit 1 Milliarde Parametern das größte öffentlich veröffentlichte Modell zur Videogenerierung. Das Modell ist in der Lage, qualitativ hochwertige, flüssige Action-Videos zu erzeugen, die auf textliche Hinweise reagieren.

Mochi 1 Preview ist ein offenes, fortschrittliches Videogenerierungsmodell mit hoher Bewegungskompatibilität und starker Cue-Verfolgung. Unser neues Modell schließt die Lücke zwischen geschlossenen und offenen Videogenerierungssystemen. Wir werden das Modell unter einer liberalen Apache 2.0-Lizenz freigeben.

Mochi 1 Vorschau Adresse

Gesicht umarmen (Modellgewichte)

[bilibili]https://www.bilibili.com/video/BV1FRy6YeEui/[/bilibili]

Funktionsliste

- Generation VideoGenerieren Sie hochwertige Videoinhalte, indem Sie Textanweisungen eingeben.

- Open-Source-ModellMochi 1 ist als Open-Source-Modell verfügbar und kann vom Nutzer individuell angepasst und weiterentwickelt werden.

- Originalgetreue BewegungsqualitätErzeugen von Videos mit flüssigen Bewegungen und originalgetreuer Physik.

- Leistungsstarke Queue-AusrichtungDie Fähigkeit, Videos zu generieren, die genau auf die Bedürfnisse des Nutzers zugeschnitten sind, basierend auf Texteingaben.

- Unterstützung der GemeinschaftBieten Sie eine Community-Plattform an, auf der die Nutzer die erstellten Videoinhalte teilen und diskutieren können.

- Unterstützung mehrerer PlattformenUnterstützung für die Verwendung auf mehreren Plattformen, einschließlich des Internets und mobiler Geräte.

Architektur des Modells Mochi 1

Mochi 1 ist ein bedeutender Fortschritt in der Open-Source-Videogenerierung mit einem Diffusionsmodell mit 10 Milliarden Parametern, das auf unserer neuartigen Asymmetric Diffusion Transformer (AsymmDiT)-Architektur basiert. Es wurde von Grund auf neu trainiert und ist das größte Videogenerierungsmodell, das jemals veröffentlicht wurde. Am wichtigsten ist jedoch, dass es sich um eine einfache und hackbare Architektur handelt.

Die Effizienz ist entscheidend dafür, dass die Gemeinschaft unsere Modelle ausführen kann. Zusätzlich zu Mochi haben wir auch unsere Video-VAE offengelegt, die Videos auf eine 128-fache Größe komprimiert und dabei 8x8 Raum und 6x Zeitkompression auf 12 Kanäle potenziellen Raum verwendet.

AsymmDiT verarbeitet Benutzerhinweise und komprimierte Videomarker effizient, indem es die Textverarbeitung vereinfacht und die Kapazität des neuronalen Netzes auf visuelle Schlussfolgerungen konzentriert. AsymmDiT verwendet einen multimodalen Mechanismus der Selbstaufmerksamkeit, um sich gemeinsam auf Text und visuelle Marker zu konzentrieren, und lernt für jede Modalität eine eigene MLP-Schicht, ähnlich wie Stable Diffusion.3 Aufgrund der großen verborgenen Dimensionen hat unser fast viermal so viele Parameter für den visuellen Strom wie für den Textstrom. Um die Modalitäten im Selbstaufmerksamkeitsmechanismus zu vereinheitlichen, verwenden wir eine asymmetrische QKV- und Ausgabeprojektionsschicht. Dieses asymmetrische Design reduziert die Anforderungen an den Inferenzspeicher.

Viele moderne Propagationsmodelle verwenden mehrere vortrainierte Sprachmodelle, um Benutzeraufforderungen darzustellen. Im Gegensatz dazu kodiert Mochi 1 Hinweise mit nur einem einzigen T5-XXL-Sprachmodell.

Mochi 1 nutzt einen vollständigen 3D-Aufmerksamkeitsmechanismus, um gemeinsam über ein Kontextfenster von 44.520 Videomarkern nachzudenken. Um jeden Marker zu lokalisieren, erweitern wir die lernbare Rotationspositionseinbettung (RoPE) auf drei Dimensionen. Das Netzwerk lernt eine Mischung aus räumlichen und zeitlichen Achsenfrequenzen von Ende zu Ende.

Mochi profitiert von einigen der neuesten Verbesserungen im Bereich der Sprachmodellerweiterungen, einschließlich der SwiGLU-Vorwärtsschicht, der Abfrageschlüssel-Normalisierung zur Verbesserung der Stabilität und der Mezzanin-Normalisierung zur Kontrolle der internen Aktivierung.

Ein technischer Bericht wird folgen, der weitere Einzelheiten enthält, um Fortschritte bei der Videoerstellung zu erleichtern.

Mochi 1 Installationsprozess

- Klon-Lager ::

git clone https://github.com/genmoai/models

cd models

- Installation von Abhängigkeiten ::

pip install uv

uv venv .venv

source .venv/bin/activate

uv pip install -e .

- Download Modellgewichte Laden Sie die Datei mit den Gewichten von Hugging Face oder über einen Magnet-Link herunter und speichern Sie sie in einem lokalen Ordner.

Verwendungsprozess

- Starten der Benutzeroberfläche ::

python3 -m mochi_preview.gradio_ui --model_dir "<path_to_downloaded_directory>"

Austauschbarkeit<path_to_downloaded_directory>ist das Verzeichnis, in dem sich die Modellgewichte befinden.

- Videoerzeugung über die Befehlszeile ::

python3 -m mochi_preview.infer --prompt "A hand with delicate fingers picks up a bright yellow lemon from a wooden bowl filled with lemons and sprigs of mint against a peach-colored background. The hand gently tosses the lemon up and catches it, showcasing its smooth texture. A beige string bag sits beside the bowl, adding a rustic touch to the scene. Additional lemons, one halved, are scattered around the base of the bowl. The even lighting enhances the vibrant colors and creates a fresh, inviting atmosphere." --seed 1710977262 --cfg_scale 4.5 --model_dir "<path_to_downloaded_directory>"

Austauschbarkeit<path_to_downloaded_directory>ist das Verzeichnis, in dem sich die Modellgewichte befinden.

Mochi 1 online erleben

- Gehen Sie zur Seite GenerationNach dem Einloggen klicken Sie auf "Playground", um die Seite zur Videoerstellung aufzurufen.

- EingabeaufforderungBeschreibung: Geben Sie die Beschreibung des Videos, das Sie erstellen möchten, in das Eingabefeld ein. Zum Beispiel: "Ein Filmtrailer für die Abenteuer eines 30-jährigen Astronauten mit einem roten Motorradhelm aus Wolle".

- Auswahl der EinstellungenWählen Sie den Videostil, die Auflösung und andere Einstellungen nach Bedarf.

- Video generierenKlicken Sie auf die Schaltfläche "Generieren", und das System wird das Video nach Ihren Vorgaben erstellen.

- Herunterladen & TeilenSobald das Video erstellt ist, kann es in der Vorschau angezeigt und lokal heruntergeladen oder direkt auf sozialen Medienplattformen geteilt werden.

Erweiterte Funktionen

- Kundenspezifische ModelleBenutzer können die Modellgewichte für Mochi 1 herunterladen und sie zur Personalisierung lokal trainieren und einstellen.

- Interaktion mit der Gemeinschaft: Treten Sie der Discord-Community von Genmo bei, um Erfahrungen auszutauschen und erstellte Videos mit anderen Benutzern zu teilen.

- API-SchnittstelleEntwickler können die von Genmo bereitgestellte API-Schnittstelle nutzen, um Funktionen zur Videoerstellung in ihre Anwendungen zu integrieren.

allgemeine Probleme

- Fehler bei der VideogenerierungAchten Sie darauf, dass die eingegebenen Aufforderungen klar und spezifisch sind, und vermeiden Sie vage oder komplexe Beschreibungen.

- Login-ProblemeFalls Sie sich nicht einloggen können, überprüfen Sie bitte Ihre Internetverbindung oder verwenden Sie einen anderen Browser.

- Modell DownloadBesuchen Sie die GitHub-Seite von Genmo, um die neuesten Mochi 1-Modellgewichte herunterzuladen.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...