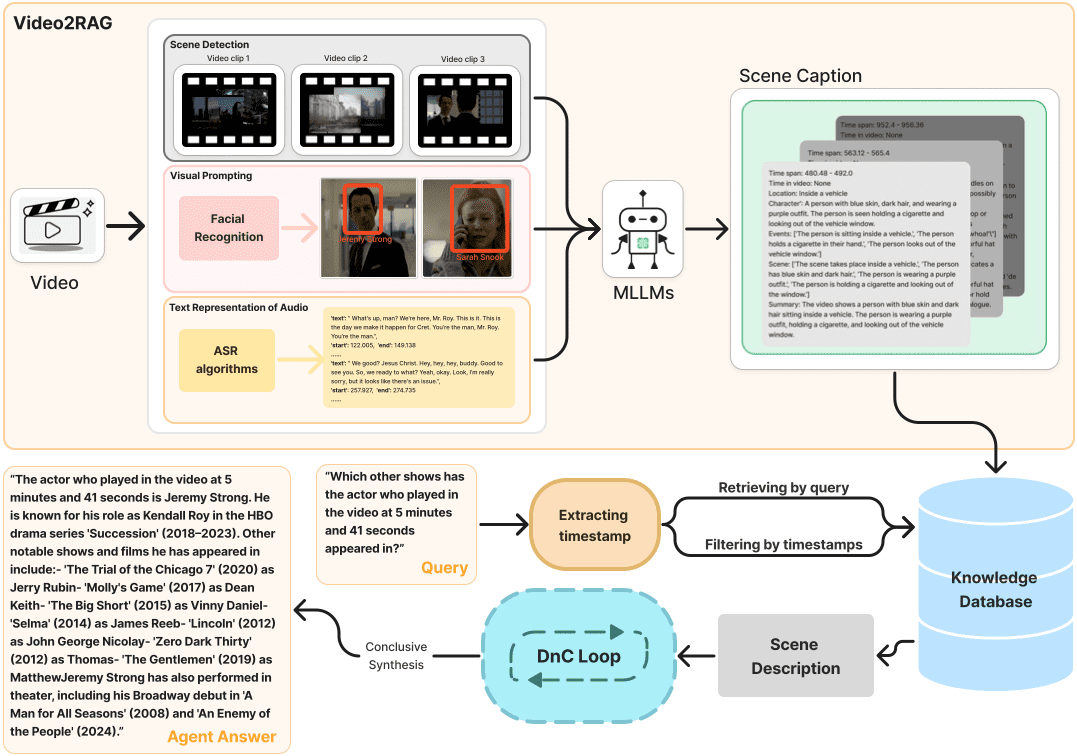

综合介绍

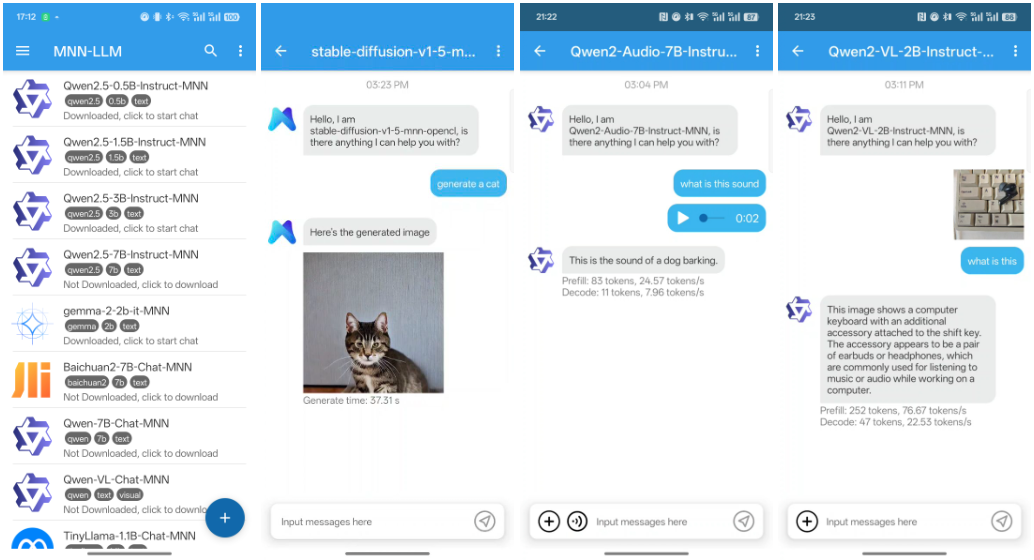

MNN(Mobile Neural Network)是阿里巴巴开发的一个高效、轻量级的深度学习框架,专为移动端设备优化。MNN不仅能够在移动设备上进行快速推理,还支持多模态任务,包括文本生成、图像生成和音频处理等。MNN已经被集成到阿里巴巴的多个应用中,如淘宝、天猫、优酷、钉钉和闲鱼等,覆盖了诸如直播、短视频捕捉、搜索推荐和产品图像搜索等超过70种使用场景。

功能列表

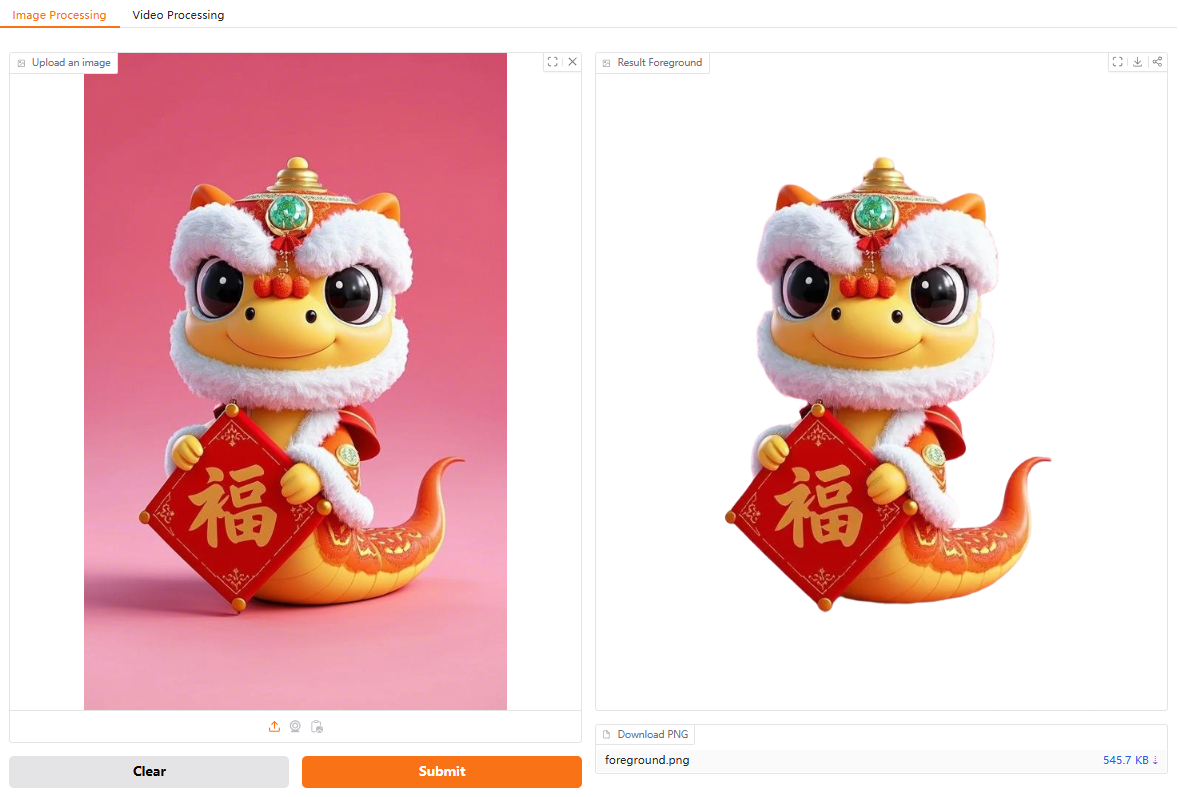

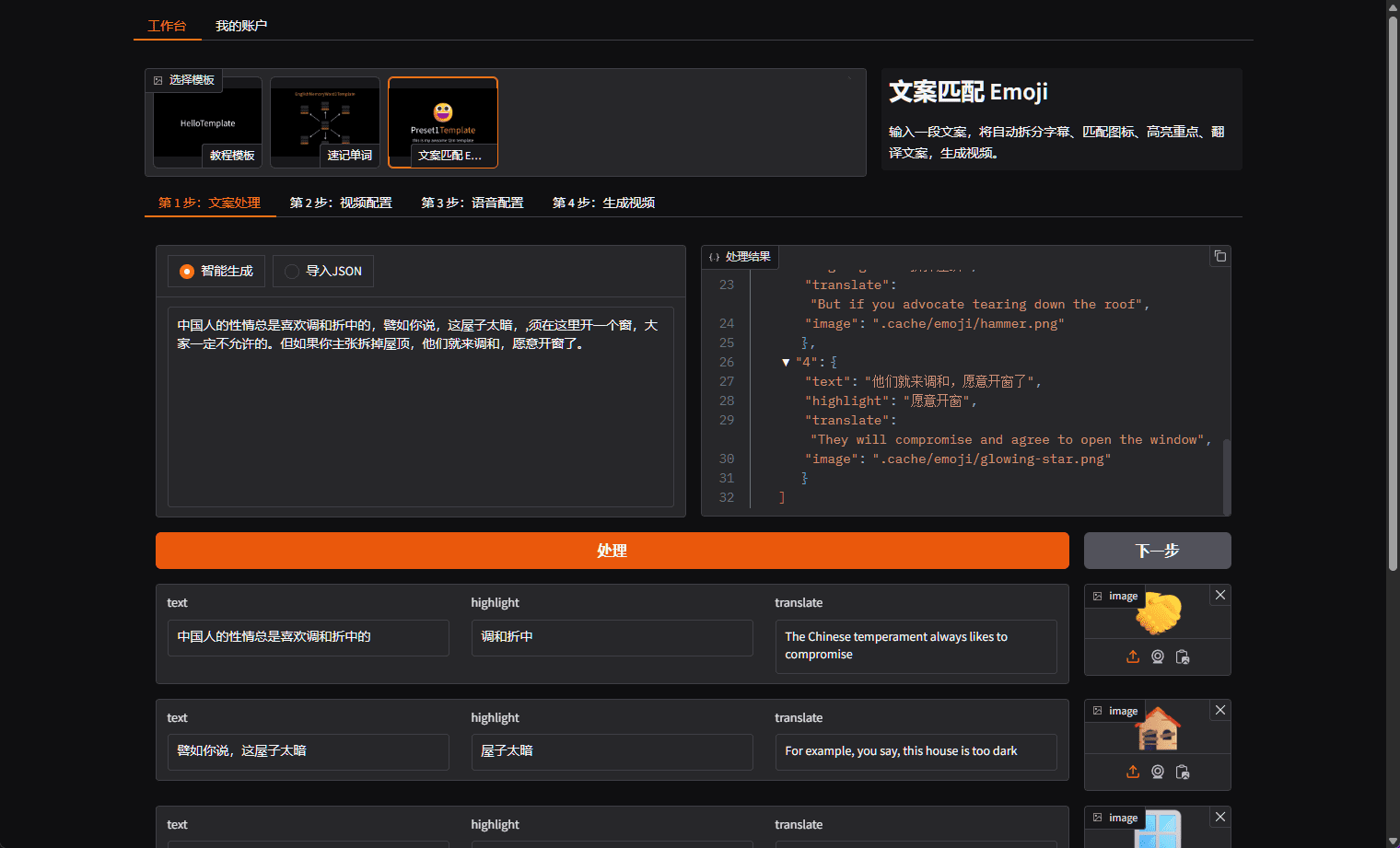

- 多模态支持:支持文本生成、图像生成、音频处理等多种任务。

- CPU推理优化:在移动设备上实现了出色的CPU推理性能。

- 轻量级框架:框架设计轻量,适合移动设备的资源限制。

- 广泛应用:被集成到阿里巴巴的多个应用中,覆盖多种业务场景。

- 开源代码:提供完整的开源代码和文档,易于集成和二次开发。

使用帮助

安装流程

- 下载与安装:从GitHub仓库克隆项目代码。

git clone https://github.com/alibaba/MNN.git cd MNN

2. **编译项目**:根据项目提供的README文档,配置编译环境并编译项目。

```bash

mkdir build

cd build

cmake ..

make -j4

- 集成到Android应用:将编译生成的库文件集成到Android项目中,修改

build.gradle文件进行配置。

使用方法

多模态功能

MNN支持多种多模态任务,包括文本生成、图像生成和音频处理。以下是如何使用这些功能的示例:

- 文本生成:利用预训练的语言模型进行文本生成。

import MNN interpreter = MNN.Interpreter("text_model.mnn") session = interpreter.createSession() input_tensor = interpreter.getSessionInput(session) # 输入文本进行预处理 input_data = preprocess_text("输入文本") input_tensor.copyFrom(input_data) interpreter.runSession(session) output_tensor = interpreter.getSessionOutput(session) output_data = output_tensor.copyToHostTensor() result = postprocess_text(output_data) print(result) - 图像生成:使用预训练的生成模型进行图像生成。

import MNN interpreter = MNN.Interpreter("image_model.mnn") session = interpreter.createSession() input_tensor = interpreter.getSessionInput(session) # 输入数据进行预处理 input_data = preprocess_image("输入图像") input_tensor.copyFrom(input_data) interpreter.runSession(session) output_tensor = interpreter.getSessionOutput(session) output_data = output_tensor.copyToHostTensor() result = postprocess_image(output_data) print(result) - 音频处理:使用预训练的音频模型进行音频生成或处理。

import MNN interpreter = MNN.Interpreter("audio_model.mnn") session = interpreter.createSession() input_tensor = interpreter.getSessionInput(session) # 输入音频数据进行预处理 input_data = preprocess_audio("输入音频") input_tensor.copyFrom(input_data) interpreter.runSession(session) output_tensor = interpreter.getSessionOutput(session) output_data = output_tensor.copyToHostTensor() result = postprocess_audio(output_data) print(result)

详细操作流程

- 创建推理实例:初始化MNN模型并创建推理会话。

import MNN interpreter = MNN.Interpreter("model.mnn") session = interpreter.createSession() - 输入数据预处理:根据模型类型,对输入数据进行预处理。

input_tensor = interpreter.getSessionInput(session) input_data = preprocess_data("输入数据") input_tensor.copyFrom(input_data) - 执行推理:运行会话进行推理。

interpreter.runSession(session) - 输出数据后处理:获取输出结果并进行后处理。

output_tensor = interpreter.getSessionOutput(session) output_data = output_tensor.copyToHostTensor() result = postprocess_data(output_data) print(result)

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...