Mistral veröffentlicht Open Source Mistral Small 3: Leistung konkurriert mit GPT-4o und übertrifft Llama 3

Mistral Klein 3: Apache 2.0-Protokoll, 81% MMLU, 150 Token/Sek.

Heute hat Mistral AI Mistral Small 3, ein latenzoptimiertes Modell mit 24 Milliarden Parametern, vorgestellt und unter dem Apache 2.0 Protokoll veröffentlicht.

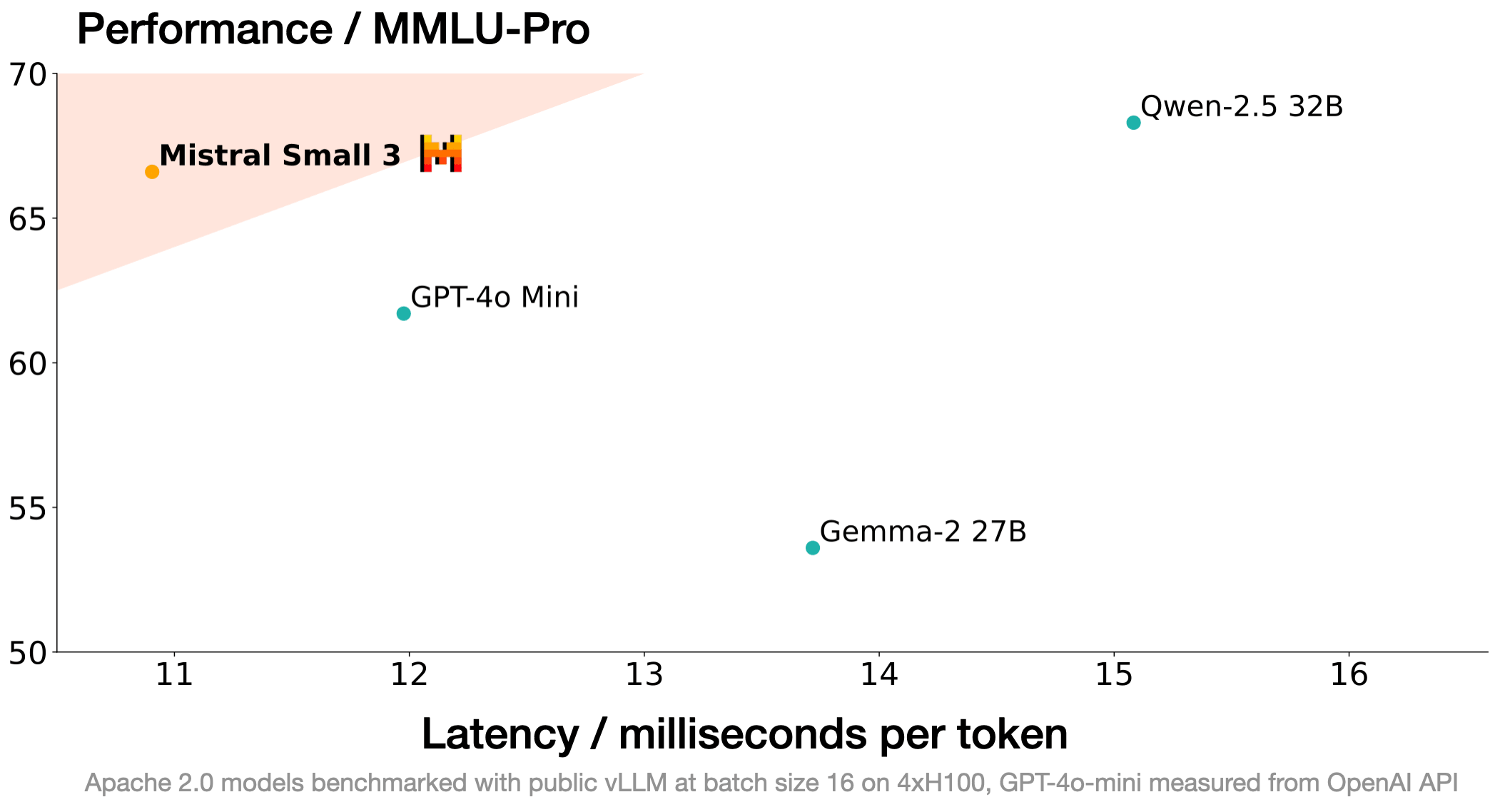

Mistral Small 3 ist vergleichbar mit größeren Modellen wie Llama 3.3 70B oder Qwen 32B und ist eine ausgezeichnete Open-Source-Alternative zu undurchsichtigen proprietären Modellen wie GPT4o-mini. Mistral Small 3 ist vergleichbar mit Llama 3.3 70B instruct, ist aber mehr als 3 mal schneller auf der gleichen Hardware.

Mistral Small 3 ist ein vortrainiertes und auf Instruktionen abgestimmtes Modell, das für die Anforderungen des "80%" bei generativen KI-Aufgaben entwickelt wurde, die starke linguistische Fähigkeiten und eine hohe Befolgungsleistung bei sehr geringer Latenzzeit erfordern.

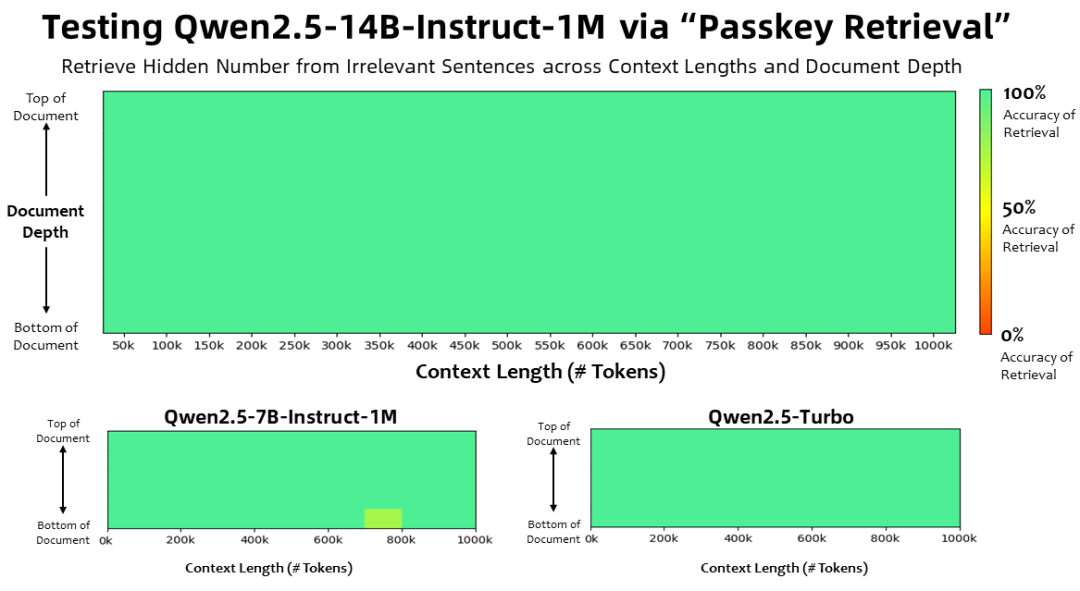

Mistral AI Dieses neue Modell wurde entwickelt, um die Leistung in einem Maßstab zu sättigen, der für den lokalen Einsatz geeignet ist. Mit einer MMLU-Genauigkeit von über 81% und einer Latenzzeit von 150 Token/Sekunde ist Mistral Small das bisher effizienteste Modell seiner Art.

Mistral AI veröffentlicht Checkpoints für das Vortraining und die Feinabstimmung der Instruktionen unter dem Apache 2.0 Protokoll. Diese Checkpoints können als leistungsstarke Grundlage für einen beschleunigten Fortschritt dienen. Beachten Sie, dass Mistral Small 3 weder mit Verstärkungslernen (Reinforcement Learning, RL) noch mit synthetischen Daten trainiert wird und daher bei der Modellerstellung effizienter ist als das Deepseek R1 (eine großartige und ergänzende Open-Source-Technologie!) Mistral AI freut sich darauf zu sehen, wie die Open-Source-Gemeinschaft sie annimmt und anpasst. Mistral AI freut sich darauf, zu sehen, wie die Open-Source-Gemeinschaft sie annimmt und anpasst.

Leistungen

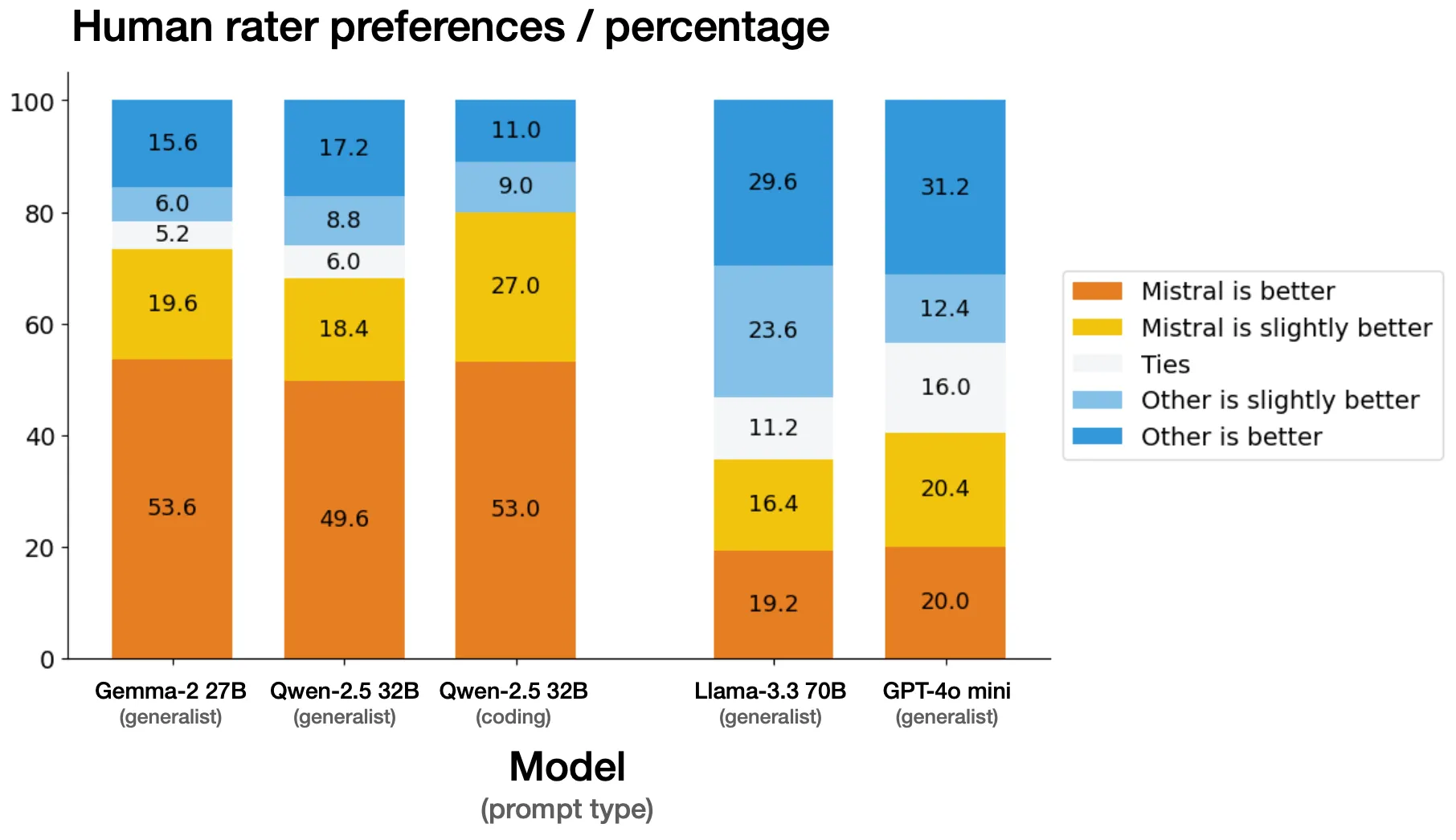

manuelle Bewertung

Mistral AI führte Seite-an-Seite-Evaluierungen mit einem externen Drittanbieter für eine Reihe von über 1.000 proprietären Codes und generischen Stichworten durch. Mistral AI ist sich bewusst, dass in einigen Fällen die Benchmarks für das menschliche Urteilsvermögen erheblich von den öffentlich zugänglichen Benchmarks abweichen, aber Mistral AI hat besondere Sorgfalt darauf verwendet, die Fairness der Bewertung zu überprüfen. gültig sind.

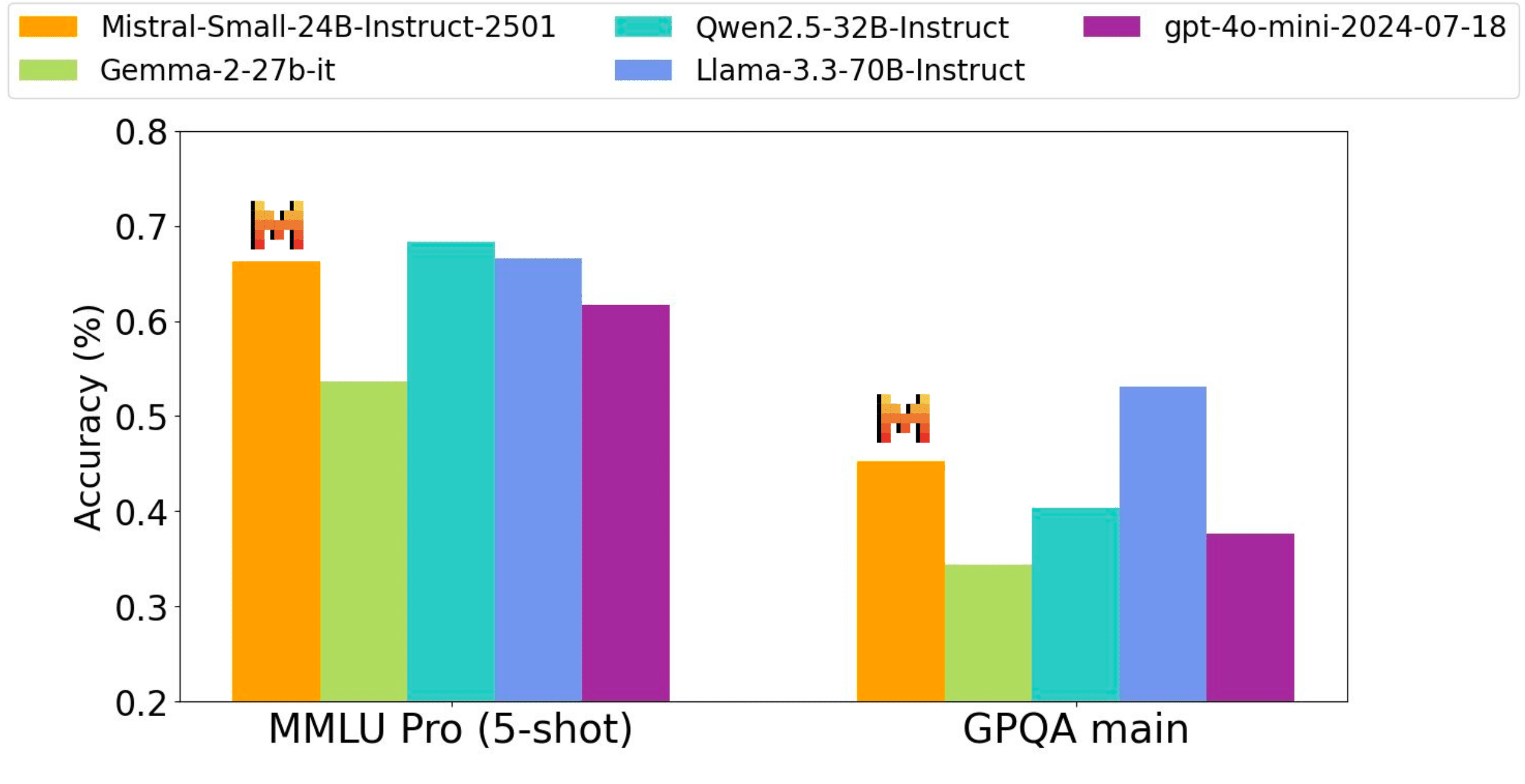

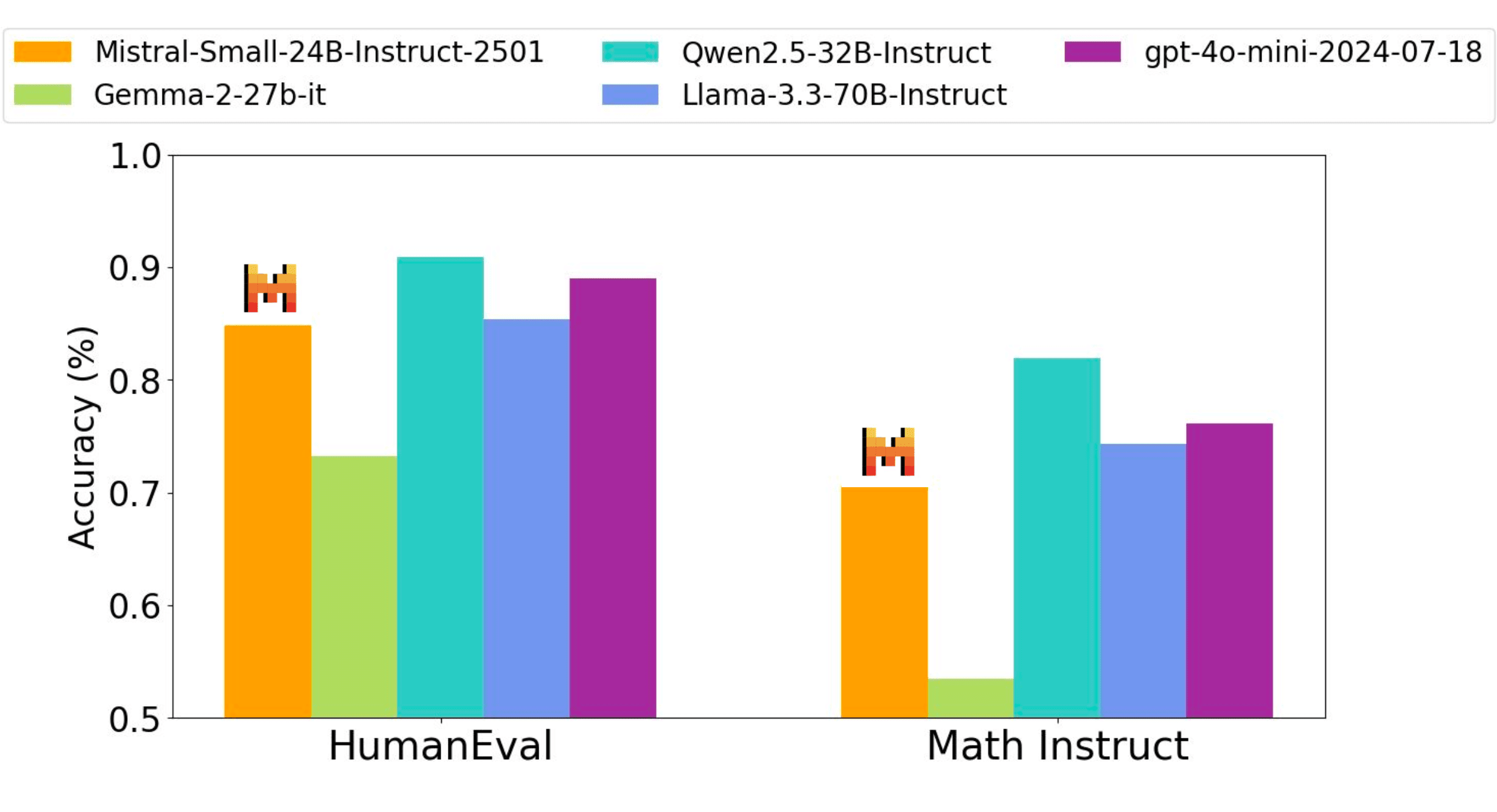

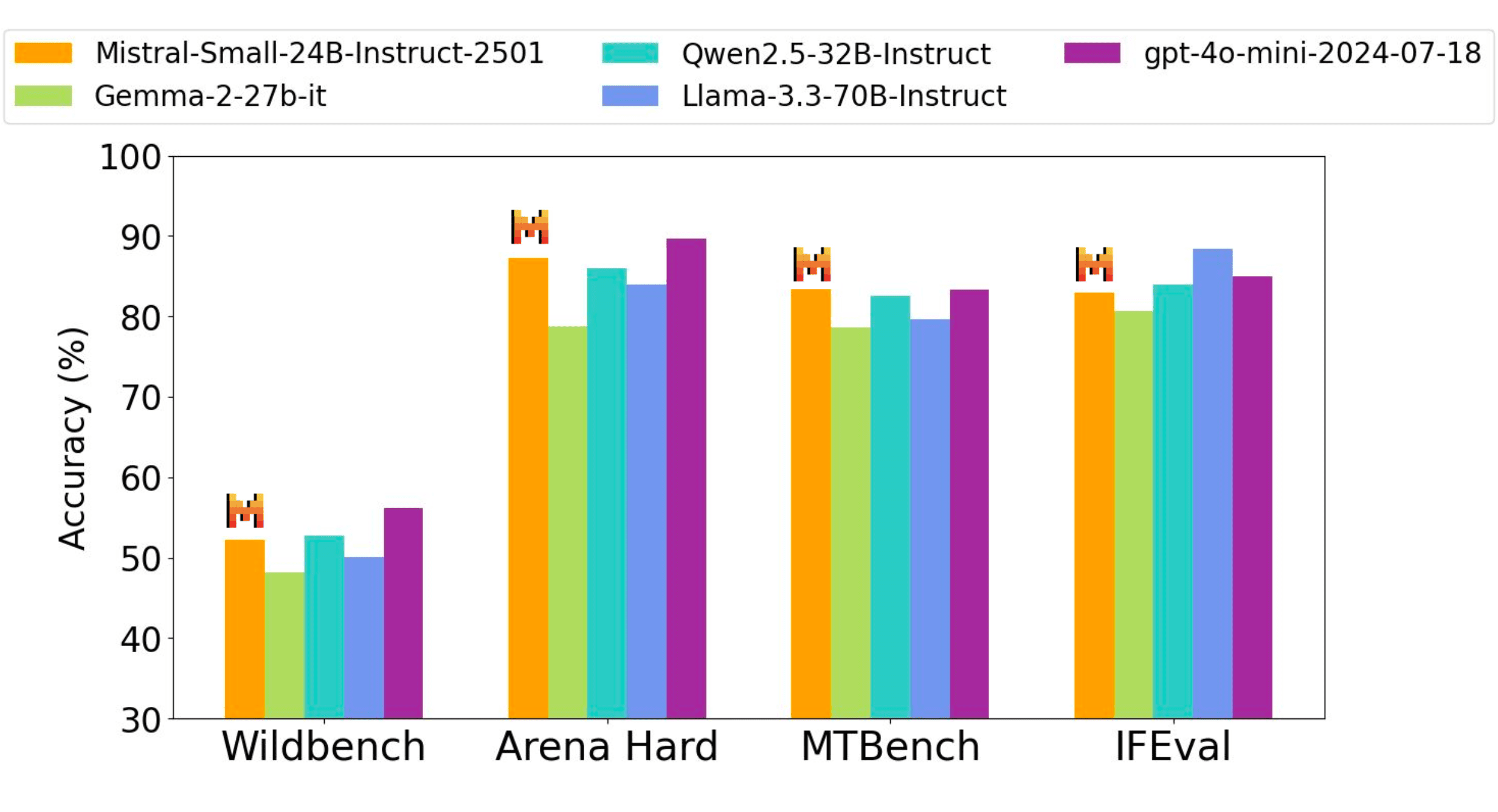

richtungsweisende Funktion

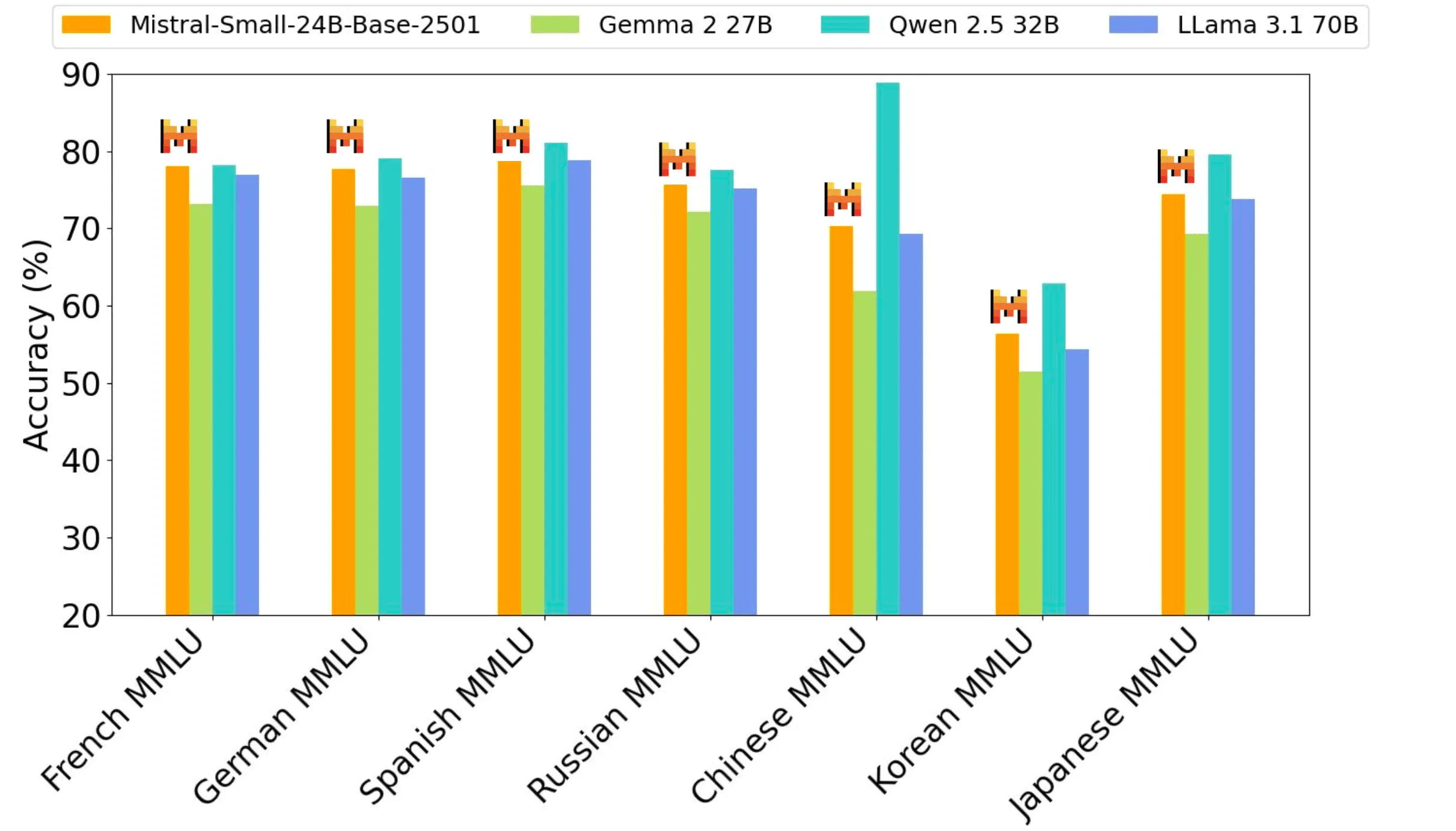

Das Modell zur Feinabstimmung der Instruktionen von Mistral AI hat einen Wettbewerbsvorteil gegenüber Open-Source-Gewichtungsmodellen, die dreimal so groß sind, sowie gegenüber dem proprietären GPT4o-mini-Modell in Code-, Mathematik-, Allgemeinwissen- und Instruktionsfolge-Benchmarks.

Die Leistungsgenauigkeit aller Benchmarks wird durch denselben internen Evaluierungsprozess erzielt - daher können die Zahlen geringfügig von den zuvor berichteten Leistungen abweichen (Qwen2.5-32B-Instruct, Llama-3.3-70B-Instruct, Gemma-2-27B-IT). wildbench, Arena hard und Wildbench, Arena hard und MTBench Judge based evals auf Basis von gpt-4o-2024-05-13.

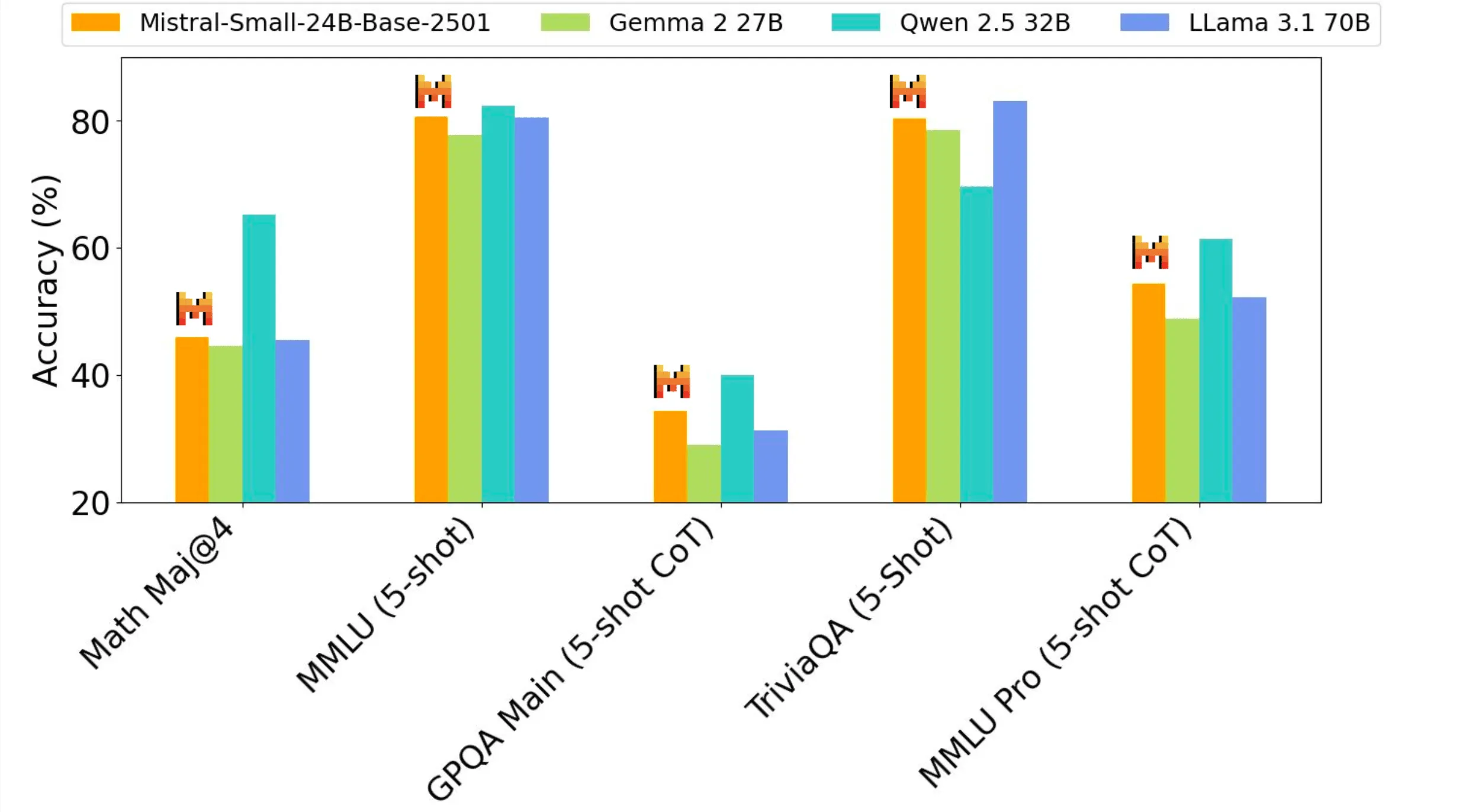

Leistung vor dem Training

Der Mistral Small 3 bietet als 24B-Modell die beste Leistung für seine Größenklasse und kann es mit dreimal so großen Modellen wie dem Llama 3.3 70B aufnehmen.

Wann wird Mistral Small 3 verwendet?

Unter den Kunden und der Community von Mistral AI haben sich mehrere einzigartige Anwendungsfälle für vortrainierte Modelle in diesem Umfang herauskristallisiert:

- Reaktionsschnelle Dialogassistenz: Mistral Small 3 eignet sich hervorragend für Szenarien, die schnelle und präzise Antworten erfordern. Dazu gehören viele virtuelle Assistenzszenarien, in denen Benutzer sofortiges Feedback und Interaktion in nahezu Echtzeit erwarten.

- Funktionsaufrufe mit geringer Latenz: Mistral Small 3 kann schnelle Funktionsausführungen verarbeiten, wenn es als Teil eines Automatisierungs- oder Agenten-Workflows eingesetzt wird.

- Feinabstimmung zur Erstellung von Fachexperten: Mistral Small 3 kann fein abgestimmt werden, um sich auf bestimmte Bereiche zu konzentrieren und hochpräzise Fachexperten zu erstellen. Dies ist besonders nützlich in Bereichen wie Rechtsberatung, medizinische Diagnostik und technische Unterstützung, wo domänenspezifisches Wissen entscheidend ist.

- Lokale Argumentation: besonders vorteilhaft für Bastler und Organisationen, die mit sensiblen oder geschützten Informationen arbeiten. Bei der Quantifizierung kann Mistral Small 3 privat auf einer einzelnen RTX 4090 oder einem Macbook mit 32 GB RAM laufen.

Die Kunden von Mistral AI evaluieren Mistral Small 3 in verschiedenen Branchen, darunter:

- Wird von Finanzdienstleistern zur Betrugserkennung verwendet

- Wird von Gesundheitsdienstleistern für die Triage von Kunden verwendet

- Robotik-, Automobil- und Fertigungsunternehmen für geräteinterne Steuerung und Kontrolle

- Zu den kundenübergreifenden horizontalen Anwendungsfällen gehören der virtuelle Kundendienst sowie die Analyse von Stimmungen und Feedback.

Verwenden Sie Mistral Small 3 auf Ihren bevorzugten Technologiestationen

Der Mistral Small 3 ist jetzt auf la Plateforme als mistral-small-latest vielleicht mistral-small-2501 Der Text wird in Form des Mistral AI-Modells bereitgestellt. Bitte konsultieren Sie die Dokumentation von Mistral AI, um zu erfahren, wie Sie die Modelle von Mistral AI für die Texterzeugung verwenden können.

Mistral AI freut sich auch über die Zusammenarbeit mit Hugging Face, Ollama, Kaggle, Together AI und Fireworks AI, die das Modell ab heute auf ihren Plattformen zur Verfügung stellen:

- Umarmendes Gesicht (Basismodell)

- Ollama

- Kaggle

- Gemeinsam AI

- Feuerwerk AI

- Demnächst für NVIDIA NIM, Amazon SageMaker, Groq, Databricks und Snowflake!

Der Weg in die Zukunft

Dies sind aufregende Tage für die Open-Source-Gemeinschaft! Mistral Small 3 ergänzt große Open-Source-Inferenzmodelle wie das kürzlich veröffentlichte DeepSeek und kann als leistungsstarkes Basismodell verwendet werden, um Inferenzfähigkeiten in den Vordergrund zu stellen.

Neben vielen anderen Dingen werden in den nächsten Wochen kleine und mittelgroße Mistral-Modelle mit verbesserten Argumentationsfähigkeiten veröffentlicht werden. Wenn Sie daran interessiert sind, an der Mistral-KI-Reise teilzunehmen (Mistral AI stellt ein), oder wenn Sie über sich hinauswachsen wollen, indem Sie Mistral Small 3 knacken und es jetzt noch besser machen!

Das Open-Source-Modell von Mistral

Mistral AI bekräftigt seine Verpflichtung, das Apache 2.0 Protokoll für generische Modelle zu verwenden, da Mistral AI die MRL-lizenzierten Modelle auslaufen lässt . Wie bei Mistral Small 3 werden die Modellgewichte zum Download und zum lokalen Einsatz zur Verfügung stehen und können frei modifiziert und in jeder Umgebung verwendet werden. Die Modelle werden auch über serverlose APIs auf la Plateforme, den lokalen und VPC Deployment-, Anpassungs- und Orchestrierungsplattformen von Mistral AI, sowie den Inferenz- und Cloud-Partnern von Mistral AI verfügbar sein. Unternehmen und Entwickler, die spezielle Funktionen benötigen (erhöhte Geschwindigkeit und Kontext, domänenspezifisches Wissen, aufgabenspezifische Modelle (z. B. Code-Vervollständigung)), können auf zusätzliche kommerzielle Modelle zurückgreifen, die die Beiträge von Mistral AI zur Community ergänzen.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...