MiniMax Erster quelloffener MiniMax-01, 4M super langer Kontext, neue Architektur, Herausforderung Transformer

"MoE" plus "noch nie dagewesene groß angelegte Einführung in Produktionsumgebungen". Blitzschlag Achtung", plus "Software- und Engineering-Refactoring von der Framework- bis zur CUDA-Ebene", was kommt dabei heraus?

Die Antwort ist ein neues Modell, das die Fähigkeiten der Spitzenmodelle verbindet und die Kontextlänge auf die 4-Millionen-Token-Grenze anhebt.

Am 15. Januar hat das Makromodellierungsunternehmen MiniMax offiziell die seit langem angekündigte neue Modellserie veröffentlicht: MiniMax-01, die aus dem sprachlichen Grundmakromodell MiniMax-Text-01 und dem visuellen multimodalen Makromodell MiniMax-VL-01 besteht, das durch die Integration eines leichten ViT-Modells entwickelt wurde.

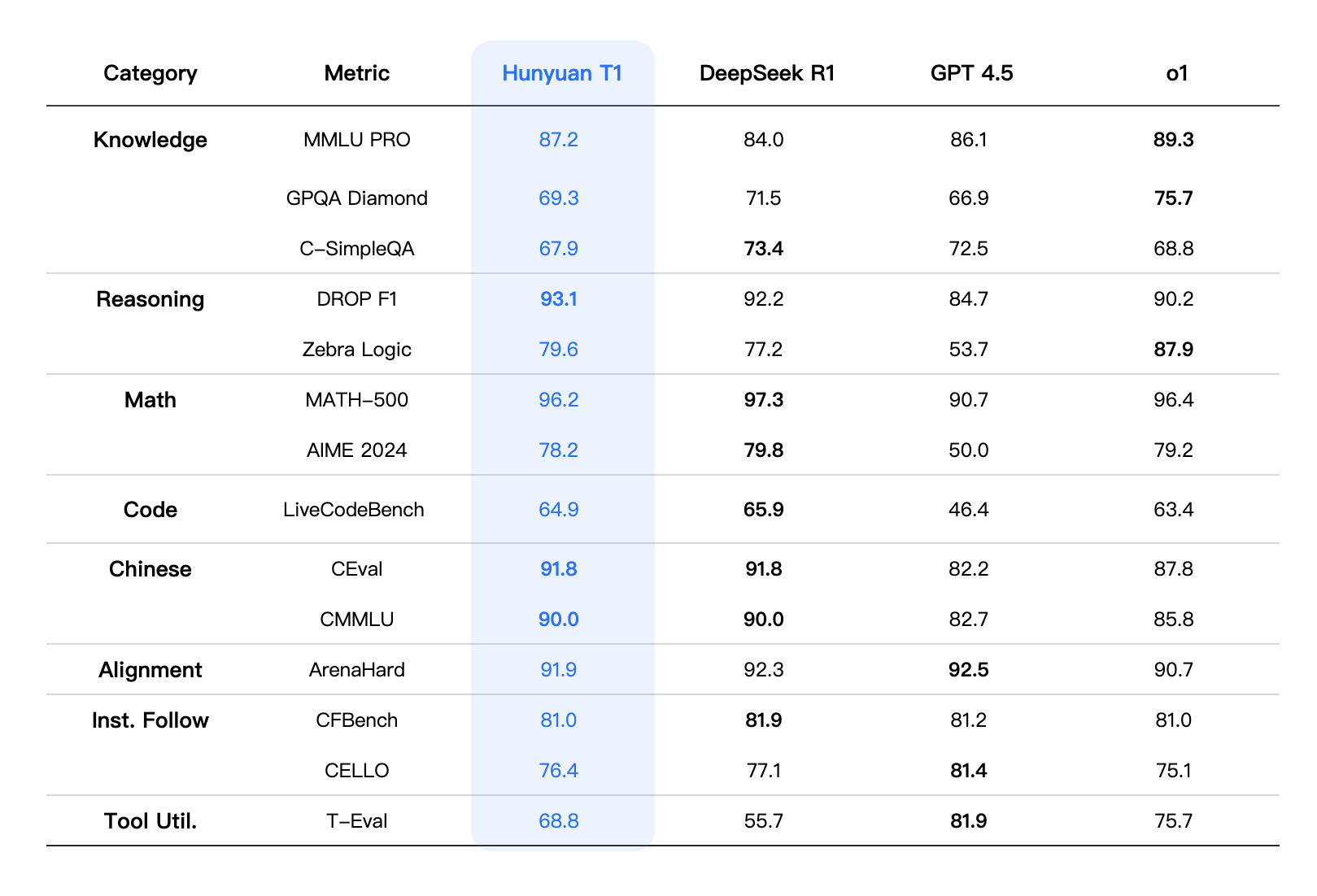

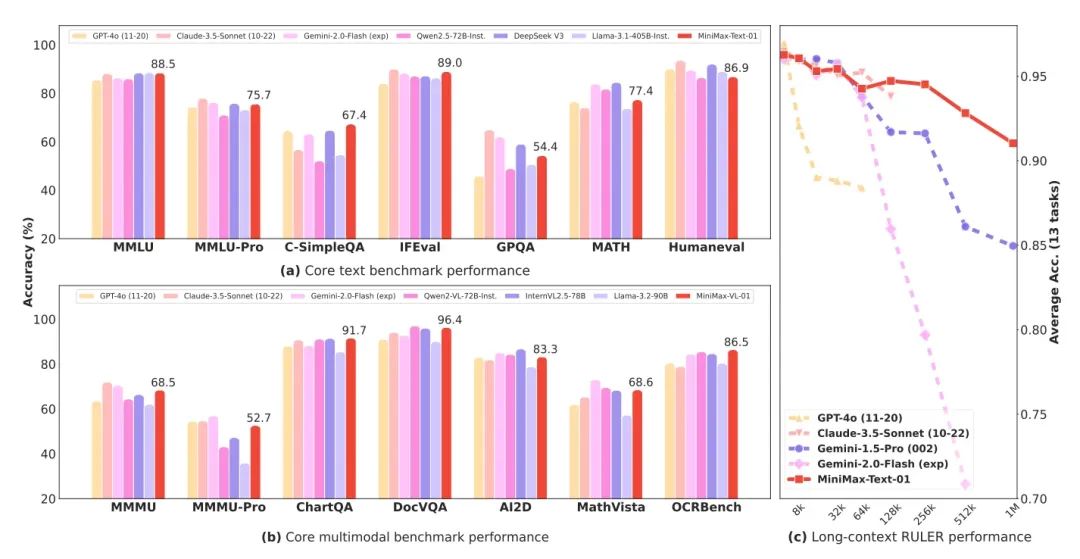

MiniMax-01 ist ein MoE-Modell (Mixed Expert) mit 456 Milliarden Gesamtparametern und 32 Experten, das in Bezug auf die kombinierte Leistung bei mehreren Mainstream-Prüfungssätzen mit GPT-4o und Claude 3.5 sonnet gleichauf liegt, während es gleichzeitig die 20-32-fache Kontextlänge der heutigen Spitzenmodelle aufweist, und bei längeren Eingabelängen ist es auch das Modell mit dem längsten Leistungsabfall. ist das Modell mit dem langsamsten Leistungsabfall. Das heißt, es ist ein echter 4-Millionen-Token-Kontext.

- Grundsprachliches Makromodell MiniMax-Text-01, visuelles multimodales Makromodell MiniMax-VL-01

- Die neue Aufmerksamkeitsarchitektur von Lightning, Square to Linear, reduziert die Inferenzkosten drastisch

- Schwerer Open Source, Textmodellparameter bis zu 456 Milliarden, 32 Experten

- Ultra-ultra-langer Kontext mit 4 Millionen Wörtern und einer Leistung, die den Spitzenmodellen aus Übersee entspricht

- Das Modell, der Code und der technische Bericht wurden alle veröffentlicht, ganz ehrlich!

Sowohl das Web-Erlebnis als auch die API sind jetzt live und können online unter der Adresse am Ende des Artikels erlebt und vermarktet werden.

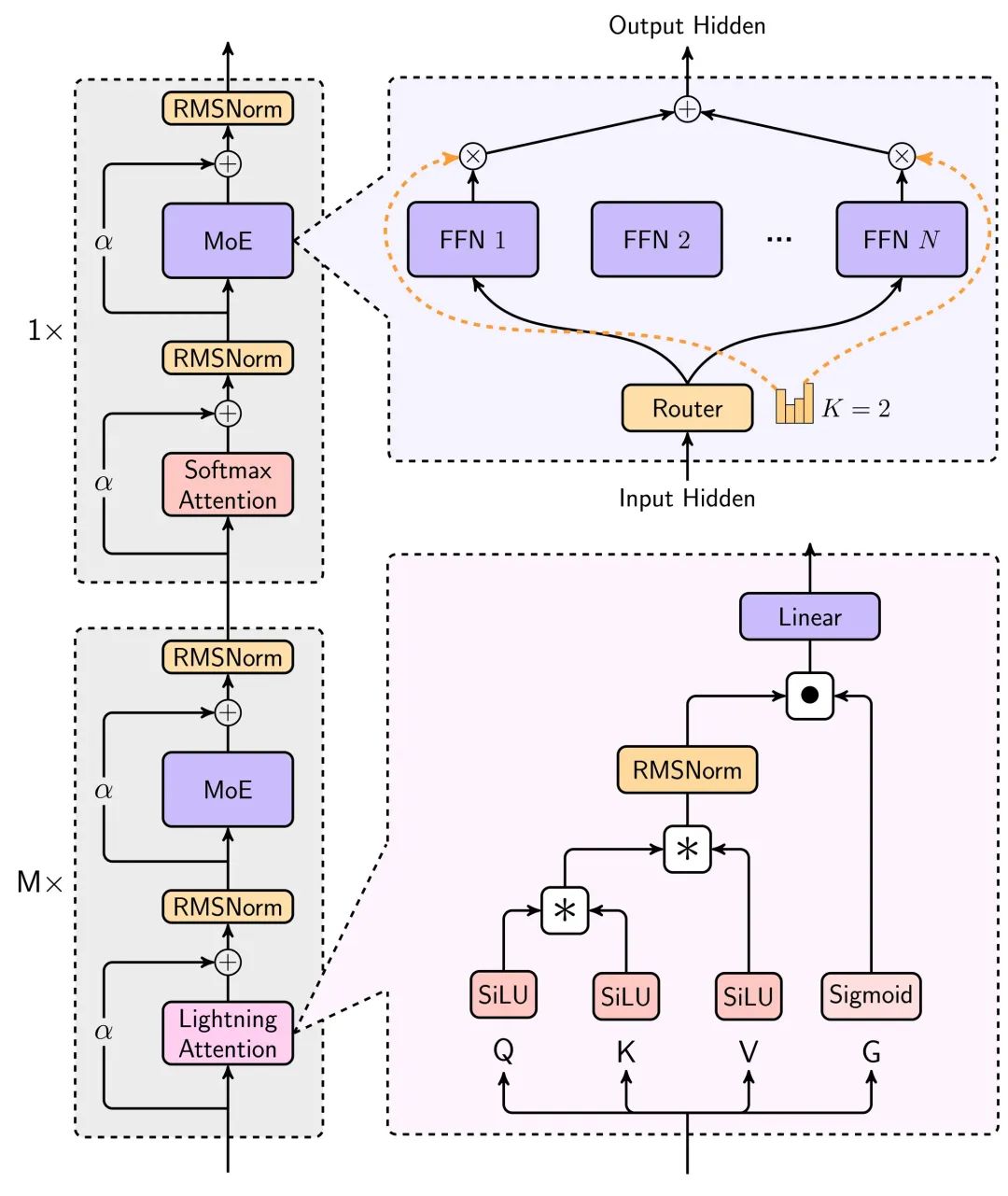

Neue Technologie: Aufmerksamkeit durch Blitze

Das Überraschendste an diesem Modell ist die neue lineare Aufmerksamkeitsarchitektur.

Wir alle wissen, dass in der tatsächlichen AI verwenden, ist langer Text von entscheidender Bedeutung, die lange Erinnerung an Zeichen-Chat, AI Coding, um Code zu schreiben, Agent, um eine Vielzahl von Aufgaben, die Szenario ist untrennbar mit dem langen Text zu vervollständigen.

Die großen Modelle sind im Preis gesunken, aber je länger sie eingesetzt werden, desto langsamer und teurer werden sie.

Die Ursache dieses Problems ist Transformator Die Architektur hat eine quadratische Berechnungskomplexität. Der arithmetische Aufwand für die Argumentation steigt mit zunehmendem Kontext exponentiell an.

Diesmal verwendet das neue Modell von MiniMax den Aufmerksamkeitsmechanismus Lightning, einen linearen Aufmerksamkeitsmechanismus, der die Berechnungs- und Schlussfolgerungszeit für lange Texte erheblich reduzieren kann.

Die wichtigsten Architekturdiagramme für diese Modellierung sind im technischen Bericht zu finden.

Die Verringerung des Ressourcenverbrauchs bei der Modellinferenz durch diese Architektur ist enorm, wie das folgende Diagramm zeigt, das die Inferenzzeiten für lange Texte vergleicht, bei denen die lineare Aufmerksamkeit verwendet wird, um die Inferenzzeiten langsam und nahezu linear ansteigen zu lassen, anstatt exponentiell, wenn der Kontext weiter ansteigt.

Eine ausführlichere Beschreibung findet sich in dem technischen Bericht am Ende des Artikels.

Der Rechenaufwand ist geringer, der Preis sinkt, und die Leistung kann nicht so lange beeinträchtigt werden, dass der Text wirklich brauchbar ist.

Das folgende Diagramm zeigt die Leistung von Text-1 bei sehr langen Texten, wo es überraschenderweise das Intervall mit einer Länge von 512K+ übertrifft Zwillinge 2.0 Blitzlicht.

Ein weiterer sehr interessanter Punkt in dem technischen Bericht ist, dass die Fähigkeit des Modells zum kontextbezogenen Lernen, die mit der Verbesserung des Kontexts allmählich zunimmt, eine große Hilfe für das Schreiben von KI sowie für Aufgaben sein kann, die ein langes Gedächtnis erfordern.

Insgesamt wird durch die Anwendung des Blitzaufmerksamkeitsmechanismus die Nutzbarkeit von langen Texten für große Modelle drastisch erhöht, und der Preis hat die Chance, in Zukunft um eine weitere Größenordnung zu sinken.

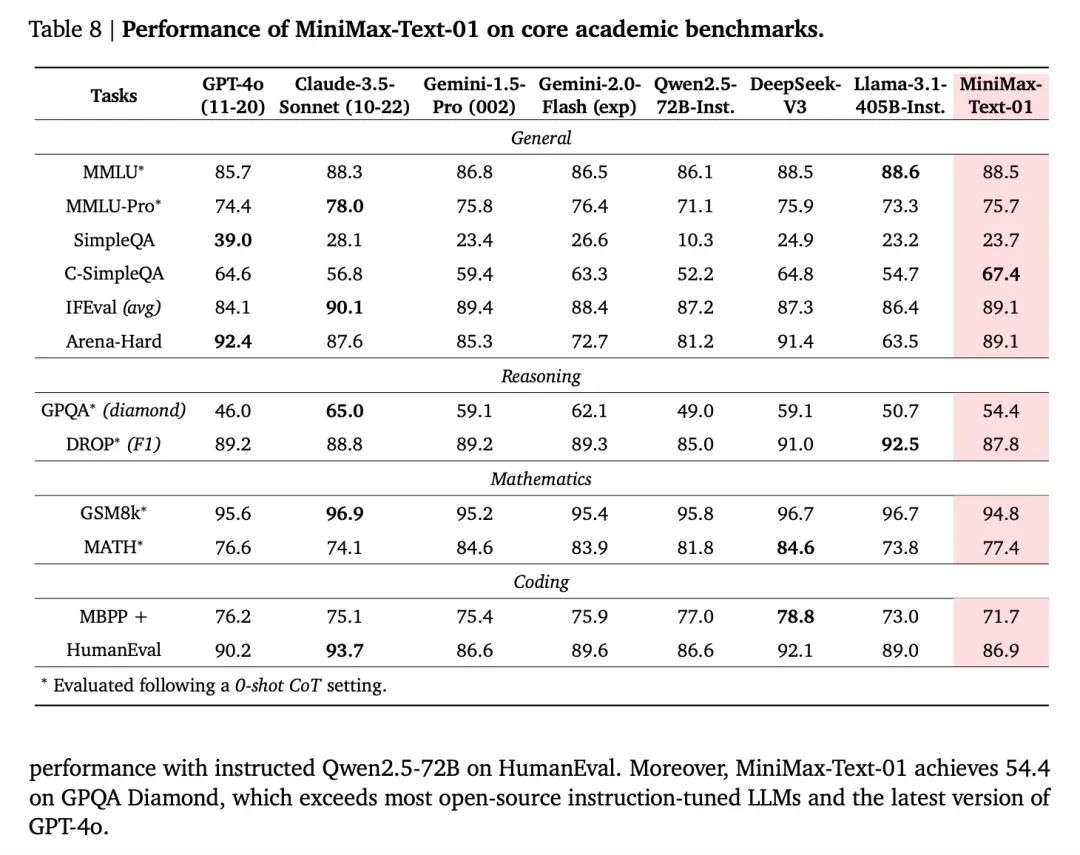

Modellleistung, Nivellierung der ersten Linie

Was die Leistungskennzahlen des Modells angeht, so kann es als Open-Source-Modell in vielen Bereichen mit den besten Closed-Source-Modellen aus Übersee mithalten.

Und da das Modell für die Optimierung und Iteration auf das Feedback der Conch-Plattform zurückgreifen kann, ist auch die Nutzererfahrung realer Szenarien gewährleistet.

Die offizielle Verwendung von realen Benutzer verwenden Szenarien, um eine Testreihe zu bauen, können Sie sehen, dass die Leistung in realen Szenarien ist auch sehr hell, vor allem prominente Szenarien sind drei: kreatives Schreiben, Wissen Quiz, langen Text.

Darüber hinaus ist das visuelle Verständnis Modell MiniMax-VL-01 Leistung, im Grunde in jedem Index gleich oder übertreffen die Übersee-Top-Modelle, vor allem praktische OCR-und Chart-Szenen.

Nächster Transformer-Moment

Wenn die Iterationen der Generationen von Modellen nicht mehr wild sind, werden Kontextlänge und logisches Denken zu den beiden wichtigsten Richtungen.

In diesem Zusammenhang war Gemini einst der längste Token. DeepMind-CEO Demsi Hassabis hat außerdem verraten, dass das Gemini-Modell bei Google in Experimenten bereits 10 Millionen Token-Längen erreicht hat und vermutlich irgendwann "unendliche Längen" erreichen wird, aber was Gemini davon abhält, sind die entsprechenden Kosten. Was Gemini jedoch davon abhält, dies jetzt zu tun, sind die Kosten dafür. In einem kürzlich geführten Interview sagte er, dass Deepmind jetzt einen neuen Ansatz zur Lösung dieses Kostenproblems hat.

Derjenige, der zuerst die Kontextlänge erhöhen und gleichzeitig die Kosten senken kann, wird wahrscheinlich die Oberhand behalten. Nach den Ergebnissen zu urteilen, die MiniMax-01 gezeigt hat, hat es wirklich eine qualitative Verbesserung der Effizienz erreicht.

In diesem ausführlichen technischen Bericht lässt sich die Effizienz der Hardware-Nutzung an einer Statistik ablesen: MiniMax erreicht 75% MFUs auf H20-GPUs, was eine recht hohe Zahl ist.

MFU (Machine FLOPs Utilization) bezieht sich auf die tatsächliche Nutzung der Hardware-Rechenleistung (FLOPs, d.h. Gleitkommaoperationen pro Sekunde) durch ein Modell während des Betriebs. Kurz gesagt, MFU beschreibt, ob ein Modell die Hardwareleistung voll ausnutzt. Eine hohe Auslastungsrate bringt auf jeden Fall Kostenvorteile mit sich.

Der MiniMax 01 ist sicherlich eine der seltenen Überraschungen in der aktuellen Debatte um die "dead-on-the-wall".Eine weitere, die in letzter Zeit für viel Gesprächsstoff gesorgt hat, ist DeepSeek V3. Wie bereits erwähnt, sind Deepseek V3 und MiniMax-01 heute zwei wichtige Richtungen, eine im Bereich der Inferenz und eine in längeren Kontexten.

Interessanterweise optimieren beide in gewissem Maße den zentralen Aufmerksamkeitsmechanismus in Transformer, der den Grundstein für den heutigen Boom gelegt hat, und es handelt sich um ein kühnes Refactoring, Hardware und Software in einem. deepSeek V3 wurde als das Ausmelken der Nvidia-Karten beschrieben, und es ist entscheidend für MiniMaxs Fähigkeit, eine so hohe Inferenz-MFU zu erreichen, dass sie auch Sie optimieren den Trainingsrahmen und die Hardware direkt.

Dem Bericht von MiniMax zufolge haben sie einen CUDA-Kernel für lineare Aufmerksamkeitsspanne direkt von Grund auf selbst Schritt für Schritt in die Tiefe entwickelt und zu diesem Zweck verschiedene begleitende Frameworks entwickelt, um die effiziente Nutzung von GPU-Ressourcen zu optimieren. Beide Unternehmen erreichten ihre Ziele durch eine engere Integration von Hardware- und Softwarefunktionen.

Eine weitere interessante Beobachtung ist, dass es sich bei diesen beiden herausragenden Unternehmen um Unternehmen handelt, die bereits vor dem Aufkommen von ChatGPT in die Forschung und Entwicklung großer Modelltechnologien investiert haben. Das Erstaunliche an diesen beiden Modellen ist, dass sie nicht im Modus "Aufholen von GPT4" agieren, wie wir es aus der Vergangenheit gewohnt sind, sondern dass sie nach ihrer eigenen Einschätzung der Entwicklung der Technologie hohe Investitionen und sogar einige Wetten auf Innovation getätigt und die Antwort nach einer Reihe von nachhaltiger und solider Arbeit geliefert haben. Stattdessen haben sie, basierend auf ihrer eigenen Einschätzung der technologischen Entwicklung, hohe Investitionen getätigt und sogar einige Wetten auf Innovation abgeschlossen, und die Antwort nach einer Reihe von nachhaltiger und solider Arbeit geliefert.

Und keine dieser Antworten ist nur für sich selbst, sondern sie alle versuchen zu beweisen, dass ein Konzept, das einst im Labor feststeckte, die versprochene Wirkung haben kann, wenn es in großem Maßstab in realen Szenarien eingesetzt wird, und dadurch mehr Menschen in die Lage versetzt, es weiter zu optimieren.

Das erinnert an die Zeit, als Transformer aufkam.

Als der Attention-Mechanismus auch im Labor viral geworden war, die Kontroverse aber immer noch tobte, war es Google, das an sein Potenzial glaubte, das die Rechenleistung und die Ressourcen anhäufte, um es von einem theoretischen Experiment zu einer realen Sache zu machen, die in großem Maßstab eingesetzt wurde. Als nächstes stürzten sich die Menschen auf den bewährten Weg zum heutigen Wohlstand.

Mit Transformer, das mehr Schichten übereinander stapelt und mehr Energie verbraucht, und MiniMax-01, das versucht, den alten Aufmerksamkeitsmechanismus zu überholen, ist es wieder ein bisschen wie ein Déjà-vu. Sogar der berühmte Titel des Papiers "Attention is all you need", den ein Google-Forscher gab, um den Aufmerksamkeitsmechanismus zu betonen, passt perfekt zu MiniMax: lineare Aufmerksamkeit ist alles, was man braucht - - - - - - -Aufmerksamkeit ist alles, was man braucht.

"Das Modell behält derzeit noch 1/8 der normalen Softmax-Aufmerksamkeit bei. Wir arbeiten an effizienteren Architekturen, die die Softmax-Attention schließlich ganz abschaffen werden, so dass unbegrenzte Kontextfenster ohne Überlastung der Rechner möglich sind."

Modellpreis

Input: $1/Million Token

Ausgabe: 8 $/Million Token

Verwenden Sie es grundsätzlich mit geschlossenen Augen.

Ressourcen für die Modellierung

Code:https://github.com/MiniMax-AI/MiniMax-01

Modelle:https://huggingface.co/MiniMaxAI/MiniMax-Text-01, https://huggingface.co/MiniMaxAI/MiniMax-VL-01

Technischer Bericht:https://filecdn.minimax.chat/_Arxiv_MiniMax_01_Report.pdf

Web-Seite:https://hailuo.ai

API. https://www.minimaxi.com/

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...