Mini LLM Flow: Aufbau von LLM-Mini-Intelligenzen mit "gerichteter Graphenstruktur" in 100 Codezeilen

Allgemeine Einführung

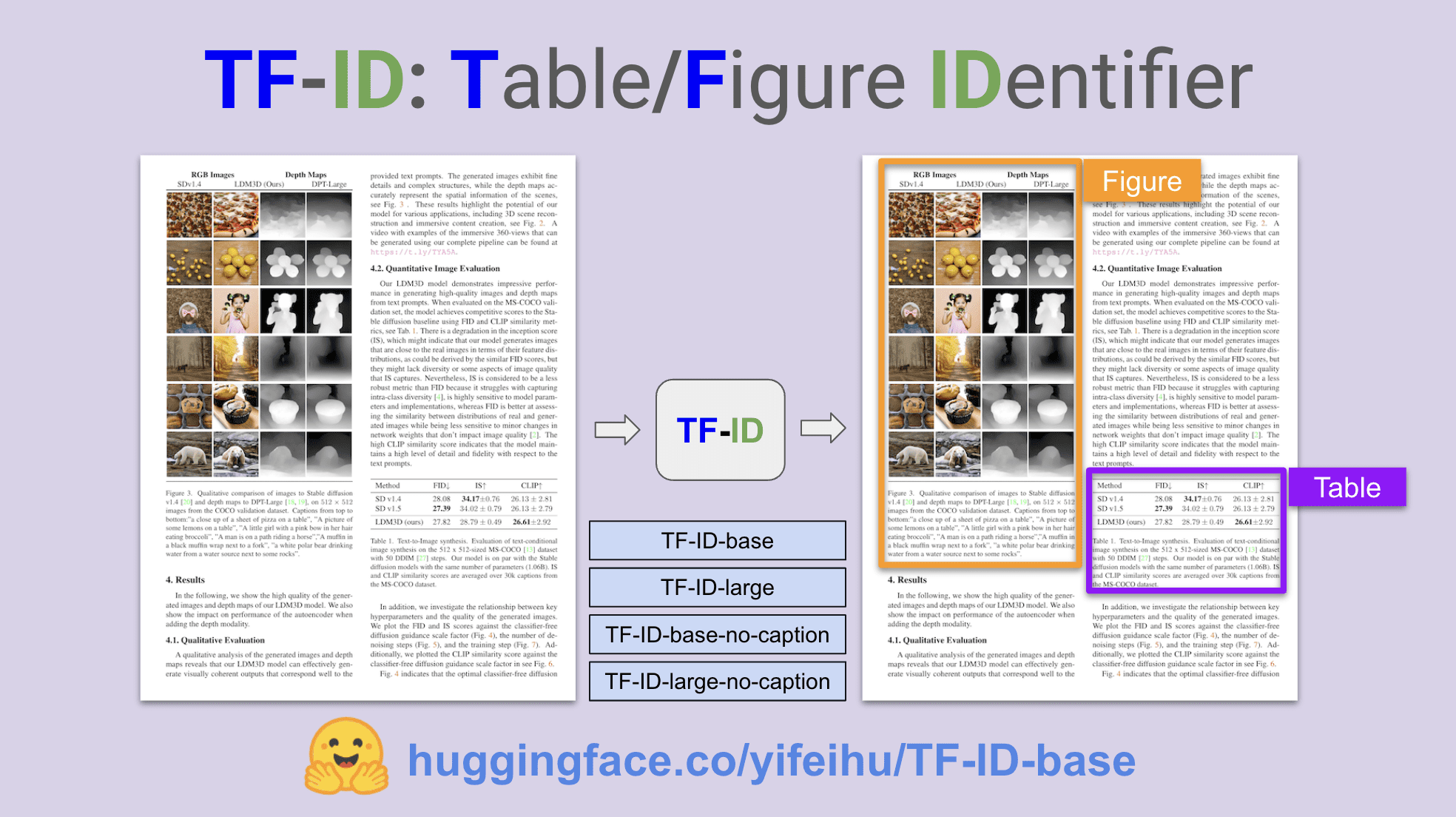

miniLLMFlow ist ein minimalistisches Large Language Model (LLM)-Entwicklungsframework, das nur 100 Zeilen Kerncode enthält und die Designphilosophie "Der Weg ist einfach" demonstriert. Das Framework wurde speziell entwickelt, um KI-Assistenten (z.B. ChatGPT, Claude, etc.) in die Lage zu versetzen, autonom zu programmieren, und unterstützt fortgeschrittene Funktionen wie Multi-Intelligenz, Aufgabenzerlegung und RAG-Abrufverbesserung. Das Projekt nutzt das MIT-Open-Source-Protokoll und wird auf der GitHub-Plattform kontinuierlich aktualisiert und gepflegt. Seine besten Eigenschaften sindModellierung von LLM-Workflows als verschachtelte gerichtete GraphenstrukturenDurch die Verarbeitung einfacher Aufgaben durch Knoten, die Verbindung von Agenten durch Aktionen (Markierung von Kanten), die Aufgabenzerlegung durch Prozessorchestrierungsknoten und die Unterstützung von Prozessverschachtelung und Stapelverarbeitung wird die Entwicklung komplexer KI-Anwendungen einfach und intuitiv.

Funktionsliste

- Unterstützung für kollaborative Entwicklungssysteme mit mehreren Intelligenzen

- Bereitstellung von Funktionen zur Aufgabenzerlegung und Prozessplanung

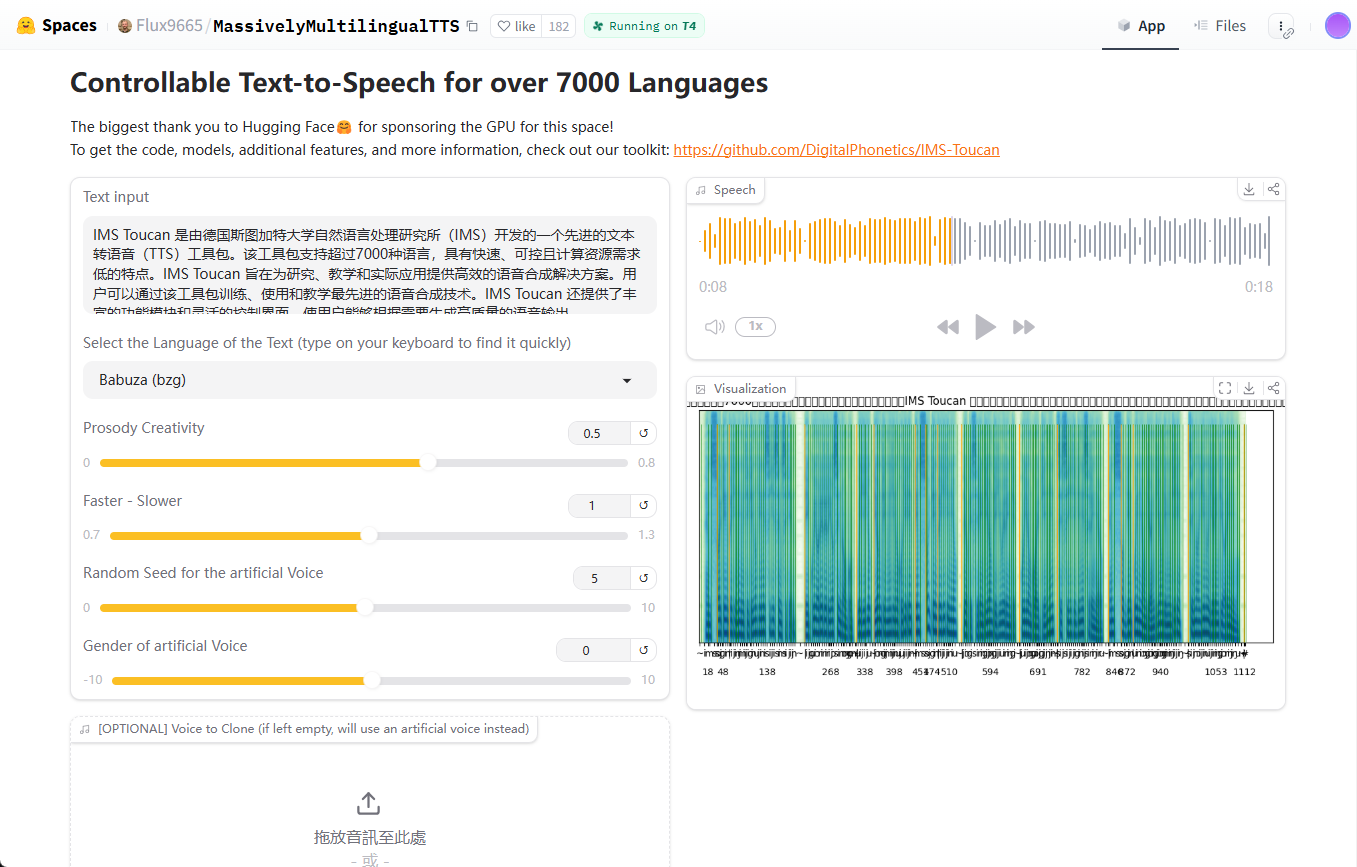

- Implementierung von RAG (Retrieval Augmented Generation) Anwendungsentwicklung

- Unterstützt Knotenstapelfunktion für datenintensive Aufgaben

- Workflow-Management mit verschachtelter, gerichteter Graphenstruktur

- Integration der wichtigsten LLM-Assistenten (z. B. ChatGPT, Claude)

- Unterstützung für benutzerdefinierte Tools und API-Pakete

- Umfassende Unterstützung mit Dokumentation und Tutorials

Hilfe verwenden

1. die Konfiguration der Installation

Weg 1: Installation über pip

pip install minillmflow

Ansatz 2: Direkte Verwendung des Quellcodes

Kopieren Sie den Quellcode (nur 100 Zeilen) direkt aus dem Projekt, um ihn schnell in Ihr Projekt zu integrieren.

2. die Beschreibung der Infrastruktur

miniLLMFlow verwendet eine verschachtelte gerichtete Graphenstruktur und enthält die folgenden Kernkonzepte:

- KnotenpunkteLLM: Basiseinheit für die Bearbeitung einzelner LLM-Aufgaben

- Aktionen: beschriftete Kanten von verbundenen Knoten für Interaktionen zwischen Intelligenzen

- StrömungenDirected graphs formed by choreographed nodes for task decomposition

- VerschachtelungProzesse können als Knotenpunkte wiederverwendet werden, um die Erstellung komplexer Anwendungen zu unterstützen.

- StapelUnterstützung für die parallele Verarbeitung von datenintensiven Aufgaben

3) Leitfaden für den Entwicklungsprozess

- Entwurfsphase

- Identifizierung von Prozessen und Knotenstrukturen auf hoher Ebene

- Entwurf von Strukturen mit gemeinsamem Speicher

- Definieren Sie Datenfelder und Aktualisierungsmethoden

- Realisierungsphase

- Beginnen Sie mit einer einfachen Implementierung

- Schrittweises Hinzufügen komplexer Funktionen

- Entwickelt mit Hilfe des LLM-Assistenten

- Entwickelt mit LLM Assistant

- Projektentwicklung mit Claude::

- Erstellen Sie ein neues Projekt und laden Sie Dokumente hoch

- Einrichten von Projektanpassungsanweisungen

- Lassen Sie sich von Claude bei der Gestaltung und Umsetzung helfen

- Entwickeln mit ChatGPT::

- Verwenden Sie einen spezialisierten GPT-Assistenten

- Option zur Verwendung neuerer Modelle für die Codeentwicklung

- Projektentwicklung mit Claude::

4. einleitendes Beispiel

Das Projekt bietet ein komplettes Einführungs-Tutorial, das zeigt, wie das Paul Graham Article Abstract und das QA Proxy System implementiert werden, das durch den Einstieg in Google Colab schnell erlernt werden kann.

5. bewährte Praktiken

- Beginnen Sie mit einfachen Funktionen und erweitern Sie diese schrittweise

- Nutzen Sie den LLM-Assistenten für die Entwicklung voll aus

- Siehe den Beispielcode in der Dokumentation

- Verwenden Sie die integrierten Debugging- und Testwerkzeuge

- Verfolgen Sie Projektaktualisierungen und Diskussionen in der Gemeinschaft

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...