Ausführlicher Überblick über die 10 besten Text-to-Speech-Projekte

Open-Source-Text-to-Speech (TTS)-Projekt: für Anwendungen, die realistischen "Sprach"-Klang erzeugen

Auf der Welle der künstlichen Intelligenz ist die Text-to-Speech-Technologie (TTS) zu einer wichtigen Brücke zwischen der digitalen Welt und den menschlichen Sinnen geworden. Vom Mensch-Maschine-Dialog in intelligenten Assistenten über die Sprachführung in Navigationssystemen bis hin zu Lesehilfen - die TTS-Technologie durchbricht mit ihrem einzigartigen Charme die Grenzen des geschriebenen Wortes und macht die Informationsvermittlung intuitiver und effizienter.

Der Geist von Open Source treibt die schnelle Entwicklung der TTS-Technologie voran. Immer mehr Entwickler und Forscher schließen sich der Open-Source-Gemeinschaft an, um das TTS-Ökosystem aufzubauen und zu verbessern. In diesem Artikel werden wir uns auf eine Reihe von hochkarätigen Open-Source-TTS-Projekten konzentrieren, ihre technischen Merkmale und ihr Anwendungspotenzial analysieren und den Lesern dabei helfen, die für ihre eigenen Bedürfnisse am besten geeignete "Sound"-Engine aus einer großen Auswahl zu finden.

Überblick über Open-Source-TTS-Projekte

Im Folgenden werden eine Reihe von Open-Source-TTS-Projekten mit ihren eigenen Vorteilen vorgestellt. Sie unterscheiden sich in Bezug auf Sprachabdeckung, Klangfarbentreue, Funktionalität usw. Der Leser kann je nach den tatsächlichen Anwendungsszenarien auswählen:

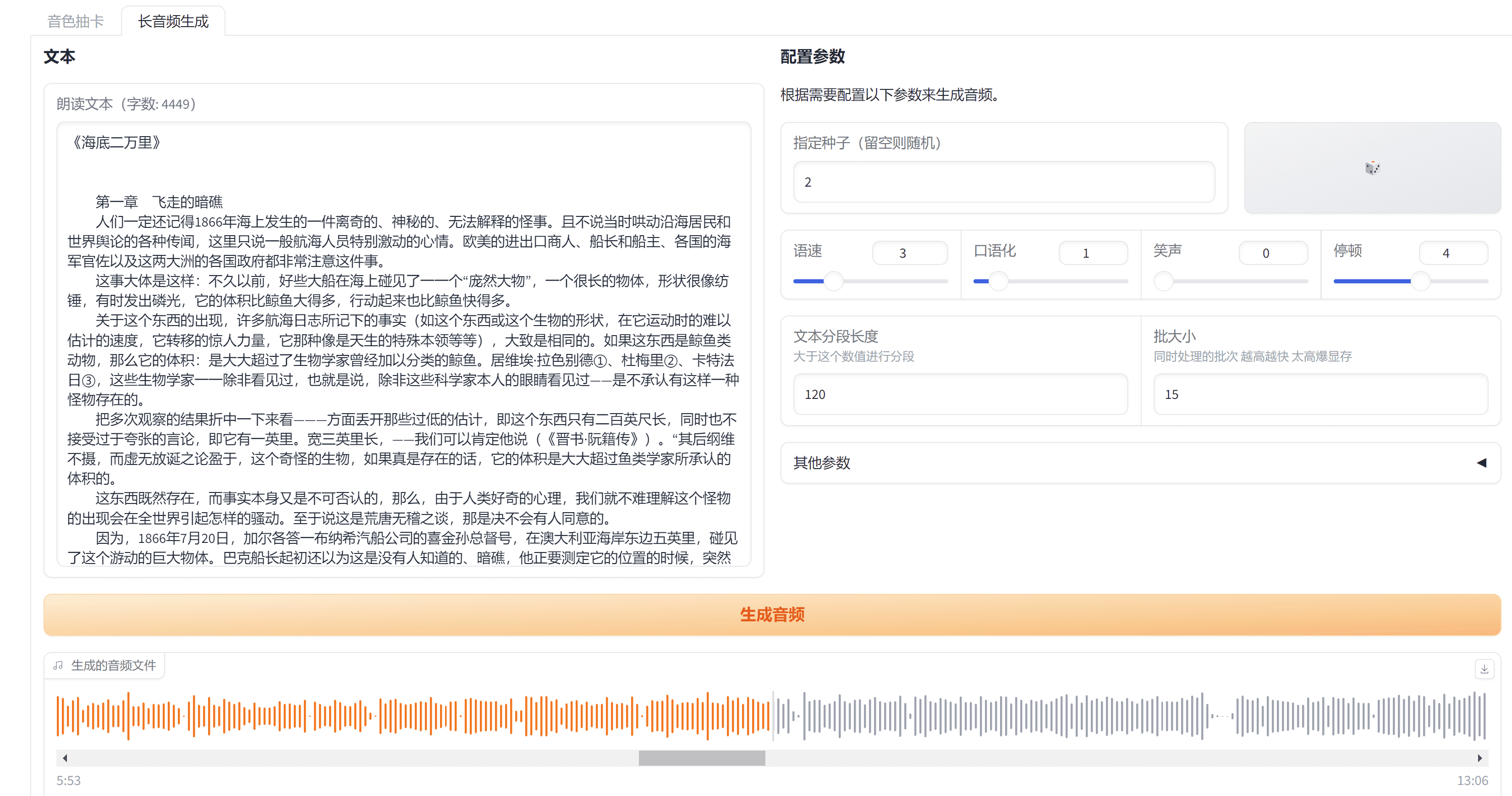

1) ChatTTS: natürliche Sprachsynthese für Dialogszenarien

Projektmerkmale: ChatTTS Der Schwerpunkt liegt auf der Optimierung der Wirkung der Sprachsynthese in Gesprächsszenarien, und seine Hauptstärken sindHervorragende kontextübergreifende Verarbeitung von Chinesisch und Englischim Gesang antwortenMulti-Talker-Simulation. Es unterstützt sechs Sprachkonfigurationen, darunter Chinesisch, Englisch und Japanisch, und kann gemischte chinesische und englische Texte reibungslos und natürlich synthetisieren, was besonders für Anwendungsszenarien wichtig ist, die mit mehrsprachigen Dialoginhalten umgehen müssen. Die Multi-Speaker-Funktion ermöglicht es ChatTTS, die Stimmen verschiedener Charaktere zu simulieren, was dem Dialogsystem eine größere Ausdruckskraft verleiht.

Mögliche Anwendungsszenarien: Intelligente Kundenservicesysteme, KI-Assistenten, mehrsprachige Lerntools, Hörbucherstellung und vieles mehr.

Vorteil: Optimierung von Konversationsszenen, natürliches und flüssiges Lesen von Chinesisch und Englisch, Unterstützung für mehrere Sprechertöne.

Zu beachtende Aspekte: Im Vergleich zu einigen Projekten, die eine extreme Klangqualität anstreben, kann sich ChatTTS mehr auf die Natürlichkeit und Funktionalität des Dialogs konzentrieren, und es kann Unterschiede in der Klangqualität in bestimmten Szenarien geben.

GitHub-Adresse: https://github.com/2noise/ChatTTS

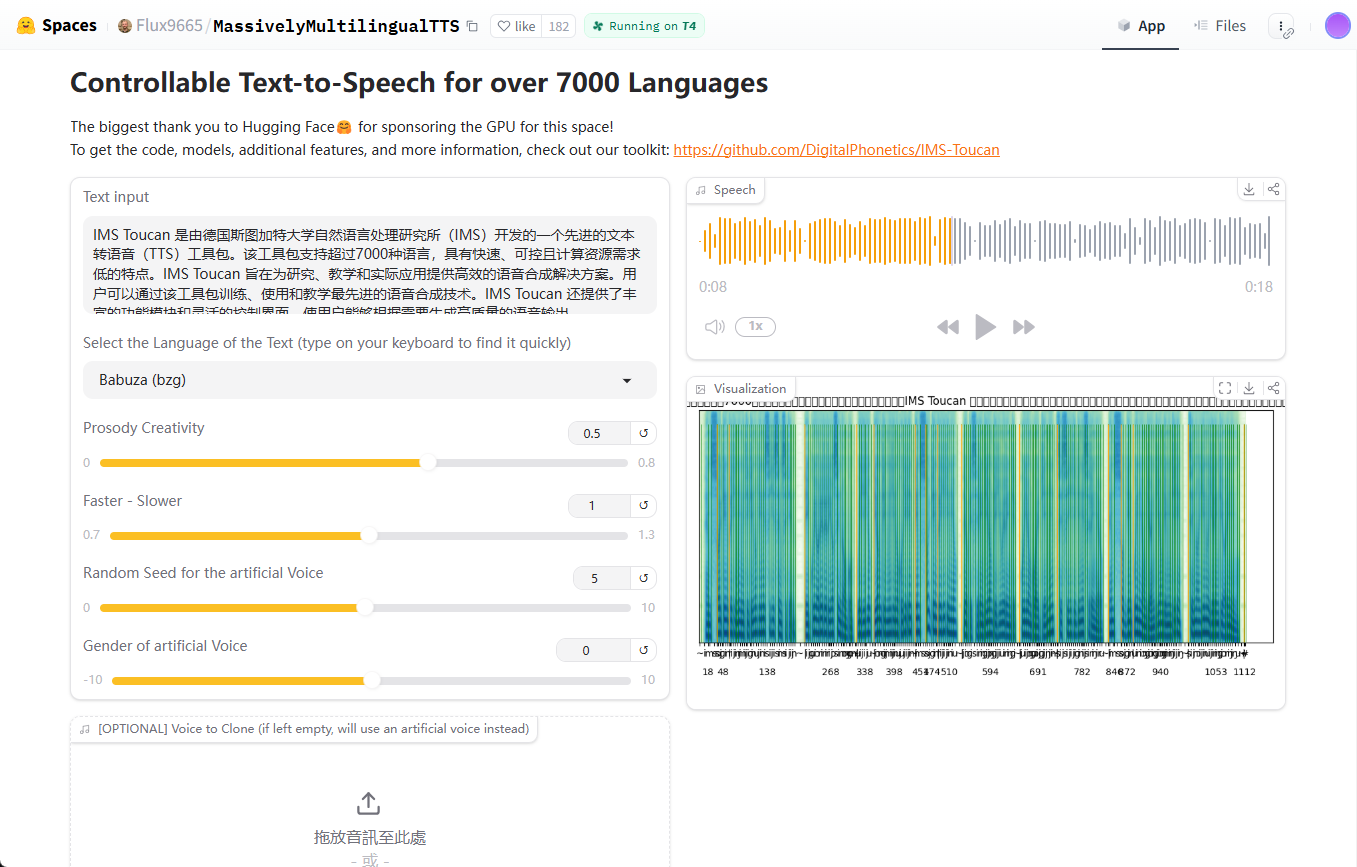

2 IMS Toucan: Synthesefähigkeiten über Sprachgrenzen hinweg

Projektmerkmale:IMS-Tukan mit Hilfe vonUmfassende Sprachunterstützungist bekannt für seinen Anspruch, Sprache in über 7.000 Sprachen synthetisieren zu können. Diese beeindruckende Sprachabdeckung macht es ideal für die Entwicklung globaler Anwendungen. IMS Toucan hat außerdemSprachsynthese mit mehreren SprechernDie Funktion ist in der Lage, die Stimmcharakteristik verschiedener Sprecher zu simulieren und eine reiche Auswahl an Tönen zu bieten.

Mögliche Anwendungsszenarien: Globalisierte Anwendungsentwicklung, mehrsprachige Bildungsplattformen, Entwicklung von Sprachressourcen für seltene Sprachen, linguistische Forschung usw.

Vorteil: Extrem hohe Sprachabdeckung, Unterstützung für mehrere Sprecher, aktive Open-Source-Gemeinschaft.

Zu beachtende Aspekte: Ein so breites Spektrum an Sprachunterstützung kann bedeuten, dass die Verbesserung der Klangqualität in bestimmten Sprachen nicht so gut ist wie bei Modellen, die sich auf weniger Sprachen konzentrieren. Es wird empfohlen, praktische Tests durchzuführen, um die Wirksamkeit der Unterstützung für die Zielsprache zu bewerten.

GitHub-Adresse: https://github.com/DigitalPhonetics/IMS-Toucan

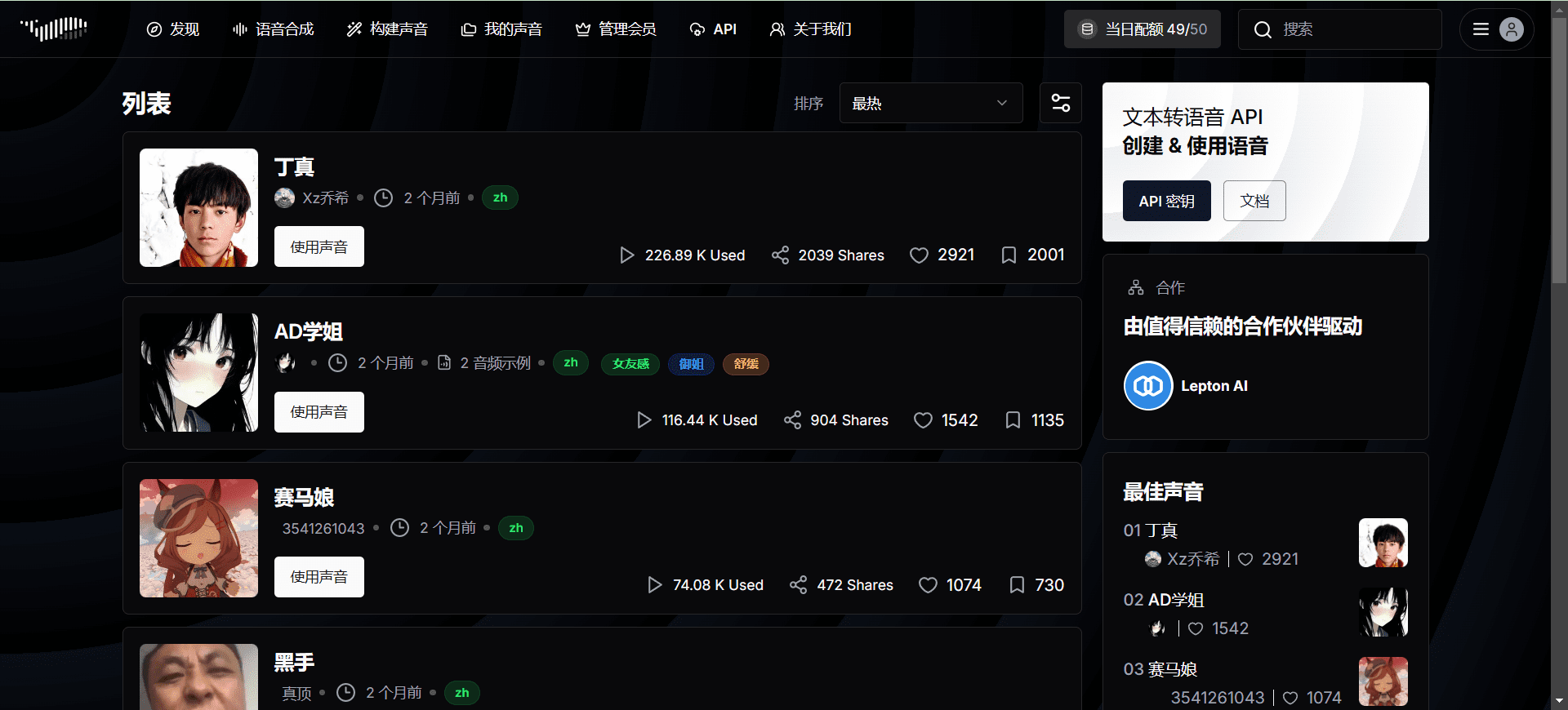

3) Fish Speech: Beherrschung der chinesischen Sprachsynthese

Projektmerkmale: Fisch-Rede sich spezialisieren aufChinesisch, Englisch und Japanischder Sprachsynthese, insbesondere inChinesische SprachverarbeitungDie Leistung ist hervorragend. Das Projekt betont, dass die Qualität der Sprachsynthese dank der Verwendung von etwa 150.000 Stunden dreisprachiger Daten für das Training nahe an die einer echten Person herankommt. Wenn Ihr Anwendungsszenario hauptsächlich auf Chinesisch ist und Sie einen hohen Anspruch an Natürlichkeit und Ausdruckskraft haben, lohnt sich ein Blick auf Fish Speech.

Mögliche Anwendungsszenarien: Chinesischer Sprachassistent, Plattform zur Erstellung chinesischer Inhalte, chinesische Hörbücher und chinesische Sprachnavigation.

Vorteil: Hervorragende Qualität der chinesischen Sprachsynthese mit hoher Natürlichkeit und freundlicher chinesischer Sprachunterstützung durch die Open-Source-Community.

Zu beachtende Aspekte: Die Sprachunterstützung konzentriert sich auf Chinesisch, Englisch und Japanisch; die Unterstützung für andere Sprachen muss möglicherweise weiter geprüft werden.

GitHub-Adresse: https://github.com/fishaudio/fish-speech

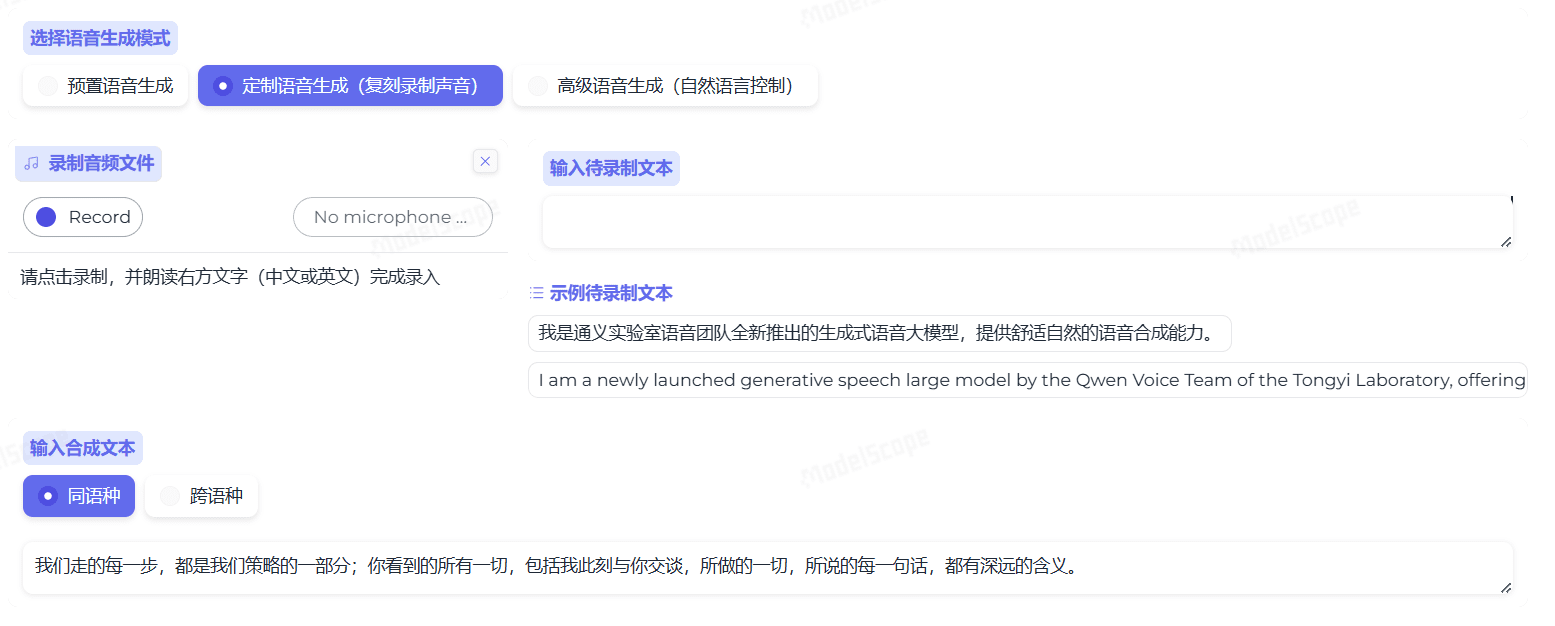

4 FunAudioLLM: Ein neues Modell für LLM-gestützte Sprachinteraktion

Projektmerkmale: FunAudioLLM wird von Alibaba als Open Source zur Verfügung gestellt. Die Innovation liegt in der tiefgreifenden Integration von TTS-Technologie und groß angelegter Sprachmodellierung (LLM) mit dem Ziel, Folgendes zu erreichenNatürlichere und reibungslosere Sprachinteraktion zwischen Menschen und LLMs. Es konzentriert sich nicht nur auf die qualitativ hochwertige Spracherzeugung, sondern betont auch die Synergie zwischen Sprachverständnis und -erzeugung in LLM-Anwendungen und erforscht die nächste Generation von Sprachinteraktionsparadigmen. Von besonderem Interesse sind dabei CosyVoice verfügt über ausgezeichnete Möglichkeiten zum schnellen Klonen von Stimmen.

Mögliche Anwendungsszenarien: Intelligente Lautsprecher der neuen Generation, intelligente Assistenten mit fortgeschrittenen Sprachinteraktionsfunktionen, LLM-basierte Dialogsysteme und intelligente Haussteuerungszentren.

Vorteil: Unterstützt von Ali, starke technische Stärke, LLM kombiniert mit der innovativen Richtung, wird erwartet, dass eine intelligente Sprach-Interaktion Erfahrung zu erreichen.

Zu beachtende Aspekte: Da es sich um ein relativ neues Projekt handelt, ist die Reife und Stabilität des Modells möglicherweise noch in der Entwicklung und Verfeinerung begriffen.

GitHub-Adresse: https://github.com/FunAudioLLM

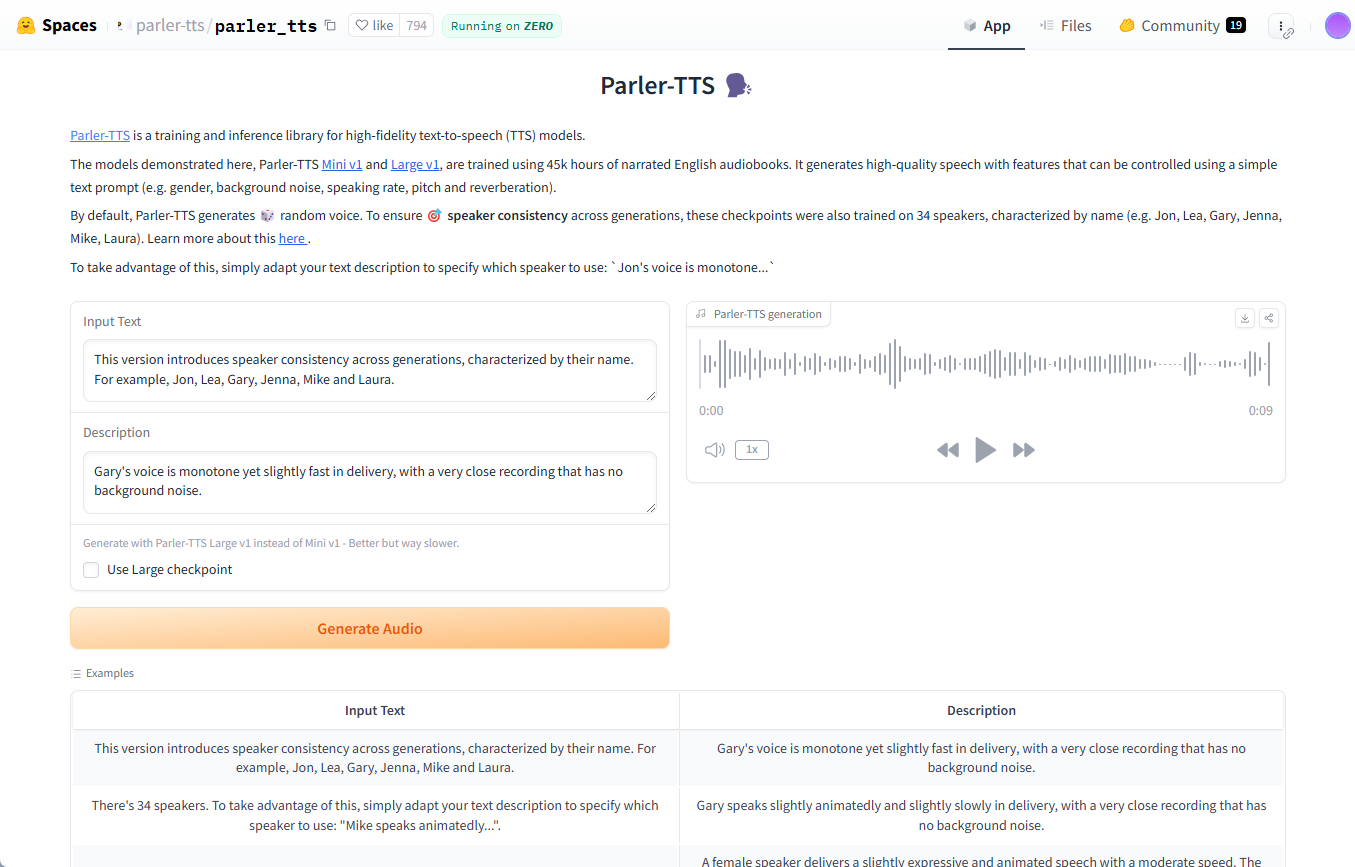

5) Parler-TTS: die Verschmelzung von leichter und stilisierter Sprache

Projektmerkmale: Parler-TTS Fokus aufLeichtgewichtsklasse (in der Leichtathletik)im Gesang antwortenStilisierte Sprachsynthese. Es erzeugt qualitativ hochwertige, natürlich wirkende Sprache, die das Geschlecht, die Tonhöhe, die Geschwindigkeit und andere personalisierte Merkmale des Zielsprechers nachahmt und gleichzeitig den Stil des Sprechers angibt. Dadurch kann Parler-TTS effizient auf Geräten mit begrenzten Ressourcen laufen und verleiht der Sprachsynthese eine persönlichere und ausdrucksvollere Note.

Mögliche Anwendungsszenarien: Mobile Anwendungen, eingebettete Systeme, Anwendungen, die personalisierte Sprache erfordern, Studien zum Klonen von Sprache und zur Migration von Stilen, usw.

Vorteil: Das Modell ist leichtgewichtig, hat einen geringen Ressourcenverbrauch, unterstützt die Erzeugung stilisierter Sprache und ist in der Lage, die Klangfarbe des Sprechers nachzuahmen.

Zu beachtende Aspekte: Da es sich um ein leichtes Modell handelt, ist es vielleicht nicht so gut wie einige der größeren Modelle, wenn es um extreme Klangqualität geht.

GitHub-Adresse: https://github.com/huggingface/parler-tts

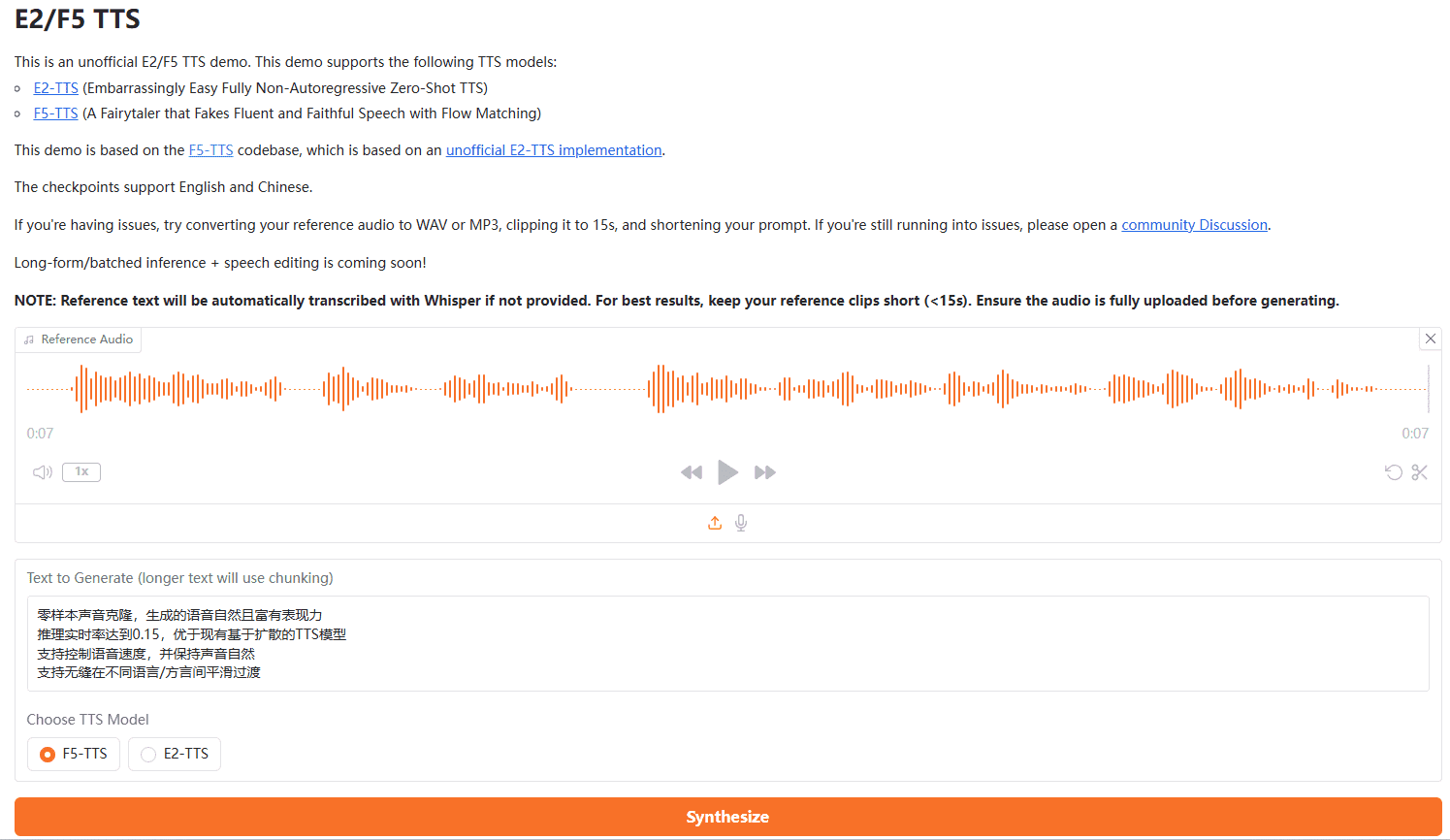

6 F5-TTS: Effizientes Klonen von Null-Samples in Echtzeit

Projektmerkmale: F5-TTS Die gemeinsam von der Shanghai Jiao Tong University und der University of Cambridge bereitgestellteKlonen von Null-Samplesim Gesang antwortenEchtzeit-Sprachsynthese. Seine Inferenz-Echtzeitrate erreicht 0,15, was bedeutet, dass die Synthesegeschwindigkeit viel schneller als in Echtzeit ist und den Anforderungen latenzempfindlicher Anwendungen gerecht wird. Darüber hinaus unterstützt der F5-TTSSprachsteuerungim Gesang antwortenReibungslose Übergänge zwischen Sprachen/DialektenRTF=0,15 bedeutet, dass für die Synthese von 1 Sekunde Sprache nur 0,15 Sekunden benötigt werden. Der Begriff "Real-Time Factor 0.15" bezieht sich in der Regel auf den Real-Time Factor (RTF), wobei die Synthese umso schneller ist, je kleiner der Wert ist; RTF=0.15 bedeutet, dass die Synthese einer 1-Sekunden-Sprache nur 0.15 Sekunden dauert.

Mögliche Anwendungsszenarien: Echtzeit-Sprachinteraktionssystem, Synchronisierung von Spielfiguren, interaktive Live-Anwendungen, mehrsprachiges Konferenzsystem, sofortige Sprachübersetzung usw.

Vorteil: Die Echtzeit-Inferenz ist schnell und unterstützt das Klonen von Stimmen ohne Samples, eine kontrollierte Sprechgeschwindigkeit und sanfte Übergänge zwischen den Sprachen.

Zu beachtende Aspekte: Die Klangqualität und das Klonen von Null-Sample-Klonen kann von der Qualität des Referenztons beeinflusst werden.

GitHub-Adresse: https://github.com/SWivid/F5-TTS

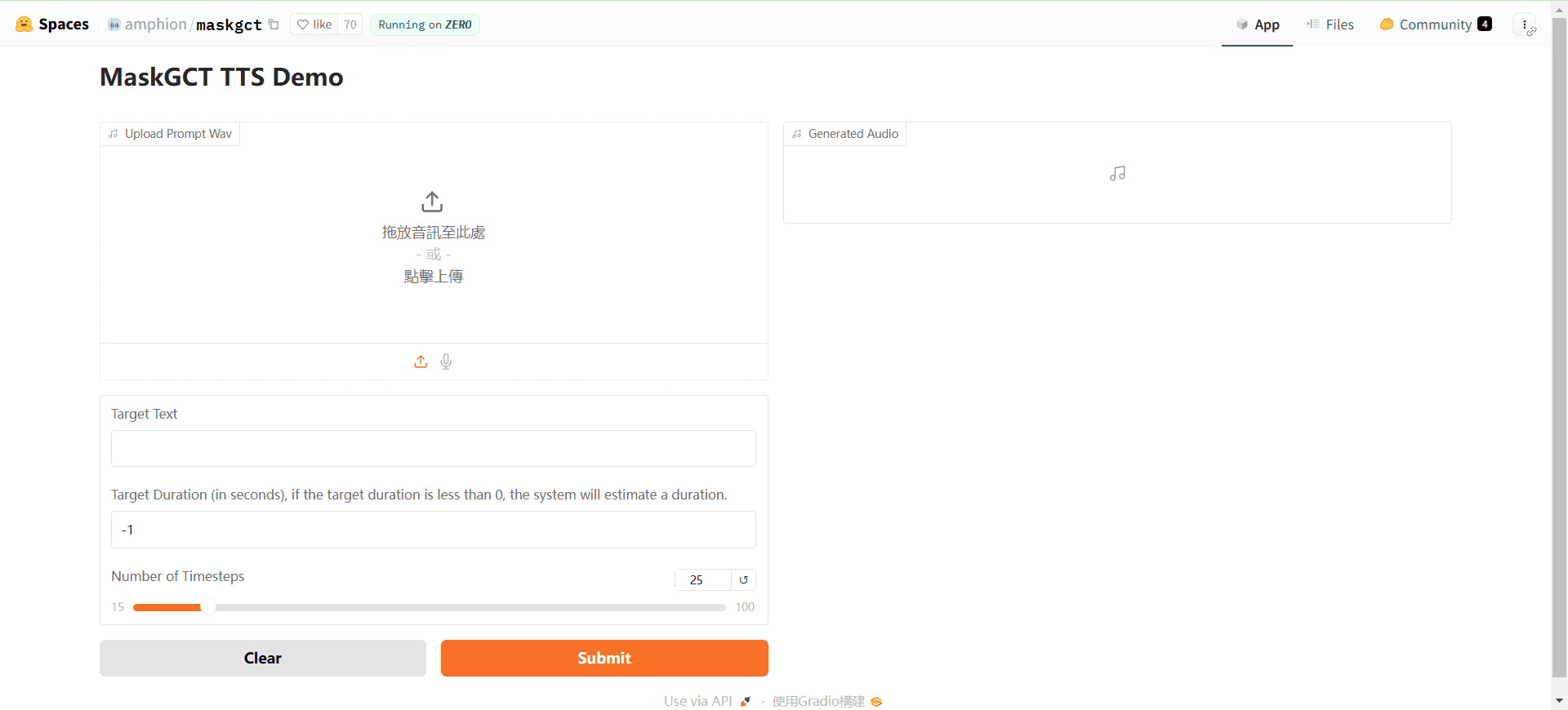

7. maskGCT: Vielseitige TTS mit Nullabtastung und nicht-autoregressiver Architektur

Projektmerkmale: MaskeGCT ist einvöllig nicht-autoregressivDas Modell TTS, das auch über ein leistungsstarkesNullprobeMerkmale. Es ist funktionsreich und unterstütztSprachübergreifende Übersetzung und Synchronisation, Sprachklonen, Sprachumwandlung, EmotionskontrolleDie nicht-autoregressive Architektur ermöglicht es, die Qualität der Synthese mit höherer Geschwindigkeit und Effizienz zu gewährleisten. Die nicht-autoregressive Architektur ermöglicht eine höhere Generierungsgeschwindigkeit und Effizienz bei gleichzeitiger Gewährleistung der Synthesequalität, während die diversifizierten Funktionen den Einsatz in einem breiteren Spektrum von Anwendungsszenarien ermöglichen.

Mögliche Anwendungsszenarien: Mehrsprachige Filmsynchronisation, Lokalisierung von Sprachinhalten, personalisierte Dienstleistungen zur Anpassung der Stimme, Technologie zum Schutz des Urheberrechts auf Sprache, emotionales Sprachinteraktionssystem, sprachübergreifende Kommunikationswerkzeuge usw.

Vorteil: Nicht-autoregressive Architektur, schnelle Generierung, reichhaltige Funktionalität, Unterstützung von Cross-Language, Klonen von Sprache, Emotionskontrolle und viele andere fortschrittliche Funktionen.

Zu beachtende Aspekte: Die Funktionalität ist komplexer und erfordert möglicherweise ein gewisses Maß an technischem Geschick, um die fortgeschrittenen Funktionen vollständig nutzen zu können.

GitHub-Adresse: https://github.com/open-mmlab/Amphion/tree/main/models/tts/maskgct

8. outeTTS (früher Smol TTS): ein leichtes und flexibles TTS für die LLaMa-Architektur

Projektmerkmale: OuteTTS (oft auch als Smol TTS bezeichnet) auf der Grundlage von LLaMa ArchitekturGebaut, um einNull-Proben-SprachklonenModelle. Seine Hauptmerkmale sind, dass es leichtgewichtig, flexibel und einfach zu implementieren und zu verwenden ist. OuteTTS ist eine lohnende Einstiegsoption für Entwickler, die das Klonen von Nullproben schnell ausprobieren, aber keine allzu komplexen Modelle verwenden möchten.

Mögliche Anwendungsszenarien: Schnelle Entwicklung von leichtgewichtigen Anwendungen, Prototyping, Anpassung von persönlichen Sprachassistenten, Experimentieren mit Techniken zum Klonen von Stimmen, usw.

Vorteil: Das auf der LLaMa-Architektur basierende Modell ist leichtgewichtig, einfach zu implementieren und unterstützt das Klonen von Null-Sample-Sprache.

Zu beachtende Aspekte: Da es sich um ein leichtgewichtiges Modell handelt, können die Klangqualität und der Funktionsreichtum relativ begrenzt sein. Artikel erscheinen oft unter den Namen OuteTTS oder Smol TTS, die sich auf denselben Artikel beziehen.

GitHub-Adresse: https://github.com/edwko/OuteTTS

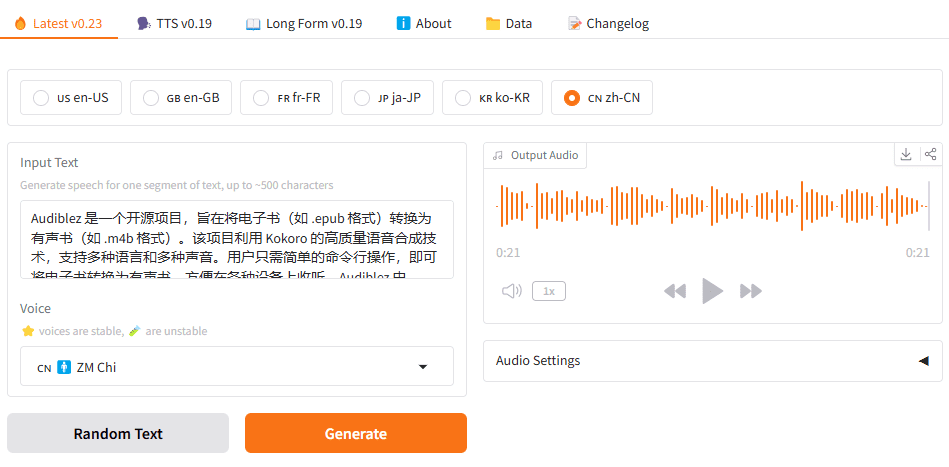

9 Kokoro: geringe Anzahl von Referenzen, kompaktes Modell mit mehrsprachiger Unterstützung

Projektmerkmale: Kokoro ist ein relativ kleines Open-Source-TTS-Modell mit nur 82 Millionen Parametern, das mit einem relativ kleinen Audiodatensatz trainiert wurde. Trotz der geringen Größe des Modells, zeigt Kokoro immer noch guteUnterstützung mehrerer SprachenFähigkeiten, was das Potenzial von Miniaturen im Bereich der mehrsprachigen TTS zeigt. Kokoro kann eine praktikable Option sein, wenn mehrsprachige TTS-Funktionen in ressourcenbeschränkten Umgebungen eingesetzt werden müssen.

Mögliche Anwendungsszenarien: Anwendungen für Geräte mit geringen Ressourcen, eingebettete Systeme, schnell einsetzbare mehrsprachige Funktionen, kostensensitive TTS-Lösungen und vieles mehr.

Vorteil: Das Modell hat eine geringe Teilnehmerzahl, erfordert nur wenige Ressourcen, unterstützt mehrere Sprachen und ist einfach zu implementieren.

Zu beachtende Aspekte: Begrenzt durch die Größe des Modells und die Menge der Trainingsdaten, können Klangqualität und Natürlichkeit hinter größeren Modellen zurückbleiben.

GitHub-Adresse: https://github.com/hexgrad/kokoro

10. llasa: Technologie zum Klonen von Sprache mit hoher Wiedergabetreue bei Null-Proben

Projektmerkmale: Llasa ist ein Open-Source-Audio-Labor der Hong Kong University of Science and Technology.Klonen von Null-Sample-Sprache und TTS-ModellierungLlasa unterstützt sowohl die Generierung von Sprache aus Klartext als auch hochpräzises Klonen unter Verwendung einer gegebenen Referenzsprache. Es unterstützt sowohl die Spracherzeugung aus Klartext als auch das hochpräzise Klonen von Sprache unter Verwendung einer gegebenen Referenzsprache.Originaltreue und Natürlichkeit des SprachklonensLlasa ist eine Technologie zum Klonen von Stimmen, die eine äußerst realistische Tonwiedergabe unter Null-Sample-Bedingungen anstrebt. Wenn Sie hohe Ansprüche an die Qualität der Stimmklontechnik haben, lohnt es sich, Llasa zu studieren und anzuwenden.

Mögliche Anwendungsszenarien: Hochpräzises Klonen von Stimmen, Synchronisieren von Charakteren und Anpassen von Stimmen, Erstellen von personalisierten Sprachinhalten, Schutz des Urheberrechts für Sprachinhalte, emotionale Sprachsynthese usw.

Vorteil: Qualitativ hochwertiges Null-Sample-Sprachklonen mit hoher Sprachnatürlichkeit und -ähnlichkeit, produziert vom Audio-Labor der Hong Kong University of Science and Technology mit großer technischer Stärke.

Zu beachtende Aspekte: Größere Modellgrößen (1 Milliarde Parameter) können höhere Anforderungen an die Rechenressourcen stellen.

Modell-Download-Adresse: https://huggingface.co/HKUSTAudio/Llasa-1B

Wie wählt man das richtige Open-Source-TTS-Projekt für sich aus?

Bei so vielen großartigen Open-Source-TTS-Projekten ist es entscheidend, dasjenige auszuwählen, das Ihren Anforderungen am besten entspricht. Hier sind einige wichtige Überlegungen, die Ihnen helfen, eine fundierte Entscheidung zu treffen:

- Sprachabdeckung: Welche Sprachen muss Ihre Anwendung unterstützen? Es werden Projekte bevorzugt, die die Zielsprache unterstützen.

- Qualität und Natürlichkeit der Stimme: Welche Erwartungen haben Sie an die Klangqualität und Natürlichkeit der synthetischen Sprache? Es wird empfohlen, sich die von den einzelnen Projekten bereitgestellten Demos anzuhören, um einen visuellen Eindruck von den Spracheffekten der verschiedenen Modelle zu erhalten und eine umfassende Bewertung durch die Kombination von subjektiven Bewertungsmaßstäben (z. B. MOS - Mean Opinion Score) und objektiven Bewertungsdaten vorzunehmen.

- Funktionale Merkmale Anforderungen: Benötigt Ihre Anwendung erweiterte Funktionen wie Zero-Sample-Cloning, mehrere Sprecher, Emotionskontrolle, Anpassung der Sprechgeschwindigkeit usw.? Wählen Sie einen Artikel mit den entsprechenden Funktionen auf der Grundlage Ihrer tatsächlichen Anforderungen.

- Überlegungen zu Leistung und Effizienz: Bestehen für Ihr Anwendungsszenario Echtzeitanforderungen? Welche Beschränkungen bestehen hinsichtlich der Inferenzgeschwindigkeit und des Ressourcenverbrauchs der Modelle? Für interaktive Echtzeitanwendungen müssen beispielsweise Modelle mit hoher Inferenzgeschwindigkeit gewählt werden; für Geräte mit eingeschränkten Ressourcen müssen leichtgewichtige Modelle in Betracht gezogen werden.

- Verbesserung der Benutzerfreundlichkeit und der Dokumentation: Ist die Dokumentation des Projekts gründlich und leicht verständlich? Bietet es eine einfache Bereitstellung und Nutzung? Für unerfahrene Entwickler kann die Wahl eines Projekts mit klarer Dokumentation und einfachem Einstieg die Lernkosten effektiv senken.

- Gemeinschaftsaktivitäten und Instandhaltung: Ist die Open-Source-Gemeinschaft des Projekts aktiv? Gibt es laufende Aktualisierungen und Wartungsarbeiten? Eine aktive Gemeinschaft bedeutet in der Regel eine schnellere technische Unterstützung und schnellere Iterationen.

- Lizenzvereinbarung: Achten Sie immer auf die Open-Source-Lizenzvereinbarung des Projekts, um herauszufinden, ob die kommerzielle Nutzung erlaubt ist und ob die kommerzielle Nutzung bestimmten Bedingungen unterliegt. Zu den gängigen Open-Source-Lizenzen gehören die MIT-Lizenz, die Apache-2.0-Lizenz, die GPL-Lizenz usw. Verschiedene Lizenzen haben unterschiedliche Einschränkungen für die kommerzielle Nutzung.

- Anforderungen an die Hardware-Ressourcen: Verschiedene TTS-Modelle haben unterschiedliche Anforderungen an die Hardware-Ressourcen. Einige große Modelle benötigen Hochleistungs-GPUs, um reibungslos zu laufen, während leichtgewichtige Modelle in einer CPU-Umgebung laufen können. Wählen Sie das richtige Modell je nach Ihren Hardware-Bedingungen.

Wir empfehlen Ihnen, die oben genannten Faktoren zu kombinieren und jedes Projekt entsprechend Ihrem spezifischen Anwendungsszenario und Ihren technischen Möglichkeiten sorgfältig zu bewerten und zu testen. Viele der Projekte bieten vortrainierte Modelle und Demo-Beispiele, so dass Sie sie ausprobieren und das Projekt auswählen können, das Ihren Anforderungen am besten entspricht.

Schlussbemerkungen

Die Verbreitung von Open-Source-TTS-Projekten hat die Innovation in der Sprachtechnologie vorangetrieben und den Entwicklern eine Fülle von Auswahlmöglichkeiten geboten. Egal, ob Sie ein kommerzieller Entwickler, ein akademischer Forscher oder ein Technologie-Enthusiast sind, Sie können in der Open-Source-Community die ideale Sprach-Engine finden, um Ihrer Anwendung eine lebendigere und natürlichere Sprachinteraktion zu ermöglichen. Mit dem kontinuierlichen Fortschritt der Technologie ist zu erwarten, dass in Zukunft weitere Innovationen im Open-Source-TTS-Bereich auftauchen werden und die Popularität und Anwendung der Sprachtechnologie weiter fördern.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...