FREE!!! Github schließt sich mit Azure zusammen, um Entwicklern die wichtigsten Closed-Source-Open-Source-Modell-API-Aufrufe, einschließlich o1, kostenlos zur Verfügung zu stellen

Der dichte Code auf dem Bildschirm war mit Konfigurationsinformationen für verschiedene Modell-APIs durchsetzt, und der Kaffee auf dem Tisch war längst kalt geworden.

Dies ist ein wahres Abbild dessen, was viele Entwickler erleben, wenn sie versuchen, KI-Anwendungen zu erstellen: umständliche Umgebungskonfiguration, kostspielige APIs und unzureichende Dokumentationsunterstützung ......

"Wie großartig wäre es, eine einheitliche Plattform zu haben, die es allen Entwicklern leicht macht, eine Vielzahl von KI-Modellen zu nutzen."

Dieser Wunsch ist heute endlich in Erfüllung gegangen.

GitHub hat offiziell den Dienst GitHub Models gestartet, der über 100 Millionen Entwicklern weltweit eine Revolution in der KI-Entwicklung ermöglicht.

Lassen Sie uns einen Blick auf dieses bahnbrechende neue Produkt werfen.

Eine stille Revolution der Entwicklung

Die Rolle des Entwicklers ändert sich in der sich schnell entwickelnden Welt der KI grundlegend.GitHub hat offiziell den GitHub Copilot Free Plan angekündigt, der jetzt für alle Nutzer verfügbar ist!

Der Wechsel vom traditionellen "Programmierer" zum "KI-Ingenieur" ist nicht nur eine Änderung der Berufsbezeichnung, sondern eine Revolution des gesamten Paradigmas der Softwareentwicklung.

Die Entstehung der GitHub-Modelle steht für diesen historischen Wendepunkt.

Warum GitHub-Modelle?

Nicht mehr nötig, wenn Sie KI-Modelle in Ihren Projekten verwenden müssen:

- Wechseln zwischen Plattformen, um das richtige Modell zu finden

- Konfigurieren Sie verschiedene Umgebungen und Abhängigkeiten für jedes Modell

- Besorgnis über hohe Kosten für API-Aufrufe

- Sich durch komplexe Bereitstellungsprozesse verzetteln

All diese Probleme sind in GitHub Models elegant gelöst.

Leistungsstarke Modelle auf Tastendruck

Die Modellpalette ist deluxe

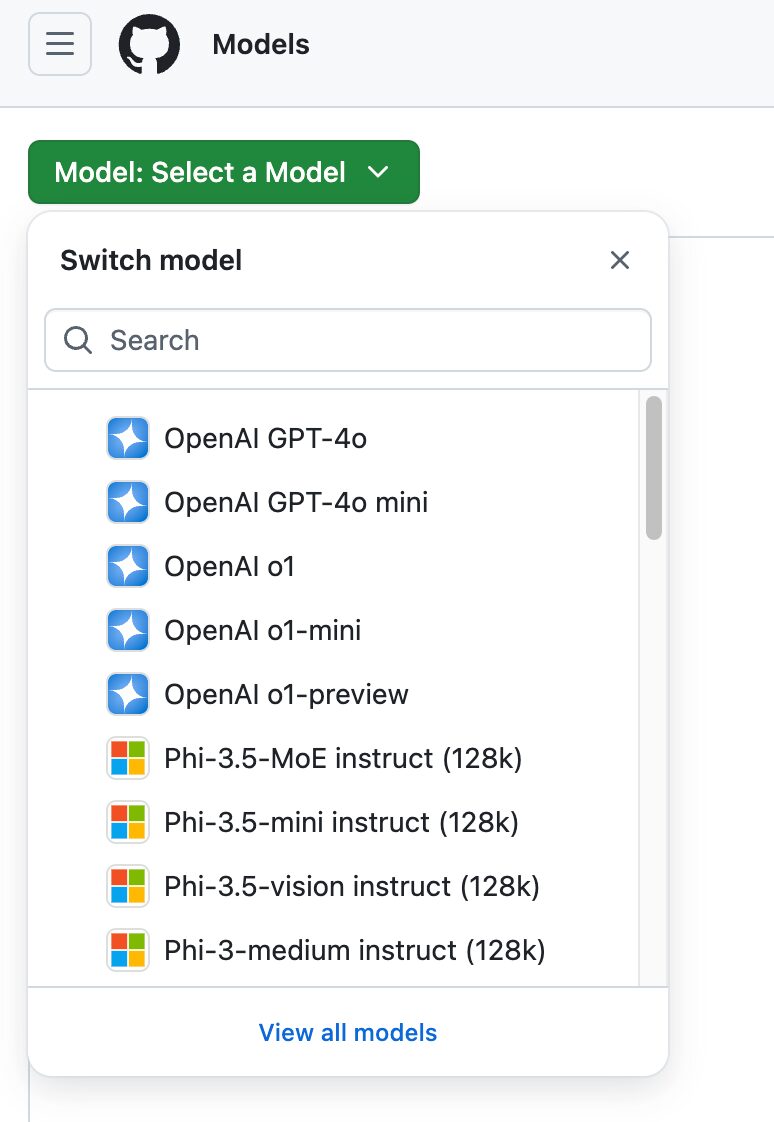

GitHub Models bietet eine beeindruckende Bibliothek von Modellen:

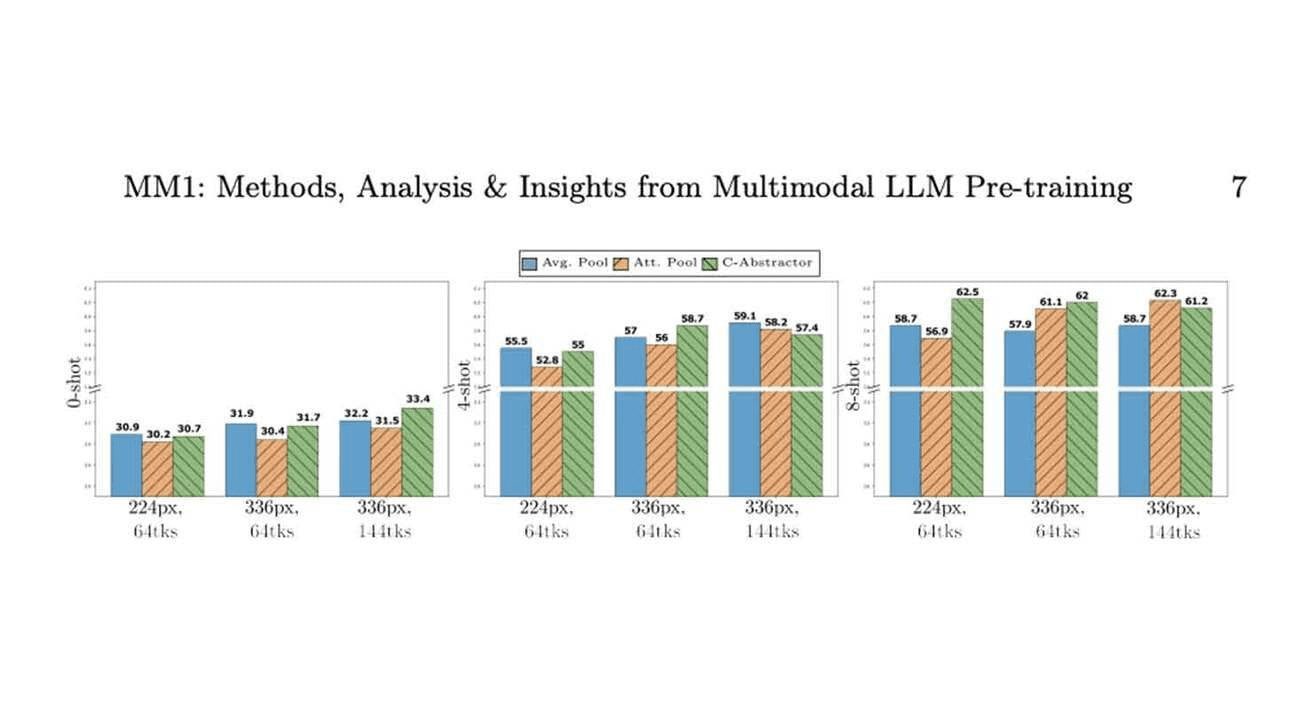

- Llama 3.1: Metas neuestes quelloffenes Großmodell glänzt in mehreren Benchmarks

- GPT-4o: eines der leistungsfähigsten kommerziellen Modelle von OpenAI mit Unterstützung für multimodale Eingaben

- GPT-4o mini: eine leichtere Version für Anwendungen, die eine schnelle Reaktionszeit erfordern

- Phi 3: Microsofts effizientes Modell, das bei bestimmten Aufgaben erstaunlich gut abschneidet

- Mistral Large 2: Bekannt für niedrige Latenzzeiten, geeignet für die Entwicklung von Echtzeitanwendungen

Jedes Modell hat seine eigenen Vorteile, und die Entwickler können sich für das Modell entscheiden, das ihren spezifischen Anforderungen am besten entspricht.

Erstaunlich einfach zu bedienen

Imdoaa aus unserer Gruppe, ein technischer Leiter eines Start-ups, berichtete von seinen Erfahrungen mit GitHub Models:

"Früher bereitete uns die Auswahl und das Testen von KI-Modellen besonderes Kopfzerbrechen. Entweder mussten wir hohe Gebühren zahlen oder viel Zeit für die Bereitstellung von Open-Source-Modellen aufwenden. Mit GitHub Models gibt es keines dieser Probleme mehr. Wir können die Ergebnisse verschiedener Modelle in der Spielwiese schnell vergleichen und das Modell finden, das unseren Anforderungen am besten entspricht. Das Beste daran ist, dass der gesamte Prozess vom Experimentieren bis zur Bereitstellung innerhalb des GitHub-Ökosystems abläuft und die Erfahrung unglaublich reibungslos ist."

Vertieftes Verständnis der drei Kernkompetenzen

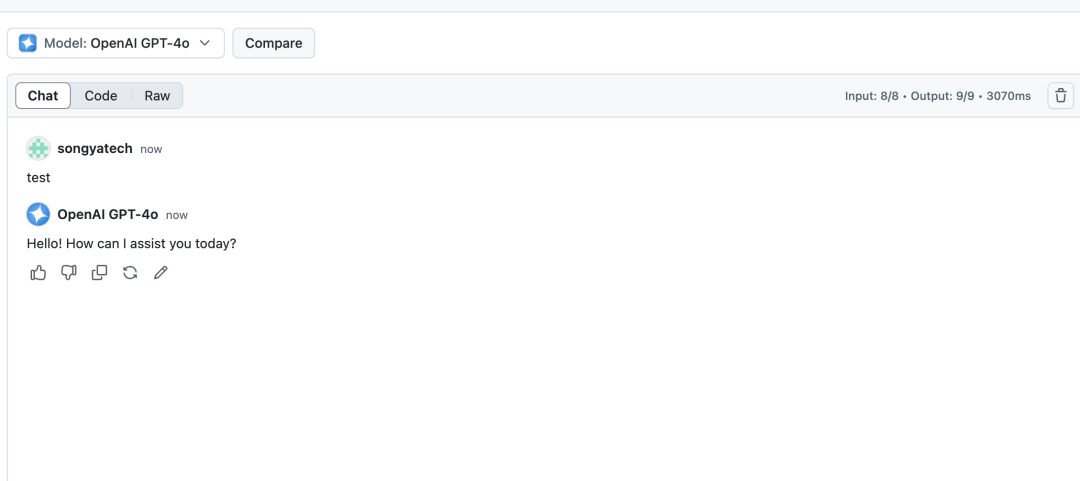

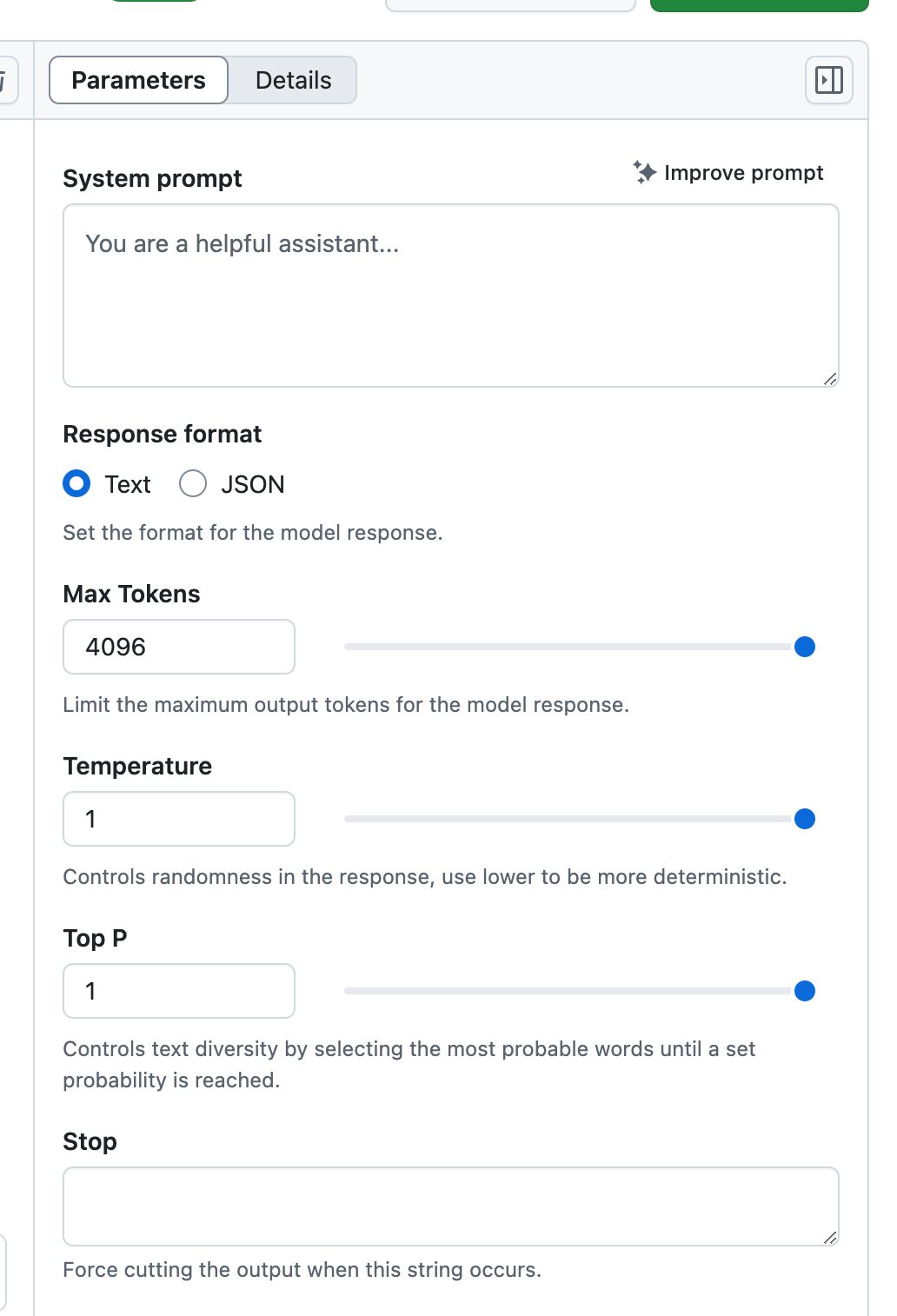

1. revolutionäre Spielplatzumgebung

Playground ist mehr als eine einfache Modelltestumgebung, es ist ein komplettes KI-Labor:

- Anpassung der Parameter in Echtzeit::

- Temperaturkontrolle

- Einstellung der maximalen Tokenanzahl

- Anpassung der Top-p-Probenahme

- Optimierung der Systemaufforderungen

- Multimodell-Vergleich::

Für Vergleichstests können mehrere Modelle gleichzeitig geöffnet werden, um die Leistungsunterschiede zwischen verschiedenen Modellen mit denselben Eingaben zu veranschaulichen. - Geschichte Sparen::

Alle Versuchsverfahren werden zur späteren Überprüfung und Optimierung aufgezeichnet.

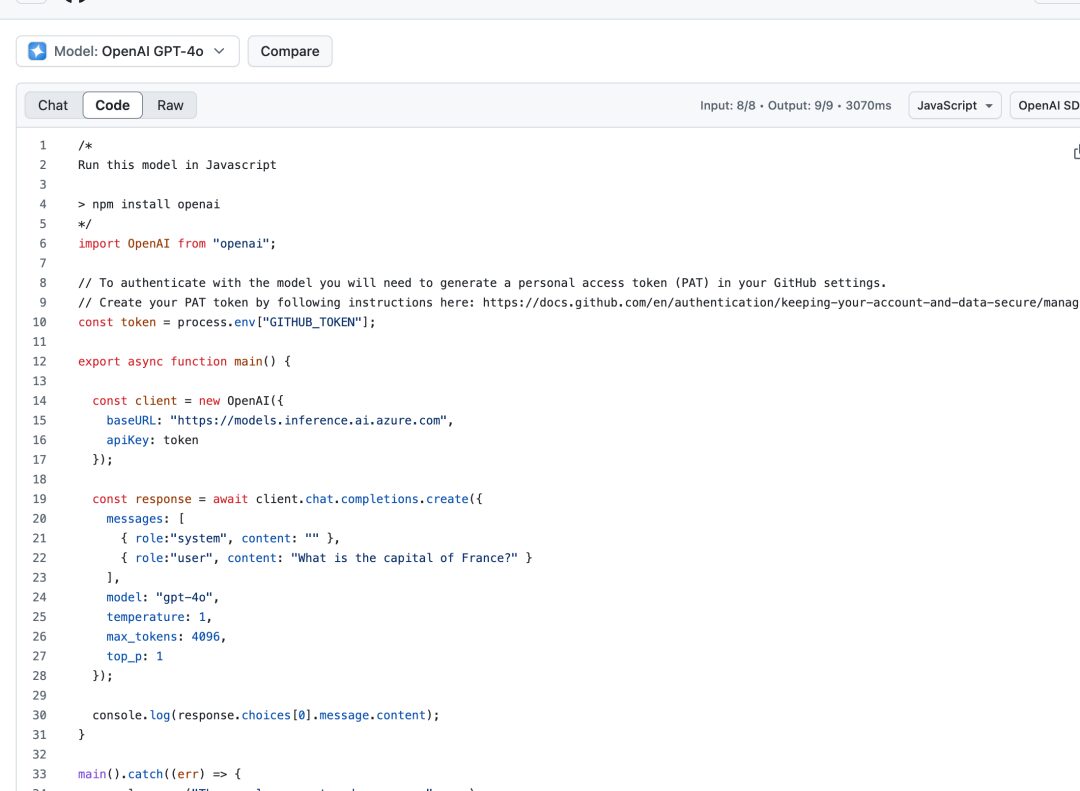

2. nahtlose Integration von Codespaces

Die Integration von Codespaces macht den Entwicklungsprozess unglaublich reibungslos:

- Vorkonfigurierte Umgebung::

Alle erforderlichen Abhängigkeiten und Konfigurationen sind sofort einsatzbereit. - Unterstützung mehrerer Sprachen::

Enthält Beispielcode und SDK für Python, JavaScript, Java und andere gängige Sprachen.

- Versionskontrolle::

Die direkte Integration mit GitHub-Repositories erleichtert die Verwaltung von Codeänderungen.

3. sichere Bereitstellung auf Unternehmensebene

Mit der Unterstützung von Azure AI werden Implementierungen auf Unternehmensebene einfach und zuverlässig:

- Globaler Einsatz::

Mehr als 25 Azure-Regionen zur Auswahl, die einen schnellen Zugang für Nutzer weltweit gewährleisten. - Einhaltung der Sicherheitsvorschriften::

Entspricht den Sicherheitsstandards von Unternehmen und unterstützt Datenverschlüsselung und Zugriffskontrolle. - Skalierbarkeit::

Automatische Skalierung der Ressourcen auf der Grundlage der Nachfrage, um die Stabilität der Dienste zu gewährleisten.

Eingehende Analyse der Anwendung von Quoten

Die Gestaltung der Nutzungsquoten für die verschiedenen Versionen spiegelt die Produktstrategie von GitHub wider:

Kostenlose Version und Copilot Individual

- Abfragen pro Minute: 10

- Tagesquote: 50

- Token-Beschränkungen:

- Eingang: 8000

- Leistung: 4000

- Gleichzeitige Anfragen: 2

Dieses Kontingent ist für einzelne Entwickler zur Projektvalidierung und zum Lernen geeignet.

Copilot Business

- Beibehaltung der Gleichzeitigkeits- und Tokengrenzen

- Tägliche Anfragen auf 100 erhöht

- Geeignet für die Entwicklungsbedürfnisse von kleinen Teams

Copilot Unternehmen

- Abfragen pro Minute: 15

- Tagesquote: 150

- Größere Token-Grenze:

- Eingabe: 16000

- Leistung: 8000

- Gleichzeitige Anfragen: 4

- Geeignet für die Anwendungsentwicklung auf Unternehmensebene

Praktische Tipps

Tipps zur Verbesserung der Entwicklungseffizienz

- Intelligente Caching-Politik

# 示例代码:实现简单的结果缓存 import hashlib import json class ModelCache: def __init__(self): self.cache = {} def get_cache_key(self, prompt, params): data = f"{prompt}_{json.dumps(params, sort_keys=True)}" return hashlib.md5(data.encode()).hexdigest() def get_or_compute(self, prompt, params, model_func): key = self.get_cache_key(prompt, params) if key in self.cache: return self.cache[key] result = model_func(prompt, params) self.cache[key] = result return result - Optimierung der Chargenverarbeitung

Organisieren Sie Anfragestapel sinnvoll, um häufige API-Aufrufe zu vermeiden. - Bewährte Praktiken der Fehlerbehandlung

Implementierung eines intelligenten Wiederholungsmechanismus zur Bewältigung vorübergehender Ausfälle.

Sicherheitsempfehlungen

- Verwaltung von Zugangstoken

- Regelmäßige Rotation Persönlicher Zugang Token

- Anwendung des Prinzips der geringsten Privilegien

- Vermeiden Sie die feste Kodierung von Token im Code

- Datensicherheit

- Daten vor dem Senden an das Modell desensibilisieren

- Ermöglichung von Datenzugriffsprüfungen

- Regelmäßige Überprüfung der Sicherheitsprotokolle

Blick nach vorn

Thomas Dohmke, CEO von GitHub, hat die Vision, die Welt dabei zu unterstützen, in den nächsten Jahren das Ziel von 1 Milliarde Entwicklern zu erreichen. Hinter dieser Ambition steht der feste Glaube an die Demokratisierung von KI.

Beginnen Sie Ihre Reise als AI Engineer noch heute!

- Vorbereitung der Bewerbung

- Besuchen Sie die offizielle GitHub Models Seite

- Antrag auf eine Warteliste einreichen

- GitHub-Konto und persönliches Zugangs-Token vorbereiten

- Umgebung Konfiguration

import OpenAI from "openai"; const token = process.env["GITHUB_TOKEN"]; const client = new OpenAI({ baseURL: "https://models.inference.ai.azure.com", apiKey: token }); - Starten Sie das Experiment

- Testen verschiedener Modelle auf dem Spielplatz

- Schnellstartprojekt mit Beispielcode

- Schrittweise Erweiterung der Anwendungsfunktionalität

Schlussbemerkungen

Die Entwicklung der KI-Technologie gestaltet die Zukunft der Softwareentwicklung neu. Die Einführung von GitHub Models ist mehr als nur die Geburt eines neuen Produkts, es ist der Beginn einer neuen Ära. Es gibt jedem Entwickler die Möglichkeit, sich an der KI-Revolution zu beteiligen und die Welt mit innovativen Ideen und Praktiken zu verändern.

Jetzt stellt sich nicht mehr die Frage, ob Sie mit der KI-Entwicklung beginnen sollen, sondern wie Sie die leistungsstarke Plattform von GitHub Models besser nutzen können, um auf dem Weg zum KI-Ingenieur weiterzukommen. Die Gelegenheit ist da, sind Sie bereit?

Ein erfahrener Entwickler sagte: "GitHub Models ist nicht nur ein Tool, sondern ein Schlüssel zum KI-Zeitalter. Damit kann jeder Entwickler zum KI-Ingenieur werden und jede Idee kann Wirklichkeit werden".

Jetzt ist es an der Zeit, Ihre KI-Entwicklungsreise zu beginnen.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...