MathCLUE: DeepSeek R1 fordert "Nationalen Highschool-Mathematikwettbewerb" heraus und übertrifft o1 dramatisch

Einführung in MathCLUE "National High School Mathematics Competition": Eine eingehende Bewertung der Fähigkeit zum mathematischen Denken auf Wettbewerbsebene in großen Modellen. Das Bewertungssystem deckt eine Reihe repräsentativer Dimensionen der Highschool-Mathematik ab, darunter Geometrie, Algebra und Wahrscheinlichkeitsstatistik.

🔥 Messmodell: DeepSeek-R1 (Zugriff über chat.deepseek.com)

DeepSeek-R1 Bewertung und Analyse

🔍 DeepSeek-R1 führt die MathCLUE-Liste der nationalen Mathematikwettbewerbe für Gymnasien an

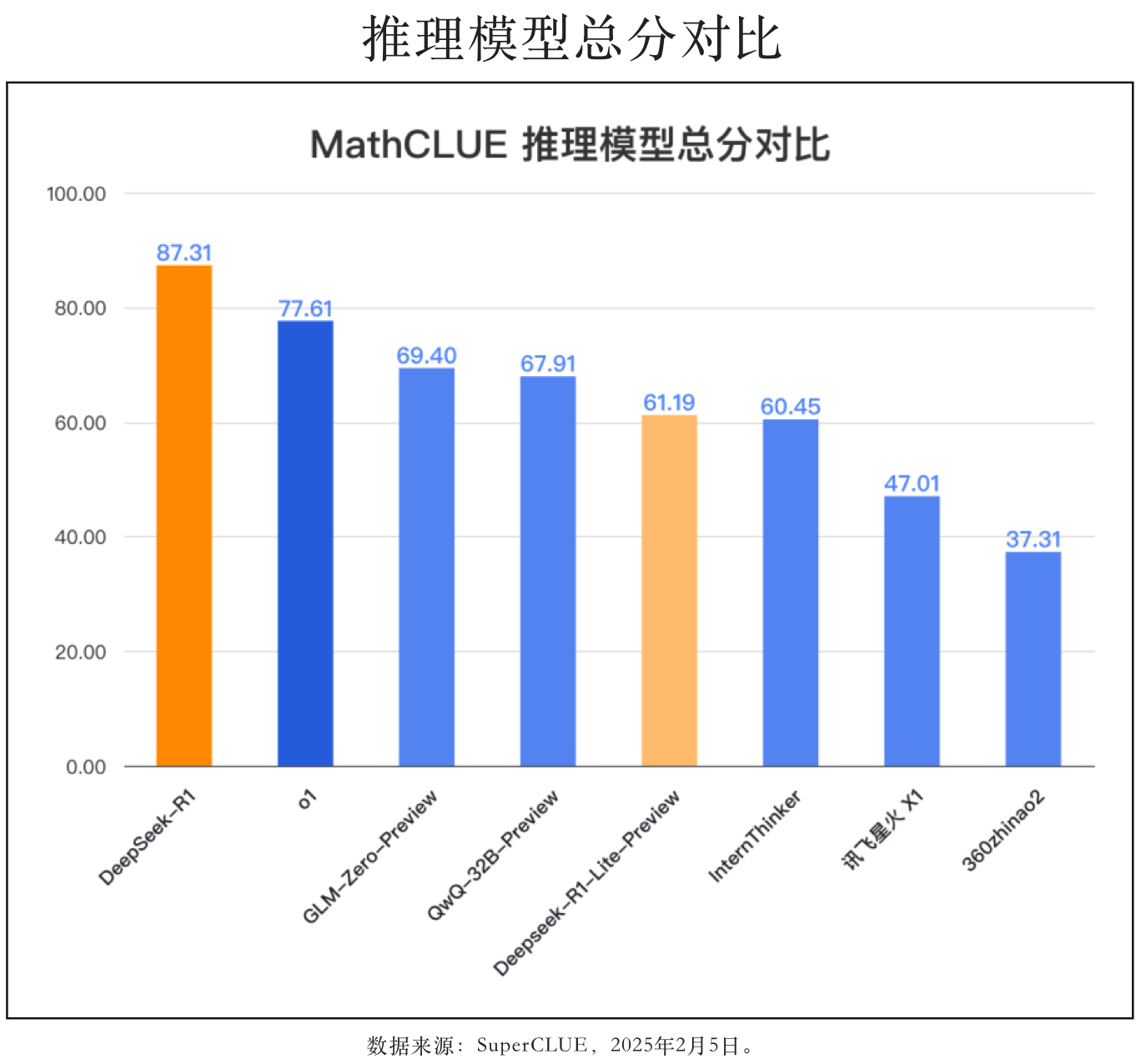

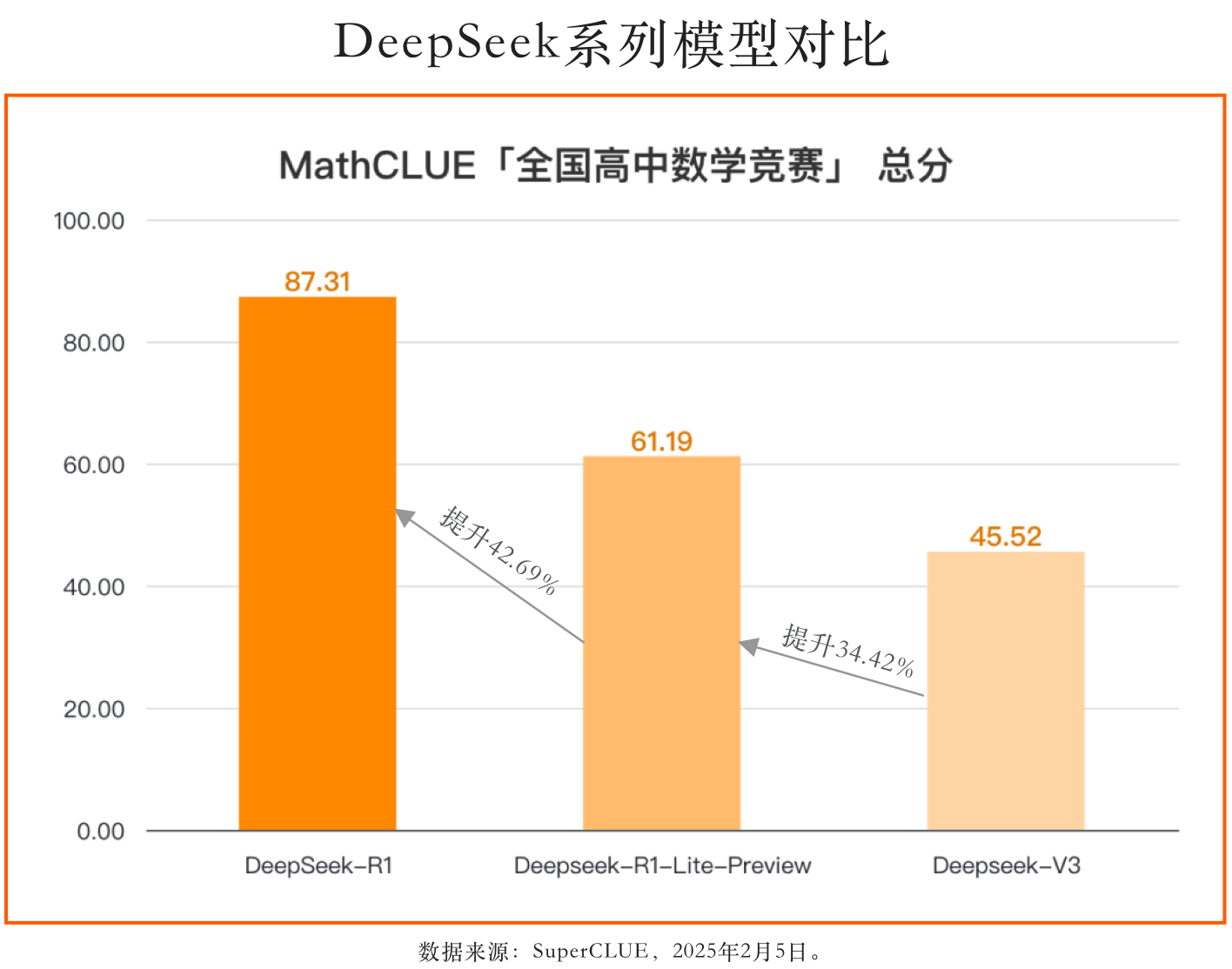

DeepSeek-R1 führt die Bewertungsliste des nationalen High-School-Mathematikwettbewerbs mit einer ausgezeichneten Punktzahl von 87,31 Punkten an und liegt damit fast 10 Punkte vor dem weltweiten Spitzenmodell o1. Im Vergleich zu DeepSeek-R1-Lite-Preview, das sich um 26,12 Punkte verbessert hat, ist die Gesamtpunktzahl erheblich gestiegen, und die Fähigkeit zum mathematischen Denken und zur Problemlösung hat ein neues Niveau erreicht.

Inzwischen sind die Ergebnisse des Qwen2.5-Max "National High School Maths Competition" bekannt! Die Erwartungen nicht erfüllt, mit Begründung

🔥 Bewertungsmodell: Qwen2.5-Max

Rufen Sie die offizielle API-Versionsbezeichnung auf: qwen-max-2025-01-25

Qwen2.5-Max Bewertung und Analyse

🔍Qwen2.5-Max hat noch Verbesserungspotenzial auf der MathCLUE-Liste

Qwen2.5-Max erzielte 33,58 Punkte und belegte den 9. Platz im nationalen Mathematikwettbewerb für Gymnasien, noch vor berühmten Modellen aus Übersee. Claude 3.5 Sonnet (20241022) 15,67 Punkte, hat aber immer noch Raum für Verbesserungen (mit einem Abstand von mehr als 30 Punkten) im Vergleich zu den wichtigsten großen Modellen im In- und Ausland.

Wir haben die Leistung des Modells im Hinblick auf seine falschen Fragen eingehend analysiert. Es hat sich herausgestellt, dass das Modell den Lösungsprozess auslässt und bei einigen Rätseln direkt falsche Antworten gibt, und dass diese Bewertung nur auf der Grundlage der endgültigen Antworten erfolgt, was der Hauptgrund für seine niedrige Punktzahl sein könnte.

Bewertungen

MathCLUE National High School Maths Competition Review Set. Deckt die Fragen des National High School Mathematics Competition 2024 ab und entwickelt eine strenge Bewertung des Big Model.

Methodik

Die Methode, bei der festgestellt wird, ob die endgültige Antwort mit der Referenzantwort des Makromodells auf die Bewertungsaufgabe übereinstimmt, um die Korrektheit (richtig oder falsch) des Makromodells in Bezug auf eine Frage zu bestätigen, gewährleistet eine vollständige Objektivität der Bewertung.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...