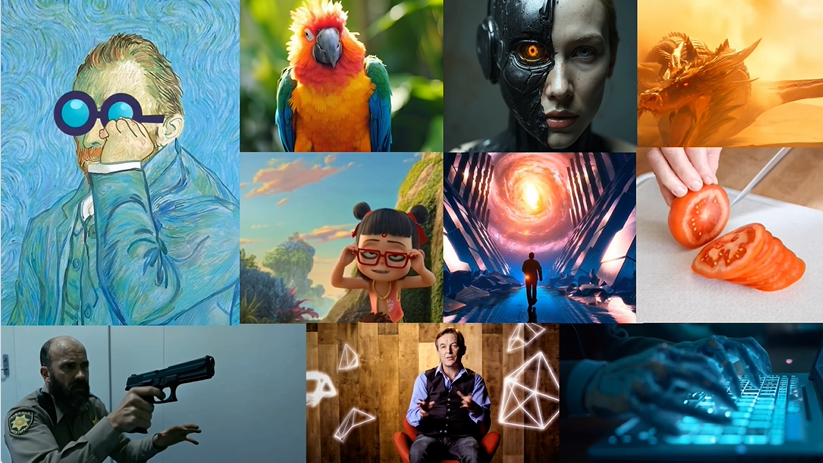

Magic 1-For-1: effizientes Open-Source-Projekt zur Erstellung von Videos, das behauptet, ein einminütiges Video in einer Minute zu erstellen

Allgemeine Einführung

Magic 1-For-1 ist ein effizientes Modell zur Videogenerierung, das die Speichernutzung optimiert und die Latenzzeit bei der Inferenz verringert. Magic 1-For-1 kann qualitativ hochwertige einminütige Videoclips in weniger als einer Minute für Szenarien erzeugen, in denen kurze Videos schnell erzeugt werden müssen. Das Projekt wurde von Forschern der Universität Peking, Hedra Inc. und Nvidia entwickelt, und der Code und die Modellgewichte sind auf GitHub öffentlich zugänglich.

Funktionsliste

- Text-zu-Bild-Generierung: Konvertiert die eingegebene Textbeschreibung in ein Bild.

- Bild-zu-Video-Generierung: Konvertieren Sie generierte Bilder in Videoclips.

- Effiziente Speichernutzung: Optimiert die Speichernutzung für Umgebungen mit nur einer GPU.

- Schnelle Inferenz: Verringerung der Inferenzlatenz für eine schnelle Videogenerierung.

- Download von Modellgewichten: Hier finden Sie Links zum Download von bereits trainierten Modellgewichten.

- Umgebungseinrichtung: Hier finden Sie eine detaillierte Anleitung zur Einrichtung der Umgebung und zur Installation von Abhängigkeiten.

Hilfe verwenden

Umgebungseinstellungen

- Installieren Sie git-lfs:

sudo apt-get install git-lfs

- Die Conda-Umgebung wird erstellt und aktiviert:

conda create -n video_infer python=3.9

conda activate video_infer

- Installieren Sie die Projektabhängigkeiten:

pip install -r requirements.txt

Download Modellgewichte

- Erstellen Sie ein Verzeichnis zum Speichern der trainierten Gewichte:

mkdir pretrained_weights

- Download Magische 1-für-1-Gewichte:

wget -O pretrained_weights/magic_1_for_1_weights.pth <model_weights_url>

- Laden Sie die Komponente "Hugging Face" herunter:

huggingface-cli download tencent/HunyuanVideo --local_dir pretrained_weights --local_dir_use_symlinks False

huggingface-cli download xtuner/llava-llama-3-8b-v1_1-transformers --local_dir pretrained_weights/text_encoder --local_dir_use_symlinks False

huggingface-cli download openai/clip-vit-large-patch14 --local_dir pretrained_weights/text_encoder_2 --local_dir_use_symlinks False

Video generieren

- Führen Sie die folgenden Befehle für die Text- und Bild-zu-Video-Generierung aus:

python test_ti2v.py --config configs/test/text_to_video/4_step_ti2v.yaml --quantization False

- Oder verwenden Sie das mitgelieferte Skript:

bash scripts/generate_video.sh

Detaillierte Funktionsabläufe

- Text-zu-Bild-GenerierungGeben Sie eine Textbeschreibung ein und das Modell generiert ein entsprechendes Bild.

- Bild-zu-Video-GenerierungEingabe der generierten Bilder in das Videogenerierungsmodul, um kurze Videoclips zu erstellen.

- Effiziente SpeichernutzungGewährleistung eines effizienten Betriebs auch in Umgebungen mit nur einer GPU durch Optimierung der Speichernutzung.

- schnelle InferenzReduzierung der Inferenzverzögerung und schnelle Videogenerierung für Szenarien, die eine schnelle Generierung von kurzen Videos erfordern.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...