LM-Geschwindigkeit: Schnelles Testen der API-Leistung großer Modelle

Allgemeine Einführung

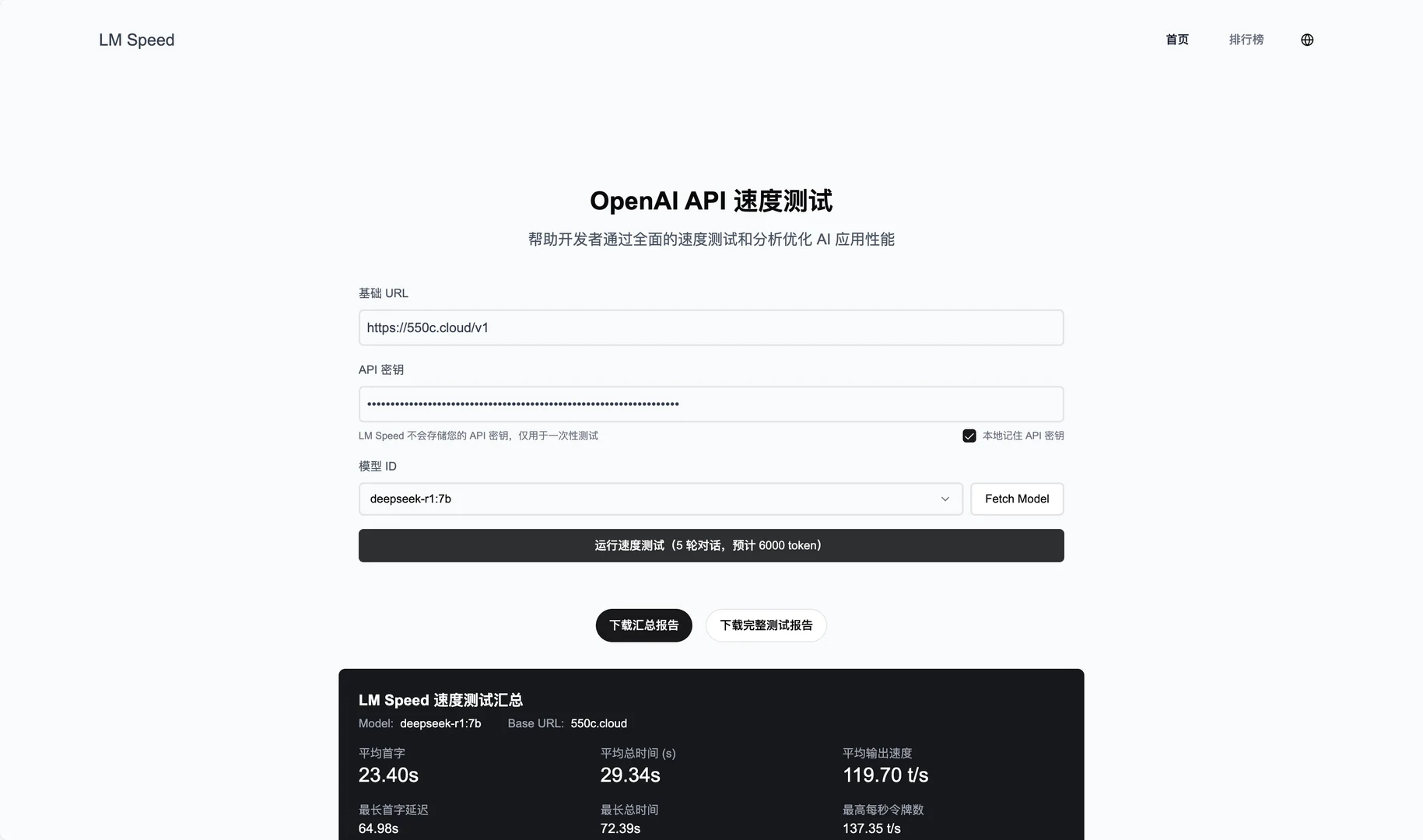

LM Speed ist ein Tool, das speziell für KI-Entwickler entwickelt wurde und als Online-Dienst unter lmspeed.net zur Verfügung steht. Seine Hauptfunktion besteht darin, die Leistung von Sprachmodell-APIs zu testen und zu analysieren, um den Benutzern zu helfen, Geschwindigkeitsengpässe schnell zu erkennen und die Aufrufstrategien zu optimieren. Das Tool unterstützt eine Vielzahl von Schnittstellen, darunter auch die OpenAI-API, und bietet Datenüberwachung in Echtzeit sowie detaillierte Leistungsberichte. Ob Sie ein einzelner Entwickler oder ein Team sind, LM Speed macht es Ihnen leicht, die Leistung verschiedener Modelle und Anbieter durch intuitive Datendiagramme und automatische Tests zu vergleichen.

Funktionsliste

- Leistungsüberwachung in Echtzeit: Anzeige mehrdimensionaler Daten, z. B. Verarbeitung pro Sekunde Token Nummer (TPoS).

- Umfassende Leistungsbewertung: Messen Sie wichtige Kennzahlen wie die Latenzzeit des ersten Tokens, die Reaktionszeit und mehr.

- Datenvisualisierung: Erstellen Sie aussagekräftige Diagramme zur Visualisierung von Leistungstrends.

- Automatisierte Stresstests: fünf aufeinanderfolgende Testrunden, um zuverlässige Daten zu gewährleisten.

- Ein-Klick-Berichterstellung: automatische Erstellung professioneller Prüfberichte, Unterstützung von Export und Weitergabe.

- Schnelltest für URL-Parameter: Starten Sie den Test direkt über den Link ohne manuelle Eingabe.

- Speicherung historischer Daten: Aufzeichnung von Testergebnissen und Unterstützung von Trendanalysen.

Hilfe verwenden

Nutzung von Online-Diensten

- Zugang zur Website

Öffnen Sie Ihren Browser und gehen Sie zu https://lmspeed.net. - Eingabe der Testparameter

Füllen Sie das Seitenformular mit den folgenden Informationen aus:baseUrlAPI-Dienstadresse, z. B.https://api.deepseek.com/v1.apiKeyIhr API-Schlüssel.modelIdID des zu prüfenden Modells, z. B.free:QwQ-32B.

- Anfahrprüfung

Klicken Sie auf die Schaltfläche "Test starten", und das System führt automatisch fünf Runden Stresstests durch. Während des Tests sehen Sie Datenaktualisierungen in Echtzeit, einschließlich TPoS und Antwortzeiten. - Ergebnisse anzeigen

Sobald der Test abgeschlossen ist, werden auf der Seite detaillierte Grafiken und Kennzahlen angezeigt, z. B. die Latenzzeit für das erste Token und die durchschnittliche Leistung. Sie können auf die Schaltfläche "Bericht generieren" klicken, um die PDF-Datei herunterzuladen oder sie an Ihr Team weiterzugeben. - Schnelltest von URL-Parametern

Wenn Sie sie nicht manuell eingeben wollen, können Sie den Test direkt mit einem Link starten. Beispiel:

https://lmspeed.net/?baseUrl=https://api.suanli.cn/v1&apiKey=sk-你的密钥&modelId=free:QwQ-32B

Nach dem Öffnen des Links wird der Test automatisch gestartet. Hinweis: Aus Sicherheitsgründen ist es empfehlenswert, den API-Schlüssel nicht direkt in der URL zu übergeben.

Lokale Bereitstellung Installationsprozess

- Vorbereiten der Umgebung

Vergewissern Sie sich, dass auf Ihrem Computer Git, Node.js (v16 oder höher empfohlen), Docker und Docker Compose installiert sind; falls nicht, laden Sie diese zuerst herunter und installieren Sie sie. - Klon-Lager

Öffnen Sie ein Terminal und geben Sie den folgenden Befehl ein, um den Code herunterzuladen:

git clone https://github.com/nexmoe/lm-speed.git

cd lm-speed

- Docker-Bereitstellung

- einrichten.

docker-compose.ymlDatei, kopieren Sie den offiziell bereitgestellten Code:version: '3.8' services: app: image: nexmoe/lmspeed:latest ports: - "8650:3000" environment: - DATABASE_URL=postgresql://postgres:postgres@db:5432/nexmoe - NODE_ENV=production depends_on: - db restart: always db: image: postgres:16 restart: always environment: POSTGRES_USER: postgres POSTGRES_PASSWORD: postgres POSTGRES_DB: nexmoe volumes: - postgres_data:/var/lib/postgresql/data volumes: postgres_data: - Läuft im Terminal:

docker-compose up -d - Nach erfolgreicher Bereitstellung rufen Sie die

http://localhost:8650Dienste anzeigen.

- Manuelle Bereitstellung

- Installieren Sie die Abhängigkeit:

npm install - Kopieren und Konfigurieren von Umgebungsvariablen:

cp .env.example .envCompiler

.envDatei, geben Sie die Datenbankadresse und die API-Konfiguration ein. - Starten Sie den Dienst:

npm run dev - Interviews

http://localhost:3000.

Featured Function Bedienung

- Echtzeit-Überwachung

Bei Online-Tests zeigt die Seite dynamisch TPoS- und Antwortzeitänderungen an. Sie können mit der Maus über die Diagramme fahren, um die genauen Werte zu sehen. - automatisierte Prüfung

Nachdem Sie auf "Test starten" geklickt haben, führt das System automatisch fünf Testrunden durch. Die Ergebnisse jeder Runde werden aufgezeichnet, und am Ende werden der Durchschnitt und die Schwankungsbreite generiert, damit Sie die Stabilität der API beurteilen können. - Bericht exportieren

Wenn der Test abgeschlossen ist, klicken Sie auf "Bericht exportieren" und wählen Sie das PDF-Format. Der Bericht enthält die Testumgebung, Leistungskennzahlen und Diagramme und eignet sich für die gemeinsame Nutzung im Team oder zur Archivierung. - Analyse historischer Daten

Der Online-Dienst speichert Ihre Tests. Rufen Sie nach der Anmeldung die Seite "Verlauf" auf, um frühere Testergebnisse und Leistungstrends einzusehen.

caveat

- Stellen Sie sicher, dass der API-Schlüssel gültig ist, sonst schlägt der Test fehl.

- Prüfen Sie beim lokalen Einsatz, ob die Firewall offene Ports hat (Standard 3000 oder 8650).

- Wenn die Grafik langsam geladen wird, liegt möglicherweise ein Netzwerkproblem vor. Wir empfehlen, die Seite zu aktualisieren und erneut zu versuchen.

Mit diesen Schritten können Sie die Leistung der Sprachmodellierungs-API online oder lokal mit LM Speed testen. Die Bedienung ist einfach, die Ergebnisse sind eindeutig und sehr nützlich.

Anwendungsszenario

- Entwickler wählen API-Dienste

Entwicklertests mit LM Speed DeepSeek und APIs wie Silicon Flow, um den für das Projekt am besten geeigneten Anbieter auszuwählen. - Team-Optimierungsmodell Anrufe

KI-Teams überwachen damit die Leistung von APIs bei hoher Belastung und passen die Aufrufstrategien an, um die Anwendungseffizienz zu verbessern. - Forscher analysieren Leistungsschwankungen

- Die Forscher untersuchten die Veränderungen in der Leistung des Modells unter verschiedenen Bedingungen durch fünf Testrunden und historische Daten, um den wissenschaftlichen Bericht zu verfassen.

QA

- Welche APIs werden von LM Speed unterstützt?

Es unterstützt hauptsächlich APIs im OpenAI-Format, wie DeepSeek, Suanli und so weiter. Solange die API mit dem OpenAI SDK kompatibel ist, kann sie getestet werden. - Was ist mit instabilen Testergebnissen?

Prüfen Sie, ob die Netzverbindung stabil ist, oder erhöhen Sie die Anzahl der Testrunden (der Code kann für die lokale Bereitstellung geändert werden). Starke Schwankungen bei den Ergebnissen können ein Problem mit dem API-Anbieter darstellen. - Muss ich bezahlen?

Die Online-Dienste sind derzeit kostenlos, die Funktionalität kann jedoch eingeschränkt sein. Die lokale Bereitstellung ist völlig kostenlos und der Code ist quelloffen.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...