llms.txt Generator: Schnelles Erfassen von Website-Inhalten und Generieren von LLM-Trainingstext-Datensätzen.

Allgemeine Einführung

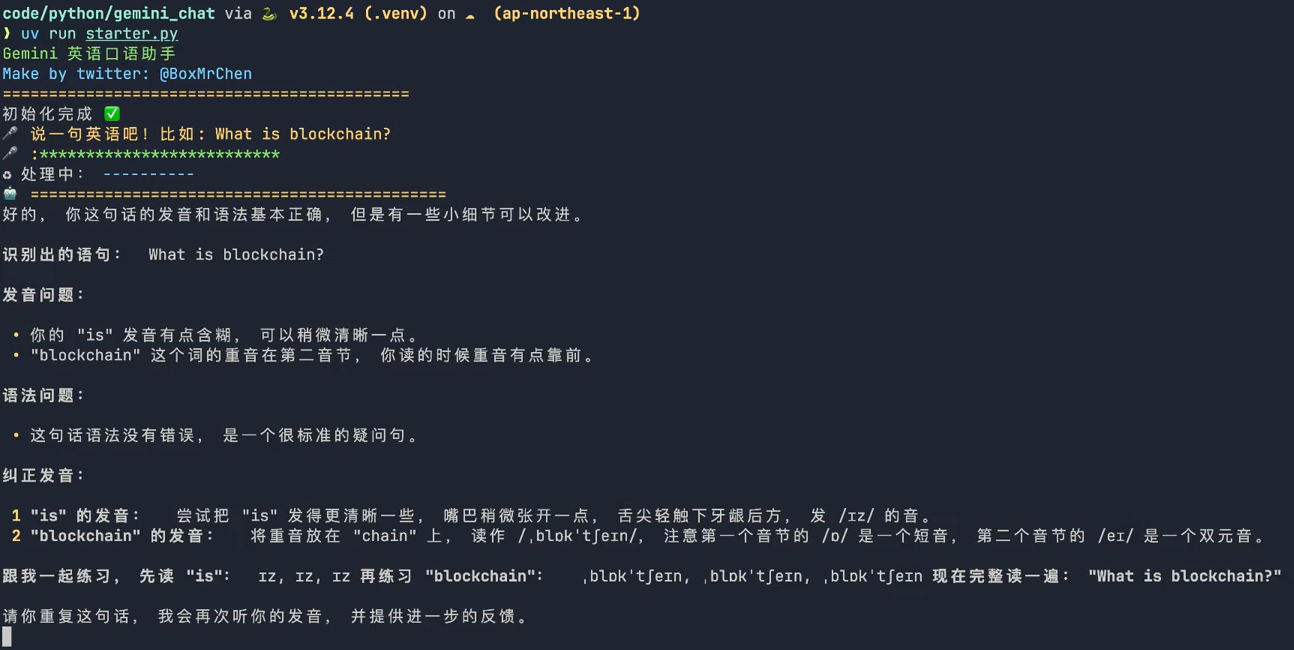

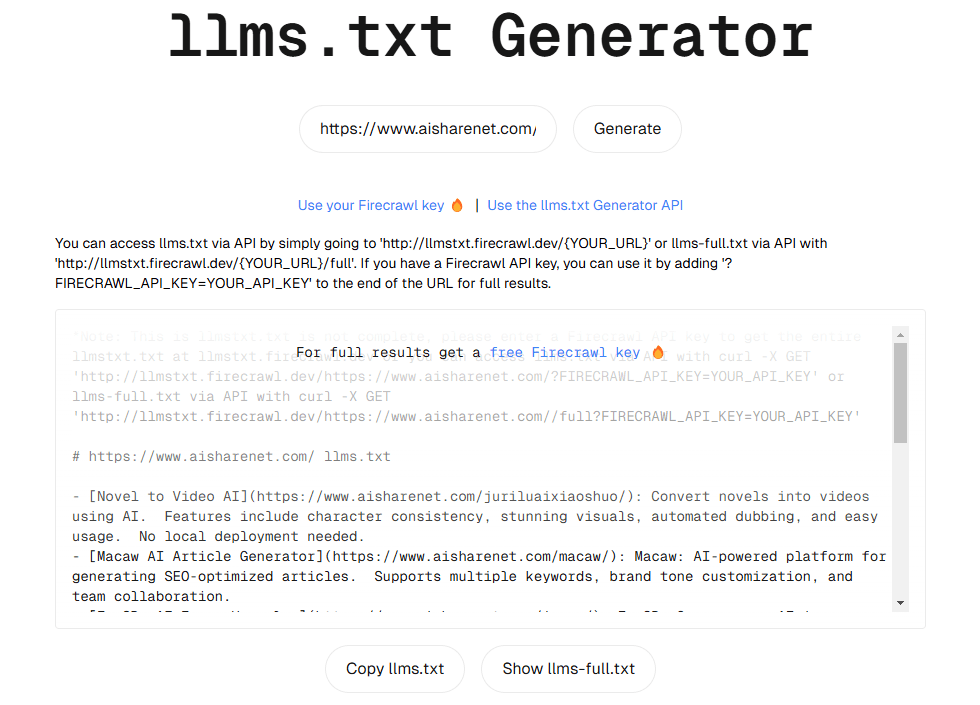

llmstxt-generator ist ein professionelles Tool zur Extraktion und Integration von Webinhalten, das auf die Vorbereitung hochwertiger Textdatensätze für das Training und die Inferenz von Large Language Models (LLM) spezialisiert ist. Das von Mendable AI entwickelte Tool nutzt die von @firecrawl_dev bereitgestellte Web-Crawling-Technologie und GPT-4-mini für die Textverarbeitung. Es durchforstet automatisch den Inhalt einer bestimmten Website und fasst alle Inhalte in einer standardisierten Textdatei zusammen. Das Tool bietet eine bequeme Weboberfläche und eine API-Schnittstelle, die es den Nutzern ermöglicht, auf einfache Weise Trainingsdatensätze zu generieren, die sich besonders für KI-Forscher und -Entwickler eignen, die Textdaten von Websites in großen Mengen benötigen.

Funktionsliste

- Automatisches Crawlen aller relevanten Seiten der Ziel-Website-Inhalte

- Bietet zwei Textausgabeformate: Standard (llms.txt) und vollständig (llms-full.txt).

- Unterstützt die intuitive Bedienung über die Weboberfläche

- Bereitstellung einer RESTful-API-Schnittstelle, um programmatische Aufrufe zu ermöglichen

- Unterstützung für die spezielle Behandlung von GitHub-Repository-Inhalten

- Fähigkeit zur intelligenten Extraktion und Verarbeitung von Webinhalten

- Unterstützung für benutzerdefinierte Firecrawl-API-Schlüssel zur Erhöhung der Crawl-Limits

- Enthält einen Web-Caching-Mechanismus zur Verbesserung der Effizienz der Datenerfassung

- Unterstützung für die Konvertierung mehrerer Inhaltsformate (z. B. Markdown)

Hilfe verwenden

1. die Nutzung der Webschnittstelle

- Besuchen Sie die offizielle Website: https://llmstxt.firecrawl.dev

- Geben Sie die URL der Ziel-Website in das Eingabefeld ein

- Klicken Sie auf die Schaltfläche "Generieren", um mit der Texterstellung zu beginnen.

- Warten Sie auf den Abschluss der Verarbeitung, um die erzeugte Textdatei zu erhalten

2. die API-Nutzung

Grundlegende API-Aufrufe:

GET https://llmstxt.firecrawl.dev/[YOUR_URL_HERE]

- Holen Sie sich die Standardversion des Textes: Gehen Sie direkt zur obigen URL

- Um die vollständige Version des Textes zu erhalten, fügen Sie "/full" am Ende der URL hinzu.

Verwenden Sie einen benutzerdefinierten API-Schlüssel:

Wenn Sie ein höheres Crawl-Limit benötigen, können Sie Ihr eigenes verwenden, indem Sie Firecrawl API-Schlüssel::

GET https://llmstxt.firecrawl.dev/[YOUR_URL_HERE]?FIRECRAWL_API_KEY=YOUR_API_KEY

3) Leitlinien für den lokalen Einsatz

Wenn Sie es in einer lokalen Umgebung ausführen möchten, folgen Sie bitte den nachstehenden Schritten:

- Umgebung Konfiguration:

einrichten..envDatei und konfigurieren Sie die folgenden notwendigen Parameter:

FIRECRAWL_API_KEY=你的key

SUPABASE_URL=你的supabase URL

SUPABASE_KEY=你的supabase key

OPENAI_API_KEY=你的OpenAI key

- Installation und Betrieb:

npm install

npm run dev

4 Vorsichtsmaßnahmen für die Verwendung

- Verarbeitungszeit: kann einige Minuten dauern, da das Crawlen der Website und die LLM-Verarbeitung durchgeführt werden müssen

- Beschränkung der kostenlosen Version: bis zu 10 Seiten pro Website ohne eigenen API-Schlüssel

- Erweiterte Version: Bis zu 100 Seiten mit eigenem Firecrawl API Schlüssel

- Caching-Mechanismus: Das System speichert die Ergebnisse im Zwischenspeicher, wiederholte Anfragen für dieselbe URL innerhalb von 3 Tagen werden direkt in den Zwischenspeicher zurückgegeben.

- Unterstützung für GitHub-Repositorys: GitHub-Repository-URLs werden speziell verarbeitet, um Repository-bezogene Inhalte zu extrahieren.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...