LLManager: ein Management-Tool, das intelligente automatische Prozessgenehmigungen mit menschlichen Audits kombiniert

Allgemeine Einführung

LLManager ist ein intelligentes Open-Source-Werkzeug zur Verwaltung von Genehmigungen, das auf der LangChain-Technologie LangGraph Framework, das entwickelt wurde, um die Bearbeitung von Genehmigungsanträgen zu automatisieren und gleichzeitig die Entscheidungsfindung in Verbindung mit der menschlichen Überprüfung zu optimieren. Es lernt aus historischen Genehmigungen durch semantische Suche, stichprobenloses Lernen und reflektierende Mechanismen, um die Genauigkeit der Genehmigung zu verbessern. Die Benutzer können das Agenten-Posteingang LLManager kann Anfragen anzeigen und beantworten, unterstützt benutzerdefinierte Genehmigungs- und Ablehnungskriterien und passt sich an mehrere Sprachmodelle (z. B. OpenAI, Anthropic) an. Das Tool eignet sich für die Genehmigung von Unternehmensbudgets, für das Projektmanagement und für Szenarien zur Überprüfung der Einhaltung von Vorschriften. Der Code wird auf GitHub gehostet, sodass Entwickler die Funktionalität frei erweitern können. Das Tool legt den Schwerpunkt auf die Zusammenarbeit von KI und Menschen und schafft ein Gleichgewicht zwischen Effizienz und Zuverlässigkeit.

Funktionsliste

- Automatisierte GenehmigungenAutomatische Erstellung von Genehmigungsempfehlungen auf der Grundlage von benutzerdefinierten Genehmigungs- und Ablehnungskriterien.

- Human AuditUnterstützung der manuellen Annahme, Änderung oder Ablehnung von KI-generierten Genehmigungen, um eine genaue Entscheidungsfindung zu gewährleisten.

- semantische Suche: Extraktion von 10 semantisch ähnlichen Mustern aus historischen Anträgen, um die kontextuelle Relevanz von Genehmigungen zu verbessern.

- Lernen mit weniger StichprobenOptimierung der zukünftigen Entscheidungsfähigkeit des Modells auf der Grundlage historischer Genehmigungsdaten.

- ReflexionsmechanismenAnalyse der Ergebnisse der geänderten Genehmigungen und Erstellung reflektierender Berichte zur Verbesserung der Modellleistung.

- Modell-AnpassungUnterstützung für Modelle wie OpenAI, Anthropic, usw., mit Unterstützung für die Werkzeugaufruf-Funktion.

- Agent Inbox InteraktivBietet eine intuitive Schnittstelle zum Anzeigen, Beantworten und Verwalten von Genehmigungsanfragen.

- Dynamischer Aufbau von StichwörternDynamische Anpassung der Eingabeaufforderungen auf der Grundlage von Anfragen, um verschiedenen Genehmigungsszenarien gerecht zu werden.

- Durchgängige BewertungTestfälle ausführen, um die Zuverlässigkeit und Genauigkeit des Arbeitsablaufs zu überprüfen.

Hilfe verwenden

Einbauverfahren

LLManager basiert auf dem Open-Source-Projekt LangChain und LangGraph und muss lokal installiert werden. Im Folgenden sind die detaillierten Installationsschritte aufgeführt:

- Klonen der Codebasis::

Führen Sie den folgenden Befehl im Terminal aus, um den LLManager-Code zu erhalten:git clone https://github.com/langchain-ai/llmanager.git cd llmanager - Installation von Abhängigkeiten::

Stellen Sie sicher, dass Python 3.11 oder höher und Node.js (für Yarn) auf Ihrem System installiert sind. Erstellen Sie eine virtuelle Umgebung und installieren Sie die Abhängigkeiten:python3 -m venv venv source venv/bin/activate yarn installZu den Standard-Abhängigkeiten gehören LangChain und das Anthropic/OpenAI-Integrationspaket. Zusätzliche Installationen sind erforderlich, wenn andere Modelle (z. B. Google GenAI) verwendet werden:

yarn install @langchain/google-genai - Umgebungsvariablen konfigurieren::

Kopieren Sie die Beispiel-Umgebungsdatei und tragen Sie die erforderlichen Informationen ein:cp .env.example .envCompiler

.envfügen Sie den LangSmith-API-Schlüssel und die Anthropisch API-Schlüssel (bei Verwendung des anthropischen Modells):LANGCHAIN_PROJECT="default" LANGCHAIN_API_KEY="lsv2_..." LANGCHAIN_TRACING_V2="true" LANGSMITH_TEST_TRACKING="true" ANTHROPIC_API_KEY="your_anthropic_key"LangSmith wird für Tracing und Debugging verwendet und sollte aktiviert sein.

- Starten des Entwicklungsservers::

Führen Sie den folgenden Befehl aus, um den LangGraph-Server zu starten:yarn devDer Server läuft standardmäßig auf dem

http://localhost:2024Stellen Sie in Produktionsumgebungen auf einem Cloud-Server bereit und aktualisieren Sie die URL. Stellen Sie in einer Produktionsumgebung auf einem Cloud-Server bereit und aktualisieren Sie die URL.

Verwendung

Das Kernstück von LLManager ist die Verwaltung und Beantwortung von Genehmigungsanträgen über den Agentenposteingang. Nachfolgend finden Sie den detaillierten Arbeitsablauf:

- Durchführung einer End-to-End-Bewertung::

- Führen Sie den folgenden Befehl aus, um einen neuen Genehmigungsassistenten zu erstellen und 25 Testfälle auszuführen:

yarn test:single evals/e2e.int.test.ts - Das Terminal gibt die UUID des neuen Assistenten aus und speichert diese ID für die Konfiguration des Agentenposteingangs.

- Wenn Sie denselben Assistenten wiederverwenden müssen, können Sie die

evals/e2e.int.test.tsWenn Sie eine feste Helfer-ID verwenden, benutzen Sie die feste Helfer-ID.

- Führen Sie den folgenden Befehl aus, um einen neuen Genehmigungsassistenten zu erstellen und 25 Testfälle auszuführen:

- Konfigurieren von Genehmigungsregeln::

- existieren

config.jsonLegen Sie Genehmigungs- und Ablehnungskriterien im Beispiel:{ "approvalCriteria": "请求需包含详细预算和时间表", "rejectionCriteria": "缺少必要文件或预算超标", "modelId": "anthropic/claude-3-7-sonnet-latest" } - Wenn keine Regeln festgelegt sind, lernt der LLManager auf der Grundlage historischer Daten, aber das Festlegen von Regeln beschleunigt die Modellanpassung.

modelIdetw. unterstützenprovider/model_nameFormat, wie zum Beispielopenai/gpt-4ovielleichtanthropic/claude-3-5-sonnet-latest.

- existieren

- Verwendung des Agentenposteingangs::

- Gehen Sie zu dev.agentinbox.ai und klicken Sie auf "Posteingang hinzufügen".

- Geben Sie die folgenden Informationen ein:

- Assistent/Grafik-IDUUID: UUID, die durch die End-to-End-Auswertung erzeugt wird.

- Bereitstellungs-URL::

http://localhost:2024(Entwicklungsumgebung). - Name: Passen Sie den Namen an, z. B.

LLManager.

- Aktualisieren Sie den Posteingang nach der Übermittlung, um die ausstehenden Anträge zu sehen.

- Für jede Anfrage wird der Agenten-Eingangskorb angezeigt:

- KI-generierte Genehmigungsempfehlungen und Begründungsberichte.

- Handlungsoptionen: Annehmen, Ändern (Vorschläge oder Anweisungen bearbeiten) oder Ablehnen (Gründe angeben).

- Geänderte oder akzeptierte Anträge werden automatisch in der Bibliothek Less Sample Example gespeichert, um spätere Genehmigungen zu optimieren.

- Ansicht und Optimierung der Genehmigungshistorie::

- Klicken Sie im Posteingang des Agenten auf Bearbeitete Anfragen, um Genehmigungsdetails, AI-Inferenzberichte und Protokolle über manuelle Änderungen anzuzeigen.

- Das System extrahiert ähnliche Anfragen aus der Historie als kontextuelle Eingabemodelle durch semantische Suche.

- Die geänderte Anfrage löst den Reflexionsmechanismus aus, der einen Reflexionsbericht erstellt, der im Reflexions-Repository gespeichert und zur Verbesserung des Modells verwendet wird.

Featured Function Bedienung

- semantische SucheWenn eine neue Anfrage eintrifft, extrahiert das System 10 semantisch ähnliche Anfragen (einschließlich des Inhalts der Anfrage, der endgültigen Antwort und der Beschreibung) aus der Historie als Prompt-Kontext, um die Genauigkeit der Genehmigung zu verbessern.

- Reflexionsmechanismen::

- Wenn das Handbuch nur die Beschreibung ändert (richtige Antwort, aber falsche Argumentation), lösen Sie die

explanation_reflectionKnotenpunkte, um Denkfehler zu analysieren und neue Überlegungen anzustellen. - Wenn sowohl die Antwort als auch die Beschreibung geändert werden, lösen Sie

full_reflectionKnoten, die Analyse von Gesamtfehlern und die Erzeugung von Reflexionen. - Die Reflexionsberichte werden in einer Reflexionsbank hinterlegt, um die spätere Argumentation zu optimieren.

- Wenn das Handbuch nur die Beschreibung ändert (richtige Antwort, aber falsche Argumentation), lösen Sie die

- Dynamischer Aufbau von StichwörternPasst die Eingabeaufforderungen dynamisch auf der Grundlage von Antragsinhalten und historischen Daten an, um sicherzustellen, dass Genehmigungen an eine Vielzahl von Szenarien angepasst werden.

- Modellwechsel: durch Änderung der

config.jsonden Nagel auf den Kopf treffenmodelIdwechseln Sie zu einem Modell, das Tool-Aufrufe unterstützt (z. B.openai/gpt-4o), müssen Sie sicherstellen, dass das entsprechende Integrationspaket installiert ist.

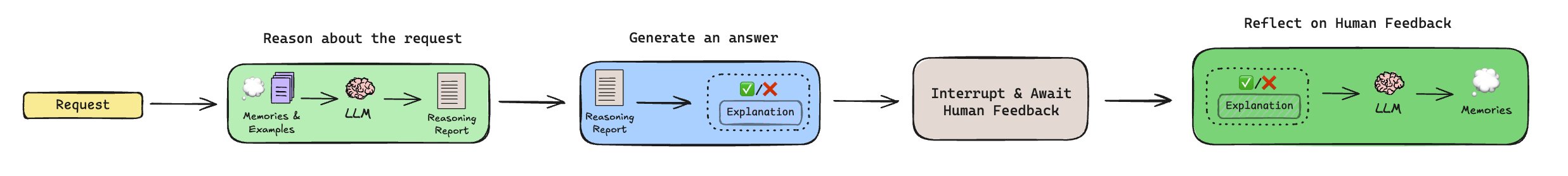

Workflow erklärt

Der Genehmigungsprozess von LLManager umfasst die folgenden Schritte:

- Begründung::

- Extraktion historischer Überlegungen und kleinerer Beispiele (über die semantische Suche).

- Erzeugt einen Begründungsbericht, der analysiert, ob dem Antrag stattgegeben werden sollte, trifft aber keine endgültige Entscheidung.

- Antwort generieren::

- Kombinieren Sie den Begründungsbericht und den Kontext, um eine endgültige Genehmigungsempfehlung (genehmigen oder ablehnen) und eine Beschreibung zu erstellen.

- Menschliche Überprüfung::

- Unterbrechen Sie den Arbeitsablauf und warten Sie auf die manuelle Überprüfung durch den Agenteneingang.

- Ein Mensch kann die Vorschläge annehmen, abändern oder ablehnen, und die Änderungen werden in der Bibliothek der Kleineren Musterbeispiele hinterlegt.

- Reflexion::

- Wird die Empfehlung geändert, wird ein Reflexionsmechanismus ausgelöst, um Verbesserungsvorschläge zu erarbeiten.

- Unveränderte Anfragen überspringen diesen Schritt.

caveat

- Stellen Sie sicher, dass der LangSmith-API-Schlüssel gültig ist und dass sowohl die Entwicklungs- als auch die Produktionsumgebung über stabile Netzwerke verfügen.

- Für Nicht-OpenAI/Anthropic-Modelle müssen zusätzliche Integrationspakete installiert werden, siehe LangChain-Dokumentation.

- Für den produktiven Einsatz muss der LangGraph-Server in die Cloud verschoben und die URL für den Agentenposteingang aktualisiert werden.

Anwendungsszenario

- Genehmigung des Unternehmenshaushalts

LLManager automatisiert die Bearbeitung von Budgetanträgen der Mitarbeiter und generiert Empfehlungen auf der Grundlage vordefinierter Regeln (z.B. Budgetobergrenzen, Projektarten). Das Finanzteam überprüft, ändert oder bestätigt die Ergebnisse über den Agentenposteingang, wodurch sich wiederholende Aufgaben reduziert werden. - Zuweisung von Projektaufgaben

Projektleiter verwenden LLManager, um Anträge auf Aufgabenzuweisung zu genehmigen. Das System analysiert Aufgabenprioritäten und Ressourcenanforderungen, um Zuweisungsempfehlungen zu erstellen. Der Manager überprüft die Anfrage manuell, um eine effiziente und angemessene Aufgabenzuweisung zu gewährleisten. - Überprüfung der Einhaltung

LLManager prüft die eingereichten Dokumente auf Einhaltung der Vorschriften und weist auf mögliche Probleme hin. Das Compliance-Team bestätigt oder korrigiert die Ergebnisse über den Posteingang, was die Effizienz der Prüfung erhöht. - Verwaltung von Kundenanfragen

Kundendienstteams verwenden LLManager, um Kundenerstattungen oder Serviceanfragen zu genehmigen. Das System generiert Empfehlungen auf der Grundlage historischer Daten, und das Team überprüft sie manuell, um sicherzustellen, dass die Entscheidungen fair und einheitlich sind.

QA

- Welche Modelle unterstützt der LLManager?

Unterstützungsmodelle wie OpenAI, Anthropic, etc. müssen die Werkzeugaufruf-Funktion unterstützen. Nicht-Standardmodelle erfordern die Installation von LangChain-Integrationspaketen, wie z.B.@langchain/google-genai. - Wie kann ich denselben Assistenten wiederverwenden?

Änderungenevals/e2e.int.test.tsWenn Sie eine feste Helfer-ID verwenden oder nach einer vorhandenen ID suchen, bevor Sie eine Auswertung durchführen, vermeiden Sie die Erstellung eines neuen Helfers. - Wie wird es in einer Produktionsumgebung eingesetzt?

Stellen Sie LangGraph auf einem Cloud-Server bereit, aktualisieren Sie die Bereitstellungs-URL für den Agentenposteingang und verwenden Sie LangSmith zur Überwachung der Workflow-Leistung. - Wie kann ich meinen Arbeitsablauf anpassen?

Bearbeiten Sie den Teilgraphen für die Argumentation (zur Anpassung der Logik für die Generierung von Aufforderungen) oder den Teilgraphen für die Reflexion (zur Steuerung der Regeln für die Generierung von Reflexionen), um sie an bestimmte Genehmigungsszenarien anzupassen.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...