Die Llama 4-Serie debütiert: ein Neuanfang für native multimodale KI-Innovationen?

Meta hat am 5. April 2025 Llama 4, das neueste Mitglied seiner Llama-Familie von großen Sprachmodellen, veröffentlicht und damit einen bedeutenden Fortschritt in der KI, insbesondere bei der nativen Multimodalität und der Modellarchitektur, erzielt. Im Mittelpunkt der Veröffentlichung stehen die Modelle Llama 4 Scout und Llama 4 Maverick sowie eine Vorschau auf das riesige "Lehrermodell" Llama 4 Behemoth, das der Technologie zugrunde liegt. Dieser Schritt zeigt nicht nur Metas Engagement, aufzuholen und zu versuchen, die Spitzenmodelle der Branche zu übertreffen, sondern setzt auch seine Strategie fort, das Open-Source-KI-Ökosystem voranzutreiben.

Übersicht über die Kernmodelle der Llama 4-Serie

Meta bringt zwei Modelle der Llama 4-Serie für Entwickler und Anwendungen auf den Markt:

- Llama 4 ScoutDas Modell verfügt über 17 Milliarden aktive Parameter und 16 Experten, insgesamt also über 109 Milliarden Parameter. Das Highlight ist die klassenbeste multimodale Fähigkeit, die alle bisherigen Llama-Modelle übertrifft. Noch bemerkenswerter ist, dass es bis zu 10 Millionen Parameter unterstützt. Token Kontextfenster und übertrifft damit die 128K von Llama 3 bei weitem. Meta behauptet, dass das Modell die Google Gemma 3 und Zwillinge 2.0 Flash-Lite und Mistral AI (in Form eines Nominalausdrucks) Mistral 3.1 und von Int4 quantifiziert, um auf einem einzigen NVIDIA H100-Grafikprozessor eingesetzt zu werden, was zeigt, dass der Schwerpunkt auf der Effizienz liegt.

- Llama 4 MaverickEs hat ebenfalls 17 Milliarden aktive Parameter, ist aber mit 128 Experten und 400 Milliarden Gesamtparametern ausgestattet. Es wird als das beste multimodale Modell seiner Klasse angesehen und soll OpenAIs GPT-4o und Googles Gemini 2.0 Flash herausfordern. Laut den von Meta veröffentlichten Daten schneidet Maverick in mehreren Benchmarks gut ab und hat fast doppelt so viele Parameter wie sein aktiver Parameter, was die Inferenz- und Codierungsleistung angeht. DeepSeek v3 . Eine experimentelle Version des Chats ist verfügbar unter LMArena Das Leaderboard erhielt eine ELO-Punktzahl von 1417, was sein Potenzial für die Dialogfähigkeit zeigt. Das Modell kann auf einem einzigen NVIDIA H100 DGX-Host ausgeführt werden.

Außerdem hat Meta eine Vorschau Llama 4 Behemoth Modellierung. Es ist ein Ungetüm mit 288 Milliarden aktiven Parametern, 16 Experten und fast 2 Billionen Teilnehmern insgesamt. Es befindet sich noch in der Ausbildung und ist noch nicht freigegeben, dient aber als "Lehrermodell" für Scout und Maverick und steigert deren Leistung durch Wissensdestillation. Behemoth glänzt bei Mathematik-, Mehrsprachen- und Bild-Benchmarks. Meta behauptet, dass es GPT-4.5 bei einigen MINT-Benchmarks wie MATH-500 und GPQA Diamond übertrifft, Anthropisch (in Form eines Nominalausdrucks) Claude Sonnet 3.7 und Googles Gemini 2.0 Pro.

Wichtige technologische Innovationen: MoE, Multimodalität und lange Kontexte

Die Llama 4-Serie führt eine Reihe wichtiger technologischer Innovationen ein, die die Leistungsverbesserungen untermauern.

Hybride Architektur des Kompetenzmodells (MoE)

Llama 4 ist die erste Modellfamilie von Meta, die die Mixed Expert (MoE)-Architektur verwendet, die in den letzten Jahren viel Aufmerksamkeit auf sich gezogen hat, da sie es den Modellen ermöglicht, nur eine kleine Anzahl von Parametern (d.h. "Experten") zu einem Zeitpunkt der Inferenz zu aktivieren, während sie eine große Anzahl von Gesamtparametern haben. Dieses Design ermöglicht eine höhere Leistung als herkömmliche dichte (Dense) Modelle für ein gegebenes Trainingsbudget und verbessert die Recheneffizienz von Training und Inferenz.

Llama 4 Maverick hat beispielsweise 400 Milliarden Gesamtparameter, die auf 128 Routing-Experten und einen gemeinsamen Experten verteilt sind. Bei der Argumentation wird jedes Token sowohl an den gemeinsamen Experten als auch an einen der Routing-Experten gesendet. Das Modell verwendet abwechselnd dichte und MoE-Schichten, um ein Gleichgewicht zwischen Leistung und Effizienz herzustellen. Diese Architektur ermöglicht es, Maverick auf einem einzigen H100 DGX-Host einzusetzen oder die Effizienz durch verteiltes Reasoning zu maximieren und die Kosten und Latenzzeiten der Modelldienste zu reduzieren.

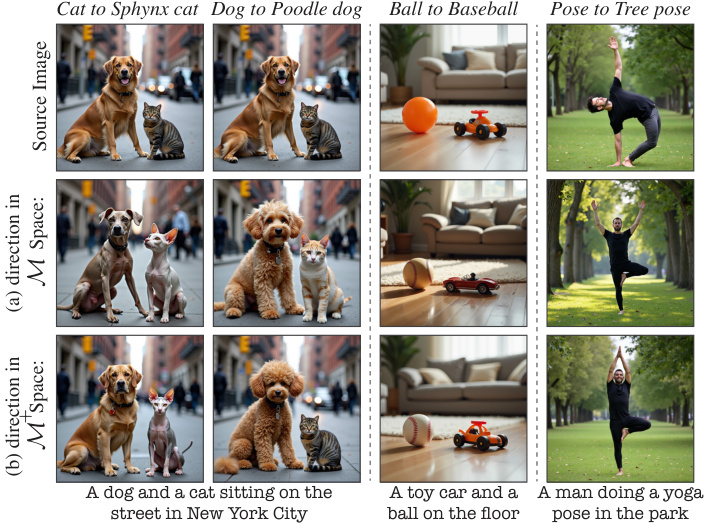

Einheimische Multimodalität und frühe Integration

Im Gegensatz zu früheren Ansätzen, die linguistische Modelle trainierten, bevor sie an visuelle Fähigkeiten angepasst wurden, ist Llama 4 als natives multimodales Modell konzipiert. Es verwendet eine Early-Fusion-Strategie, die textuelle und visuelle Token nahtlos in das Backbone-Netzwerk des Modells integriert. Das bedeutet, dass das Modell mit großen Mengen an unmarkierten Text-, Bild- und Videodaten gemeinsam vortrainiert werden kann. Llama 4 verbessert auch seinen visuellen Encoder, der auf MetaCLIP basiert, aber mit einem eingefrorenen Llama-Modell trainiert wird, um große Sprachmodelle besser zu unterstützen. Das Modell kann bis zu 48 Bildeingaben im Pre-Training verarbeiten und schneidet bei Post-Trainingstests mit bis zu 8 Bildeingaben gut ab und ist in der Lage, mehrere Bildeingaben und textuelle Hinweise für visuelles Denken und Verstehen zu verarbeiten.

Durchbruch im 10-Millionen-Token-Kontextfenster

Eine weitere Besonderheit von Llama 4 Scout ist das branchenführende Kontextfenster von bis zu 10 Millionen Token. Eine derartig große Kontextkapazität eröffnet neue Möglichkeiten für die Verarbeitung sehr langer Dokumente, die Analyse großer Datensätze oder die Führung von Dialogen, die beispielsweise ein Langzeitgedächtnis erfordern:

- Zusammenfassung und Fragen und Antworten zu mehreren längeren Berichten oder Büchern.

- Analysieren Sie die gesamte Codebasis, um Abhängigkeiten zu verstehen oder Fehler zu finden.

- Stark personalisierte Dienste, die auf wochen- oder sogar monatelangen Nutzeraktivitäten basieren.

- Informationsextraktion und -analyse in Bereichen wie Recht oder Medizin, in denen große Mengen an Text verarbeitet werden müssen.

Meta führt die langen Kontextfähigkeiten von Scout auf seine innovativen iRoPE Architektur. Die Architektur verwendet eine Kontextlänge von 256K sowohl für das Pre-Training als auch für das Post-Training und kombiniert verschachtelte Aufmerksamkeitsschichten (ohne Positionseinbettungen) und Temperaturskalierung der Inferenzzeit, um die Längengeneralisierung zu verbessern. Das "i" steht für interleaved (verschachtelt), und "RoPE" bezieht sich auf Rotary Position Embeddings (rotierende Positionseinbettungen), was auf die Unterstützung von "infinite Das "i" steht für "interleaved" und "RoPE" für "Rotary Position Embeddings", was auf das langfristige Ziel hinweist, "unendliche" Kontextlängen zu unterstützen.

Trainingsmethoden und Leistung

Bei der Entwicklung von Llama 4 wurden zahlreiche Verbesserungen am Ausbildungsprozess vorgenommen.

Vorschulungsphase:

- Daten und MaßstabDie Gesamtmenge der Trainingsdaten beträgt über 30 Billionen Token, mehr als doppelt so viel wie bei Llama 3, und umfasst eine Vielzahl von Text-, Bild- und Videodatensätzen. Unterstützung für 200 Sprachen, wobei für mehr als 100 Sprachen mehr als 1 Milliarde Token an Trainingsdaten vorhanden sind.

- Effizienz und PräzisionTraining: Das Training wird mit FP8-Präzision durchgeführt, um die Recheneffizienz zu erhöhen (390 TFLOPs/GPU für Behemoth auf 32K GPUs), ohne dabei Abstriche bei der Qualität zu machen.

- Optimierung der HyperparameterEntwicklung einer neuen Technik namens MetaP zur zuverlässigen Festlegung wichtiger Hyperparameter (z. B. Lernrate pro Schicht, Initialisierungsskala). Es wurde festgestellt, dass diese Parameter über Chargengrößen, Modellbreiten, -tiefen und die Anzahl der Trainingstoken hinweg gut übertragbar sind.

- Mittlere AusbildungEinführung spezifischer Trainingsmethoden und Datensätze nach dem Pre-Training zur Erweiterung der Fähigkeiten im langen Kontext und zur Verbesserung der Kernleistung.

Nachbereitungsphase:

- neues VerfahrenEin neuer Prozess von Lightweight Supervised Fine-Tuning (SFT) -> Online Reinforcement Learning (RL) -> Lightweight Direct Preference Optimisation (DPO) wurde eingeführt. Meta fand heraus, dass traditionelles SFT und DPO das Modell zu sehr einschränken können, was die Exploration in der RL-Phase einschränkt und Inferenz, Kodierung und mathematische Fähigkeiten beeinträchtigt.

- Filtern von DatenEntfernen Sie mehr als 50% der als "leicht" eingestuften SFT-Daten, indem Sie das Llama-Modell als Richter verwenden und sich bei schwierigeren Datensätzen auf leichtgewichtige SFT konzentrieren.

- Intensives Online-LernenSignifikante Leistungssteigerungen wurden durch die sorgfältige Auswahl schwierigerer Aufforderungen (Prompts) während der multimodalen Online-RL-Phase erzielt. Es wurde eine kontinuierliche Online-RL-Strategie angewandt, bei der zwischen Modelltraining und der Verwendung von modellgefilterten Daten abgewechselt wurde, wobei nur mittelschwere bis schwierige Aufforderungen beibehalten wurden, um ein Gleichgewicht zwischen Berechnung und Genauigkeit zu erreichen.

- Leichtgewichtiger DSBSchließlich wird ein leichtgewichtiger DPO durchgeführt, um Grenzfälle in Bezug auf die Qualität der Modellantwort zu behandeln, wobei die Intelligenz und die Dialogfähigkeit des Modells ausgeglichen werden.

Leistungsvergleich:

Meta hat Benchmark-Ergebnisse veröffentlicht, die zeigen:

- Llama 4 MaverickÜbertrifft GPT-4o und Gemini 2.0 in den Bereichen Kodierung, Inferenz, Mehrsprachigkeit, langer Kontext und Bildbenchmarks. Vergleichbar mit DeepSeek v3.1 mit größeren Parameterskalen bei Kodierung und Inferenz.

- Llama 4 ScoutKlassenbeste Leistung, übertrifft Gemma 3, Gemini 2.0 Flash-Lite, Mistral 3.1 und alle Llama-Modelle der vorherigen Generation. Übertrifft alle früheren Llama-Modelle in Bezug auf die Erdung des Bildes.

Es ist wichtig zu beachten, dass die Benchmark-Ergebnisse in der Regel unter bestimmten Bedingungen erzielt werden und die Leistung in realen Anwendungen variieren kann. Diese Daten zeigen jedoch zumindest, dass das Llama 4 das Potenzial hat, mit branchenführenden Modellen in einer Reihe von Bereichen zu konkurrieren.

Behemoth: Der "Lehrer" mit 2 Billionen Parametern und die Herausforderung der Ausbildung

Llama 4 Behemoth dient nicht nur dazu, die Fähigkeit von Meta zu demonstrieren, sehr große Modelle zu trainieren, sondern vor allem als "Lehrmeister" für die Entwicklung von Llama 4. Durch Codistillation übertrug Behemoth seine Fähigkeiten in den Bereichen Mathematik, Mehrsprachigkeit und Bildverständnis auf das kleinere Maverick-Modell, und Meta entwickelte eine neue Codistillations-Verlustfunktion, die die Gewichte des weichen Ziels (Wahrscheinlichkeitsverteilungen aus dem Lehrermodell) und des harten Ziels (die realen Etiketten) während des Trainingsprozesses dynamisch anpasst. Gewichte. Diese kollaborative Destillation während des Pre-Trainings amortisiert die erheblichen Rechenkosten für die Berechnung der Destillationsziele für das Studentenmodell.

Das Training eines Modells mit 2 Billionen Parametern ist an sich schon eine große technische Herausforderung. meta hat einige Erfahrungen mit der Post-Training-Phase gemacht:

- DatenbeschneidungUm die Leistung zu maximieren, müssen die SFT-Daten stärker beschnitten werden als die kleineren Modelle, und zwar um bis zu 95%, um sich auf qualitativ hochwertige und schwierige Daten konzentrieren zu können.

- Intensives LernenDie RL-Strategie konzentriert sich auf die Auswahl schwieriger Stichwörter durch pass@k-Analyse und die Erstellung von Trainingseinheiten mit steigendem Schwierigkeitsgrad. Das dynamische Herausfiltern von Stichwörtern mit Nullvorteil und das Mischen von Stichwörtern aus verschiedenen Fähigkeitsdimensionen in Trainingseinheiten ist entscheidend für die Verbesserung der mathematischen, logischen und kodierenden Leistung.

- Die Anweisungen folgenSampling diverser Systeminstruktionen (Systeminstruktionen) ist von entscheidender Bedeutung, um sicherzustellen, dass das Modell bei Argumentations- und Codierungsaufgaben eine gute Instruktionstreue beibehält.

- InfrastrukturFür die MoE-Architektur und Hyperscale hat Meta sein Parallelisierungsdesign optimiert und ein vollständig asynchrones Online-RL-Trainingssystem entwickelt. Das Framework ermöglicht eine flexible Zuweisung verschiedener Modelle an verschiedene GPUs, wobei die Ressourcen auf der Grundlage der Rechengeschwindigkeit ausgeglichen werden und die Trainingseffizienz Berichten zufolge um das ~10-fache gegenüber der vorherigen Generation verbessert wird.

Sicherheit und Entschärfung von Vorurteilen

Wie alle großen Modellentwickler hat auch Meta bei der Entwicklung von Llama 4 den Schwerpunkt auf Sicherheit und verantwortungsvolle KI gelegt. Sein Ansatz deckt den gesamten Lebenszyklus der Modellentwicklung ab:

- Abschwächung vor und nach der Ausbildung:: Einsatz von Maßnahmen wie Datenfilterung in der Pre-Trainingsphase; Anwendung verschiedener Techniken in der Post-Trainingsphase, einschließlich der Einspeisung der richtigen Menge an Sicherheitsdaten in jeder Phase, um das Modell an die Nutzungsstrategie anzupassen.

- Werkzeuge auf SystemebeneMeta stellt eine Reihe von Sicherheitstools zur Verfügung, die Entwickler integrieren können:

- Lama-Wächter:: Auf der Grundlage der Risikotaxonomie von MLCommons entwickeltes Input/Output-Sicherheitserkennungsmodell.

- Prompter Wächter:: Klassifizierungsmodelle zur Erkennung von bösartigen Hinweisen (z. B. Jailbreak-Angriffe) und Injektionsangriffen.

- CyberSecEvalAn assessment tool for evaluating and mitigating the security risks of generative AI networks.

Meta betont die Anpassungsfähigkeit dieser Tools, die es den Entwicklern ermöglicht, die Sicherheitsrichtlinien an ihre eigenen Bedürfnisse anzupassen.

- Bewertung und Red-Team-Tests:: Durchführung von Modelltests des Systems mit automatisierten und manuellen gegnerischen Tests. Entwickelte ein System namens GOAT (Generative Offensivmittelprüfung) Der neue Ansatz des Unternehmens zur Verbesserung der Testabdeckung und der Testeffizienz durch die Simulation mehrerer Interaktionsrunden mit mäßig qualifizierten Angreifern ermöglicht es den Experten des Red Teams, sich auf neuere Risikobereiche zu konzentrieren.

Umgang mit Vorurteilen

Meta erkennt das Problem der Voreingenommenheit, das bei großen Sprachmodellen vorherrscht, insbesondere die historische Tendenz, bestimmte Positionen zu kontroversen politischen und sozialen Themen zu bevorzugen, was zum Teil auf die inhärente Voreingenommenheit der Internet-Trainingsdaten zurückzuführen ist. Das Ziel von Llama 4 ist es, die Voreingenommenheit der Modelle zu beseitigen, so dass sie in der Lage sind, verschiedene Seiten kontroverser Themen ohne Voreingenommenheit oder Wertung zu verstehen und zu artikulieren.

Meta behauptet, dass Llama 4 in diesem Bereich erhebliche Fortschritte gemacht hat, die Llama 3 übertreffen und sich mit dem Grok Durchaus:

- Bei kontroversen politischen und sozialen Themen sank der Prozentsatz der Antwortverweigerungen von 7% in Llama 3.3 auf unter 2%.

- Der Anteil der Aufforderungen, die ungleiche (voreingenommene) Ablehnungen enthielten, war niedriger als 1% für Ablehnungsantworten.

- Bei einer Reihe kontroverser politischer oder sozialer Themen zeigt Llama 4 eine starke politische Voreingenommenheit mit einer Häufigkeit der Antworten, die mit der von Grok vergleichbar ist und etwa die Hälfte derjenigen von Llama 3.3 beträgt.

Meta sagt, dass es weiterhin daran arbeiten wird, die Verzerrungsrate in seinen Modellen zu reduzieren.

Offenheit, Benutzerfreundlichkeit und Ökosysteme

Llama 4 Scout und Llama 4 Maverick stehen ab sofort auf llama.com und Hugging Face zum Download bereit und werden von allen wichtigen Cloud-, Daten- und Edge-Computing-Partnern unterstützt. Benutzer können auch die Llama 4-betriebene Meta-KI .

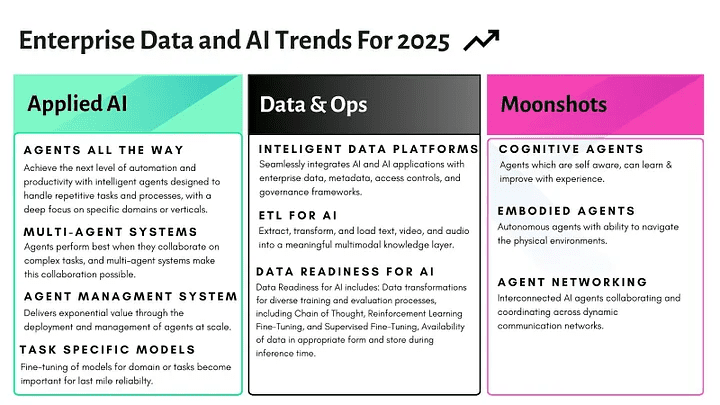

Meta hat sein Engagement für ein offenes Ökosystem bekräftigt, da es davon überzeugt ist, dass Offenheit die Innovation fördert. Die Veröffentlichung von Llama 4, insbesondere die MoE-Architektur, die nativen multimodalen Fähigkeiten und die ultralangen Kontextfenster, bieten KI-Entwicklern und -Forschern sicherlich leistungsstarke neue Werkzeuge. Die tatsächliche Leistung dieser fortschrittlichen Modelle, ihre Benutzerfreundlichkeit, die Kosten für die Feinabstimmung und die potenziellen Risiken, die sie bei der Förderung "personalisierter Erfahrungen" darstellen, müssen jedoch noch getestet und beobachtet werden. Ob die Llama 4-Serie wirklich eine neue Ära der KI unter der Führung von Meta einläuten wird, wird letztlich der Markt beantworten. Meta hat außerdem angekündigt, dass es auf der LlamaCon am 29. April weitere Informationen über seine Vision geben wird.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...