LiteAvatar: Audio-gesteuerte 2D-Porträts von interaktiven digitalen Menschen in Echtzeit, die mit 30 Bildern pro Sekunde auf der CPU laufen

Allgemeine Einführung

LiteAvatar ist ein Open-Source-Tool, das vom HumanAIGC-Team (Teil von Ali) entwickelt wurde und sich auf die Erzeugung von Gesichtsanimationen aus audiogesteuerten 2D-Avataren in Echtzeit konzentriert. Es läuft mit 30 Bildern pro Sekunde (fps) allein auf der CPU und eignet sich daher besonders für stromsparende Szenarien wie Echtzeit-2D-Videochats oder Avatar-Anwendungen auf mobilen Geräten. LiteAvatar kombiniert Spracherkennung (ASR) und Mundvorhersage, um synchronisierte Gesichtsausdrücke und Mundbewegungen auf der Grundlage eingehender Audio-Features zu generieren, mit weichen und natürlichen Animationseffekten. Das Projekt wird auf GitHub gehostet, wobei der vollständige Code und die Dokumentation für Entwickler kostenlos zur Verfügung stehen und nach Bedarf weiterentwickelt werden können. Ob für Unterhaltung, Bildung oder virtuelles Hosting, dieses Tool demonstriert die perfekte Kombination aus geringem Gewicht und hoher Leistung.

Einsatz der interaktiven Echtzeit-Version von LiteAvatar: https://github.com/HumanAIGC-Engineering/OpenAvatarChat

Funktionsliste

- Audiogesteuerte AnimationserstellungGenerierung von Gesichtsausdrücken und Mundanimationen von Avataren in Echtzeit durch Eingabe von Audio.

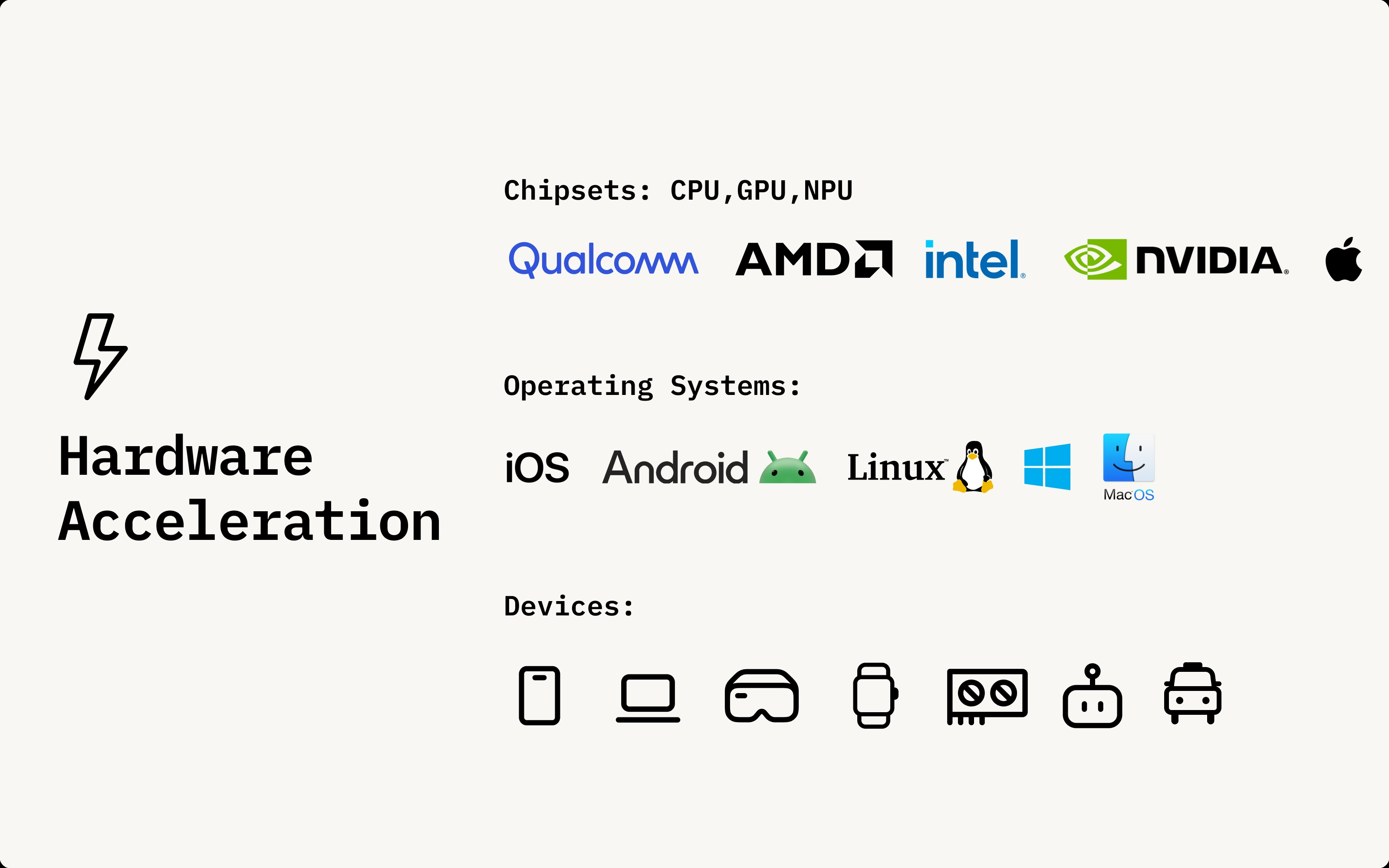

- Leichter BetriebRuckelfreie Animationen mit 30 Bildern pro Sekunde können allein durch die CPU erreicht werden, ohne dass GPU-Unterstützung erforderlich ist.

- Vorhersage der MundsynchronisationDas ASR-Modell wird verwendet, um Audiomerkmale zu extrahieren und Mundbewegungen zu erzeugen, die dem Sprachinhalt entsprechen.

- Unterstützung für mobile GeräteDas optimierte Modell ist an Geräte mit geringem Stromverbrauch angepasst und eignet sich für Mobiltelefone oder Tablets.

- Open-Source-UnterstützungDer vollständige Quellcode wird zur Verfügung gestellt, so dass die Benutzer die Funktionalität anpassen oder in andere Projekte integrieren können.

- Echtzeit-VerarbeitungsfähigkeitDie Verarbeitung von Audio-Eingängen mit geringer Latenz sorgt dafür, dass die Animation in hohem Maße mit dem Ton synchronisiert ist.

Hilfe verwenden

LiteAvatar ist ein auf GitHub basierendes Open-Source-Projekt, das eine gewisse technische Basis für die Installation und Nutzung voraussetzt. Im Folgenden finden Sie eine detaillierte Installations- und Nutzungsanleitung, die Ihnen den schnellen Einstieg in dieses audiogetriebene 2D-Avatar-Tool ermöglicht.

Einbauverfahren

- Vorbereitung der Umwelt

- Stellen Sie sicher, dass Sie Python 3.8 oder höher auf Ihrem Computer installiert haben. Dies können Sie mit dem Befehl

python --versionÜberprüfen Sie die Version. - Installieren Sie Git, das zum Herunterladen von Code von GitHub verwendet wird. Windows-Benutzer können Git von der offiziellen Website herunterladen, und Linux- oder macOS-Benutzer können es über einen Paketmanager installieren (z. B.

sudo apt install git). - Bereiten Sie ein Terminal vor, das die Befehlszeile unterstützt (z. B. CMD, PowerShell für Windows oder Terminal für Linux/macOS).

- Stellen Sie sicher, dass Sie Python 3.8 oder höher auf Ihrem Computer installiert haben. Dies können Sie mit dem Befehl

- LiteAvatar-Projekt herunterladen

- Öffnen Sie ein Terminal und geben Sie den folgenden Befehl ein, um das Code-Repository zu klonen:

git clone https://github.com/HumanAIGC/lite-avatar.git - Sobald das Klonen abgeschlossen ist, wechseln Sie in das Projektverzeichnis:

cd lite-avatar

- Öffnen Sie ein Terminal und geben Sie den folgenden Befehl ein, um das Code-Repository zu klonen:

- Installation von Abhängigkeiten

- Das Projekt erfordert die Unterstützung einiger Python-Bibliotheken. Führen Sie den folgenden Befehl aus, um die Abhängigkeiten zu installieren:

pip install -r requirements.txt - für den Fall, dass

requirements.txtIn der Dokumentation sind keine spezifischen Abhängigkeiten aufgeführt, Sie können sich auf die Projektdokumentation beziehen, zu den üblichen Abhängigkeiten gehörennumpyundtorch(CPU-Version),modelscopeusw. Beispiel für eine manuelle Installation:pip install numpy torch modelscope

- Das Projekt erfordert die Unterstützung einiger Python-Bibliotheken. Führen Sie den folgenden Befehl aus, um die Abhängigkeiten zu installieren:

- Überprüfen der Installation

- Nachdem die Installation abgeschlossen ist, führen Sie einen einfachen Testbefehl aus (der genaue Befehl richtet sich z. B. nach dem README des Projekts:

python demo.py - Wenn kein Fehler gemeldet wird, wurde die Umgebung erfolgreich konfiguriert.

- Nachdem die Installation abgeschlossen ist, führen Sie einen einfachen Testbefehl aus (der genaue Befehl richtet sich z. B. nach dem README des Projekts:

Verwendung

Die Kernfunktion von LiteAvatar ist es, Animationen aus audio-gesteuerten Avataren zu erzeugen. Hier sind die detaillierten Schritte:

Vorbereiten von Audiodateien

- Audioformat: Unterstützt gängige Formate wie

.wavvielleicht.mp3. Es wird empfohlen, klares Mono-Audio mit einer Abtastrate von etwa 16 kHz zu verwenden, um optimale Ergebnisse zu erzielen. - AudioquelleEs kann sich um Ihre aufgenommene Stimme oder um aus einem Video extrahiertes Audio handeln. Empfohlenes Tool: Audacity (kostenlose Audiobearbeitungssoftware).

Echtzeit-Animationen ausführen

- Auslöseverfahren

- Führen Sie im Projektverzeichnis das Hauptskript aus (vorausgesetzt, die

main.py(Der genaue Dateiname ergibt sich aus der README):python main.py --audio_path your_audio_file.wav - Parameter Beschreibung:

--audio_path: Gibt den Pfad der Audiodatei an.--outputOptionaler Parameter zur Angabe des Speicherpfads für das generierte animierte Video; der Standardwert kann direkt angezeigt werden.

- Führen Sie im Projektverzeichnis das Hauptskript aus (vorausgesetzt, die

- Echtzeit-Eingangsprüfung

- Wenn die Mikrofoneingabe unterstützt wird, probieren Sie den Echtzeitmodus aus (Sie müssen überprüfen, ob README diese Funktion bereitstellt). Beispiel-Befehl:

python main.py --live - Das Programm hört auf Mikrofoneingaben und erzeugt Animationen in Echtzeit.

- Wenn die Mikrofoneingabe unterstützt wird, probieren Sie den Echtzeitmodus aus (Sie müssen überprüfen, ob README diese Funktion bereitstellt). Beispiel-Befehl:

Ergebnisse anzeigen

- Ausgabe der AnimationNach der Ausführung zeigt das Programm eine Animation des Avatars auf dem Bildschirm an oder erzeugt eine Videodatei (z. B. eine

output.mp4). - AnpassungsparameterWenn die Animation nicht zufriedenstellend ist, können Sie in der Dokumentation nachlesen, wie Sie die Modellparameter anpassen, z. B. die Bildrate oder die Mundempfindlichkeit (je nach Code-Implementierung).

Featured Function Bedienung

Audiogesteuerte Animationserstellung

- umziehen::

- Bereiten Sie die Audiodatei vor, z. B.

test.wav. - Befehl ausführen:

python main.py --audio_path test.wav --output result.mp4 - Das Programm ruft das ASR-Modell von ModelScope auf, um Audiomerkmale zu extrahieren, und generiert dann die Animation durch das Mundvorhersagemodell.

- Bereiten Sie die Audiodatei vor, z. B.

- WirkungDer Mund und die Mimik der Avatare verändern sich in Abhängigkeit vom Ton, z. B. öffnen sich ihre Münder, wenn sie "Hallo" sagen, und sie singen mit mehr Rhythmusgefühl.

Einsatz von Mobilgeräten

- VoraussetzungenModelle müssen in ein leichtgewichtiges Format (z.B. ONNX) exportiert und auf dem Handy integriert werden.

- Rigg::

- Konvertieren Sie das Modell lokal (spezifische Skripte sind der Projektdokumentation hinzuzufügen, das Beispiel geht davon aus, dass die

export.py):python export.py --model lite_avatar_model.pth --output lite_avatar.onnx - Oberbefehlshaber (Militär)

.onnxDie Dateien werden auf mobilen Geräten bereitgestellt und mit ONNX-fähigen Frameworks wie NCNN ausgeführt.

- Konvertieren Sie das Modell lokal (spezifische Skripte sind der Projektdokumentation hinzuzufügen, das Beispiel geht davon aus, dass die

- am EndeLow-Power-Echtzeit-Animation auf Mobiltelefonen, geeignet für Video-Chat-Anwendungen.

caveat

- LeistungsoptimierungWenn Sie mit Laggy arbeiten, können Sie die Bildrate reduzieren (z.B. von 30fps auf 15fps), indem Sie die Konfigurationsdatei oder die Kommandozeilenparameter ändern.

- Komponenten während der Prüfung anpassenWenn Sie eine Fehlermeldung erhalten, überprüfen Sie, ob Ihre Abhängigkeitsversionen übereinstimmen, oder schauen Sie auf der GitHub Issues-Seite nach, um Hilfe von der Community zu erhalten.

- SkalierbarkeitWenn Sie neue Funktionen hinzufügen möchten (z.B. Emoji-Steuerung), können Sie das Projekt forken und den Code ändern. Das HumanAIGC-Team begrüßt es, wenn Sie Pull Requests einreichen.

Mit diesen Schritten können Sie LiteAvatar einfach installieren und verwenden, um den Prozess der audio-gesteuerten Avatar-Animation zu erleben. Dieses Tool bietet eine effiziente und bequeme Lösung sowohl für Entwicklungstests als auch für reale Anwendungen.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...