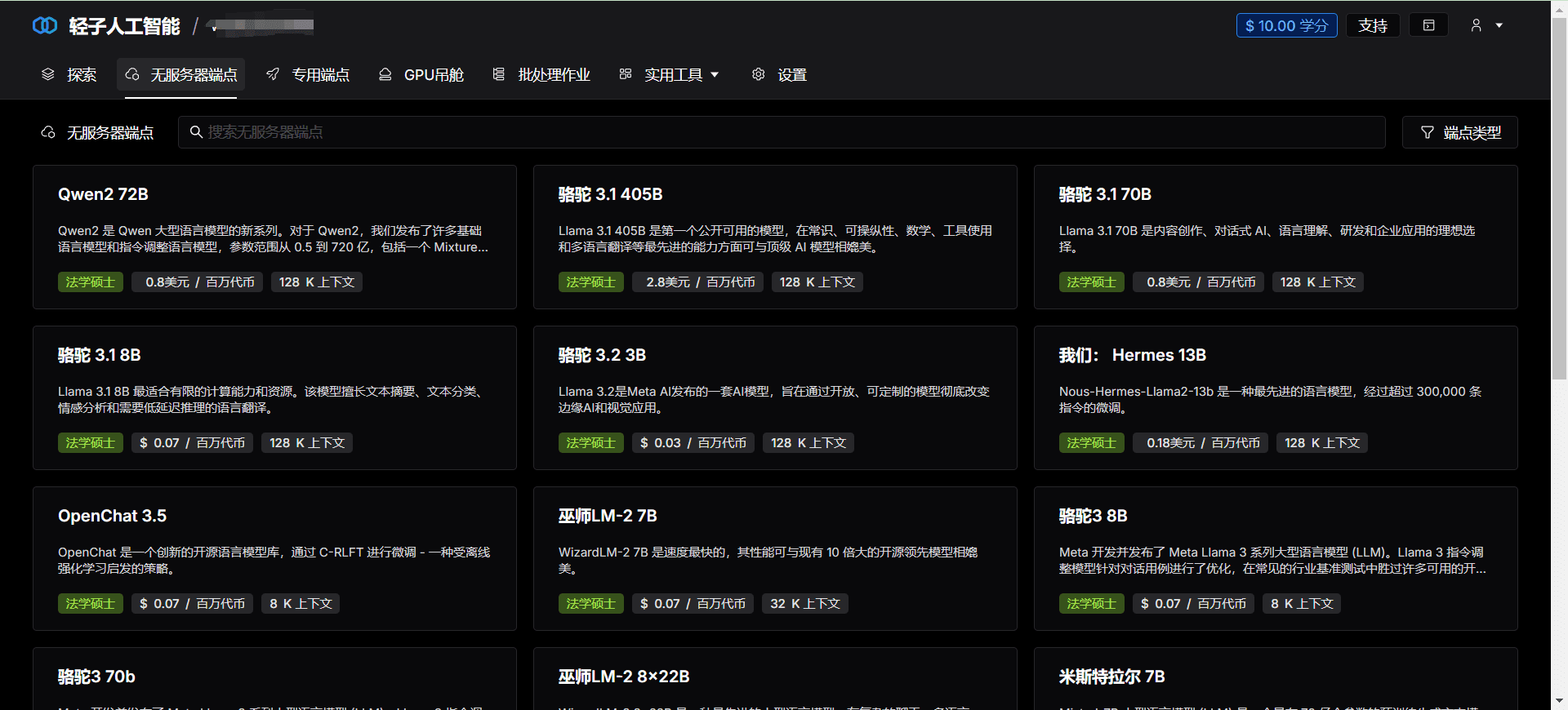

Lepton AI: Cloud-native KI-Plattform mit kostenloser Bereitstellung von KI-Modellen mit begrenzter GPU-Rate

Allgemeine Einführung

Lepton AI ist eine führende Cloud-native KI-Plattform, die Entwicklern und Unternehmen effiziente, zuverlässige und einfach zu nutzende KI-Lösungen bietet. Mit seinen leistungsstarken Rechenkapazitäten und seiner benutzerfreundlichen Oberfläche hilft Lepton AI seinen Nutzern bei der schnellen Landung und Skalierung von komplexen KI-Projekten.

Funktionsliste

- Effizientes RechnenBereitstellung hochleistungsfähiger Rechenressourcen für das Training und die Inferenz umfangreicher KI-Modelle.

- Cloud Native ErfahrungNahtlose Integration in die Cloud-Computing-Technologie zur Vereinfachung der Entwicklung und Bereitstellung von KI-Anwendungen.

- GPU-InfrastrukturBietet erstklassige GPU-Hardwareunterstützung, um eine effiziente Ausführung von KI-Aufgaben zu gewährleisten.

- Schneller EinsatzUnterstützt die native Python-Entwicklung für die schnelle Bereitstellung von Modellen, ohne dass Sie Container oder Kubernetes lernen müssen.

- Flexible APIBietet eine einfache und flexible API, die den Aufruf von KI-Modellen in jeder Anwendung erleichtert.

- Horizontale AusdehnungUnterstützt horizontale Skalierung zur Bewältigung umfangreicher Arbeitslasten.

Hilfe verwenden

Installation und Nutzung

- Registrieren Sie sich für ein KontoBesuchen Sie die Website von Lepton AI, klicken Sie auf die Schaltfläche "Registrieren" und geben Sie die erforderlichen Informationen ein, um Ihre Registrierung abzuschließen.

- Ein Projekt erstellenNach dem Einloggen gehen Sie auf "Systemsteuerung", klicken Sie auf "Projekt erstellen" und geben Sie den Namen und die Beschreibung des Projekts ein.

- Auswahl von ComputerressourcenIn den Projekteinstellungen wählen Sie die erforderlichen Rechenressourcen aus, einschließlich Typ und Anzahl der GPUs.

- Modell hochladenIn "Model Management" klicken Sie auf "Upload Model" und wählen die lokale Modelldatei zum Hochladen aus.

- Konfiguration der UmgebungIn "Environment Configuration" wählen Sie die gewünschte Laufzeitumgebung und die Abhängigkeitspakete aus.

- BereitstellungsmodellKlicken Sie auf "Bereitstellen". Das System wird das Modell automatisch bereitstellen und die API-Schnittstelle generieren.

- Aufrufen der APIIn "API-Dokumentation" können Sie die generierte API-Schnittstellendokumentation einsehen und das mitgelieferte API-Aufrufmodell zur Argumentation verwenden.

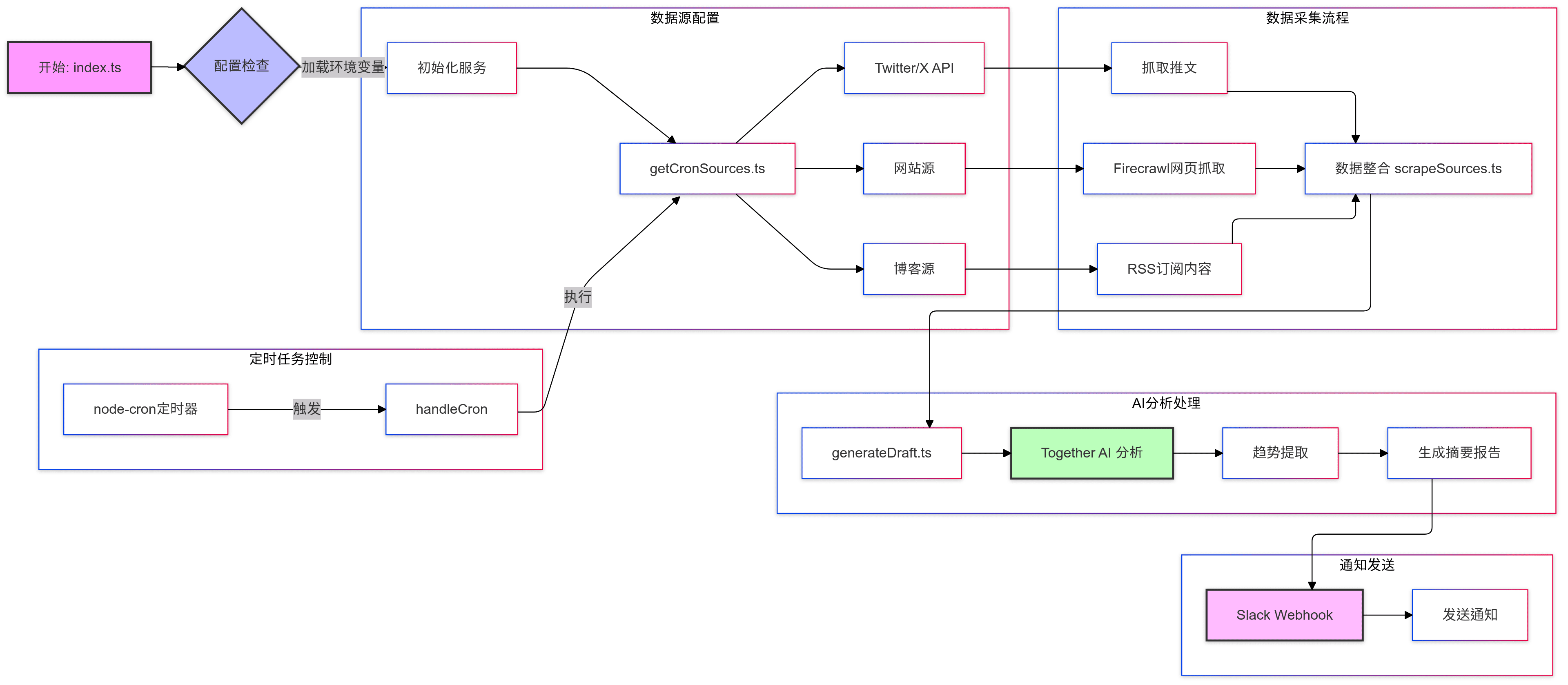

Arbeitsablauf

- ModellschulungModelltraining wird lokal mit Python durchgeführt, um sicherzustellen, dass das Modell die erwartete Leistung erbringt.

- ModellversucheModellprüfungen vor Ort durchführen, um die Genauigkeit und Stabilität des Modells zu überprüfen.

- Modell UploadUpload der trainierten Modelle auf die Lepton AI-Plattform zur Online-Bereitstellung.

- Umgebung KonfigurationKonfigurieren Sie die Laufzeitumgebung und die Abhängigkeitspakete entsprechend den Modellanforderungen, um sicherzustellen, dass das Modell ordnungsgemäß läuft.

- API-AufrufDie generierte API-Schnittstelle kann verwendet werden, um das Modell zur Inferenz in der Anwendung aufzurufen und die Ergebnisse in Echtzeit zu erhalten.

- Überwachung und WartungAuf der Seite "Monitor" können Sie den Betriebsstatus und die Leistungsindikatoren des Modells für eine rechtzeitige Wartung und Optimierung einsehen.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...