Die Benutzeroberfläche von Le Chat wurde verbessert, Mistral tritt offiziell in den Verbrauchermarkt ein und konkurriert mit ChatGPT

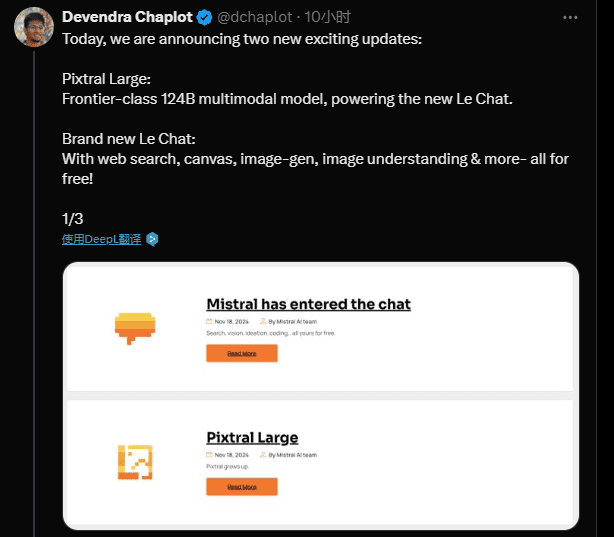

Mistral Gestern Abend wurden auf einen Schlag zwei wichtige Produktaktualisierungen veröffentlicht: das Chat-Tool - Le Chat und das multimodale Modell - Pixtral Large.

Das neue Le Chat

Neue Funktionen hinzugefügt: Leinwand, Websuche, Bilderzeugung, Bildverständnis, noch wie ihre Basis Mistral API Der Dienst ist derselbe, er muss kostenlos bleiben.

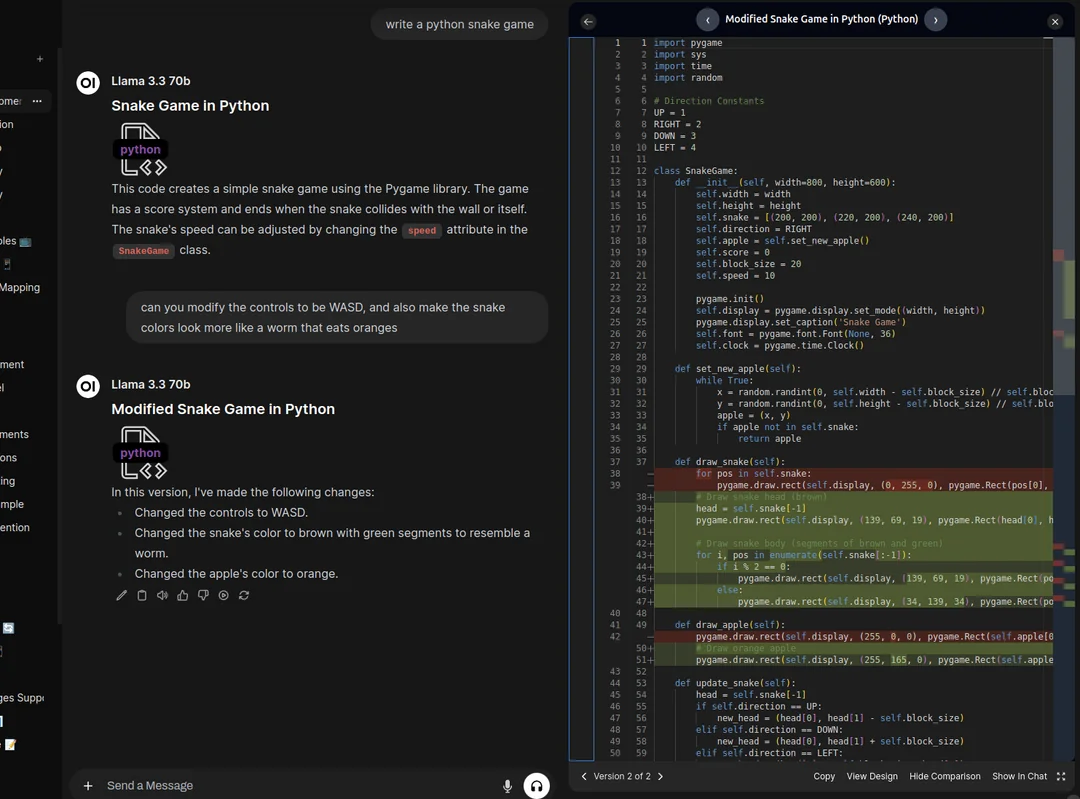

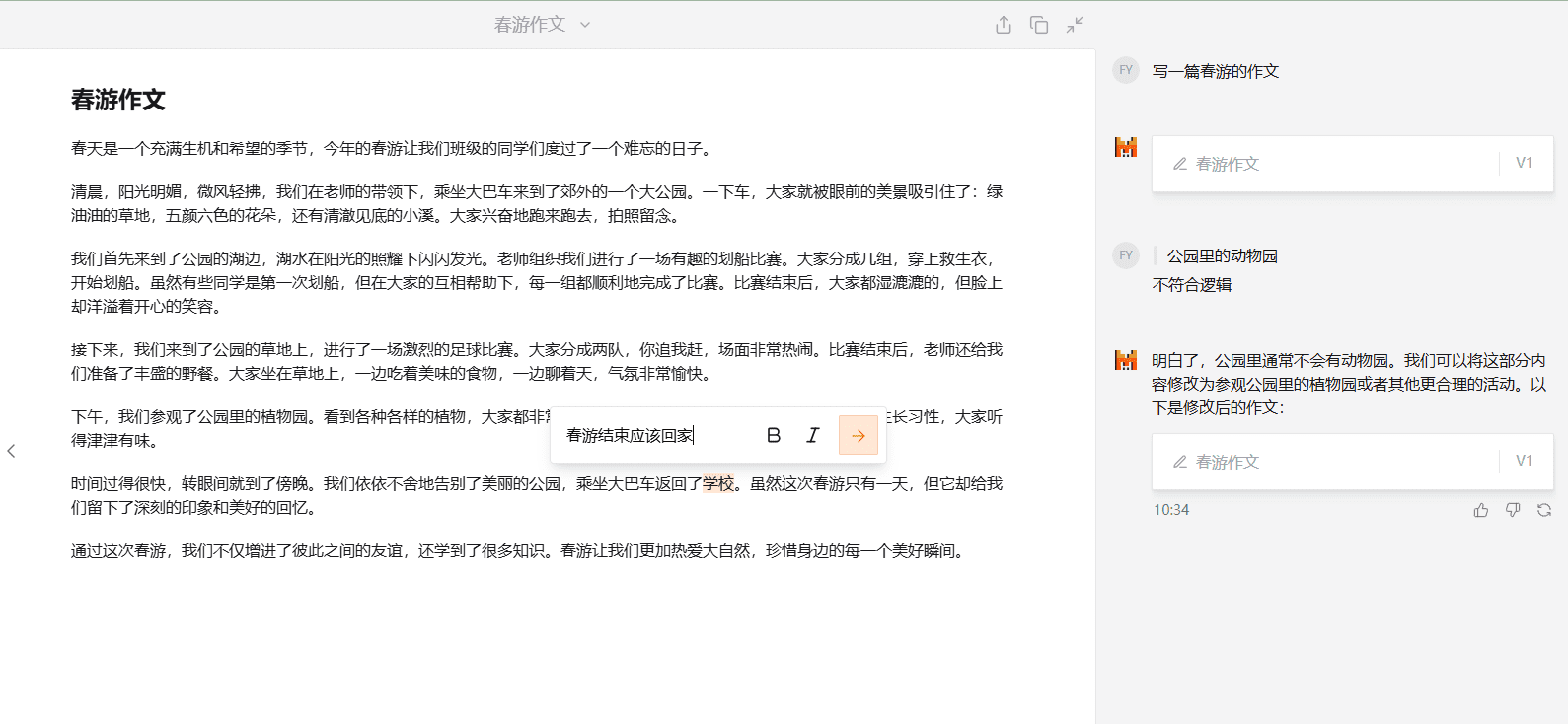

Le Chat-Leinwand

Der neue Inhalt kann durch Auswahl von Teilen des generierten Inhalts und Vorschlagen von Änderungen erstellt werden. Auf der rechten Seite befindet sich der Änderungsdatensatz und die beschriftete Version, auf der linken Leinwand der generierte Hauptinhalt.

Le Chat Websuche

Verlassen Sie sich auf die Brave-Suchmaschine, um die Quellen-URLs für Antwortzitate auszugeben.

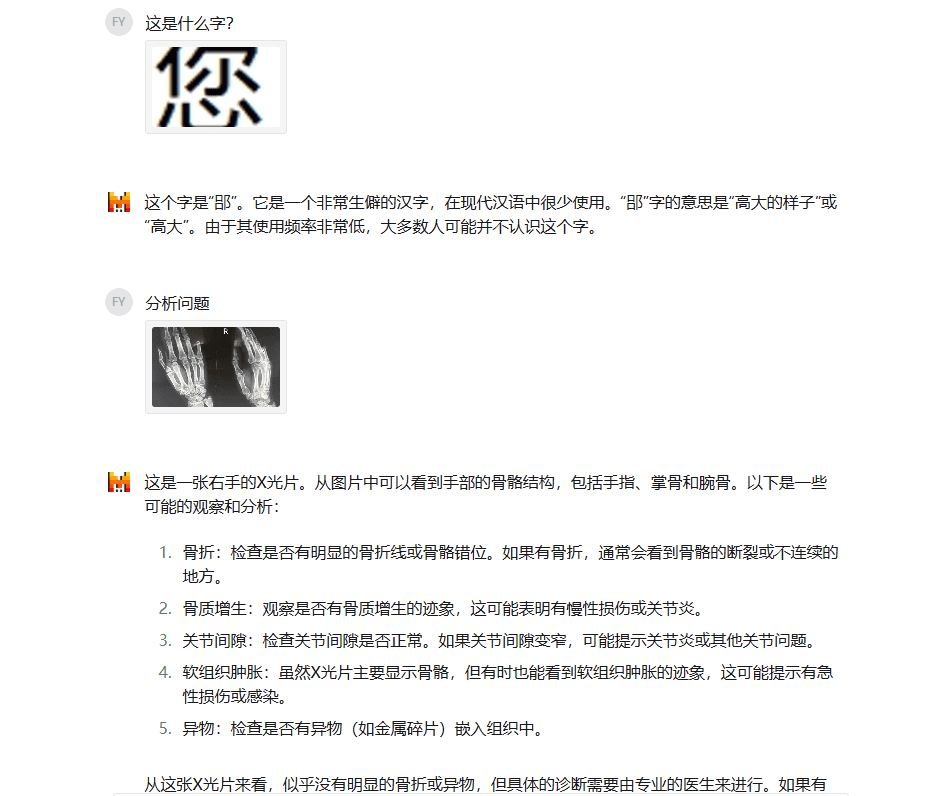

Le Chat Image Recognition

Bildinhalt und Bedeutung Anerkennung Kalibrierung, während die chinesischen einzigen Anerkennung ungenau, wenn die Länge der chinesischen, kann eine genauere Anerkennung, aber einzelne komplexe chinesische Schriftzeichen wird immer noch Fehler zu identifizieren oder Ausgabe Bedeutung ähnlich wie das einzelne Wort ist nicht das gleiche. Dies ist ähnlich wie die openai Modell, erwarten Sie nicht zu viel.

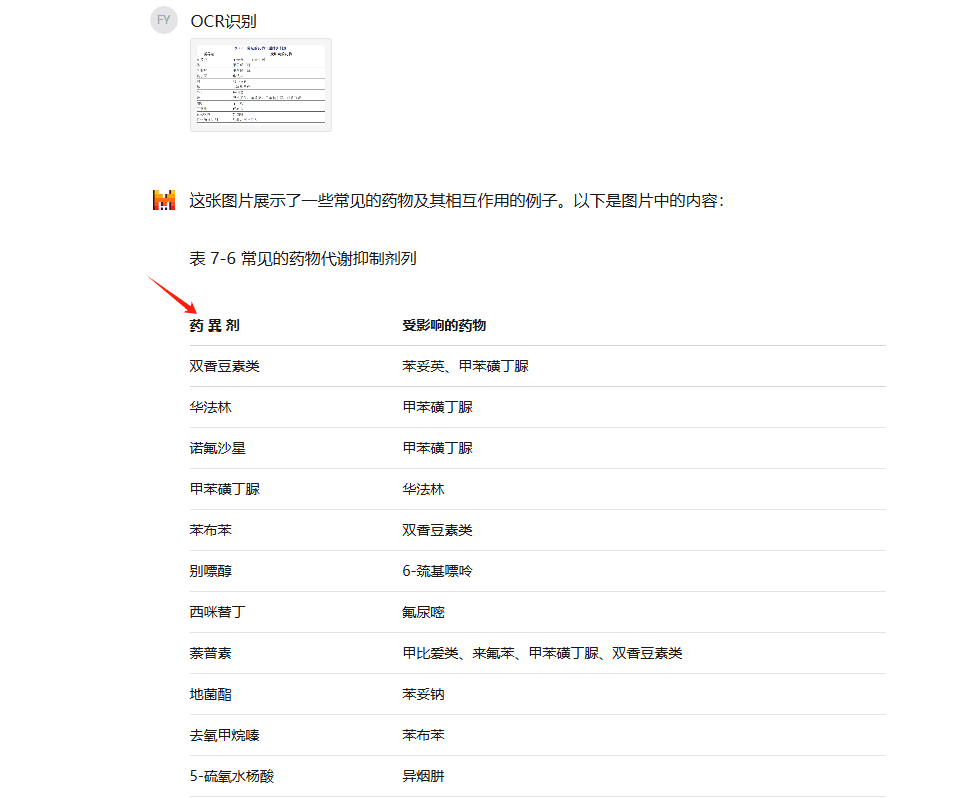

Das folgende Beispiel einer OCR kann eine gute Veranschaulichung der Situation: das Bild zeigt nur auf die Texterkennung Fehler, der ursprüngliche Text in der Abbildung ist "Induktor", was darauf hindeutet, dass die Bilderkennung von Text oder auf "Erraten", die Chinesen im Vergleich zu den englischen leicht erraten nicht passieren.

Le Chat Bilderzeugung

Wählen Sie Bilderzeugung, geben Sie eine Eingabeaufforderung mit den Worten create, draw, generate usw. ein, und das Flux Pro-Modell wird automatisch aufgerufen, um ein Bild zu erzeugen.

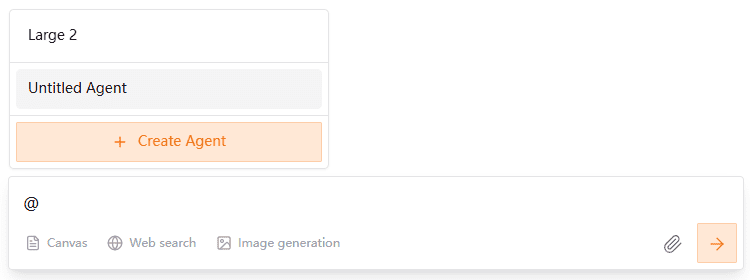

Wake Up Agent

Dies ist ein lange veröffentlichtes Feature... Viele Leute bemerken nicht, dass man alle von Mistral veröffentlichten Modelle auswählen kann, um den intelligenten Assistenten für Dialoge anzupassen, und man kann in das Dialogfeld tippen@ Wecken Sie den intelligenten Assistenten. Bei den meisten Aufgaben ist das großformatige Modell von Mistral für alle Arten von Aufgaben hervorragend geeignet.

Wir stellen das neue multimodale große Modell Pixtral Large vor.

- Multimodale Leistung auf Grenzniveau

- Stand der Technik bei MathVista, DocVQA, VQAv2

- Erweitert die Funktionalität von Mistral Large 2 ohne die Textleistung zu beeinträchtigen.

- 123B multimodaler Decoder, 1B parametrischer visueller Encoder

- 128K Kontextfenster: unterstützt mindestens 30 hochauflösende Bilder

- Verwendung:

- Versuche zur Chat

- in unserem API den Nagel auf den Kopf treffen

pixtral-large-latest - verfügbar unter hier (literarisch) Herunterladen von

Heute haben wir Pixtral Large veröffentlicht, ein 124B offen gewichtetes multimodales Modell, das auf Mistral Large 2 aufbaut. Pixtral Large ist das zweite Modell in unserer multimodalen Serie, das modernste Bildverstehensfähigkeiten demonstriert. Insbesondere ist das Modell in der Lage, Dokumente, Diagramme und natürliche Bilder zu verstehen, während es gleichzeitig die führenden Textverständnisfähigkeiten von Mistral Large 2 beibehält.

Das Modell steht für Forschung und Lehre unter der Mistral-Forschungslizenz (MRL) zur Verfügung. Für Experimente, Tests und die Produktion zu kommerziellen Zwecken kann es unter der Mistral-Kommerzlizenz verwendet werden.

Leistungen

Wir haben die Leistung von Pixtral Large mit dem Frontier-Modell bei einer Reihe von multimodalen Standard-Benchmarks mit einem Allzweck-Testtool bewertet. Bei MathVista erreicht unser Modell 69,4%, übertrifft damit alle anderen Modelle und zeigt, dass es in der Lage ist, komplexe mathematische Zusammenhänge anhand visueller Daten zu erkennen. Um seine Fähigkeit zu beurteilen, komplexe Diagramme und Dokumente zu verstehen, haben wir es mit ChartQA und DocVQA bewertet, wo Pixtral Large GPT-4o und Gemini-1.5 Pro übertraf.

Schließlich zeigt sich der Pixtral Large auch im MM-MT-Bench wettbewerbsfähig und übertrifft den Claude-3.5 Sonnet (neu), den Gemini-1.5 Pro und den GPT-4o (neu).Der MM-MT-Bench ist ein die eigenen finanziellen Ressourcen zu erweitern Eine überprüfungsbasierte Bewertung, die reale Anwendungsszenarien von multimodalen großen Sprachmodellen widerspiegeln soll (weitere Informationen finden Sie unter Pixtral 12B Technischer Bericht).

qualitatives Beispiel

Mehrsprachige OCR und Inferenz...

Stichwort Wort:

Ich habe Kaffee und Würstchen gekauft. Wie viel sollte ich bezahlen? Plus 18% für das Trinkgeld.

Antwort:

Um den Gesamtbetrag einschließlich des Trinkgelds 18% zu berechnen, gehen Sie wie folgt vor:

- Berechnen Sie die Kosten für Kaffee und Würstchen:

- 2x Latte Macchiato: 2 * 4.50 CHF = 9.00 CHF

- 1x Schweineschnitzel: 22.00 CHF

- Gesamtkosten für Kaffee und Wurst: 9.00 CHF + 22.00 CHF = 31.00 CHF

- Berechnen Sie die Spitze für 18%:

- Trinkgeld: 31.00 CHF * 0.18 = 5.58 CHF

- Addieren Sie das Trinkgeld zu den Gesamtkosten:

- Fälliger Gesamtbetrag: 31,00 CHF + 5,58 CHF = 36,58 CHF

Sie zahlen also insgesamt 36,58 CHF.

Grafisches Verständnis...

Stichwort Wort:

Seit wann gibt es Probleme mit dem Modell Dark Dragon?

Antwort:

Der Trainingsverlust für das Modell "dark-dragon-50" beginnt bei etwa 10.000 Schritten eine deutliche Instabilität zu zeigen. Es gibt eine deutliche Spitze in den Verlustwerten an diesem Punkt und eine weitere große Spitze bei etwa 20.000 Schritten. Diese Spitzen deuten darauf hin, dass der Trainingsprozess des Modells "dark-dragon-50" ab etwa 10.000 Schritten Probleme aufweist.

Weitere Beispiele...

Stichwort Wort:

Welche Unternehmen verwenden Mistral AI Das Modell?

Antwort:

Zu den Unternehmen, die das Mistral AI-Modell verwenden, gehören:

- BNP Paribas

- Mutig

- Cloudflare

- CMA CGM (Duffy Shipping Group, Frankreich)

- Vorderseite

Eine Sache noch...

Mit der Veröffentlichung von Pixtral LargeMistral Großwurde auch unser modernes Textmodell aktualisiert. Das Modell wurde aktualisiert in unserem API eingebettet in pixtral-large-latest Die Nutzung ist auch für die Forschung mit HuggingFace unter einer Mistral Forschungslizenz (MRL) oder für die kommerzielle Nutzung durch eine kommerzielle Lizenz von Mistral AI möglich.

Dieses neueste Modell ist eine deutliche Verbesserung gegenüber dem Vorgängermodell Mistral Large 24.07, mit bedeutenden Fortschritten beim Verstehen langer Zusammenhänge, neuen Systemhinweisen und genaueren Funktionsaufrufen. Das Modell ist ideal geeignet für RAG und intelligente Arbeitsabläufe, die in Anwendungsszenarien auf Unternehmensebene eingesetzt werden können, wie z. B. Wissenserforschung und -austausch, semantisches Verständnis von Dokumenten, Aufgabenautomatisierung und Verbesserung der Kundenerfahrung.

Mistral Large 24.11 wird in Kürze über unsere Cloud-Provider-Partner live gehen, beginnend mit Google Cloud und Microsoft Azure, und wird voraussichtlich innerhalb einer Woche verfügbar sein.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...