Laminar: Open-Source-KI-Produktentwicklungsplattform für einfache Datenvisualisierung, Verfolgung und Auswertung

Allgemeine Einführung

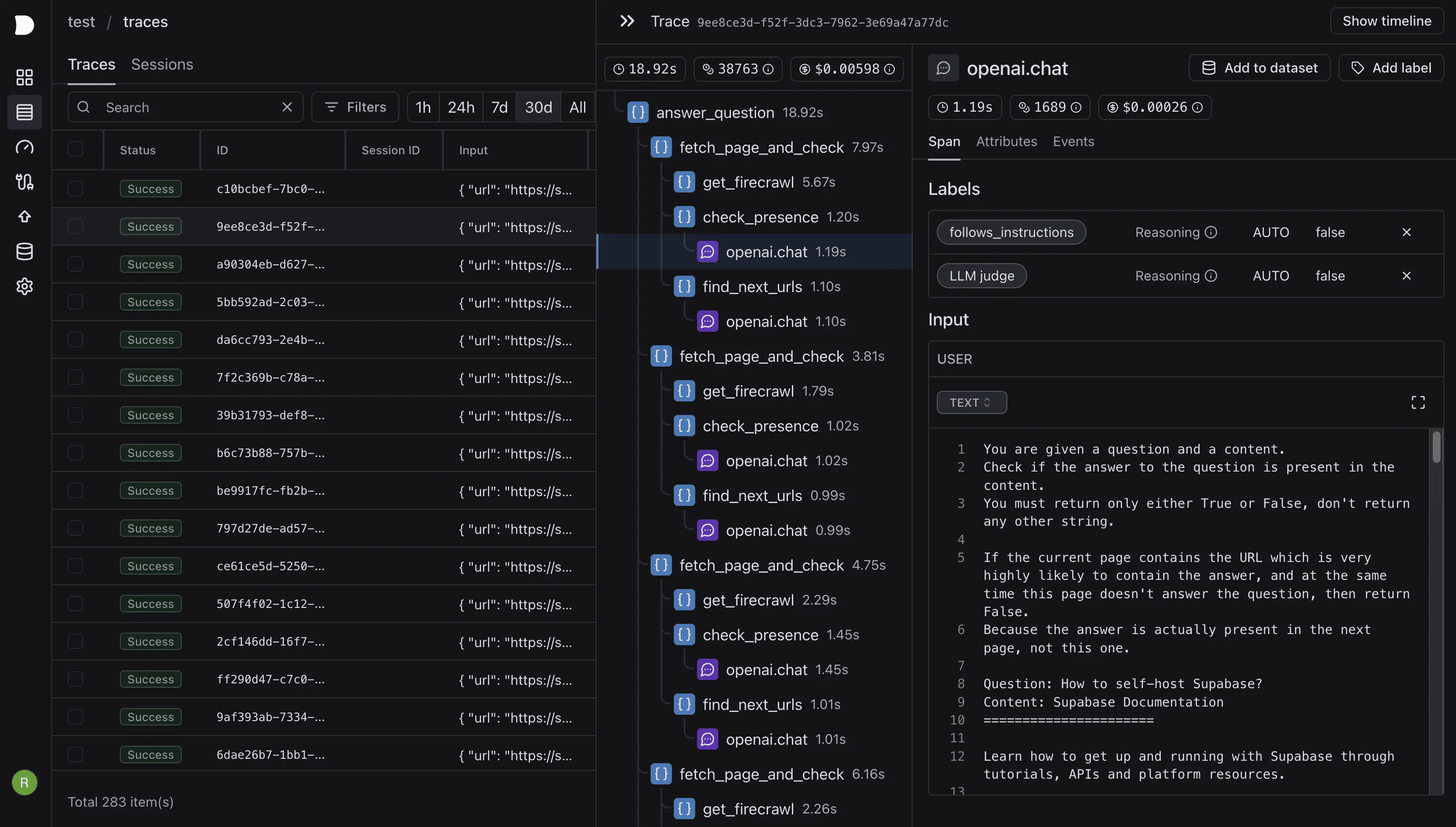

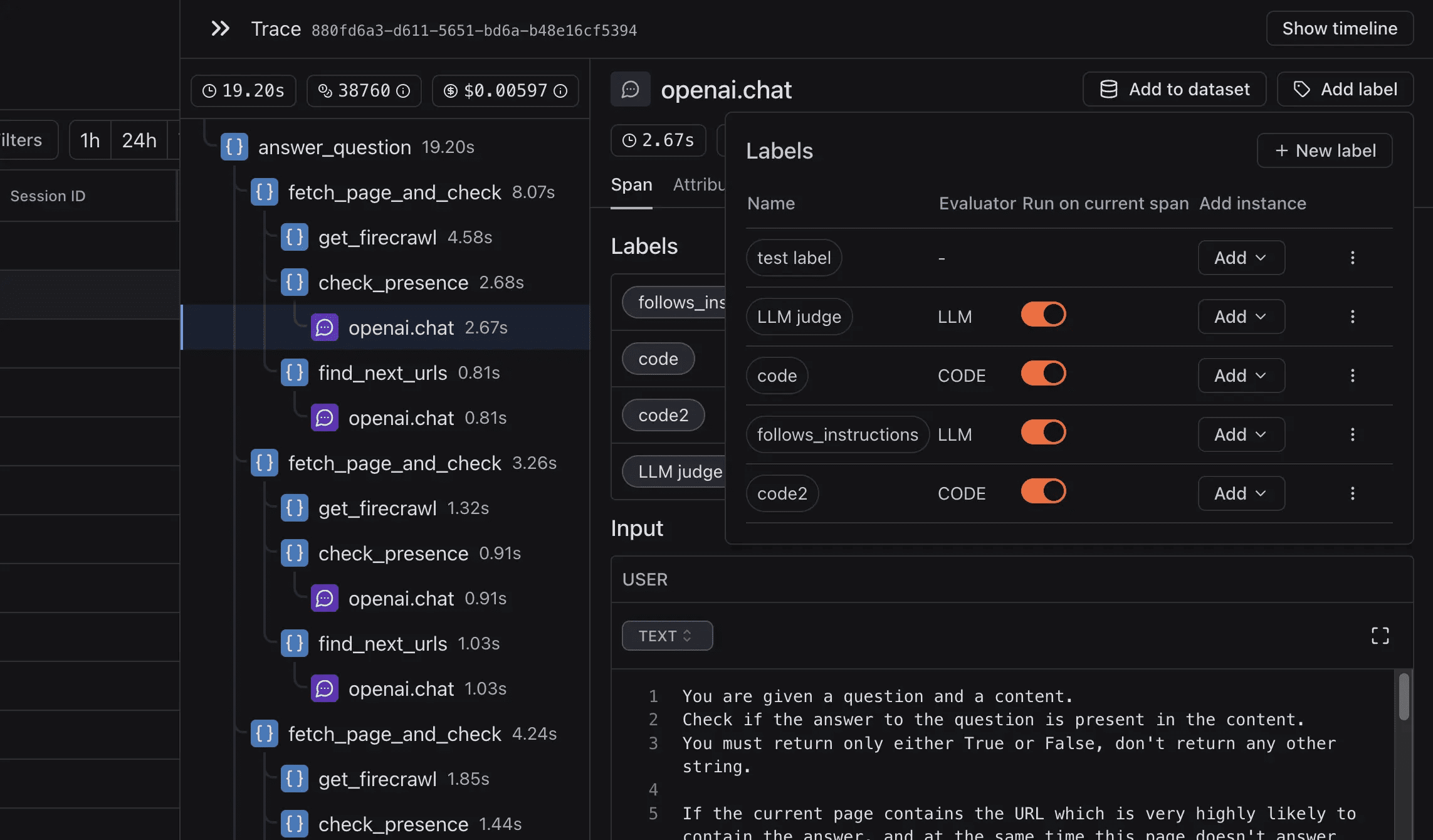

Laminar ist eine Open-Source-Plattform zur Optimierung von KI-Engineering, die sich auf KI-Engineering von den ersten Prinzipien an konzentriert. Sie hilft Anwendern, Daten zu sammeln, zu verstehen und zu nutzen, um die Qualität von LLM-Anwendungen (Large Language Models) zu verbessern. Laminar bietet umfassende Funktionen für Beobachtung, Textanalyse, Auswertung und Cue-Chain-Management, um Anwender bei der Entwicklung und Optimierung komplexer KI-Produkte zu unterstützen. Ob Datenverfolgung, Online-Evaluierung oder Erstellung von Datensätzen, Laminar bietet leistungsstarke Unterstützung für eine effiziente KI-Entwicklung und -Einführung.

Der moderne Open-Source-Technologiestack umfasst Rust, RabbitMQ, Postgres, Clickhouse und mehr und gewährleistet hohe Leistung und geringen Overhead. Benutzer können schnell mit Docker Compose bereitstellen oder die volle Funktionalität über eine gehostete Plattform nutzen.

DEMO: https://www.lmnr.ai/

Funktionsliste

- DatenverfolgungDokumentieren Sie jeden Schritt der Ausführung der LLM-Anwendung und sammeln Sie wertvolle Daten für eine bessere Bewertung und Feinabstimmung.

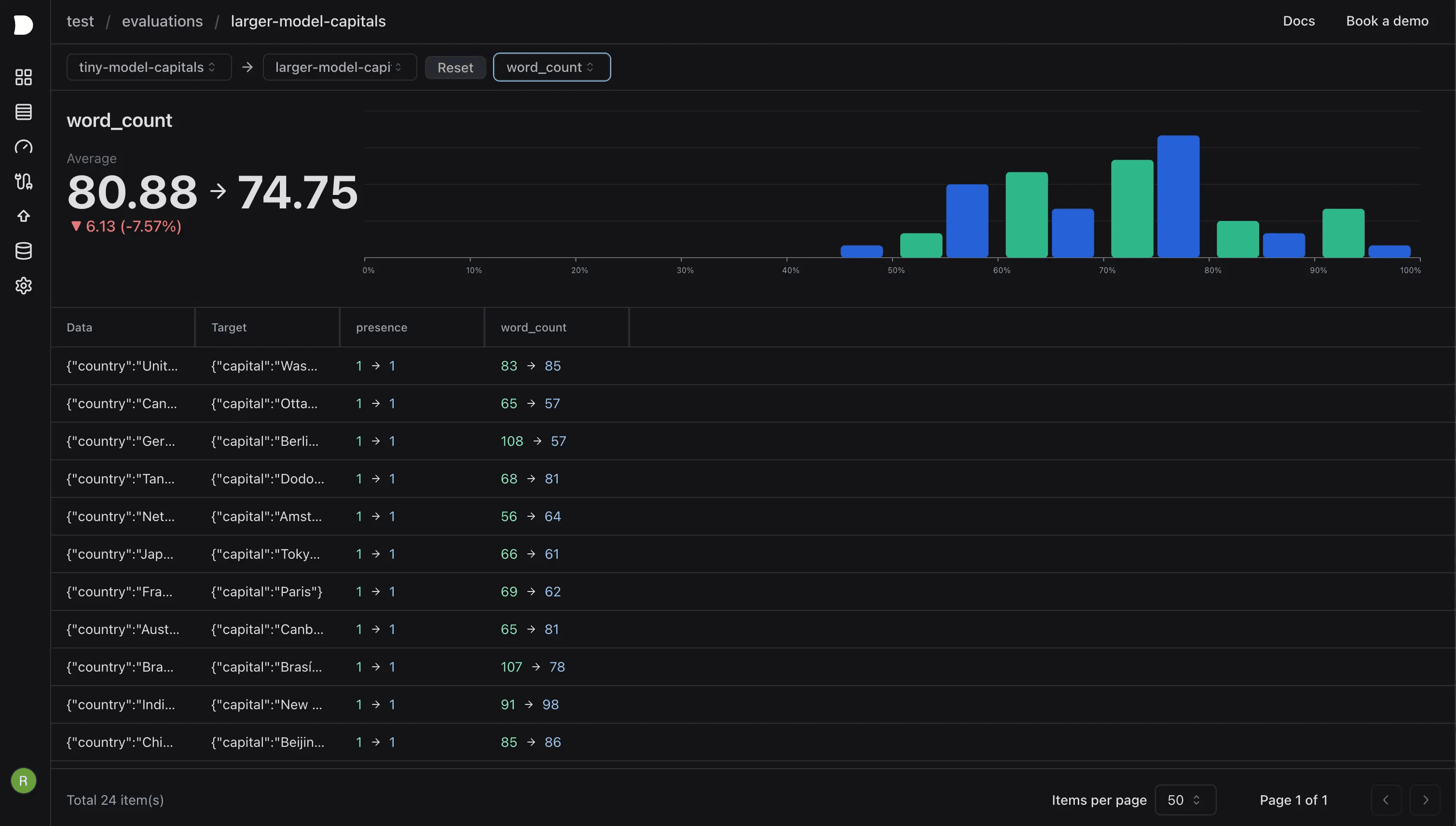

- Online-BewertungLLM als Rater einrichten oder ein Python-Skript als Evaluator für jede empfangene Spanne verwenden.

- Aufbau des DatensatzesErstellung von Datensätzen aus Verfolgungsdaten zur Bewertung, Feinabstimmung und Förderung der Technik.

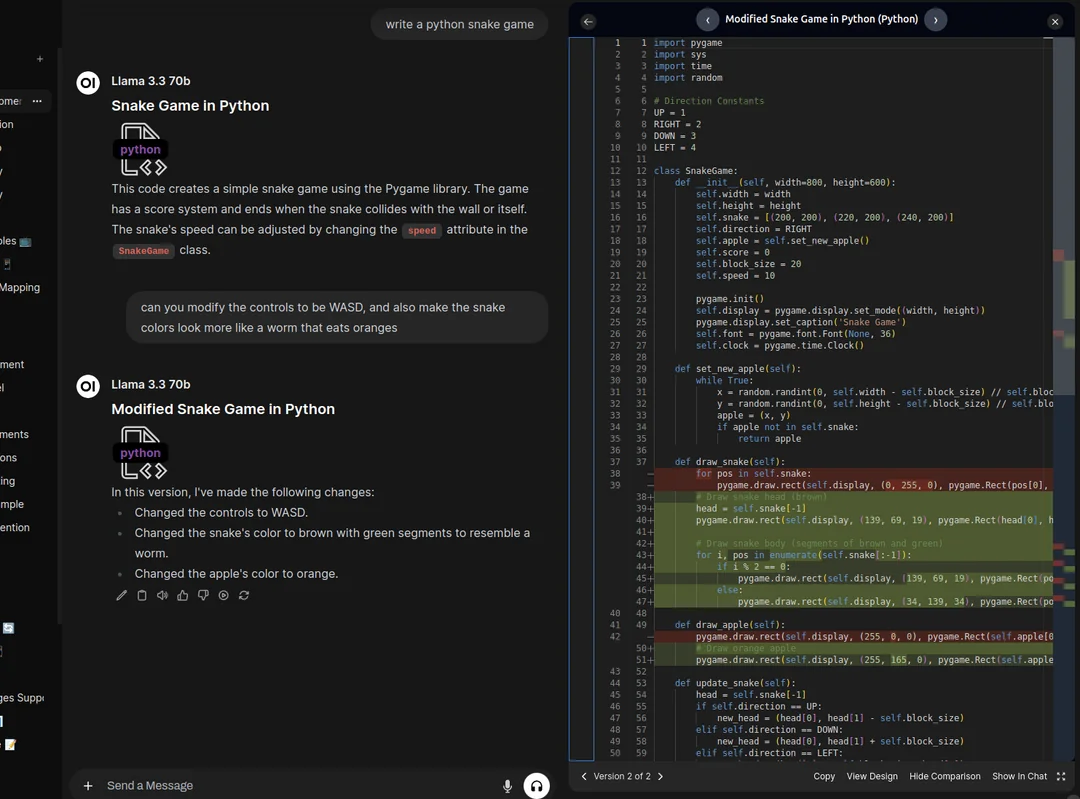

- Stichwort KettenmanagementUnterstützung für den Aufbau und das Hosting komplexer Cue-Ketten, einschließlich hybrider oder selbstreflexiver LLM-Pipelines.

- Quelloffen und selbstgehostetVollständig quelloffen, leicht selbst zu hosten und mit nur wenigen Befehlen einsatzbereit.

Hilfe verwenden

Einbauverfahren

- Klonen von GitHub-Repositories:

git clone https://github.com/lmnr-ai/lmnr - Rufen Sie den Projektkatalog auf:

cd lmnr - Gestartet mit Docker Compose:

docker compose up -d

Funktion Betriebsanleitung

Datenverfolgung

- InitialisierungImportieren Sie Laminar in Ihren Code und initialisieren Sie den API-Schlüssel des Projekts.

from lmnr import Laminar, observe Laminar.initialize(project_api_key="...") - Kommentarfunktion: Verwendung

@observeKommentieren Sie Funktionen, die nachverfolgt werden müssen.@observe() def my_function(): ...

Online-Bewertung

- Einrichten des EvaluatorsDer LLM kann so eingerichtet werden, dass er als Richter fungiert oder einen Python-Skriptauswerter verwendet, um jeden empfangenen Bereich zu bewerten und zu markieren.

# 示例代码 evaluator = LLMJudge() evaluator.evaluate(span)

Aufbau des Datensatzes

- Erstellen eines DatensatzesDaten aus Tracking-Daten für die spätere Auswertung und Feinabstimmung konstruieren.

dataset = create_dataset_from_traces(traces)

Stichwort Kettenmanagement

- Eine Kette von Stichwörtern bildenUnterstützung für den Aufbau komplexer Cue-Ketten, einschließlich Agentenmischung oder selbstreflektierender LLM-Pipelines.

chain = PromptChain() chain.add_prompt(prompt)

selbst gehostet

- Selbstgehostete SchritteUm mit nur wenigen Befehlen mit dem Self-Hosting zu beginnen, stellen Sie sicher, dass Docker und Docker Compose in Ihrer Umgebung installiert sind.

git clone https://github.com/lmnr-ai/lmnr cd lmnr docker compose up -d

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...