Kunlun Weaver veröffentlicht Chinas erstes Open Source Video Big Model für KI-Kurzfilme

Allgemeine Szenarien versus vertikale Szenarien, das ist die erste Wahl, die sich bei der Entwicklung von KI-Großmodellen stellt.

Bei den meisten Videomodellen auf dem Markt handelt es sich um allgemeine Modelle, die auf der Grundlage von Eingabeaufforderungen durch die Benutzer Videoinhalte für verschiedene Szenarien erzeugen können. Gleichzeitig haben einige der großen Videomodelle begonnen, vertikale Bereiche zu erforschen, die näher an den Anwendungsszenarien liegen, wie z. B. das kürzlich von ByteDance veröffentlichte Goku Das Modell konzentriert sich also auf die Live-Banding-Anwendung von Digital Man.

SkyReels V1: Ein Meilenstein für chinesische KI-Kurzdrama-Videomodelle

Kunlun World Wide kündigte heute SkyReels V1 an, Chinas erstes großes Modell der Videogenerierung für die Erstellung von KI-Kurzfilmen. Kunlun Wanwei hat im Dezember 2024 SkyReels, eine Plattform für KI-Kurzfilme, offiziell ins Leben gerufen, und die SkyReels V1 wird robuste Big-Model-Technologie für die Plattform bereitstellen.

Nach eigenen Beobachtungen und Erfahrungen kann das SkyReels V1 als das "leistungsfähigste" Videomodell auf dem Markt bezeichnet werden. Es hat seine Ausdruckskraft unter Beweis gestellt, die mit der von Film und Fernsehen in vielen Aspekten vergleichbar ist, wie z. B. Mikroausdrücke von Charakteren, Details von Handlungen, Szenenaufbau, Bildkomposition und Objektivbedienung, und es ist in der Lage, Performance-Filmmaterial auf "Filmstar- und Königinnen-Niveau" zu erzeugen.

SkyReels A1: Simultane Open-Source-Algorithmen für kontrollierte Ausdrucksbewegungen

Zusammen mit SkyReels V1 veröffentlicht, ist die SkyReels A1 ist der erste von KunlunWanwei entwickelte Algorithmus auf SOTA-Ebene, der auf einem Videobasismodell basiert und durch Mimik und Aktion gesteuert werden kann.

Darüber hinaus sind SkyReels V1 und SkyReels A1 Open-Source-Modelle, die gemäß der Open-Source-Vereinbarung von allen Benutzern kostenlos heruntergeladen und verwendet werden können. Die Open-Source-Adresse lautet wie folgt:

https://github.com/SkyworkAI/SkyReels-V1

https://github.com/SkyworkAI/SkyReels-A1

https://skyworkai.github.io/skyreels-a1.github.io/report.pdf

wenn DeepSeek R1 setzt eine neue Open-Source-Benchmark für große Textmodelle, insbesondere für Inferenzmodelle, dann Kunlun Wanwei's SkyReels V1 SkyReels A1 und SkyReels A1 haben auf dem boomenden Markt für KI-Kurzfilme eine neue Stufe der Open Source etabliert. Mit der Unterstützung dieser beiden Modelle wird der Markt für KI-Kurzfilme voraussichtlich den "DeepSeek-Moment" einläuten.

1. das "leistungsstärkste" Video-Megamodell

SkyReels V1 ist ein großes Modell, das von der Open-Source-Community profitiert und aktiv zu ihr beiträgt. Es wird auf der Grundlage von HunYuan-Video trainiert, einem hybriden Videomodell, das von Tencent im Dezember 2023 als Open Source veröffentlicht wurde.

Obwohl Open-Source-Modelle bei allgemeinen Aufgaben gut abschneiden, ist ihre Leistung in bestimmten Bereichen oder bei segmentierten Aufgaben möglicherweise nicht optimal. Daher müssen die Modellanbieter in der Regel während des eigentlichen Trainingsprozesses eine Menge Feinabstimmung, Inferenzoptimierung und Sicherheitsabgleich vornehmen.

Derzeit weisen die großen Videomodelle auf dem Markt für KI-Kurzfilme im Allgemeinen Mängel bei der Erzeugung von Charakterausdrücken auf, wobei das größte Problem darin besteht, dass die Charakterausdrücke leer und wenig lebendig sind. Mit SkyReels V1 will Kunlun diese Probleme der Branche überwinden.

Die Modellschulung ist eine Schlüsselkomponente für die Beherrschung der Kenntnisse und Fähigkeiten eines großen Modells. Im Trainingsprozess von SkyReels V1 besteht das Hauptziel von KunlunWei darin, dem Modell beizubringen, "wie es funktioniert". Zu diesem Zweck hat Kunlun vor allem die beiden folgenden technologischen Kerninnovationen durchgeführt:

Datenbereinigung und Kennzeichnung: ein Eckpfeiler der Modellfeinabstimmung

Die erste ist die Datenbereinigung und -etikettierung, die ein wichtiger Bestandteil der Modellfeinabstimmung ist. Genauso wie ein Lehrer hochwertiges Lehrmaterial benötigt, um sich auf den Unterricht vorzubereiten, hat KunlunWavi einen hochwertigen Datensatz von zehn Millionen Filmen, Fernsehserien und Dokumentarfilmen erstellt, der auf einem selbst entwickelten, hochwertigen Datenbereinigungs- und manuellen Etikettierungsprozess basiert. Dies ist das "Lehrmaterial" für SkyReels V1 zum Erlernen der Schauspielerei.

Das menschenzentrierte multimodale Großmodell des Videoverstehens: Verbesserung des Zeichenverständnisses

"Unterrichtsmaterialien" allein reichen nicht aus; es bedarf einer eingehenderen Anleitung zur Modellierung. Daher hat KunlunWanwei ein eigenes menschenzentriertes (zeichenzentriertes) multimodales Modell für das Verstehen von Videos entwickelt. Ziel ist es, die Fähigkeit des Modells, die Informationen zu den Figuren im Video zu verstehen, deutlich zu verbessern.

Dieses intelligente Analysesystem für Charaktere, das auf einem großen multimodalen Modell für das Verstehen von Videos basiert, kann auf mehreren Ebenen Effekte wie Ausdruckserkennung, Wahrnehmung der räumlichen Position des Charakters, Verstehen von Verhaltensabsichten und Verstehen von Aufführungsszenen auf "Filmstar-Niveau" erzielen.

Was ist eine "Filmstar"-Darbietung?

SkyReels V1 ist beispielsweise in der Lage, Mikroausdrücke von Charakteren in Filmqualität zu erzeugen. Es unterstützt 33 subtile Charakterausdrücke und mehr als 400 Kombinationen natürlicher Bewegungen, die den emotionalen Ausdruck des echten Lebens sehr gut wiedergeben.

Ein weiteres Beispiel ist, dass SkyReels V1 auch die Ästhetik von filmgerechter Beleuchtung beherrscht. SkyReels V1 wurde mit hochwertigen Film- und TV-Daten in Hollywood-Qualität trainiert, so dass jedes von SkyReels V1 erzeugte Bild in Bezug auf Komposition, Schauspielerposition und Kamerawinkel eine filmische Qualität aufweist.

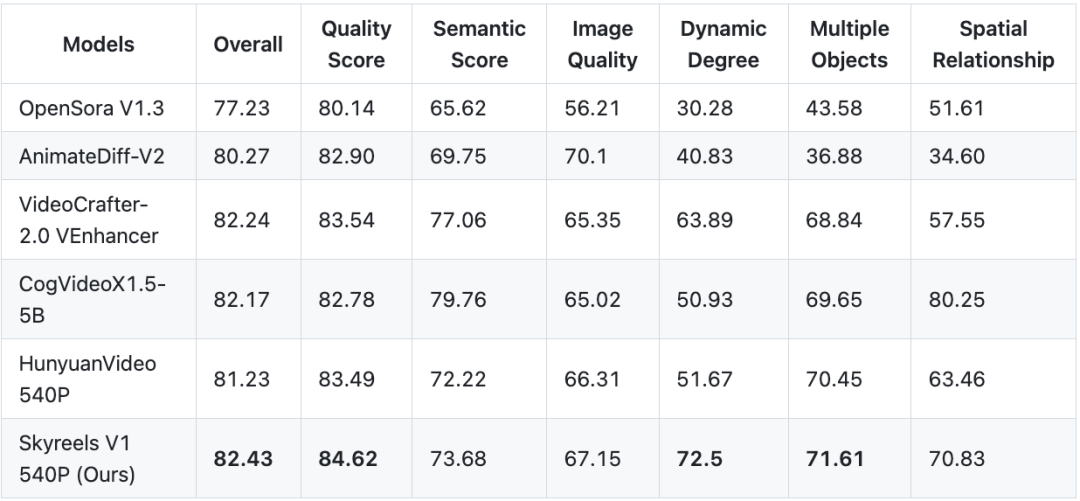

Vergleich von SkyReels V1 mit Closed-Source-Modellen

Obwohl SkyReels V1 ein Open-Source-Modell ist, erzielt es Ergebnisse, die mit Closed-Source-Modellen wie Conch AI und Corinne AI vergleichbar sind. Unter den gleichen Bedingungen für das Stichwort ist der Vergleich der Generierungsergebnisse von SkyReels V1, Conch AI und Keling AI wie folgt:

Stichwort Wort 1: Ein Bild einer braunhaarigen Frau mit einer wunderschönen rot getönten Brille und karmesinrotem Lippenstift. Sie winkte mit der Hand nach vorne und lächelte, dann lachte sie.

SkyReels V1.

Conch AI.

Kerin AI.

Stichwort Wort 2: Die dramatische Frontalaufnahme zeigt das Gesicht eines Tiefseetauchers, der einen altmodischen Kupfer-Tauchhelm trägt. Das dicke runde Glas des Helms gibt den Blick frei auf seinen ruhigen Gesichtsausdruck. Winzige Bläschen steigen im Inneren des Helms auf, und an den Innenwänden haften Wassertröpfchen. Vorsichtig hielt er ein aufgeschlagenes Buch in der Hand, dessen Seiten sanft in der Unterwasserströmung flatterten. Das Buch schien trocken und unversehrt zu sein, ganz im Gegensatz zu seiner wässrigen Umgebung. Sanfte Sonnenstrahlen durchdrangen das Wasser, beleuchteten sein Gesicht und warfen einen goldenen Schimmer auf die Seiten. Um ihn herum schwammen Fische, deren Farben durch die Tiefe gedämpft wurden, aber vor dem blaugrünen Hintergrund immer noch lebhaft wirkten. Der Taucher liest den Text aufmerksam, ganz in die Lektüre vertieft, obwohl er unter Wasser ist. Die surreale Kombination von Literatur und den Tiefen des Ozeans schafft eine traumhafte Atmosphäre und unterstreicht die Suche nach Wissen an den unerwartetsten Orten.

SkyReels V1.

Conch AI.

Kerin AI.

In Bezug auf die tatsächlichen Ergebnisse zeigt SkyReels V1 die Stärke der Closed-Source-Modelle in Bezug auf die Bildklarheit und die Feinheit der Charakterdarstellung. SkyReels V1 übertrifft die Closed-Source-Modelle sogar in Bezug auf die Haardynamik und andere Details.

Graphgenerierte Videofunktionen, die in Open-Source-Modellen ihresgleichen suchen

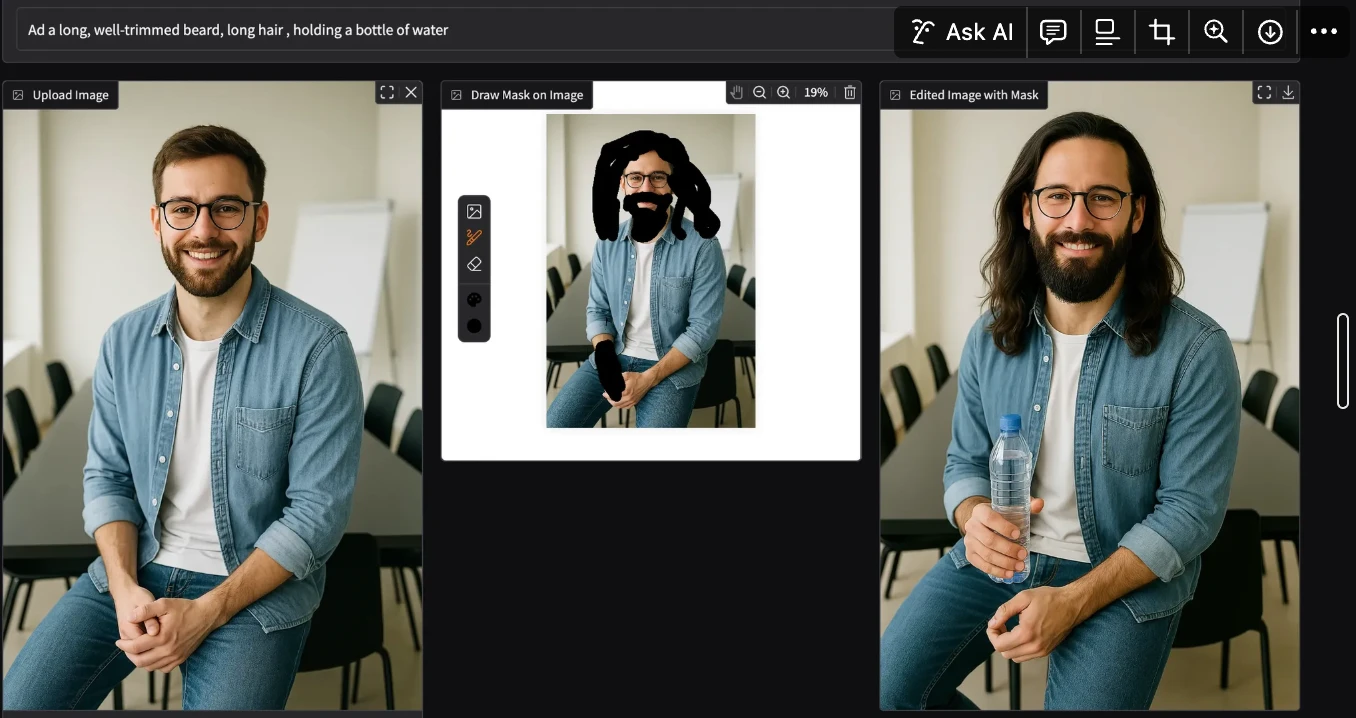

Darüber hinaus unterstützt SkyReels V1 nicht nur textgenerierte Videos, sondern auch bildgenerierte Videos, die zu den leistungsfähigsten graphgenerierten Videomodellen unter den aktuellen Open-Source-Modellen gehören.

Um die Fähigkeiten von SkyReels V1 bei der Grafikerzeugung zu testen, haben wir das Modell mit Standbildern des beliebten Murmeltiers aus dem chinesischen Neujahrsfilm Ne Zha's Demon Child Descends gefüttert und ein Stichwort gesetzt: Das Murmeltier schaut auf, hält eine Sekunde inne und schreit dann. Die von SkyReels V1 erzeugten Ergebnisse sind verblüffend:

Wohl wahr.SkyReels V1 ist das leistungsstärkste Videomakromodell auf dem heutigen Markt.

2. selbstentwickeltes Inferenzsystem SkyReels Infer: Aufbau eines Open-Source-Modells für alle

Noch wertvoller ist, dass SkyReels V1 als Open-Source-Modell nicht nur einen bedeutenden Durchbruch bei der Erzeugung von Ergebnissen erzielt hat, sondern auch eine sehr hohe Inferenz-Effizienz aufweist. Dies ist SkyReels Infer zu verdanken, einem von Kunlun Wanwei entwickelten Argumentationsrahmen.

Implikationen eines Rahmens für die Selbstbeurteilung

Welche Bedeutung haben selbstrecherchierende Begründungsrahmen?

Im Allgemeinen werden Open-Source-Modelle seltener speziell für Inferenz-Frameworks optimiert, insbesondere in großen Anwendungsszenarien. Ohne eine Optimierung des Inferenzrahmens ist es jedoch schwierig, die Anforderungen der Benutzer in Bezug auf Effizienz und Kosten der Schlussfolgerungen zu erfüllen.

Ein Beispiel dafür ist die für Anfang 2024 geplante Veröffentlichung von OpenAI. Sora Damals berichteten einige Nutzer, dass Sora eine Stunde brauchte, um ein einminütiges Video zu erstellen. Dies war einer der Hauptgründe, warum Sora fast ein Jahr nach seiner Veröffentlichung eingestellt wurde. Auch heute noch haben viele der großen Videomodelle mit dem Problem der langen Wartezeiten bei der Erstellung von Videos zu kämpfen.

SkyReels Infer, das von KunlunWanwei entwickelte Inferenz-Framework, bietet nicht nur eine hohe Leistung, sondern berücksichtigt auch Effizienz und Benutzerfreundlichkeit.

Die überlegene Leistung von SkyReels Infer

Die Inferenzgeschwindigkeit von SkyReels Infer ist ausgezeichnet. Auf einer einzelnen RTX 4090-Karte dauert es nur 80 Sekunden, um ein 544P-Video zu erzeugen. Der Benutzer kann in Gedanken versunken sein oder auf seinem Handy surfen, und schon ist das Video erstellt.

SkyReels Infer unterstützt verteiltes paralleles Rechnen auf mehreren Karten. Dies ist eine leistungsstarke Technologie. Einfach ausgedrückt, ermöglicht sie die Zusammenarbeit mehrerer Grafikkarten bei der Videoerzeugung.

Mit Technologien wie Context Parallel, CFG Parallel und VAE Parallel arbeiten mehrere Grafikkarten als hocheffizientes Team zusammen, um erhebliche Verarbeitungsgeschwindigkeiten zu erreichen. Dies ist besonders nützlich für Anwendungen, die umfangreiche Berechnungen erfordern, wie z. B. die Erstellung komplexer Animationen oder Videos mit Spezialeffekten.

SkyReels Infer zeichnet sich auch bei der Optimierung von niedrigem Videospeicher aus. Es nutzt die fp8-Quantisierung und die Offloading-Technologie auf Parameterebene, damit SkyReels Infer auch auf gewöhnlichen Grafikkarten mit kleinem Videospeicher reibungslos läuft.

Der Grafikspeicher ist ein wichtiger Parameter einer Grafikkarte, der die Menge der Daten bestimmt, die die Karte gleichzeitig verarbeiten kann. In der Vergangenheit erforderten viele Modelle der Videogeneration einen hohen Grafikspeicher, was den Durchschnittsnutzer oft davon abhielt, sie aufgrund mangelnder Grafikkartenleistung zu nutzen. Die Optimierung von SkyReels Infer für geringen Speicherbedarf hat diese Situation völlig verändert. Das bedeutet, dass die Benutzer die Leistung der Video-Generation-Modelle problemlos erleben können, ohne teure High-End-Grafikkarten kaufen zu müssen. Dies senkt zweifellos die Schwelle für die KI-Videogenerierung, so dass mehr Nutzer in den Genuss der KI-Technologie kommen können.

SkyReels Infer basiert auf der Open-Source-Bibliothek Diffuser. Die Diffuser-Bibliothek ist eine hervorragende Open-Source-Bibliothek, die eine Fülle von Funktionen und Werkzeugen bietet. SkyReels Infer basiert auf der Diffuser-Bibliothek und erbt natürlich viele ihrer Vorteile. Für Entwickler bedeutet dies, dass sie schnell loslegen und SkyReels Infer einfach in ihre bestehenden Projekte integrieren können.

Leistungsvergleich

Was ist die tatsächliche Leistung von SkyReels Infer? Kunlun verwendet SkyReels V1, das mit dem SkyReels Infer Inferenz-Framework ausgestattet ist, und HunYuan-Video, die offizielle Open Source von Tencent, um einen Leistungsvergleichstest durchzuführen. Die Testergebnisse zeigen, dass SkyReels V1 bei der Erstellung von 544p-Videos eine bessere Geschwindigkeit und Latenzzeit aufweist als HunYuan-Video.

Darüber hinaus unterstützt SkyReels V1 eine Multi-Card Deployment-Strategie, die es ermöglicht, bis zu 8 Grafikkarten gleichzeitig zu nutzen, um Rechenaufgaben zu beschleunigen. Darüber hinaus ist SkyReels V1 mit High-End-Grafikkarten wie der A800 und Consumer-Grafikkarten wie der RTX 4090 kompatibel und erfüllt damit die Anforderungen sowohl von professionellen als auch von gelegentlichen Nutzern.

3. quelloffener Algorithmus zur Steuerung von Ausdrucksbewegungen SkyReels A1: branchenführende "AI Face-Swapping"-Technologie

Es ist erwähnenswert, dass nach dem Modelltraining und den Inferenzsitzungen dieUm eine genauere und kontrollierbarere Videogenerierung von Charakteren zu erreichen, hat Kunlun außerdem SkyReels A1, einen kontrollierbaren Algorithmus für Ausdrucksbewegungen, der auf einem Videobasismodell basiert, als Open Source veröffentlicht.

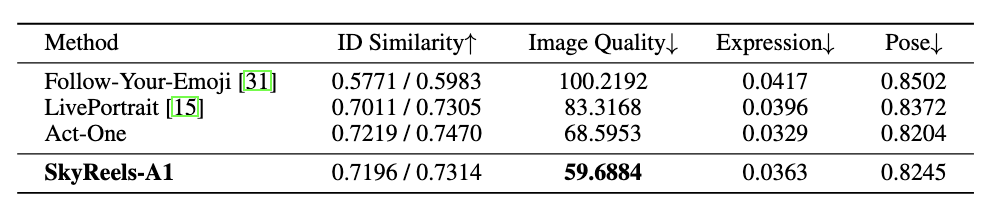

SkyReels A1 ist ein Algorithmus auf Anwendungsebene, der auf der zugrundeliegenden Trainings- und Inferenztechnologie aufsetzt und mit der Act-One-Technologie von Runway zur Erfassung filmischer Ausdrücke verglichen wird.

Das "AI Face Swap"-Spiel von SkyReels A1.

Das Kernstück von Runway Act-One und Kunlun SkyReels A1 ist der "KI-Gesichtstausch": Die Benutzer müssen nur ein Foto von Charakter A und einen Videoclip von Charakter B vorbereiten, und dann können der Ausdruck, die Bewegung und die Linien von Charakter B direkt auf Charakter A übertragen werden. Das Gameplay von Runway Act-One und Kunlun SkyReels A1 basiert auf dem "KI-Gesichtstausch".

In Bezug auf ID-Ähnlichkeit, Bildqualität, Ausdruck und Pose erreicht SkyReels A1 SOTA-Ergebnisse (State of the Art) im Vergleich zu ähnlichen Open-Source-Algorithmen in der Branche. Im Vergleich zu ähnlichen Open-Source-Algorithmen in der Branche erzielt SkyReels A1 SOTA-Ergebnisse (State of the Art), die denen der Closed-Source-Technologie Act-One nahe kommen, mit einem Vorteil bei der Generierungsqualität.

Video-gesteuerte, filmische Ausdruckserfassung

Erstens ermöglicht SkyReels A1 eine videogestützte, filmische Ausdruckserfassung mit einem höheren Grad an Charakterausdruck als Runway Act-One.

Originalgetreue Wiedergabe der Mikroexpression

Als Nächstes folgt die originalgetreue Wiedergabe von Mikroexpressionen. SkyReels A1 ist in der Lage, äußerst realistische Videos von Menschen in Bewegung zu erzeugen, die auf jedem menschlichen Maßstab basieren, einschließlich Porträts, Halbkörper- und Ganzkörperkompositionen. Dieser Realismus entsteht durch die genaue Simulation von Ausdrucksveränderungen und Emotionen sowie durch die Tiefe der mehrdimensionalen Details wie Hauttextur und Körperbewegungen.

Zum Beispiel die Erzeugung von Seitengesichtsausdruckskontrollen:

und eine realistischere Erzeugung von Mikroausdrücken für Augenbrauen und Augen:

Gesichtserkennung und Verarbeitung großer Bewegungen

Zusätzlich zu den Mikroausdrücken übertrifft SkyReels A1 Runway Act-One auch in Bereichen wie der Beibehaltung von Gesichtern und der Verarbeitung großer Bewegungen. Die Beibehaltung von Gesichtern und die Verarbeitung großer Bewegungen sind genau die Bereiche, in denen viele Modelle zur Videogenerierung fehleranfällig sind.

Im folgenden Beispiel weist das Gesicht des Zeichens ganz rechts eine erhebliche Verzerrung auf, die nicht mit dem Originalbild des Zeichens übereinstimmt.

SkyReels A1 ermöglicht auch eine größere Kopf- und natürliche Körperbewegung. Im folgenden Fall hat der Körper der Figur ganz rechts fast keine Bewegung.

Es ist leicht zu erkennen, dass die Algorithmen von SkyReels A1 den komplexen Prozess der herkömmlichen Videoproduktion vereinfachen und den Autoren von Inhalten eine effiziente, flexible und kostengünstige Lösung bieten, die bei der Produktion einer Vielzahl von kreativen Inhalten eingesetzt werden kann.

4. der "DeepSeek-Moment" auf dem KI-Kurzfilm-Markt

Die Open Source von SkyReels V1 und SkyReels A1 ist nur der erste Schritt von KunlunWei's Open Source Plan für große Videomodelle. In der Zukunft wird Kunlun weiterhin verwandte Technologien als Open Source zur Verfügung stellen, einschließlich professioneller Spiegelsteuerungsversionen, Modellparametern mit 720P-Auflösung, Modellparametern für größere Trainingsdatensätze und Algorithmen zur Videogenerierung, die eine kontrollierte Ganzkörpergenerierung unterstützen.

Tatsächlich ist Open Source seit langem in der DNA von Kunlun World Wide verankert. Fang Han, Vorsitzender und CEO von Kunlun World Wide, verfügt als Gründungsvater von Chinese Linux, einer der vier Musketiere von Chinese Linux und einer der ersten Cybersecurity-Experten in China über 30 Jahre Erfahrung in der Internetbranche. Fang Han engagiert sich seit 1994 aktiv in der Open-Source-Bewegung und ist ein früher Befürworter des Konzepts von Open Source im Internet.

Fang Han hat öffentlich erklärt, dass das Open-Source-Big-Modell eine wichtige Ergänzung und Alternative zum kommerziellen Closed-Source-Big-Modell ist, in der Hoffnung, die Demokratisierung der Technologie zu fördern und die Schwelle der Industrie durch Open Source zu senken.

Bereits im Dezember 2022 veröffentlichte Kunlun WV eine ganze Reihe von Algorithmen und Modellen der "Kunlun Tiangong" AIGC und kündigte die vollständige Open Source an. Kunlun ist nicht nur eines der Unternehmen mit dem umfassendsten Layout im heimischen AIGC-Bereich, sondern auch das erste Unternehmen in China, das sich der AIGC-Open-Source-Community widmet.

In den vergangenen drei Jahren hat KunlunWanwei die Tiangong-Reihe großer Modelle veröffentlicht und als Open-Source angeboten. Im April 2024 veröffentlichte Kunlun World Wide Tiangong 3.0, ein MoE-Supermodell mit 400 Milliarden Parametern, dessen Leistung die von Grok 1.0 übertrifft, und stellte es gleichzeitig als Open Source zur Verfügung. Im Juni 2024 veröffentlichte KunlunWei erneut das 200-Milliarden-Sparse-MoE-Modell und wurde damit zum ersten quelloffenen 100-Milliarden-MoE-Modell, das Inferenzen auf einem einzigen RTX 4090-Server unterstützt. Im November 2024 stellte die KWL Skywork-o1-Open und andere Modellreihen als Open Source zur Verfügung.

Mit dem Glauben an Open-Source-Technologie setzt sich Kunlun dafür ein, dass die Industrie den Traum von AGI (General Artificial Intelligence) verwirklicht.

Seit dem Einstieg in die KI-Branche im Jahr 2020 hat Kunlun den Aufbau der gesamten Industriekette "Recheninfrastruktur - Big Model Algorithmus - KI-Anwendung" abgeschlossen und eine diversifizierte KI-Geschäftsmatrix aufgebaut.

KI-Kurzfilme sind ein wichtiges Segment in Kunluns diversifizierter KI-Anwendungsmatrix.

KI-Kurzfilme sind ein aufstrebender Markt, für den bis 2025 ein hohes Wachstum erwartet wird. Das "2024 Short Drama Overseas Marketing White Paper", das von TikTok for Business veröffentlicht wurde, sagt voraus, dass die durchschnittliche monatliche Nutzerzahl von Kurzfilmen in Überseemärkten in Zukunft 200-300 Millionen erreichen wird, und die Marktgröße wird voraussichtlich 10 Milliarden Dollar erreichen, das Marktpotenzial ist also enorm.

Im Dezember 2024 brachte KunlunWanwei die KI-Kurzfilm-Plattform Skyreels in den USA auf den Markt. Dies war ein wichtiger Schritt für KunlunWanwei auf dem globalen KI-Unterhaltungsmarkt und brachte dem nordamerikanischen Publikum ein neues intelligentes Kurzfilmerlebnis. Die KI-Kurzfilm-Plattform SkyReels bietet nicht nur leistungsstarke Tools für die Erstellung professioneller Inhalte, sondern senkt auch die Schwelle für die Erstellung von KI-Kurzfilmen erheblich, so dass auch nicht-professionelle Nutzer leicht einsteigen können.

Die weitreichenden Auswirkungen der KI auf die globale Film- und Fernsehindustrie

Wie wird die KI-Technologie die globale Film- und Fernsehindustrie revolutionieren?

In seiner Rede auf der Weltkonferenz für künstliche Intelligenz 2024 wies Fang Han, Vorsitzender von Kunlun World Wide, darauf hin, dass KI in Übersee eine enorme Entwicklungsdividende birgt, insbesondere in Ländern mit kleinen Sprachen.

Am Beispiel der Film- und Theaterindustrie stellte er fest, dass die Produktion eines Films in Nigeria etwa 20.000 Dollar kostet. Im Vergleich zu "Wandering Earth", dessen Produktion in China 300 Millionen RMB kostete, und "Avatar", dessen Produktion in den Vereinigten Staaten Hunderte von Millionen Dollar kostete, ist eine solche Produktion eindeutig nicht wettbewerbsfähig. Es wird jedoch erwartet, dass das Aufkommen der KI-Technologie diese Lücke schließen wird.

"Meine persönliche Vorhersage ist, dass in 3 bis 5 Jahren mit Hilfe der KI-Technologie die Kosten für die Produktion eines Blockbusters auf Wandering Earth-Niveau auf Zehntausende von Dollar sinken könnten. Dies wird vielen Regionen in Übersee enorme Entwicklungsmöglichkeiten bieten. Überall sind die Menschen begierig darauf, lokalisierte Kulturprodukte zu sehen, seien es Romane, Musik, Videos oder Comics, und brauchen Inhalte, die näher an ihrer lokalen Kultur sind. Daher birgt die KI in Übersee eine enorme Entwicklungsdividende". sagte Fang Han.

Auf einer kleineren Ebene liegt die Dividende der KI in der exponentiellen Senkung der Produktionskosten von Kulturprodukten, die den Schaffensmodus "eine Person, ein Drama" ermöglicht. Auf einer größeren Ebene ermöglicht die AIGC-Technologie unterprivilegierten kulturellen Gruppen durch die Senkung der Schwelle für die Schaffung von Inhalten, selbst Inhalte zu produzieren, was die globale kulturelle Affirmation fördern wird, was die beste Manifestation der Technologie für das Gute ist.

Die Branche betrachtet das Aufkommen der KI im Allgemeinen als den "iPhone-Moment", aber Fang Han glaubt, dass KI eher mit der Revolution der Handykamera vergleichbar ist, denn die Kamera löste einen Wandel in der Art des Filmens aus, der wiederum riesige Kurzvideo-Plattformen wie Jitterbug und Shutterbug hervorbrachte. In ähnlicher Weise wird KI auch eine große Anzahl neuer KI-UGC-Plattformen hervorbringen und ein goldenes Zeitalter der Produktion und des Konsums personalisierter Inhalte einleiten.

SkyReels V1, das erste Open-Source-Videogenerationsmodell für die Erstellung von KI-Kurzfilmen, und SkyReels A1, der erste SOTA-bewertete, auf einem Videobasismodell basierende Algorithmus zur Steuerung von Gesichtsausdrücken, sind genau die Werkzeuge, die die Universalität der AIGC-Ära beschleunigen. SkyReels V1, das erste Open-Source-Videogenerationsmodell für die Erstellung von KI-Kurzfilmen, und SkyReels A1, der erste SOTA-bewertete Algorithmus zur Steuerung von Gesichtsausdrücken auf der Grundlage eines Videobasismodells, sind die Werkzeuge, um die Ankunft von AIGC zu beschleunigen.

Es wird erwartet, dass der Markt für KI-Kurzfilme den "DeepSeek-Moment" einläutet, der ihm zusteht.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Verwandte Beiträge

Keine Kommentare...