Kokoro TTS API: Dockerisierter FastAPI-Wrapper für schnelle Text-to-Speech (Kokoro-82M-Modell)

Allgemeine Einführung

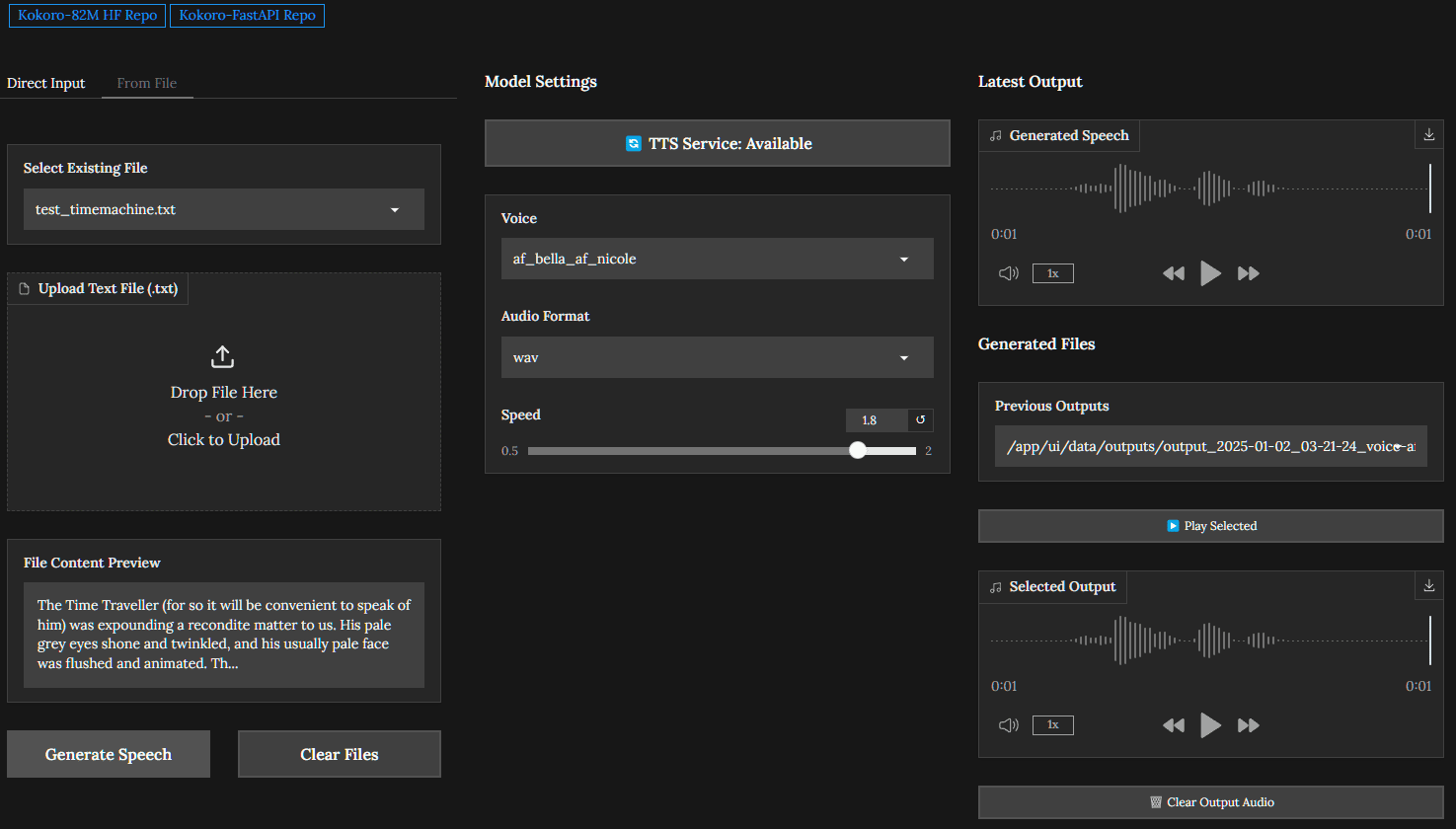

Kokoro-FastAPI ist ein Docker-basiertes FastAPI-Paket, das für die Unterstützung des Text-to-Speech-Modells Kokoro-82M entwickelt wurde. Das Projekt unterstützt NVIDIA GPU-Beschleunigung und bietet Warteschlangenverarbeitung und Auto-Splicing, um die Sprachausgabe von rohem, gewachsenem Text effizienter und kohärenter zu machen. Das Projekt wird von GitHub-Benutzer remsky entwickelt und ist öffentlich auf GitHub verfügbar. Benutzer können Text-to-Speech-Anfragen über die API-Schnittstelle stellen und erhalten eine qualitativ hochwertige Sprachausgabe für eine Vielzahl von Anwendungsszenarien, die Spracherzeugung erfordern.

Funktionsliste

- Bereitstellung eines API-Pakets für das Text-to-Speech-Modell Kokoro-82M

- Unterstützt NVIDIA GPU-Beschleunigung zur Verbesserung der Effizienz der Spracherzeugung

- Warteschlangenverarbeitungsfunktion zur Unterstützung gleichzeitiger Anfragen

- Automatische Spleißfunktion zur Erzeugung einer kohärenten Sprachausgabe von langen Texten

- Dockerisierte Bereitstellung für eine vereinfachte Installation und Konfiguration

- Bereitstellung von Beispielcode und Dokumentation für Entwickler, um den Einstieg zu erleichtern.

Hilfe verwenden

Einbauverfahren

- Stellen Sie sicher, dass Docker und die NVIDIA-Docker-Unterstützung installiert sind.

- Klonen Sie das Kokoro-FastAPI-Projekt-Repository:

git clone https://github.com/remsky/Kokoro-FastAPI.git

- Wechseln Sie in das Projektverzeichnis und erstellen Sie das Docker-Image:

cd Kokoro-FastAPI docker build -t kokoro-fastapi . - Starten Sie den Docker-Container:

docker run --gpus all -d -p 8000:8000 kokoro-fastapi

Verwendung der API-Schnittstelle

- Zugriff auf die API-Dokumentation:

Öffnen Sie Ihren Browser und besuchen Sie http://localhost:8000/docs, um die API-Dokumentation anzusehen und die Schnittstelle zu testen. - Sendet eine Text-to-Speech-Anfrage:

Verwenden Sie eine POST-Anfrage, um eine Nachricht an die/generateSchnittstelle sendet z.B. Textdaten:curl -X POST "http://localhost:8000/generate" -H "accept: application/json" -H "Content-Type: application/json" -d '{"text": "你好,世界!"}' - Sprachausgabe abrufen:

Bei erfolgreicher Anfrage wird die URL der erzeugten Sprachdatei zurückgegeben und der Benutzer kann die Datei herunterladen oder abspielen.

Beispielcode (Rechnen)

Das Projekt enthält Beispielcode, um Entwicklern den Einstieg zu erleichtern:

- Das Beispiel test_openai_tts.py zeigt, wie man eine Text-to-Speech-Anfrage über die API stellt.

Detaillierte Vorgehensweise

- Stellen Sie sicher, dass das System die Hardware- und Softwareanforderungen erfüllt, insbesondere NVIDIA GPU- und CUDA-Treiber.

- Folgen Sie den Installationsanweisungen, um den Kokoro-FastAPI-Dienst zu installieren und zu starten.

- Lesen Sie die API-Dokumentation und den Beispielcode, um eine Text-to-Speech-Anforderung zu senden.

- Abrufen von Sprachausgabedateien und anschließende Verarbeitung und Verwendung.

Mit den oben beschriebenen Schritten können Benutzer Kokoro-FastAPI einfach einsetzen und verwenden, um eine effiziente Text-to-Speech-Funktionalität zu erreichen und hochwertige Spracherzeugungsdienste für verschiedene Anwendungsszenarien bereitzustellen.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...