综合介绍

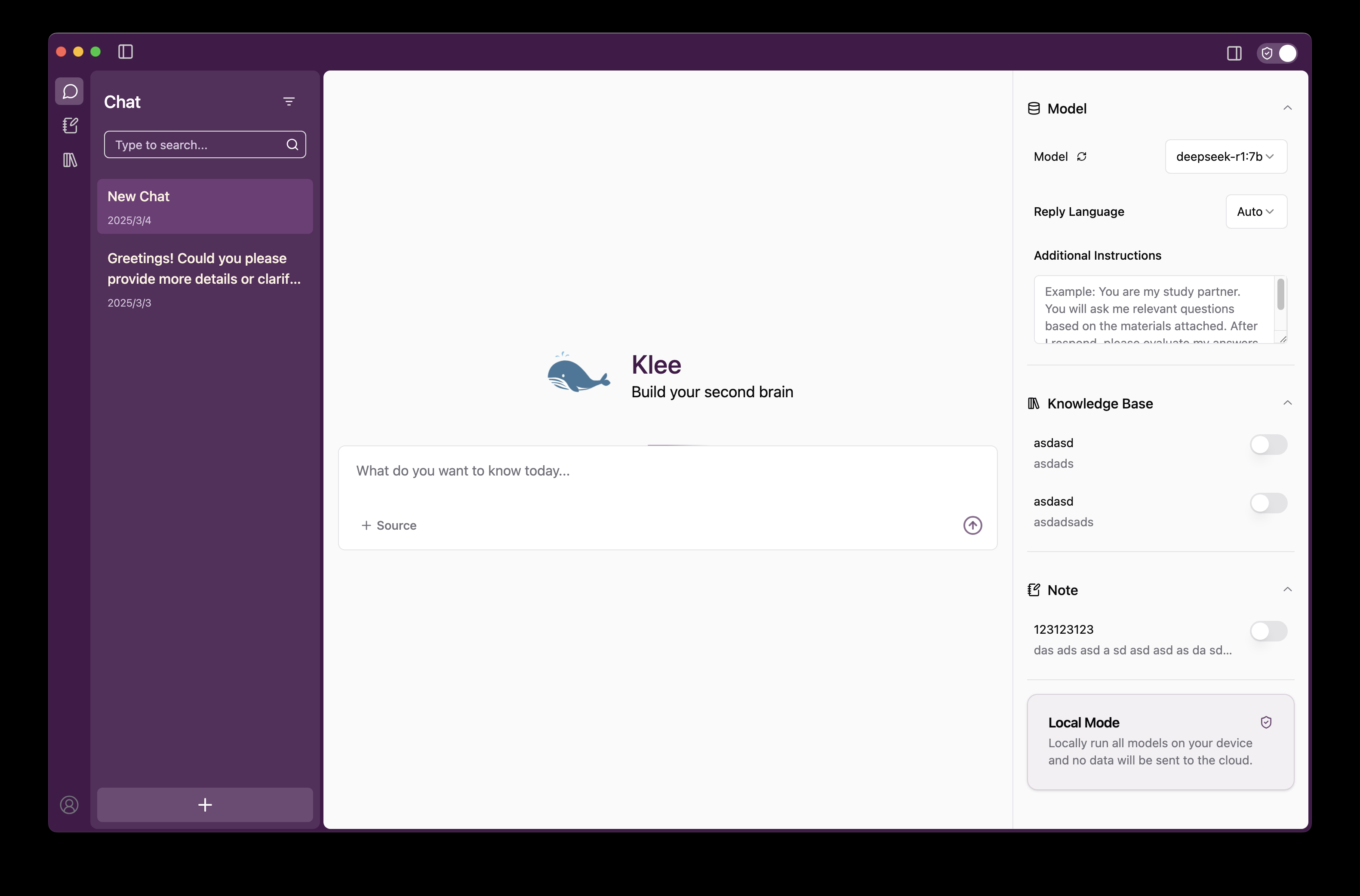

Klee 是一个开源桌面应用程序,旨在帮助用户在本地运行开源大语言模型(LLM),并提供安全的私人知识库管理和 Markdown 笔记功能。它基于 Ollama 和 LlamaIndex 技术构建,支持用户通过简单操作下载并运行 AI 模型,所有数据处理均在本地完成,无需联网或上传至云端,确保隐私安全。Klee 提供直观的用户界面,适用于 Windows、MacOS 和 Linux 系统,无论是技术开发者还是普通用户,都可以通过它轻松实现文本生成、文件分析和知识整理。目前,Klee 在 GitHub 上开源,受到社区欢迎,用户可自由下载、定制或参与开发。

功能列表

- 一键下载并运行大语言模型:通过界面直接从 Ollama 下载并运行开源 LLM,无需手动配置环境。

- 本地知识库管理:支持上传文件和文件夹,构建私人知识索引并供 AI 查询。

- Markdown 笔记生成:自动将 AI 对话或分析结果保存为 Markdown 格式,便于记录和编辑。

- 完全离线使用:无需网络连接,所有功能均在本地运行,且不收集用户数据。

- 跨平台支持:兼容 Windows、MacOS 和 Linux 系统,提供一致体验。

- 开源与可定制:提供完整源代码,支持用户修改功能或参与社区贡献。

使用帮助

安装流程

Klee 的安装分为客户端(klee-client)和服务端(klee-service)两部分,以下是详细步骤:

1. 系统要求

- 操作系统:Windows 7+、MacOS 15.0+ 或 Linux。

- 软件依赖:

- Node.js 20.x 或更高版本。

- Yarn 1.22.19 或更高版本。

- Python 3.x(服务端需要,推荐 3.12+)。

- Git(用于克隆仓库)。

- 硬件要求:至少 8GB 内存,建议 16GB 或更高以运行较大模型。

2. 安装客户端 (klee-client)

- 克隆客户端仓库:

在终端运行:

git clone https://github.com/signerlabs/klee-client.git

cd klee-client

- 安装依赖:

yarn install

- 配置环境变量:

- 复制示例文件:

cp .env.example .env - 编辑

.env文件,默认配置如下:VITE_USE_SUPABASE=false VITE_OLLAMA_BASE_URL=http://localhost:11434 VITE_REQUEST_PREFIX_URL=http://localhost:6190若服务端端口或地址不同,请调整

VITE_REQUEST_PREFIX_URL。

- 开发模式运行:

yarn dev

这将启动 Vite 开发服务器和 Electron 应用。

5. 打包应用(可选):

yarn build

打包后的文件位于 dist 目录。

6. MacOS 签名(可选):

- 编辑

.env添加 Apple ID 和团队信息:APPLEID=your_apple_id@example.com APPLEIDPASS=your_password APPLETEAMID=your_team_id - 运行

yarn build后即可生成签名应用。

3. 安装服务端 (klee-service)

- 克隆服务端仓库:

git clone https://github.com/signerlabs/klee-service.git

cd klee-service

- 创建虚拟环境:

- Windows:

python -m venv venv venv\Scripts\activate - MacOS/Linux:

python3 -m venv venv source venv/bin/activate

- 安装依赖:

pip install -r requirements.txt

- 启动服务:

python main.py

默认端口为 6190,若需更改端口:

python main.py --port 自定义端口号

服务启动后需保持运行。

4. 下载预编译版本(可选)

- 访问 GitHub Releases,下载适用于您系统的安装包。

- 解压后直接运行,无需手动构建。

主要功能操作流程

一键运行大语言模型

- 启动应用:

- 确保服务端运行,打开客户端程序。

- 下载模型:

- 在界面中选择 Ollama 支持的模型(如 LLaMA、Mistral)。

- 点击“Download”按钮,Klee 会自动下载模型至本地。

- 运行模型:

- 下载完成后,点击“Run”,模型加载至内存。

- 在对话框输入问题或指令,点击“Send”获取响应。

- 注意事项:

- 首次加载模型可能需要几分钟,取决于模型大小和硬件性能。

- 若无响应,检查服务端是否运行在

http://localhost:6190。

本地知识库管理

- 上传文件:

- 点击界面中的“Knowledge”选项。

- 支持拖放或手动选择文件/文件夹(支持 PDF、TXT 等格式)。

- 构建索引:

- 上传后,LlamaIndex 自动为文件生成索引。

- 索引完成后,文件内容可被 AI 检索。

- 查询知识库:

- 在对话界面勾选“Use Knowledge Base”,输入问题。

- AI 将结合知识库内容生成回答。

- 管理知识库:

- 在“Knowledge”页面可删除或更新文件。

Markdown 笔记生成

- 保存笔记:

- AI 响应后,点击“Save as Note”按钮。

- 系统自动将内容转为 Markdown 格式保存。

- 管理笔记:

- 在“Notes”页面查看所有笔记。

- 支持编辑、导出(保存为 .md 文件)或删除。

- 使用场景:

- 适合记录 AI 分析结果、学习笔记或工作总结。

特色功能操作详解

完全离线使用

- 操作方法:

- 安装完成后,所有功能无需网络即可运行。

- 下载模型后断网仍可正常使用。

- 数据安全:

- Klee 不收集任何用户数据,所有文件和对话仅存储在本地。

- 日志仅用于调试,不上传至外部服务器。

开源与社区贡献

- 获取源代码:

- 访问 GitHub 仓库,下载代码。

- 贡献方式:

- 提交 Pull Request 添加功能或修复 Bug。

- 参与 GitHub Issues 讨论,优化文档或推广应用。

- 定制方法:

- 修改服务端支持其他模型或 API。

- 调整客户端界面,需熟悉 React 和 Electron。

使用建议

- 性能优化:运行大模型(如 13B 参数)时,建议使用 16GB+ 内存或 GPU 加速。

- 模型选择:初次使用可选择较小模型(如 7B 参数)测试。

- 问题反馈:在 GitHub 或 Discord 寻求帮助。

通过以上步骤,用户可快速安装并使用 Klee,享受本地化 AI 的便利。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...