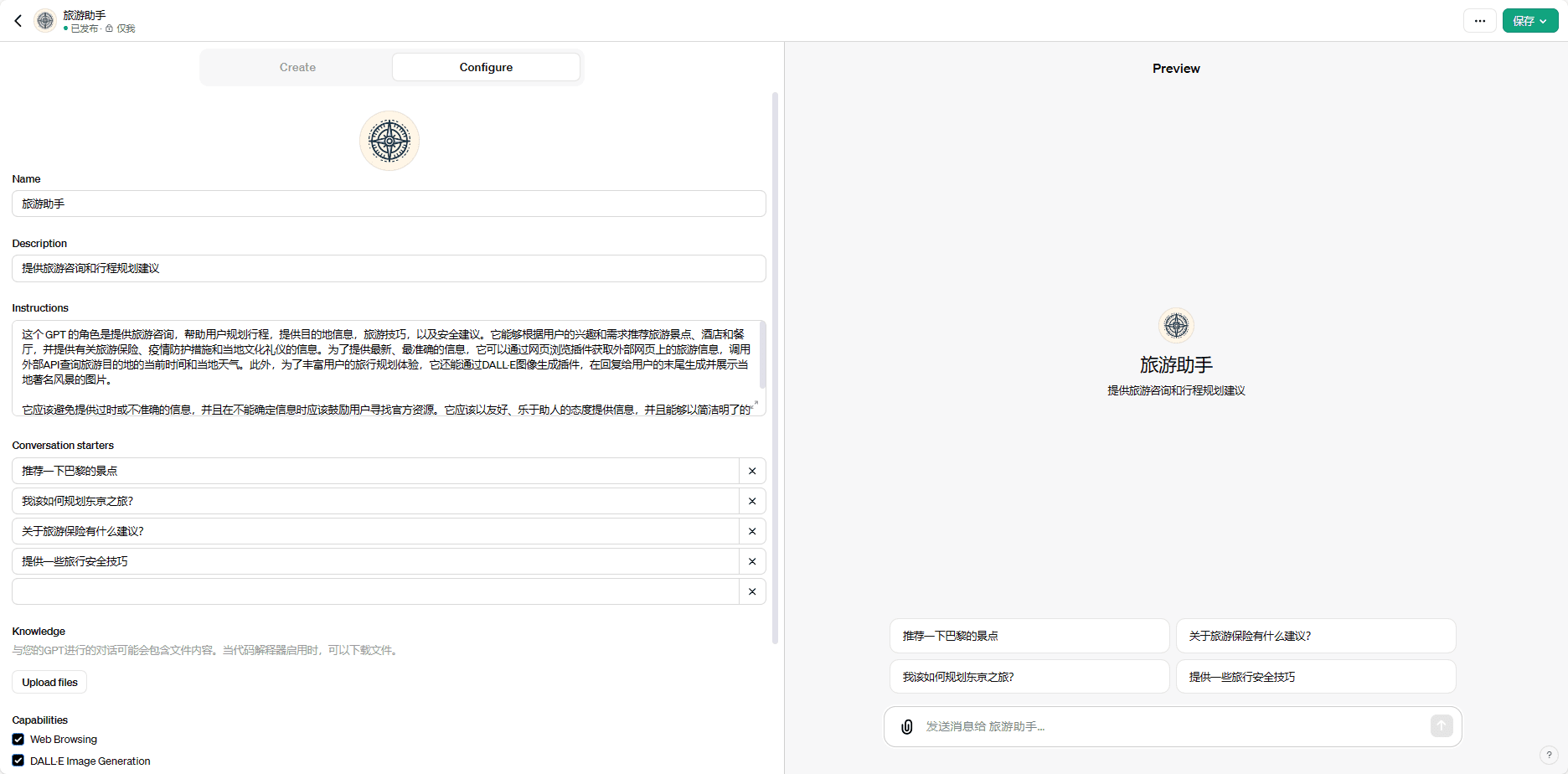

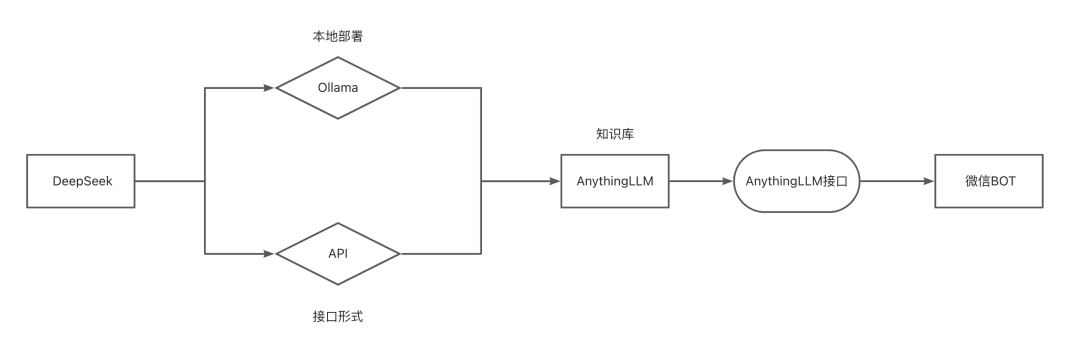

Implementierung einer lokalen/API-Wissensbasis auf der Grundlage von DeepSeek-R1 und Zugriff auf das WeChat BOT

Im vorangegangenen Artikel, "DieLokale Bereitstellung DeepSeek-R1 und WeChat Bot Access TutorialsIn "DeepSeek-R1" haben wir DeepSeek-R1 lokal eingesetzt und auf einen WeChat-Bot zugegriffen, der mit uns gechattet hat. Heute möchte ich mit Ihnen eine interessantere Art und Weise teilen, damit zu spielen: wie wir unseren KI-Assistenten mit trockenen Dingen füttern, damit er sich in einen professionellen Berater verwandeln kann, der wirklich weiß, was er tut!

Als Nächstes führe ich Sie durch den gesamten Prozess der Erstellung der Wissensdatenbank, einschließlich der Konfiguration der Umgebung, der Einrichtung der Wissensdatenbank, des Hochladens von Informationen sowie einiger Details zu den Tuning-Tipps. Zum Schluss werden wir diese "wissensreiche" KI in den WeChat-Roboter einsetzen, um einen intelligenten Assistenten zu schaffen, der Sie wirklich versteht!

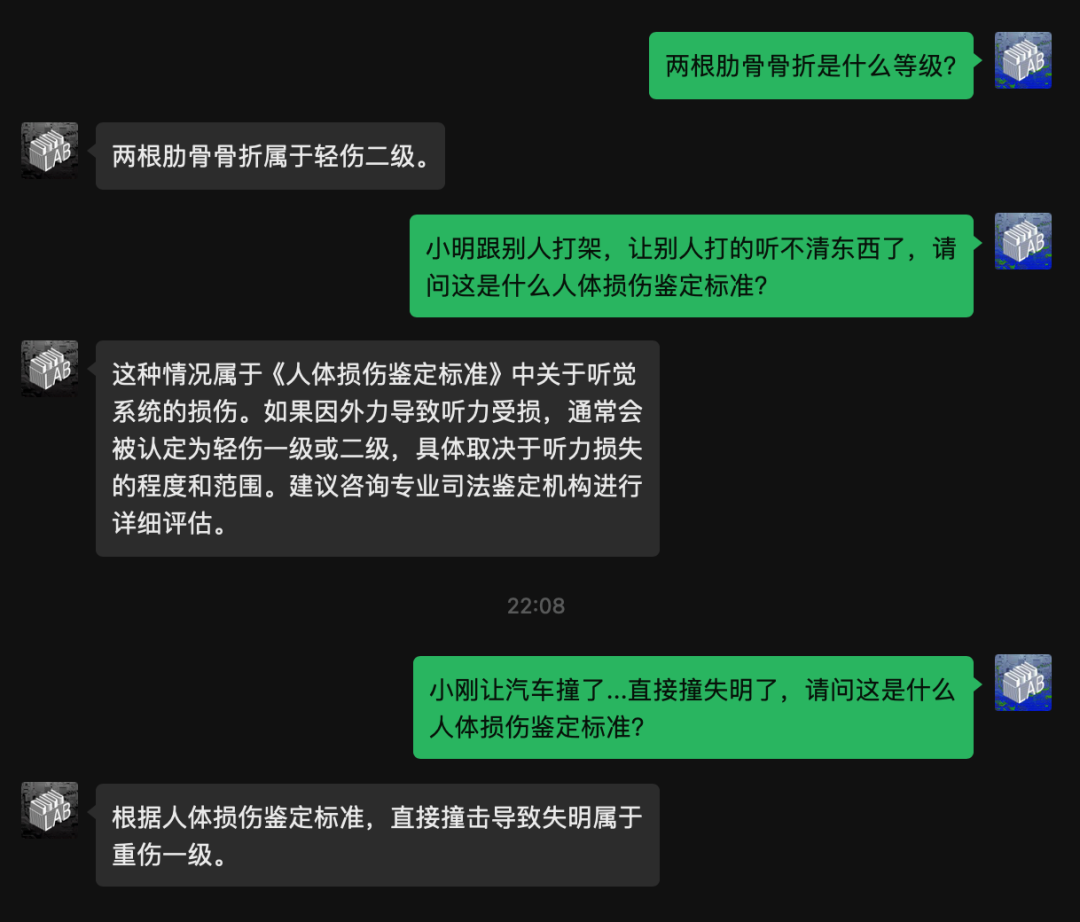

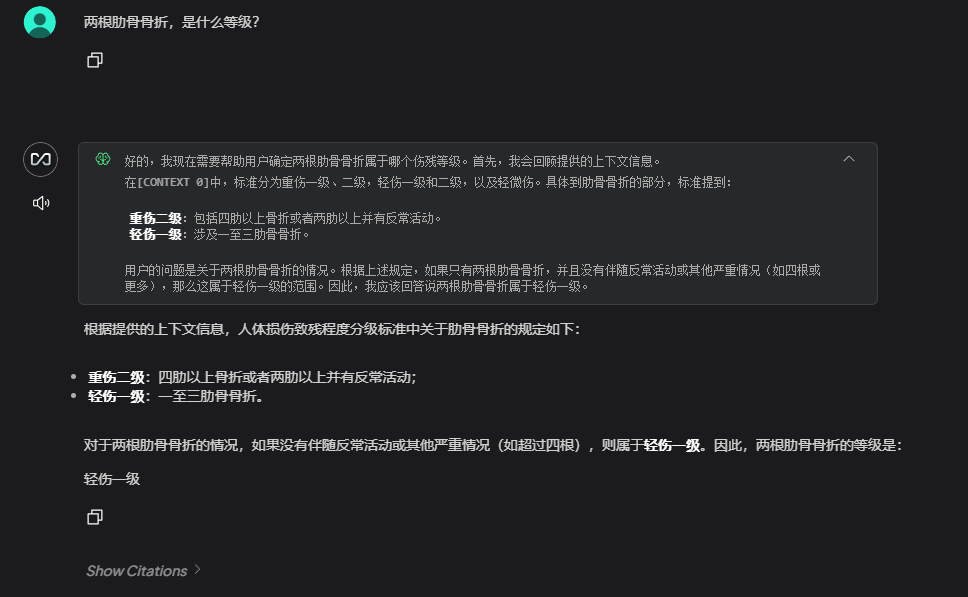

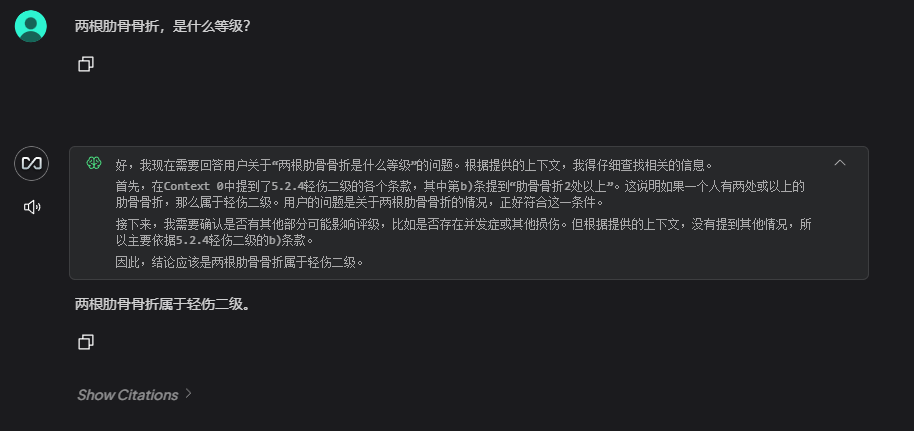

Schauen wir uns zunächst das Ergebnis an. Dies ist das Ergebnis, nachdem ich eine Informationsabfrage zur Klassifizierung des Grades der Behinderung bei Verletzungen des menschlichen Körpers hochgeladen habe:

DeepSeek-R1 Einsatz

DeepSeek Es gibt zwei Möglichkeiten der Bereitstellung, zum einen die lokale Bereitstellung und zum anderen den Zugriff auf APIs von Drittanbietern.

Vor- und Nachteile von beidem:

- lokaler Einsatz

✅ Vorteile: vollständig private Daten, geringe langfristige Kosten, Reaktionsfähigkeit

❌ Nachteile: frisst lokale Arithmetik, erfordert besser konfigurierte Rechner - API-Aufruf

✅ Vorteile: schneller Zugriff, wartungsfrei, belastbare Skalierbarkeit

❌ Nachteile: Daten müssen an Dritte weitergegeben werden, langfristige Kosten sind nicht kontrollierbar

Lokale DeepSeek

Zunächst müssen Sie sicherstellen, dass Sie Folgendes installiert haben ollama und ollama funktioniert ordnungsgemäß.

DeepSeekAPI

Eigentlich wollte ich diesen Beitrag nur über den Ansatz der lokalen Bereitstellung schreiben .....

Da jedoch die Webversion von DeepSeek in letzter Zeit "gestreikt" hat, war ich gezwungen, die lokale Version auszuprobieren. ChatBox Ich hatte nicht erwartet, dass ich eine vollwertige Version von R1 erleben würde, und es war ein Riesenspaß! Ich denke, dass diese Lösung auch gut riecht, also werde ich nebenbei in die API schreiben.

Hier stelle ich Ihnen zwei Plattformen zur Verfügung, auf die Sie nach Belieben zugreifen können.

Zunächst müssen wir den API-Schlüssel abrufen und dann die Konfiguration der Wissensdatenbank mit dem API-Schlüssel auffüllen.

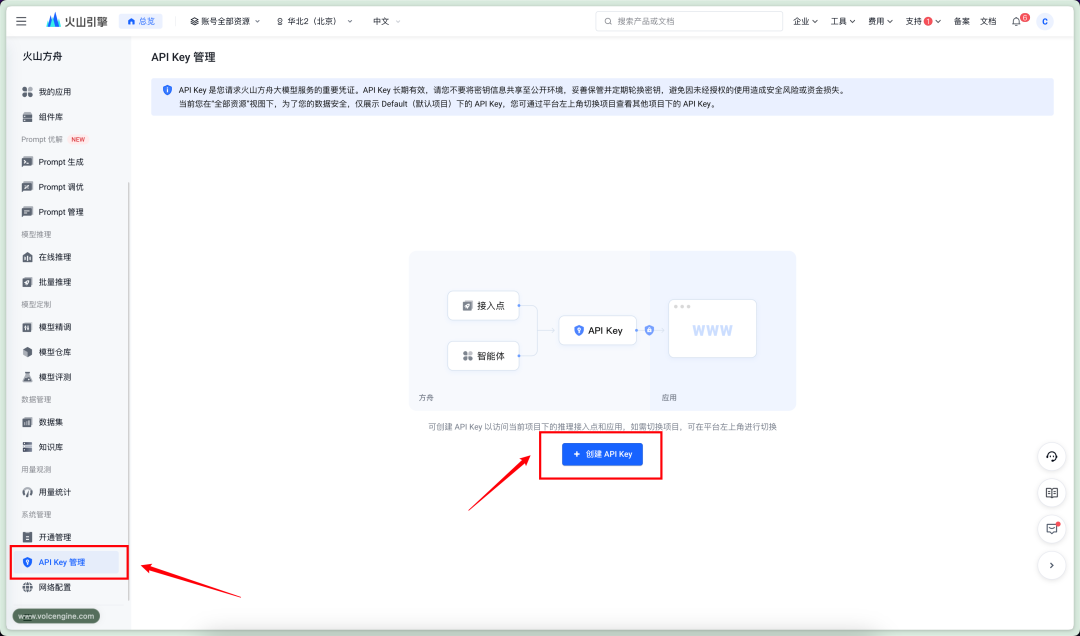

vulkanische Arche

offizielle Website

https://console.volcengine.com/ark

Preise

Eingabe: ¥2/M Wertmarken

Ausgabe: ¥8/M Wertmarken

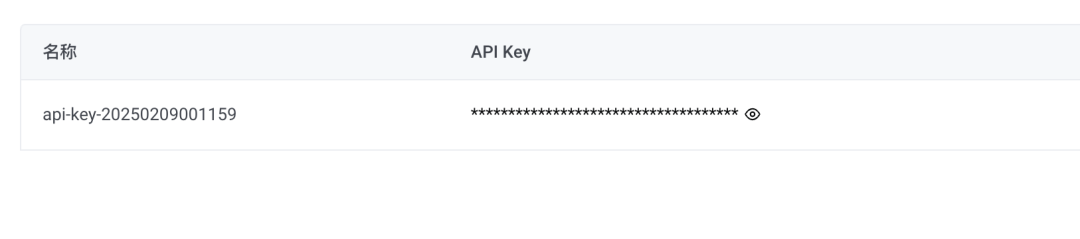

EintragAPIKey管理erstellen.APIkey

Neuer geheimer Schlüssel, API-Key kopieren

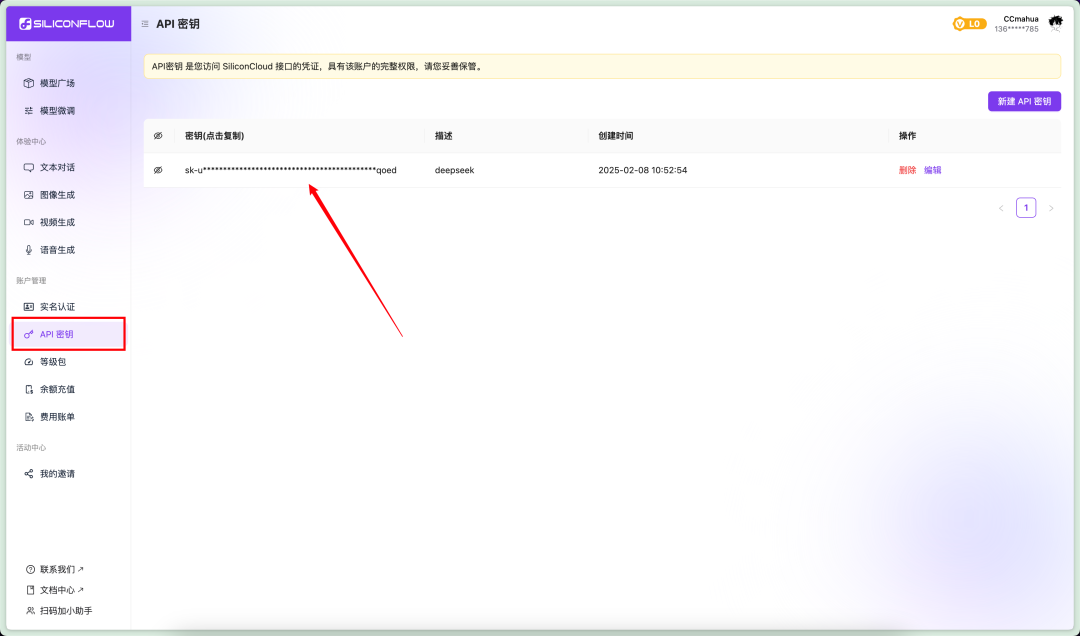

Durchfluss auf Siliziumbasis

Durchfluss auf Siliziumbasis offizielle Website

https://cloud.siliconflow.cn/account/ak

Preise

Eingabe: ¥4/M Wertmarken

Ausgabe: ¥16/M Wertmarken

Gehen Sie auf die linke Seite desAPI秘钥Klicken Sie auf新建秘钥Nachkopieren des geheimen Schlüssels

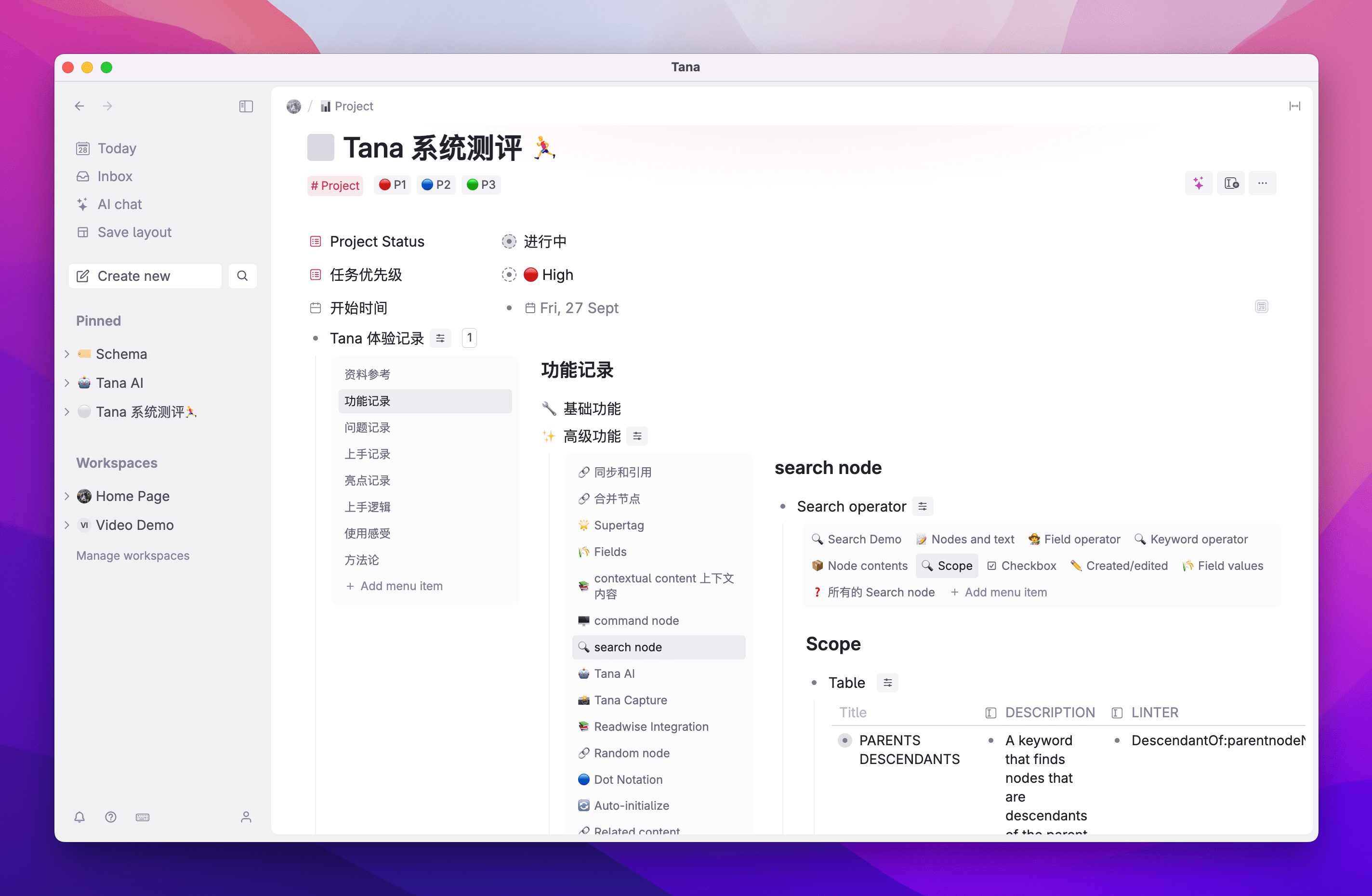

Repository

Installation der Wissensdatenbank

Als nächstes müssen wir auf die Wissensdatenbank zugreifen, hier verwenden wirAnythingLLMDas Projekt.

AnythingLLM ist ein quelloffenes Large Language Model (LLM)-Anwendungsframework, das Benutzern helfen soll, auf einfache Weise intelligente Fragen und Antworten, Dokumentenanalysen und andere Anwendungen auf der Grundlage privater Daten zu erstellen und einzusetzen.

Rufen Sie die AnythingLLM-Website auf und laden Sie das Installationsprogramm herunter.

https://anythingllm.com/

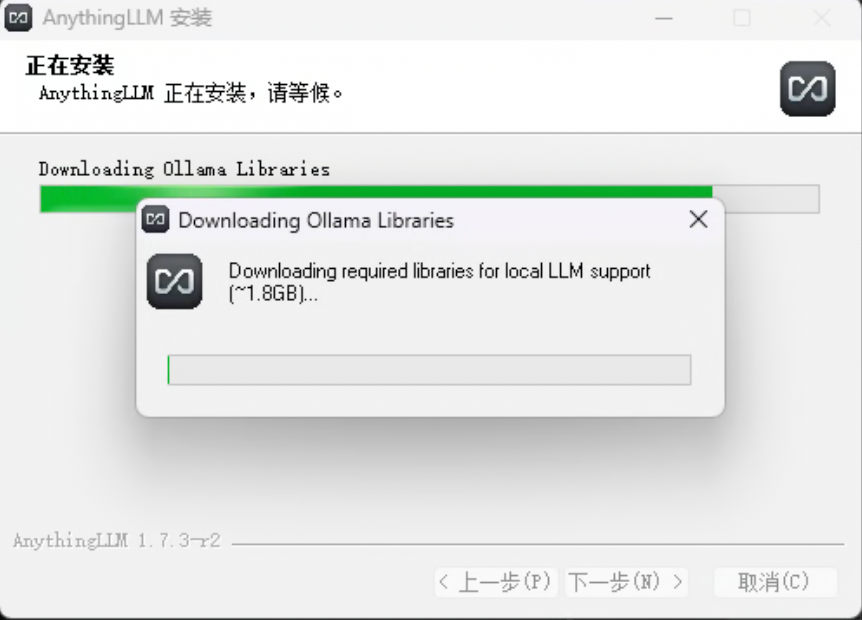

Führen Sie das Installationsprogramm aus, zwischendurch werden die zusätzlich benötigten Abhängigkeiten heruntergeladen (GPU, NPG-Unterstützung)

Wenn der Download fehlschlägt oder wenn Sie das Download-Fenster schließen und diesen Schritt überspringen, wird AnythingLLM trotzdem erfolgreich installiert.

Machen Sie sich jetzt keine Sorgen, Sie können die Installation auch manuell durchführen.

Der Weblink hat einelibReißverschluss.

Entpacken Sie das Zip-Archiv und legen Sie den extrahierten Ordner in den Ordner你的安装目录AnythingLLMresourcesollamaIm Inneren des Katalogs.

Konfiguration der Wissensdatenbank

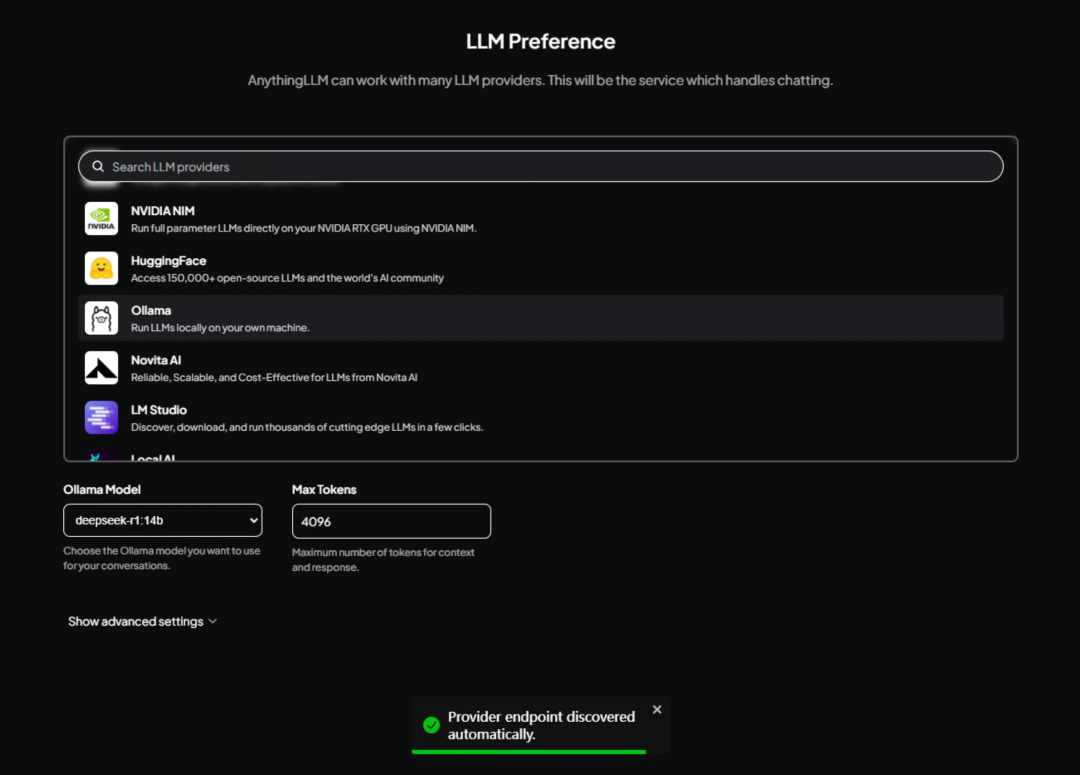

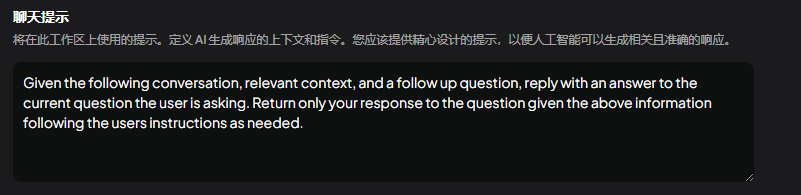

Nach Abschluss der Installation rufen Sie die AnythingLLM-Schnittstelle auf, wo Sie ein großes Standardmodell auswählen müssen.

lokale Konfiguration

Wenn Sie eine lokale Bereitstellung von DeepSeek verwenden, scrollen Sie nach unten, um dieOllamaWählen Sie einfach.

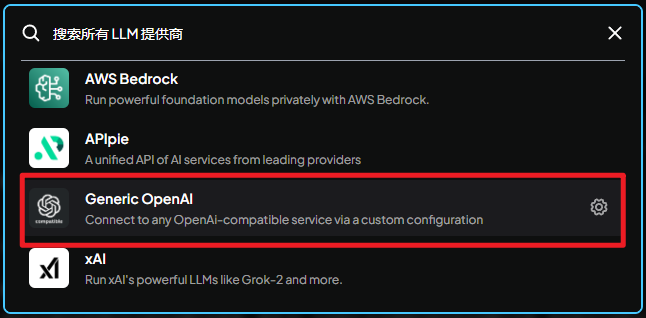

API-Konfiguration

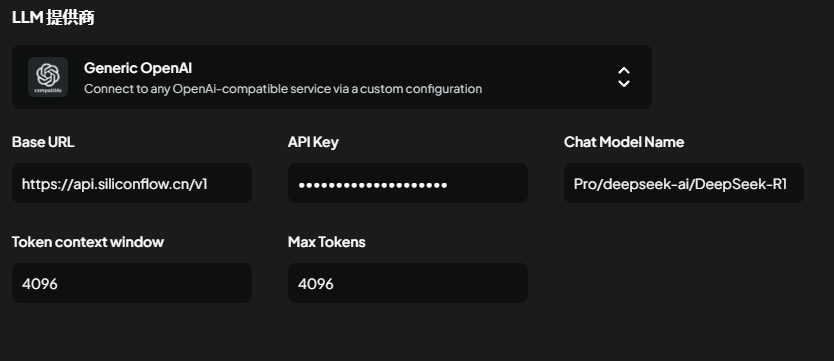

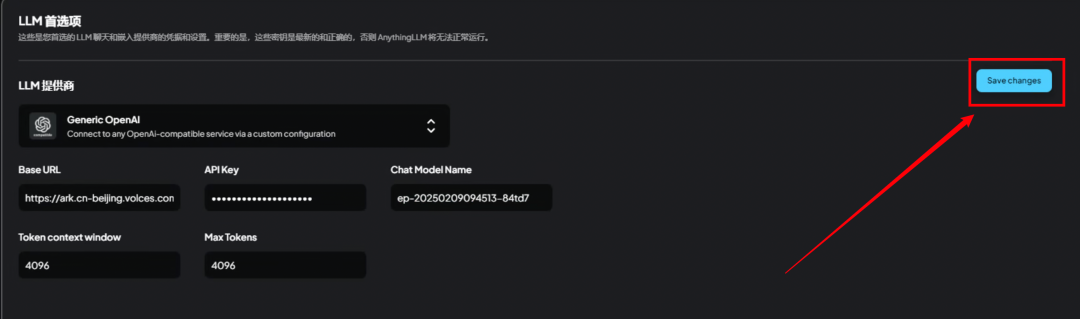

Wenn Sie eine Drittanbieter-API verwenden, muss dieser Schritt nicht ausgewählt werdenollamaSie finden es hier unten.Generic OpenAI

Generische OpenAI:

Verbinden Sie sich über eine benutzerdefinierte Konfiguration mit jedem Dienst, der mit dem OpenAI-Schnittstellenformat kompatibel ist.

Es gibt 5 Parameter, die ausgefüllt werden müssen

Verwenden Sie die silikonbasierte Flow-API:

BaseURLAnfrageadresse

https://api.siliconflow.cn/v1

APIkeyAPI-Geheimschlüssel, geben Sie den Schlüssel ein, den Sie gerade erhalten haben.

ChatModelNameName des Modells

Pro/deepseek-ai/DeepSeek-R1

Token context window(Kontextfenster)

4096

Max Tokens(Maximale Anzahl von Token)

4096 oder 8192, je nach Ihrer Situation.

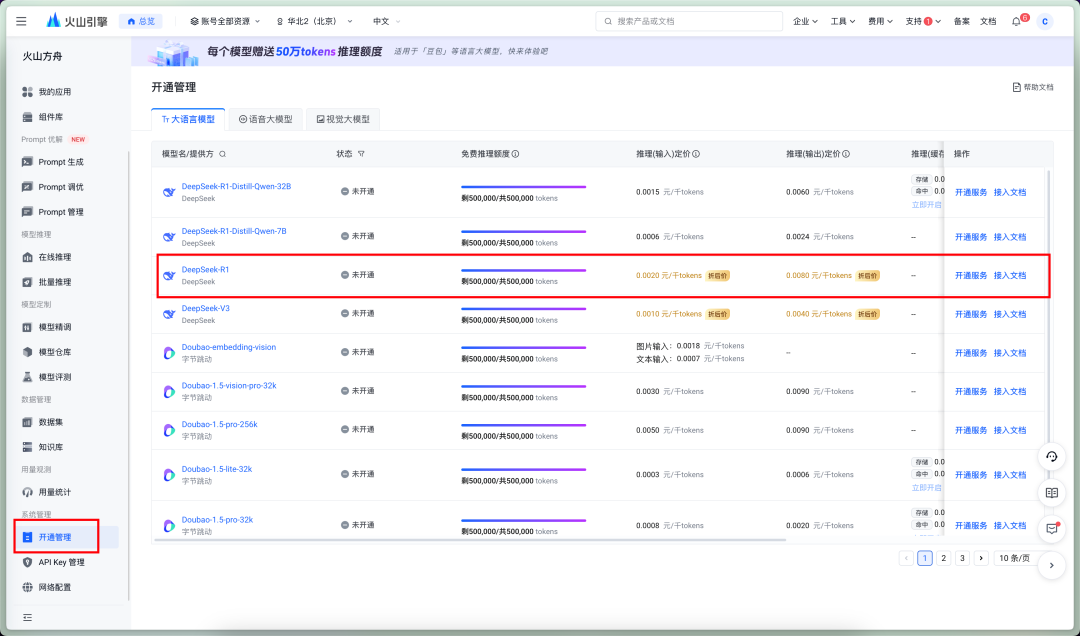

Verwenden Sie die Volcano Ark API:

BaseURLAnfrageadresse

https://ark.cn-beijing.volces.com/api/v3

APIkeyAPI-Geheimschlüssel, geben Sie den Schlüssel ein, den Sie gerade erhalten haben.

ChatModelNameName des Modells

Hier ist speziell, Vulkan Arche Modellname muss mit Access Point ID gefüllt werden.

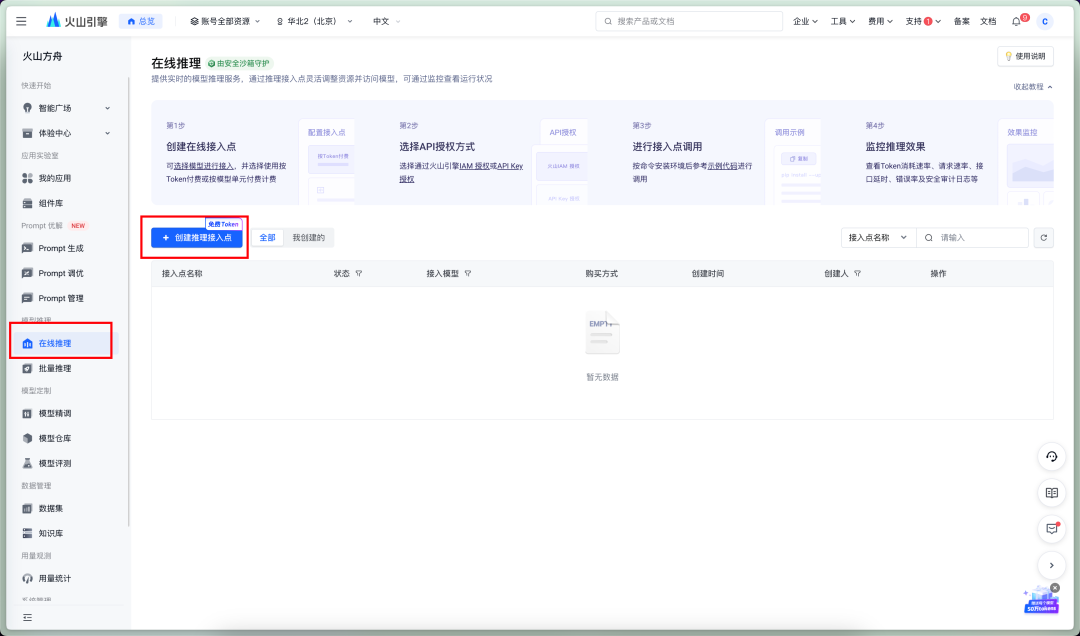

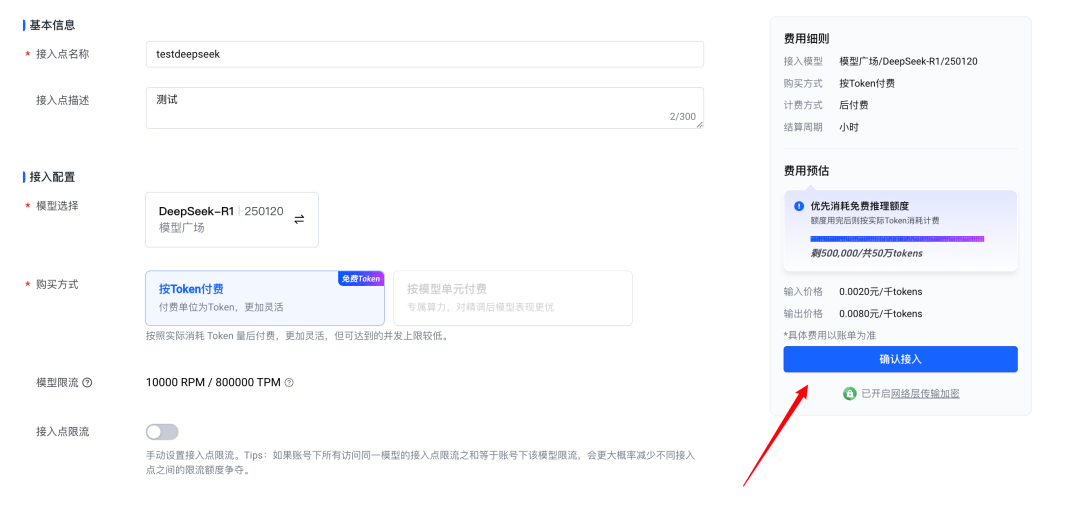

Schalten Sie zunächst DeepSeekR1 ein!

Kommen Sie zu Online Reasoning - Zugangspunkte schaffen

Bestätigen Sie den Zugang

Diese ID ist die ID des Zugangspunkts, geben Sie einfach diesen Wert ein.

Token context window(Kontextfenster)

4096

Max Tokens(Maximale Anzahl von Token)

4096 oder 8192, je nach Ihrer Situation.

Wenn Sie die oben genannten Einstellungen vorgenommen haben, tippen Sie bitte aufSaveChanageSparen.

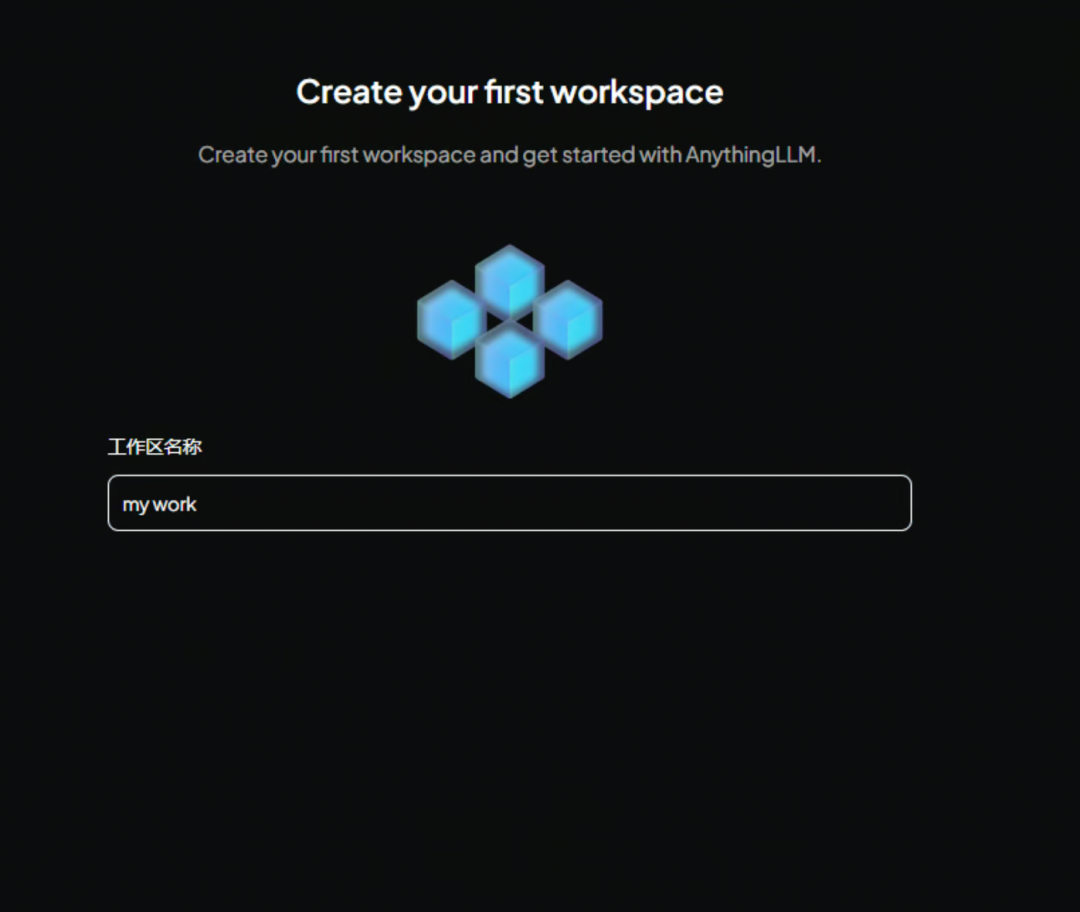

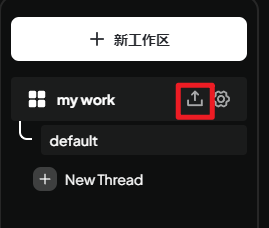

Erstellung von Arbeitsbereichen

Der nächste Schritt in diesem Datenschutz-Schnittstelle, ist es, Ihnen zu sagen, wie man Daten zu speichern, wie diese Anweisungen zu verwenden, sowieso, sind alle Sätze von Wörtern, direkt überspringen Sie den nächsten Schritt sein kann

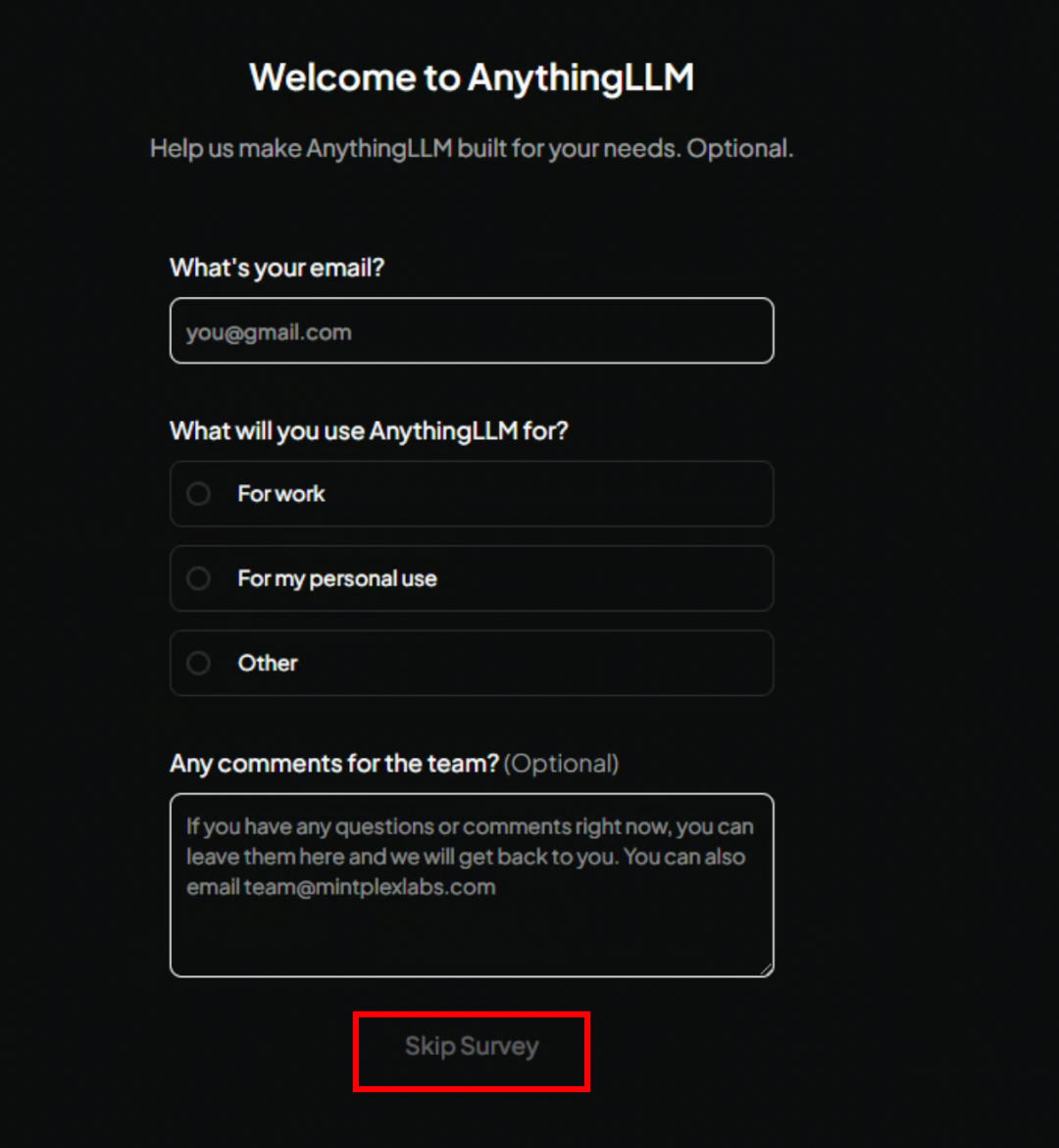

Dieser Schritt ist der Willkommensbildschirm, nichts Besonderes, überspringen Sie ihn einfach!

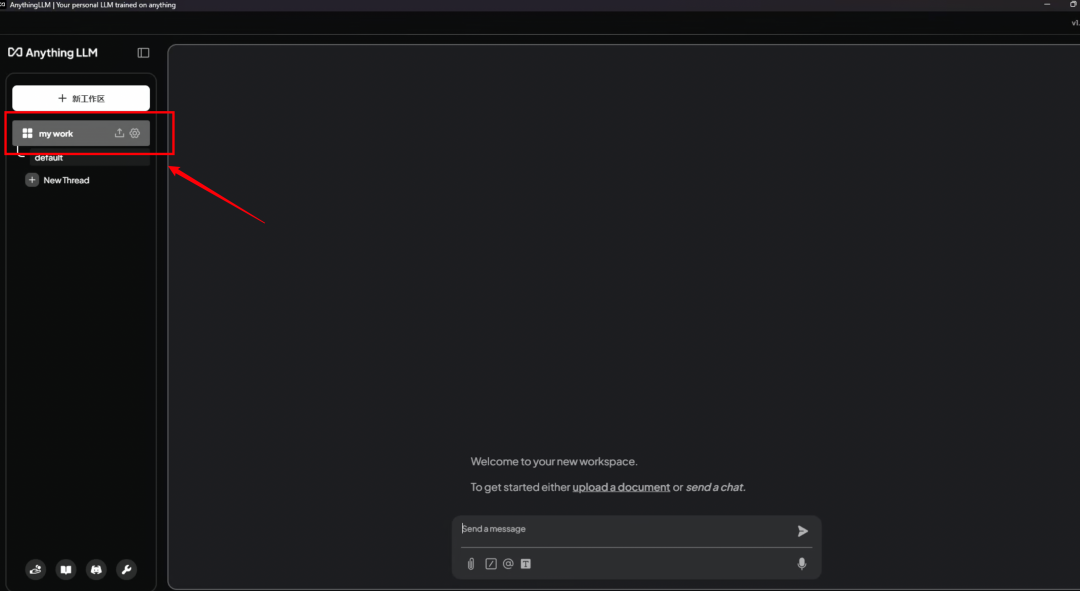

Es wird empfohlen, einen englischen Namen für den Arbeitsbereich zu verwenden, da er sich als nützlich erweisen wird, wenn Sie ihn später über die API aufrufen möchten.

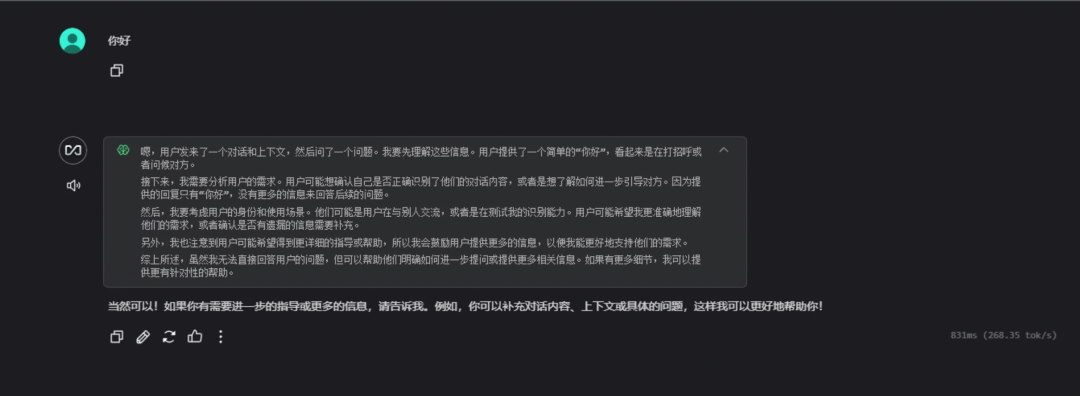

Jetzt eingeben AnythingLLM Die Hauptschnittstelle des Spiels ist nun verfügbar. Sie zeigt Ihnen anhand eines Beispieldialogs, wie Sie spielen können

Klicken Sie auf den soeben benannten Arbeitsbereich auf der linken Seite, um ein neues Dialogfenster zu öffnen.

Hier ist ein einfacher Dialog, um zu testen, ob der Modellaufruf erfolgreich war.

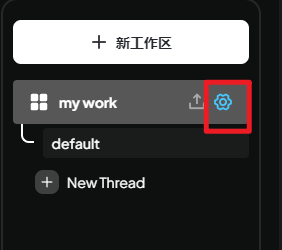

Arbeitsbereich einrichten

Klicken Sie auf die Schaltfläche Setup auf der rechten Seite des Arbeitsbereichs, um die Setup-Oberfläche aufzurufen.

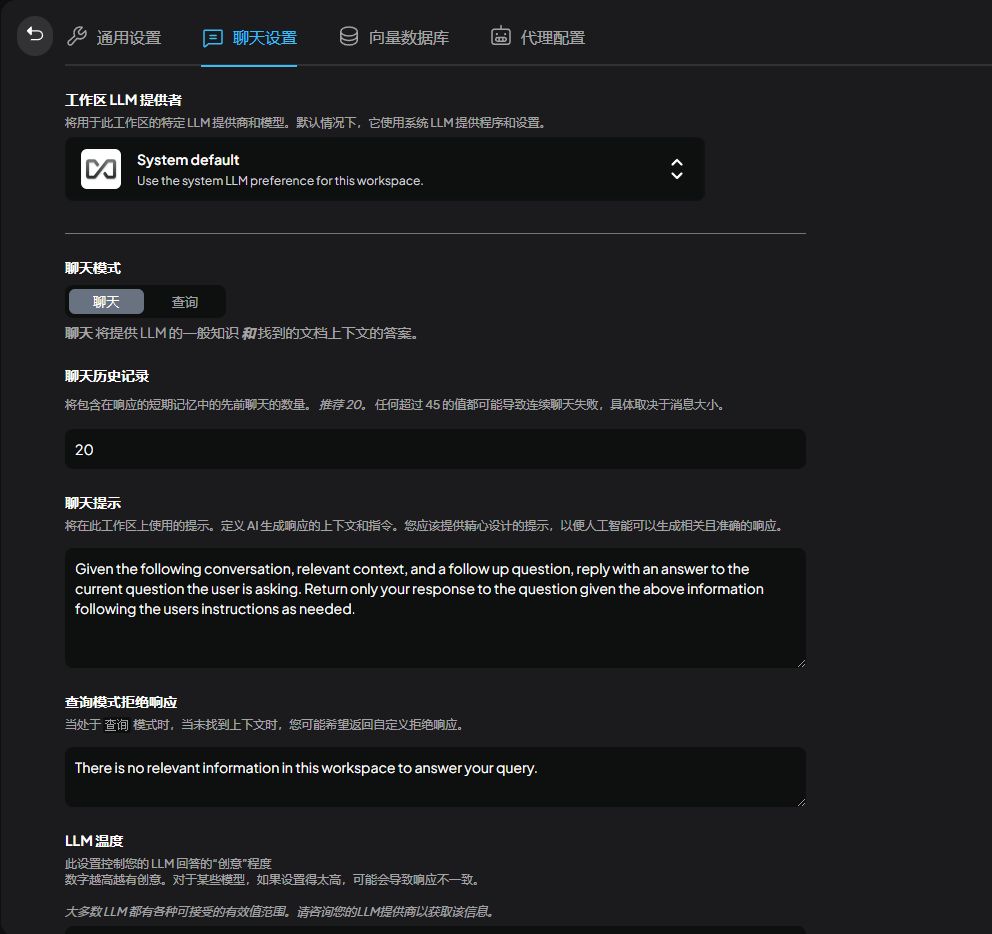

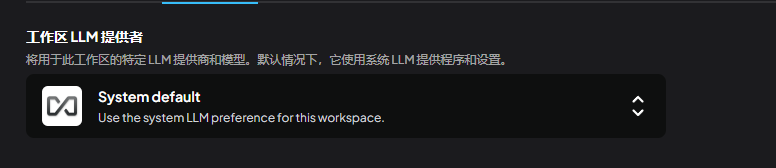

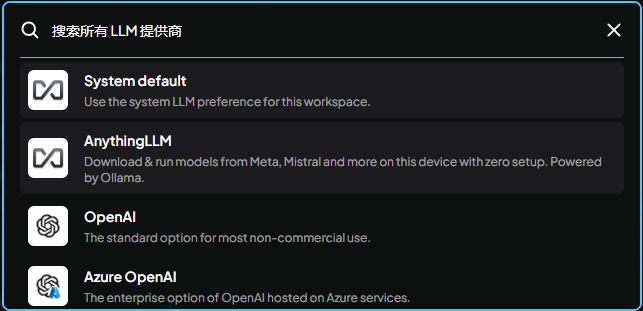

Gehe zu den Chat-Einstellungen, wo wir das Modell im Detail anpassen können

Hier können Sie das derzeit verwendete große Modell einstellen. Standardmäßig wird das vom System eingestellte Modell verwendet, das zuvor eingestellt wurdeollama

Andere große lokale Modelle oder API-Dienste sind ebenfalls verfügbar.

Der Modus ist in Chat und Abfrage unterteilt, Abfrage bedeutet, dass Sie nur die Abfragekontextfunktion verwenden (Sie müssen Ihre eigenen hochgeladenen Dokumente haben), Chat bedeutet, dass Sie die Chatfunktion + Abfrage verwenden

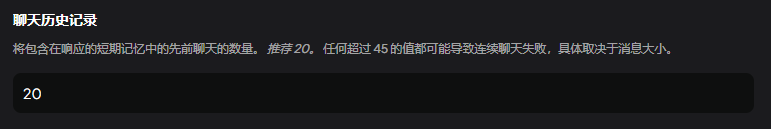

Anzahl der Kontexte

Sie können es als ein Persona-Stichwort interpretieren, das in Chinesisch geändert oder als Standard belassen werden kann.

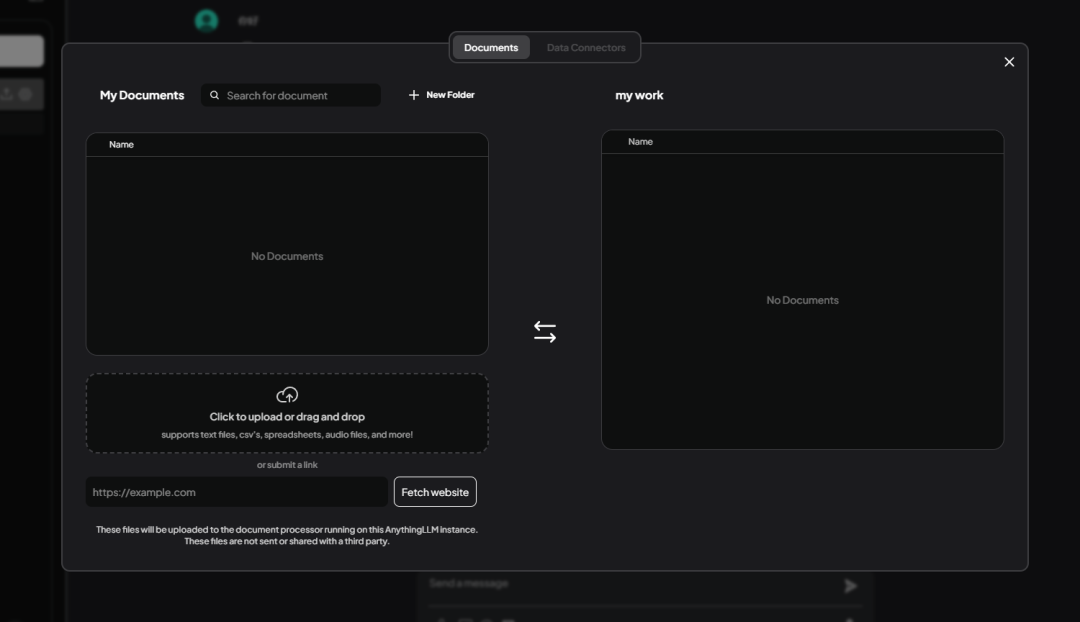

Informationen zur Fütterung

Als nächstes müssen Sie die Wissensdatenbank füttern, klicken Sie auf den Arbeitsbereich neben上传按钮

Zugang zur Schnittstelle Knowledge Base Management

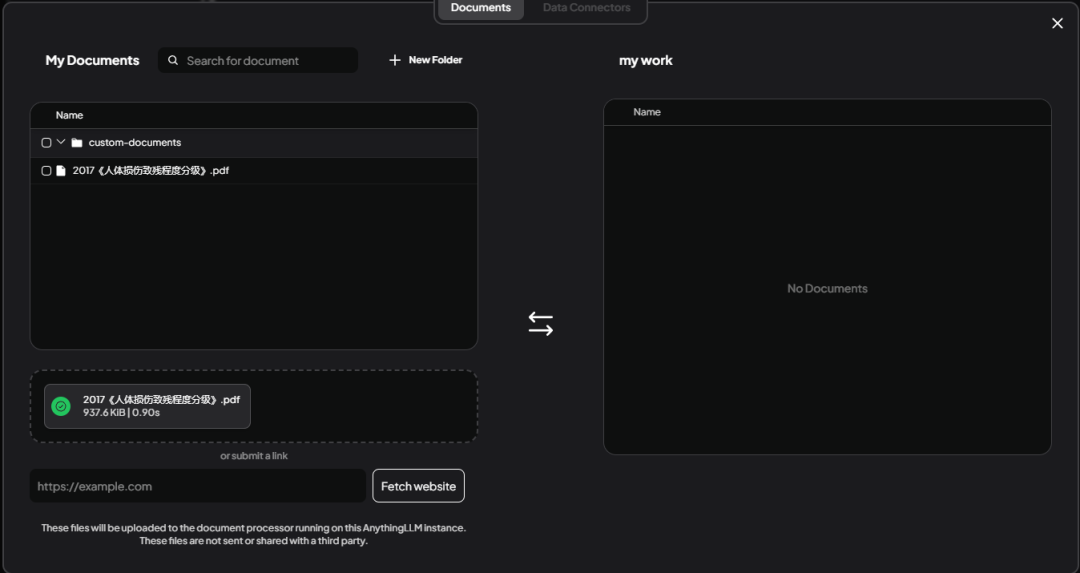

Unterstützt Batch-Uploads, unterstützt Excel, World, txt und andere Dateiformate. Hier habe ich eine Datei hochgeladen《人体损伤致残程度分级》.pdf.

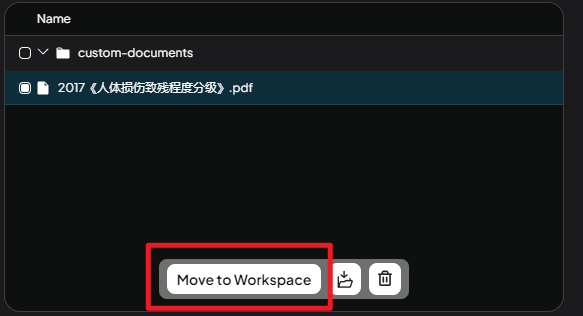

Wählen Sie die Datei aus und klicken Sie aufMove to WorkSpaceMit diesem Schritt werden Dateien aus dem temporären Bereich dem Arbeitsbereich hinzugefügt.

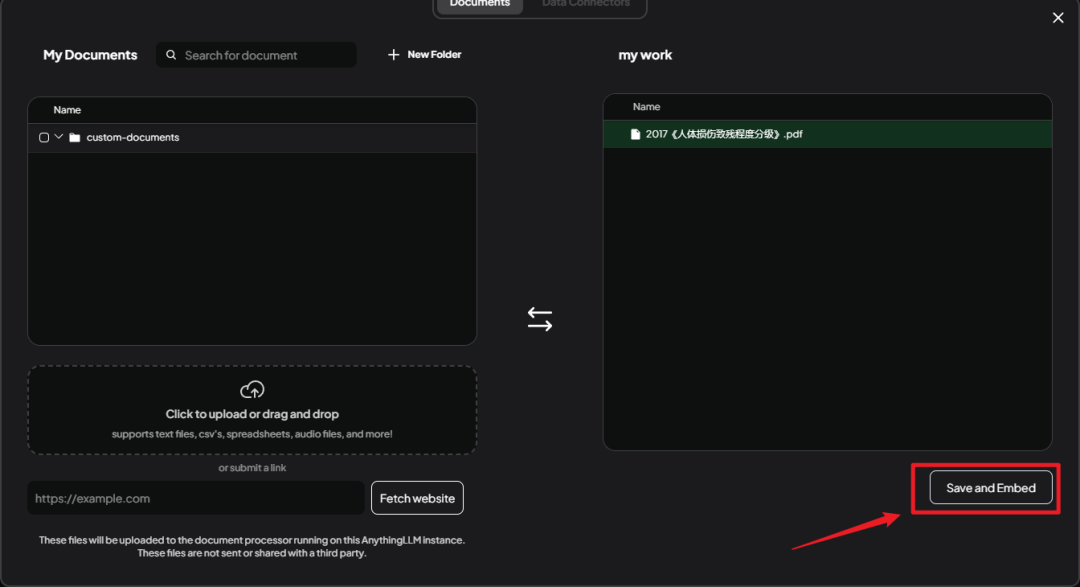

Sie sehen die hochgeladenen Dateien rechts übertragen, hier klicken Sie auf dasSace and EmbedRetten Sie.

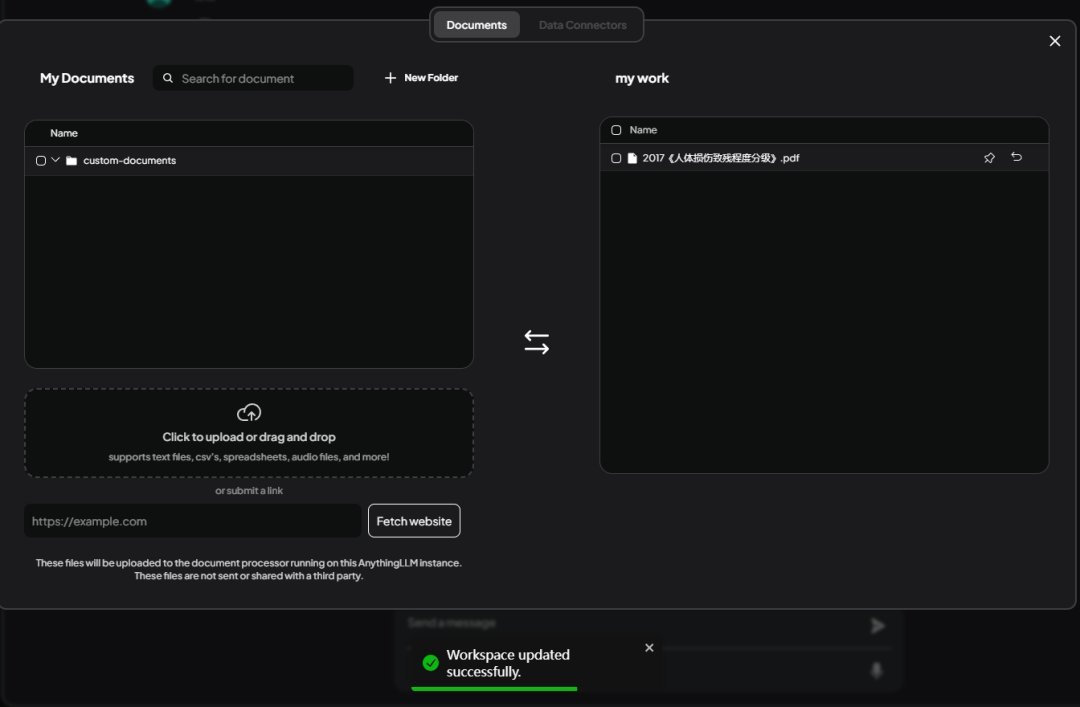

Tipps untenWorkSpace updated successfullyZeigt eine erfolgreiche Speicherung an.

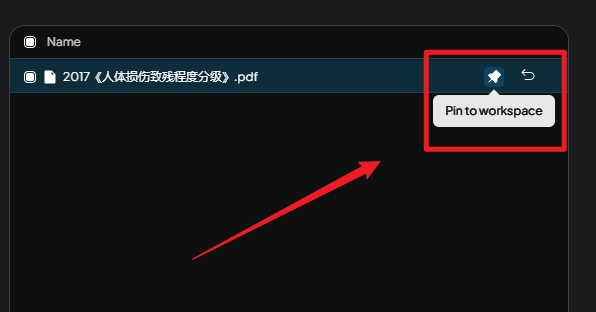

Hier müssen Sie aufPin to workspaceDiese Schaltfläche.

Pin an Arbeitsbereich::

Wenn Sie bei der Verwendung von AnythingLLM feststellen, dass Sie standardmäßig keine zufriedenstellenden Antworten erhalten, können Sie die Qualität Ihrer Antworten verbessern, indem Sie Dokumente anheften. Dies ist ein schneller Weg, um die Genauigkeit und Relevanz Ihrer Antworten zu verbessern.

Vereinfacht ausgedrückt ist das Pinning von Dokumenten der Prozess, bei dem der Inhalt eines Dokuments direkt in das Sprachmodell eingespeist wird, so dass es sich bei der Beantwortung einer Frage auf diesen Inhalt beziehen und eine bessere Antwort geben kann.

Dann kehren wir zur Seite "Gespräche" zurück, erstellen ein neues Gespräch, stellen eine Frage und überprüfen, ob die Wissensdatenbank erfolgreich hinzugefügt wurde.

Fehlerbehebung

Sie können sehen, dass DeepSeek die Frage in Verbindung mit den hochgeladenen Informationen beantwortet hat, aber die Antwort enthält Fehler.

Zum Beispiel die erste Frage:

Fragen Sie:

Wie lautet die Note für zwei gebrochene Rippen?

Antwort:

Auf der Grundlage der bereitgestellten Kontextinformationen lauten die Standards für die Klassifizierung von Rippenfrakturen bei Verletzungen des Menschen wie folgt:

Schwere Verletzung Grad 2: Fraktur von mehr als vier Rippen oder von mehr als zwei Rippen mit paradoxer Bewegung;

Leichte Verletzungen ersten Grades: Frakturen der ersten bis dritten Rippe.

Ein Bruch von zwei Rippen wird, wenn er nicht mit einer paradoxen Aktivität oder anderen schwerwiegenden Bedingungen (z. B. mehr als vier) einhergeht, als leichte Verletzung ersten Grades eingestuft. Zwei gebrochene Rippen werden also eingestuft:

leichte Verletzungen (ersten Grades)

In der hochgeladenen Datei werden jedoch zwei gebrochene Rippen als leichte Verletzung zweiten Grades eingestuft. Dies ist ein ziemlich schwerwiegender Fehler für eine Bewerbung in der Rechtsberatung.

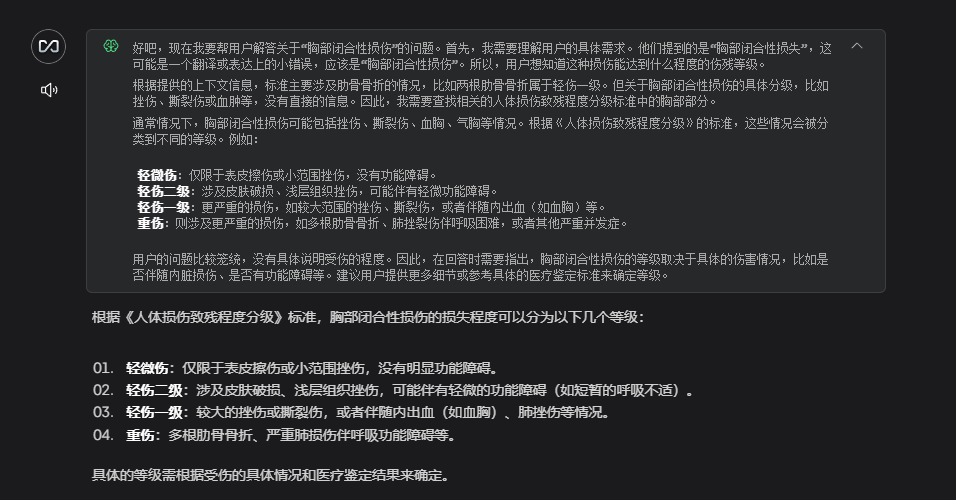

Es gibt keinen Grund zur Eile, wenn diese Art von Unfähigkeit, Fragen zu beantworten, auftritt, lassen Sie uns der Ursache auf den Grund gehen.

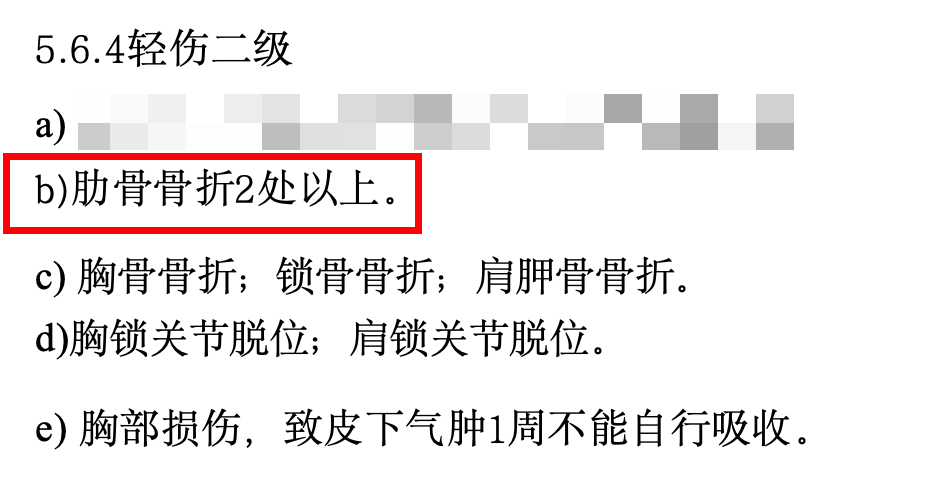

Ich habe mir die hochgeladene PDF-Datei genauer angesehen und festgestellt, dass sie viele Tabellen, spezielle Formatierungen und eine ganze Menge ungenutzter Inhalte enthält. Diese "Verunreinigungen" beeinträchtigen die Fähigkeit der KI, das zu verstehen, was wir ihr eigentlich vermitteln wollen.

Diese unübersichtliche Formatierung kann dazu führen, dass die KI den Überblick über die wichtigsten Punkte verliert, wie bei einem unübersichtlichen Buch. Daher habe ich die wichtigsten Inhalte in einem übersichtlichen Word-Dokument zusammengefasst, den unbrauchbaren Inhalt gelöscht und dann erneut in die KI eingespeist.

Ein Auszug aus dem Inhalt des gesammelten Dokuments:

5.6.4轻伤二级

b)肋骨骨折2处以上。

c) 胸骨骨折;锁骨骨折;肩胛骨骨折。

d)胸锁关节脱位;肩锁关节脱位。

e) 胸部损伤,致皮下气肿1周不能自行吸收。

f) 胸腔积血;胸腔积气。

g)胸壁穿透创。

h)胸部挤压出现窒息征象。

5.6.5轻微伤

a)肋骨骨折;肋软骨骨折。

5.7 腹部损伤

5.7. 1重伤一级

a)肝功能损害(重度)。

b)胃肠道损伤致消化吸收功能严重障碍,依赖肠外营养。

c) 肾功能不全(尿毒症期)。

Ich habe die Frage erneut gestellt, und dieses Mal war die Antwort viel genauer!

Dies ist nur die einfachste Lösung. Wenn Sie möchten, dass die KI genauer antwortet, können Sie auch versuchen, das Dokumentenformat anzupassen, die Suchmethode zu optimieren, die KI-Parameter anzupassen usw. Aber über diese fortgeschrittenen Möglichkeiten sprechen wir später.

Zugang zu WeChat BOT

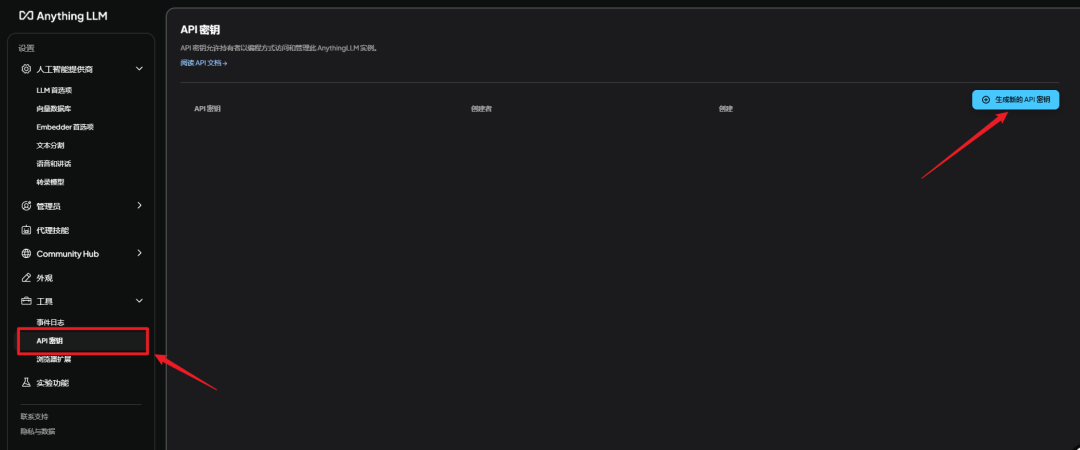

Abrufen des geheimen AnythingLLM-Schlüssels

zeigen (eine Eintrittskarte)AnythingLLMgehen Sie zu Einstellungen - API-Geheimschlüssel - Neuen API-Geheimschlüssel generieren

Verwendung des Integration Packs

Ich habe dieAnythingLLMSchnittstelle zuNGCBOTund zu einem integrierten Paket geschnürt.

Entpacken Sie den Weblink in der DateiNGCBOT_LLM.zipZip, Doppelklick启动器.exeBereit zum Laufen.

Es gibt drei Dinge, die Sie tun müssen, bevor Sie es benutzen!

Es gibt drei Dinge, die Sie tun müssen, bevor Sie es benutzen!

Es gibt drei Dinge, die Sie tun müssen, bevor Sie es benutzen!

Vergewissern Sie sich zunächst, dass sich im Verzeichnis Ihres Integrationspakets kein Chinesisch befindet; andernfalls tritt ein Fehler auf!

korrekte Darstellung

F:AIAIpackageNGCBot

falsche Demonstration

F:微信BOTAIpackageNGCBot

Zweitens: Installieren Sie die angegebene Version von WeChat.

Unter dem Weblink finden Sie eine Microsoft-Version

WeChatSetup-3.9.10.27.exe

Installieren Sie diese Version, hatte der Computer ursprünglich microsoft nicht löschen müssen, direkt die Installation überschreiben.

Drittens: Ändern Sie die NGCBOT-Konfigurationsdatei.

erfordern ein gründliches Verständnis vonConfigConfig.yamlDie Konfigurationsdatei kann geändert werden.

Es gibt drei Änderungen in der Konfigurationsdatei

1. die Konfiguration des Superadministrators ändern.

Tragen Sie hier die ID des Mikrosignals ein, das Sie eingerichtet haben, und denken Sie daran, sie immer zu ändern! Ansonsten wird alles an mich gesendet ....

Wie erhalte ich diese ID? Verwenden Sie das Mikrosignal, das Sie als Administrator einrichten möchten, senden Sie eine Nachricht an den Bot, und Sie werden die ID der Person, die die Nachricht gesendet hat, in der Konsole sehen.

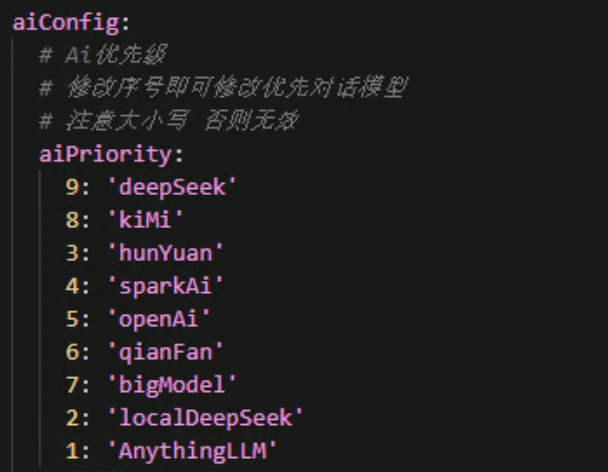

2 Ändern Sie die Konfiguration der ai-Priorität.

Hier wird die Reihenfolge angegeben, in der die ai-Schnittstellen ausgeführt werden, wobei eine kleinere Zahl vorne Priorität bedeutet. Die Standardeinstellung ist AnythingLLM priority.

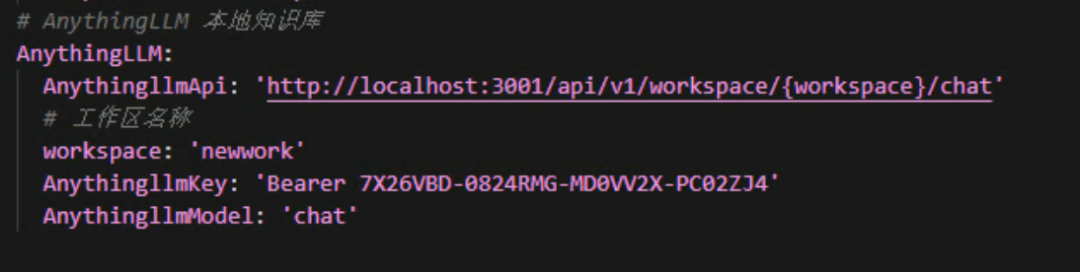

3.AllesLLM-Konfiguration.

Hier müssen Sie dieworkspaceundAnythingLLMkeyDiese beiden Werte sind völlig in Ordnung.

workspaceGeben Sie den Namen des Arbeitsbereichs ein, den Sie mit AnythingLLM erstellt haben, und zwar in Kleinbuchstaben.

AnythingLLMkeyGeben Sie den geheimen Schlüssel ein, den Sie in AnythingLLM erhalten. Nicht den geheimen Schlüssel von Silicon Flow oder den von Volcano Ark!

Denken Sie daran, den Träger vorne zu lassen.

Nachdem Sie die oben genannten Schritte zur Änderung durchgeführt haben, doppelklicken Sie auf die Schaltfläche启动器.exeDann können Sie Spaß haben!

Den Zugang zum Integrationspaket finden Sie am Ende des Artikels.

Herzlichen Glückwunsch! Jeder, der dies sieht, ist 👍🏻👍🏻

Wenn Sie einfach nur schnell mit Wissensdatenbank-Bots spielen wollen, sehen Sie hier nach.

Für die Kleinen, die tiefer eintauchen wollen, steht Folgendes geschrieben

- Wie man die AnythingLLM-Schnittstelle aufruft

- Wie man die NGCBOT-Funktionalität erweitert

Lesen Sie weiter, wenn Sie interessiert sind

Entwicklung und Ausbau

Schnittstellenaufruf

Dieser Schritt ist für diejenigen geeignet, die ihre Entwicklungsforschung erweitern wollen. Wenn Sie Anfänger sind und das Integrationspaket direkt spielen wollen, überspringen Sie bitte diesen Schritt.

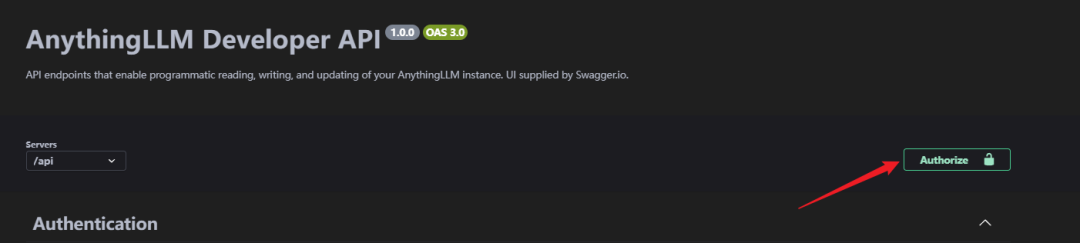

OK, gehen wir ein wenig weiter: Browser-Eingaben[http://localhost:3001/api/docs/](http://localhost:3001/api/docs/)Rufen Sie die API-Seite auf.

Da die ursprüngliche offizielle API-Dokumentation nicht über das Internet zugänglich ist, wurde sie hier durch einen lokalen Zugang zur API-Dokumentation ersetzt.

Nachdem Sie die Seite mit der API-Beschreibung aufgerufen haben, können Sie sehen, dass es hier verschiedene Schnittstellen gibt. Und es unterstützt das Debugging direkt auf dieser Seite.

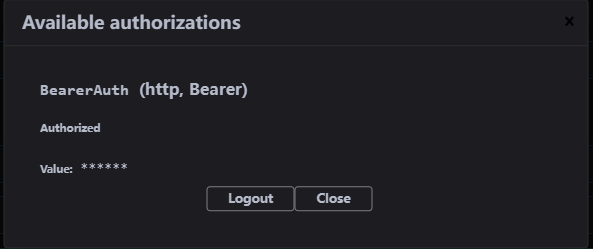

Bevor wir mit dem Zugriff beginnen, müssen wir den geheimen Schlüssel autorisieren, indem wir auf die SchaltflächeAuthorize.

Fügen Sie den AnythingLLMAPI-Schlüssel in den geöffneten Bildschirm ein, die Autorisierung ist erfolgreich!

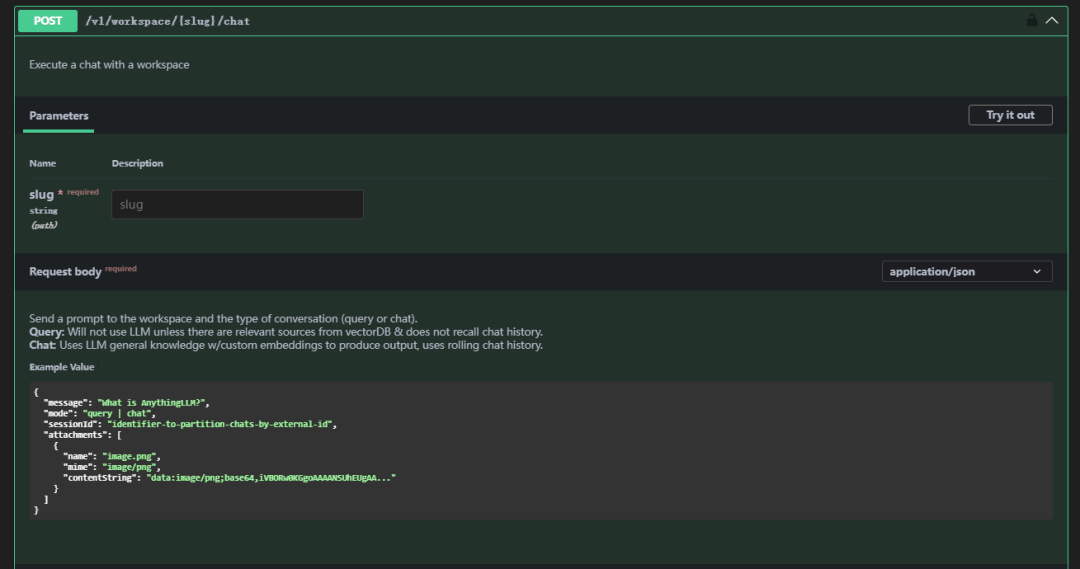

Dann gehen Sie hinunter und suchen/v1/workspace/{slug}/chatDiese API

Beschreibung der Parameter

| Parameter | Anweisungen | Hinweis |

|---|---|---|

| Schnecke | Arbeitsbereich | Chinesische Zeichen, Großbuchstaben und andere Sonderzeichen werden abgelehnt, nur Kleinbuchstaben |

| Nachricht | Nachricht | Die Nachricht, die Sie senden möchten |

| Modus | Paradigma | Das Schema ist in Chat und Abfrage unterteilt, Abfrage bedeutet, dass nur die Abfragekontextfunktion verwendet wird (Sie müssen Ihre eigenen hochgeladenen Dokumente haben), Chat bedeutet, dass die Chatfunktion verwendet wird |

Beispiel für einen Antrag (Antragstext)

curl --location 'http://localhost:3001/api/v1/workspace/newwork/chat'

--header 'Authorization: Bearer 7X26VBD-0824RMG-MD0VV2X-PC02ZJ4'

--header 'Content-Type: application/json'

--data '{

"message": "两根肋骨骨折是什么等级?",

"mode": "chat"

}'

Antworten

{

"id": "488ff13e-0206-4014-bf50-ea2d8e78c1c3",

"type": "textResponse",

"close": true,

"error": null,

"chatId": 17,

"textResponse": "<think>n好的,我现在需要解决用户的问题:“两根肋骨骨折是什么等级?” 用户之前已经询问过这个问题,并且我给出了一个回答,但现在他再次提问,可能希望得到更详细或不同的解释。nn首先,回顾一下上下文。在提供的Context 0中,5.6.4轻伤二级部分提到了b)肋骨骨折2处以上属于轻伤二级。因此,两根肋骨骨折符合这一标准,应定级为轻伤二级。nn用户可能是一名法律工作者、家属或受伤者本人,想要了解骨折的严重程度以便处理工伤赔偿或其他相关事宜。他们可能对分级标准不太熟悉,所以才会多次询问。nn在思考过程中,我需要确认是否还有其他相关的评定标准会影响结果。例如,是否有特殊情况如骨折的位置、是否伴随内脏损伤等,这些因素可能会改变评定等级。但根据提供的Context,没有提到这些情况,因此只能基于给出的信息进行判断。nn此外,用户可能希望知道如何申请工伤认定或后续的赔偿流程,但由于信息有限,我无法提供具体步骤,但可以建议他们联系劳动保障部门或医疗机构获取专业指导。nn总结来说,两根肋骨骨折属于轻伤二级,这是根据提供的标准得出的结论。用户可能需要进一步的法律或医疗咨询来处理相关事宜。n</think>nn根据您提供的上下文信息:nn在 **5.6.4 轻伤二级** 中提到:n- **b) 肋骨骨折2处以上**。nn因此,**两根肋骨骨折属于轻伤二级**。",

"sources": [

{

"text": "5.2.4轻伤二级nna)面部单个创口或者瘢痕长度4.5cm 以上;多个创口或者瘢痕长度累计6.0cm 以上。nnb)面颊穿透创,皮肤创口或者瘢痕长度1.0cm以上。nnc)口唇全层裂创,皮肤创口或者瘢痕长度1.0cm 以上。nnd) 面部块状瘢痕,单块面积3.0cm²以上或多块面积累计5.0cm²以上。nne) 面部片状细小瘢痕或者色素异常,面积累计8.0cm²以上。f)眶壁骨折(单纯眶内壁骨折除外)。nng)眼睑缺损。nnh) 一侧眼睑轻度外翻。nni) 一侧上眼睑下垂覆盖瞳孔。nnj) 一侧眼睑闭合不全。nnk)一侧泪器损伤伴溢泪。nn1)耳廓创口或者瘢痕长度累计6.0cm以上。nnm)耳廓离断、缺损或者挛缩畸形累计相当于一侧耳廓面积15%以上。n)鼻尖或者一侧鼻翼缺损。nno) 鼻骨粉碎性骨折;双侧鼻骨骨折;鼻骨骨折合并上颌骨额突骨折;鼻骨骨折合并鼻中隔骨折;双侧上颌骨额突骨折。nnp) 舌缺损。nnq) 牙齿脱落或者牙折2枚以上。nnr) 腮腺、颌下腺或者舌下腺实质性损伤。nns) 损伤致张口困难I 度 。nnt)颌骨骨折(牙槽突骨折及一侧上颌骨额突骨折除外)。u)颧骨骨折。nn5.2.5轻微伤nnnnnnnnnna)面部软组织创。nnb)面部损伤留有瘢痕或者色素改变。nnc) 面部皮肤擦伤,面积2.0cm²以上;面部软组织挫伤;面部划伤4.0cm以上。nnd)眶内壁骨折。nne)眼部挫伤;眼部外伤后影响外观。nnf) 耳廓创。nng) 鼻骨骨折;鼻出血。h)上颌骨额突骨折。nni) 口腔粘膜破损;舌损伤。nnj) 牙齿脱落或者缺损;牙槽突骨折;牙齿松动2枚以上或者Ⅲ度松动1枚以上。nn5.3 听器听力损伤nn5.3. 1重伤一级nna) 双耳听力障碍(≥91dB HL)。nn5.3.2重伤二级nna) 一耳听力障碍(≥91dB HL)。nnb) 一耳听力障碍(≥81dB HL),另一耳听力障碍(≥41dB HL)。nnc) 一耳听力障碍(≥81dB HL),伴同侧前庭平衡功能障碍。nnd) 双耳听力障碍(≥61dB HL)。nne) 双侧前庭平衡功能丧失,睁眼行走困难,不能并足站立。nn5.3.3轻伤一级nna)双耳听力障碍(≥41dB HL)。nnb)双耳外耳道闭锁。nn5.3.4轻伤二级nna) 外伤性鼓膜穿孔6周不能自行愈合。b...continued on in source document...",

"id": "210f98f0-d656-4c0f-b3d5-d617f6398eca",

"url": "file://C:\Users\XX\AppData\Roaming\anythingllm-desktop\storage\hotdir\新建 DOCX 文档.docx",

"title": "新建 DOCX 文档.docx",

"docAuthor": "no author found",

"description": "No description found.",

"docSource": "pdf file uploaded by the user.",

"chunkSource": "localfile://C:\Users\XX\Desktop\新建 DOCX 文档.docx",

"published": "2025/2/7 13:00:52",

"wordCount": 126,

"token_count_estimate": 3870

}

],

"metrics": {

"prompt_tokens": 431,

"completion_tokens": 326,

"total_tokens": 757,

"outputTps": 63.178294573643406,

"duration": 5.16

}

}

Auf diese Weise haben wir den Test des Aufrufs der AnythingLLM-Schnittstelle abgeschlossen. Anhand dieser Schnittstelle können Sie Ihre eigene Geschäftslogik implementieren. Im Folgenden kombinieren wir den WeChat BOT, um den Wissensbasis-Roboter zu implementieren.

NGC-Änderungen

Die NGCBOT-Projekte müssen inApiServerAiServerAiDialogue.pyHinzufügen eines Aufrufs zum SkriptAnythingLLMDie Logik der

Hier setze ich einfach den Code ein.

def getAnythingLLM(self, content, messages):

"""

本地 AnythingLLM 模型

:param content: 对话内容

:param messages: 消息列表

:return:

"""

op(f'[*]: 正在调用本地AnythingLLM对话接口... ...')

messages.append({"role": "user", "content": f'{content}'})

data = {

"model": self.anythingLLMConfig.get('anythingllmModel'),

"message": content

}

headers = {

"Content-Type": "application/json",

"Authorization": self.anythingLLMConfig.get('anythingllmKey')

}

try:

resp = requests.post(

url=self.anythingLLMConfig.get('anythingllmApi').format(workspace=self.anythingLLMConfig.get('workspace')),

headers=headers,

json=data,

timeout=300

)

resp.encoding = 'utf-8'

json_data = resp.json()

assistant_content = json_data['textResponse']

if "</think>" in assistant_content:

assistant_content = assistant_content.split("</think>")[1].strip()

messages.append({"role": "assistant", "content": f"{assistant_content}"})

if len(messages) == 21:

del messages[1]

del messages[2]

return assistant_content, messages

except Exception as e:

op(f'[-]: 本地AnythingLLM对话接口出现错误, 错误信息: {e}')

return None, [{"role": "system", "content": f'{self.systemAiRole}'}]

Fügen Sie dieanythingLLMConfig

self.anythingLLMConfig = {

'anythingllmApi': configData['apiServer']['aiConfig']['AnythingLLM']['AnythingllmApi'],

'anythingllmKey': configData['apiServer']['aiConfig']['AnythingLLM']['AnythingllmKey'],

'anythingllmModel': configData['apiServer']['aiConfig']['AnythingLLM']['AnythingllmModel'],

'workspace': configData['apiServer']['aiConfig']['AnythingLLM']['workspace']

}

Erwerb des Integrationspakets

Tootsie Labs - Windowns Edition

Quark:

https://pan.quark.cn/s/8d1293227cf9

Baidu.

https://pan.baidu.com/s/1wx8LmbY2XBaJAAJvmGK06g?pwd=8d5m

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...