Auflösung der Verwirrung o1, sind Inferenzmodelle wie DeepSeek-R1 denkend oder nicht?

Ich habe einen lustigen Artikel über TheDie Gedanken sind überall: Über das Unterdenken von o1-ähnlichen LLMs"Das Thema ist die Analyse des Denkmodells o1 Häufiges Wechseln der Denkpfade und Unkonzentriertheit im Denken, bezeichnet als"Unterdenken".Es werden auch Methoden zur Schadensbegrenzung genannt. Dieser Artikel beantwortet gleichzeitig die Frage, ob das Inferenzmodell ein neues Denken ist oder nicht, und hoffentlich findet der Leser seine eigene Antwort.

I. Hintergrund:

In den letzten Jahren haben große Sprachmodelle (Large Language Models, LLMs), repräsentiert durch das o1-Modell von OpenAI, ihre überlegenen Fähigkeiten bei komplexen Denkaufgaben bewiesen, bei denen sie die Tiefe des menschlichen Denkens nachahmen, indem sie die Menge der am Denkprozess beteiligten Berechnungen erhöhen. Allerdings haben bestehende Studien die Tiefe des Denkens von LLMs in Frage gestellt:Denken diese Modelle wirklich tiefgründig?

Um diese Frage zu beantworten, schlagen die Autoren dieses Papiers vor"Unterdenken".des Konzepts und analysiert es systematisch. Die Autoren argumentieren, dass dienicht genug Stoff zum Nachdenkenist die o1-Klasse der LLMs bei der Lösung komplexer Probleme.Ein zu frühes Verlassen vielversprechender Schlussfolgerungspfade führt zu einer unzureichenden Gedankentiefe und beeinträchtigt letztlich die Modellleistung. Dieses Phänomen ist bei Mathematikrätseln besonders ausgeprägt.

II. Methoden der Reflexion und Forschung:

Um dem Phänomen des Unterdenkens auf den Grund zu gehen, haben die Autoren die folgenden Untersuchungen durchgeführt:

1. die Definition und Beobachtung des Phänomens des Reflexionsdefizits

- Definieren des Denkens: Die Autoren definieren "Denken" als einen kognitiven Zwischenschritt im Argumentationsprozess eines Modells und verwenden Begriffe wie "alternativ" als Zeichen für einen Wechsel im Denken.

- Beispiel: In Abbildung 2 zeigen die Autoren ein Beispiel für das Ergebnis eines Modells mit 25 Denkschritten und vergleichen es mit dem Ergebnis von Overthinking.

- Versuchsaufbau:

- Test-Sets: Die Autoren wählten drei anspruchsvolle Testreihen aus:

- MATH500. Enthält Fragen aus Mathematikwettbewerben der Oberstufe mit Schwierigkeitsgraden von 1 bis 5.

- GPQA Diamant. Enthält Multiple-Choice-Fragen für Hochschulabsolventen aus den Bereichen Physik, Chemie und Biologie.

- AIME2024. Die Themen des U.S. Invitational Mathematics Competition decken ein breites Spektrum an Bereichen ab, darunter Algebra, Zählen, Geometrie, Zahlentheorie und Wahrscheinlichkeit.

- Modellauswahl: Die Autoren wählten zwei Open-Source-Modelle der o1-Klasse mit sichtbaren langen Gedankenketten: das QwQ-32B-Preview und das DeepSeek-R1-671B, und verwendeten das DeepSeek-R1-Preview als Ergänzung, um die Entwicklung der R1-Modellfamilie zu zeigen.

- Test-Sets: Die Autoren wählten drei anspruchsvolle Testreihen aus:

2. die Analyse der Erscheinungsformen unzureichender Reflexion

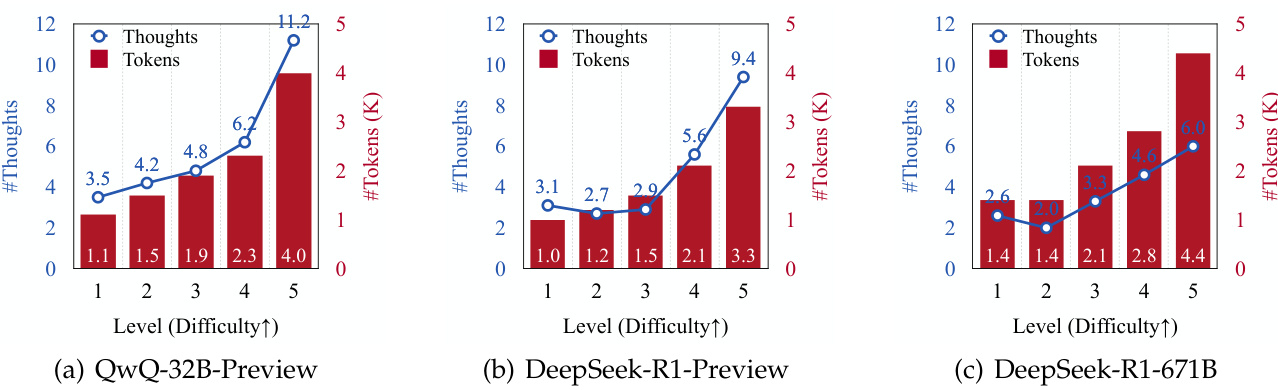

- Überlegungen zur Häufigkeit des Wechsels und zur Schwierigkeit des Problems:

- Die Autoren stellten fest, dass die Anzahl der generierten Inferenzreflexionen und die Anzahl der generierten Token für alle Modelle mit zunehmender Schwierigkeit des Problems anstieg (siehe Abbildung 3).

- Dies deutet darauf hin, dass LLMs der Klasse o1 in der Lage sind, den Argumentationsprozess dynamisch anzupassen, um komplexere Probleme zu bewältigen.

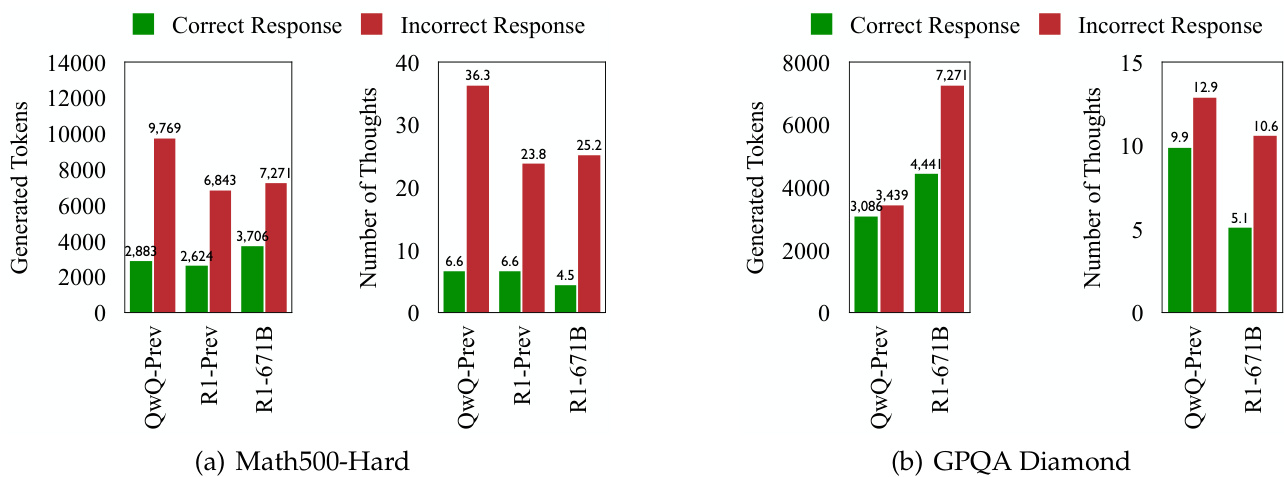

- Nachdenken über Umschalten und Fehlerreaktion:

- In allen Testsätzen zeigten LLMs der Klasse o1 häufiger einen Denkwechsel, wenn sie falsche Antworten generierten (siehe Abbildungen 1 und 4).

- Dies deutet darauf hin, dass, obwohl das Modell darauf abzielt, kognitive Prozesse dynamisch anzupassen, um Probleme zu lösen, häufigeres Umschalten des Denkens nicht unbedingt zu einer höheren Genauigkeit führt.

3. eingehende Untersuchung der Art des Denkdefizits

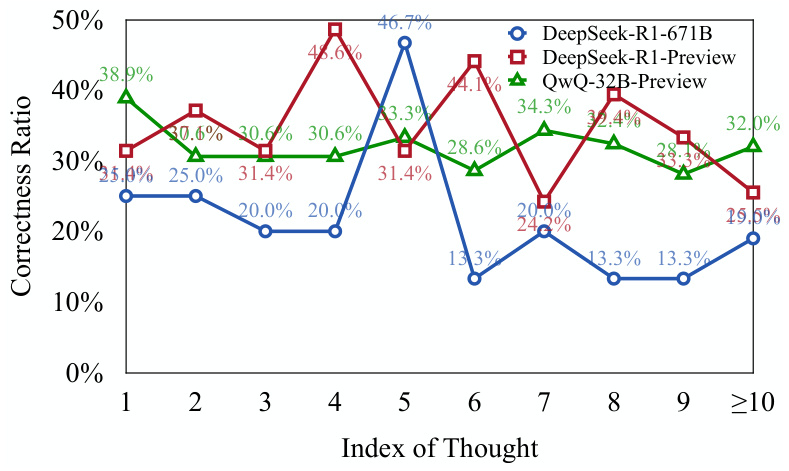

- Bewerten Sie die Richtigkeit des Denkens:

- Die Autoren verwendeten zwei auf Llama und Qwen basierende Modelle (DeepSeek-R1-Distill-Llama-70B und DeepSeek-R1-Distill-Qwen-32B), um zu beurteilen, ob jeder Denkschritt richtig war.

- Die Ergebnisse zeigen, dassEin beträchtlicher Teil der frühen Denkschritte in der Fehlerreaktion ist richtig, aber nicht vollständig erforscht(siehe Abbildung 5).

- Dies deutet darauf hin, dass das Modell, wenn es mit einem komplexen Problem konfrontiert istNeigung zum vorzeitigen Verlassen vielversprechender Denkwege, was zu einem Mangel an gedanklicher Tiefe führt.

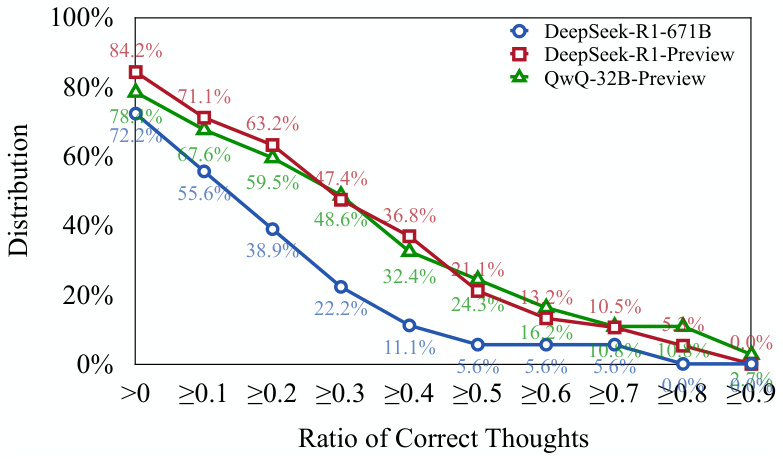

- Denken Sie über die Verteilung der Korrektheit nach:

- Die Autoren fanden heraus, dass mehr als 701 TP3T-Fehlerantworten mindestens einen richtigen Denkschritt enthielten (siehe Abbildung 6).

- Dies unterstreicht die obige Auffassung:o Modelle der Klasse 1 sind in der Lage, die richtigen Wege der Argumentation einzuleiten, aber es kann schwierig sein, diese Wege bis zur richtigen Schlussfolgerung fortzusetzen.

4. die Quantifizierung des Mangels an Reflexion: Vorschlag neuer Indikatoren für die Bewertung

- Nachdenken über Unter-Indikatoren (UT):

- Diese Metrik quantifiziert den Grad des Unterdenkens, indem sie die Effizienz des Tokens bei der Erzeugung einer Fehlerantwort misst.

- Konkret berechnet die UT-Metrik die Fehlerreaktion, bei der dieAnzahl der Token, die vom Anfang bis zum ersten richtig gedacht wurden, im Verhältnis zur Gesamtzahl der Token.

- Höhere UT-Werte weisen auf ein höheres Maß an Unterdenken hind.h. ein größerer Anteil der Token, die das Modell als Reaktion auf einen Fehler generiert, trägt nicht wirksam zur Erzeugung des richtigen Denkens bei.

5. die Auswirkung des Unterdenkens auf die Modellleistung:

- Die Autoren stellten fest, dassDas Phänomen des Unterdenkens wirkt sich je nach Datensatz und Aufgabe unterschiedlich aus::

- Bei den Datensätzen MATH500-Hard und GPQA Diamond wies das Modell DeepSeek-R1-671B zwar eine höhere Genauigkeit, aber auch einen höheren UT-Wert auf, was auf ein stärkeres Unterdenken bei der Fehlerreaktion schließen lässt.

- Auf dem AIME2024-Testsatz hat das DeepSeek-R1-671B-Modell nicht nur eine höhere Genauigkeit, sondern auch einen niedrigeren UT-Wert, was auf einen gezielteren und effizienteren Inferenzprozess hindeutet.

III. wichtige Schlussfolgerungen:

- Unzureichendes Denken ist ein wichtiger Faktor für das schlechte Abschneiden der o1 LLM bei komplexen Problemen. Häufiges Umdenken führt dazu, dass das Modell nicht in der Lage ist, vielversprechende Inferenzpfade eingehend zu untersuchen, was sich letztlich auf seine Genauigkeit auswirkt.

- Das Phänomen des Unterdenkens hängt mit der Schwierigkeit des Problems und der Modellierungsfähigkeit zusammen. Schwerere Probleme verschlimmern das Unterdenken, und leistungsfähigere Modelle verringern nicht immer das Unterdenken.

- Unterdenken ist etwas anderes als Überdenken. Zu viel Denken bedeutet, dass ein Modell bei einfachen Problemen Rechenressourcen verschwendet, während zu wenig Denken bedeutet, dass ein Modell bei komplexen Problemen vielversprechende Inferenzpfade vorzeitig aufgibt.

- Der Underthinking-Indikator (UT) kann das Ausmaß des Unterdenkens effektiv quantifizieren. Diese Metrik bietet eine neue Perspektive für die Bewertung der Argumentationseffizienz von LLMs der Klasse o1.

IV. Reaktionsstrategien:

Um das Problem des unzureichenden Denkens zu mildern, schlagen die Autoren einDekodierungsstrategie mit Think Switching Penalty (TIP)::

- Kerngedanken: Während des Dekodierungsprozesses werden auf das Token, das mit dem Think-Switch verbunden ist, Strafen angewandt, dieErmutigung der Modelle, das derzeitige Denken zu vertiefen, bevor sie zu einem neuen Denken übergehen.

- Ergebnisse: Die TIP-Strategie verbessert die Genauigkeit des QwQ-32B-Preview-Modells in allen Testsätzen, was ihre Wirksamkeit bei der Entschärfung des Underthinking-Problems beweist.

V. Zukunftsperspektiven:

Die Autoren schlagen als künftige Forschungsrichtungen vor:

- Entwicklung von Anpassungsmechanismen, die es den Modellen ermöglichen, ihre Denkprozesse selbst zu regulieren.

- Weitere Verbesserung der Inferenz-Effizienz von LLMs der Klasse o1.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Verwandte Beiträge

Keine Kommentare...