InspireMusic: Alis Open-Source-Framework für die einheitliche Erzeugung von Musik, Songs und Audio

Allgemeine Einführung

InspireMusic ist ein auf PyTorch basierendes Open-Source-Toolkit, das sich auf Musik-, Song- und Audiogenerierung konzentriert. Es bietet ein einheitliches Framework für die Erzeugung von hochwertigem Audio mit Kontrolle über Text-Cues, Musikstruktur und Musikstil. InspireMusic unterstützt 24kHz und 48kHz Audio-Generierung und ist in der Lage, lange Audio-Generierung. Das Toolkit bietet nicht nur Inferenz- und Trainingscode, sondern unterstützt auch Mixed-Precision-Training für die Feinabstimmung und Inferenz des Modells.InspireMusic hat sich zum Ziel gesetzt, den Nutzern bei der Innovation von Klanglandschaften zu helfen und die harmonische Ästhetik in der Musikforschung durch den Prozess des Audio-Labelling und De-Labelling zu verbessern.

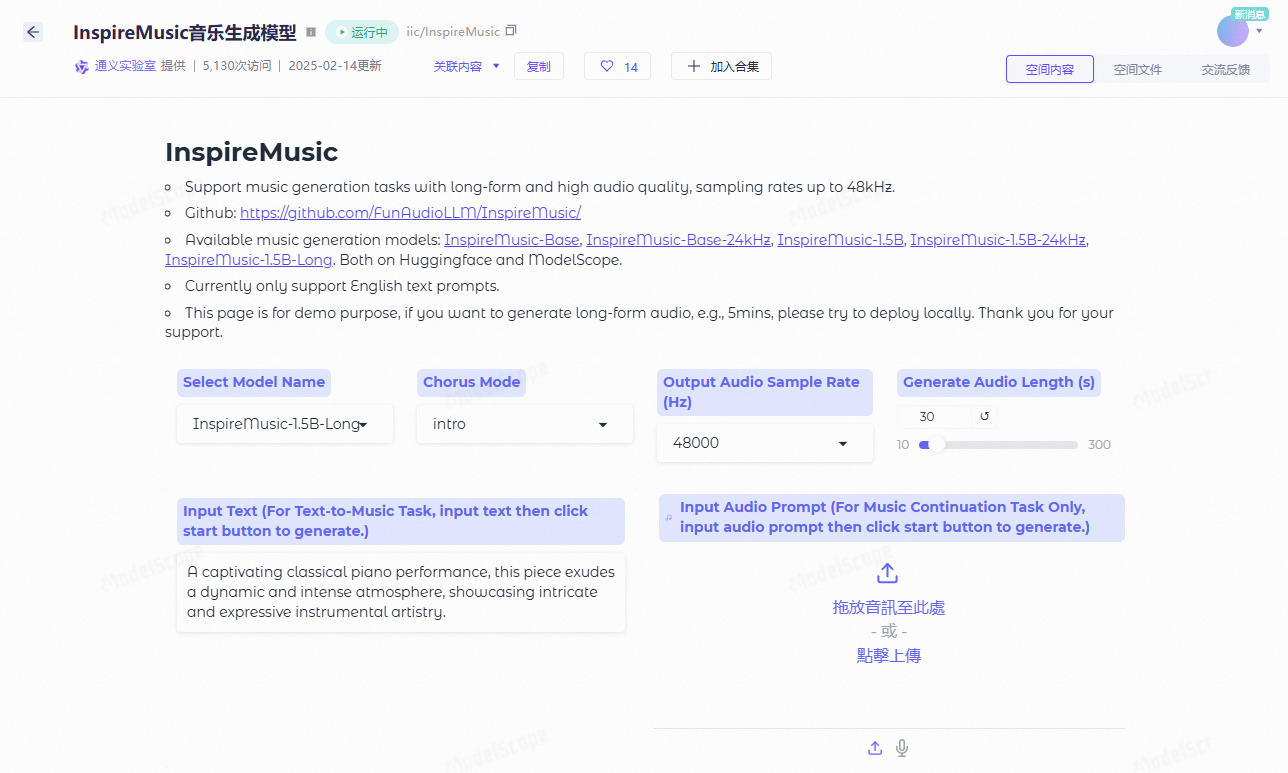

Demo: https://modelscope.cn/studios/iic/InspireMusic/summary

Funktionsliste

- Text-to-MusicMusik aus Textstichworten generieren.

- Kontrolle der MusikstrukturUnterstützung für die Erzeugung von Musik auf der Grundlage musikalischer Strukturen.

- Musikstil-SteuerungSie können den Stil der erzeugten Musik bestimmen.

- Hochwertige AudioerzeugungUnterstützt 24kHz und 48kHz Audiogenerierung.

- Lange AudioerzeugungUnterstützt die Erzeugung von Audiodaten mit langer Dauer.

- Gemischtes PräzisionstrainingUnterstützt BF16, FP16/FP32 Training mit gemischter Präzision.

- Modell-Feinabstimmung und InferenzErmöglicht eine einfache Feinabstimmung und Überlegungen zu Skripten und Strategien.

- Online-DemoEine Online-Demo ist verfügbar, und die Benutzer können sie auf ModelScope und HuggingFace ausprobieren.

Hilfe verwenden

Einbauverfahren

- Klon-Lagerhaus:

git clone https://github.com/FunAudioLLM/InspireMusic.git

cd InspireMusic

- Installieren Sie die Abhängigkeit:

pip install -r requirements.txt

- Installieren Sie PyTorch (wählen Sie den entsprechenden Installationsbefehl für Ihre CUDA-Version):

pip install torch torchvision torchaudio

Leitlinien für die Verwendung

Text-to-Music

- Bereiten Sie Textaufforderungen vor, z. B. "Erfinden Sie ein schwungvolles Klavierstück".

- Führen Sie das Generierungsskript aus:

python app.py --text "生成一段欢快的钢琴音乐"

- Die erzeugte Musik wird in dem angegebenen Ausgabeverzeichnis gespeichert.

Kontrolle der Musikstruktur

- Bereiten Sie eine Musikstrukturdatei vor, die die Rhythmen, Akkorde usw. der Musik definiert.

- Führen Sie das Generierungsskript aus:

python app.py --structure path/to/structure/file

- Die erzeugte Musik wird auf der Strukturdatei basieren.

Musikstil-Steuerung

- Wählen Sie einen vordefinierten Musikstil aus, z.B. "Klassik", "Jazz", etc.

- Führen Sie das Generierungsskript aus:

python app.py --style "古典"

- Die erzeugte Musik wird dem ausgewählten Musikstil entsprechen.

Modell-Feinabstimmung und Inferenz

InspireMusic bietet bequeme Skripte zur Feinabstimmung und Inferenz, die es dem Benutzer ermöglichen, das Modell und die Inferenz nach seinen Bedürfnissen zu optimieren. Nachfolgend finden Sie ein einfaches Beispiel für die Feinabstimmung:

- Bereiten Sie den Trainingsdatensatz vor.

- Führen Sie das Feinabstimmungsskript aus:

python finetune.py --data path/to/dataset --output path/to/output/model

- Inferenz mit einem fein abgestimmten Modell:

python app.py --model path/to/output/model --text "生成一段新的音乐"

Online-Demo

Benutzer können die Online-Demoseiten auf ModelScope und HuggingFace besuchen, um die Leistungsfähigkeit von InspireMusic zu erleben. Geben Sie einfach Textanweisungen ein, um hochwertige Musik zu erzeugen.

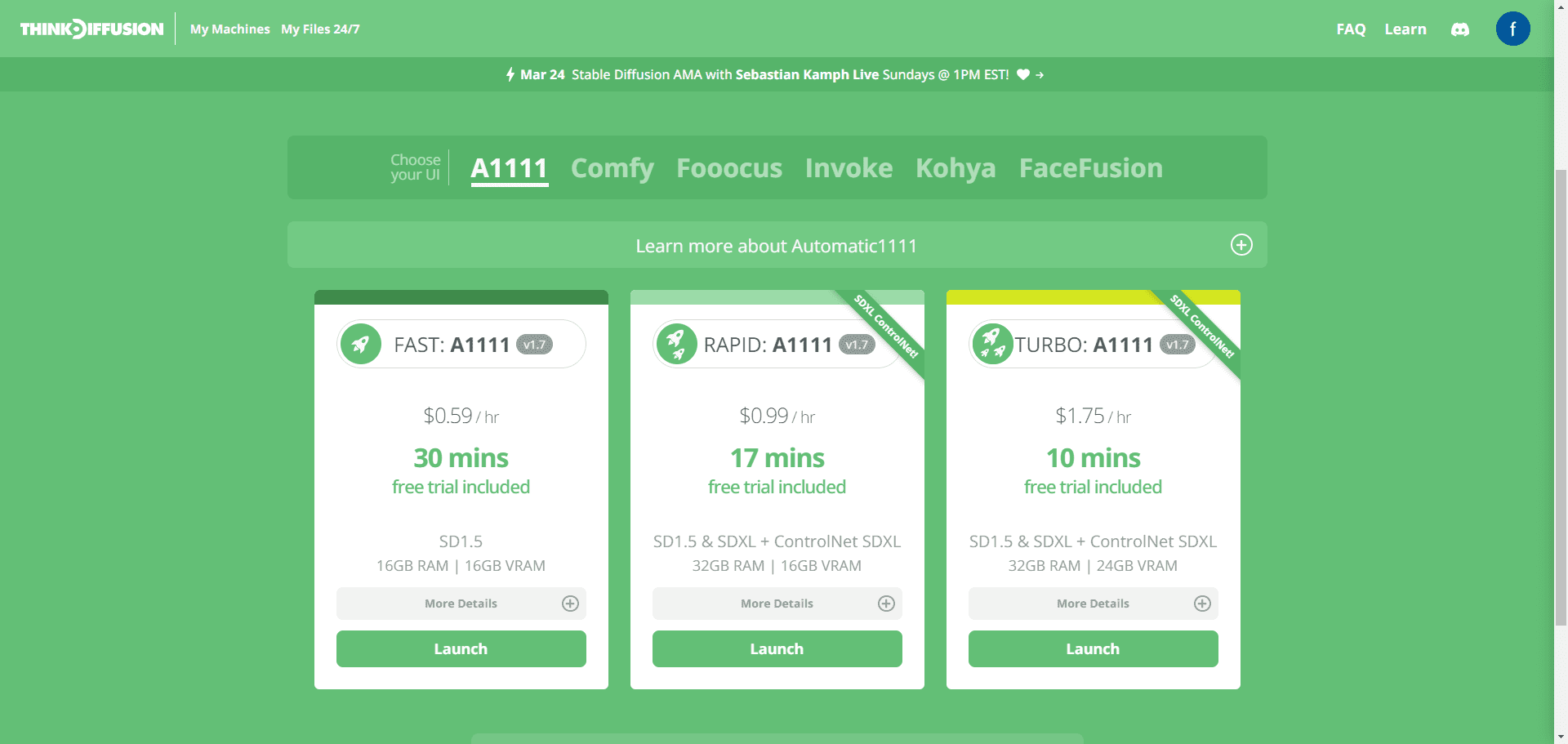

jian27 Integrationspaket

Quark: https://pan.quark.cn/s/4843d9c54615

Baidu: https://pan.baidu.com/s/1hKIHENqPbKRBjnbVRBni7Q?pwd=2727

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...