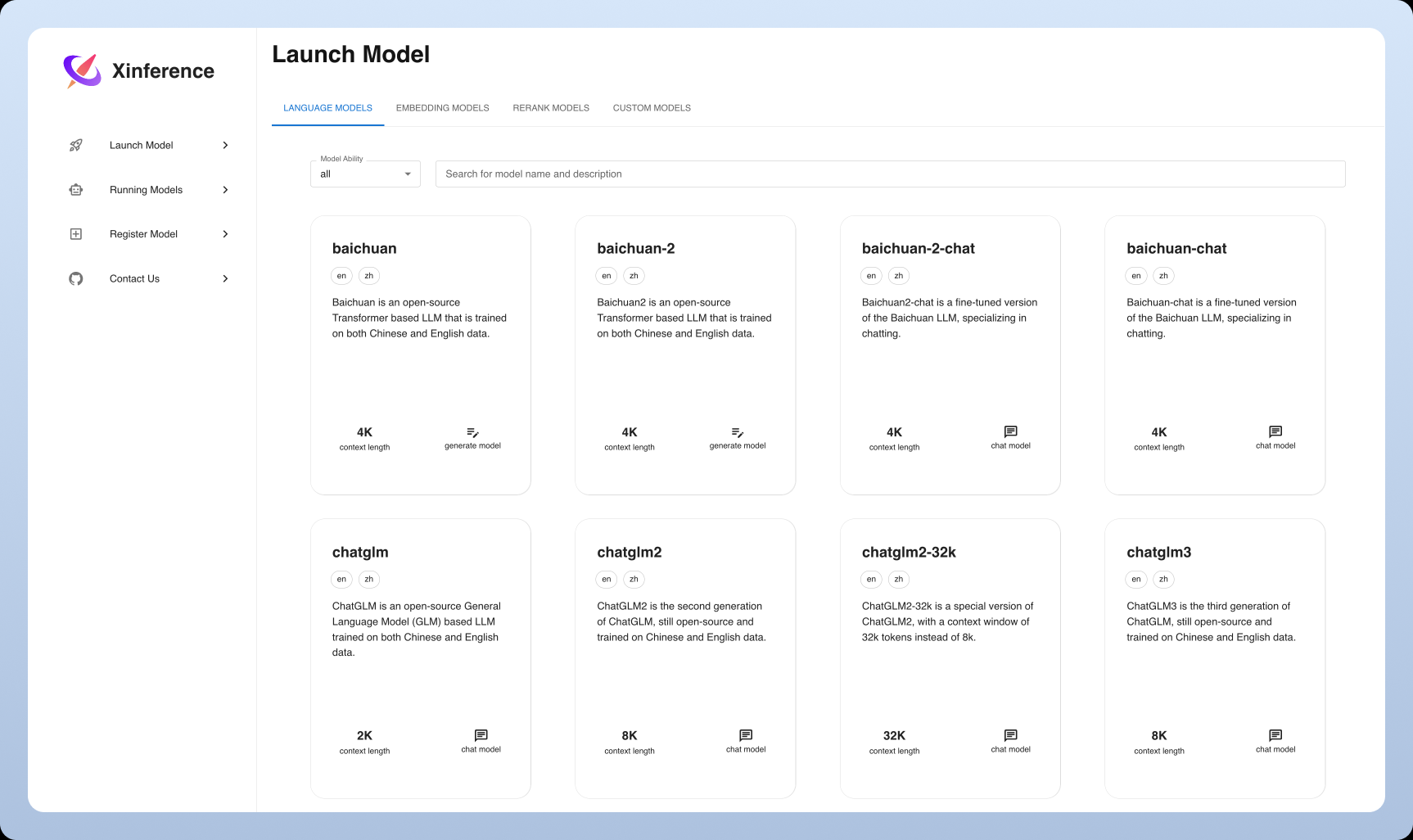

Xinference: Einfache verteilte KI-Modellbereitstellung und -wartung

Allgemeine Einführung

Xorbits Inference (oder kurz Xinference) ist eine leistungsstarke und vielseitige Bibliothek, die sich auf die verteilte Bereitstellung von Sprachmodellen, Spracherkennungsmodellen und multimodalen Modellen konzentriert. Mit Xorbits Inference können Benutzer ihre eigenen Modelle oder integrierte fortgeschrittene Modelle mit einem einzigen Befehl bereitstellen und nutzen. Ob in der Cloud, auf einem lokalen Server oder auf einem Personal Computer, Xorbits Inference läuft effizient. Die Bibliothek ist besonders für Forscher, Entwickler und Datenwissenschaftler geeignet und hilft ihnen, das volle Potenzial modernster KI-Modelle auszuschöpfen.

Funktionsliste

- verteilte BereitstellungUnterstützt verteilte Einsatzszenarien, so dass Modellinferenzaufgaben nahtlos auf mehrere Geräte oder Maschinen verteilt werden können.

- ModellierungsdienstRationalisierung des Prozesses der Bereitstellung großer Sprachmodelle, Spracherkennungsmodelle und multimodaler Modelle.

- Bereitstellung mit einem einzigen BefehlBereitstellung und Wartung von Modellen mit einem einzigen Befehl, sowohl für experimentelle als auch für Produktionsumgebungen.

- Heterogene Hardware-NutzungIntelligence nutzt heterogene Hardware, einschließlich GPUs und CPUs, um Modellinferenzaufgaben zu beschleunigen.

- Flexible APIs und SchnittstellenBereitstellung einer Vielzahl von Schnittstellen zur Interaktion mit dem Modell, die RPC, RESTful API (kompatibel mit OpenAI API), CLI und WebUI unterstützen.

- Eingebaute fortschrittliche ModelleIntegrierte Unterstützung für eine breite Palette modernster Open-Source-Modelle, die der Benutzer direkt für seine Experimente verwenden kann.

Hilfe verwenden

Einbauverfahren

- Vorbereitung der UmweltStellen Sie sicher, dass Python 3.7 oder höher installiert ist.

- Installation von Xorbits Inference::

pip install xorbits-inference

- Überprüfen der InstallationNachdem die Installation abgeschlossen ist, können Sie mit dem folgenden Befehl überprüfen, ob die Installation erfolgreich war:

xinference --version

Leitlinien für die Verwendung

Bereitstellungsmodell

- Modelle laden: Verwenden Sie den folgenden Befehl, um ein vorab trainiertes Modell zu laden:

xinference load-model --model-name <模型名称>

Beispiel:

xinference load-model --model-name gpt-3

- Neue DiensteNach dem Laden des Modells starten Sie den Dienst:

xinference serve --model-name <模型名称>

Beispiel:

xinference serve --model-name gpt-3

- Aufrufen der APISobald der Dienst gestartet ist, kann er über eine RESTful-API aufgerufen werden:

curl -X POST http://localhost:8000/predict -d '{"input": "你好"}'

Verwendung des eingebauten Modells

Xorbits Inference verfügt über eine eingebaute Unterstützung für eine breite Palette von fortgeschrittenen Modellen, die vom Benutzer direkt zur Durchführung von Experimenten verwendet werden können. Beispiel:

- Sprachmodellz.B. GPT-3, BERT, usw.

- Spracherkennungsmodell: z.B. DeepSpeech, etc.

- multimodales Modell: z.B. CLIP, etc.

verteilte Bereitstellung

Xorbits Inference unterstützt die verteilte Bereitstellung, so dass Benutzer Modellinferenzaufgaben nahtlos auf mehrere Geräte oder Maschinen verteilen können. Die Schritte werden im Folgenden beschrieben:

- Konfigurieren einer verteilten UmgebungInstallieren Sie Xorbits Inference auf jedem Knoten und konfigurieren Sie die Netzwerkverbindung.

- Verteilte Dienste startenVerteilte Dienste auf dem Master-Knoten starten:

xinference serve --distributed --nodes <节点列表>

Beispiel:

xinference serve --distributed --nodes "node1,node2,node3"

- Aufrufen der verteilten APIÄhnlich wie bei Single-Node-Implementierungen wird sie über eine RESTful-API aufgerufen:

curl -X POST http://<主节点IP>:8000/predict -d '{"input": "你好"}'

allgemeine Probleme

- Wie kann ich das Modell aktualisieren? Verwenden Sie den folgenden Befehl, um das Modell zu aktualisieren:

xinference update-model --model-name <模型名称>

- Wie kann ich die Protokolle einsehen? Verwenden Sie den folgenden Befehl, um das Dienstprotokoll anzuzeigen:

xinference logs --model-name <模型名称>© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...