Inception Labs veröffentlicht erstes kommerziell nutzbares Diffusionsmodell für große Sprachen

Inception Labs stellt die Mercury-Familie von Diffused Large Language Models (dLLMs) vor, die bis zu 10-mal schneller und kostengünstiger als bestehende LLMs sind und die Sprachmodellierung an neue Grenzen der Intelligenz und Geschwindigkeit führen.

Zentrum

- Inception Labs hat die Mercury-Familie von Diffused Large Language Models (dLLMs) offiziell freigegeben. Damit ist eine neue Generation von LLMs geboren und eine neue Stufe der schnellen, qualitativ hochwertigen Textgenerierungstechnologie eingeläutet.

- Mercury ist 10x schneller als aktuelle geschwindigkeitsoptimierte LLMs. Auf NVIDIA H100-GPUs laufen Mercury-Modelle mit mehr als 1.000 Token/Sekunde, eine Geschwindigkeit, die bisher nur mit kundenspezifischen Chips möglich war.

- Codegenerierungsmodell Quecksilber-Kodierer Jetzt in Spielplatz Inception Labs bietet Zugang zu Code-Modellen und generischen Modellen für Unternehmenskunden über APIs und native Implementierungen.

Die Vision von Inception Labs - Diffusion Empowering the Next Generation of LLMs

Aktuelle Large Language Models (LLMs) verwenden in der Regel ein autoregressives Modell, was bedeutet, dass sie wie eine menschliche Schrift von links nach rechts geschrieben werden Token Generierung von Text. Diese Generierung ist von Natur aus seriell - vorherige Token müssen generiert werden, bevor nachfolgende Token generiert werden können, und jedes generierte Token erfordert die Auswertung eines neuronalen Netzes mit Milliarden von Parametern. Die branchenführenden LLM-Unternehmen setzen auf eine verstärkte Berechnung während der Inferenzzeit, um die Inferenz- und Fehlerkorrekturfähigkeiten ihrer Modelle zu verbessern, aber die Generierung langwieriger Inferenzprozesse führt auch dazu, dass die Inferenzkosten in die Höhe schießen und die Latenzzeit zunimmt, wodurch die Produkte letztendlich schwer zu verwenden sind. Ein Paradigmenwechsel ist unabdingbar, um hochwertige KI-Lösungen wirklich allgegenwärtig zu machen.

Diffusionsmodelle bieten die Möglichkeit eines solchen Paradigmenwechsels. Solche Modelle verwenden einen "Grob-zu-Fein"-Generierungsprozess. Wie im Video gezeigt, beginnt die Ausgabe des Modells mit reinem Rauschen und wird in mehreren "Entrauschungs"-Schritten schrittweise optimiert.

Im Gegensatz zu autoregressiven Modellen sind Diffusionsmodelle nicht gezwungen, nur das zu berücksichtigen, was zuvor ausgegeben wurde. Dadurch sind sie besser in der Lage, Schlussfolgerungen zu ziehen und Antworten zu strukturieren. Da Diffusionsmodelle außerdem in der Lage sind, ihre Ausgabe kontinuierlich zu optimieren, können sie Fehler wirksam korrigieren und Täuschungen verringern. Aufgrund dieser Vorteile sind Diffusionsmodelle die treibende Kraft für viele der aktuellen herausragenden KI-Lösungen im Bereich der Video-, Bild- und Audiogenerierung, wie Sora, Midjourney und Riffusion, um nur einige zu nennen. Versuche, Diffusionsmodelle auf diskrete Daten, wie Text und Code, anzuwenden, waren jedoch bisher nicht erfolgreich. Bis zu Mercury war diese Situation völlig verfahren.

Mercury Coder - 1000+ Token/Sekunde, modernste Intelligenz an Ihren Fingerspitzen!

Inception Labs freut sich, die Veröffentlichung von Mercury Coder, der ersten öffentlich verfügbaren dLLM, bekannt zu geben.

Mercury Coder ist das Ergebnis bahnbrechender Forschung des Gründungsteams von Inception Labs, das nicht nur Pionierarbeit bei der Bilddiffusionsmodellierung geleistet hat, sondern auch viele zentrale generative KI-Technologien miterfunden hat, darunter Direct Preference Optimisation (DPO) und Decision Transformers. Mercury Coder ist das Ergebnis der bahnbrechenden Forschung des Gründungsteams von Inception Labs, das nicht nur Pionierarbeit bei der Bilddiffusionsmodellierung geleistet hat, sondern auch eine Reihe zentraler generativer KI-Technologien miterfunden hat, darunter Direct Preference Optimization (DPO), Flash Attention und Decision Transformers.

dLLM kann als direkter Ersatz für bestehende autoregressive LLMs verwendet werden und unterstützt alle Anwendungsszenarien, einschließlich RAG (Retrieval Augmentation Generation), Tool-Nutzung und Agenten-Workflows. dLLM generiert beim Empfang einer Benutzerabfrage die Antworten nicht Token für Token. Beim Empfang einer Benutzeranfrage generiert dLLM die Antwort nicht Token für Token, sondern generiert die Antwort grob bis fein, wie in der obigen Animation zu sehen ist. Das Transformer-Modell (das in Mercury Coder verwendet wird) wurde auf einer großen Datenmenge trainiert und ist in der Lage, die Qualität der Antwort global zu optimieren, indem es mehrere Token parallel modifiziert, um die generierten Ergebnisse zu verbessern. Das Transformer-Modell (das in Mercury Coder verwendet wird) wurde auf einer großen Datenmenge trainiert und ist in der Lage, die Qualität der Antwort global zu optimieren und mehrere Token parallel zu modifizieren, um die Ergebnisse kontinuierlich zu verbessern.

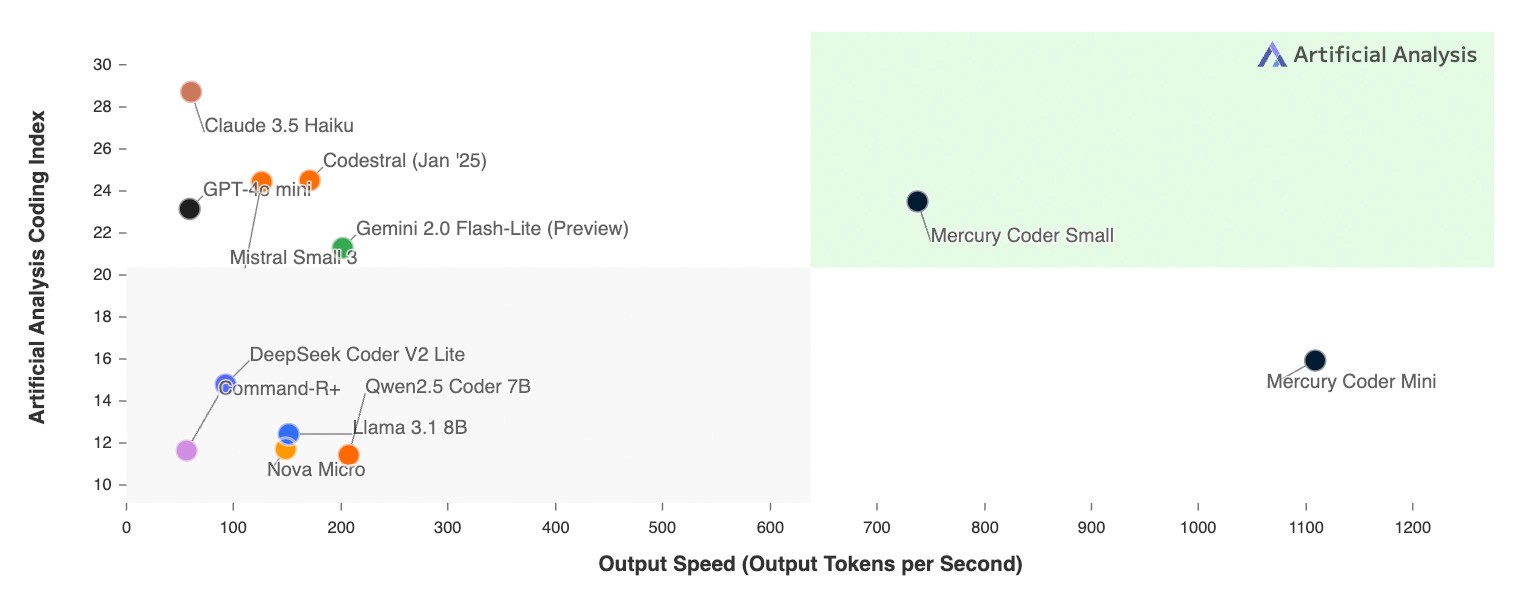

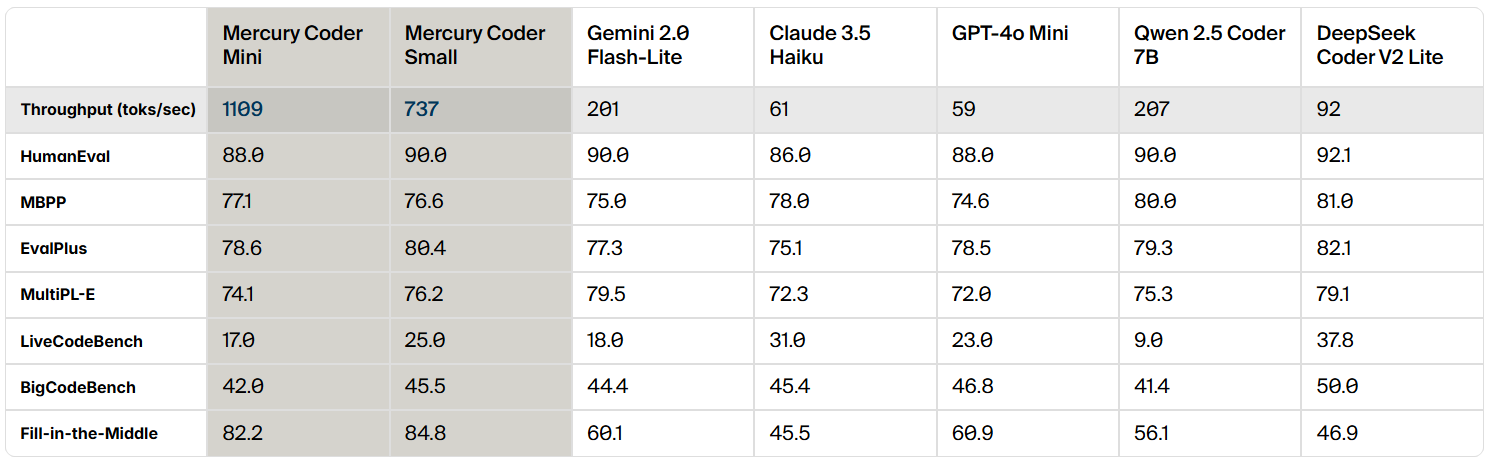

Mercury Coder ist eine dLLM, die für die Codegenerierung optimiert ist. In Standard-Code-Benchmark-Tests schneidet Mercury Coder bei einer Vielzahl von Benchmarks hervorragend ab und übertrifft oft den GPT-4o Mini und den Claude 3.5 Geschwindigkeitsoptimierte autoregressive Modelle wie Haiku sind ebenfalls bis zu 10 Mal schneller.

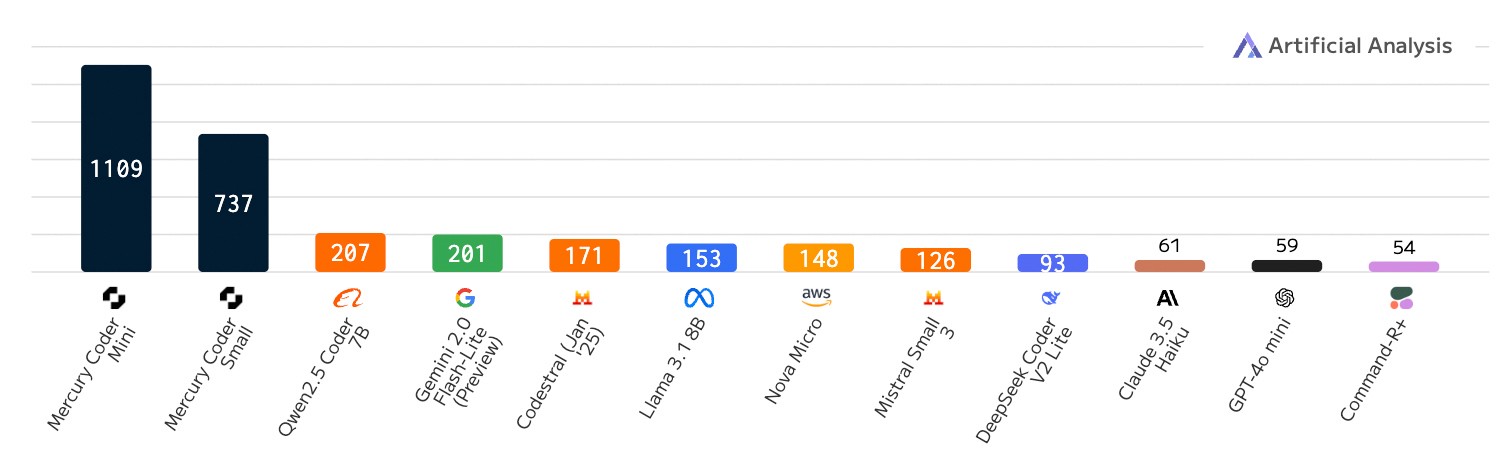

Das einzigartige Merkmal von dLLM ist seine unglaubliche Geschwindigkeit. Während selbst geschwindigkeitsoptimierte autoregressive Modelle mit maximal 200 Token/Sek. laufen, läuft Mercury Coder mit über 1000 Token/Sek. auf einem Allzweck-Grafikprozessor NVIDIA H100, was einer 5-fachen Beschleunigung entspricht. Mercury Coder ist sogar über 20 Mal schneller als einige Grenzmodelle, die mit weniger als 50 Token pro Sekunde laufen.

Bisher konnten nur dedizierte Hardware wie Groq, Cerebras und SambaNova Durchsätze wie dLLM erreichen. Die algorithmischen Verbesserungen von Mercury Coder und die Hardware-Beschleunigung gehen Hand in Hand, und auf schnelleren Chips steigen die Geschwindigkeitssteigerungen sogar noch weiter an.

Geschwindigkeitsvergleich: Anzahl der ausgegebenen Token pro Sekunde; Arbeitsbelastung beim Schreiben von Code

Noch spannender ist, dass Entwickler die Code-Vervollständigungsfunktion von Mercury Coder bevorzugen. In der Kopilot In den Arena-Benchmarks belegte Mercury Coder Mini den zweiten Platz und übertraf geschwindigkeitsoptimierte Modelle wie GPT-4o Mini und Gemini-1.5-Flash und erreichte sogar die Leistung von größeren Modellen wie GPT-4o. Gleichzeitig ist Mercury Coder auch das schnellste Modell, etwa viermal so schnell wie GPT-4o Mini.

Inception Labs lädt Sie ein, sich selbst von der Leistungsfähigkeit von Mercury Coder zu überzeugen: Inception Labs ist eine Partnerschaft mit Lambda Labs eingegangen. Spielplatz Die Plattform bietet Ihnen einen Testzugang zu Mercury Coder. Erleben Sie, wie Mercury Coder hochwertigen Code in einem Bruchteil der Zeit erzeugt, wie im folgenden Video gezeigt.

Was bedeutet das für KI-Anwendungen?

Frühe Anwender von Mercury dLLM, darunter Marktführer in den Bereichen Kundensupport, Codegenerierung und Unternehmensautomatisierung, wechseln erfolgreich vom standardmäßigen autoregressiven Basismodell zu Mercury dLLM als direktem Ersatz. Diese Umstellung schlägt sich direkt in einer besseren Benutzererfahrung und geringeren Kosten nieder. In latenzsensitiven Anwendungsszenarien mussten Partner in der Vergangenheit oft kleinere, weniger leistungsfähige Modelle wählen, um strenge Latenzanforderungen zu erfüllen. Dank der überragenden Leistung von dLLM können diese Partner nun größere, leistungsfähigere Modelle einsetzen und trotzdem ihre ursprünglichen Kosten- und Geschwindigkeitsanforderungen erfüllen.

Inception Labs bietet den Zugang zur Mercury-Modellfamilie sowohl über eine API als auch über eine lokale Bereitstellung. Mercury-Modelle sind vollständig kompatibel mit bestehender Hardware, Datensätzen und überwachten Feinabstimmungs- (SFT) und Ausrichtungsprozessen (RLHF).

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...