Hugging Face startet Agent Intelligence Body Rankings: Wer ist führend bei Tool Calling?

NVIDIA-CEO Jen-Hsun Huang hat KI-Intelligenzen als "digitale Arbeitskräfte" gepriesen, und er ist nicht der einzige führende Techniker, der diese Ansicht vertritt. Auch Microsoft-CEO Satya Nadella glaubt, dass die Technologie intelligenter Körper die Arbeitsweise von Unternehmen grundlegend verändern wird.

Die Fähigkeit dieser Intelligenzen, mit externen Tools und APIs zu interagieren, hat ihre Anwendungsszenarien erheblich erweitert. KI-Intelligenzen sind jedoch bei weitem nicht perfekt, und die Bewertung ihrer Leistung in realen Anwendungen ist aufgrund der Komplexität der möglichen Interaktionen eine Herausforderung.

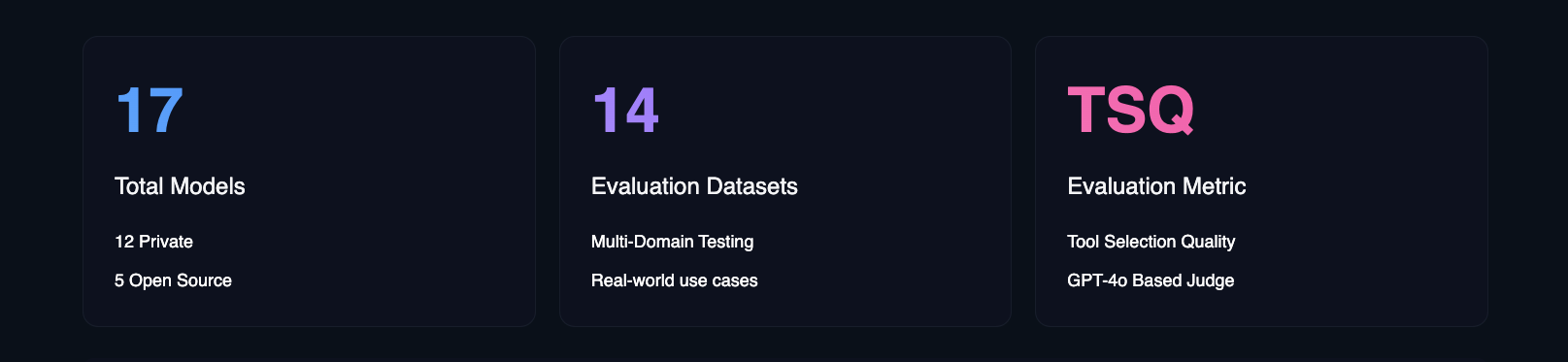

Um dieser Herausforderung zu begegnen, hat Hugging Face das Agent Intelligence Body Ranking eingeführt. Unter Verwendung der Galileo Tool Selection Quality (TSQ) Metrik bewertet das Leaderboard die Leistung verschiedener Large Language Models (LLMs) bei der Handhabung von werkzeugbasierten Interaktionen und bietet damit eine klare Referenz für Entwickler.

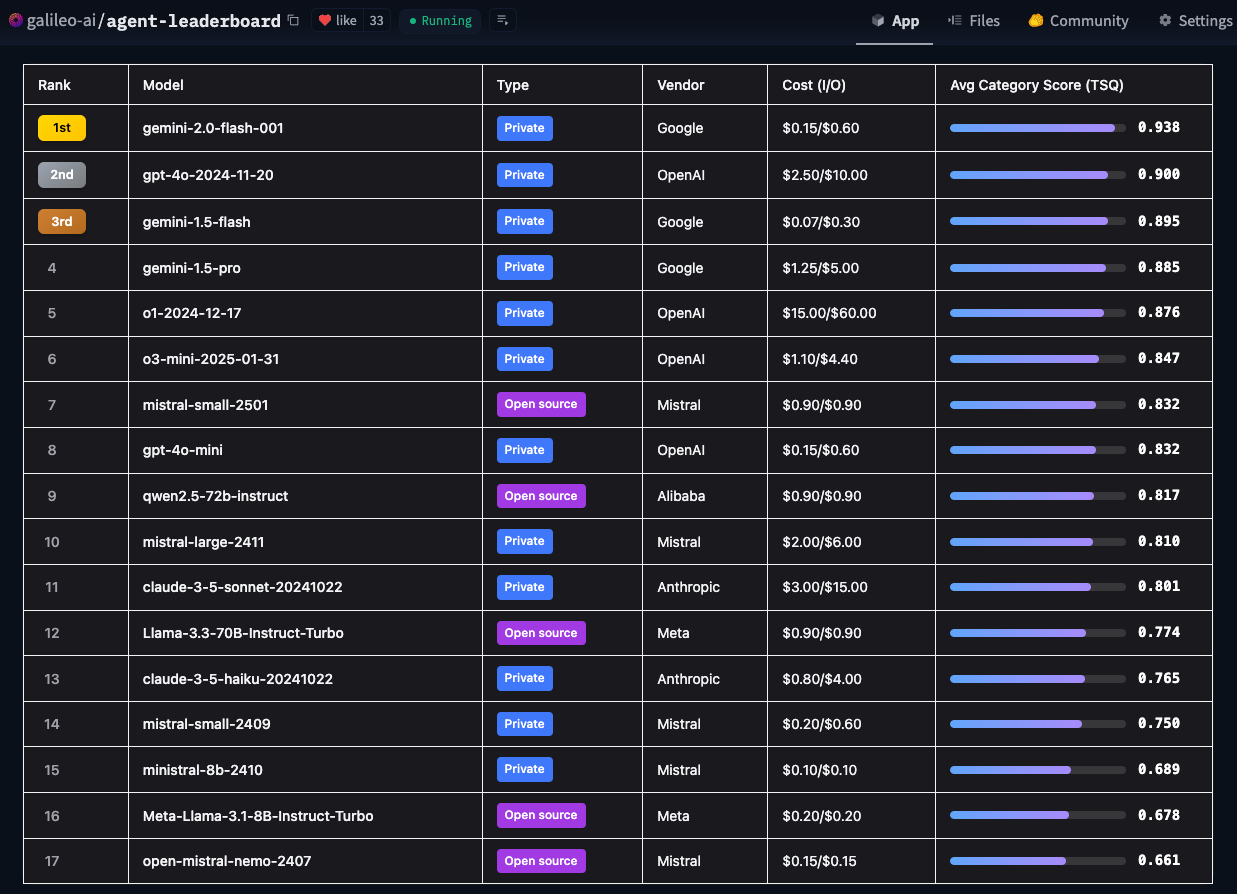

- Hugging Face Agent Intelligent Body Ranking

Hugging Face hat diese Rangliste erstellt, um die zentrale Frage zu beantworten: "Wie gut funktionieren KI-Intelligenzen tatsächlich in realen Geschäftsumgebungen?" Akademische Benchmarks sind wichtig, aber sie konzentrieren sich auf die technischen Fähigkeiten, während Hugging Face sich mehr damit beschäftigt, welche Modelle tatsächlich auf eine Vielzahl von realen Anwendungsfällen anwendbar sind.

Einzigartige Merkmale des Hugging Face Agent Intelligent Body Assessment Leaderboard

Derzeitige Mainstream-Evaluierungsrahmen konzentrieren sich in der Regel auf bestimmte Bereiche. So zeichnet sich BFCL beispielsweise durch akademische Bereiche wie Mathematik, Unterhaltung und Bildung aus; τ-bench konzentriert sich auf branchenspezifische Szenarien wie Einzelhandel und Fluggesellschaften; xLAM deckt 21 Datenerzeugungsbereiche ab; und ToolACE konzentriert sich auf API-Interaktionen in 390 Bereichen. Das Hugging Face Leaderboard ist insofern einzigartig, als es diese Datensätze zu einem umfassenden Bewertungsrahmen kombiniert, der eine größere Bandbreite an Bereichen und realen Anwendungsfällen abdeckt.

Durch die Integration von विविध Benchmarks und Testszenarien bieten die Leaderboards von Hugging Face nicht nur eine Bewertung der technischen Fähigkeiten eines Modells, sondern konzentrieren sich auch darauf, verwertbare Erkenntnisse darüber zu liefern, wie das Modell mit Grenzfällen und Sicherheitsüberlegungen umgeht. Hugging Face bietet auch Einblicke in verschiedene Faktoren wie Kosteneffizienz, Implementierungsrichtlinien und geschäftliche Auswirkungen - allesamt wichtige Faktoren für Unternehmen, die KI einsetzen wollen. Mit diesem Ranking hofft Hugging Face, Unternehmensteams dabei zu helfen, die KI-Modelle, die ihre spezifischen Anforderungen am besten erfüllen, genauer zu bestimmen und dabei die Einschränkungen von realen Anwendungen zu berücksichtigen.

Angesichts der Häufigkeit, mit der neue Large Language Models (LLM) veröffentlicht werden, plant Hugging Face, die Benchmarks der Bestenliste monatlich zu aktualisieren, um sicherzustellen, dass sie mit den sich schnell entwickelnden Modellierungstechnologien Schritt halten.

Wichtigste Ergebnisse

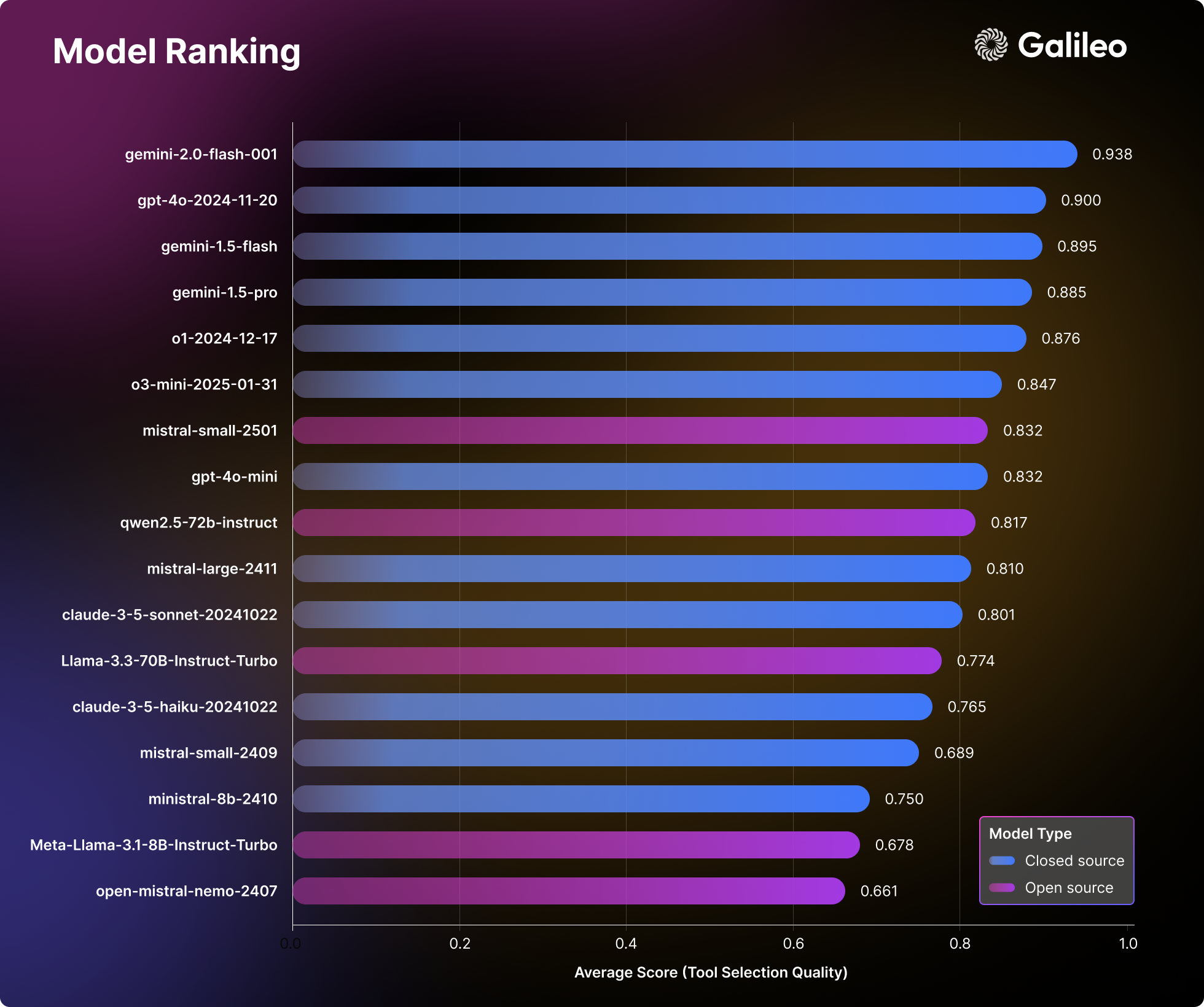

Die eingehende Analyse von 17 führenden Large Language Models (LLMs) durch Hugging Face offenbart interessante Muster in der Art und Weise, wie KI-Intelligenzen Aufgaben in der realen Welt angehen. Hugging Face führte umfassende Stresstests mit privaten und Open-Source-Modellen in 14 verschiedenen Benchmarks durch und bewertete dabei Dimensionen, die von einfachen API-Aufrufen bis zu komplexen Multi-Tool-Interaktionen reichen.

Große Sprachmodellierung (LLM) Rankings

Die Bewertungsergebnisse von Hugging Face stellen herkömmliche Vorstellungen von der Leistung von Modellen in Frage und bieten eine wertvolle praktische Referenz für Teams, die KI-Intelligenzen entwickeln.

Die wichtigsten Ergebnisse des Agent's Intelligent Body Rankings

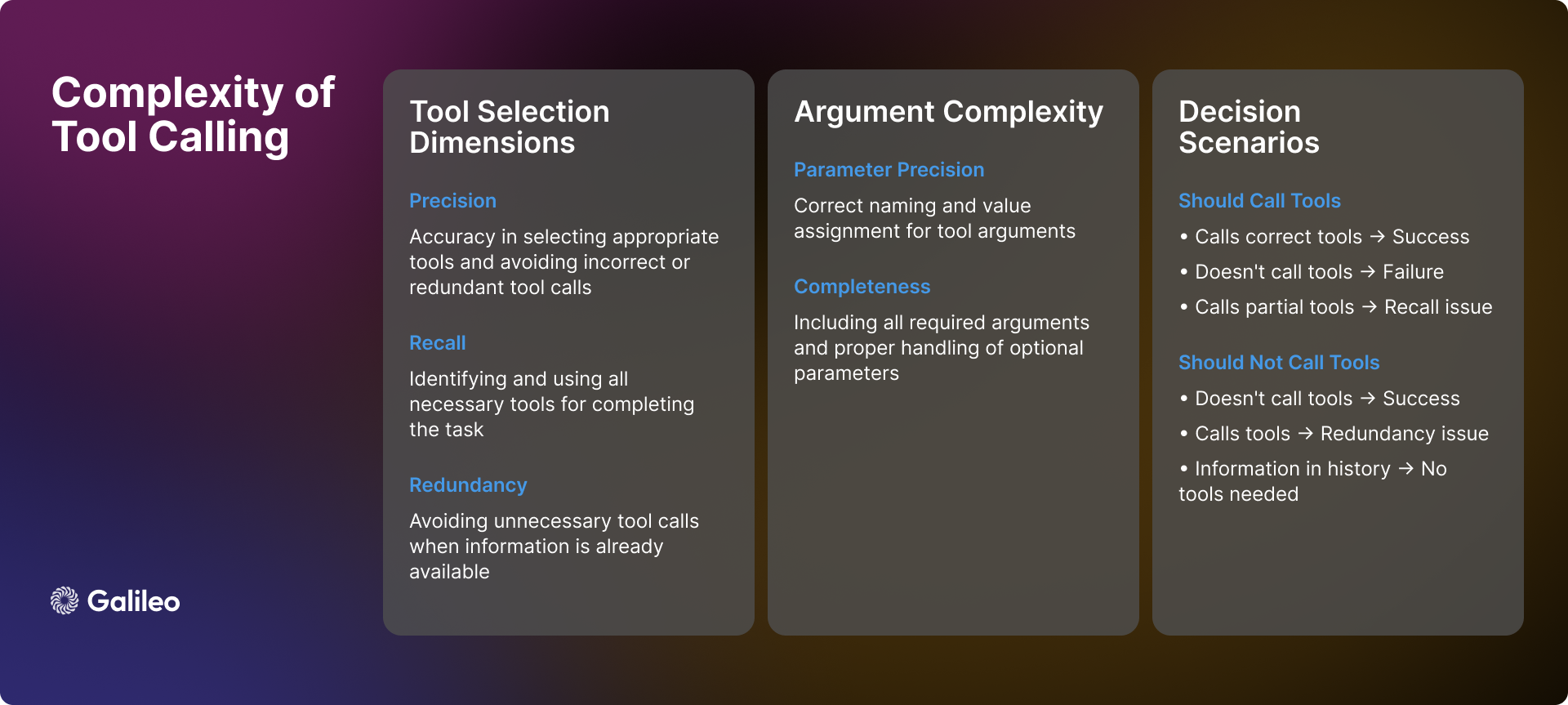

Komplexität der Werkzeugaufrufe

Die Komplexität des Tool-Aufrufs geht weit über einfache API-Aufrufe hinaus. In der Praxis sehen sich KI-Intelligenzen bei der Nutzung von Tools mit vielen komplexen Szenarien und Herausforderungen konfrontiert, die präzise Entscheidungen erfordern:

Szenenerkennung

Wenn ein intelligentes Organ eine Benutzeranfrage erhält, besteht seine erste Aufgabe darin, festzustellen, ob der Aufruf eines Werkzeugs erforderlich ist. Manchmal sind die benötigten Informationen bereits in der Dialoghistorie vorhanden, so dass der Aufruf eines Werkzeugs überflüssig ist. Außerdem kann es sein, dass die verfügbaren Werkzeuge nicht ausreichen, um das Problem des Benutzers zu lösen, oder dass sie für die Aufgabe selbst nicht relevant sind. In diesen Fällen müssen die Intelligenzen in der Lage sein, ihre Grenzen zu erkennen und dem Benutzer gegenüber ehrlich zu sein, anstatt die Verwendung ungeeigneter Werkzeuge zu erzwingen.

Dynamik der Werkzeugauswahl

Die Auswahl von Werkzeugen ist kein einfaches binäres "Ja" oder "Nein" Problem; es geht um Präzision und Wiedererkennung. Im Idealfall sollte eine intelligente Einrichtung in der Lage sein, alle notwendigen Werkzeuge genau zu identifizieren und gleichzeitig die Auswahl irrelevanter Werkzeuge zu vermeiden. Die Realität ist jedoch oft komplexer. Ein intelligentes Organ kann ein notwendiges Werkzeug richtig identifizieren, aber andere auslassen (unzureichende Erinnerung), oder es kann einige unnötige Werkzeuge falsch auswählen, aber die richtigen wählen (unzureichende Präzision). Keines dieser Szenarien ist optimal, aber sie stellen unterschiedliche Grade der Auswahlverzerrung dar.

Parametrisierung

Selbst wenn eine intelligente Stelle erfolgreich das richtige Werkzeug auswählt, kann die Verarbeitung der Parameter noch neue Herausforderungen mit sich bringen. Intelligente Stellen müssen:

- Geben Sie alle erforderlichen Parameter an und stellen Sie sicher, dass sie richtig benannt sind.

- Korrekter Umgang mit optionalen Parametern.

- Stellen Sie die Genauigkeit der Parameterwerte sicher.

- Formatieren Sie die Parameter entsprechend der spezifischen Spezifikation des Werkzeugs.

sequentielle Entscheidungsfindung

Für mehrstufige Aufgaben müssen die Intelligenzen fortgeschrittenere Entscheidungsfähigkeiten aufweisen:

- Bestimmen Sie die optimale Reihenfolge der Werkzeugaufrufe.

- Behandelt Abhängigkeiten zwischen Werkzeugaufrufen.

- Aufrechterhaltung der kontextuellen Kohärenz zwischen mehreren Vorgängen.

- Flexibilität, um auf örtlich begrenzte Erfolge oder Misserfolge zu reagieren.

Die oben beschriebene Komplexität zeigt deutlich, dass die Qualität der Werkzeugauswahl nicht als einfache Kennzahl betrachtet werden sollte. Stattdessen sollte sie als eine umfassende Bewertung der Fähigkeit von Intelligenzen betrachtet werden, komplexe Entscheidungen in realen Szenarien zu treffen.

Methodik

Der Bewertungsprozess von Hugging Face folgt einer systematischen Methodik, die eine umfassende und unvoreingenommene Bewertung der KI-Intelligenzen zum Ziel hat:

- Modellauswahl: Hugging Face hat sorgfältig eine Reihe von führenden Sprachmodellen ausgewählt, sowohl proprietäre als auch Open-Source-Implementierungen. Diese Auswahlstrategie zielt darauf ab, einen umfassenden Überblick über die aktuelle Technologielandschaft zu geben.

- Smart Body Konfiguration: Hugging Face konfiguriert jedes Modell als eine Intelligenz mit standardisierten Systemhinweisen und gewährt ihnen Zugang zu einem einheitlichen Satz von Werkzeugen. Durch diese standardisierte Konfiguration wird sichergestellt, dass die Leistungsabweichung die inhärenten Fähigkeiten des Modells widerspiegelt und nicht durch externe Faktoren wie z. B. Cue Engineering beeinflusst wird.

- Definition des Indikators: Hugging Face legt die Qualität der Werkzeugauswahl (TSQ) als zentrale Bewertungskennzahl fest und konzentriert sich auf die Korrektheit der Werkzeugauswahl und die Effektivität der Parameternutzung. Die TSQ-Metriken wurden mit Blick auf die Leistungsanforderungen in der Praxis entwickelt.

- Kuratierung von Datensätzen: Hugging Face erstellt einen ausgewogenen und bereichsübergreifenden Datensatz, indem es strategisch aus bestehenden ausgereiften Benchmark-Datensätzen Stichproben zieht. Der Datensatz testet umfassend die Fähigkeiten der Intelligenzen, von einfachen Funktionsaufrufen bis hin zu komplexen Interaktionen über mehrere Runden, um die Vollständigkeit der Bewertung zu gewährleisten.

- Punktesystem: Die endgültige Leistungsbewertung wird durch die Berechnung des Durchschnitts der gleichen Gewichtung aller Datensätze abgeleitet. Dieser Ansatz gewährleistet eine ausgewogene Bewertung und verhindert, dass eine einzelne Fähigkeit das Gesamtergebnis dominiert, wodurch die umfassende Leistung der Intelligenzen objektiver wiedergegeben wird.

Mit dieser strukturierten Bewertungsmethode will Hugging Face Erkenntnisse liefern, die direkt in reale Einsatzentscheidungen einfließen können.

Wie misst Hugging Face die Leistung einer Agent Intelligence?

Wie der Bewertungsrahmen funktioniert

Wie bereits erwähnt, erfordert die Bewertung von Werkzeugaufrufen zuverlässige Messungen in einer Vielzahl unterschiedlicher Szenarien. Hugging Face hat die Metrik "Qualität der Werkzeugauswahl" entwickelt, um die Leistung der Intelligenzen beim Einsatz von Werkzeugen zu bewerten, wobei die Genauigkeit der Werkzeugauswahl und die Effektivität der Verwendung von Parametern untersucht werden. Der Bewertungsrahmen wurde entwickelt, um festzustellen, ob die Intelligenzen die Werkzeuge angemessen nutzen, um Aufgaben zu erledigen, und um Situationen zu identifizieren, in denen der Einsatz von Werkzeugen unnötig ist.

Während des Bewertungsprozesses nutzte Hugging Face die Modelle GPT-4o und ChainPoll, um Entscheidungen zur Werkzeugauswahl zu bewerten. Für jede Interaktion sammelt Hugging Face mehrere unabhängige Beurteilungen, wobei die Endnote den Anteil der positiven Bewertungen darstellt. Jede Bewertung enthält eine detaillierte Erklärung, um die Transparenz des Bewertungsprozesses zu gewährleisten.

Das folgende Codebeispiel zeigt, wie die TSQ-Metriken verwendet werden, um die Leistung eines Large Language Model (LLM) auf einem Datensatz zu bewerten:

import promptquality as pq

import pandas as pd

file_path = "path/to/your/dataset.parquet" # 替换为你的数据集文件路径

project_name = "agent-leaderboard-evaluation" # 替换为你的项目名称

run_name = "tool-selection-quality-run" # 替换为你的运行名称

model = "gpt-4o" # 你想要评估的模型名称

tools = [...] # 你的工具列表

llm_handler = pq.LLMHandler() # 初始化 LLMHandler

df = pd.read_parquet(file_path, engine="fastparquet")

chainpoll_tool_selection_scorer = pq.CustomizedChainPollScorer(

scorer_name=pq.CustomizedScorerName.tool_selection_quality,

model_alias=pq.Models.gpt_4o,

)

evaluate_handler = pq.GalileoPromptCallback(

project_name=project_name,

run_name=run_name,

scorers=[chainpoll_tool_selection_scorer],

)

llm = llm_handler.get_llm(model, temperature=0.0, max_tokens=4000)

system_msg ={

"role":"system",

"content":'Your job is to use the given tools to answer the query of human. If there is no relevant tool then reply with "I cannot answer the question with given tools". If tool is available but sufficient information is not available, then ask human to get the same. You can call as many tools as you want. Use multiple tools if needed. If the tools need to be called in a sequence then just call the first tool.',

}

outputs = []

for row in df.itertuples():

chain = llm.bind_tools(tools)

outputs.append(

chain.invoke(

[system_msg,*row.conversation],

config=dict(callbacks=[evaluate_handler])

)

)

evaluate_handler.finish()

Warum hat Hugging Face das Large Language Model (LLM) für die Evaluierung von Toolaufrufen gewählt?

Die Bewertungsmethode auf der Grundlage des Large Language Model (LLM) ermöglicht eine umfassende Bewertung verschiedener komplexer Szenarien. Mit diesem Ansatz kann wirksam überprüft werden, ob die intelligente Stelle Situationen mit unzureichenden Kontextinformationen richtig gehandhabt hat, um festzustellen, ob weitere Informationen vom Benutzer erforderlich sind, bevor das Werkzeug eingesetzt werden kann. In Anwendungsszenarien mit mehreren Werkzeugen ist die Methode in der Lage zu überprüfen, ob der intelligente Körper alle notwendigen Werkzeuge identifiziert und in der richtigen Reihenfolge aufruft. In langen Kontextdialogen stellt die Methode sicher, dass der intelligente Körper relevante Informationen von früher in der Dialoghistorie vollständig berücksichtigt. Selbst in Fällen, in denen Werkzeuge fehlen oder nicht anwendbar sind, bestimmt die Bewertungsmethode, ob der intelligente Körper Werkzeugaufrufe korrekt vermeidet und somit unangemessene Aktionen vermeidet.

Um in der TSQ-Metrik zu glänzen, müssen KI-Intelligenzen ausgefeilte Fähigkeiten vorweisen, darunter die Auswahl des richtigen Werkzeugs bei Bedarf, die Bereitstellung präziser Parameter, die effiziente Koordinierung mehrerer Werkzeuge und das Erkennen von Szenarien, in denen der Einsatz von Werkzeugen unnötig ist. Wenn beispielsweise alle erforderlichen Informationen bereits in der Dialoghistorie vorhanden sind oder wenn kein geeignetes Tool zur Verfügung steht, ist es besser, das Tool zu vermeiden.

Bewertung der inhaltlichen Zusammensetzung des Datensatzes

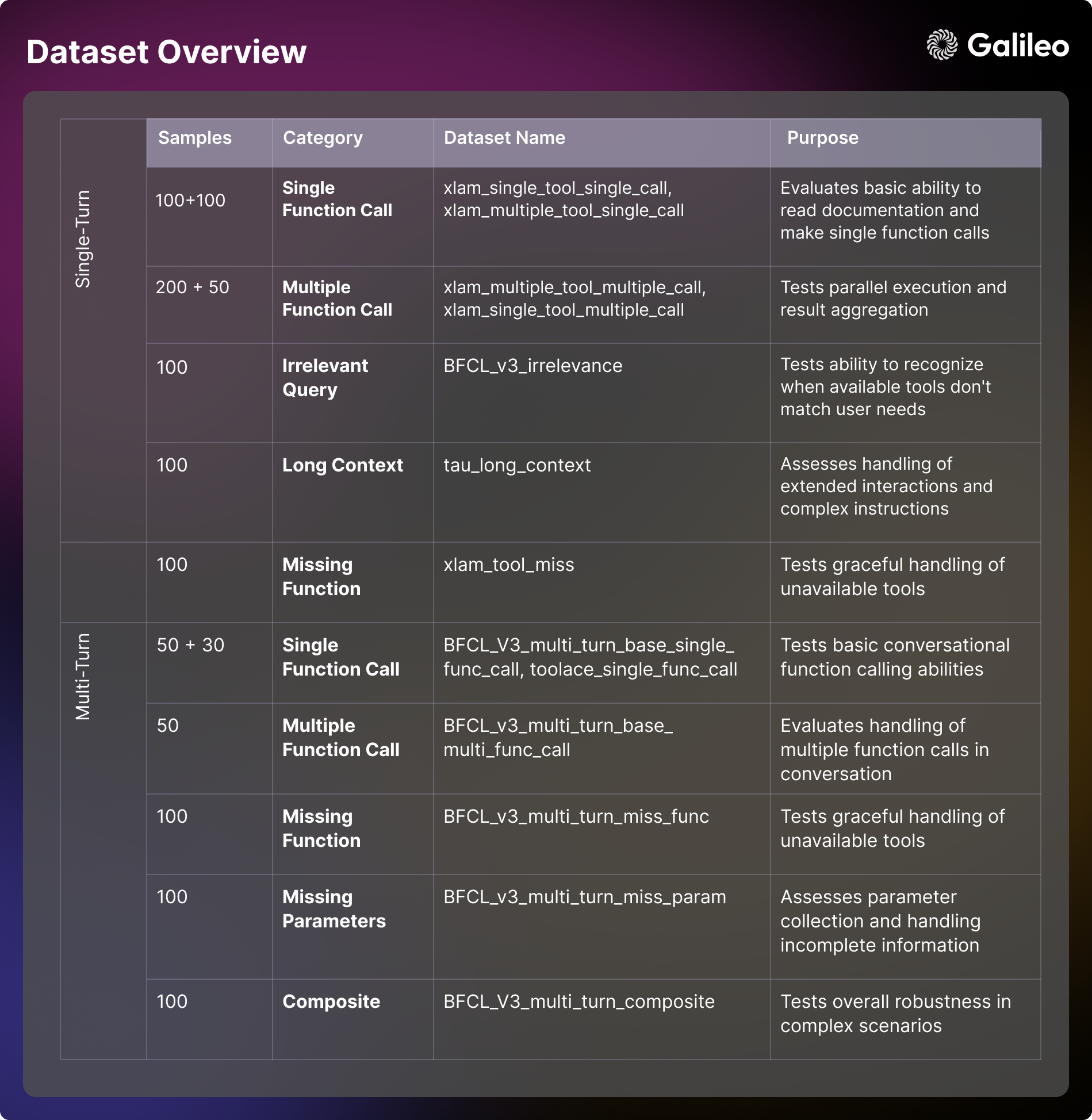

Der Bewertungsrahmen von Hugging Face verwendet eine Reihe von sorgfältig kuratierten Benchmark-Datensätzen, die aus dem BFCL (Berkeley Funktion Aufrufen Leaderboard (Berkeley Function Call Leaderboard), τ-bench (Tau-Benchmark), Xlam und ToolACE. Jeder Datensatz ist darauf ausgerichtet, die Fähigkeiten der Intelligenzen in einem bestimmten Aspekt zu testen. Das Verständnis dieser Bewertungsdimensionen ist sowohl für die Modellevaluierung als auch für die Entwicklung praktischer Anwendungen entscheidend.

Einzelschusskapazität

- Verwendung von Basiswerkzeugen Szenario: Konzentriert sich auf die Bewertung der Fähigkeit eines intelligenten Körpers, die Werkzeugdokumentation und Prozessparameter zu verstehen und grundlegende Funktionsaufrufe durchzuführen. Diese Dimension konzentriert sich auf die Untersuchung der Antwortformatierungs- und Fehlerbehandlungsfähigkeiten der Intelligenzen in direkten Interaktionen. Diese Fähigkeit ist entscheidend für einfache automatisierte Aufgaben in realen Anwendungen, wie z. B. das Setzen von Erinnerungen oder das Abrufen grundlegender Informationen [xlam_single_tool_single_call].

- Auswahl der Werkzeuge Szenario: Bewertet die Fähigkeit des Modells, das richtige Werkzeug aus mehreren Werkzeugoptionen auszuwählen. In dieser Dimension wird untersucht, inwieweit das Modell in der Lage ist, die Werkzeugdokumentation zu verstehen und eine begründete Entscheidung über die Eignung des Werkzeugs zu treffen. Für reale Anwendungsszenarien, in denen Mehrzweck-Intelligenzen gebaut werden, ist diese Fähigkeit entscheidend [xlam_multiple_tool_single_call].

- parallele Ausführung Szenario: Untersuchen Sie die Fähigkeit eines Modells, mehrere Werkzeuge zu programmieren, die gleichzeitig zusammenarbeiten. Diese Dimension ist entscheidend für die Verbesserung der Effizienz in realen Anwendungen [xlam_multiple_tool_multiple_call].

- Wiederverwendung von Werkzeugen Szenario: Bewertung der Fähigkeit der Intelligenzen, Stapelverarbeitungen und Parametervariationen effizient zu handhaben. Dieser Aspekt ist besonders wichtig für Stapelverarbeitungsszenarien in realen Anwendungen [xlam_single_tool_multiple_call].

Fehlerbehandlung und Randfälle

- Irrelevanztests Szenario: Die Fähigkeit eines Testmodells, die Grenzen von Werkzeugen zu erkennen und vernünftig zu kommunizieren, wenn die verfügbaren Werkzeuge nicht den Bedürfnissen der Benutzer entsprechen. Diese Fähigkeit ist ein Eckpfeiler für die Sicherstellung der Benutzererfahrung und der Systemzuverlässigkeit [BFCL_v3_irrelevance].

- Umgang mit fehlenden Werkzeugen Szenario: Untersuchen Sie, wie elegant das Modell mit der Situation umgeht, in der das benötigte Werkzeug nicht verfügbar ist, einschließlich der Fähigkeit, den Benutzer über seine Einschränkungen zu informieren und Alternativen anzubieten [xlam_tool_miss, BFCL_v3_multi_turn_miss_func].

Kontextmanagement (Computertechnik)

- langer Kontext Szenario: Bewertung der Fähigkeit eines Modells, die kontextuelle Kohärenz aufrechtzuerhalten und komplexe Anweisungen in Dialogen mit großer Reichweite zu verstehen. Diese Fähigkeit ist entscheidend für die Handhabung komplexer Workflows und langer Interaktionen [tau_long_context, BFCL_v3_multi_turn_long_context].

vielschichtige Interaktion

- Grundlegender Dialog Szenario: Testen Sie die Fähigkeit von Intelligenzen, konversationelle Funktionsaufrufe zu tätigen und den Kontext in einem Dialog mit mehreren Runden beizubehalten. Diese grundlegende Fähigkeit ist entscheidend für die Entwicklung interaktiver Anwendungen [BFCL_v3_multi_turn_base_single_func_call, toolace_single_func_call].

- komplexes Zusammenspiel Szenario: Kombinieren Sie mehrere Herausforderungen, um die allgemeine Robustheit und Problemlösungsfähigkeit von Intelligenzen in komplexen Szenarien umfassend zu testen [BFCL_v3_multi_turn_base_multi_func_call, BFCL_v3_multi_turn_composite].

Verwaltung der Parameter

- fehlender Parameter Szenario: Untersuchen Sie, wie das Modell mit Situationen umgeht, in denen Informationen unvollständig sind, und wie effektiv es mit dem Benutzer interagiert, um die notwendigen Parameter zu sammeln [BFCL_v3_multi_turn_miss_param].

Hugging Face hat den Datensatz offengelegt, um die Forschung und Anwendungsentwicklung in der Gemeinschaft zu erleichtern - Hugging Face Agenten-Rangliste Datensatz

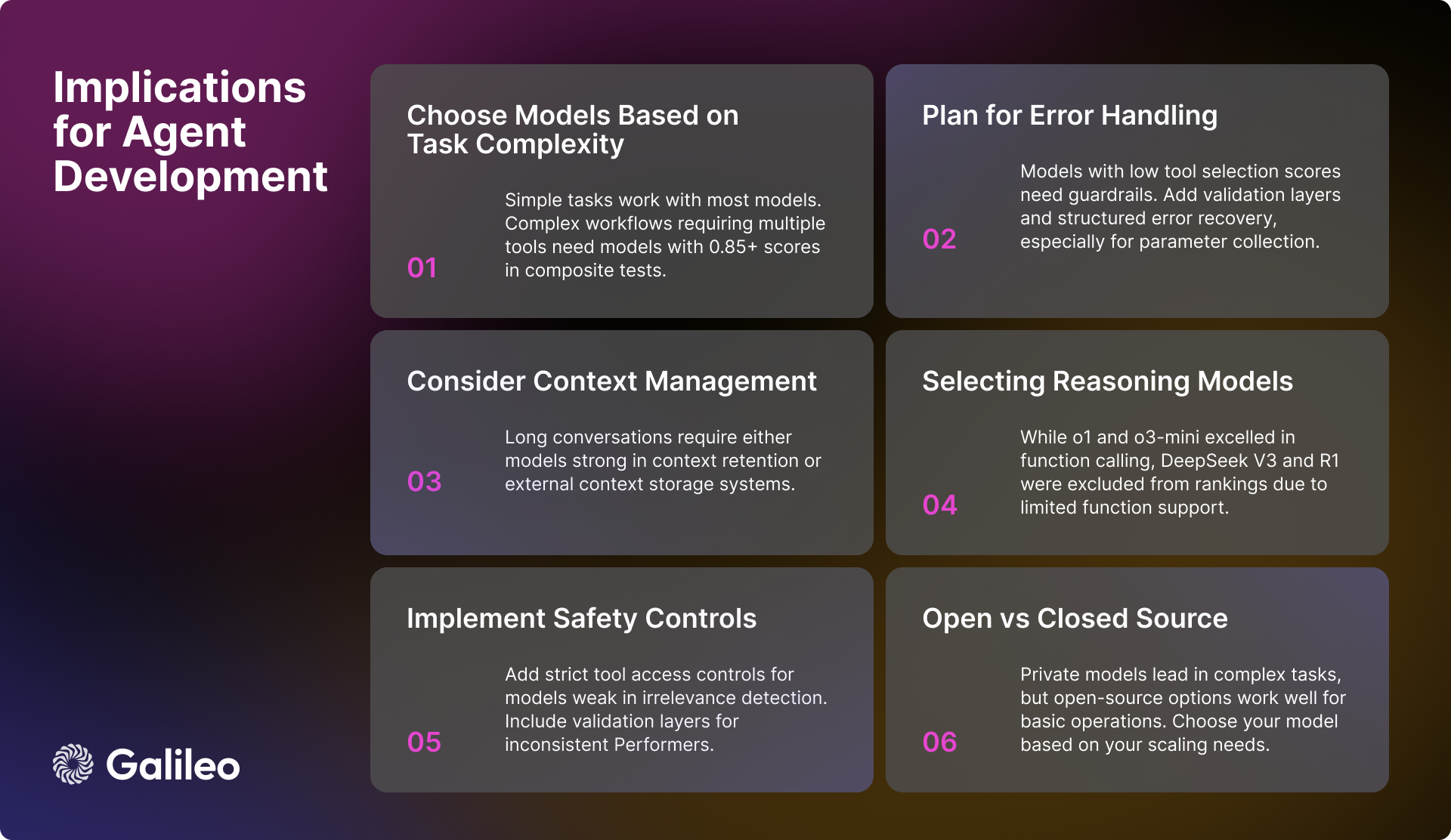

Praktische Auswirkungen für KI-Ingenieure

Die Ergebnisse der Bewertung von Hugging Face liefern viele wertvolle Erkenntnisse für KI-Ingenieure bei der Entwicklung von KI-Intelligenzen. Die folgenden Schlüsselfaktoren müssen bei der Entwicklung eines robusten und effizienten intelligenten Körpersystems berücksichtigt werden:

Modellauswahl und Leistung

Für Anwendungen, die komplexe Arbeitsabläufe bewältigen müssen, ist es entscheidend, leistungsstarke Modelle auszuwählen, die bei der zusammengesetzten Aufgabe einen Wert von über 0,85 erreichen. Zwar sind die meisten Modelle in der Lage, grundlegende Aufgaben zum Aufruf von Werkzeugen zu bewältigen, doch bei parallelen Operationen ist es wichtiger, sich auf die Ausführungsbewertung des Modells für eine bestimmte Aufgabe zu konzentrieren, als sich nur auf die Gesamtleistungskennzahlen zu verlassen.

Kontext- und Fehlermanagement

Für Modelle, die in Szenarien mit langem Kontext schlecht abschneiden, ist es von entscheidender Bedeutung, eine wirksame Strategie zur Zusammenfassung des Kontexts zu implementieren. Wenn Modelle mit Unzulänglichkeiten bei der Irrelevanzerkennung oder der Parameterverarbeitung ausgewählt werden, müssen robuste Mechanismen zur Fehlerbehandlung entwickelt werden. Für Modelle, die zusätzliche Unterstützung bei der Parametererfassung benötigen, kann ein strukturierter Arbeitsablauf in Betracht gezogen werden, der den Benutzer bei der Bereitstellung der erforderlichen Parameterinformationen anleitet.

Sicherheit und Zuverlässigkeit

Um zu gewährleisten, dass das System sicher und zuverlässig ist, ist es wichtig, eine strenge Zugangskontrolle für Werkzeuge einzuführen, insbesondere für Modelle, die bei der Erkennung irrelevanter Vorgänge nicht gut abschneiden. Bei Modellen mit unzureichender Leistungsstabilität sollten zusätzliche Überprüfungsebenen hinzugefügt werden, um die Gesamtzuverlässigkeit des Systems zu verbessern. Außerdem ist ein gut konstruiertes System zur Fehlerbehebung von entscheidender Bedeutung, vor allem bei Modellen, die mit fehlenden Parametern nicht zurechtkommen.

Optimierung der Systemleistung

Bei der Gestaltung der Workflow-Architektur des Systems sollten die unterschiedlichen Fähigkeiten der verschiedenen Modelle zur parallelen Ausführung und zur Bewältigung von Szenarien mit langem Kontext gebührend berücksichtigt werden. Bei der Implementierung einer Stapelverarbeitungsstrategie ist es wichtig, die Fähigkeit des Modells zur Wiederverwendung von Werkzeugen zu bewerten, da sich dies unmittelbar auf die Gesamteffizienz des Systems auswirkt.

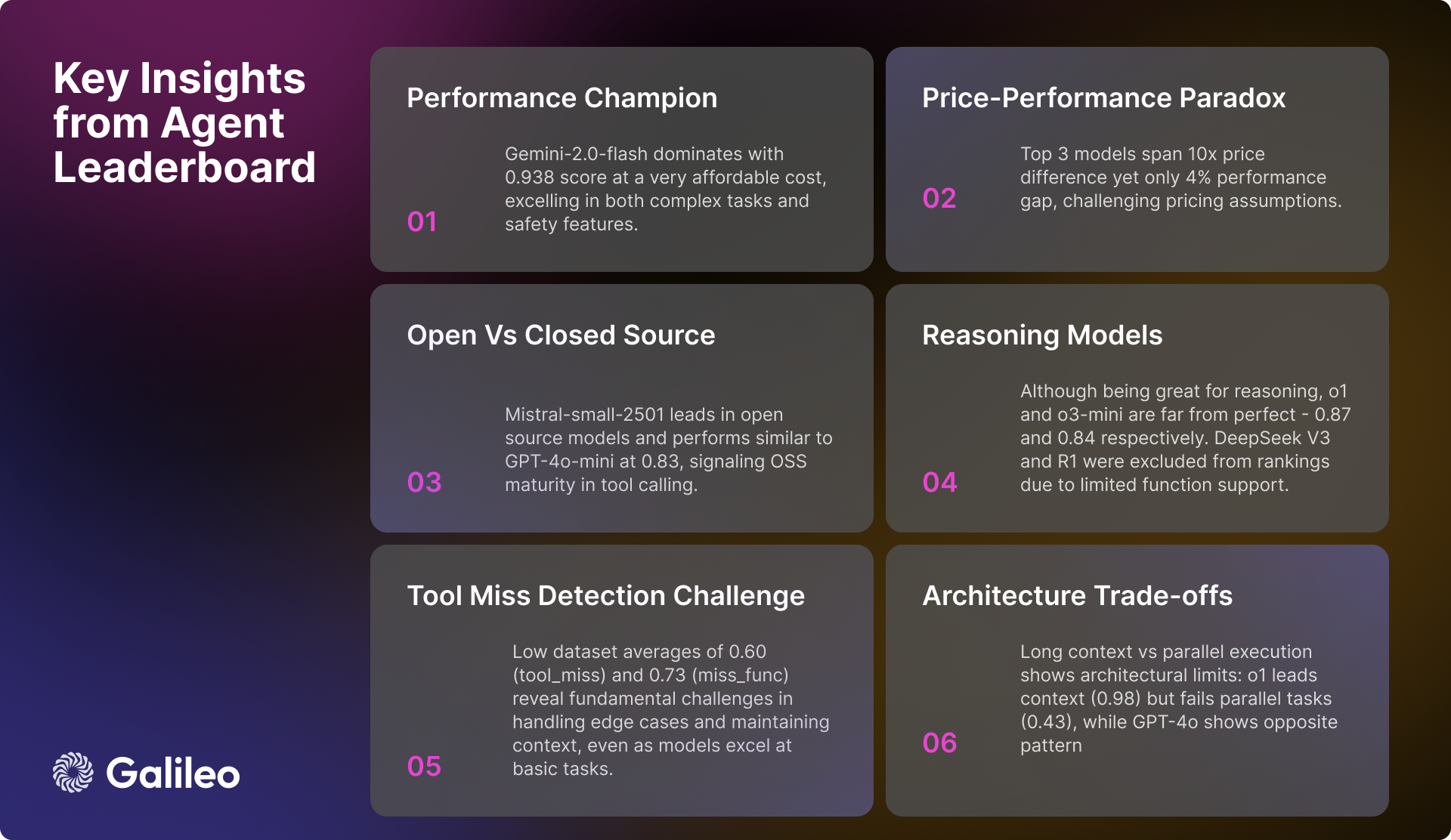

Aktueller Stand der Entwicklung von AI-Modellen

Während proprietäre Modelle derzeit noch die Nase vorn haben, verbessert sich die Leistung von Open-Source-Modellen rapide. Bei einfachen Interaktionsaufgaben mit Werkzeugen werden alle Arten von Modellen immer ausgereifter. Bei komplexen Interaktionen über mehrere Runden und bei Szenarien mit langem Kontext stehen die Modelle jedoch noch vor vielen Herausforderungen.

Die Variabilität der Modellleistung in verschiedenen Dimensionen macht deutlich, wie wichtig es ist, Modelle auf der Grundlage spezifischer Anwendungsfallanforderungen auszuwählen. Anstatt sich nur auf die generischen Leistungskennzahlen des Modells zu konzentrieren, sollten die Entwickler die tatsächliche Leistung des Modells in den angestrebten Anwendungsszenarien eingehend bewerten.

Hugging Face hofft, dass diese Liste von Agent Intelligentsia eine wertvolle Referenz für Entwickler darstellt.

Überblick über die Modellleistung

Inferenzmodell

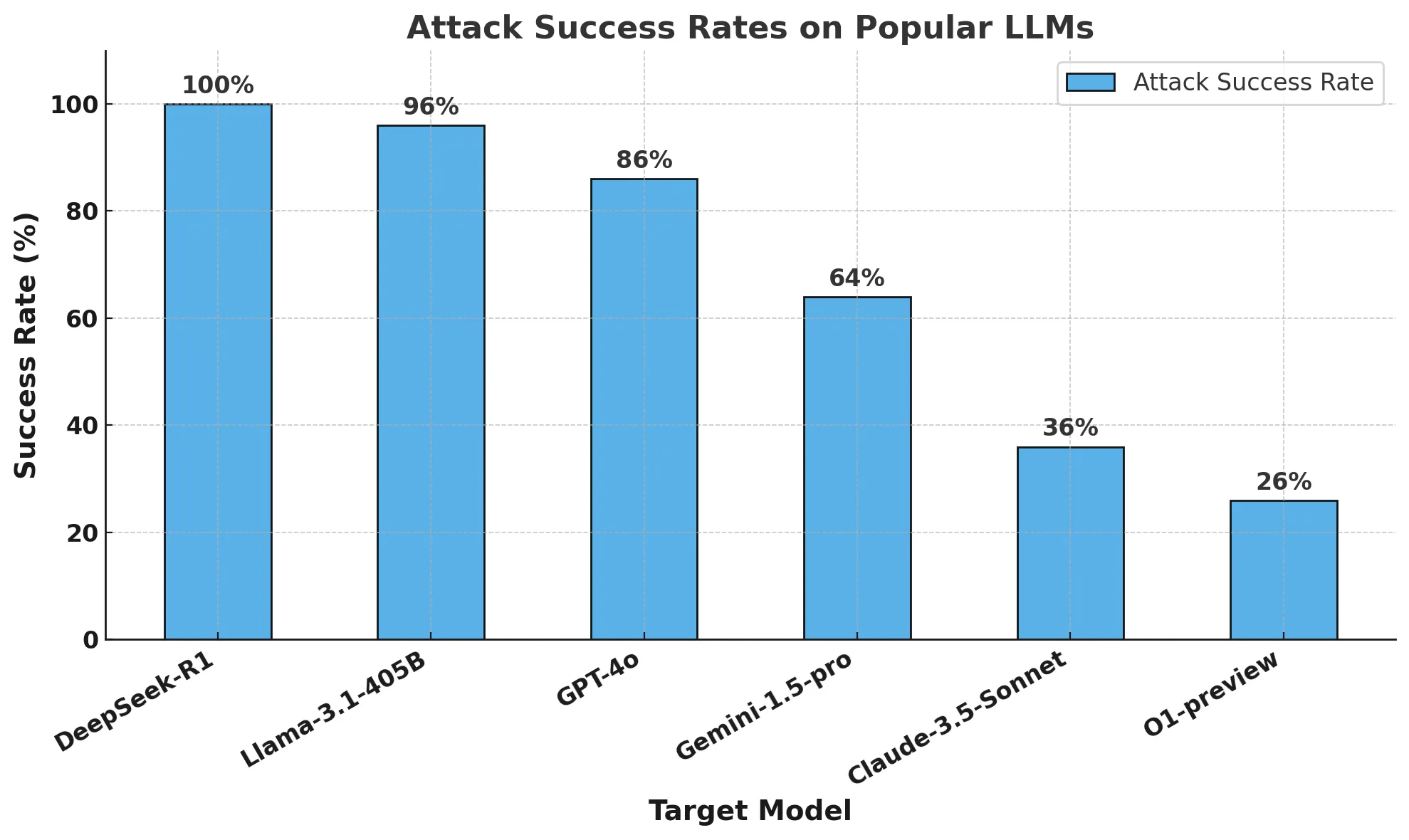

Ein interessantes Phänomen bei der Analyse von Hugging Face ist die Leistung des Inferenzmodells. Obwohl o1 im Gesang antworten o3-mini Während es bei der Integration der Funktionsaufrufe gut abschnitt und hohe Werte von 0,876 bzw. 0,847 erreichte, stieß Hugging Face bei anderen Inferenzmodellen auf einige Probleme. Genauer gesagt.DeepSeek V3 im Gesang antworten Tiefensuche R1 Die Modelle, die zwar in Bezug auf die Allzweckfähigkeiten bewundernswert sind впечатляющий, wurden aufgrund ihrer begrenzten Unterstützung für Funktionsaufrufe in der aktuellen Version von der Rangliste der Umarmungsgesichter ausgeschlossen.

Es ist zu betonen, dass es DeepSeek V3 im Gesang antworten Tiefensuche R1 Der Ausschluss aus der Rangliste bedeutet nicht, dass die überlegene Leistung dieser Modelle in Abrede gestellt wird, sondern ist vielmehr eine umsichtige Entscheidung, die in voller Kenntnis der veröffentlichten Einschränkungen der Modelle getroffen wurde. In der Deepseek V3 und Tiefensuche R1 In der offiziellen Diskussion über Hugging Face machten die Entwickler deutlich, dass die aktuellen Versionen dieser Modelle noch keine Funktionsaufrufe unterstützen. Hugging Face hat sich dafür entschieden, auf eine zukünftige Version mit nativer Funktionsaufrufunterstützung zu warten, anstatt zu versuchen, Workarounds zu entwickeln oder potenziell irreführende Leistungskennzahlen zu präsentieren.

Dieser Fall подчеркивает Funktionsaufrufe sind eine spezielle Funktion, die nicht alle leistungsstarken Sprachmodelle standardmäßig haben. Selbst Modelle, die sich beim Reasoning auszeichnen, unterstützen möglicherweise keine strukturierten Funktionsaufrufe, wenn sie nicht speziell dafür entwickelt und trainiert wurden. Eine gründliche Evaluierung des Modells für Ihren spezifischen Anwendungsfall wird daher sicherstellen, dass Sie die beste Wahl treffen.

Elite-Tier-Leistung (>= 0,9)

Zwilling-2.0-Blitz Das Modell ist weiterhin führend in der Rangliste mit einer hervorragenden Durchschnittsnote von 0,938. Das Modell weist eine ausgezeichnete Stabilität und Konsistenz in allen Bewertungskategorien auf, mit besonderen Stärken bei zusammengesetzten Szenarien (0,95) und der Erkennung von Irrelevanz (0,98). In Anbetracht seiner pro Million Token $0,15/$0,6 Preisgestaltung.Zwilling-2.0-Blitz Ein überzeugendes Gleichgewicht zwischen Leistung und Kosteneffizienz.

Dicht gefolgt von GPT-4oDas Modell erreichte eine hohe Punktzahl von 0,900 und schnitt bei komplexen Aufgaben wie der Verarbeitung mehrerer Werkzeuge (0,99) und der parallelen Ausführung (0,98) gut ab. Obwohl GPT-4o Der Preis ist mit 2,5 bzw. 10 Dollar pro Million Token deutlich höher, aber die überlegene Leistung des Unternehmens ist immer noch оправдывает für die höheren Kosten.

Hochleistungsband (0,85 bis 0,9)

Das Hochleistungssegment konzentriert sich auf eine Reihe von starken Modellen. Gemini-1.5-Blitz Die exzellente Note von 0,895 wird beibehalten, insbesondere bei der Erkennung von Unkorrelation (0,98) und der Leistung einzelner Funktionen (0,99). Gemini-1.5-pro Trotz des höheren Preises von $1,25/$5 pro Million Token erreichte es immer noch eine hohe Punktzahl von 0,885 und zeigte deutliche Stärken bei kombinierten Aufgaben (0,93) und der Ausführung mit einem einzigen Werkzeug (0,99).

o1 Trotz des höheren Preises von $15/$60 pro Million Token beweist das Modell seine Marktposition mit einer Punktzahl von 0,876 und einer branchenführenden Verarbeitungsleistung für langen Kontext (0,98). Aufstrebende Modelle o3-mini Es ist mit 0,847 wettbewerbsfähig, zeichnet sich durch einzelne Funktionsaufrufe (0,975) und Irrelevanzerkennung (0,97) aus und bietet mit einem Preis von $1,1/$4,4 pro Million Token eine ausgewogene Auswahl.

Mittlere Schichtkapazität (0,8 bis 0,85)

GPT-4o-mini hält eine effiziente Leistung von 0,832 aufrecht und schneidet besonders gut bei der parallelen Werkzeugnutzung (0,99) und der Werkzeugauswahl ab. Allerdings schneidet das Modell in Szenarien mit langem Kontext relativ schlecht ab (0,51).

Im Lager der Open-Source-Modellierer ist diemistral-klein-2501 Mit einer Punktzahl von 0,832 zeigt das Modell im Vergleich zur Vorgängerversion deutliche Verbesserungen sowohl bei der Verarbeitung langer Kontexte (0,92) als auch bei der Werkzeugauswahl (0,99). Qwen-72b Mit einer Punktzahl von 0,817 liegt es dicht dahinter und kann mit dem privaten Modell bei der Erkennung von Irrelevanz (0,99) mithalten und zeigt eine starke Verarbeitung von langem Kontext (0,92). Mistral-groß Gute Leistungen bei der Werkzeugauswahl (0,97), aber immer noch Probleme bei der Integration von Aufgaben (0,76).

Claude-sonnet erreichte eine Punktzahl von 0,801 und schnitt bei der instrumentellen Deletionserkennung (0,92) und der Verarbeitung einzelner Funktionen (0,955) am besten ab.

Basisschichtmodell (<0,8)

Die Modelle der Basisstufe umfassten in erster Linie Modelle, die in bestimmten Bereichen gut abschnitten, aber in Bezug auf die Gesamtpunktzahl relativ niedrig waren. Claude-Haiku Mit einer ausgewogenen Leistung von 0,765 und einem Preis von $0,8/$4 pro Million Token beweist es eine hohe Kosteneffizienz.

Open-Source-Modell Llama-70B weist ein Potenzial von 0,774 auf, insbesondere im Multi-Tool-Szenario (0,99). Während Mistral-klein (0.750), Mistral-8b (0,689) und Mistral-nemo (0,661) und andere kleinere Varianten des Modells bieten den Nutzern hingegen effiziente Optionen für grundlegende Aufgabenszenarien.

Diese Datensätze sind unerlässlich, um einen Rahmen für die umfassende Bewertung der Aufrufmöglichkeiten von Sprachmodellierungswerkzeugen zu schaffen.

Kommentare: Das von Hugging Face ins Leben gerufene Agent Intelligent Body Ranking trifft genau den Kernpunkt der aktuellen Big Language Model-Anwendung - die effiziente Nutzung von Tools. Lange Zeit lag das Augenmerk der Branche auf der Fähigkeit des Modells selbst, doch die Fähigkeit des Toolaufrufs ist der Schlüssel dafür, dass das Modell wirklich implementiert wird und reale Probleme lösen kann. Die Erstellung dieser Rangliste bietet Entwicklern zweifellos einen wertvollen Anhaltspunkt bei der Auswahl des am besten geeigneten Modells für ein bestimmtes Anwendungsszenario. Von der Bewertungsmethodik über die Erstellung des Datensatzes bis hin zur abschließenden Leistungsanalyse beweist der Bericht von Hugging Face seine rigorose und akribische Professionalität und spiegelt auch seine aktiven Bemühungen zur Förderung der Implementierung von KI-Anwendungen wider. Besonders lobenswert ist, dass sich das Ranking nicht nur auf die absolute Leistung der Modelle konzentriert, sondern auch die Leistung der Modelle in verschiedenen Szenarien analysiert, wie z. B. lange Kontextverarbeitung und Multi-Tool-Aufrufe, die in realen Anwendungen entscheidend sind. Darüber hinaus hat Hugging Face den Evaluierungsdatensatz großzügig als Open Source zur Verfügung gestellt, was zweifellos die Forschung und Entwicklung der Community im Bereich der Werkzeugaufrufe weiter fördern wird. Alles in allem ist dies ein sehr zeitgemäßes und wertvolles Unterfangen.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Verwandte Beiträge

Keine Kommentare...