Von neuronalen Netzen bis zum umarmenden Gesicht - eine kurze Geschichte der neuronalen Netze und des Deep Learning

TL;DR Dieser Artikel umfasst mehr als 8200 Wörter und dauert etwa 15 Minuten, um ihn vollständig zu lesen. Dieses Papier gibt einen kurzen Überblick über die neuesten Big-Model-Anwendungen von Wahrnehmungsmaschinen bis hin zum Deep Learning ChatGPT Die Geschichte des

Original: https://hutusi.com/articles/the-history-of-neural-networks

Im Leben gibt es nichts zu fürchten, nur Dinge zu verstehen.

-- Frau Curie

I Tiefe Vertrauensnetze

Im Jahr 2006 erforschte Jeffrey Hinton, Professor an der Universität von Toronto in Kanada, wie man mehrschichtige neuronale Netze trainiert, und er arbeitet seit mehr als drei Jahrzehnten im Stillen auf dem Gebiet der neuronalen Netze. Obwohl er als Titan auf diesem Gebiet gilt, wurden seine Forschungsergebnisse von der Industrie nicht ausreichend gewürdigt, weil neuronale Netze in der Branche der künstlichen Intelligenz unterschätzt wurden.

Hinton wurde in London, England, geboren. Seine Familie hat eine Reihe bedeutender Wissenschaftler hervorgebracht, und George Boole, der Logiker, der die Boolesche Algebra begründete, war sein Ururgroßvater. Sein Großvater war ein Wissenschaftsschriftsteller und sein Vater ein Entomologe. Hinton war schlauer als alle anderen um ihn herum, aber sein Weg durch die Schule war ein ziemlicher Kampf: Er studierte zunächst Architektur an der Universität, dann Physik, dann Philosophie und schloss schließlich mit einem BSc in Psychologie ab. 1972 ging Hinton an die Universität von Edinburgh, um im Bereich der neuronalen Netze zu promovieren, der damals weithin als das beliebteste Fachgebiet in der Branche galt. Zu dieser Zeit wurden neuronale Netze von der Industrie verachtet, und selbst Hintons Doktorvater war der Meinung, dass sie wenig praktischen Nutzen hätten und keine Zukunft hätten. Hinton ließ sich jedoch nicht beirren und glaubte an die Forschung auf dem Gebiet der neuronalen Netze. Er bestand darauf, dass er den Wert neuronaler Netze beweisen könne, worauf er mehr als 30 Jahre lang beharrte.

Hinton erlitt einen Bandscheibenvorfall in der Lendenwirbelsäule, als er als junger Mann einen Heizlüfter transportierte, und leidet seither an Problemen im unteren Rückenbereich. In den letzten Jahren hat sich das Problem verschlimmert, und die meiste Zeit muss er sich flach auf den Rücken legen, um die Schmerzen zu lindern. Das bedeutet, dass er nicht Auto fahren oder fliegen kann und auch nicht flach auf einem Klappbett in seinem Büro liegen kann, wenn er sich mit Studenten im Labor trifft. Die körperlichen Schmerzen trafen Hinton nicht annähernd so hart wie die Gleichgültigkeit gegenüber der akademischen Forschung. Bereits 1969 legte Minsky in seinem Buch Perceptual Machines das Gesetz über mehrschichtige Wahrnehmungsmaschinen fest und drückte damit der späteren Forschung an neuronalen Netzen einen Stempel auf: "Es wird keine Zukunft für mehrschichtige Wahrnehmungsmaschinen geben, weil niemand auf der Welt eine mehrschichtige Wahrnehmungsmaschine gut genug trainieren kann, um sie auch nur in die Lage zu versetzen, die einfachsten Funktionsweisen zu erlernen." Die begrenzte Fähigkeit einschichtiger Perzeptronen, die nicht einmal grundlegende Klassifizierungsprobleme wie "Heteroskedastizität" bewältigen können, und das Fehlen verfügbarer Trainingsmethoden für mehrschichtige Perzeptronen ist gleichbedeutend mit der Feststellung, dass die Forschung im Bereich der neuronalen Netze eine Sackgasse ist. Neuronale Netze galten in der Industrie als akademische Ketzerei, und niemand glaubte an ihren Erfolg. Daher achteten die Studenten bei der Wahl ihrer Betreuer darauf, neuronale Netze zu umgehen, und eine Zeit lang konnte Sinton nicht einmal genügend Doktoranden rekrutieren.

1983 erfand Hinton die Boltzmann-Maschine, und später wurde die vereinfachte eingeschränkte Boltzmann-Maschine auf das maschinelle Lernen angewandt und wurde zur Grundlage für die hierarchische Struktur tiefer neuronaler Netze. 1986 schlug Hinton den Fehler-Backpropagation-Algorithmus (BP) für mehrschichtige Wahrnehmungsmaschinen vor, einen Algorithmus, der die Grundlage für das spätere Deep Learning legte. Hinton erfand immer wieder etwas Neues, und er schrieb mehr als zweihundert Arbeiten über neuronale Netze, auch wenn sie nicht gut aufgenommen wurden. Bis 2006 hatte Hinton ein reichhaltiges theoretisches und praktisches Fundament angehäuft, und dieses Mal veröffentlichte er eine Arbeit, die das gesamte maschinelle Lernen, ja die ganze Welt verändern sollte.

Sinton fand heraus, dass neuronale Netze mit mehreren versteckten Schichten in der Lage sind, automatisch Merkmale für das Lernen zu extrahieren, was effektiver ist als traditionelles maschinelles Lernen mit manueller Merkmalsextraktion. Darüber hinaus kann die Schwierigkeit des Trainings mehrschichtiger neuronaler Netze durch schichtweises Vortraining verringert werden, wodurch das seit langem bestehende Problem des Trainings mehrschichtiger neuronaler Netze gelöst wird. Hinton veröffentlichte seine Ergebnisse in zwei Arbeiten zu einer Zeit, als der Begriff "neuronales Netz" von vielen Redakteuren akademischer Zeitschriften abgelehnt wurde, und einige Manuskripttitel wurden sogar zurückgegeben, weil sie das Wort "neuronales Netz" enthielten. Um die Empfindlichkeiten dieser Leute nicht zu irritieren, nahm Hinton einen neuen Namen an und nannte das Modell "Deep Belief Network" (Tiefes Vertrauensnetzwerk).

II. Sensoren

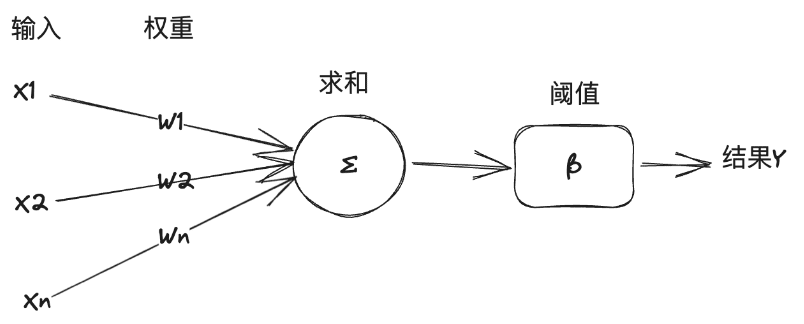

Die Forschung im Bereich der neuronalen Netze lässt sich bis in die 1940er Jahre zurückverfolgen. 1940 traf der 17-jährige Walter Pitts den 42-jährigen Professor Warren McCulloch an der University of Illinois in Chicago und schloss sich dessen Forschungsprojekt an: Er versuchte, mithilfe von Neuronennetzen ein mechanisches Modell des Gehirns auf der Grundlage logischer Operationen zu erstellen. Sie benutzten logische Operationen, um das Denkmodell des menschlichen Gehirns zu abstrahieren, und stellten das Konzept des "Neuronalen Netzes" (Neural Network) auf, wobei die Neuronen die kleinste informationsverarbeitende Einheit im neuronalen Netz sind; und sie abstrahierten und vereinfachten den Arbeitsprozess der Neuronen in ein sehr einfaches logisches Operationsmodell, das später als "M Das Modell wurde nach den Anfangsbuchstaben ihrer beiden Namen "M-P Neuron Model" genannt.

In diesem Modell empfängt ein Neuron eine Reihe von Eingangssignalen von anderen Neuronen, und die Bedeutung der Eingangssignale variiert von einem Neuron zum anderen, was durch das "Gewicht" der Verbindung dargestellt wird, und das Neuron summiert alle Eingänge in Übereinstimmung mit dem Gewicht und vergleicht das Ergebnis mit der "Schwelle" des Neurons, um zu entscheiden, ob das Signal ausgegeben werden soll. Das Neuron summiert alle Eingaben entsprechend den Gewichten und vergleicht das Ergebnis mit dem "Schwellenwert" des Neurons, um zu entscheiden, ob ein Signal an die Außenwelt ausgegeben werden soll oder nicht.

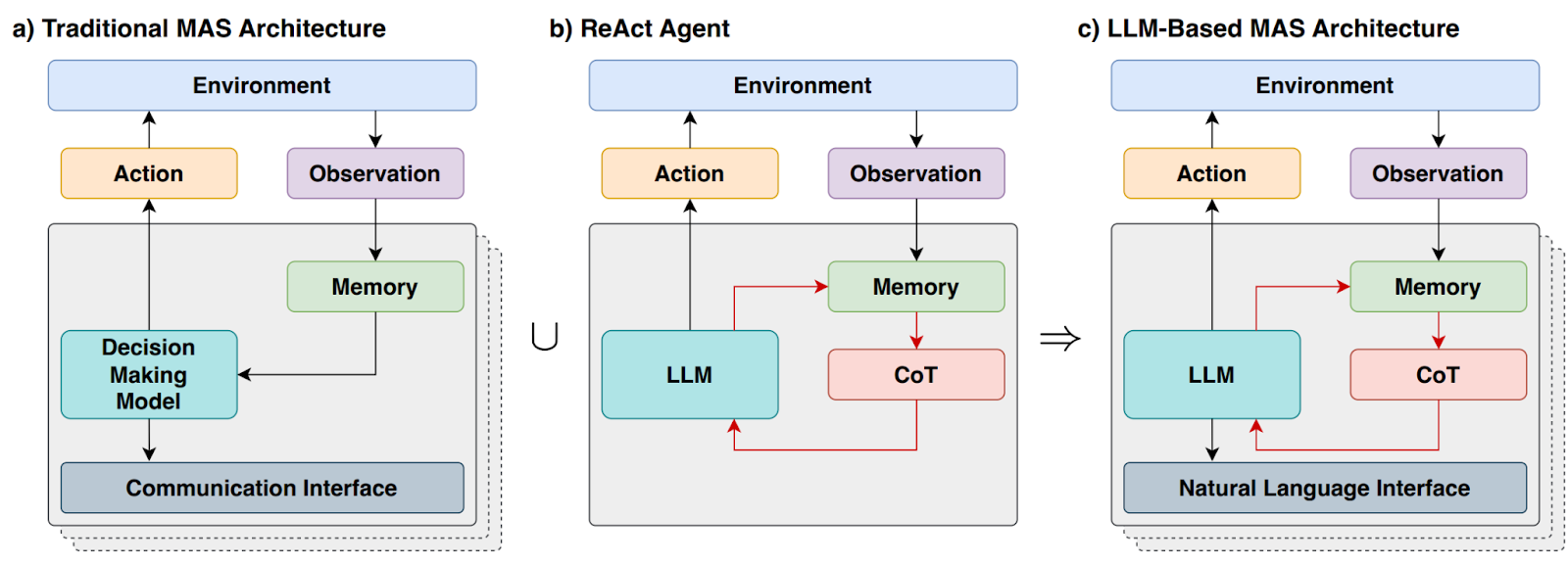

Das "M-P-Modell" ist einfach und unkompliziert genug, um mit symbolischer Logik modelliert zu werden, und KI-Experten haben es als Grundlage für den Aufbau neuronaler Netzmodelle zur Lösung von Aufgaben des maschinellen Lernens verwendet. Hier eine kurze Erläuterung der Beziehung zwischen künstlicher Intelligenz, maschinellem Lernen und Deep Learning: Künstliche Intelligenz ist der Einsatz von Computertechnologie, um menschliche Intelligenz zu erreichen, im allgemeinen Lehrbuch definiert als das Studium und die Konstruktion von intelligenten Agenten. Intelligente Agenten sind intelligente Agenten oder einfach Agenten, die spezifische Aufgaben oder allgemeine Aufgaben lösen, indem sie das menschliche Denken und die menschliche Kognition nachahmen. Intelligente Agenten, die charakteristische Aufgaben lösen, werden als schwache künstliche Intelligenz oder enge künstliche Intelligenz (ANI) bezeichnet, während intelligente Agenten, die allgemeine Aufgaben lösen, als starke künstliche Intelligenz oder allgemeine künstliche Intelligenz (AGI) bezeichnet werden. Maschinelles Lernen ist ein Zweig der KI, der aus Daten lernt und Systeme verbessert. Deep Learning hingegen ist ein weiterer Zweig des maschinellen Lernens, der neuronale Netzwerktechniken für das maschinelle Lernen verwendet.

1957 simulierte und implementierte Rosenblatt, Professor für Psychologie an der Cornell University, auf einem IBM-Computer ein neuronales Netzwerkmodell, das er Perceptron nannte. Sein Ansatz bestand darin, eine Reihe von Neuronen des M-P-Modells zusammenzustellen, die zum Trainieren und Ausführen einiger Aufgaben der maschinellen Bildverarbeitung zur Mustererkennung verwendet werden konnten. Im Allgemeinen gibt es beim maschinellen Lernen zwei Arten von Aufgaben: Klassifizierung und Regression. Bei der Klassifizierung geht es darum, zu bestimmen, welcher Klasse die Daten angehören, z. B. ob es sich bei einem Bild um eine Katze oder einen Hund handelt, während es bei der Regression um die Vorhersage von Daten aus anderen Daten geht, z. B. um die Vorhersage des Gewichts einer Person auf der Grundlage ihres Bildes. Perceptrons lösen lineare Klassifizierungsprobleme. Erläutern Sie dies anhand eines Beispiels für die Funktionsweise von Perceptron-Maschinen aus dem Buch "The Frontiers of Intelligence":

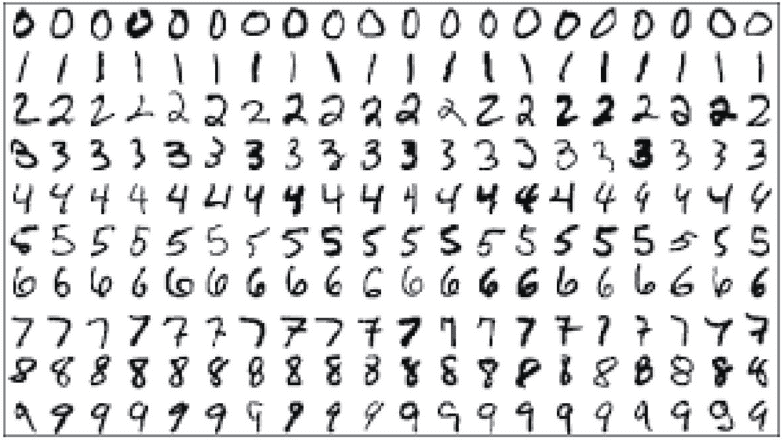

Angenommen, die Aufgabe besteht darin, arabische Ziffern automatisch zu erkennen. Die zu erkennenden Ziffern werden handgeschrieben oder in verschiedenen Formen gedruckt, die Ziffern werden durch Scannen in einer Bilddatei von 14*14 Pixeln Größe gespeichert. Zunächst wird für das maschinelle Lernen ein Trainingssatz ähnlich der folgenden Abbildung vorbereitet. Der Trainingssatz ist ein Datensatz, der speziell für das maschinelle Lernen bereitgestellt wird. Es handelt sich dabei nicht nur um einen Satz von Bildern und anderen Daten, sondern er wird manuell voretikettiert, um der Maschine mitzuteilen, um welche Zahlen es sich bei den Bilddaten handelt.

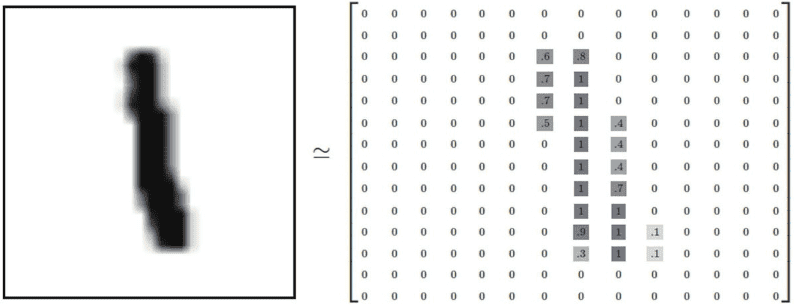

Dann müssen wir eine Datenstruktur entwerfen, damit die Maschine diese Bilder speichern und verarbeiten kann. Bei einem digitalen 14*14-Graustufenbild können die schwarzen Pixel durch 1, die weißen Pixel durch 0 und die Graustufenpixel zwischen Schwarz und Weiß durch eine Fließkommazahl zwischen 0 und 1 in Abhängigkeit von ihrer Graustufenintensität dargestellt werden. Wie in der folgenden Abbildung dargestellt, kann dieses Bild in ein zweidimensionales Tensor-Array umgewandelt werden:

Und die Maschine ist in der Lage zu erkennen, um welche Zahlen es sich auf dem Bild handelt, indem sie hauptsächlich die Merkmale des Bildes findet, die eine bestimmte Zahl darstellen. Für Menschen ist es einfach, diese handgeschriebenen Zahlen zu erkennen, aber es ist schwierig für uns zu erklären, was diese Merkmale sind. Das Ziel des maschinellen Lernens ist es, die Merkmale dieser Bilder in der Trainingsmenge zu extrahieren, die Zahlen darstellen, und nach dem M-P-Modell besteht die Art und Weise, die Merkmale zu extrahieren, darin, die Werte der einzelnen Pixel des Bildes zu gewichten und zu summieren und das Gewicht jedes Pixels, das jeder Zahl entspricht, auf der Grundlage der Ergebnisse der Übereinstimmung zwischen den Beispielbildern in der Trainingsmenge und den kommentierten Daten zu berechnen: Wenn ein bestimmtes Pixel eine sehr negative Evidenz dafür hat, dass das Bild nicht zu einer Zahl gehört Wenn ein Pixel eine sehr negative Evidenz dafür hat, dass das Bild nicht zu einer bestimmten Zahl gehört, wird das Gewicht dieses Pixels auf einen negativen Wert für diese Zahl gesetzt, im Gegenteil, wenn ein Pixel eine sehr positive Evidenz dafür hat, dass das Bild zu einer bestimmten Zahl gehört, wird das Gewicht dieses Pixels auf einen positiven Wert für diese Zahl gesetzt. Zum Beispiel sollte für die Zahl "0" das Pixel in der Mitte des Bildes kein schwarzes (1) Pixel haben, wenn es erscheint, dann gehört das Bild zur Zahl 0 als negativer Beweis, es reduziert die Wahrscheinlichkeit, dass das Bild die Zahl 0 ist. Auf diese Weise kann nach dem Training und der Kalibrierung des Datensatzes die Gewichtsverteilung jedes Pixels, das jeder Zahl 0-9 entspricht, als 14*14 (=196) ermittelt werden.

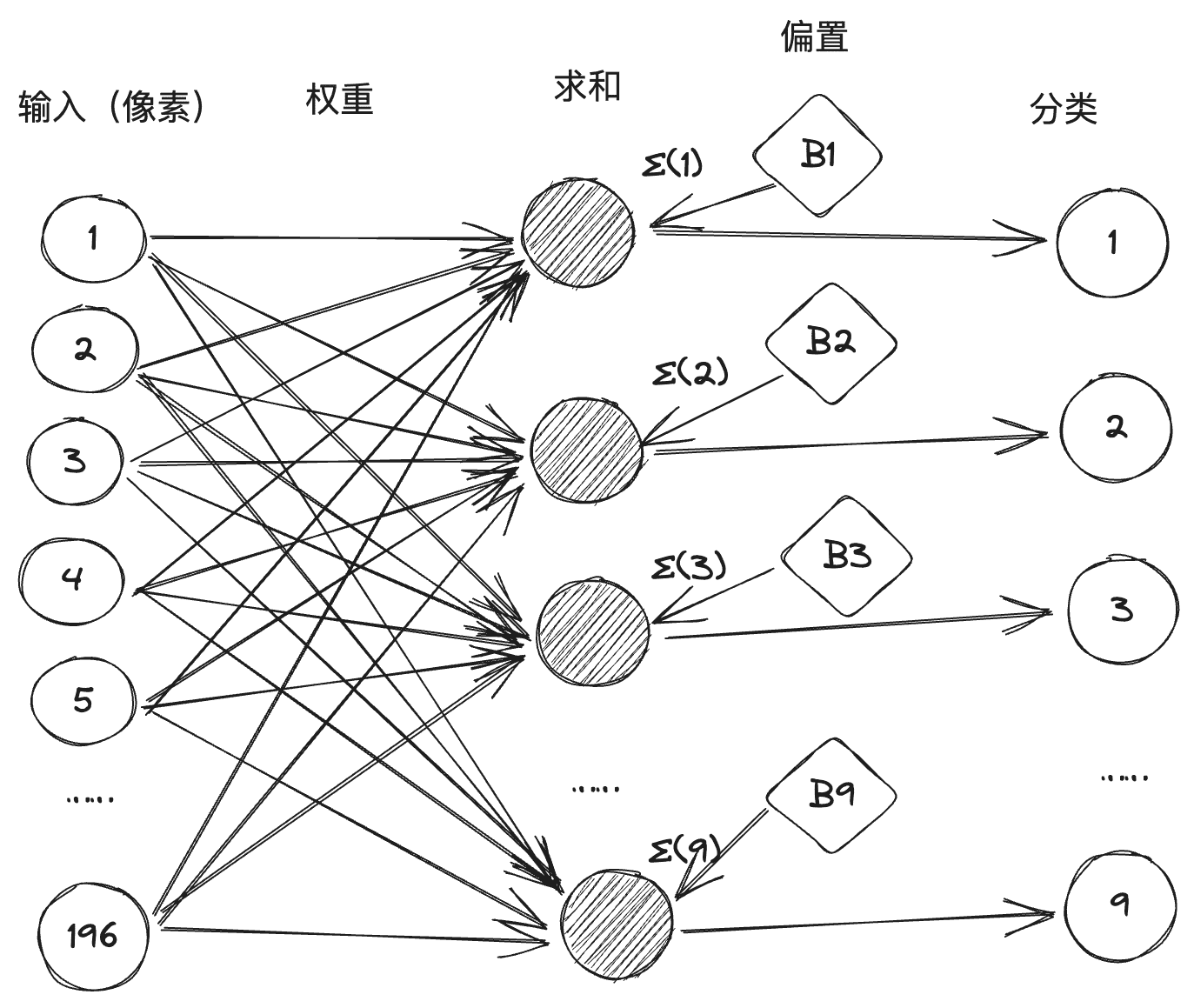

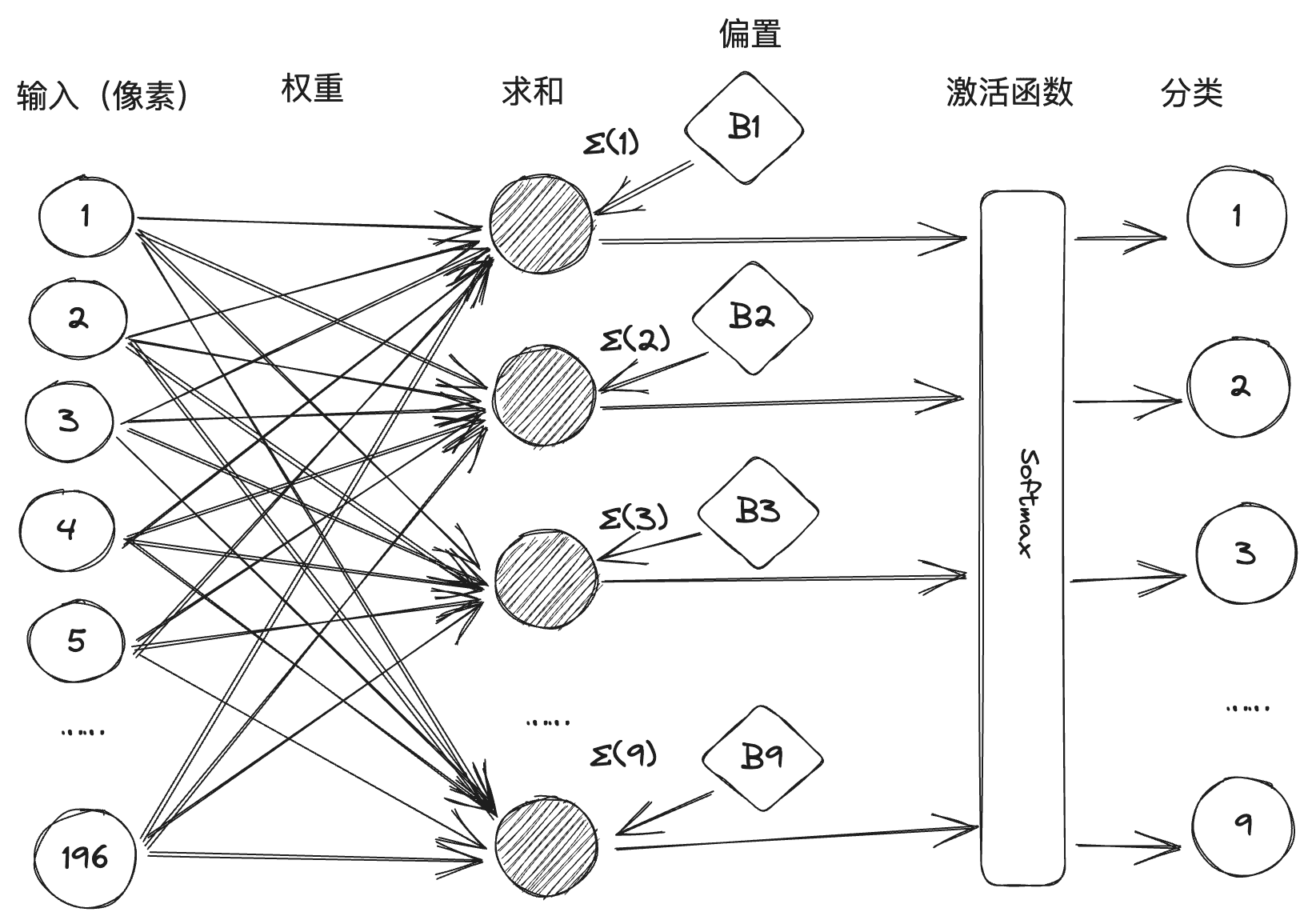

Wir wandeln dann den Klassifizierungsprozess jeder Zahl in ein M-P-Neuron um, jedes Neuron hat 196 Pixeleingänge, und der Gewichtswert zwischen jedem Eingang und diesem Neuron wird durch Training erhalten, so dass es ein neuronales Netzwerk darstellt, das aus 10 Neuronen, 196 Eingängen und 1.960 Verbindungslinien mit Gewichten vor ihnen besteht, wie unten gezeigt: (Im Allgemeinen wird in einem neuronalen Netzwerk der Schwellenwert in eine Vorspannung umgewandelt, die als einer der Summationsterme bezeichnet wird, um den arithmetischen Prozess zu vereinfachen).

In der Praxis gibt es jedoch bei einigen handschriftlichen Schriftarten Mehrdeutigkeiten, die dazu führen können, dass zwei oder mehr Neuronen nach der gewichteten Summierung aktiviert werden. Softmax ist eine Aktivierungsfunktion, die den Summationswert verarbeitet, um die numerische Klassifizierung mit kleiner Wahrscheinlichkeit zu verhindern und die numerische Klassifizierung mit großer Wahrscheinlichkeit zu verbessern.

Rosenblatt machte die weltweit erste Hardware-Perzeptron "Mark-1" zwei Jahre später, das Perzeptron kann das englische Alphabet zu identifizieren, aber zu dieser Zeit verursachte es eine große Sensation. Das US-Verteidigungsministerium und die Navy Militär auch bemerkt, und gab eine Menge finanzieller Unterstützung, Rosenblatt auf die Wahrnehmung der Maschine das Vertrauen hat seinen Höhepunkt erreicht, und sogar ein Reporter fragte: "Es gibt keine Wahrnehmung der Maschine nicht tun können, Dinge", Rosenblatt Antwort ist "Liebe, Hoffnung, Verzweiflung! Rosenblatts Antwort war "Liebe, Hoffnung, Verzweiflung". Rosenblatts Ruhm wuchs, und seine extravagante Persönlichkeit führte dazu, dass er sich überall Feinde machte, von denen der berühmteste ein anderer Gigant der künstlichen Intelligenz war, Marvin Minsky. Minsky war der Organisator der Dartmouth-Konferenz und einer der Begründer der künstlichen Intelligenz. 1969 veröffentlichte er sein Buch Perceptual Machines (Wahrnehmungsmaschinen), in dem er die Schwachstellen von Wahrnehmungsmaschinen klar benannte. Zum einen zeigte er mathematisch auf, dass Wahrnehmungsmaschinen nicht mit nichtlinearen Klassifizierungsproblemen wie Heteroskedastizität umgehen können, und zum anderen demonstrierte er, dass die Komplexität mehrschichtiger Wahrnehmungsmaschinen ohne eine geeignete Trainingsmethode zu einer dramatischen Ausweitung der verbundenen Daten führt. Minsky gewann im Jahr der Veröffentlichung des Buches den vierten Turing Award, und das immense Prestige seines Urteils über Wahrnehmungsmaschinen verurteilte die Forschung an neuronalen Netzen zum Tode. Der Konnektionismus erhielt eine Tracht Prügel, und die symbolistische Forschung wurde zum Mainstream in der KI.

Auf dem Gebiet der künstlichen Intelligenz gibt es zwei große Denkschulen: den Konnektivismus und den Symbolismus, ähnlich wie die Schwert- und die Qi-Sekte in Kampfsportromanen, die seit langem miteinander konkurrieren. Der Konnektivismus entwickelt KI, indem er dem menschlichen Gehirn nachempfunden wird, um neuronale Netze aufzubauen, Wissen in einer großen Anzahl von Verbindungen zu speichern und auf der Grundlage von Daten zu lernen. Der Symbolismus hingegen ist der Ansicht, dass Wissen und Schlussfolgerungen durch Symbole und Regeln dargestellt werden sollten, d. h. durch eine große Anzahl von "Wenn-dann"-Regeldefinitionen, um Entscheidungen und Schlussfolgerungen zu generieren, und entwickelt KI auf der Grundlage von Regeln und Logik. Ersteres wird durch neuronale Netze und letzteres durch Expertensysteme repräsentiert.

III. Tiefes Lernen

Mit dem Scheitern der Wahrnehmungsmaschine gingen die staatlichen Investitionen in den Bereich der KI zurück, und die KI trat in ihre erste Winterperiode ein. Und in den 1980er Jahren wurde der Symbolismus, vertreten durch Expertensysteme, zum Mainstream der KI und löste die zweite Welle der KI aus, während die Forschung an neuronalen Netzen in der Kälte stand. Wie bereits erwähnt, gibt es nur eine Person, die noch immer an diesem Thema festhält, nämlich Geoffrey Hinton.

Auf der Grundlage seiner Vorgänger erfand Sinton sukzessive die Boltzmann-Maschine und den Algorithmus zur Fehlerrückverfolgung. Sintons bahnbrechende Beiträge auf dem Gebiet der neuronalen Netze brachten Leben in das Feld, obwohl der Mainstream auf dem Gebiet der künstlichen Intelligenz von den 1980er Jahren bis zum Beginn des Jahrhunderts noch die Wissensbasis und die statistische Analyse war, und die verschiedenen Techniken der neuronalen Netze begannen sich durchzusetzen, mit repräsentativen Beispielen wie den Convolutional Neural Networks (CNNs), den Long Short-term Memory Netze (LSTM), usw. Im Jahr 2006 schlug Hinton Deep Belief Networks vor, die die Ära des Deep Learning einleiteten.

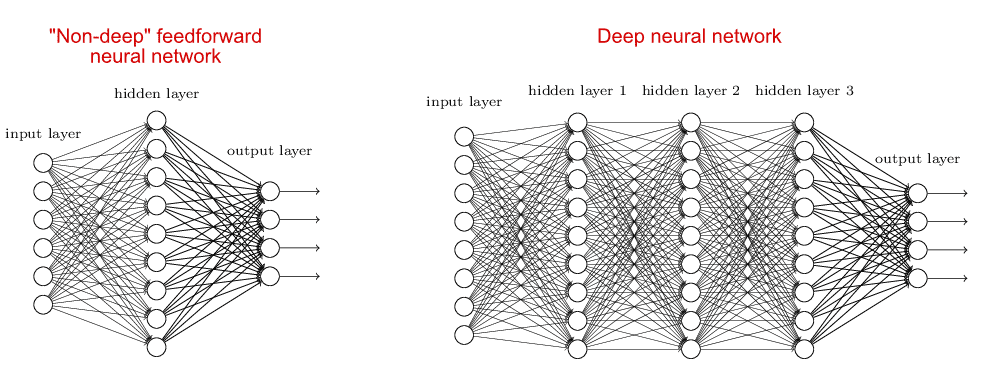

Das Modell des neuronalen Netzes, das dem tiefen Lernen entspricht, wird als tiefes neuronales Netz bezeichnet, das sich von den flachen neuronalen Netzen unterscheidet. Bei flachen neuronalen Netzen gibt es im Allgemeinen nur eine verborgene Schicht (oder mittlere Schicht) sowie Eingabe- und Ausgabeschichten, also insgesamt drei Schichten. Tiefe neuronale Netze hingegen haben mehr als eine verborgene Schicht, was einen Vergleich der beiden Arten von neuronalen Netzen ermöglicht:

Der Grund dafür, dass man sich vor dem Deep Learning auf flache neuronale Netze konzentriert hat, liegt darin, dass mit der Zunahme der Anzahl der Schichten des neuronalen Netzes die Schwierigkeit des Trainings zunimmt, da es einerseits an ausreichender arithmetischer Unterstützung mangelt und andererseits kein guter Algorithmus vorhanden ist. Das von Hinton vorgeschlagene Deep Belief Network löst dieses Trainingsproblem, indem es einen Fehler-Backpropagation-Algorithmus verwendet und Schicht für Schicht vortrainiert. Nach dem Deep Belief Network wird das Deep Neural Network zum Mainstream-Modell des maschinellen Lernens. Die derzeit beliebten Modelle GPT, Llama und andere große Modelle bestehen aus einem oder mehreren Deep Neural Networks.

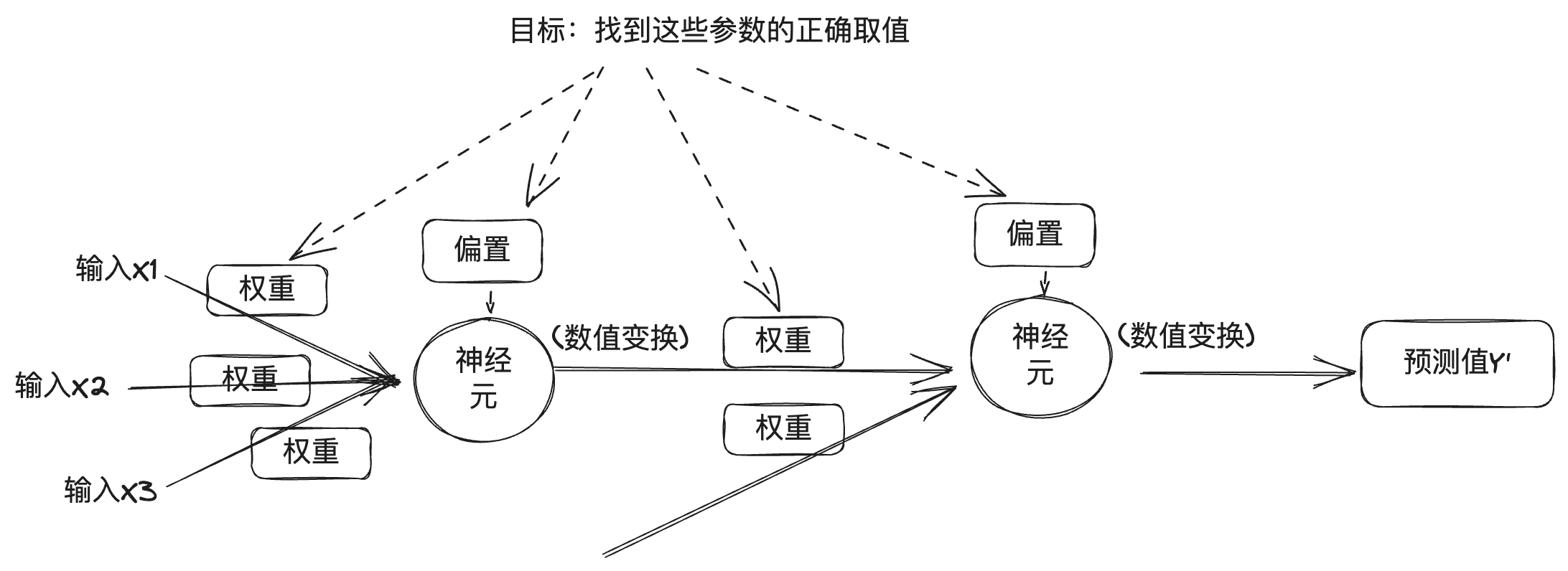

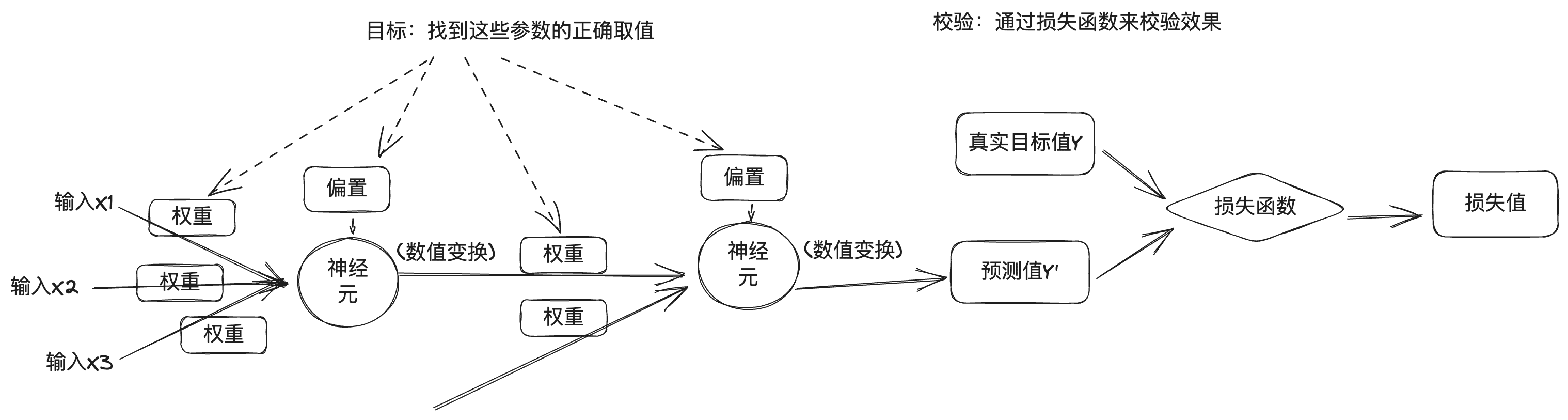

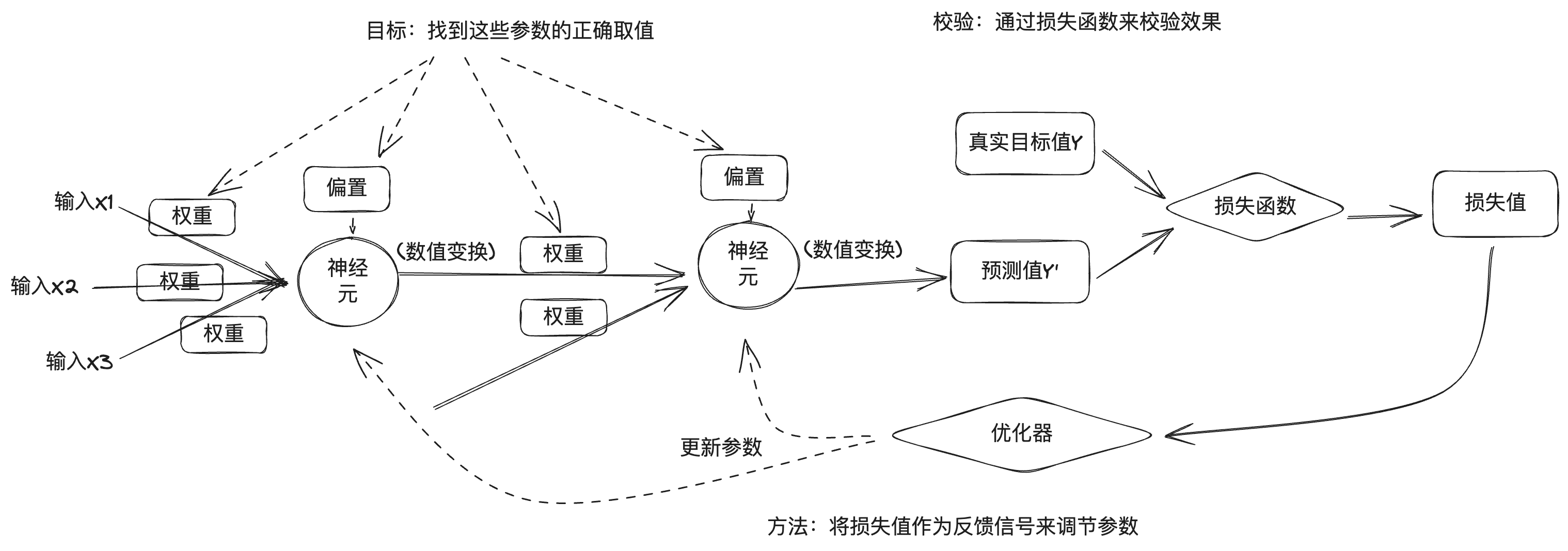

Zum Verständnis des tiefen neuronalen Netzes können Sie sich auf die Einführung des Prinzips der Wahrnehmungsmaschine oben beziehen, das tiefe neuronale Netz wird als eine Kombination mehrerer Neuronen in mehreren Schichten betrachtet, und aus dem vorherigen Abschnitt können Sie verstehen, dass das Ausgangsergebnis jeder Schicht mit dem Gewicht, der Vorspannung und der Aktivierungsfunktion zusammenhängt, und der Ausgang des tiefen neuronalen Netzes ist auch mit der Anzahl der Schichten und anderen numerischen Werten verbunden. In tiefen neuronalen Netzen können diese Werte in zwei Kategorien unterteilt werden: Die eine ist die Anzahl der Schichten, die Aktivierungsfunktion, der Optimierer usw., die als Hyperparameter bekannt sind und vom Ingenieur festgelegt werden; die andere ist die Gewichtung und die Vorspannung, die als Parameter bekannt sind und während des Trainingsprozesses von tiefen neuronalen Netzen automatisch ermittelt werden, und den richtigen Parameter zu finden ist der Zweck des tiefen Lernens.

Das Problem ist jedoch, dass ein tiefes neuronales Netz eine große Anzahl von Parametern enthält und die Änderung eines Parameters das Verhalten der anderen beeinflusst, so dass es schwierig ist, die richtigen Werte für diese Parameter zu finden. Um die richtigen Werte für die Parameter zu finden und die Modellausgabe genau zu gestalten, brauchen wir eine Möglichkeit, die Lücke zwischen der Modellausgabe und der gewünschten Ausgabe zu messen. Daher wird das Deep Learning-Training mithilfe einer Verlustfunktion gemessen, die auch als Zielfunktion oder Kostenfunktion bezeichnet wird. Die Verlustfunktion gibt an, wie gut oder schlecht das Modell des neuronalen Netzes bei dieser Trainingsstichprobe ist, indem der vorhergesagte Wert des tiefen neuronalen Netzes mit dem wahren Zielwert verglichen wird, um den Verlustwert zu erhalten.

Der Deep Learning-Ansatz verwendet die Verlustwerte als Rückkopplungssignale zur Feinabstimmung der Parameter, um die Verlustwerte für das aktuelle Trainingsprogramm zu reduzieren. Diese Feinabstimmung wird durch einen Optimierer erreicht, der Optimierungsalgorithmen wie den Gradientenabstieg implementiert, um die Parameter der Neuronenknoten in jeder Schicht durch Backpropagation zu aktualisieren.

Zu Beginn werden die Parameter des neuronalen Netzes nach dem Zufallsprinzip zugewiesen, eine Reihe von Trainingsdaten wird eingegeben, und nachdem die vorhergesagte Ausgabe des Netzes durch die Eingabeschicht und die verborgene Schicht zur Ausgabeschicht gelangt ist, wird der Verlustwert entsprechend der Verlustfunktion berechnet, was dem Prozess der Vorwärtsfortpflanzung entspricht; dann wird ausgehend von der Ausgabeschicht der Gradient der Parameter in umgekehrter Richtung entlang jeder Schicht bis zur Eingabeschicht berechnet, und die Parameter des Netzes werden unter Verwendung des Optimierungsalgorithmus auf der Grundlage des Gradienten aktualisiert, was dem Prozess der Rückwärtsfortpflanzung entspricht . Bei jedem Stapel von Trainingsmustern, die das neuronale Netz verarbeitet, werden die Parameter in die richtige Richtung feinabgestimmt und die Verlustwerte verringert, was als Trainingszyklus bezeichnet wird. Eine ausreichende Anzahl von Trainingszyklen führt zu Parametern, die die Verlustfunktion minimieren, was zu einem guten neuronalen Netzmodell führt.

Natürlich ist der eigentliche Deep-Learning-Prozess viel komplexer als dieser, daher hier nur ein kurzer Überblick über den allgemeinen Prozess.

Im Jahr 2012 leitete Hinton zwei seiner Studenten, Alex Krizhevsky und Ilya Sutskever, bei der Entwicklung des neuronalen Netzwerks AlexNet an, das am ImageNet-Bilderkennungswettbewerb teilnahm und die Meisterschaft mit einer viel höheren Genauigkeitsrate als der Zweitplatzierte gewann. Hinton und seine Studenten gründeten dann DNNResearch, Inc., um sich auf tiefe neuronale Netzwerke zu konzentrieren. Im Winter 2012 fand am Lake Tahoe an der Grenze zwischen den USA und Kanada eine geheime Auktion statt: Gegenstand der Auktion war die kürzlich gegründete DNNResearch, und die Käufer waren Google, Microsoft, DeepMind und Baidu. Am Ende, als Google und Baidu den Preis noch in die Höhe trieben, brach Hinton die Auktion ab und entschied sich für den Verkauf an Google für 44 Millionen Dollar. 2014 schnappte sich Google DeepMind. 2016 besiegte AlphaGo, das eine Kombination aus klassischer Monte-Carlo-Baumsuche und tiefen neuronalen Netzen verwendet, Lee Sedol und besiegte im darauffolgenden Jahr die Nummer 1 der Weltrangliste, Ke Jie, und AlphaGo erweiterte die Grenzen der künstlicher Intelligenz und Deep Learning auf ein neues Niveau.

Vier Hauptmodelle

Im Jahr 2015 trafen sich Musk, Greg Brockman, CTO von Stripe, Sam Altman und Ilya Sutskever, CEO von YC Ventures, und andere im Resewood Hotel in Kalifornien, um die Gründung eines KI-Labors zu besprechen, das der Kontrolle der KI-Technologie durch große Internetunternehmen entgegenwirken sollte. Als nächstes brachte Greg Brockman eine Gruppe von Forschern von Google, Microsoft und anderen zusammen, um ein neues Labor namens OpenAI zu gründen, wobei Greg Brockman, Sam Altman und Ilya Sutskever als Vorsitzender, CEO bzw. Chefwissenschaftler von OpenAI fungieren.

Ursprünglich hatten Musk und Sam Altman die Idee, OpenAI als gemeinnützige Organisation zu gründen, die die KI-Technologie für jedermann zugänglich machen würde, um den Gefahren zu begegnen, die von der Kontrolle der KI-Technologie durch große Internetunternehmen ausgehen. Da sich die Deep-Learning-KI-Technologie explosionsartig entwickelte, konnte niemand vorhersagen, ob die Technologie in Zukunft eine Bedrohung für die Menschheit darstellen würde, und Offenheit könnte der beste Weg sein, um dem entgegenzuwirken. Später im Jahr 2019 entschied sich OpenAI, eine profitable Tochtergesellschaft zu gründen, um die Entwicklung seiner Technologie zu finanzieren, und seine Kerntechnologie, die eine nachträgliche Idee war, als Closed Source zu veröffentlichen.

2017 veröffentlichten Google-Ingenieure ein Papier mit dem Titel Attention is all you need (Aufmerksamkeit ist alles, was man braucht), in dem vorgeschlagen wurde, dass die Transformator Neuronale Netzarchitektur, die durch die Einführung menschlicher Aufmerksamkeitsmechanismen in neuronale Netze gekennzeichnet ist. Die bereits erwähnte Bilderkennung ist ein Szenario des Deep Learning, bei dem es sich bei den Bilddaten um diskrete Daten handelt, zwischen denen keine Korrelation besteht. Im wirklichen Leben gibt es ein anderes Szenario, nämlich den Umgang mit zeitlichen Daten, wie z. B. Text, der mit dem Kontext des Textes zusammenhängt, und auch Sprache, Video usw. sind zeitliche Daten. Diese zeitlich geordneten Daten werden als Sequenz (Sequenzen) bezeichnet, und die eigentliche Aufgabe besteht oft darin, eine Sequenz in eine andere Sequenz umzuwandeln, z. B. die Übersetzung eines chinesischen Absatzes in einen englischen Absatz oder die Umwandlung einer Frage in einen Absatz mit intelligent generierten Antworten durch einen Roboter (Q&A), was den Ursprung des Namens Transformer darstellt. Daher kommt auch der Name Transformer. Wie bereits erwähnt, wird die Erregung eines Neurons durch die gewichtete Summe der Eingangsdaten bestimmt, mit denen es verbunden ist, wobei das Gewicht die Stärke der Verbindung darstellt. Im Falle von Zeitreihendaten ist das Gewicht jedes Elements unterschiedlich, was unserer täglichen Erfahrung entspricht, siehe z. B. die folgende Passage:

Untersuchungen haben gezeigt, dass die Reihenfolge der chinesischen Schriftzeichen nicht immer Einfluss auf das Lesen hat. Wenn Sie zum Beispiel diesen Satz zu Ende lesen, stellen Sie fest, dass alle Schriftzeichen durcheinander sind.

Dies gilt nicht nur für chinesische Schriftzeichen, sondern auch für andere menschliche Sprachen wie Englisch. Dies liegt daran, dass unser Gehirn automatisch das Gewicht der Wörter im Satz beurteilen wird, in der redundanten Informationen, um den Fokus zu fangen, die Aufmerksamkeit.Google-Ingenieure eingeführt, die Aufmerksamkeit Mechanismus in das neuronale Netzwerk-Modell, in der natürlichen Sprachverarbeitung verwendet, so dass die Maschine kann "verstehen" die Absicht der menschlichen Sprache. In der Folge veröffentlichte OpenAI im Jahr 2018 GPT-1 auf der Grundlage der Transformer-Architektur, GPT-2 im Jahr 2019, GPT-3 im Jahr 2020 und ChatGPT, ein KI-Q&A-Programm auf der Grundlage von GPT-3.5 Ende 2022, das in Bezug auf seine Dialogfähigkeit schockierend ist, und die KI hat einen großen Schritt in Richtung AGI gemacht.

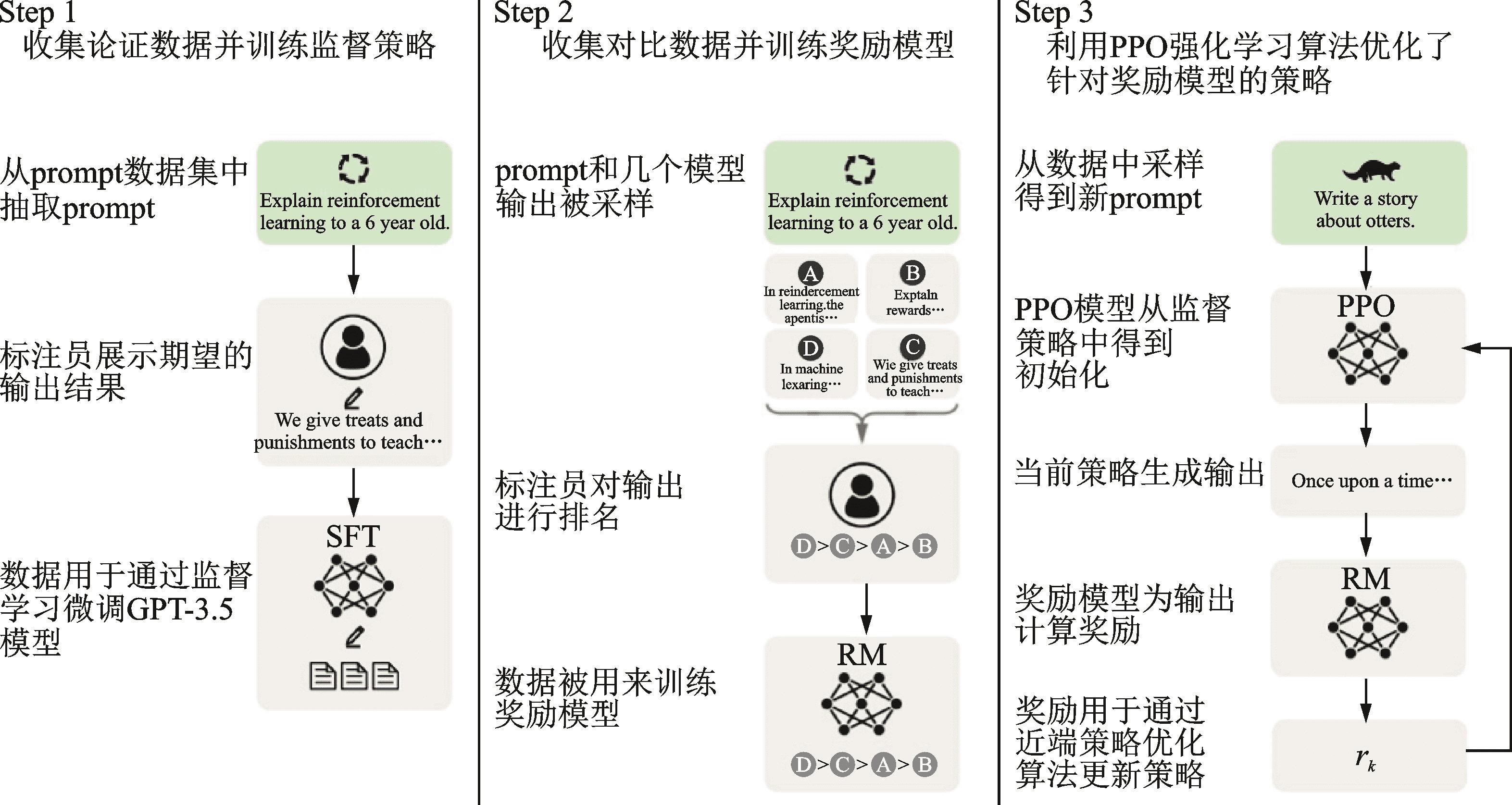

Der vollständige Name von GPT ist Generative Pre-trained Transformer, wobei Generative die Fähigkeit zur Generierung neuer Inhalte bezeichnet, Transformer die Infrastruktur und Pre-trained in der Mitte bedeutet, dass die Trainingsmethode Pre-Training ist. Warum heißt es Pre-trained? Das liegt daran, dass man mit AlexNet begonnen hat, größere Datenmengen und mehr Parameter für das Training neuronaler Netze zu verwenden, um bessere Ergebnisse zu erzielen. Diese Kosten sind etwas hoch für das Training einer spezifischen Aufgabe und sind etwas verschwenderisch, da sie nicht mit anderen neuronalen Netzen geteilt werden können. Aus diesem Grund hat die Industrie damit begonnen, einen Pre-Training + Fine-Tuning-Ansatz für das Training von neuronalen Netzwerkmodellen zu verfolgen, d.h. zuerst wird ein allgemeines, großes Modell auf einem größeren Datensatz trainiert und dann das Fine-Tuning des Modells mit einem kleineren Datensatz für spezifische Aufgabenszenarien abgeschlossen.ChatGPT verwendet Reinforcement Learning from Human Feedback (RLHF), eine Methode zum Training von neuronalen Netzwerkmodellen. ChatGPT verwendet Reinforcement Learning from Human Feedback (RLHF) für das Vortraining und die Feinabstimmung, die in drei Schritte unterteilt ist: der erste Schritt ist das Vortraining eines Sprachmodells (LM); der zweite Schritt ist das Sammeln von Q&A-Daten und das Trainieren eines Belohnungsmodells (RM); und der dritte Schritt ist die Feinabstimmung des Sprachmodells (LM) mit Reinforcement Learning (RL). Dieses Belohnungsmodell enthält menschliches Feedback, daher wird der Trainingsprozess RLHF genannt.

Die Benutzer sind beeindruckt von der Fähigkeit, mehrere Dialogrunden zu führen, sowie von der Genauigkeit bei der Verwendung von ChatGPT. Nach der zugrundeliegenden Erforschung neuronaler Netze sehen wir, dass jeder Inferenzprozess von der Eingabe über die Gewichtung und Aktivierung jedes Neurons bis zur Ausgabe geht und es keine Speichermöglichkeit gibt. Und der Grund, warum ChatGPT gut mit Mehrrunden-Dialogen funktioniert, ist, dass es die Technologie des Prompt-Engineering im Dialogmanagement verwendet.

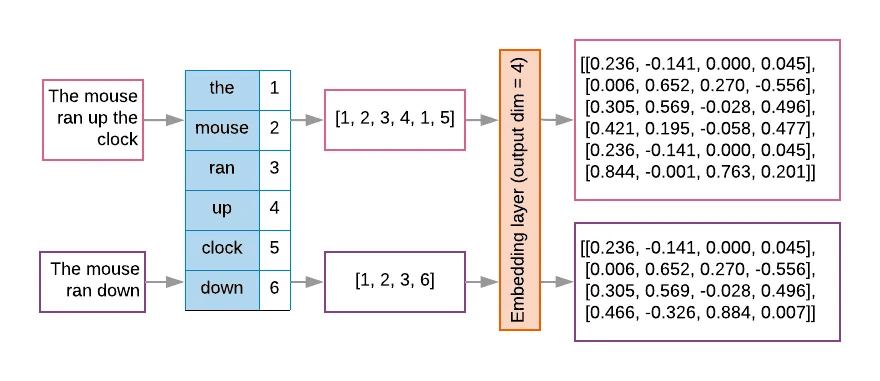

Bei großen Sprachmodellen wie ChatGPT ist die Eingabe ein Token, nachdem eine Textkette konvertiert wurde, und große Modelle entwerfen im Allgemeinen ein festes Kontextfenster, um die Anzahl der eingegebenen Token aus Gründen der Recheneffizienz und der Speicherbeschränkung zu begrenzen. Der Text wird zunächst durch den Tokenizer unterteilt und durch die Lookup-Tabelle nummeriert und dann in die Matrix in einen hochdimensionalen Raumvektor eingebettet, was der Prozess der Textvektorisierung ist, wie in der folgenden Abbildung gezeigt.

Aufgrund der begrenzten Anzahl von Token ist es notwendig, Prompt-Engineering-Techniken einzusetzen, um dem größeren Modell umfassendere Informationen in einem begrenzten Kontextfenster zu vermitteln. Prompt-Engineering nutzt eine Reihe von Strategien zur Optimierung der Modelleingaben, so dass das Modell Ausgaben produziert, die den Erwartungen besser entsprechen.

Hinter dem Erfolg von ChatGPT steht die technische Entwicklung des großen Modells, das durch GPT repräsentiert wird. OpenAI glaubt, dass große Anstrengungen Wunder bewirken, und hat die Parameter von GPT kontinuierlich erweitert, wobei GPT-1 Modellparameter 117 Millionen, GPT-2 Modellparameter 1,5 Milliarden, GPT-3 175 Milliarden und GPT-4 Modellparameter angeblich 1,8 Billionen aufweist. Mehr Modellparameter bedeuten mehr Rechenleistung zur Unterstützung des Trainings, daher hat OpenAI das "Skalierungsgesetz" zusammengefasst, das besagt, dass die Leistung eines Modells mit der Modellgröße, dem Datenvolumen und den Rechenressourcen zusammenhängt, was einfach bedeutet, dass die Leistung des Modells umso besser ist, je größer das Modell, je größer das Datenvolumen und je größer die Rechenressourcen sind. Rich Sutton, der Vater des Reinforcement Learning, vertrat in seinem Artikel "the Bitter Lesson" (die bittere Lektion) eine ähnliche Ansicht. Er ließ die Entwicklung der künstlichen Intelligenz in den letzten Jahrzehnten Revue passieren und kam zu dem Schluss, dass die Menschen kurzfristig immer versuchen, die Leistung des intelligenten Körpers durch die Konstruktion von Wissen zu verbessern, aber langfristig ist die mächtige Rechenleistung der König.

Die Fähigkeit großer Modelle hat sich auch von quantitativen zu qualitativen Veränderungen gewandelt, Googles Chefwissenschaftler Jeff Dean nannte es "emergente Fähigkeiten" (emergente Fähigkeiten) großer Modelle. Der Markt sieht diese Chance, auf der einen Seite, die großen Anbieter in der großen Modell-Investitionen in das Wettrüsten, auf der anderen Seite, das große Modell der Open-Source-Ökologie ist auch in vollem Gange.

V Umarmendes Gesicht

2016 gründeten die Franzosen Clément Delangue, Julien Chaumond und Thomas Wolf ein Unternehmen namens Hugging Face mit dem Emoji-Symbol als Logo. Hugging Face begann mit der Entwicklung intelligenter Chatbots für junge Menschen, entwickelte dann einige Tools für die Modellschulung und stellte sie im Rahmen des Modelltrainings als Open Source zur Verfügung. Später entwickelten sie einige Modelltrainings-Tools und stellten sie frei zur Verfügung. Später verlagerte sich ihr Schwerpunkt sogar auf letzteres, ein scheinbar "unprofessioneller" Ansatz, der sie auf einen neuen Weg und eine unverzichtbare Rolle im Bereich des Deep Learning geführt hat.

Silicon Valley hat eine Menge von Unternehmen sind in der Nebengeschäft, um Errungenschaften zu machen, wie Slack ursprünglich entwickelte Spiele, das Unternehmen Team ist an vielen Orten verteilt, in den Prozess der Operation entwickelt ein Kommunikations-Tool Ergebnisse in der versehentlichen Feuer, das heißt, Slack.Und Hugging Face wiederum ist auch ähnlich, sondern auch, um ihre eigenen Schmerzpunkte zu lösen.Im Jahr 2018 veröffentlichte Google das große Modell BERT, und Hugging Face-Mitarbeiter nutzten daraufhin ihr vertrautes Pytorch-Framework, um BERT zu implementieren, nannten das Modell pytorch-pretrained-bert und stellten es auf GitHub zur Verfügung. Später wurde mit Hilfe der Community eine Gruppe von Modellen wie GPT, GPT-2 und Transformer-XL eingeführt, und das Projekt wurde umbenannt in Im Bereich des Deep Learning konkurrieren die beiden Frameworks Pytorch und TensorFlow miteinander, und die Forscher wechseln häufig zwischen den beiden Frameworks, um die Vor- und Nachteile der beiden Frameworks zu vergleichen, so dass das Open-Source-Projekt die Funktion des Wechsels zwischen den beiden Frameworks hinzugefügt hat und der Projektname ebenfalls in Transformers geändert wurde. Transformers ist auch das am schnellsten wachsende Projekt auf GitHub geworden.

Hugging Face entwickelt weiterhin eine Reihe anderer Tools für maschinelles Lernen und stellt sie als Open Source zur Verfügung: Datasets, Tokenizer, Diffusers ....... Diese Tools standardisieren auch den Prozess der KI-Entwicklung. Vor Hugging Face konnte man sagen, dass die KI-Entwicklung von Forschern ohne einen standardisierten technischen Ansatz dominiert wurde. Hugging Face bietet ein umfassendes KI-Toolset und etabliert eine Reihe von De-facto-Standards, die es auch mehr KI-Entwicklern und sogar Nicht-KI-Praktikern ermöglichen, schnell einzusteigen und Modelle zu trainieren.

Hugging Face hat dann den Hugging Face Hub für das Hosting von Modellen, Datensätzen und KI-Anwendungen auf der Grundlage von Git- und Git-LFS-Technologien ins Leben gerufen. Bislang wurden 350 000 Modelle, 75 000 Datensätze und 150 000 KI-Beispiele auf der Plattform gehostet. Die Arbeit des Hostings und Open-Sourcing von Modellen und Datensätzen sowie die Einrichtung eines globalen Open-Source-Repository-Zentrums ist innovativ und weitreichend. Während der oben erwähnte Ansatz des Pre-Trainings und der Feinabstimmung die gemeinsame Nutzung von Ressourcen für das Training neuronaler Netze erleichtert, geht der Hugging Face Hub noch einen Schritt weiter, indem er es KI-Entwicklern leicht macht, die weltweit fortschrittlichsten Ergebnisse wiederzuverwenden und sie zu ergänzen, wodurch die Nutzung und Entwicklung von KI für alle demokratisiert wird. GitHub, oder wie ihr Slogan sagt: Aufbau der KI-Community der Zukunft. Ich habe bereits zwei Artikel geschrieben, einenEine Code-Übertragung, die die Welt verändert hatGit einführen, ein Artikel inDer Weg von Null auf 10 Mrd. DollarDie Einführung von GitHub und Git, GitHub, Hugging Face, ich denke, es gibt eine Art Vermächtnis zwischen ihnen, ein Vermächtnis des Hackens, das die Welt verändert, um die Zukunft zu gestalten, und das ist eines der Dinge, die mich veranlasst haben, diesen Beitrag zu schreiben.

VI. Nachwort

Als ich mich dem Ende dieses Artikels näherte, sah ich mir einen Vortrag an, den Hinton kürzlich an der Universität Oxford hielt. In diesem Vortrag stellte Hinton zwei große Denkschulen auf dem Gebiet der künstlichen Intelligenz vor, eine, die er als logischen Ansatz oder Symbolismus bezeichnete, und die andere, die er als biologischen Ansatz oder neuronalen Netzwerkkonnektionismus bezeichnete, der das menschliche Gehirn simuliert. Und der biologische Ansatz erwies sich als klarer Sieger gegenüber dem logischen Ansatz. Neuronale Netze sind Modelle, die das Verständnis des menschlichen Gehirns imitieren sollen, und große Modelle funktionieren und verstehen wie das Gehirn. Hinton glaubt, dass in der Zukunft künstliche Intelligenz jenseits des menschlichen Gehirns entstehen wird, und zwar viel früher, als wir es vorhersagen.

Anhang 1 Chronologie der Ereignisse

1943 veröffentlichten McCulloch und Pitts das "M-P-Neuronenmodell", das mit Hilfe mathematischer Logik die Recheneinheiten des menschlichen Gehirns erklärte und simulierte und das Konzept der neuronalen Netze einführte.

Der Begriff "künstliche Intelligenz" wurde erstmals 1956 auf der Dartmouth-Konferenz geprägt.

1957 schlug Rosenblatt das "Perceptron"-Modell vor, und zwei Jahre später gelang ihm der Bau des Mark-1, eines Hardware-Perceptrons, das das englische Alphabet erkennen konnte.

1969 veröffentlichte Minsky das Buch Perceptual Machines, und die in diesem Buch aufgezeigten Mängel von Wahrnehmungsmaschinen versetzten der Forschung im Bereich der Wahrnehmungsmaschinen und sogar der neuronalen Netze einen schweren Schlag.

Im Jahr 1983 erfand Hinton die Boltzmann-Maschine.

1986 erfand Hinton den Fehler-Backpropagation-Algorithmus.

Im Jahr 1989 erfand Yann LeCun das Convolutional Neural Network (CNN).

Im Jahr 2006 schlug Hinton das Deep Belief Network vor und läutete damit die Ära des Deep Learning ein.

Deep Learning wurde 2012 von der Industrie ernst genommen, als Hinton und zwei seiner Studenten AlexNet entwickelten und damit den ImageNet-Wettbewerb mit großem Vorsprung gewannen.

2015 brachte DeepMind, ein von Google übernommenes Unternehmen, AlphaGo auf den Markt, das 2016 Lee Sedol und 2017 Ke Jie besiegte.OpenAI wurde gegründet.

Hugging Face wurde im Jahr 2016 gegründet.

Im Jahr 2017 veröffentlichte Google das Transformer-Modellpapier.

2018 veröffentlichte OpenAI GPT-1, das auf der Transformer-Architektur basiert, und Hugging Face veröffentlichte das Transformers-Projekt.

Im Jahr 2019 veröffentlicht OpenAI GPT-2.

Im Jahr 2020 veröffentlicht OpenAI GPT-3. Hugging Face startet Hugging Face Hub.

Im Jahr 2022 veröffentlicht OpenAI ChatGPT.

Anhang 2 Referenzen

Bücher:

Frontiers of Intelligence: from Turing Machines to Artificial Intelligence von Zhou Zhiming (Autor) Mechanical Industry Press Oktober 2018

Die Deep Learning Revolution von Cade Metz Shuguang Du CITIC Press Januar 2023

Deep Learning in Python (2. Auflage) Francois Chollet (Autor) Liang Zhang (Übersetzer) People's Posts and Telecommunications Publishing House August 2022

An Introduction to Deep Learning: theory and implementation based on Python von Yasui Saito (Autor) Yujie Lu (Übersetzer) People's Posts and Telecommunications Publishing House 2018

Deep Learning Advanced: Natural Language Processing von Yasuyoshi Saito (Autor) Yujie Lu (Übersetzer) People's Posts and Telecommunications Publishing House Oktober 2020

Dies ist ChatGPT Stephen Wolfram (Autor) WOLFRAM Media Chinese Group (Übersetzer) People's Posts and Telecommunications Publishing House Juli 2023

Generative Künstliche Intelligenz von Ding Lei (Autor) CITIC Press Mai 2023

Huggingface Natural Language Processing Explained by Li Fulin (Autor) Tsinghua University Press April 2023

Artikel:

Eine Einführung in neuronale Netze von Yifeng Nguyen

2012, 180 Tage, die das Schicksal der Menschheit veränderten" Enkawa Research Institute

GPT Familie Evolution MetaPost

Transformer - Aufmerksamkeit ist alles, was du brauchst".

Die Entwicklung von vortrainierten Sprachmodellen.

Leitfaden für Prompt Engineering

ChatGPT hinter dem "Kredit" - RLHF Technologie ausführlich erklärt.

Entwicklung und Anwendung von ChatGPT-Großmodellierungstechniken.

Die bittere Lektion, Rich Sutton.

Ein Interview mit dem CTO von HuggingFace: Der Aufstieg von Open Source, Startup-Geschichten und die Demokratisierung von KI".

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...