HiveChat: der KI-Chatbot für den schnellen Einsatz in Unternehmen

Allgemeine Einführung

HiveChat ist ein KI-Chatbot für kleine und mittelgroße Teams, der es Administratoren ermöglicht, mehrere KI-Modelle (wie Deepseek, OpenAI, Claude und Gemini) auf einmal zu konfigurieren, damit sie von den Teammitgliedern einfach genutzt werden können. Es bietet LaTeX- und Markdown-Rendering, DeepSeek-Inferenzkettenanzeige, Bildverständnis, KI-Agenten und Cloud-Datenspeicher und unterstützt 10 große Modellanbieter. Das Projekt nutzt die Technologie-Stacks Next.js, Tailwindcss und PostgreSQL und kann lokal oder über Vercel und Docker bereitgestellt werden.

Funktionsliste

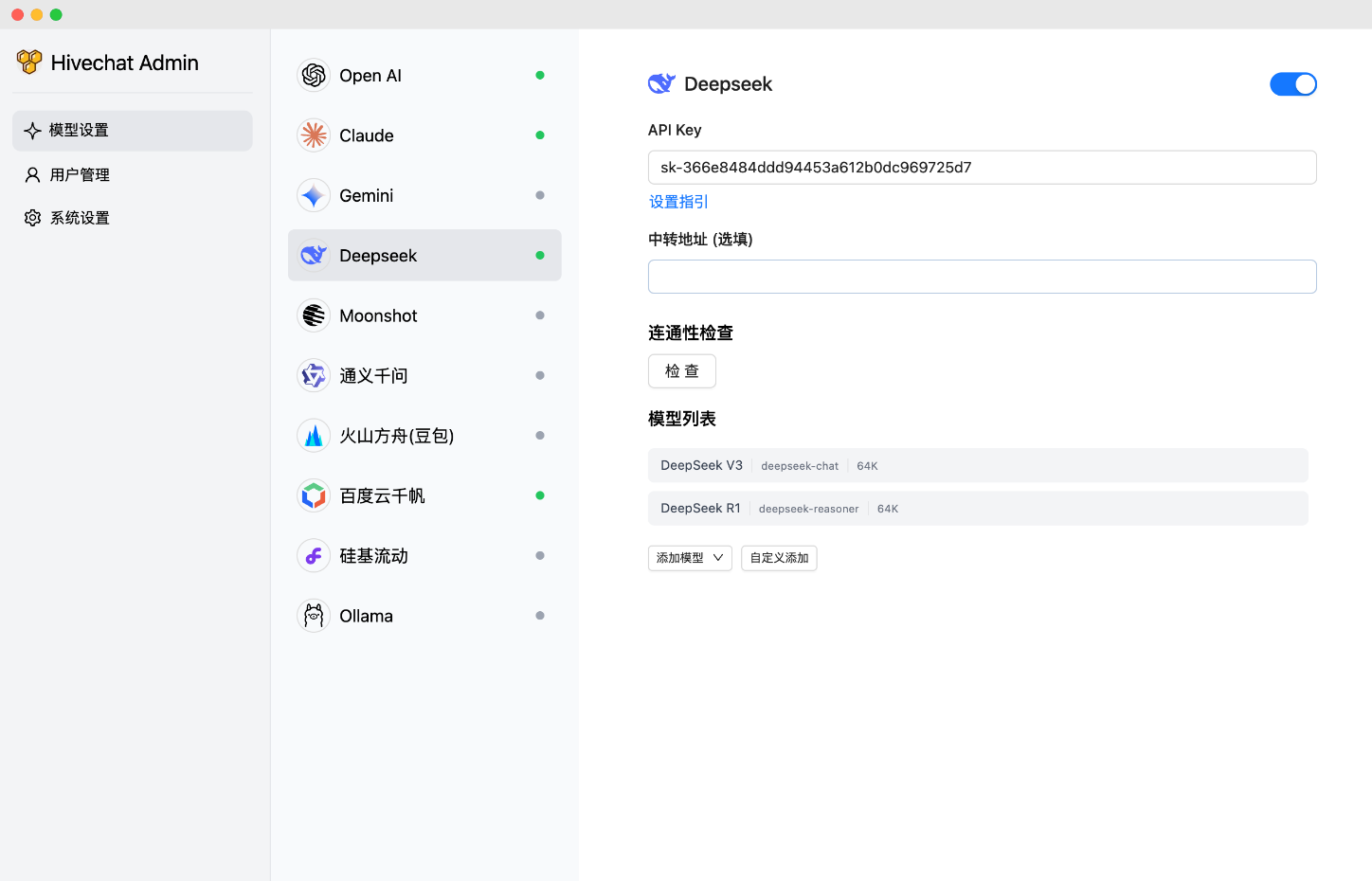

- Unterstützte KI-Modelle: HiveChat unterstützt KI-Modelle wie Deepseek, OpenAI, Claude, Gemini, Moonshot, Volcano Engine Ark, Ali Bailian (Qianwen), Baidu Qianfan, Ollama, und SiliconFlow 10 große Modellanbieter, einschließlich nationaler und internationaler Mainstream-Optionen für globalisierte Teams.

- Rendering und Anzeige: Unterstützt LaTeX- und Markdown-Rendering, was für Teams beim Umgang mit technischen Dokumenten praktisch ist; die DeepSeek-Funktion zur Anzeige der Inferenzkette hilft den Benutzern, den Inferenzprozess der KI zu verstehen.

- Multimediale Unterstützung: Bildverarbeitungsfähigkeiten, geeignet für die Bewältigung von Aufgaben im Zusammenhang mit dem Sehen.

- KI-Agent: Integrieren Sie KI-Agentenfunktionen für erweiterte Automatisierungsmöglichkeiten.

- Datenmanagement: Bietet Cloud-Datenspeicherung, um sicherzustellen, dass die Daten des Teams sicher und beständig sind.

Hilfe verwenden

Technologie-Stacks und Bereitstellungsoptionen

HiveChat verwendet eine moderne Front-End- und Back-End-Technologie, die Folgendes umfasst:

| Fähigkeiten | Beschreibungen |

|---|---|

| Weiter.js | verwendet, um das serverseitige Rendering der Reagieren Sie Gerät |

| Tailwindcss | Bietet ein schnelles CSS-Framework |

| Auth.js | Handhabung der Benutzerauthentifizierung |

| PostgreSQL | Relationale Datenbank mit Datenspeicherunterstützung |

| Drizzle ORM | Datenbankoperationen ORM-Tools |

| Ameisen-Design | UI-Komponentenbibliotheken zur Verbesserung der Benutzerfreundlichkeit |

Zu den Bereitstellungsoptionen gehören die lokale Bereitstellung, die Docker-Bereitstellung und die Vercel-Bereitstellung:

- lokaler EinsatzBenutzer müssen das Repository klonen und Folgendes ausführen

npm installdie Installation von Abhängigkeiten.npm run initdbdie Datenbank initialisieren.npm run devStarten Sie die Entwicklungsumgebung.npm run buildim Gesang antwortennpm run startFür den Einsatz in Produktionsumgebungen. - Docker-Bereitstellung: Klonen Sie das Repository, führen Sie

docker compose buildim Gesang antwortendocker compose up -dDer containerisierte Dienst kann gestartet werden. - Einsatz in Vercel: durch Vercel Einsatz Links Für die Bereitstellung mit einem Mausklick müssen Sie Umgebungsvariablen wie DATABASE_URL, AUTH_SECRET und ADMIN_CODE konfigurieren.

Sobald die Bereitstellung abgeschlossen ist, muss der Administrator http://localhost:3000/setup (oder die tatsächliche Domäne/den tatsächlichen Anschluss) besuchen, um ein Administratorkonto einzurichten.

Ausführliche Hilfe

Um den Benutzern einen schnellen Einstieg in HiveChat zu ermöglichen, finden Sie hier eine ausführliche Anleitung zur Installation und Nutzung:

Einbauverfahren

- Klon-Lager::

- Öffnen Sie ein Terminal und führen Sie den folgenden Befehl aus, um Ihr GitHub-Repository zu klonen:

git clone https://github.com/HiveNexus/HiveChat.git cd HiveChat

- Öffnen Sie ein Terminal und führen Sie den folgenden Befehl aus, um Ihr GitHub-Repository zu klonen:

- Bereitstellungsmethode auswählen::

- lokaler Einsatz::

- Stellen Sie sicher, dass Node.js und PostgreSQL installiert sind.

- in Bewegung sein

npm installInstallieren Sie die Abhängigkeit. - konfigurieren.

.envsetzen Sie die folgenden Umgebungsvariablen:DATABASE_URL=postgres://postgres:password@localhost/hivechat(muss durch eine tatsächliche Datenbankverbindung ersetzt werden, z. B. lokale PostgreSQL).AUTH_SECRET: Verwendungopenssl rand -base64 32Erzeugt eine 32-Bit-Zufallszeichenfolge.ADMIN_CODE: Legen Sie den Autorisierungscode des Administrators fest, ein Beispiel ist22113344ist es empfehlenswert, ihn durch einen benutzerdefinierten Wert zu ersetzen.NEXTAUTH_URL=http://127.0.0.1:3000(Testumgebungen können als Standard belassen werden, Produktionsumgebungen müssen auf den offiziellen Domänennamen geändert werden).

- in Bewegung sein

npm run initdbInitialisieren Sie die Datenbank. - Entwicklungsumgebung läuft

npm run devBetrieb der Produktionsumgebungnpm run buildKaiserinnpm run start.

- Docker-Bereitstellung::

- Stellen Sie sicher, dass Docker und Docker Compose installiert sind.

- in Bewegung sein

docker compose buildBauen Sie das Spiegelbild. - in Bewegung sein

docker compose up -dStarten Sie den Container. - Das Konfigurieren von Umgebungsvariablen ist dasselbe wie die lokale Bereitstellung und muss in der

docker-compose.ymlAngegeben in.

- Einsatz in Vercel::

- Interviews Vercel Einsatz Links.

- Folgen Sie den Aufforderungen zur Konfiguration von DATABASE_URL, AUTH_SECRET und ADMIN_CODE.

- Klicken Sie auf Bereitstellen und warten Sie, bis Vercel die Erstellung abgeschlossen hat.

- lokaler Einsatz::

- Administrator-Initialisierung::

- Sobald die Bereitstellung abgeschlossen ist, gehen Sie auf http://localhost:3000/setup (lokale Bereitstellung) oder den tatsächlichen Domänennamen und geben Sie ADMIN_CODE ein, um das Administratorkonto einzurichten.

Verwendung

- Bedienung durch den Administrator::

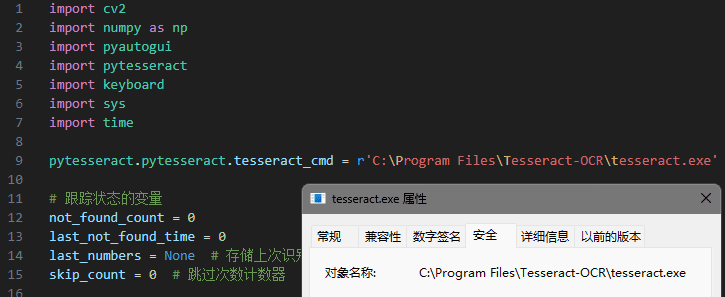

- Melden Sie sich an und gehen Sie zum Administrator-Dashboard, wo Sie den KI-Modellanbieter konfigurieren können (z. B. OpenAI API Key usw.).

- Verwalten Sie alle Benutzerkonten, indem Sie manuell Benutzer hinzufügen oder die Registrierung aktivieren.

- Zeigen Sie Statistiken zur Teamnutzung an und passen Sie die Modellkonfigurationen an, um die Leistung zu optimieren.

- Allgemeiner Benutzerbetrieb::

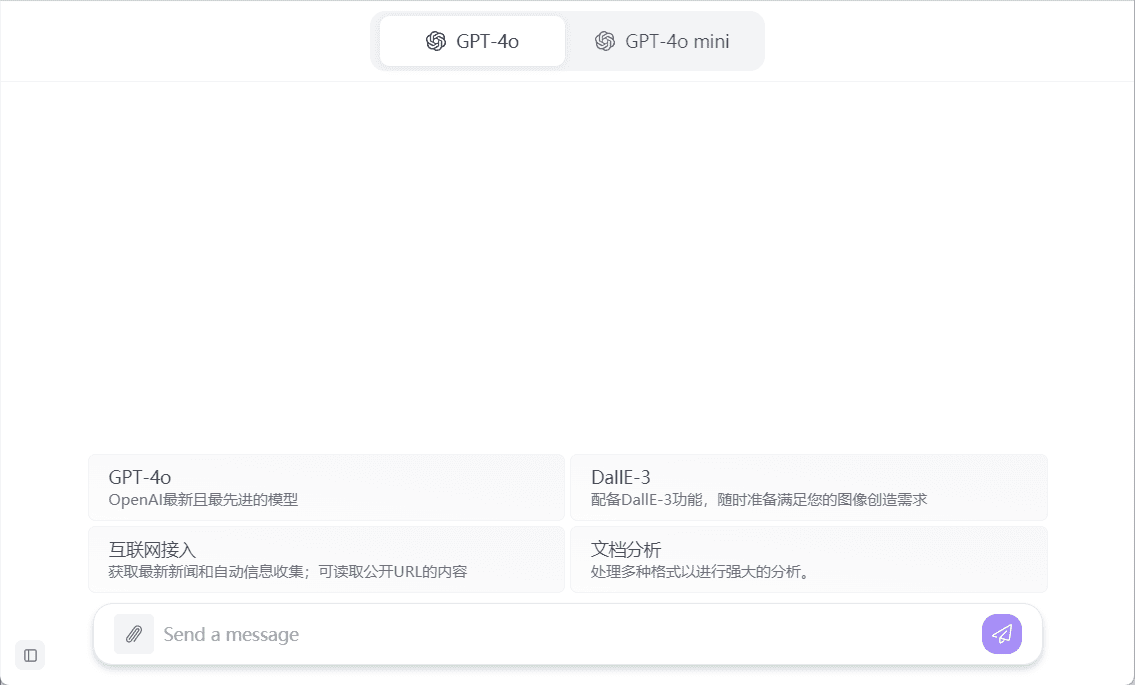

- Melden Sie sich an, um auf die Chat-Schnittstelle zuzugreifen, die Texteingaben und Multimedia-Uploads (z. B. Bilder) unterstützt.

- Formatieren Sie den Chat mit LaTeX und Markdown für technische Diskussionen.

- Wählen Sie verschiedene AI-Modelle (z. B. Deepseek oder Claude), um einen Dialog zu führen und die DeepSeek-Schlussfolgerungskette einzusehen, um den Entscheidungsprozess der KI zu verstehen.

- Die Daten werden automatisch in der Cloud gespeichert, so dass der Sitzungsverlauf jederzeit eingesehen werden kann.

- Featured Function Bedienung::

- grafisches VerständnisLaden Sie Bilder hoch, und die KI kann den Inhalt analysieren und Beschreibungen erstellen, die für Produktdesign- oder Datenanalyseteams geeignet sind.

- AI-AgentDurch Konfiguration kann die KI bestimmte Aufgaben automatisieren, z. B. die Erstellung von Berichten oder die Beantwortung häufig gestellter Fragen.

- Cloud-DatenspeicherungAlle Chats und Konfigurationen werden in der Cloud gespeichert und können von Teammitgliedern geräteübergreifend genutzt werden.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...