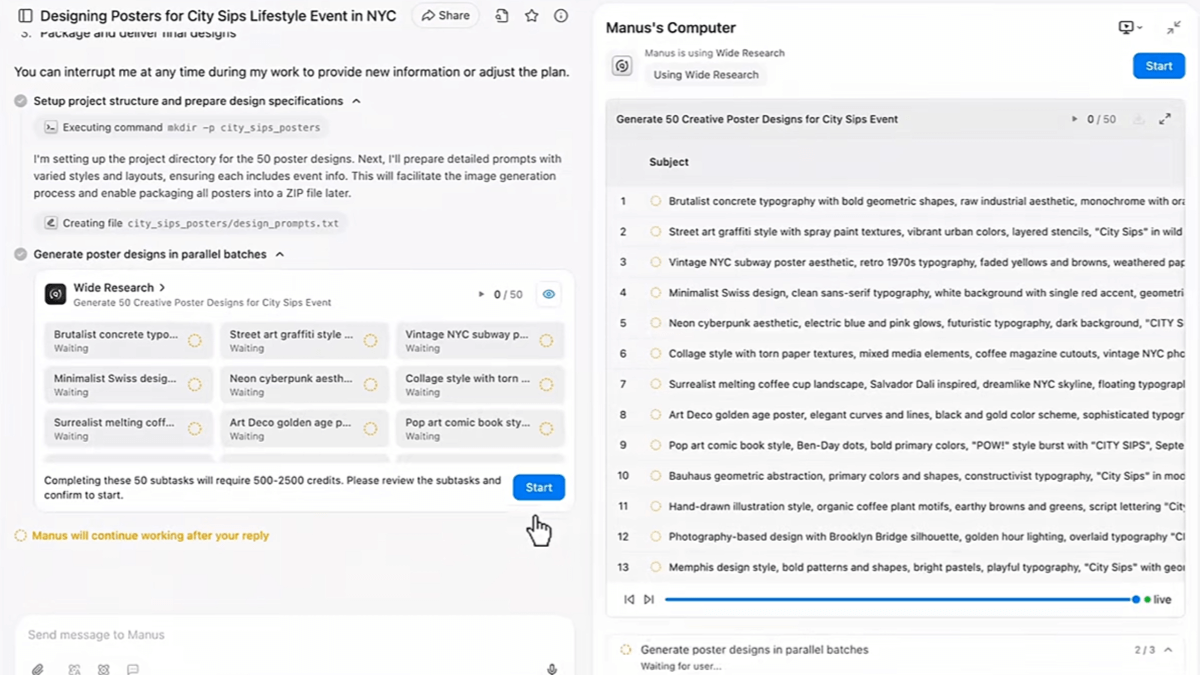

Hibiki: ein Echtzeit-Sprachübersetzungsmodell, eine Streaming-Übersetzung, die die Eigenschaften der Originalstimme bewahrt

Allgemeine Einführung

Hibiki ist ein von Kyutai Labs entwickeltes Echtzeit-Sprachübersetzungsmodell mit hoher Wiedergabetreue. Im Gegensatz zu herkömmlichen Offline-Übersetzern erzeugt Hibiki natürliche Sprachübersetzungen in der Zielsprache und liefert die Textübersetzung in Echtzeit, während der Benutzer spricht. Das Modell verwendet eine Multi-Stream-Architektur, die gleichzeitig den Eingangssprachstrom verarbeitet und die Zielsprache generiert, um kohärente und genaue Übersetzungen zu gewährleisten. Hibiki gleicht die Ausgangs- und Zielsprache und den Text durch überwachtes Training ab und verwendet Techniken zur Erzeugung synthetischer Daten, um qualitativ hochwertige Übersetzungen mit begrenzten realen Daten zu gewährleisten.

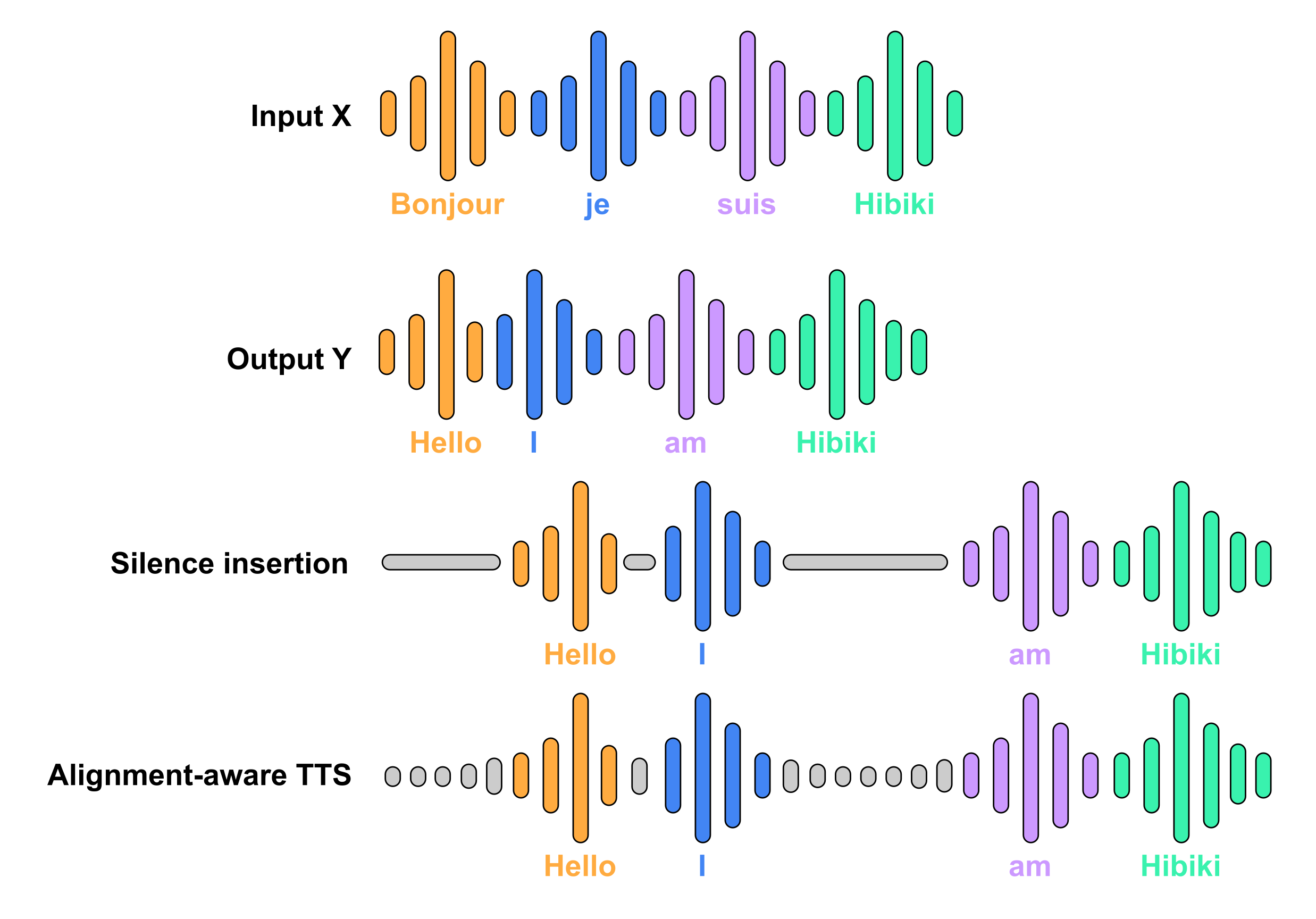

Hibiki stützt sich auf überwachtes Training von abgeglichener Quell- und Zielsprache und -text desselben Sprechers. Aufgrund der unzureichenden Menge an solchen Daten verlassen wir uns auf die Generierung synthetischer Daten. Der Abgleich auf Wortebene zwischen Ausgangs- und Zieltranskripten wird mit einem schwach überwachten Ansatz des kontextuellen Alignments unter Verwendung des Standardübersetzungssystems MADLAD durchgeführt. Die abgeleiteten Alignment-Regeln (ein Wort kommt in der Zielsprache nur dann vor, wenn es aus der Ausgangssprache vorhergesagt werden kann) werden angewandt, indem Stille eingefügt oder die Zielsprache mit Hilfe sprachgesteuerter, alignementfähiger TTS synthetisiert wird.

Funktionsliste

- Echtzeit-SprachübersetzungGenerieren Sie eine natürliche Sprachübersetzung der Zielsprache in Echtzeit, während der Benutzer spricht.

- TextübersetzungBietet eine mit der Sprache synchronisierte Textübersetzung.

- Multistream-Architektur (Datenverarbeitung)Die gleichzeitige Verarbeitung des Eingangssprachstroms und die Generierung der Zielsprache gewährleisten eine kohärente und genaue Übersetzung.

- High FidelityGewährleistung einer hohen Übersetzungsqualität durch überwachtes Training und Techniken zur Erzeugung synthetischer Daten.

- phonetische ÜbertragungOptionale Sprachübertragungsfunktion für eine natürlichere Übersetzungsstimme.

Hilfe verwenden

Einbauverfahren

PyTorch

- Montage

moshiPaket:pip install -U moshi - Laden Sie die Beispieldatei herunter:

wget https://github.com/kyutai-labs/moshi/raw/refs/heads/main/data/sample_fr_hibiki_crepes.mp3 - Führen Sie die Übersetzung aus:

python -m moshi.run_inference sample_fr_hibiki_crepes.mp3 out_en.wav --hf-repo kyutai/hibiki-1b-pytorch-bf16- Optionale Parameter

--cfg-coefDer Standardwert ist 1. Je höher der Wert, desto näher ist die generierte Sprache an der Originalsprache, der empfohlene Wert ist 3.

- Optionale Parameter

MLX

- Montage

moshi_mlxPaket (erfordert mindestens Version 0.2.1):pip install -U moshi_mlx - Laden Sie die Beispieldatei herunter:

wget https://github.com/kyutai-labs/moshi/raw/refs/heads/main/data/sample_fr_hibiki_crepes.mp3 - Führen Sie die Übersetzung aus:

python -m moshi_mlx.run_inference sample_fr_hibiki_crepes.mp3 out_en.wav --hf-repo kyutai/hibiki-1b-mlx-bf16- Optionale Parameter

--cfg-coefDer Standardwert ist 1. Je höher der Wert, desto näher ist die generierte Sprache an der Originalsprache, der empfohlene Wert ist 3.

- Optionale Parameter

MLX-Swift

kyutai-labs/moshi-swiftDas Repository enthält eine Implementierung von MLX-Swift, die auf dem iPhone läuft und auf dem iPhone 16 Pro getestet wurde. Beachten Sie, dass sich dieser Code noch in der experimentellen Phase befindet.

Rost

- gehen in

hibiki-rsKatalog:cd hibiki-rs - Laden Sie die Beispieldatei herunter:

wget https://github.com/kyutai-labs/moshi/raw/refs/heads/main/data/sample_fr_hibiki_crepes.mp3 - Führen Sie die Übersetzung aus:

cargo run --features metal -r -- gen sample_fr_hibiki_crepes.mp3 out_en.wav- ausnutzen

--features cudaDie Ausführung auf einem NVIDIA-Grafikprozessor oder mit dem--features metalLäuft auf einem Mac.

- ausnutzen

Modellierung

Wir haben zwei Modelle für die Übersetzung Französisch-Englisch veröffentlicht:

- Hibiki 2BFür PyTorch und MLX mit 16 RVQ-Streams.

- Hibiki 1BFür PyTorch und MLX, mit 8 RVQ-Streams, ideal für geräteseitiges Reasoning.

Modellliste:

- Hibiki 2B für PyTorch (bf16):

kyutai/hibiki-2b-pytorch-bf16 - Hibiki 1B für PyTorch (bf16):

kyutai/hibiki-1b-pytorch-bf16 - Hibiki 2B für MLX (bf16):

kyutai/hibiki-2b-mlx-bf16 - Hibiki 1B für MLX (bf16):

kyutai/hibiki-1b-mlx-bf16

Alle Modelle sind unter der CC-BY 4.0-Lizenz veröffentlicht.

Verwendungsprozess

- GrundierungsmodellStarten Sie das Modell nach dem Installationsvorgang.

- Eingabe StimmeEingabe von Sprache in der Ausgangssprache über das Mikrofon.

- Echtzeit-ÜbersetzungHibiki erzeugt eine Echtzeit-Sprachübersetzung in der Zielsprache und zeigt gleichzeitig die Textübersetzung an.

- Anpassung der EinstellungenEinstellungen wie Sprachübertragung anpassen, um eine natürlichere Übersetzung zu erhalten.

Hauptfunktionen

- Echtzeit-SprachübersetzungNach dem Start des Modells geben Sie Ihre Stimme direkt in das Mikrofon ein und Hibiki übersetzt sie automatisch.

- TextübersetzungHibiki erstellt gleichzeitig mit der Sprachübersetzung eine Textübersetzung, die auf der Benutzeroberfläche angezeigt wird.

- phonetische ÜbertragungAktivieren Sie die Sprachübertragungsfunktion in den Einstellungen, um die übersetzte Stimme besser an die natürliche Aussprache der Zielsprache anzupassen.

Detaillierte Vorgehensweise

- GrundierungsmodellStarten Sie das Modell nach der Installation, um sicherzustellen, dass alle Abhängigkeiten korrekt installiert wurden.

- Eingabe Stimme: Geben Sie Ihre Stimme in der Ausgangssprache über das Mikrofon ein und Hibiki beginnt automatisch mit der Übersetzung.

- Übersetzungsergebnisse anzeigenSprach- und Textübersetzungen in Echtzeit in der Zielsprache auf der Benutzeroberfläche anzeigen.

- Anpassung der Einstellungen: Passen Sie Funktionen wie die Sprachübertragung in den Einstellungen nach Bedarf an, um eine optimale Übersetzung zu erzielen.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...