HeyGem: Auf Silizium basierendes intelligentes Open-Source-Produkt Heygen digital human ping-pong

Allgemeine Einführung

HeyGem ist ein vollständig offline arbeitendes Video-Compositing-Tool für Windows, das vom GuijiAI-Team entwickelt und auf GitHub als Open Source veröffentlicht wurde. Es nutzt fortschrittliche KI-Algorithmen, um das Aussehen und die Stimme eines Nutzers genau zu klonen und realistische Avatare zu erstellen. Es unterstützt die Erstellung von personalisierten Videos, die durch Text oder Sprache gesteuert werden. HeyGem unterstützt mehrsprachige Skripte (einschließlich Englisch, Japanisch, Koreanisch, Chinesisch und acht weitere Sprachen), eine einfache und intuitive Benutzeroberfläche, die auch für Benutzer ohne technische Vorkenntnisse geeignet ist, und eine offene API, die es Entwicklern ermöglicht, die Funktionalität zu erweitern. Vor einigen Monaten hat Silicon Intelligence die Open-Source-Mobilversion der digitalen Person DUIX: Intelligente digitale Menschen für Echtzeit-Interaktion, die eine plattformübergreifende Bereitstellung mit einem Mausklick unterstützen.

HeyGem offizielle Download-Adresse: https://heygem.ai/

Funktionsliste

- Präzises Aussehen und Klonen der StimmeKI-Technologie erfasst Gesichtszüge und stimmliche Details, um Avatare und Stimmen mit hoher Wiedergabetreue zu erzeugen, wobei die Parameter angepasst werden können.

- Textgesteuertes virtuelles BildSobald der Text eingegeben ist, generiert das Tool automatisch natürliche Sprache und steuert den Avatar durch Lippensynchronisation und Ausdrucksbewegungen.

- Sprachgesteuerte VideoproduktionDynamische Videos erzeugen, indem Ton und Rhythmus des Avatars durch die Spracheingabe des Benutzers gesteuert werden.

- Vollständiger Offline-BetriebEs ist keine Netzwerkverbindung erforderlich, und alle Daten werden aus Gründen des Datenschutzes und der Sicherheit lokal verarbeitet.

- Unterstützung mehrerer SprachenAcht Sprachen werden unterstützt: Englisch, Japanisch, Koreanisch, Chinesisch, Französisch, Deutsch, Arabisch und Spanisch.

- Effizientes Video-CompositingIntelligente Optimierung der Audio- und Videosynchronisation sorgt für eine natürliche Übereinstimmung von Lippenform und Stimme.

- Open-Source-API-SchnittstelleBietet APIs für Modelltraining und Video-Compositing mit anpassbaren Funktionen für Entwickler.

Hilfe verwenden

Einbauverfahren

Der folgende Installationsvorgang hält sich strikt an die offiziellen Anweisungen, wobei die ursprünglichen Text- und Bildadressen beibehalten werden:

Voraussetzungen

- Muss Scheibe D haben.Hauptsächlich zur Speicherung von digitalen Bildern und Projektdaten

- Freier Speicherplatzbedarf: mehr als 30 GB

- C-ScheibeService-Image-Dateien: Wird zum Speichern von Service-Image-Dateien verwendet.

- Freier Speicherplatzbedarf: mehr als 100 GB

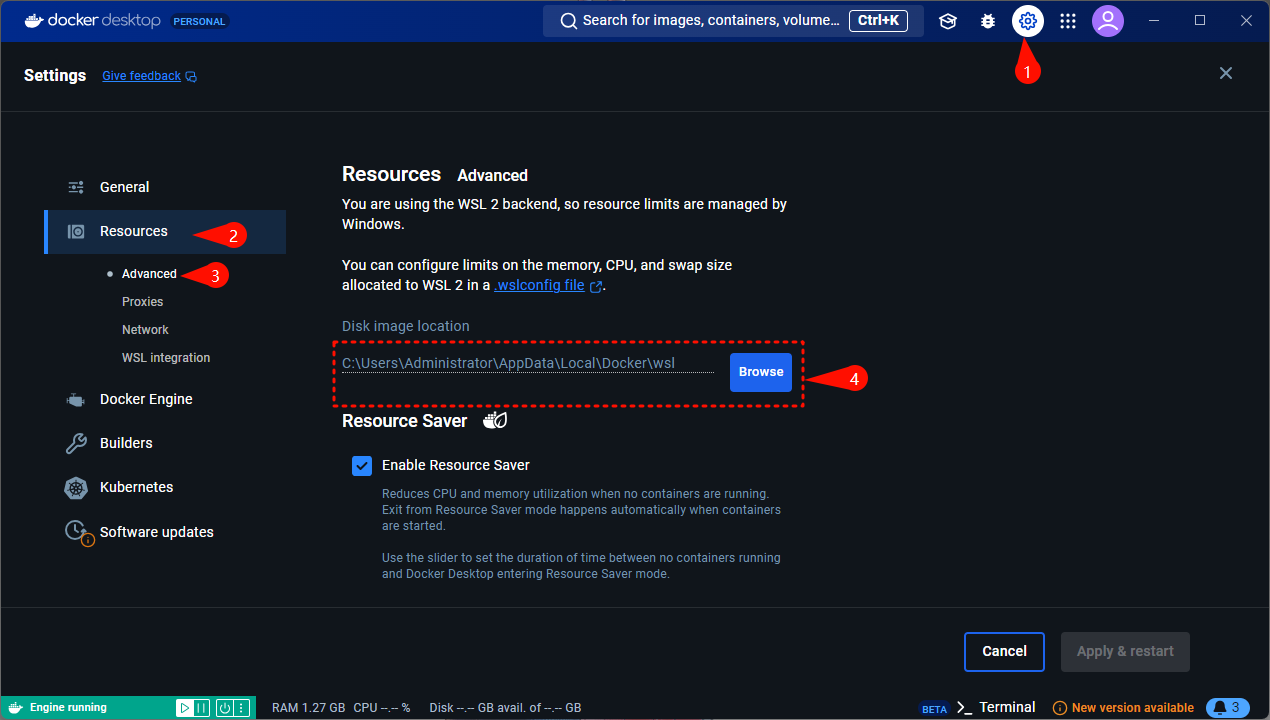

- Wenn Sie weniger als 100 GB freien Speicherplatz haben, können Sie nach der Installation von Docker einen Ordner auf einem Datenträger mit mehr als 100 GB freiem Speicherplatz an dem unten angegebenen Ort auswählen:

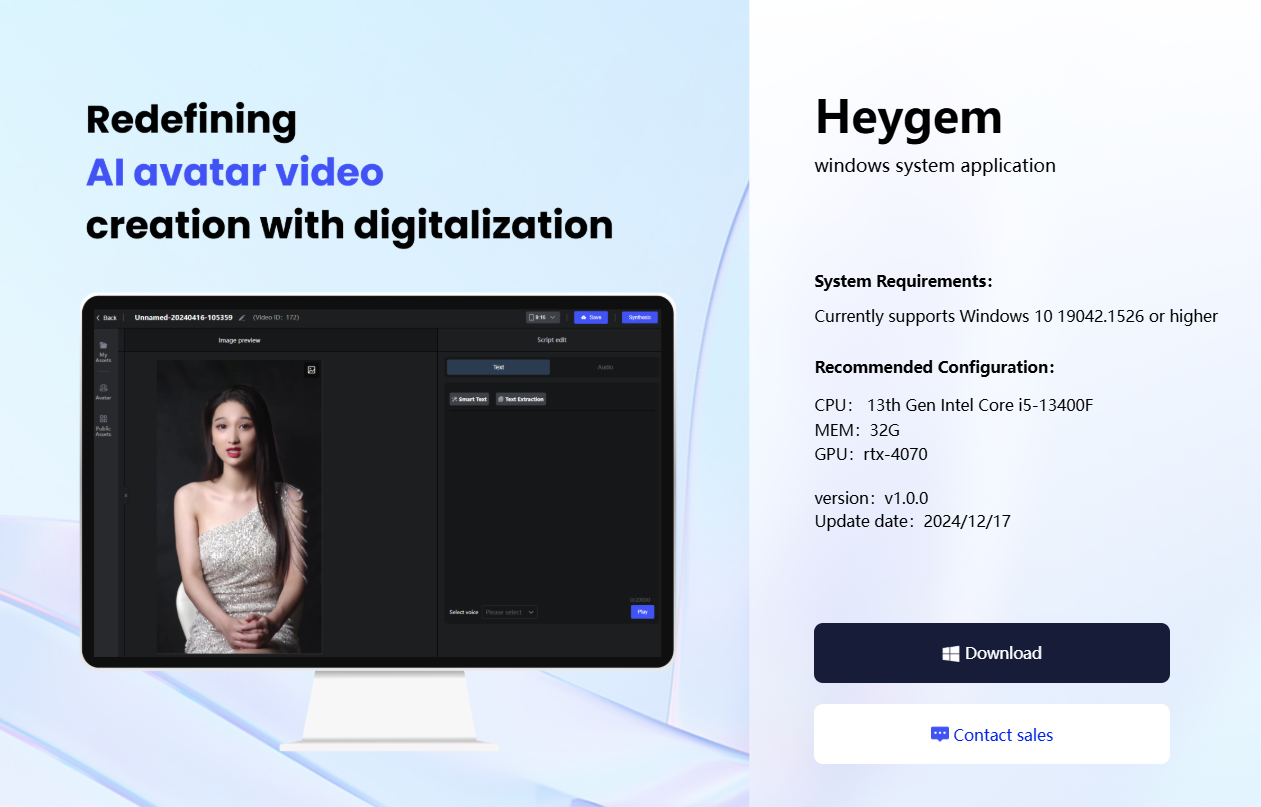

- Systemanforderungen::

- Unterstützt derzeit Windows 10 19042.1526 oder höher

- Empfohlene Konfigurationen::

- CPU: 13. Generation Intel Core i5-13400F

- Speicher: 32GB

- Grafikkarte: RTX-4070

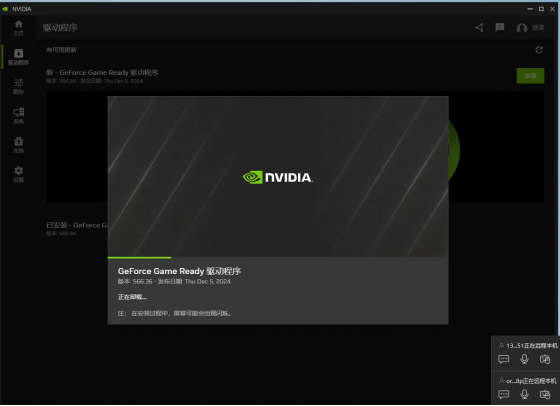

- Vergewissern Sie sich, dass Sie eine NVIDIA-Grafikkarte haben und dass die Treiber korrekt installiert sind.

- NVIDIA-Treiber-Download-Link: https://www.nvidia.cn/drivers/lookup/

- NVIDIA-Treiber-Download-Link: https://www.nvidia.cn/drivers/lookup/

Installation von Windows Docker

- Befehle verwenden

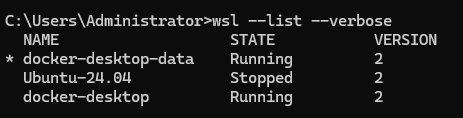

wsl --list --verbosePrüfen Sie, ob WSL installiert ist. Die folgende Abbildung zeigt, dass sie installiert ist und nicht neu installiert werden muss:

- WSL-Installationsbefehle:

wsl --install - Kann aufgrund von Netzwerkproblemen fehlschlagen, bitte versuchen Sie es mehrmals

- Während des Installationsvorgangs müssen Sie einen neuen Benutzernamen und ein neues Kennwort einrichten und sich diese merken.

- WSL-Installationsbefehle:

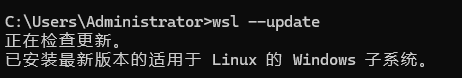

- ausnutzen

wsl --updateWSL aktualisieren:

- Laden Sie Docker für Windows herunter und wählen Sie ein Installationsprogramm, das für Ihre CPU-Architektur geeignet ist.

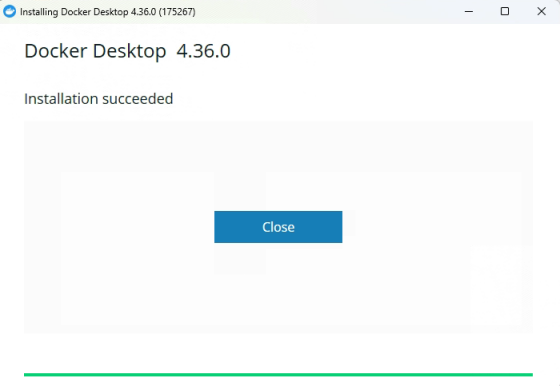

- Dieser Bildschirm zeigt die erfolgreiche Installation an:

- Docker ausführen:

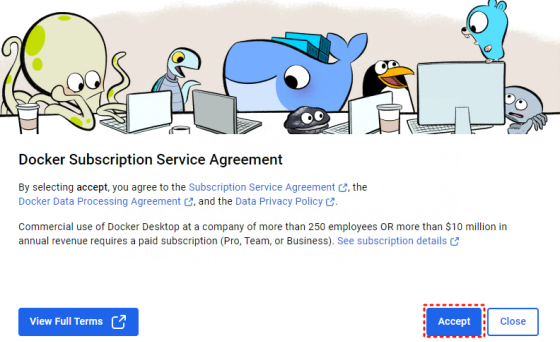

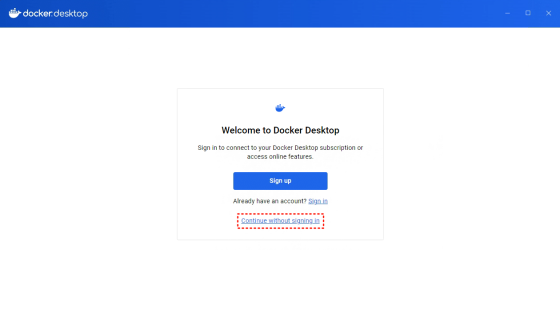

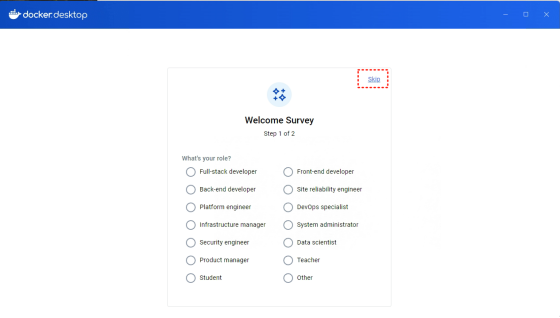

- Akzeptiert das Protokoll und überspringt die Anmeldung beim ersten Durchlauf:

Installieren des Servers

Installieren Sie die folgenden Komponenten mit Docker und docker-compose:

docker-compose.ymlDie Datei befindet sich im Verzeichnis/deployKatalog.- existieren

/deployVerzeichnis zur Ausführung derdocker-compose up -d. - Warten Sie geduldig (ca. eine halbe Stunde, je nach Internetgeschwindigkeit), der Download wird ca. 70 GB Traffic verbrauchen, bitte stellen Sie sicher, dass Sie WiFi benutzen.

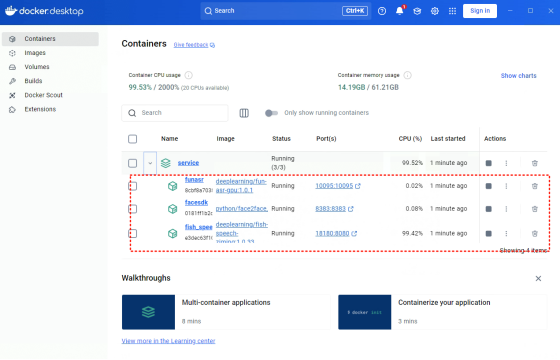

- Ein Erfolg wird angezeigt, wenn drei Dienste in Docker zu sehen sind:

Kunde

- Skript erstellen

npm run build:winNach der Ausführung wird es in derdistKatalogerstellungHeyGem-1.0.0-setup.exe. - Doppelklick

HeyGem-1.0.0-setup.exeFühren Sie die Installation durch.

Abhängigkeiten

- Nodejs 18

- Docker-Image:

docker pull guiji2025/fun-asr:1.0.1docker pull guiji2025/fish-speech-ziming:1.0.39docker pull guiji2025/heygem.ai:0.0.7_sdk_slim

Hauptfunktionen

1. das Klonen des Aussehens und der Stimme

- Material vorbereiten

- Nehmen Sie eine klare Stimme auf (10-30 Sekunden im WAV-Format) und geben Sie sie in den

D:\heygem_data\voice\data. - Machen Sie ein hochauflösendes Foto der Vorderseite und legen Sie es in die

D:\heygem_data\face2face(Die Pfade finden Sie in derdocker-compose.yml(Angepasst in).

- Nehmen Sie eine klare Stimme auf (10-30 Sekunden im WAV-Format) und geben Sie sie in den

- Klon-Funktion ausführen

- Starten Sie den Client, öffnen Sie die Oberfläche und wählen Sie "Model Training".

- Aufrufen der API

http://127.0.0.1:18180/v1/preprocess_and_tranEingabeparameter wie z.B.:{ "format": ".wav", "reference_audio": "D:/heygem_data/voice/data/sample.wav", "lang": "zh" } - Holen Sie sich die zurückgegebenen Ergebnisse (z. B. Audiopfad und Text) und speichern Sie sie zur späteren Verwendung.

2. textgesteuerte virtuelle Bilder

- Eingabetext

- Wählen Sie in der Client-Oberfläche "Audio Synthesis" und rufen Sie die API auf.

http://127.0.0.1:18180/v1/invokeEingabeparameter wie z.B.:{ "speaker": "unique-uuid", "text": "欢迎体验 HeyGem.ai", "format": "wav", "topP": 0.7, "max_new_tokens": 1024, "chunk_length": 100, "repetition_penalty": 1.2, "temperature": 0.7, "need_asr": false, "streaming": false, "is_fixed_seed": 0, "is_norm": 0, "reference_audio": "返回的音频路径", "reference_text": "返回的文本" }

- Wählen Sie in der Client-Oberfläche "Audio Synthesis" und rufen Sie die API auf.

- Video generieren

- Verwendung der Synthese-Schnittstelle

http://127.0.0.1:8383/easy/submitEingabeparameter wie z.B.:{ "audio_url": "生成的音频路径", "video_url": "D:/heygem_data/face2face/sample.mp4", "code": "unique-uuid", "chaofen": 0, "watermark_switch": 0, "pn": 1 } - Erkundigen Sie sich nach den Fortschritten:

http://127.0.0.1:8383/easy/query?code=unique-uuid.

- Verwendung der Synthese-Schnittstelle

- Ergebnisse speichern

- Wenn Sie fertig sind, wird die Videodatei lokal im angegebenen Pfad gespeichert.

3. sprachgesteuerte Videoproduktion

- Stimme aufnehmen

- Nehmen Sie Ihre Stimme im Client auf, oder laden Sie WAV-Dateien direkt in den

D:\heygem_data\voice\data.

- Nehmen Sie Ihre Stimme im Client auf, oder laden Sie WAV-Dateien direkt in den

- Video generieren

- Rufen Sie die oben genannten Audio- und Video-Compositing-APIs auf, um ein Avatar-Video mit Aktionen zu erzeugen.

- Vorschau und Anpassung

- Der Effekt wird über den Client in der Vorschau angezeigt und kann nach Anpassung der Parameter neu generiert werden.

Tipps und Tricks

- MaterialbedarfFotos müssen gleichmäßig beleuchtet sein und Sprache muss frei von Rauschen sein.

- Unterstützung mehrerer Sprachen: eingestellt in den API-Parametern

langist der entsprechende Sprachcode (z. B. "zh" für Chinesisch). - Unterstützung für Entwickler: Referenz

src/main/serviceUnterhalb des Codes können Sie die Funktionalität anpassen.

caveat

- Das System muss die Platzanforderungen von 100 GB für Laufwerk C und 30 GB für Laufwerk D erfüllen.

- Stellen Sie vor der Installation von Docker sicher, dass WSL aktiviert ist.

- Für das Herunterladen des Images sind 70 GB Datenvolumen erforderlich, ein stabiles WiFi wird empfohlen.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...