HealthGPT: Ein medizinisches Großmodell zur Unterstützung der medizinischen Bildanalyse und diagnostischer Fragen

Allgemeine Einführung

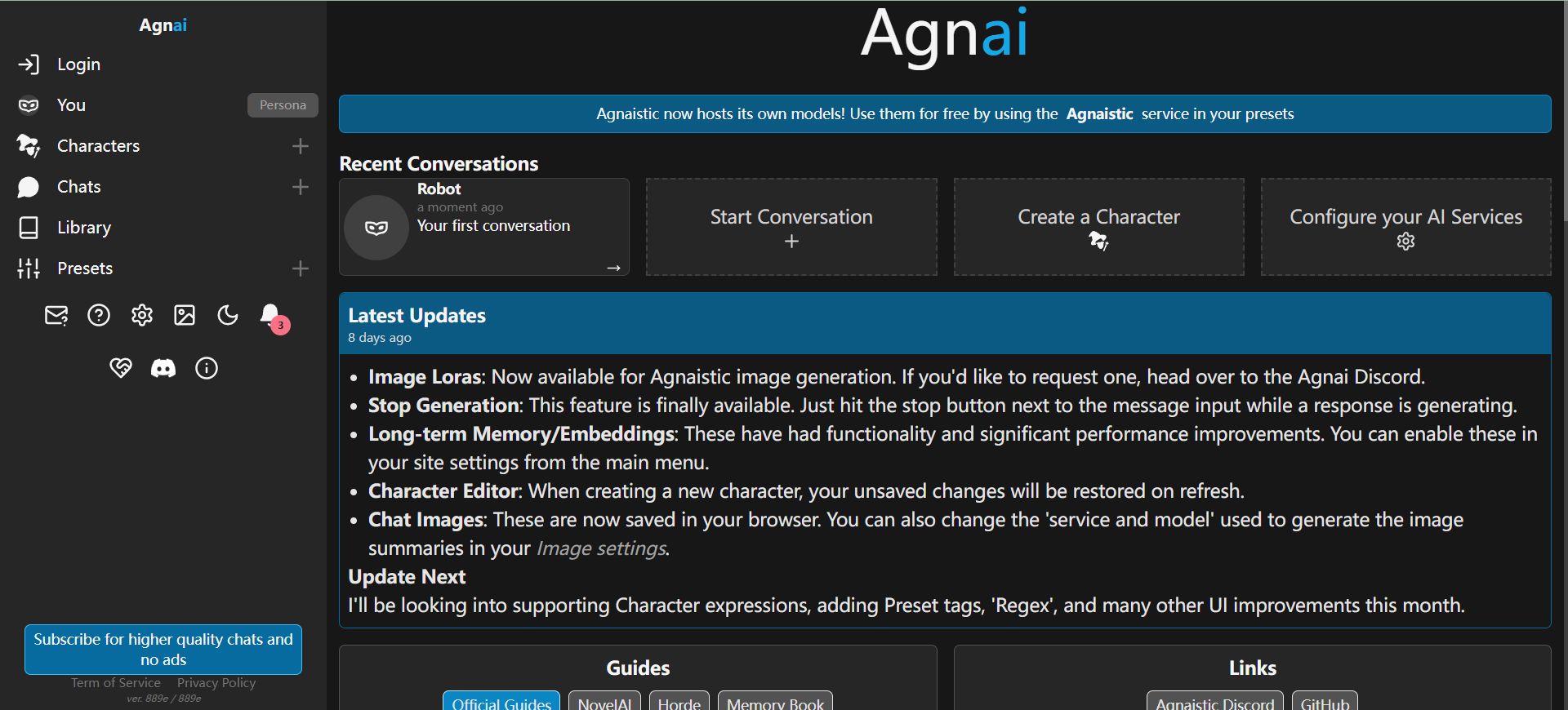

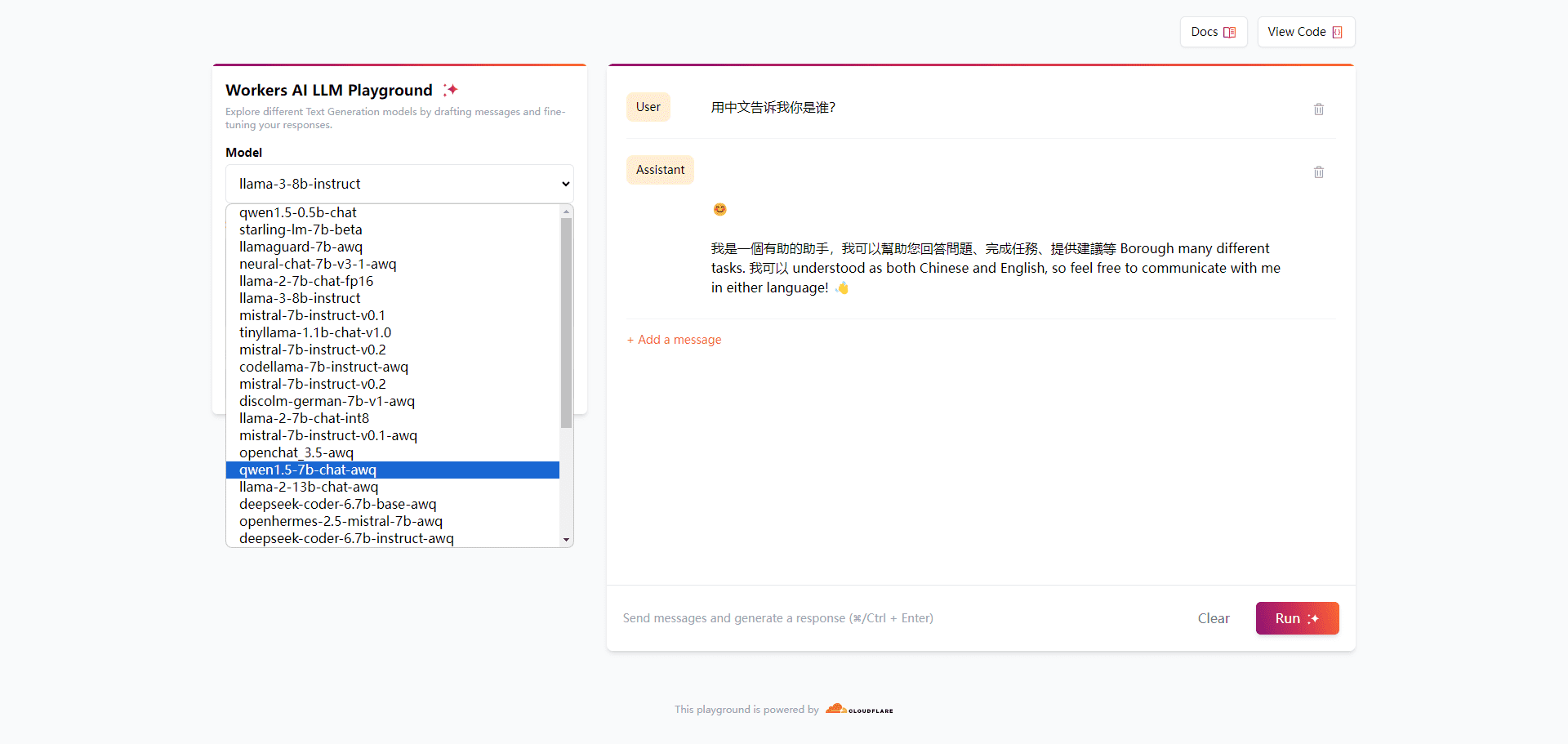

HealthGPT ist ein hochmodernes medizinisches visuelles Sprachmodell, das darauf abzielt, ein einheitliches medizinisches visuelles Verständnis und Generierungsfähigkeiten durch heterogene Wissensanpassung zu erreichen. Das Ziel des Projekts ist die Integration von medizinischen visuellen Verstehens- und Generierungsfähigkeiten in einen einheitlichen autoregressiven Rahmen, der die Effizienz und Genauigkeit der medizinischen Bildverarbeitung erheblich verbessert.HealthGPT unterstützt eine breite Palette von medizinischen Verstehens- und Generierungsaufgaben und ist in der Lage, in verschiedenen medizinischen Bildverarbeitungsszenarien gut zu funktionieren. Das Projekt wurde gemeinsam von der Zhejiang University, der University of Electronic Science and Technology, Alibaba, der Hong Kong University of Science and Technology, der National University of Singapore und vielen anderen Organisationen entwickelt und hat einen hohen Forschungs- und Praxiswert.

Funktionsliste

- Medizinische visuelle Fragen und Antworten: Unterstützt eine breite Palette medizinischer Bilder für Fragen und Antworten und beantwortet präzise medizinische Fragen, die von Benutzern gestellt werden.

- Medizinische Bilderzeugung: Erzeugung qualitativ hochwertiger medizinischer Bilder zur Unterstützung der medizinischen Diagnose und Forschung.

- Unterstützung der Aufgabenklassifizierung: Unterstützt 7 Arten von medizinischen Verstehensaufgaben und 5 Arten von medizinischen Generierungsaufgaben, die ein breites Spektrum von medizinischen Anwendungsszenarien abdecken.

- Modellarchitektur: textliche und visuelle Inhalte werden mit Hilfe hierarchischer visueller Wahrnehmung und H-LoRA-Plugins generiert, wobei visuelle Merkmale und H-LoRA-Plugins ausgewählt werden.

- Multiversionsmodell: HealthGPT-M3 und HealthGPT-L14 werden in verschiedenen Konfigurationen angeboten, um sich an unterschiedliche Bedürfnisse und Ressourcen anzupassen.

Hilfe verwenden

Einbauverfahren

- Vorbereiten der Umgebung

Klonen Sie zunächst das Projekt und erstellen Sie eine Python-Laufzeitumgebung:git clone https://github.com/DCDmllm/HealthGPT.git cd HealthGPT conda create -n HealthGPT python=3.10 conda activate HealthGPT pip install -r requirements.txt

- Gewichte vor dem Training vorbereiten

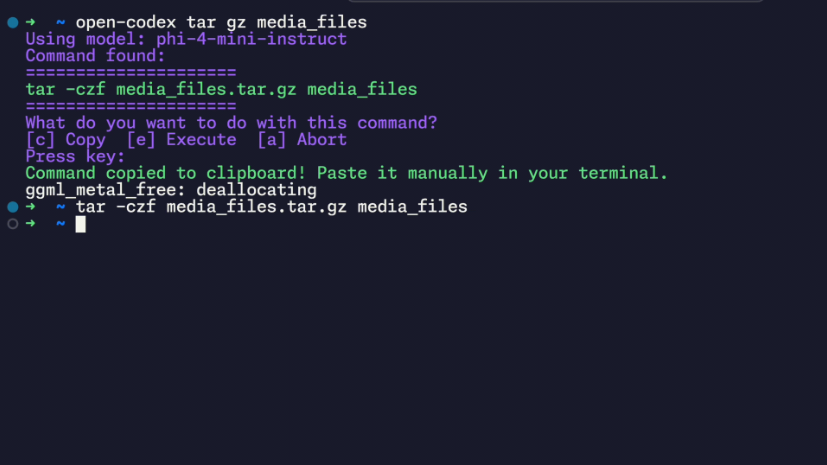

Verwendung von HealthGPTclip-vit-large-patch14-336Als visuelle Encoder basieren HealthGPT-M3 und HealthGPT-L14 jeweils aufPhi-3-mini-4k-instructim Gesang antwortenphi-4Vorschulung.

Laden Sie die erforderlichen Modellgewichte herunter und legen Sie sie im entsprechenden Verzeichnis ab:- ViT Modellierung:Download-Link

- HealthGPT-M3 Basismodell:Download-Link

- HealthGPT-L14 Basismodell:Download-Link

- VQGAN-Modell:Download-Link

- Vorbereitung von H-LoRA und Adaptergewichten

Laden Sie H-LoRA-Gewichte herunter und platzieren Sie sie, um das medizinische Bildverständnis und die Generierungsmöglichkeiten des Modells zu verbessern. Die vollständigen Gewichte werden bald veröffentlicht, also bleiben Sie dran.

Inferenz

Medizinische Vision Q&A

- Laden Sie die erforderlichen Dokumente herunter

- Skriptpfad aktualisieren

zeigen (eine Eintrittskarte)llava/demo/com_infer.shSkriptes ändern Sie die folgende Variable in den Pfad der heruntergeladenen Datei:- MODEL_NAME_OR_PATH: Pfad oder Bezeichner des Basismodells

- VIT_PATH: Gewichtungspfad des visuellen Transformationsmodells

- HLORA_PATH: Visuelles Verständnis von H-LoRA Gewichtsverläufen

- FUSION_LAYER_PATH: Gewichtspfad der Fusionsschicht

- Laufende Skripte

cd llava/demo bash com_infer.shEs ist auch möglich, Python-Befehle direkt auszuführen:

python3 com_infer.py \ --model_name_or_path "microsoft/Phi-3-mini-4k-instruct" \ --dtype "FP16" \ --hlora_r "64" \ --hlora_alpha "128" \ --hlora_nums "4" \ --vq_idx_nums "8192" \ --instruct_template "phi3_instruct" \ --vit_path "openai/clip-vit-large-patch14-336/" \ --hlora_path "path/to/your/local/com_hlora_weights.bin" \ --fusion_layer_path "path/to/your/local/fusion_layer_weights.bin" \ --question "Your question" \ --img_path "path/to/image.jpg"

Rekonstruktion von Bildern

Oberbefehlshaber (Militär)HLORA_PATHeingestellt aufgen_hlora_weights.binDateipfad und konfigurieren Sie andere Modellpfade:

cd llava/demo

bash gen_infer.sh

Sie können den folgenden Python-Befehl auch direkt ausführen:

python3 gen_infer.py \

--model_name_or_path "microsoft/Phi-3-mini-4k-instruct" \

--dtype "FP16" \

--hlora_r "256" \

--hlora_alpha "512" \

--hlora_nums "4" \

--vq_idx_nums "8192" \

--instruct_template "phi3_instruct" \

--vit_path "openai/clip-vit-large-patch14-336/" \

--hlora_path "path/to/your/local/gen_hlora_weights.bin" \

--fusion_layer_path "path/to/your/local/fusion_layer_weights.bin" \

--question "Reconstruct the image." \

--img_path "path/to/image.jpg" \

--save_path "path/to/save.jpg"© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...