Hallo2: Audio-gesteuerte Erzeugung von lippensynchronen/ausdrucks-synchronen Portraitvideos (Ein-Klick-Installation für Windows)

Allgemeine Einführung

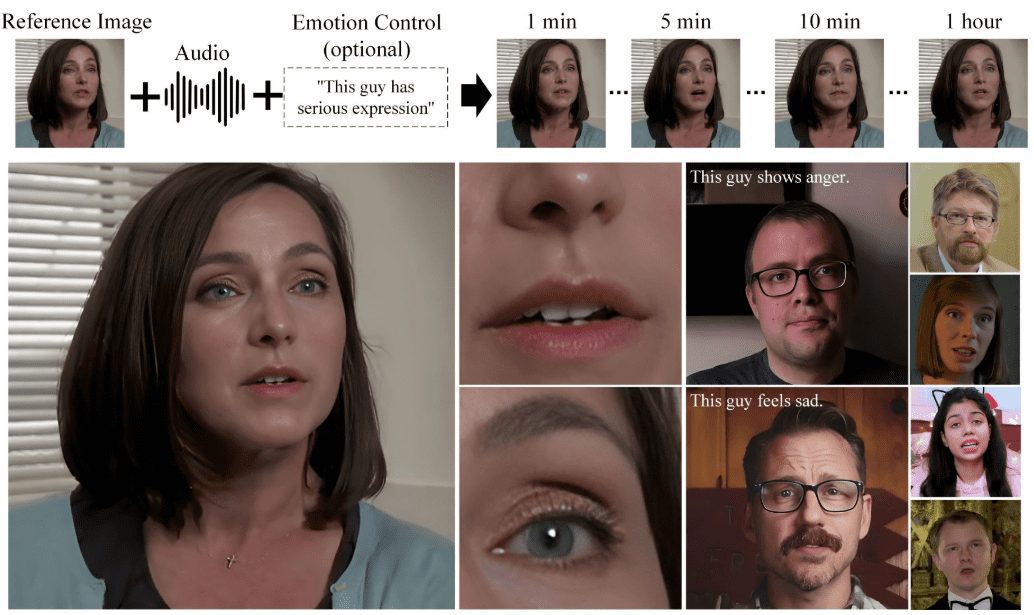

Hallo2 ist ein Open-Source-Projekt, das gemeinsam von der Fudan-Universität und Baidu entwickelt wurde, um hochauflösende Porträtanimationen durch audiogesteuerte Generierung zu erzeugen. Das Projekt nutzt fortschrittliche Generative Adversarial Networks (GAN) und Techniken zur zeitlichen Ausrichtung, um eine 4K-Auflösung und eine Videogeschwindigkeit von bis zu einer Stunde zu erreichen. Hallo2 unterstützt auch Textaufforderungen, um die Vielfalt und Kontrollierbarkeit der generierten Inhalte zu verbessern.

Hallo3 wurde veröffentlicht und ermöglicht die Audiokonditionierung durch die Einführung eines Cross-Attention-Mechanismus, der die komplexe Beziehung zwischen Audiosignalen und Gesichtsausdrücken effektiv erfasst und eine bemerkenswerte Lippensynchronisation erreicht.

Beachten Sie, dass:Hallo3 die folgenden einfachen Anforderungen an die Eingabedaten für die Inferenz hat:

Referenzbild: Das Referenzbild muss ein Seitenverhältnis von 1:1 oder 3:2 haben. Treiber-Audio: Das Treiber-Audio muss im WAV-Format vorliegen. Audiosprache: Das Audio muss in Englisch sein, da der Trainingsdatensatz des Modells nur diese Sprache enthält. Audioklarheit: Stellen Sie sicher, dass der Gesang klar und deutlich zu hören ist; Hintergrundmusik ist akzeptabel.

Funktionsliste

- Audiogesteuerte AnimationserstellungGenerieren Sie die entsprechende Porträtanimation, indem Sie eine Audiodatei eingeben.

- Unterstützung für hohe AuflösungUnterstützung für die Erstellung von Videos mit 4K-Auflösung, um eine klare Bildqualität zu gewährleisten.

- Erzeugung langer VideosKann Videoinhalte mit einer Länge von bis zu 1 Stunde erstellen.

- Erweiterung der Text-WarnungenSteuerung der generierten Porträtausdrücke und Aktionen durch semantische Textbeschriftungen.

- offene QuelleVollständiger Quellcode und vortrainierte Modelle werden bereitgestellt, um die Sekundärentwicklung zu erleichtern.

- Unterstützung mehrerer PlattformenUnterstützt die Ausführung auf mehreren Plattformen wie Windows, Linux, etc.

Hilfe verwenden

Einbauverfahren

- Systemanforderungen::

- Betriebssystem: Ubuntu 20.04/22.04

- GPU: Grafikkarte mit Unterstützung für CUDA 11.8 (z. B. A100)

- Erstellen einer virtuellen Umgebung::

conda create -n hallo python=3.10 conda activate hallo - Installation von Abhängigkeiten::

pip install torch==2.2.2 torchvision==0.17.2 torchaudio==2.2.2 --index-url https://download.pytorch.org/whl/cu118 pip install -r requirements.txt sudo apt-get install ffmpeg - Herunterladen des vortrainierten Modells::

git lfs install git clone https://huggingface.co/fudan-generative-ai/hallo2 pretrained_models

Verwendungsprozess

- Vorbereiten der Dateneingabe::

- Laden Sie das benötigte trainierte Modell herunter und bereiten Sie es vor.

- Bereiten Sie das Quellbild und die Treiber-Audiodateien vor.

- Ausführen von Inferenzskripten::

python scripts/inference.py --source_image path/to/image --driving_audio path/to/audio - Generierte Ergebnisse anzeigen::

- Die erzeugte Videodatei wird im angegebenen Ausgabeverzeichnis gespeichert und kann mit einem beliebigen Videoplayer angesehen werden.

Detaillierte Schritte

- Code herunterladen::

git clone https://github.com/fudan-generative-vision/hallo2 cd hallo2 - Erstellen und Aktivieren einer virtuellen Umgebung::

conda create -n hallo python=3.10 conda activate hallo - Installieren Sie die erforderlichen Python-Pakete::

pip install torch==2.2.2 torchvision==0.17.2 torchaudio==2.2.2 --index-url https://download.pytorch.org/whl/cu118 pip install -r requirements.txt - ffmpeg installieren::

sudo apt-get install ffmpeg - Herunterladen des vortrainierten Modells::

git lfs install git clone https://huggingface.co/fudan-generative-ai/hallo2 pretrained_models - Ausführen von Inferenzskripten::

python scripts/inference.py --source_image path/to/image --driving_audio path/to/audio - Generierte Ergebnisse anzeigen::

- Die erzeugte Videodatei wird im angegebenen Ausgabeverzeichnis gespeichert und kann mit einem beliebigen Videoplayer angesehen werden.

Hallo2: Windows Ein-Klick-Installationsprogramm

https://pan.quark.cn/s/aa9fc15a786f

Auszugsnummer: 51XY

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...