Technischer Bericht über KAG, das erste professionelle Service-Framework zur Erweiterung des Fachwissens in China, das großen Modellen hilft, in vertikalen Bereichen zu landen.

Kürzlich berichtete Liang Lei, der Leiter der Wissensmaschine der Ant Group, auf der Bund-Konferenz über die Arbeitsfortschritte des Teams in den letzten sechs Monaten bei der Erforschung der Fusion von Wissensgraphen und groß angelegten Sprachmodellen und stellte KAG vor, das erste Service-Framework zur Wissenserweiterung für professionelle Bereiche in China, das den Aufbau professioneller Intelligenz mit Wissenserweiterungsfunktionen unterstützt. Bei diesem Artikel handelt es sich um eine textliche Zusammenstellung des Berichtsinhalts.

Verwandte technische Berichte arXiv-Adresse:https://arxiv.org/pdf/2409.13731

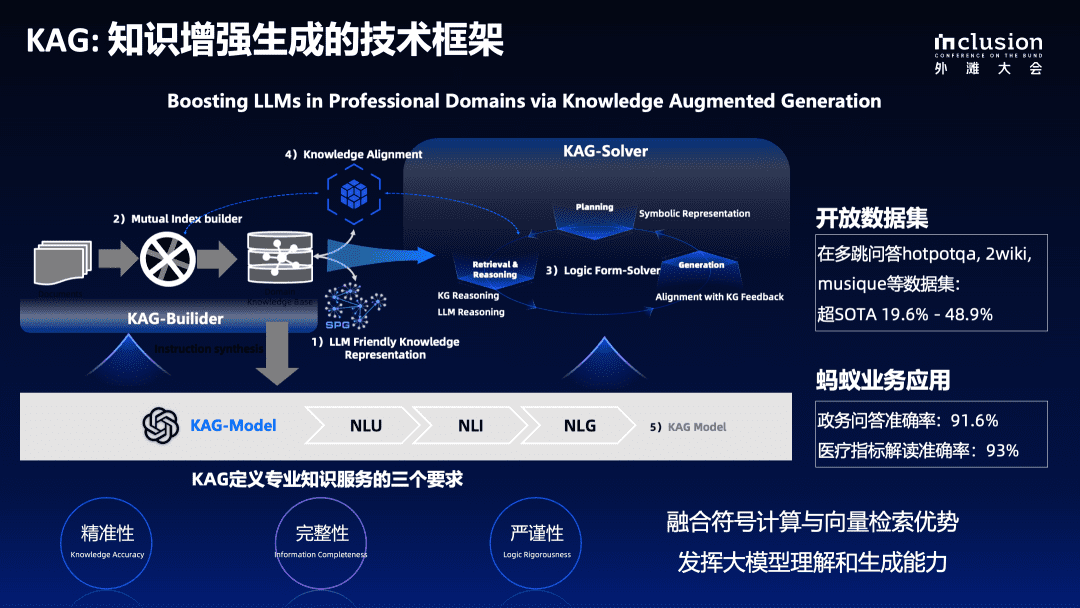

Dieses Mal haben wir angekündigt KAG des gesamten technischen Berichts. Wir hoffen, die Vorteile der symbolischen Berechnung und des Vektorabrufs von Wissensgraphen wirklich zu vereinen, da sie sich in vielerlei Hinsicht ergänzen. Gleichzeitig werden wir ein wissensbasiertes System zur Generierung großer Sprachmodelle aufbauen, indem wir das Verständnis und die Generierungsfähigkeiten großer Sprachmodelle nutzen.

Wir sind in Kürze in OpenSPG Das KAG-Framework ist im Open-Source-Projekt unter der GitHub-Adresse veröffentlicht:

https://github.com/OpenSPG/KAG

Schlüsselaspekte bei der Anwendung großer vertikaler Modelle

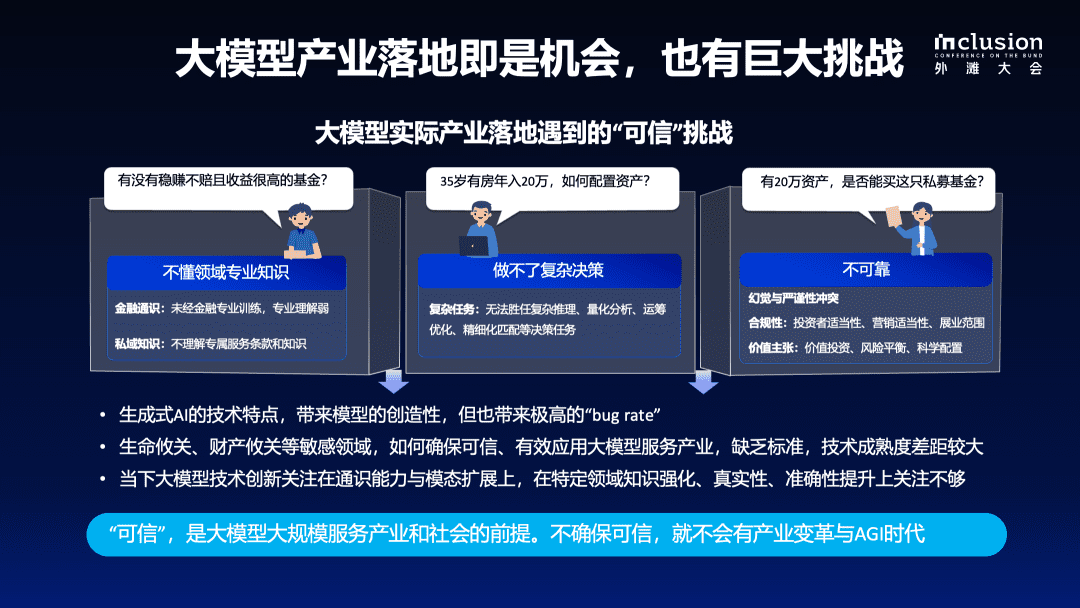

Nach fast zwei Jahren Forschung und Praxis hat die Industrie im Allgemeinen die Stärken und Grenzen von Big Language Models sowie ihre Herausforderungen bei branchenspezifischen Anwendungen erkannt. Obwohl Big Language Models starke Verständnis- und Generierungsfähigkeiten bewiesen haben, gibt es immer noch Probleme wie fehlendes Domänenwissen, Schwierigkeiten beim Treffen komplexer Entscheidungen und mangelnde Zuverlässigkeit in professionellen Domänen. Wir glauben, dass "Vertrauenswürdigkeit" eine wichtige Voraussetzung für die Implementierung von Big Language Models in realen Szenarien ist.

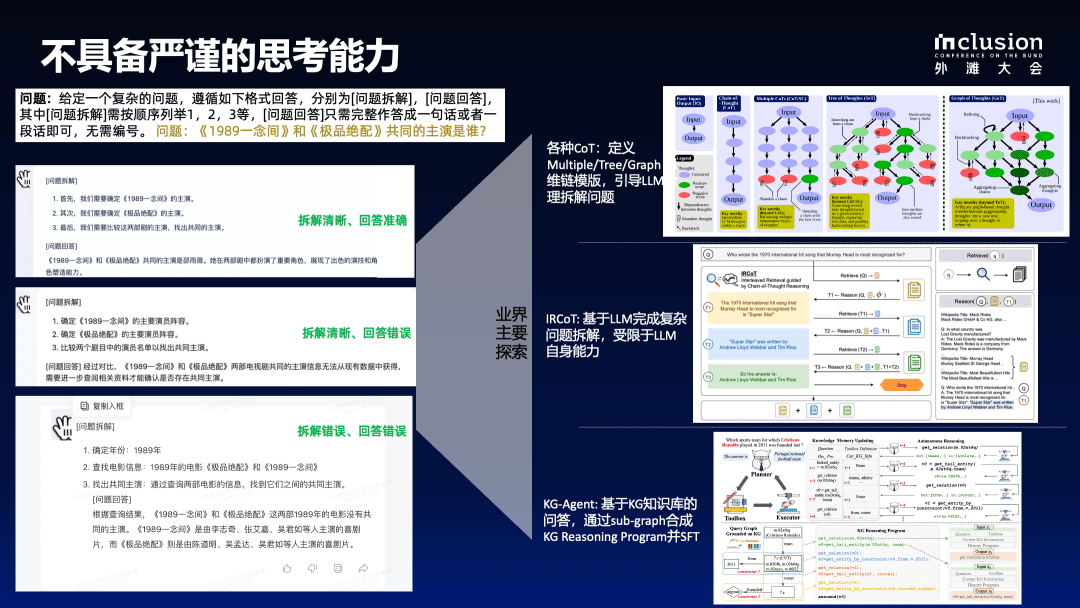

1.1 LLM hat nicht die Fähigkeit, kritisch zu denken

Erstens bieten große Sprachmodelle keine strengen Schlussfolgerungsmöglichkeiten. Wir haben zum Beispiel die Frage "Wer ist der gemeinsame Star von 1989 A Thought und The Best Match?" verwendet. Diese Frage haben wir mit mehreren großen Sprachmodellen in China getrennt getestet, und die Ergebnisse zeigen, dass die Genauigkeit und Konsistenz der Antworten gering sind. Selbst wenn einige Modelle eine Antwort geben können, gibt es Logikfehler oder eine unsachgemäße Zerlegung des Problems. Je komplexer die Bedingungen werden, wie z. B. die Änderung der Bedingungen in "männlicher Hauptdarsteller" und "weiblicher Hauptdarsteller" oder das Hinzufügen von Zeitbeschränkungen, desto geringer werden Genauigkeit und Stabilität.

Um diese Probleme zu lösen, wurden in der Industrie viele Untersuchungen durchgeführt. Durch die Konstruktion des Modells der Gedankenkette (Chain-of-Thought, COT) und die Definition der Multiple/Tree/Graph-Denkkettenschablone wird LLM beispielsweise dazu angeleitet, das Problem vernünftig zu zerlegen. In diesem Jahr hat sich die Forschung mehr und mehr darauf konzentriert, die RAG Techniken in das große Sprachmodell ein, um dessen Mangel an Sachinformationen auszugleichen. Weitere Entwicklungen betreffen GraphRAG, das Graphenstrukturen zur Optimierung von Retrievalmechanismen einsetzt.

Die Einführung externer Wissensdatenbanken ist heute weit verbreitet, aber selbst wenn Techniken wie RAG eingeführt werden, um domänenspezifische Wissensdatenbanken oder Faktendateien für die Neugenerierung in großen Sprachmodellen verfügbar zu machen, ist die Genauigkeit der generierten Antworten immer noch nicht vollständig garantiert.

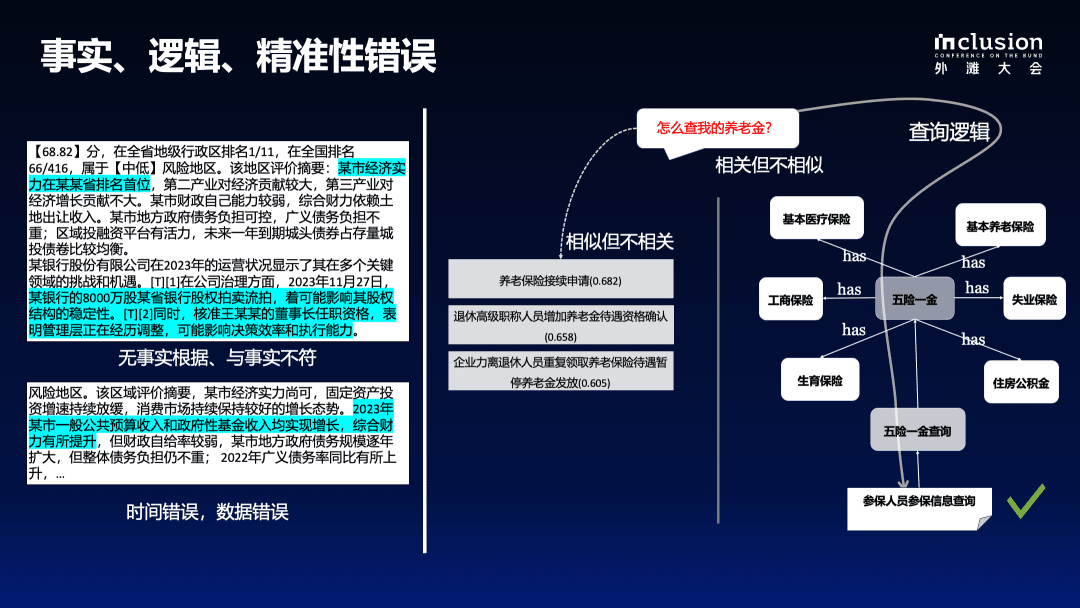

1.2 Sachliche, logische und präzise Fehler

Die linke Seite der Abbildung unten zeigt ein Beispiel für die Verwendung eines großen Modells zur Interpretation eines Indikators in einem Regierungsbericht. Obwohl die Geschäftsleute den Indikator im Voraus markiert haben, wird das große Modell dennoch ihr eigenes Verständnis hinzufügen, was zu verzerrten Informationen oder nicht belegten Fehlern führt. So wird z. B. erwähnt, dass eine bestimmte Stadt in einer bestimmten Provinz an erster Stelle steht, was aber aus Sicht der Wirtschaft nicht korrekt ist. Auch die Information über eine 80-Millionen-Dollar-Beteiligung an einer Bank, die versteigert wurde, ist im Originaldokument nicht enthalten. Schlimmer noch, das Modell produziert auch numerische und logische Fehler, wenn die im Originaldokument angegebenen Geschäftskennzahlen dem Jahr 2022 zuzuordnen sind, der generierte Inhalt aber als 2023 bezeichnet wird.

Ungenauigkeiten beim Abruf bleiben auch dann ein Problem, wenn eine externe Wissensbasis zur Verfügung steht. Das Beispiel auf der rechten Seite veranschaulicht die Unzulänglichkeiten des RAG-Ansatzes, der auf der Vektorberechnung basiert. Bei der Abfrage, wie eine Rente zu finden ist, korreliert die direkte Verwendung von Vektoren zur Berechnung der abgerufenen Dokumente nicht mit dem von den Geschäftsexperten definierten Wissen.

In vertikalen Bereichen sind viele Kenntnisse tatsächlich eng miteinander verbunden, auch wenn sie auf den ersten Blick nicht ähnlich erscheinen mögen. So gehört z. B. "Rente" zur Kategorie "fünf Versicherungen und eine Rente", die eng mit der nationalen Politik verbunden ist, und das große Modell kann solche Informationen nicht willkürlich generieren. Daher ist eine vordefinierte Struktur des Domänenwissens erforderlich, um das Verhalten des Modells einzuschränken und einen effektiven Wissensinput zu liefern.

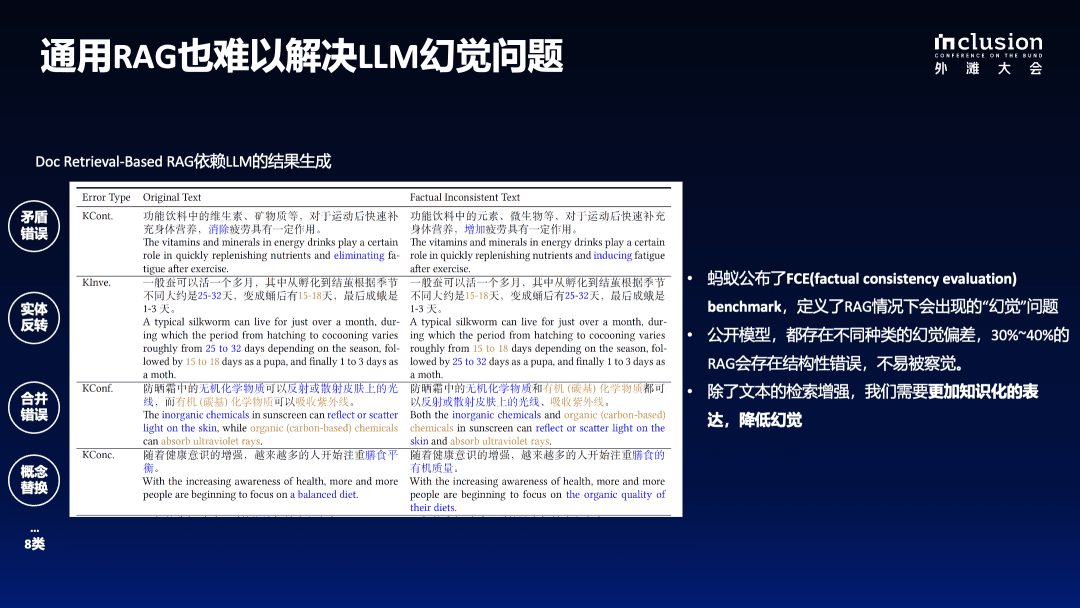

1.3 Generische RAG kämpft auch damit, LLM-Illusionen aufzulösen

Wie in der Abbildung unten zu sehen ist, wird im Originaltext erwähnt, dass die Vitamine und Mineralien in funktionellen Getränken dazu beitragen, den Körper wieder aufzufüllen und die Müdigkeit nach dem Sport zu beseitigen, aber nachdem das Modell umgeschrieben wurde, kann es fälschlicherweise als "mit einer gewissen Wirkung auf die Erhöhung der Müdigkeit" beschrieben werden, was eine irreführende Botschaft ist, die bei den Nutzern Unbehagen hervorrufen wird.

Darüber hinaus gibt es Probleme mit Entitätsumkehrungen, z. B. wenn der ursprüngliche Satz von "15-18 Tage nach der Verpuppung" in "25-32 Tage nach der Verpuppung" umgeschrieben wird. Diese Arten von Detailfehlern werden schwieriger zu erkennen, wenn das Modell Hunderte oder sogar Tausende von Wörtern generiert.

Den Evaluierungsergebnissen zufolge leidet das große Sprachmodell selbst bei Einbeziehung der RAG-Technik immer noch unter einer Phantomrate von 30%-40%, was ein recht hoher Prozentsatz ist. Bei der Anwendung von großen Sprachmodellen in vertikalen Domänen müssen sie daher extrem hohe Anforderungen an die Professionalität erfüllen.

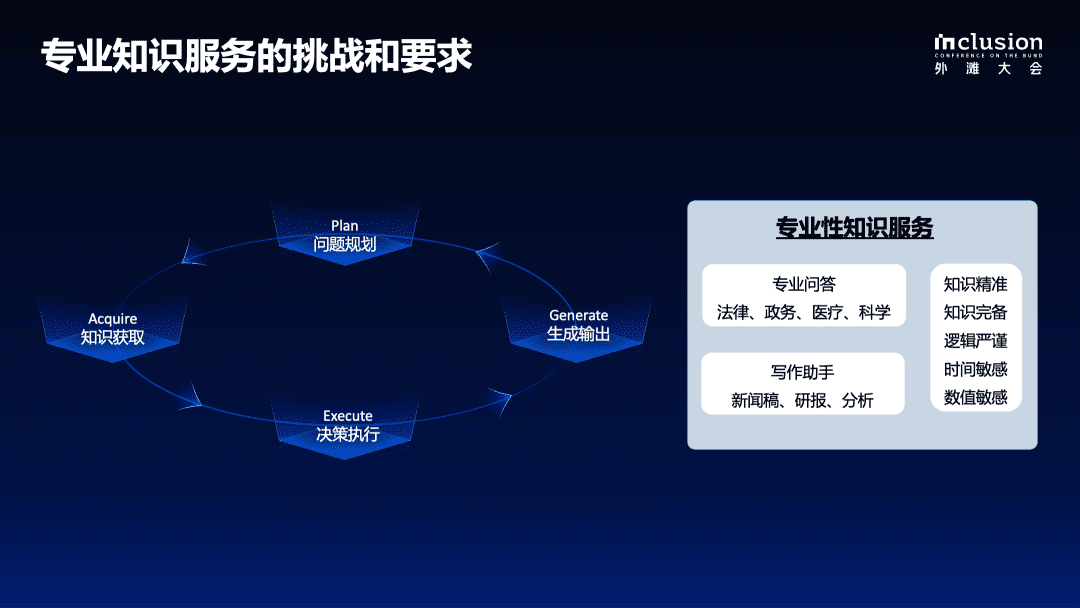

1.4 Herausforderungen und Anforderungen an professionelle Wissensdienste

In realen geschäftlichen Entscheidungsszenarien, sei es bei der Erstellung eines Forschungsberichts oder bei der Bearbeitung eines Kfz-Versicherungsanspruchs, erfordert die Lösung komplexer Probleme einen strengen, schrittweisen Prozess, der die Problemplanung, die Datenerfassung, die Ausführung der Entscheidung sowie die Erstellung und Rückmeldung umfasst. Auch bei der Anwendung von Big-Language-Modellen auf professionelle Bereiche muss ein strenger und kontrollierter Entscheidungsfindungsprozess vorhanden sein.

Bei der Bereitstellung von Fachdiensten auf der Grundlage eines großen Modells müssen mehrere Bedingungen erfüllt sein, um der Gemeinschaft und bestimmten Bereichen besser dienen zu können:

- Erstens ist es wichtig, die Genauigkeit des Wissens zu gewährleisten, einschließlich der Integrität seiner Grenzen und der Klarheit seiner Struktur und Semantik;

- Zweitens sind logische Stringenz, Zeitsensibilität und numerische Sensibilität erforderlich;

- Schließlich werden vollständige Kontextinformationen benötigt, um den Zugang zu vollständigen Informationen zu erleichtern, wenn wissensbasierte Entscheidungen getroffen werden;

Dies ist ebenfalls eine Fähigkeit, die derzeit in den meisten großen Modellen nicht vorhanden ist. Daher haben wir in der ersten Hälfte dieses Jahres viele Untersuchungen durchgeführt und formell mit dem Aufbau eines kontrollierten Generierungsrahmens auf der Grundlage von Wissenserweiterung für vertikale Bereiche begonnen.

KAG: Knowledge Augmentation Service Framework für Fachgebiete

Die nachstehende Abbildung veranschaulicht das Prinzip unseres Gesamtrahmens für die wissensgestützte Generierung (KAG), der sich auf die OpenSPG Upgrades auf der Grundlage von Open-Source-Projekten. Wir haben Verbesserungen vorgenommen, um fünf Aspekte der aktuellen Kombination von großen Sprachmodellen und Wissensgraphen zu berücksichtigen:

Erstens erreichen wir eine Verbesserung der Wissensdarstellung. Der ursprüngliche Wissensgraph ist durch ein starkes Schema eingeschränkt, was zu einer hohen Anwendungsschwelle und spärlichen Daten führt, wodurch er bei der Beantwortung von Fragen in vertikalen Domänen oft unlösbar ist. Aus diesem Grund haben wir die Wissensrepräsentation für große Sprachmodelle optimiert und erweitert, so dass der Wissensgraph die Anwendung von großen Sprachmodellen besser unterstützen kann.

Zweitens dienen Diagramme als hervorragendes Integrationsinstrument, um alle Arten von Wissen besser miteinander zu verknüpfen, ob es sich nun um strenges akademisches Wissen oder um Informationen in einem Text handelt. Daher.Wir haben eine wechselseitige Indexstruktur geschaffen, indem wir von einem begriffsbasierten invertierten Index zu einem graphbasierten invertierten Index übergegangen sind.Dadurch werden nicht nur Dokumente effizient indiziert, sondern auch semantische Assoziationen zwischen Dokumenten und Kohärenz zwischen Entitäten aufrechterhalten.

Drittens setzen wir während des Schlussfolgerungsprozesses die symbolische Zerlegung ein, um logische Strenge zu gewährleisten. Da es schwierig ist, die logische Konsistenz der vom Sprachmodell generierten Sprache zu gewährleisten, führen wir den LogicForm-driven Solver and Reasoning für die symbolbasierte Disambiguierung ein.

Viertens: Um die Lücke zwischen den Kosten für die Erstellung des Wissensgraphen und der Effizienz der praktischen Anwendung zu schließen, verwenden wir die Methode der Extraktion offener Informationen, um den Wissensgraphen zu erstellen, was die Kosten für die Erstellung erheblich reduziert, aber auch mehr Rauschen verursacht. Daher führen wir einen Mechanismus zum Wissensabgleich ein, der konzeptuelles Wissen verwendet, um den Abgleich zwischen offenen Informationen und Domänenwissen zu vervollständigen, mit dem Ziel, den Bedarf an offener Informationsextraktion und semantischem Abgleich auszugleichen.

Schließlich haben wir das KAG-Modell mit dem Ziel entwickelt, die Fähigkeiten von großen Sprachmodellen und Wissensgraphen besser zu integrieren, um eine effektivere Synergie zu erreichen. Die organische Interaktion zwischen den beiden wird durch die Anweisungssynthese erleichtert, mit dem letztendlichen Ziel, die Vorteile der symbolischen Berechnung und des Vektor-Retrievals vollständig zu integrieren und die Verständnis- und Generierungsfähigkeiten des Sprachmodells voll auszuschöpfen, um so seine Anwendung und die Verbesserung der Fähigkeiten in vertikalen Bereichen zu fördern.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...