Wie GRPO in dem Spiel "Clue of Time" besser abschneidet als o1, o3-mini und R1.

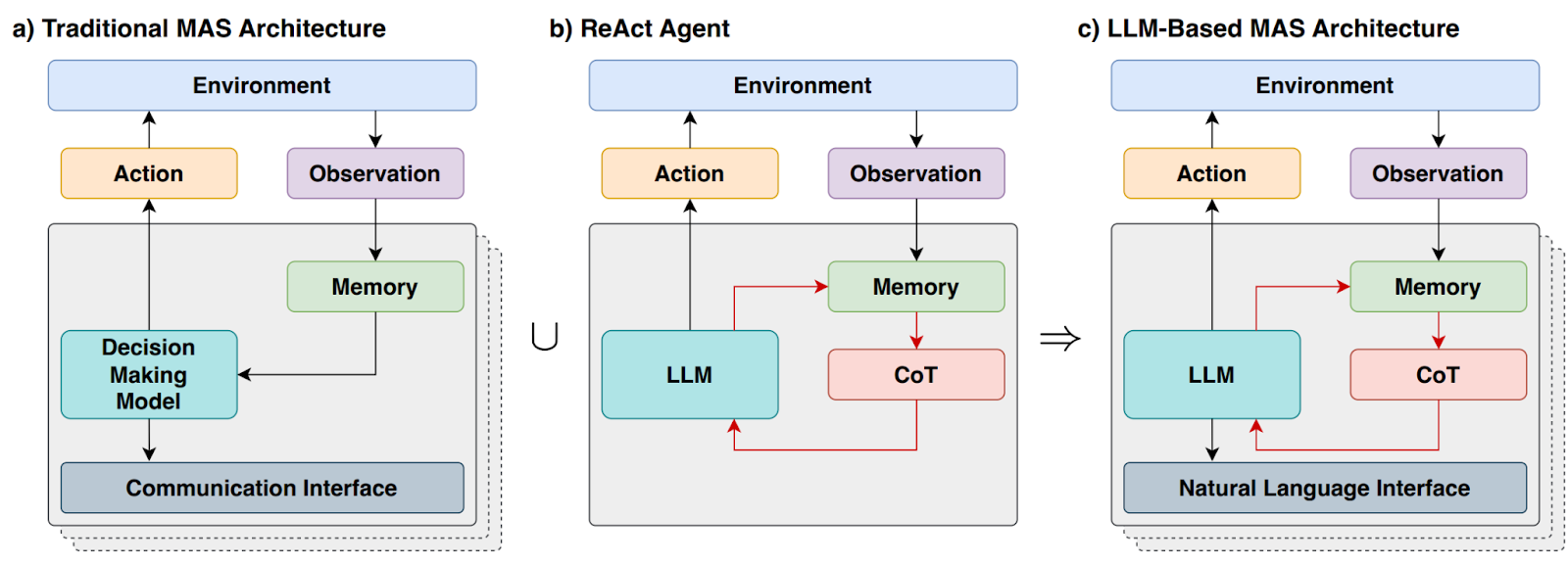

In den letzten Jahren hat der Bereich der künstlichen Intelligenz erhebliche Fortschritte bei seinen Schlussfolgerungsfähigkeiten gemacht. Nachdem OpenAI im vergangenen Jahr das leistungsstarke Inferenzpotenzial großer Sprachmodelle (LLMs) demonstriert hat, haben Google DeepMind, Alibaba, DeepSeek und Anthropisch Organisationen wie die University of California in Berkeley haben schnell nachgezogen und nutzen Techniken des verstärkten Lernens (Reinforcement Learning, RL), um fortgeschrittene Modelle mit "chain of thought" (CoT) Fähigkeiten zu trainieren. Diese Modelle haben bei vielen Benchmark-Tests in Bereichen wie Mathematik und Programmierung nahezu sättigende Ergebnisse erzielt.

Es ist jedoch eine nicht zu übersehende Tatsache, dass selbst die besten heute verfügbaren Modelle bei der Bewältigung von Problemen des logischen Denkens auf einige unüberwindbare Hindernisse stoßen. Große Sprachmodelle haben oft Schwierigkeiten, eine kohärente Kette logischer Schlussfolgerungen unter ständiger Berücksichtigung aller relevanten Details aufrechtzuerhalten oder mehrere Schlussfolgerungsschritte zuverlässig miteinander zu verbinden. Selbst hochmoderne Modelle, die 10-100 Mal so lange Inhalte generieren wie gewöhnliche Modelle, machen oft Fehler auf niedriger Ebene, die von menschlichen Problemlösern leicht erkannt werden.

Um dieser Frage nachzugehen, haben Brad Hilton und Kyle Corbitt, die Autoren dieses Artikels, sich Gedanken gemacht: Können die neuesten Techniken des Reinforcement Learning genutzt werden, um kleinere, quelloffene Modelle an die Spitze der Inferenzleistung zu bringen? Um diese Frage zu beantworten, wählten sie eine Technik namens Optimierung der relativen Gruppenpolitik (GRPO) von Algorithmen des verstärkten Lernens.

Was ist GRPO?

Einfach ausgedrückt, ist GRPO eine Methode zur Optimierung von Strategiegradienten. Methoden zur Optimierung von Strategiegradienten verbessern die Leistung des Modells, indem sie die Strategie des Modells (d.h. die Wahrscheinlichkeitsverteilung der Aktionen des Modells in einer bestimmten Situation) anpassen. GRPO aktualisiert die Strategie effizienter, indem es die relativen Vorteile einer Reihe von Modellreaktionen vergleicht. Im Vergleich zu traditionellen Methoden wie der Proximal Policy Optimization (PPO) vereinfacht GRPO den Trainingsprozess und garantiert dennoch eine hervorragende Leistung.

Um die Gültigkeit der GRPO zu überprüfen, wählten sie ein Programm namens "Zeitlicher Anhaltspunkt"Reasoning Games als experimentelle Plattformen.

Was ist Time Clue?

"Time Clue" ist ein Puzzlespiel, das von dem klassischen Brettspiel "Clue (Cluedo)" inspiriert ist. In diesem Spiel muss der Spieler anhand einer Reihe von Hinweisen den Mörder, die Mordwaffe, den Ort, die Zeit und das Motiv herausfinden. Im Gegensatz zum Originalspiel erweitert "Time Clue" das Problem auf fünf Dimensionen, was die Komplexität und Herausforderung des Spiels erhöht.

Die Autoren begannen mit relativ schwachen Modellen und trainierten sie mit Hilfe des GRPO-Algorithmus iterativ auf das Spiel "Time Clue". Im Laufe der Zeit beobachteten sie eine deutliche Verbesserung der Argumentationsfähigkeit dieser Modelle, die schließlich mit den leistungsstärksten proprietären Modellen mithalten oder diese sogar übertreffen konnten.

Nun werden sie die Informationen weitergeben, die Folgendes beinhaltenTestundAusbildungsprogrammeundDatensatz im Gesang antwortenModellgewicht Forschung, die alle unter der MIT-Lizenz frei verfügbar sind.

Benchmarking

Um ein Experiment durchführen zu können, muss zunächst eine anspruchsvolle Denkaufgabe gefunden werden, die eine eindeutig überprüfbare Lösung und skalierbare Komplexität aufweist. Zufälligerweise hatte einer der Autoren, Brad Hilton, zuvor ein Projekt namens Zeitlicher Anhaltspunkt des Rätselsatzes, der diese Anforderungen perfekt erfüllt. Neben der Erfüllung der Kriterien der grundlegenden sachlichen Klarheit können bei Bedarf neue Rätsel erstellt werden.

Temporal Clue ist inspiriert von dem beliebten Brettspiel Clue (Cluedo)Temporal Clue In diesem Spiel versuchen die Spieler herauszufinden, wer Mr. Boddy im Herrenhaus der Tudors ermordet hat. Temporal Clue verwandelt dieses Spiel in ein eigenständiges Logikrätsel, das über das Standardspiel hinausgeht.dieundWomit?undwobeiund fügte zwei zusätzliche Dimensionen hinzu:Wann?(Zeit) undAus welchem Grund?(Motivation). Die Rätsel werden zufällig generiert, und es werden minimale, aber ausreichende Hinweise verwendet, um OR-Tools (in Form eines Nominalausdrucks) CP-SAT-Löser Gewählt.

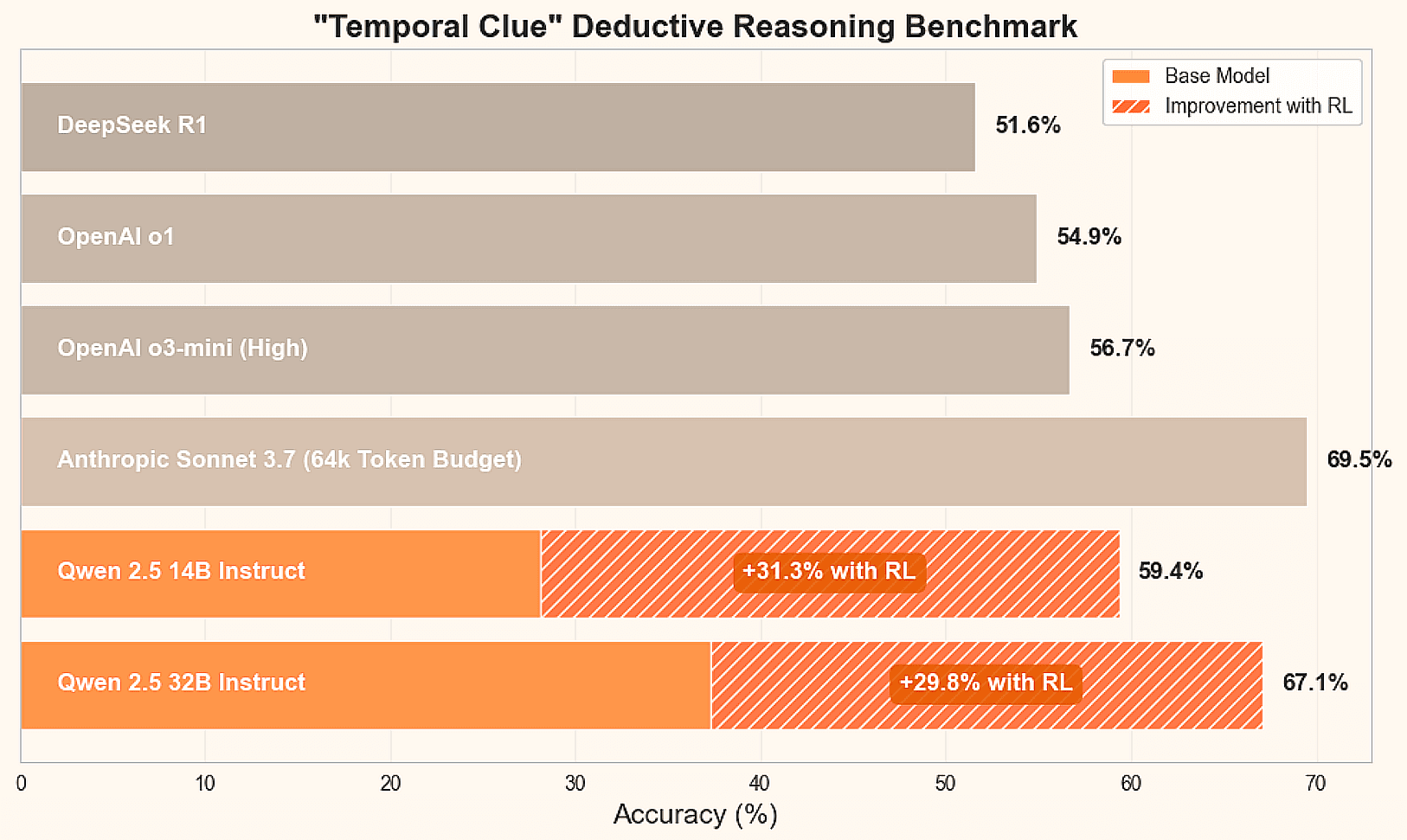

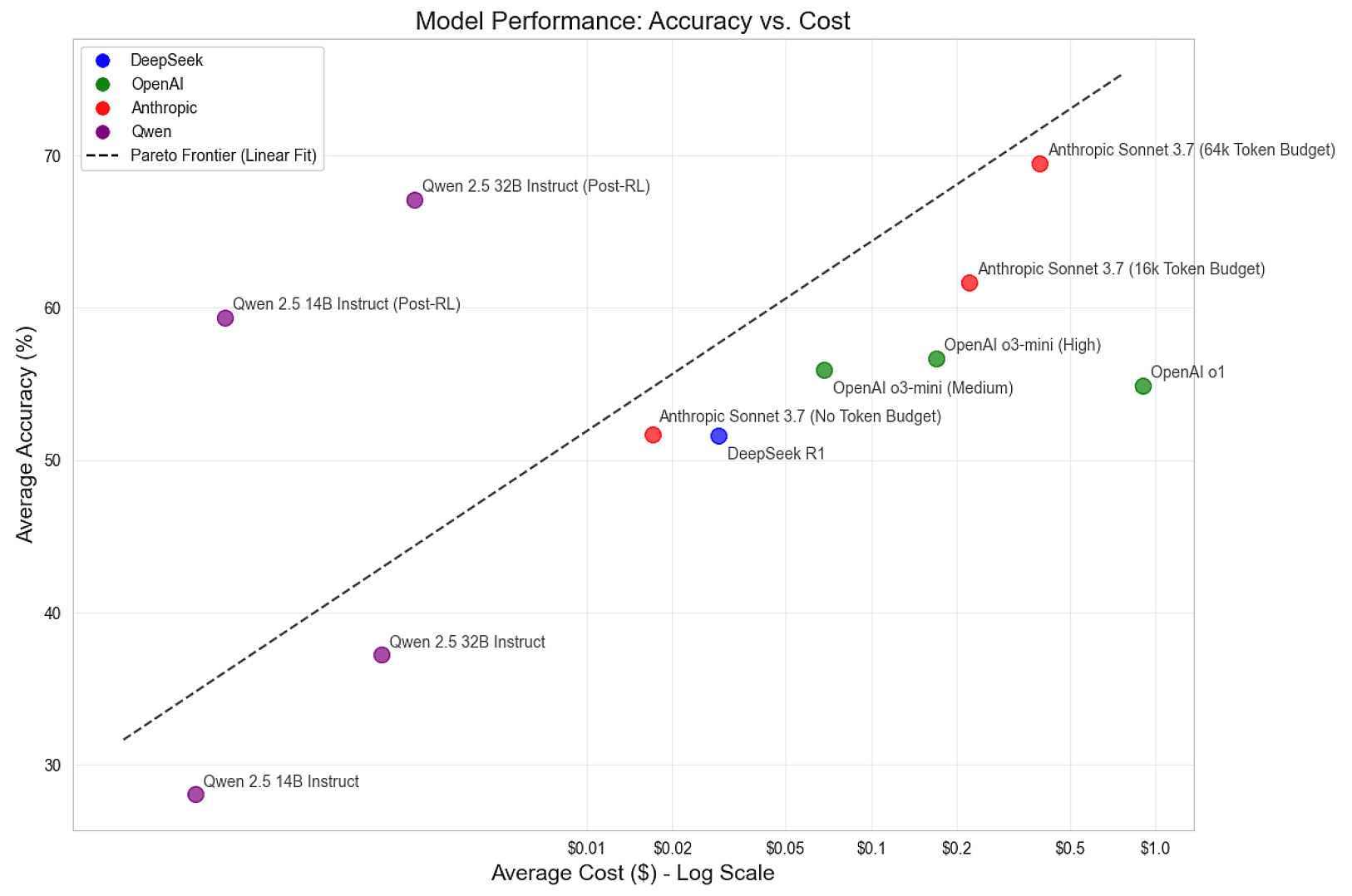

Um den aktuellen Stand der Technik für diese Inferenzaufgabe zu ermitteln, wurden führende Inferenzmodelle verglichen, darunter DeepSeek R1, Anthropisch Claude Sonnet 3.7 und Alibaba's Qwen 2.5 14B und 32B Instruct Modelle. Außerdem geben sie einen Ausblick auf die Endergebnisse:

| Mechanismus | Modellierung | logisches Denkvermögen | Durchschnittliche Genauigkeit | Durchschnittskosten |

|---|---|---|---|---|

| DeepSeek | R1 | Standard (Einstellung) | 51.6% | $0.029 |

| Anthropisch | Sonett 3.7 | nicht haben | 51.7% | $0.017 |

| Anthropisch | Sonett 3.7 | 16k | 61.7% | $0.222 |

| Anthropisch | Sonett 3.7 | 64k | 69.5% | $0.392 |

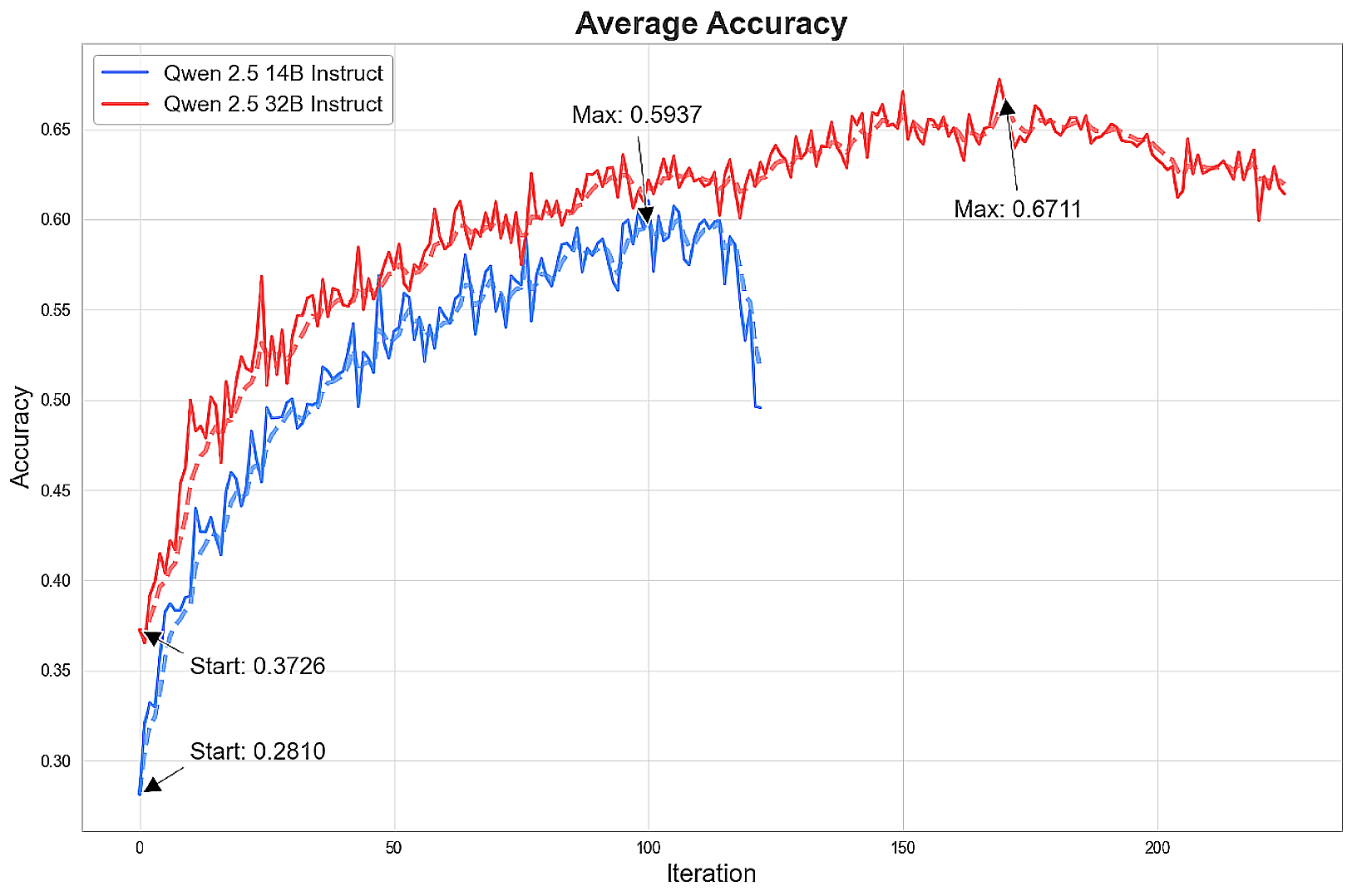

| Ali Baba, Figur aus "Tausendundeine Nacht | Qwen 2.5 14B Instruct | nicht haben | 28.1% | $0.001 |

| Ali Baba, Figur aus "Tausendundeine Nacht | Qwen 2.5 32B Instruct | nicht haben | 37.3% | $0.002 |

Aus diesen Benchmarks geht hervor, dass die 64k Token Das Modell Claude Sonnet 3.7 von Anthropic schnitt bei dieser Aufgabe am besten ab, aber alle führenden Modelle können noch verbessert werden. DeepSeek R1, ein beliebtes Open-Source-Modell, erreichte mit 51,7% fast die durchschnittliche Genauigkeit von Claude Sonnet 3.7 von Anthropic. Die Leistung des ungetunten Qwen 2.5 Instruct-Modells ist jedoch relativ schlecht. Die große Frage ist: Können diese kleineren Open-Source-Modelle auf ein Spitzenniveau trainiert werden?

Zug

Um ein hochmodernes Inferenzmodell zu trainieren, verwendeten sie Verstärkungslernen - eine Methode, die es Intelligenzen ermöglicht, aus ihren eigenen Erfahrungen in einer kontrollierten Umgebung zu lernen. In diesem Fall sind die LLMs die Intelligenzen und die Rätsel sind die Umgebung. Sie leiteten das Lernen der LLMs, indem sie sie mehrere Antworten für jedes Rätsel generieren ließen, um die Problemlandschaft zu erkunden. Sie verstärken das Denken, das zur richtigen Lösung führt, und bestrafen das Denken, das das Modell in die Irre führt.

Unter den verschiedenen RL-Methoden wählten sie den beliebten Algorithmus Group Relative Policy Optimisation (GRPO), der von DeepSeek entwickelt wurde. Im Vergleich zu traditionelleren Methoden wie der Proximal Policy Optimization (PPO) vereinfacht GRPO den Trainingsprozess und bietet dennoch eine starke Leistung. Um ihre Experimente zu beschleunigen, ließen sie die Kullback-Leibler (KL)-Dispersion Bestrafung, auch wenn ihr Ausbildungsprogramm dies unterstützt.

Zusammenfassend lässt sich sagen, dass der Ausbildungszyklus die folgenden grundlegenden Schritte umfasst:

- Generierung von Modellantworten auf Rätselaufgaben.

- Bewerten Sie die Antworten und schätzen Sie den Vorteil der Teilnahme am Chat für jede Gruppe (dies ist der "gruppenrelative" Teil von GRPO).

- Die Feinabstimmung des Modells erfolgt mit Hilfe eines Gradienten von Anpassungsstrategien, die sich an diesen Dominanzschätzungen orientieren.

- Wiederholen Sie diese Schritte mit neuen Puzzles und der neuesten Version des Modells, bis die optimale Leistung erreicht ist.

Um die Antwort zu generieren, verwenden sie das beliebte vLLM Inferenzmaschine. Sie haben die Parameterauswahl so abgestimmt, dass der Durchsatz maximiert und die Startzeit minimiert wird. Die Zwischenspeicherung von Präfixen ist besonders wichtig, da für jede Aufgabe viele Antworten abgerufen werden und die Zwischenspeicherung von Hinweisen dazu beiträgt, redundante Berechnungen zu vermeiden.

Sie stellten fest, dass zu viele Anfragen die vLLM überlastet, was zu einer Vorwegnahme oder Auslagerung laufender Anforderungen führt. Um dieses Problem zu lösen, begrenzen sie die Anforderungen mit einem Semaphor, der so eingestellt ist, dass eine hohe Key-Value-Cache-Auslastung aufrechterhalten und gleichzeitig das Swapping minimiert wird. Fortschrittlichere Planungsmechanismen können eine höhere Auslastung bei gleichzeitiger Unterstützung flexibler Generationslängen erreichen.

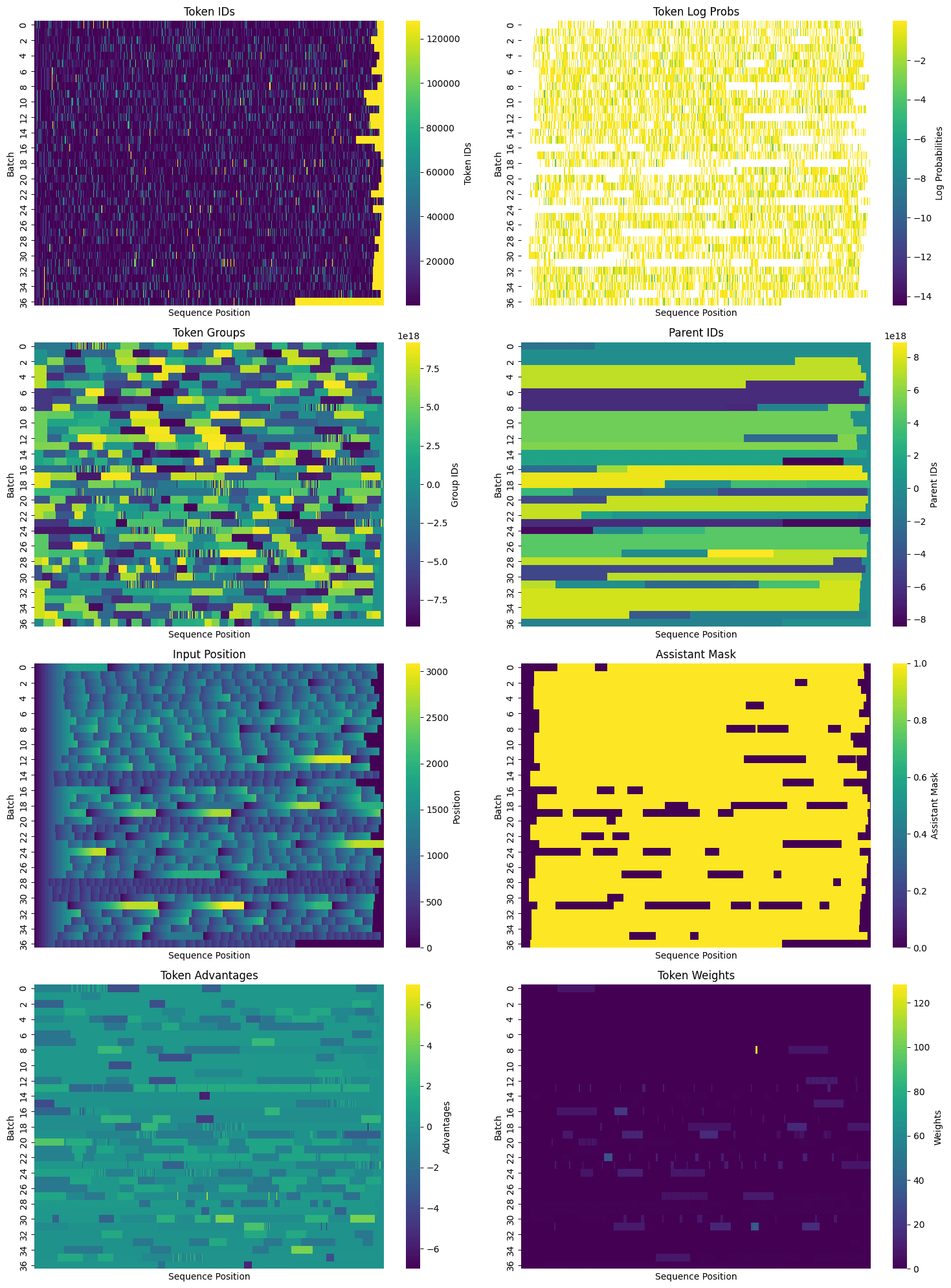

Nach der Probenahme wird ein Standard HuggingFace Transformers AutoTokenizer Die Verarbeitung ist abgeschlossen. Die Chat-Vorlagenfunktion stellt das Nachrichtenobjekt als Prompt-String dar, der eine Hilfsmaske zur Bestimmung der vom LLM generierten Token enthält, die in der Standardvorlage fehlt. %generation% Beschriftungen, so dass sie im Schritt der Beschriftung geändert werden. Die erzeugten Hilfsmasken werden in das Tensorwörterbuch aufgenommen, das für die Abstimmung verwendet wird, und dienen zur Identifizierung der Positionen, die für die Berechnung der Verluste erforderlich sind.

Nach dem Binning der Antworten und dem Erhalt von Hilfsmasken verpackten sie die Daten für die Abstimmung. Zusätzlich zur Aufnahme mehrerer Hinweis/Antwort-Paare in jede verpackte Sequenz identifizierten sie gemeinsame Hinweis-Token und wiesen jedem Token eine übergeordnete ID sowie eine Standard-Gruppen-ID zu. Insbesondere bei Aufgaben wie Temporal Clue (durchschnittlich mehr als 1.000 Token pro Rätsel) kann die Erzeugung einer großen Anzahl von Antworten für jede Aufgabe und die effiziente Verpackung des Tensors kann die Redundanz erheblich reduzieren. Sobald alle notwendigen Informationen gepackt wurden, kann der Trainingsdatensatz in zwei Dimensionen visualisiert werden, wobei jede Zeile eine Sequenz von Token darstellt, die mehrere Hinweise und Vervollständigungen enthalten kann:

Bei dicht gepackten Daten ist es Zeit für das Tuning. Die Modelle wurden vortrainiert, auf Anweisungen abgestimmt, sind ziemlich intelligent und können Anweisungen gut befolgen. Allerdings können sie das Rätsel des Temporal Clue noch nicht zuverlässig lösen. Gelegentlich gelingt es ihnen jedoch, und das reicht schon. Nach und nach wird das Modell zu einem "Spürsinn"-Zustand geführt, indem die Wahrscheinlichkeit für gutes Denken erhöht und die Wahrscheinlichkeit für schlechtes Denken verringert wird. Dies wird mit Hilfe von Standardtechniken des maschinellen Lernens erreicht, wobei ein Policy-Gradient-Ansatz verwendet wird, um Verluste zu berechnen und Gewichte günstig zu verschieben.

Für die Schulung stellte das PyTorch-Team die torchtune Torchtune verfügt über ein hocheffizientes Decoder-only Transformator Implementierungen für beliebte Modelle wie Llama, Gemma, Phi und andere. Für dieses Projekt wurde in erster Linie das Qwen-Modell verwendet, aber es wurde auch mit den Meta-Modellen Llama 8B und 70B experimentiert.Torchtune bietet auch speicherschonende und leistungssteigernde Dienstprogramme, darunter:

- Aktivieren von Kontrollpunkten

- Aktivierung Deinstallation

- quantifizierbar

- Parametereffiziente Feinabstimmung (PEFT)Zum Beispiel Adaptiv mit niedrigem Rang (LoRA)

Eine vollständige Liste der unterstützten Optimierungen finden Sie in derSelbsterklärendes Dokument hier.

Außerdem unterstützt Torchtune Multi-Device (und jetzt auchMultinode) Training, was es ideal für große Modelle macht. Es unterstützt sowohl Fully Sliced Data Parallel (FSDP) als auch Tensor Parallel (TP) Training, die in Kombination verwendet werden können. Sie bieten außerdemEin Dutzend Programmeund ermutigt die Nutzer, es zu kopieren und für ihre eigenen Anwendungsfälle anzupassen. Sie schufen eine modifizierte Version des vollständigen Feinabstimmungsprogramms, das Unterstützung bietet:

- Training mit mehreren Geräten und mit einem Gerät

- Beladung des Referenzmodells und Austausch der Gewichte für die Berechnung der KL-Dispersion

- Erweiterte Kausalmaskenberechnung mit Gruppen-IDs und übergeordneten IDs

- GRPO Verlustintegration und Komponentenprotokollierung

Das Programm ist verfügbar inhier sindSiehe. In Zukunft wollen sie die Unterstützung für Tensorparallelität hinzufügen und PEFT und Quantisierung erforschen.

Der RL-Trainingsvorgang beinhaltet die Auswahl einer großen Anzahl von Hyperparametern. Während des Trainings des Modells wurden verschiedene Konfigurationen getestet und hauptsächlich die folgenden Konfigurationen ermittelt:

- Modelle: Qwen 2.5 Instruct 14B und 32B

- Anzahl der Aufgaben pro Iteration: 32

- Anzahl der Stichproben pro Aufgabe und Iteration: 50

- Gesamtzahl der Stichproben pro Iteration: 32 * 50 = 1600

- Lernrate: 6e-6

- Microbatch-Größe: 4 Sequenzen für 14B-Modell, 8 Sequenzen für 32B-Modell

- Chargengröße: variabel, abhängig von der Anzahl der Sequenzen

Die Chargengrößen sind variabel, da sich die Länge der Antworten während des Trainings ändern kann, die Effizienz der Sequenzpackung in jeder Iteration schwankt und Antworten mit Null-Dominanz (d. h. Antworten, für die das Modell keine positive oder negative Rückmeldung gibt) verworfen werden. In einem Durchlauf wurde versucht, die Lernrate dynamisch an die Chargengröße anzupassen, was jedoch dazu führte, dass die Lernrate für kleine Chargengrößen zu hoch war und gekappt werden musste. Die Version mit der Obergrenze unterschied sich nicht signifikant von der Verwendung einer konstanten Lernrate, aber die Anpassung der Chargengröße und der Lernrate bleibt ein interessanter Bereich für zukünftige Experimente.

Sie führten auch kurze Experimente durch, bei denen sie die Anzahl der Aufgaben pro Iteration erhöhten, während sie die Anzahl der Stichproben pro Aufgabe verringerten und umgekehrt, wobei die Gesamtzahl der Stichproben pro Iteration ungefähr gleich blieb. Diese Änderungen zeigten über einen kurzen Trainingszeitraum keine signifikanten Unterschiede, was darauf hindeutet, dass das System robust gegenüber verschiedenen Kompromissen zwischen der Anzahl der Aufgaben und der Anzahl der Stichproben pro Aufgabe ist.

am Ende

Nach dem Training des Modells in mehr als 100 Iterationen wurde ein bahnbrechendes Niveau der Inferenz erreicht.

Das Modell verbessert sich rasch, dann nimmt die Verbesserung der Genauigkeit ab und geht schließlich zurück, manchmal dramatisch. Im besten Fall nähert sich das 14B-Modell bei 16k Token der Leistung von Claude Sonnet 3.7, und das 32B-Modell erreicht bei 64k Token fast die Ergebnisse von Sonnet.

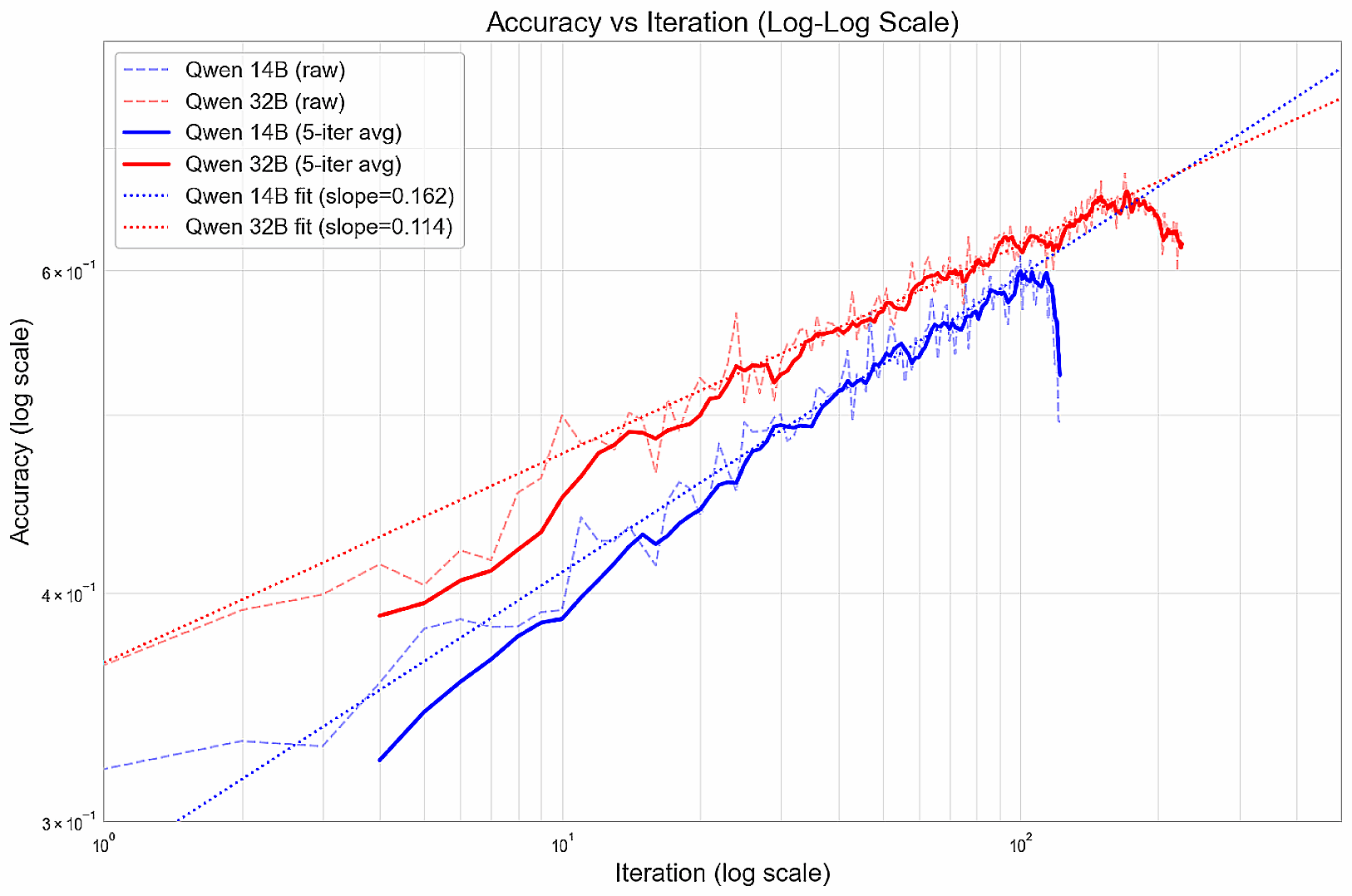

Während des Trainings folgt die Leistungsverbesserung einem Potenzgesetz und bildet eine lineare Beziehung auf dem Log-Log-Diagramm (vor der Verschlechterung).

Sie vermuten, dass diese Modelle vorschnell zu gierigen Strategien konvergieren, die zu Beginn funktionieren, aber ihre langfristigen Aussichten einschränken. Der nächste Schritt könnte darin bestehen, Möglichkeiten zu erforschen, wie eine Vielfalt von Antworten gefördert werden kann, wie Kompetenzen schrittweise aufgebaut werden können (z. B. durch Kurslernen) oder wie besonders gute Lösungen stärker belohnt werden können, um Anreize für eine gründliche Erkundung zu schaffen.

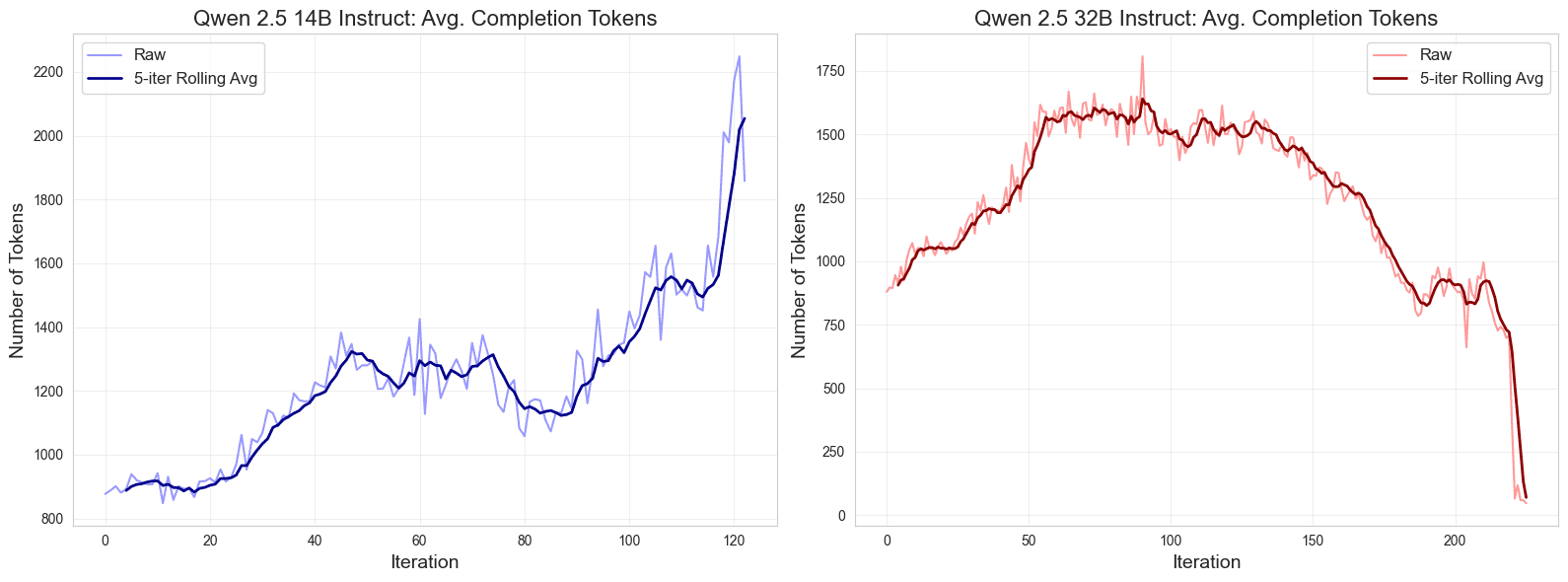

Darüber hinaus stellten sie ein interessantes Muster in der Länge des Outputs während des Trainings fest. Zunächst wird die Antwort länger, dann stabilisiert sie sich und divergiert dann gegen Ende des Trainings, wobei die Antwort des 14B-Modells länger und die Antwortlänge des 32B-Modells kürzer wird, insbesondere nachdem die Spitzenleistung erreicht ist.

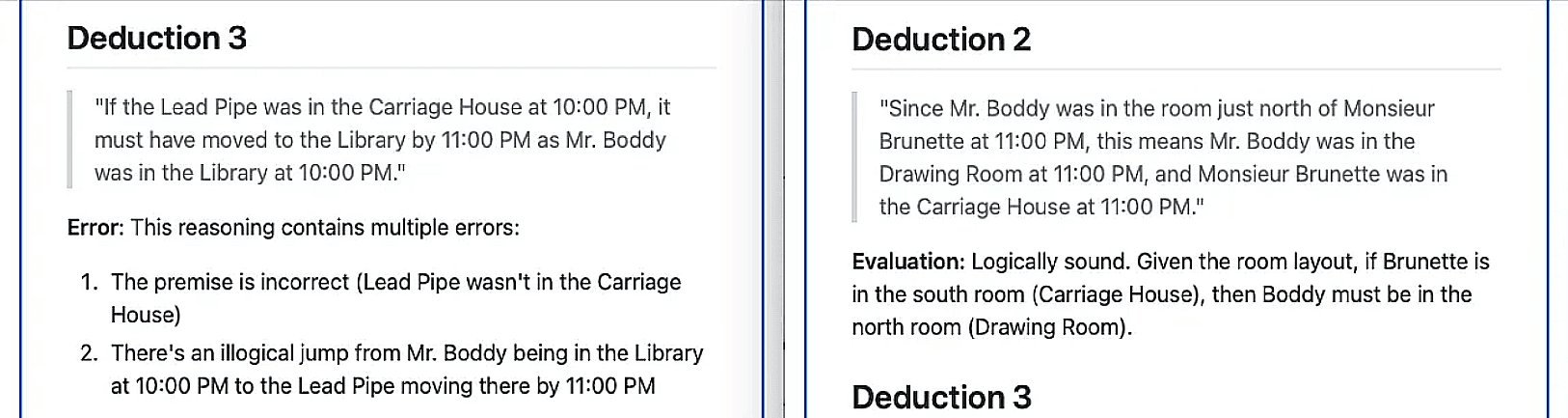

Um die Verbesserungen im logischen Denken qualitativ zu bewerten, ließen sie ihr stärkstes Spitzenmodell, Claude Sonnet 3.7, die Plausibilität des logischen Denkens des Qwen 32B-Modells bei ähnlichen Rätseln identifizieren und bewerten - vor und nach mehr als 100 Iterationen des Trainings.Sonnet identifizierte 6 Schlussfolgerungen aus dem Basismodell, von denen alle bis auf eine als falsch eingestuft wurden;Stattdessen wurden sieben Schlussfolgerungen aus dem trainierten Modell ermittelt, die bis auf eine alle als logisch fundiert eingestuft wurden.

Schließlich ist die Annahme, dassOn-Demand-BereitstellunghabenAusreichender DurchsatzSie beruhen auf Feuerwerk AI (in Form eines Nominalausdrucks)Serverlose Preisstaffelungschätzten die Kosten für das Qwen-Modell. Sie verglichen die Genauigkeit mit dem natürlichen Logarithmus der durchschnittlichen Inferenzkosten pro Antwort und beobachteten eine klare lineare Pareto-Grenze für das nicht angepasste Modell. Der Kompromiss zwischen Kosten und Genauigkeit wurde erheblich verbessert, indem das Open-Source-Modell erfolgreich auf das Genauigkeitsniveau der Grenze trainiert wurde.

Zusammenfassungen

In dieser Untersuchung wollten sie herausfinden, ob kleinere, quelloffene Sprachmodelle durch Verstärkungslernen bahnbrechende Argumentationsfähigkeiten erreichen können. Nach dem Training von Qwen 14B- und 32B-Modellen auf anspruchsvollen Temporal Clue-Rätseln unter Verwendung sorgfältig ausgewählter Hyperparameter und der GRPO-Methode erzielten sie beeindruckende Leistungssteigerungen. Diese Verbesserungen bringen Open-Source-Modelle an die Spitze der Inferenzleistung und senken gleichzeitig die Kosten erheblich. Die Ergebnisse unterstreichen das Potenzial von Reinforcement Learning, um offene Modelle effizient auf komplexe Schlussfolgerungsaufgaben zu trainieren.

Wie bereits erwähnt.DatensatzundTestundAusbildungsprogramme und Modellgewichte (14B, 32B) sind kostenlos unter der MIT-Lizenz erhältlich.

Darüber hinaus stellten sie fest, dass nur 16 Ausbildungsbeispiele Es können erhebliche Leistungssteigerungen von bis zu 10-15% erzielt werden.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...