Groq: Anbieter von Lösungen zur Beschleunigung von KI-Big-Model-Inferenzen, kostenlose Hochgeschwindigkeitsschnittstelle für Big Models

Groq Allgemeine Einführung

Groq, ein Unternehmen mit Sitz in Mountain View, Kalifornien, entwickelte den GroqChip™ und die Language Processing Unit™ (LPU). Es ist bekannt für seine Tensor-Verarbeitungseinheiten, die für KI-Anwendungen mit geringer Latenz entwickelt wurden.

Das Hauptprodukt von Groq ist die Language Processing Unit (LPU), eine neue Klasse von Chips, die nicht zum Trainieren von KI-Modellen, sondern zum schnellen Ausführen dieser Modelle entwickelt wurde, natürliche Sprache) und GPUs zu übertreffen.

Das Unternehmen hat sich zum Ziel gesetzt, Lösungen für Echtzeit-KI-Anwendungen anzubieten, die sich durch Geschwindigkeit und Genauigkeit auszeichnen und eine führende KI-Leistung in Rechenzentren bieten. Darüber hinaus bietet das Unternehmen die GroqWare™-Suite an, die Tools für die benutzerdefinierte Entwicklung und Optimierung von Workloads wie den Groq Compiler umfasst.

Groq Funktionsliste

- Verarbeitung von AI-Anwendungen in Echtzeit

- Unterstützung für Standard-Frameworks für maschinelles Lernen

- Unterstützung für SaaS- und PaaS-Hardware

- Schnelle und präzise AI-Leistung

- GroqWare™ Suite für individuell optimierte Workloads

- Gewährleistung einer genauen, energieeffizienten und wiederholbaren Inferenzleistung in großem Maßstab

Groq-Hilfe

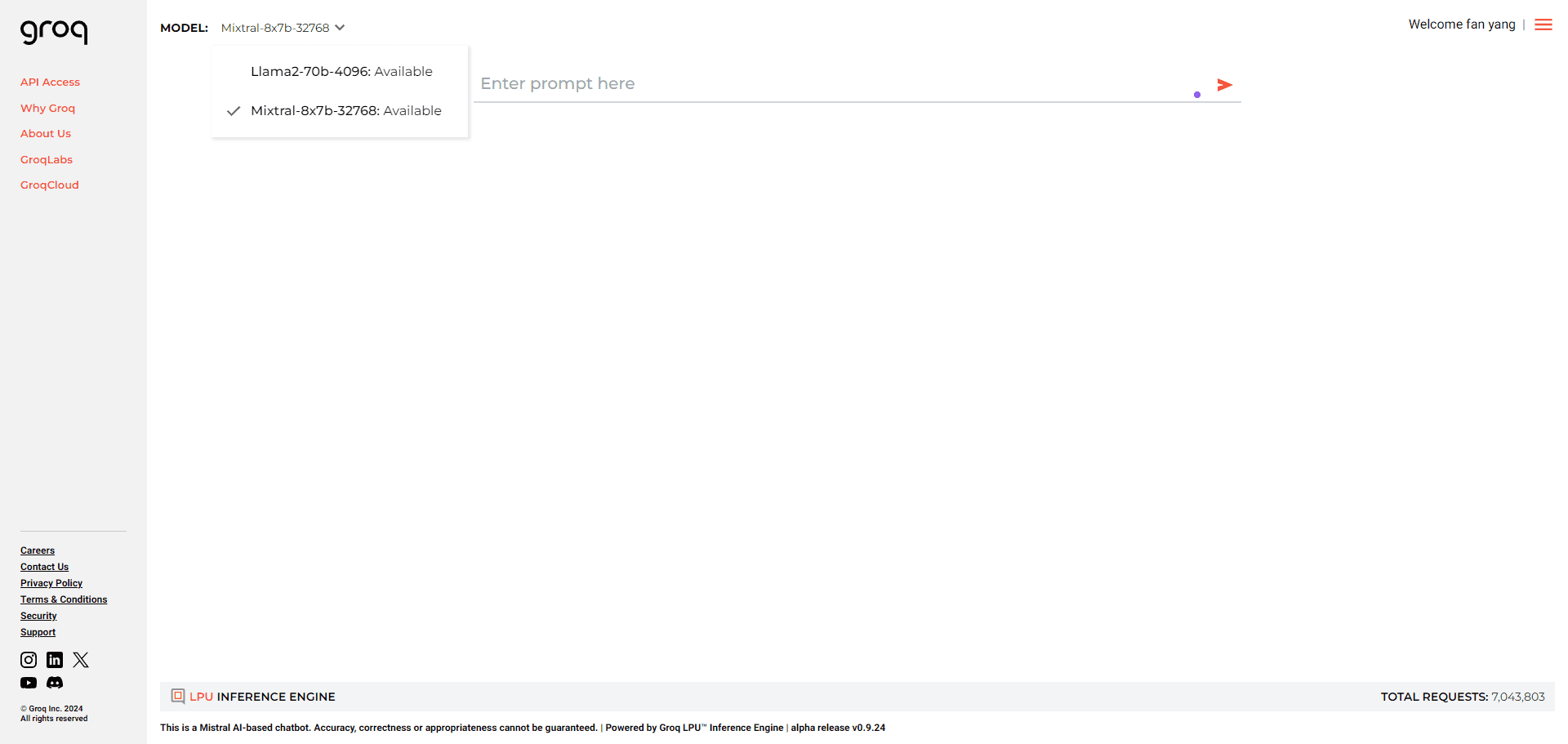

- Entwickler können den Entwicklerzugang über Playground auf GroqCloud selbst verwalten

- Wenn Sie derzeit die OpenAI-API verwenden, benötigen Sie nur drei Dinge für die Konvertierung in Groq: einen Groq-API-Schlüssel, einen Endpunkt und ein Modell

- Wenn Sie die schnellste Rechenleistung im Maßstab eines Rechenzentrums benötigen, sollten wir uns unterhalten

Sie können.Klicken Sie hierBeantragen Sie den APIKEY kostenlos und wählen Sie das Modell nach Abschluss der Beantragung:

Chat-Vervollständigung

| ID | Anfragen pro Minute | Anfragen pro Tag | Wertmarken pro Minute | Wertmarken pro Tag |

|---|---|---|---|---|

| gemma-7b-it | 30 | 14,400 | 15,000 | 500,000 |

| gemma2-9b-it | 30 | 14,400 | 15,000 | 500,000 |

| llama-3.1-70b-versatile | 30 | 14,400 | 20,000 | 500,000 |

| lama-3.1-8b-instant | 30 | 14,400 | 20,000 | 500,000 |

| llama-3.2-11b-text-preview | 30 | 7,000 | 7,000 | 500,000 |

| lama-3.2-1b-vorschau | 30 | 7,000 | 7,000 | 500,000 |

| lama-3.2-3b-vorschau | 30 | 7,000 | 7,000 | 500,000 |

| llama-3.2-90b-text-preview | 30 | 7,000 | 7,000 | 500,000 |

| Lama-Wache-3-8b | 30 | 14,400 | 15,000 | 500,000 |

| Lama3-70b-8192 | 30 | 14,400 | 6,000 | 500,000 |

| Lama3-8b-8192 | 30 | 14,400 | 30,000 | 500,000 |

| llama3-groq-70b-8192-tool-use-preview | 30 | 14,400 | 15,000 | 500,000 |

| llama3-groq-8b-8192-tool-use-preview | 30 | 14,400 | 15,000 | 500,000 |

| llava-v1.5-7b-4096-preview | 30 | 14,400 | 30,000 | (Keine Begrenzung) |

| Mixtral-8x7b-32768 | 30 | 14,400 | 5,000 | 500,000 |

Sprache in Text

| ID | Anfragen pro Minute | Anfragen pro Tag | Audio-Sekunden pro Stunde | Audio-Sekunden pro Tag |

|---|---|---|---|---|

| destillieren-flüstern-groß-v3-de | 20 | 2,000 | 7,200 | 28,800 |

| flüstern-groß-v3 | 20 | 2,000 | 7,200 | 28,800 |

Nehmen wir als nächstes das curl-Format als Beispiel. Diese Schnittstelle ist mit dem OPENAI-Schnittstellenformat kompatibel, also lassen Sie Ihrer Fantasie freien Lauf, solange es Schnittstellen gibt, die die Anpassung der OPENAI-API sowie die Verwendung von Groq ermöglichen.

curl -X POST "https://api.groq.com/openai/v1/chat/completions" \

-H "Authorisation: Bearer $GROQ_API_KEY" \

-H "Content-Type: application/json" \

-d '{"messages": [{"role": "user", "content": "Explain the importance of low latency LLMs"}], "model": "mixtral-8x7b-32768"}'

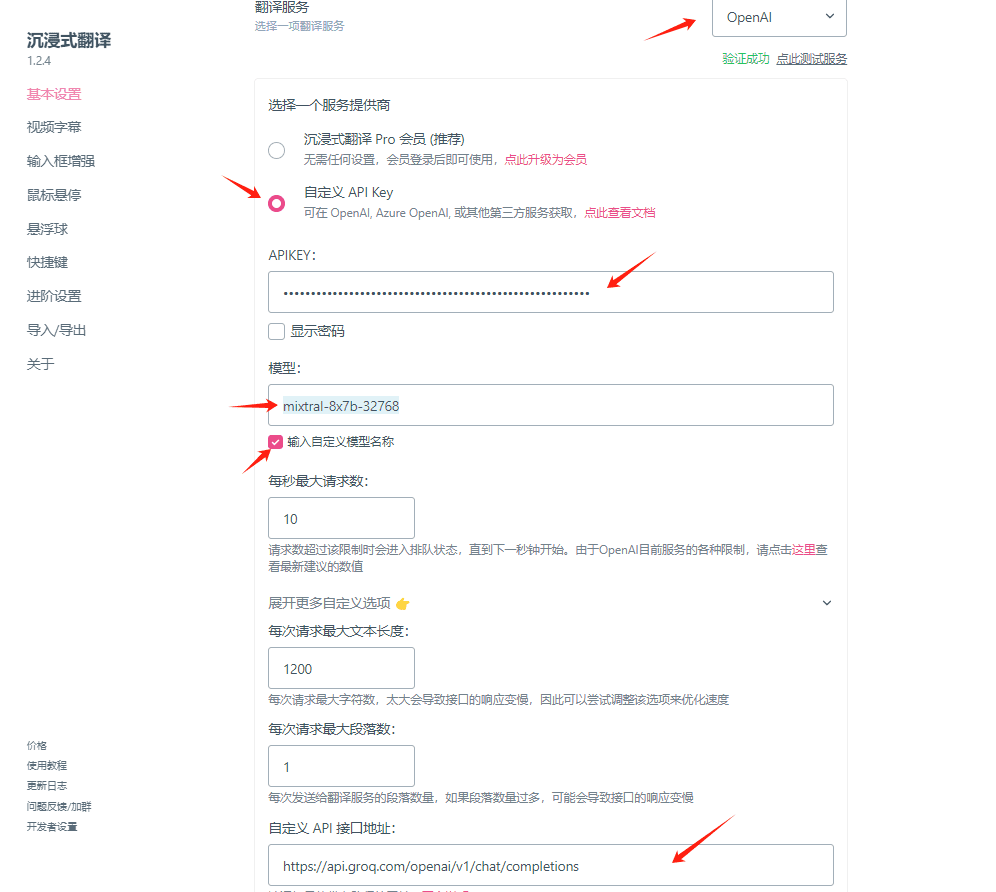

Verwendungsbeispiel: Konfigurieren von Groq-Schlüsseln für die Verwendung im Immersive Translation Plugin

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...