Grok 3 Benchmark-Daten 'verwässert'? OpenAI-Mitarbeiter sagt, xAI könnte die Leistung falsch darstellen

Die Debatte über KI-Benchmarking und die Art und Weise, wie KI-Labors ihre Ergebnisse veröffentlichen, wird immer öffentlicher. Die Leistung von KI wird seit langem auf kontroverse Weise gemessen und berichtet, und nun treten diese Debatten hinter den Kulissen endlich ins Rampenlicht.

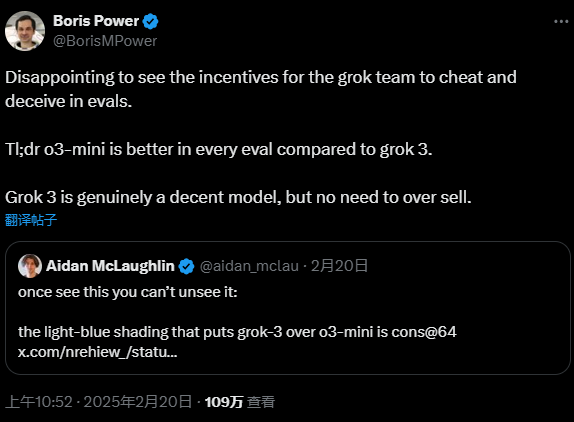

In dieser Woche beschuldigte ein Mitarbeiter von OpenAI öffentlich xAI, das von Elon Musk gegründete KI-Unternehmen, irreführende Benchmark-Ergebnisse zu veröffentlichen, um für seine neuesten KI-Modelle zu werben. Grok 3 Igor Babushkin, einer der Mitbegründer von xAI, reagierte sofort auf die Anschuldigungen und betonte, dass an dem Ansatz von xAI nichts falsch sei. Die öffentliche Debatte hat die Frage der Transparenz bei der Bewertung von KI-Leistungen sicherlich in den Vordergrund gerückt.

Aber die Wahrheit liegt vielleicht irgendwo zwischen den beiden Seiten. Wie bei vielen Streitigkeiten im technischen Bereich liegt die Wahrheit oft unter der Oberfläche und erfordert tieferes Graben und Hinterfragen.

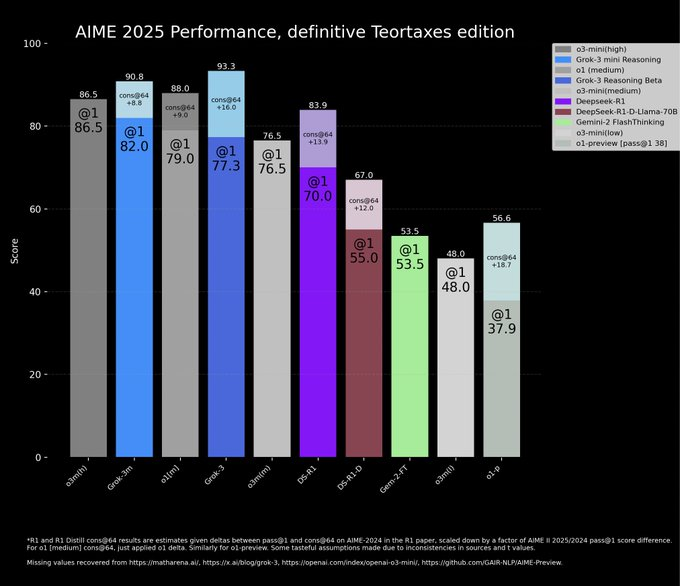

In einem Beitrag im offiziellen xAI-Blog präsentiert xAI ein Diagramm, das die überragende Leistung von Grok 3 im AIME 2025 Benchmark zeigt. AIME 2025 ist eine Sammlung von Fragen aus einer kürzlich durchgeführten anspruchsvollen Mathematikprüfung und gilt als Lackmustest für die mathematischen Fähigkeiten von KI. Es ist jedoch erwähnenswert, dass Experten seit langem die Gültigkeit von AIME als KI-Benchmark in Frage gestellt haben. Es wäre interessant zu erfahren, welche Absichten xAI mit der Wahl eines so umstrittenen Benchmarks zur Demonstration der Modellfähigkeit verfolgte. Nichtsdestotrotz werden AIME 2025 und seine früheren Versionen immer noch häufig verwendet, um die mathematische Argumentation von KI-Modellen zu bewerten.

xAI behauptete in seinem Diagramm, dass beide Versionen von Grok 3, Grok 3 Reasoning Beta und Grok 3 mini Reasoning, das aktuelle State-of-the-Art-Modell von OpenAI, o3-mini-high, im AIME 2025-Test übertrafen. OpenAI-Mitarbeiter wiesen jedoch auf der X-Plattform schnell darauf hin, dass das Diagramm von xAI einen kritischen Fehler aufwies: Sie ließ die AIME 2025 Testergebnisse von o3-mini-high unter "cons@64"-Bedingungen aus. Diese selektive Darstellung der Daten wirft Fragen über die Absichten von xAI auf.

Sie fragen sich vielleicht: "Was genau ist "consensus@64"? Einfach ausgedrückt, steht es für "consensus@64" und ist eine besondere Art von Bewertungsmethode. Bei dieser Methode versucht das Modell 64 Mal, jede Frage im Benchmark-Test zu beantworten, und die häufigste Antwort ist die endgültige Antwort. Es überrascht nicht, dass der "cons@64"-Mechanismus die Benchmark-Punktzahl eines Modells in der Regel deutlich verbessert. xAI lässt die "cons@64"-Daten absichtlich aus seinen Diagrammen weg, was den Eindruck erwecken könnte, dass Grok 3 andere Modelle übertrifft, was aber nicht der Fall ist. Ist dieser "trickreiche" Ansatz nicht ein faires Spiel?

Ein Blick auf die tatsächlichen Daten zeigt, dass sowohl Grok 3 Reasoning Beta als auch Grok 3 mini Reasoning beim AIME 2025 in der "@1"-Bedingung, d. h. beim ersten Versuch des Modells, im Benchmark zu punkten, tatsächlich schlechter abschneiden als o3-mini-high. Sogar die Beta-Ergebnisse von Grok 3 Reasoning liegen nur geringfügig vor dem o1-Modell von OpenAI (eingestellt auf "mittlere" Rechenleistung). Trotz dieses Datenvergleichs wirbt xAI für Grok 3 als "die intelligenteste KI der Welt". Diese Werbestrategie beruht nicht auf strengen wissenschaftlichen Erkenntnissen, sondern ist eher eine Marketingtaktik, um die Aufmerksamkeit des Marktes zu gewinnen. Ist es in einer Zeit, in der sich die KI-Technologie rasant entwickelt, wichtiger, bodenständige technologische Fortschritte zu machen, oder ist es wichtiger, die Zukunft durch einen übertriebenen Marketing-Hype zu gewinnen? Dies könnte eine Frage sein, die die gesamte KI-Branche ernsthaft bedenken sollte.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...