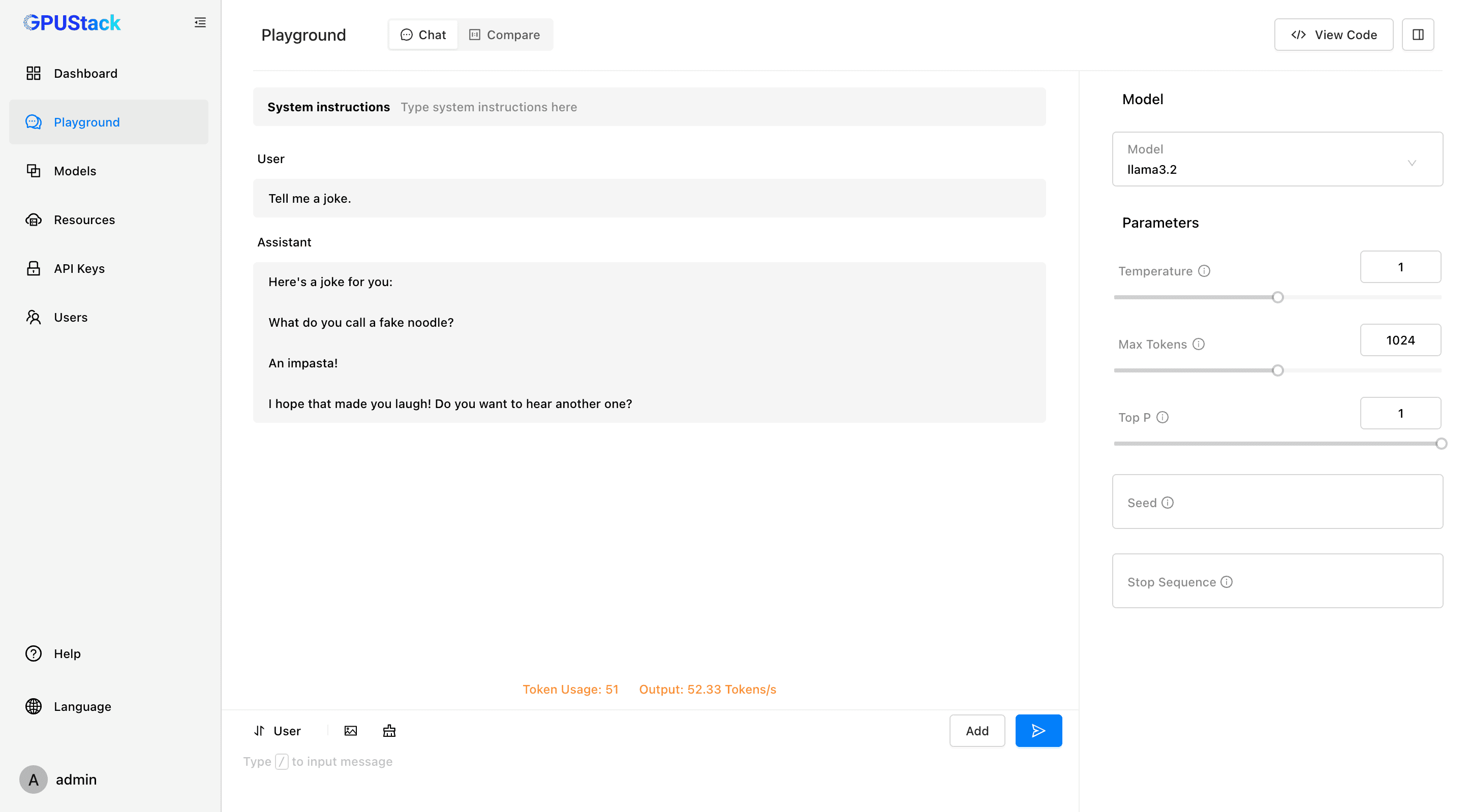

GPUStack: Verwaltung von GPU-Clustern zur Ausführung großer Sprachmodelle und zur schnellen Integration allgemeiner Inferenzdienste für LLMs.

Allgemeine Einführung

GPUStack ist ein Open-Source-GPU-Cluster-Management-Tool, das für die Ausführung von Large Language Models (LLMs) entwickelt wurde. Es unterstützt eine breite Palette von Hardware, einschließlich Apple MacBooks, Windows-PCs und Linux-Servern, und erleichtert die Skalierung der Anzahl von GPUs und Knoten, um wachsenden Rechenanforderungen gerecht zu werden. GPUStack bietet verteilte Inferenzfunktionen, unterstützt Single-Node-Multi-GPU- und Multi-Node-Inferenz und Services und ist mit der OpenAI-API kompatibel, was die Benutzer- und API-Schlüsselverwaltung sowie die Echtzeitüberwachung der GPU-Leistung und -Nutzung vereinfacht. Sie ist mit der OpenAI-API kompatibel, vereinfacht die Benutzer- und API-Schlüsselverwaltung und überwacht die GPU-Leistung und -Auslastung in Echtzeit. Sein leichtgewichtiges Python-Paketdesign sorgt für minimale Abhängigkeiten und einen minimalen operativen Overhead, was es ideal für Entwickler und Forscher macht.

Funktionsliste

- Unterstützung verschiedener Hardware: Kompatibel mit Apple Metal, NVIDIA CUDA, Ascend CANN, Moore Threads MUSA und mehr.

- Verteilte Inferenz: unterstützt Single-Node-Multi-GPU- und Multi-Node-Inferenz und -Dienste.

- Mehrere Inferenz-Backends: Unterstützung für llama-box (llama.cpp) und vLLM.

- Leichtgewichtige Python-Pakete: minimale Abhängigkeiten und minimaler operativer Overhead.

- OpenAI-kompatible API: Bietet API-Dienste, die mit dem OpenAI-Standard kompatibel sind.

- Benutzer- und API-Schlüsselverwaltung: Vereinfacht die Benutzer- und API-Schlüsselverwaltung.

- GPU-Leistungsüberwachung: Überwachen Sie die GPU-Leistung und -Nutzung in Echtzeit.

- Token-Nutzungs- und Ratenüberwachung: Effiziente Verwaltung der Token-Nutzung und Ratenbegrenzung.

Hilfe verwenden

Einbauverfahren

Linux oder MacOS

- Öffnen Sie das Terminal.

- Führen Sie den folgenden Befehl aus, um GPUStack zu installieren:

curl -sfL https://get.gpustack.ai | sh -s -

- Nach der Installation wird GPUStack als Dienst auf dem systemd- oder launchd-System ausgeführt.

Windows (Computer)

- Führen Sie PowerShell als Administrator aus (vermeiden Sie die Verwendung von PowerShell ISE).

- Führen Sie den folgenden Befehl aus, um GPUStack zu installieren:

Invoke-Expression (Invoke-WebRequest -Uri "https://get.gpustack.ai" -UseBasicParsing).Content

Leitlinien für die Verwendung

Ersteinrichtung

- Zugang zu GPUStack UI: Im Browser öffnen

http://myserver. - Verwenden Sie den Standard-Benutzernamen

adminund das Anfangspasswort für die Anmeldung. Methode zum Abrufen des Anfangspassworts:- Linux oder MacOS: Ausführen

cat /var/lib/gpustack/initial_admin_password. - Windows: läuft

Get-Content -Path "$env:APPDATA\gpustack\initial_admin_password" -Raw.

- Linux oder MacOS: Ausführen

API-Schlüssel erstellen

- Nach der Anmeldung in der GPUStack UI klicken Sie im Navigationsmenü auf "API Keys".

- Klicken Sie auf die Schaltfläche "Neuer API-Schlüssel", geben Sie den Namen ein und speichern Sie ihn.

- Kopieren Sie den generierten API-Schlüssel und speichern Sie ihn ordnungsgemäß (nur zum Zeitpunkt der Erstellung sichtbar).

Verwendung der API

- Setzen von Umgebungsvariablen:

export GPUSTACK_API_KEY=myapikey

- Verwenden Sie curl, um auf OpenAI-kompatible APIs zuzugreifen:

curl http://myserver/v1-openai/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer $GPUSTACK_API_KEY" \

-d '{

"model": "llama3.2",

"messages": [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Hello!"}

],

"stream": true

}'

Laufen und Chatten

- Führen Sie den folgenden Befehl im Terminal aus, um mit dem Modell llama3.2 zu chatten:

gpustack chat llama3.2 "tell me a joke."

- Klicken Sie in der GPUStack-Benutzeroberfläche auf "Spielplatz", um zu interagieren.

Überwachung und Verwaltung

- Überwachen Sie die GPU-Leistung und -Nutzung in Echtzeit.

- Verwalten Sie Benutzer- und API-Schlüssel, verfolgen Sie die Token-Nutzung und die Preise.

Unterstützte Modelle und Plattformen

- Unterstützte Modelle: LLaMA, Mistral 7B, Mixtral MoE, Falcon, Baichuan, Yi, Deepseek, Qwen, Phi, Grok-1, und andere.

- Unterstützte multimodale Modelle: Llama3.2-Vision, Pixtral, Qwen2-VL, LLaVA, InternVL2, und andere.

- Unterstützte Plattformen: macOS, Linux, Windows.

- Unterstützte Beschleuniger: Apple Metal, NVIDIA CUDA, Ascend CANN, Moore Threads MUSA, mit zukünftigen Plänen zur Unterstützung von AMD ROCm, Intel oneAPI, Qualcomm AI Engine.

Dokumentation und Gemeinschaft

- Offizielle Dokumentation: siehe GPUStack-Dokumentation Hier finden Sie die vollständige Anleitung und API-Dokumentation.

- Beitragsleitfaden: Lesen Leitlinien für Beiträge Finden Sie heraus, wie Sie zu GPUStack beitragen können.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Verwandte Beiträge

Keine Kommentare...