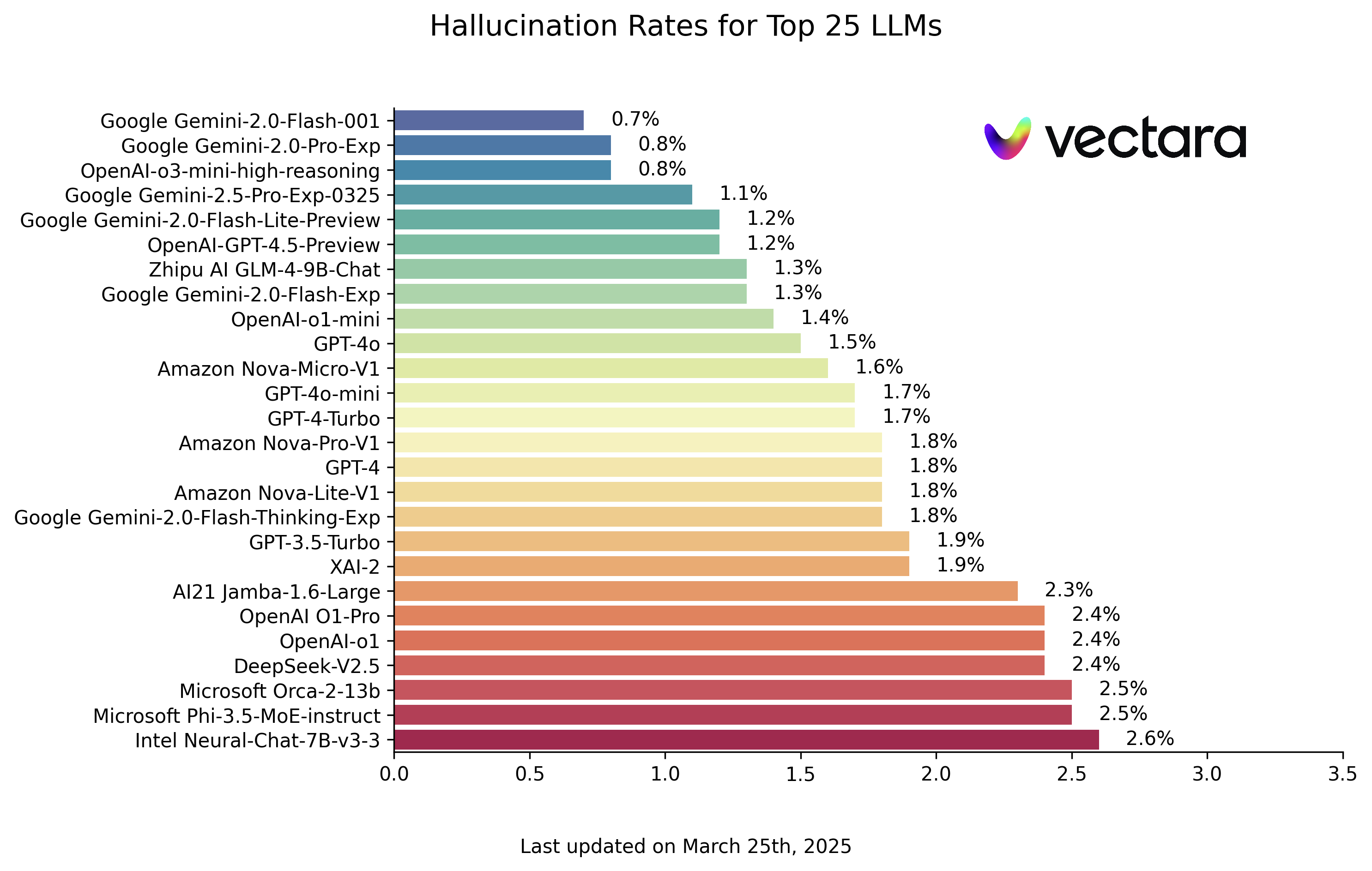

Google veröffentlicht sein eigenes KI-Modell: Gemini 2.0 Flash Thinking Experimental

Google hat ein neues KI-Modell veröffentlicht, das es "schlussfolgernd" nennt. Es befindet sich jedoch noch im Versuchsstadium, und unsere kurzen Tests haben gezeigt, dass es noch verbesserungswürdig ist.

Dieses neue Modell wird als Zwillinge 2.0 Flash Thinking Experimental (der Name ist etwas hochtrabend), das in der AI-Studio Es wird in der KI-Prototyping-Plattform von Google verwendet. Die Modellkarte beschreibt ihn als "am besten geeignet für multimodales Verstehen, logisches Denken und Codieren" und in der Lage, "die komplexesten Probleme in Bereichen wie Programmierung, Mathematik und Physik zu lösen".

In einem Beitrag auf X bezeichnete Logan Kilpatrick, der für das Produkt AI Studio verantwortlich ist, das Gemini 2.0 Flash Thinking Experimental als Googles "ersten Schritt auf einer Reise des Denkens". In seinem eigenen Beitrag sagte Jeff Dean, Chefwissenschaftler bei Google DeepMind, dass der Gemini 2.0 Flash Thinking Experimental darauf trainiert ist, Gedanken zu nutzen, um das Denken zu verbessern.

"Wir sahen ermutigende Ergebnisse, als wir den Rechenaufwand für die Inferenzzeit erhöhten", sagte Dean und bezog sich damit auf den Rechenaufwand, den das Modell zur Beantwortung der Frage benötigt.

Das Gemini 2.0 Flash Thinking Experimental baut auf dem kürzlich veröffentlichten Gemini 2.0 Flash-Modell von Google auf, das ähnlich wie das o1-Modell von OpenAI und andere sogenannte Inferenzmodelle konzipiert zu sein scheint. Im Gegensatz zu den meisten KI-Modellen überprüft sich das Inferenzmodell effektiv selbst und vermeidet so einige der Fallstricke, die KI-Modelle normalerweise zu Fehlern verleiten.

Ein Nachteil von Schlussfolgerungsmodellen ist jedoch, dass sie in der Regel länger brauchen - oft Sekunden bis Minuten - um zu einer Lösung zu gelangen.

Auf eine Frage hin hält das Gemini 2.0 Flash Thinking Experimental inne, bevor es antwortet, zieht mehrere verwandte Fragen in Betracht und "erklärt" dabei seine Überlegungen. Später fasst das Modell zusammen, was es für die genaueste Antwort hält.

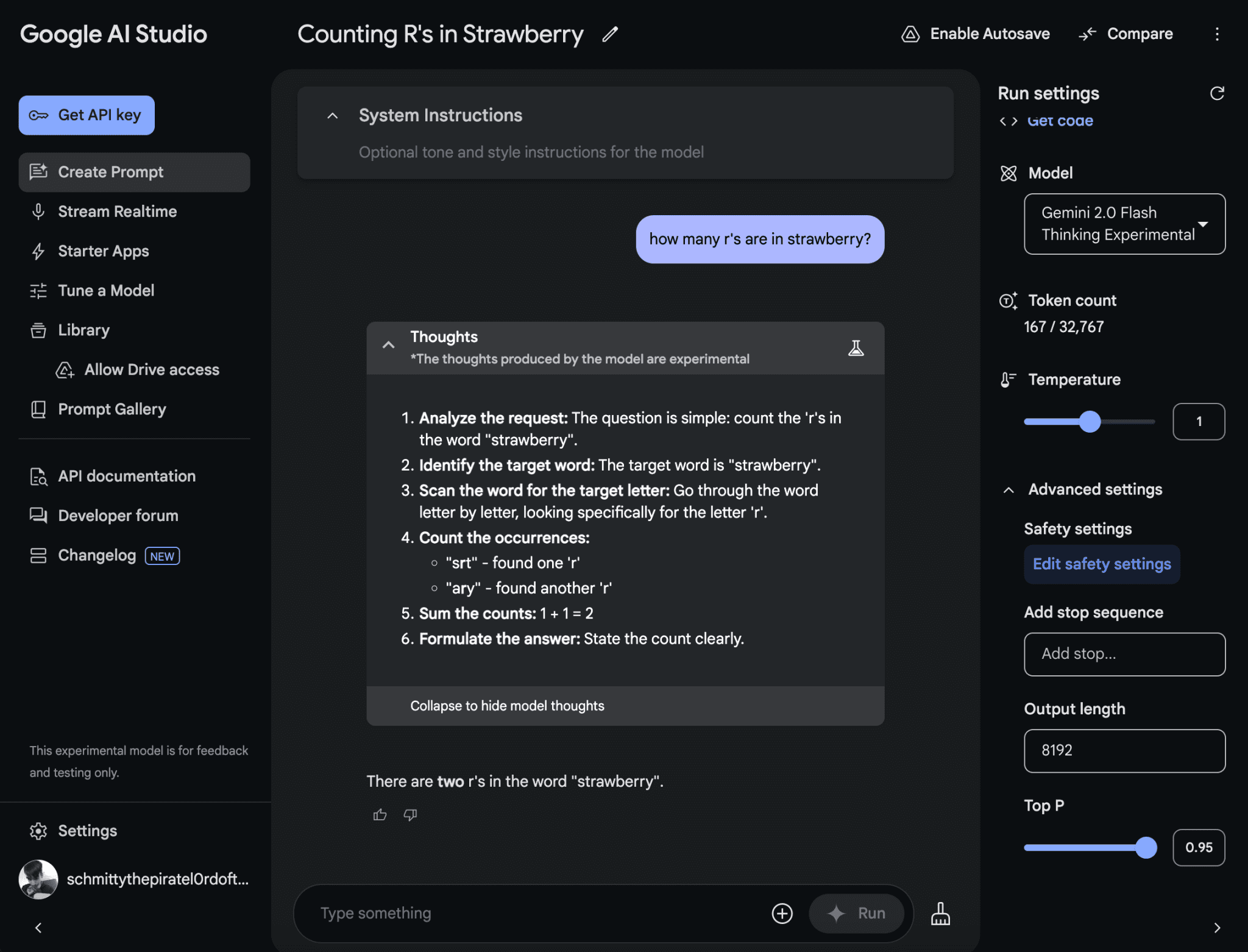

Nun, theoretisch sollte es das. Als ich Gemini 2.0 Flash Thinking Experimental fragte, wie viele Rs in dem Wort "Erdbeere" enthalten sind, antwortete es "zwei".

Das neue Inferenzmodell von Google ist beim Zählen der Buchstaben von Wörtern nicht sehr leistungsfähig und macht manchmal Fehler. Bildnachweis: Google

Die tatsächlichen Ergebnisse können von Person zu Person variieren.

Nach der Veröffentlichung von o1 gab es eine Explosion von Inferenzmodellen von konkurrierenden KI-Labors - und nicht nur von Google. ein KI-Forschungsunternehmen, das von quantitativen Händlern finanziert wird DeepSeek stellte Anfang November sein erstes Inferenzmodell, DeepSeek-R1, vor, und im selben Monat veröffentlichte das Qwen-Team von Alibaba das angeblich erste Inferenzmodell für die offene Herausforderung o1.

Im Oktober wurde berichtet, dass Google mehrere Teams hat, die an Inferenzmodellen arbeiten. In einem Bericht vom November enthüllte The Information dann, dass Google mindestens 200 Forscher hat, die sich mit dieser Technologie beschäftigen.

Was hat den Boom bei der Inferenzmodellierung ausgelöst? Ein Grund ist die Suche nach neuen Wegen zur Verbesserung der generativen KI. Wie mein Kollege Max Zeff kürzlich berichtete, bringen "Brute-Force"-Techniken zur Skalierung von Modellen nicht mehr die Verbesserungen, die sie einst brachten.

Nicht jeder ist davon überzeugt, dass Inferenzmodelle der beste Weg in die Zukunft sind. Zum einen sind sie in der Regel kostspielig, da für die Ausführung der Modelle eine hohe Rechenleistung erforderlich ist. Und obwohl sie in Benchmarks gut abschneiden, ist es nicht klar, ob Inferenzmodelle dieses Tempo beibehalten können.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...