Google veröffentlicht Gemma 3 QAT-Modell: Spitzen-KI-Modelle für Consumer-GPUs

Nach der Einführung einer neuen Generation von offenen Modellen im letzten Monat Gemma 3 Google hat kürzlich sein Modell-Ökosystem um eine neue Version erweitert, die für Quantization-Aware Training (QAT) optimiert ist. Gemma 3 wurde zuvor verwendet in BF16 Die Genauigkeit ist geringer als die einer einzelnen High-End-GPU (z. B. NVIDIA H100Die QAT-Version wurde entwickelt, um den Speicherbedarf der Modelle deutlich zu reduzieren und gleichzeitig die höchstmögliche Qualität der Ausgabe beizubehalten, so dass leistungsstarke KI-Modelle auf verbraucherfreundlicherer Hardware laufen können. Die QAT-Version wurde entwickelt, um den Speicherbedarf des Modells deutlich zu reduzieren und gleichzeitig die höchstmögliche Qualität der Ausgabe beizubehalten, so dass leistungsstarke KI-Modelle auf verbraucherfreundlicherer Hardware ausgeführt werden können.

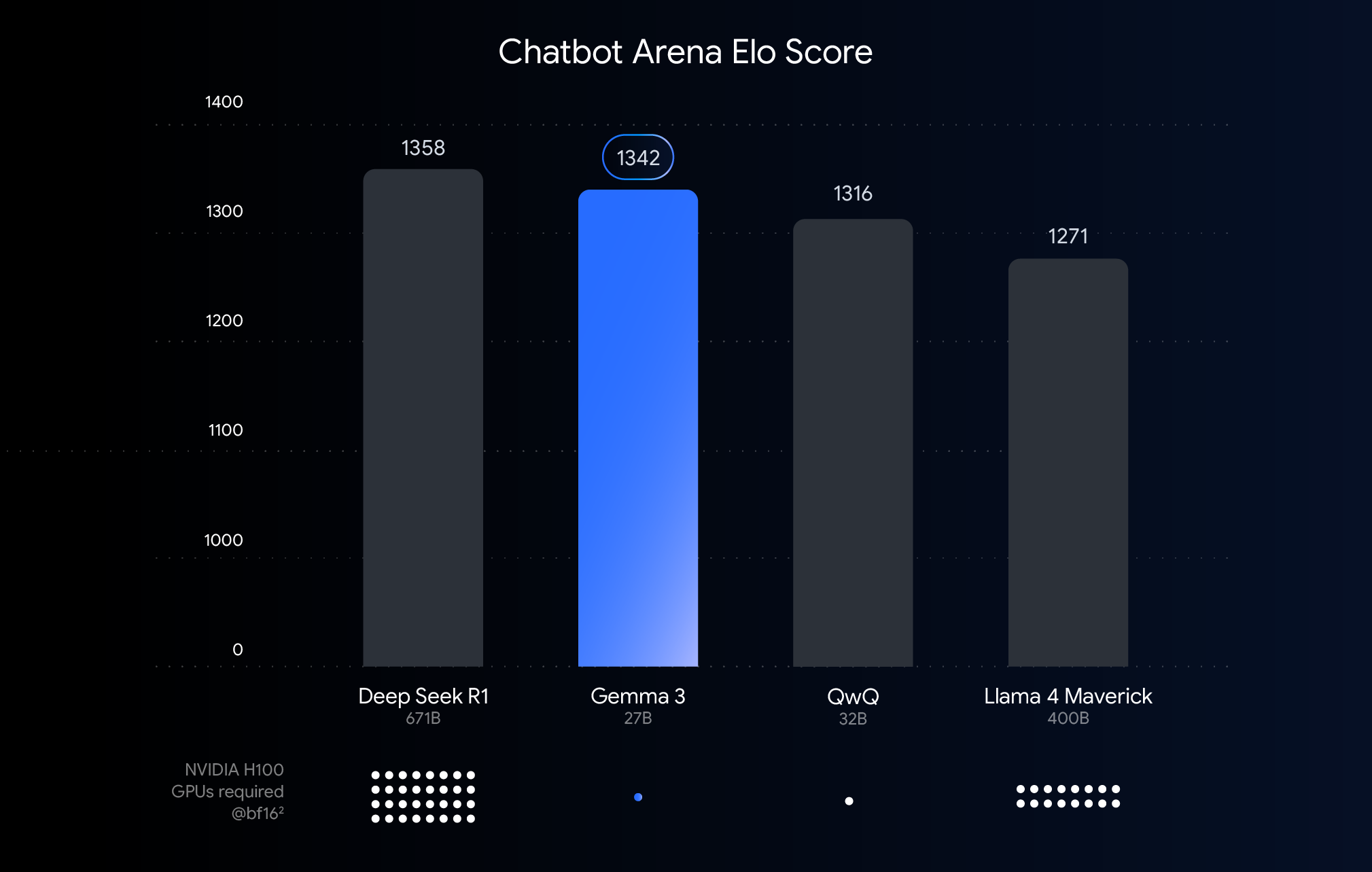

Dieses Diagramm zeigt die Rangfolge der KI-Modelle auf der Grundlage der Chatbot-Arena-Elo-Punkte, wobei eine höhere Punktzahl für eine höhere Benutzerpräferenz steht. Die Punkte zeigen an, was das Modell zur Ausführung benötigt NVIDIA H100 Die geschätzte Anzahl der GPUs.

Verständnis der Schwellenwerte für Leistung, Genauigkeit und Quantifizierung

Das obige Diagramm zeigt einen Vergleich der Leistung (Elo-Scores) von kürzlich veröffentlichten großen Sprachmodellen. Höhere Balken bedeuten, dass die Modelle in anonymen, von menschlichen Bewertern durchgeführten Seite-an-Seite-Vergleichen besser abschneiden. Der untere Teil des Diagramms kennzeichnet die Leistung auf dem BF16 die für die Ausführung jedes Modells unter dem Datentyp NVIDIA H100 GPU Geschätzte Anzahl.

Option BF16 Der Vergleich wird vorgenommen, weil es sich um ein häufig verwendetes numerisches Format für viele groß angelegte Modellinferenzen handelt, das Modellparameter mit einer Genauigkeit von 16 Bit darstellt. Im Fall der vereinheitlichten BF16 Vergleiche unter diesen Bedingungen helfen dabei, die inhärenten Fähigkeiten des Modells selbst in derselben Inferenzkonfiguration zu bewerten, wobei Variablen, die durch unterschiedliche Hardware oder Optimierungstechniken wie Quantisierung eingeführt werden, ausgeschlossen werden.

Es ist erwähnenswert, dass das Diagramm zwar die BF16 einen fairen Vergleich anstellen, aber beim tatsächlichen Einsatz von sehr großen Modellen ist es zur Reduzierung der enormen Anforderungen an die Hardware (z. B. die Anzahl der Grafikprozessoren) oft notwendig, ein System wie das FP8 und andere Formate mit geringerer Genauigkeit, was einen Kompromiss zwischen Leistung und Machbarkeit erfordern kann.

Hardware-Barrieren abbauen: KI leichter zugänglich machen

Während Gemma 3 auf High-End-Hardware für Cloud-Implementierungen und Forschungsszenarien gut funktioniert, zeigt das Feedback der Nutzer deutlich, dass der Markt erwartet, die Fähigkeiten von Gemma 3 auf vorhandener Hardware nutzen zu können. Die zunehmende Verbreitung leistungsstarker KI-Technologien bedeutet, dass die Modelle effizient auf Consumer-GPUs laufen müssen, die üblicherweise auf Desktops, Laptops und sogar mobilen Geräten zu finden sind. Die lokale Ausführung großer Modelle verbessert nicht nur den Datenschutz, verringert die Netzwerklatenz und unterstützt Offline-Anwendungen, sondern bietet auch mehr Raum für die Anpassung durch den Benutzer.

QAT-Technologie: Der Schlüssel zum Gleichgewicht zwischen Leistung und Zugänglichkeit

Quantifizierungstechniken sind der Schlüssel zur Erreichung dieses Ziels. Bei der KI-Modellierung zielt die Quantisierung darauf ab, die Genauigkeit der Zahlen (d. h. der Modellparameter) zu verringern, die bei der Modellspeicherung und -berechnung verwendet werden. Dies ist vergleichbar mit der Komprimierung eines Bildes durch Verringerung der Anzahl der im Bild verwendeten Farben. Im Vergleich zur Verwendung von 16 Bit pro Zahl (BF16), kann die Quantisierung weniger Bits verwenden, zum Beispiel 8 Bits (int8) oder sogar 4-Bit (int4).

Adoption int4 Dies bedeutet, dass jede Ziffer durch nur 4 Bits dargestellt wird und die Datengröße kleiner ist als die BF16 Um den Faktor 4 reduziert. Herkömmliche Quantisierungsmethoden (z. B. Post-Training-Quantisierung PTQ) werden in der Regel nach dem Training des Modells durchgeführt, was einfach zu implementieren ist, aber zu erheblichen Leistungseinbußen führen kann. Die von Google verwendete QAT-Technik ist anders.

QAT führt während des Modelltrainings einen Quantisierungsschritt ein, um Operationen mit geringer Genauigkeit zu simulieren. Dieser Ansatz ermöglicht es dem Modell, sich noch während des Trainings an die Umgebung mit geringer Genauigkeit anzupassen, wodurch die Genauigkeit bei der anschließenden Quantisierung besser beibehalten werden kann, was kleinere, schnellere Modelle ermöglicht. Konkret wendete Google ca. 5.000 QAT-Schritte auf das Gemma-3-Modell an, um die Wahrscheinlichkeit eines nicht quantisierten Kontrollpunkts zu ermitteln. Auf diese Weise wird behauptet, dass nach der Quantisierung auf Q4_0 Die Komplexität, ein Maß für die Vorhersagekraft des Modells, nimmt um 54% ab, wenn das Format (unter Verwendung des lama.cpp (Bewertung).

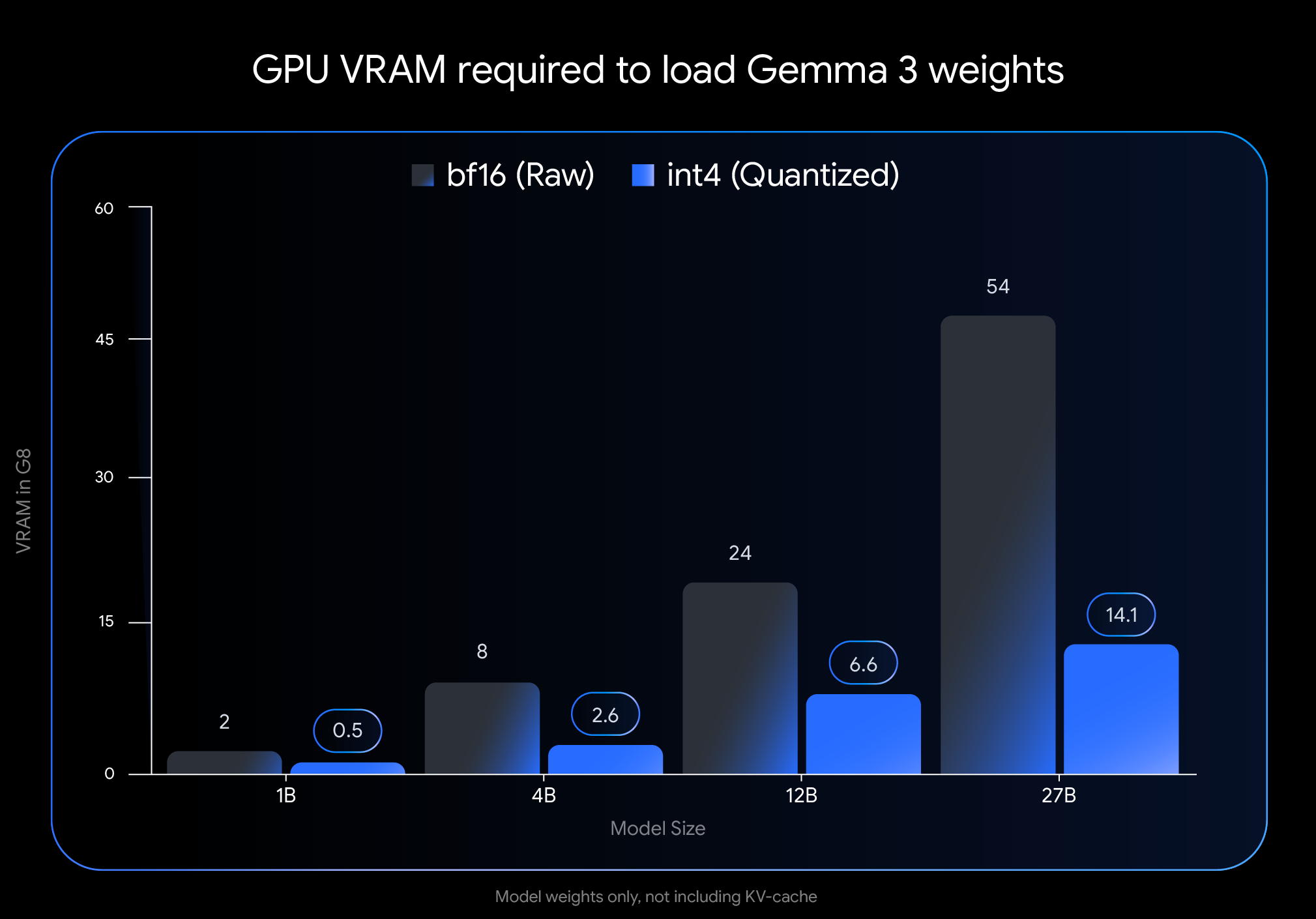

Signifikanter Effekt: Die VRAM-Nutzung wird drastisch reduziert

int4 Die Auswirkungen der Quantisierung sind beträchtlich, insbesondere im Hinblick auf die Menge an Videospeicher (VRAM), die zum Laden der Modellgewichte erforderlich ist:

- Gemma 3 27B. Von 54 GB (

BF16) an 14,1 GB (int4) - Gemma 3 12B. Ab 24 GB (

BF16) Reduktion auf 6,6 GB (int4) - Gemma 3 4B. Ab 8 GB (

BF16) Reduziert auf 2,6 GB (int4) - Gemma 3 1B. Ab 2 GB (

BF16) an 0,5 GB (int4)

Vorsicht! Diese Daten stellen nur den VRAM dar, der zum Laden der Modellgewichte benötigt wird. Die Ausführung des Modells erfordert außerdem zusätzlichen VRAM für den KV-Cache, der Dialogkontextinformationen speichert, deren Größe von der Kontextlänge abhängt.

Führe Gemma 3 auf deinem Gerät aus!

Die drastische Verringerung des Grafikspeicherbedarfs ermöglicht die Ausführung größerer, leistungsfähigerer Modelle auf weit verbreiteter Consumer-Hardware:

- Gemma 3 27B (

int4): Jetzt ist es einfach, auf einem einzigen Desktop der 24-GB-VRAM-Klasse zu laufenNVIDIA RTX 3090oder ähnlichen Grafikkarten konnten die Nutzer Googles größte Gemma-3-Variante lokal ausführen. - Gemma 3 12B (

int4): Die Fähigkeit, auf Laptop-Grafikprozessoren mit 8 GB VRAM (wie z. B. demNVIDIA RTX 4060 Laptop GPUDas Unternehmen bringt auch leistungsstarke KI-Funktionen auf tragbare Geräte. - Kleinere Modelle (4B, 1B). Ermöglicht eine bessere Zugänglichkeit für ressourcenbeschränkte Systeme, einschließlich einiger mobiler Geräte.

Einfache Integration in gängige Tools

Um es den Nutzern zu erleichtern, diese Modelle in ihren eigenen Arbeitsabläufen zu verwenden, hat Google die Hugging Face im Gesang antworten Kaggle Die offizielle int4 im Gesang antworten Q4_0 Unquantifizierte QAT-Modelle. Gleichzeitig ist Google eine Partnerschaft mit mehreren beliebten Entwickler-Tools eingegangen, um den Nutzern die Möglichkeit zu geben, QAT-basierte quantifizierte Kontrollpunkte nahtlos auszuprobieren:

- Ollama. Alle Gemma 3 QAT-Modelle werden von Haus aus unterstützt und können mit einem einfachen Befehl schnell ausgeführt werden.

- LM Studio. Bietet eine benutzerfreundliche Schnittstelle zum einfachen Herunterladen und Ausführen von Gemma 3 QAT-Modellen auf Ihrem Desktop.

- MLX. nutzen.

MLXDer Rahmen ist inApple SiliconEffiziente und optimale Inferenz von Gemma 3 QAT-Modellen auf dem - Gemma.cpp. Eine spezielle C++-Implementierung von Google für effiziente Inferenz auf der CPU.

- llama.cpp. Native Unterstützung für QAT-Modelle im GGUF-Format zur einfachen Integration in bestehende Arbeitsabläufe.

Mehr quantitative Optionen in der Gemmaverse-Ökologie

Zusätzlich zu dem offiziell veröffentlichten QAT-Modell werden aktive Gemmaverse Die Gemeinschaft bietet auch viele Alternativen an. Diese Systeme verwenden in der Regel Post-Training-Quantisierungsverfahren (PTQ), die von der Bartowski, Unsloth, GGML und anderen Beiträgen von Gemeindemitgliedern, und in Hugging Face Verfügbar am. Die Erkundung dieser Community-Optionen bietet den Nutzern eine breitere Palette an Möglichkeiten, zwischen Modellgröße, Geschwindigkeit und Qualität zu wählen, um spezifische Anforderungen zu erfüllen.

Beginnen Sie jetzt!

Die Bereitstellung modernster KI-Leistung auf leicht zugänglicher Hardware ist ein wichtiger Schritt zur Demokratisierung der KI-Entwicklung. Mit den Gemma 3-Modellen, die durch QAT optimiert wurden, können Nutzer nun modernste KI-Funktionen auf ihrem eigenen Desktop oder Laptop nutzen. Dies senkt nicht nur die Hürde für Entwickler und Forscher, groß angelegte Sprachmodelle zu erforschen, sondern signalisiert auch das Potenzial für leistungsfähigere KI-Anwendungen.

Erforschen Sie quantitative Modelle und beginnen Sie mit deren Erstellung:

- Verwendung auf einem PC

OllamaLaufen:https://ollama.com/library/gemma3 - existieren

Hugging Faceim Gesang antwortenKaggleSchauen Sie sich das Modell an: - Läuft auf mobilen Geräten (über

Google AI Edge):https://developers.googleblog.com/en/gemma-3-on-mobile-and-web-with-google-ai-edge/

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Verwandte Beiträge

Keine Kommentare...