GLM-4.5V - Multimodales Open-Source-Modell für visuelles Reasoning von Smart Spectrum

Was ist GLM-4.5V?

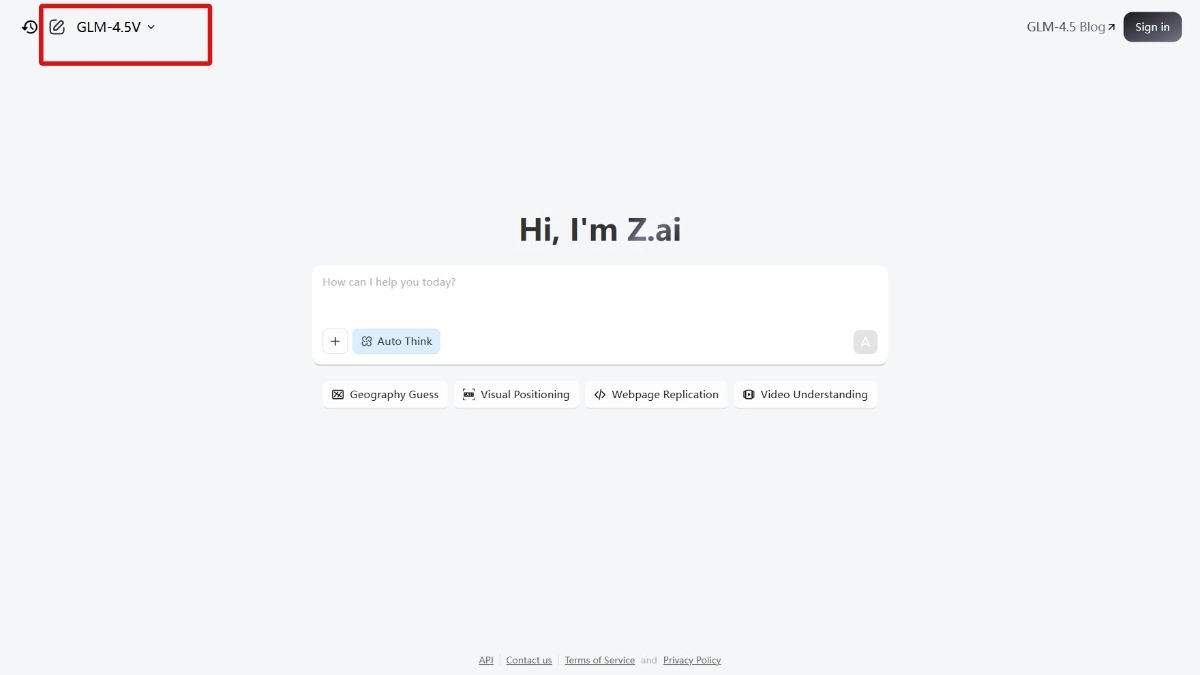

GLM-4.5V ist das weltweit führende quelloffene visuelle Inferenzmodell von Smart Spectrum mit 106 Milliarden Gesamtparametern und 12 Milliarden aktivierten Parametern. Das Modell basiert auf einer neuen Generation von TextbasismodellenGLM-4.5-LuftGLM-4.5 ist auf ein starkes visuelles Verständnis und schlussfolgernde Fähigkeiten trainiert und kann ein breites Spektrum an visuellen Inhalten wie Bilder, Videos, Dokumente usw. verarbeiten. Das Modell erbringt gute Leistungen bei multimodalen Aufgaben, die Szenarien wie visuelle Fragen und Antworten, die Erstellung von Bildbeschreibungen, das Verstehen von Videos und die Replikation von Web-Frontends abdecken, und unterstützt gleichzeitig den flexiblen Wechsel zwischen schneller Antwort und tiefgreifender Schlussfolgerung.GLM-4.5V erreicht SOTA-Leistung in 41 öffentlich verfügbaren visuellen multimodalen Listen und erzielt visuelle Schlussfolgerungen für alle Szenarien durch effizientes hybrides Training, was kostengünstige multimodale KI-Lösungen für Unternehmen und Entwickler ermöglicht. Lösungen für Unternehmen und Entwickler.

Funktionsmerkmale des GLM-4.5V

- grafische ArgumentationObjekte, Beziehungen zwischen Figuren und Hintergrundinformationen in komplexen Szenen verstehen können.

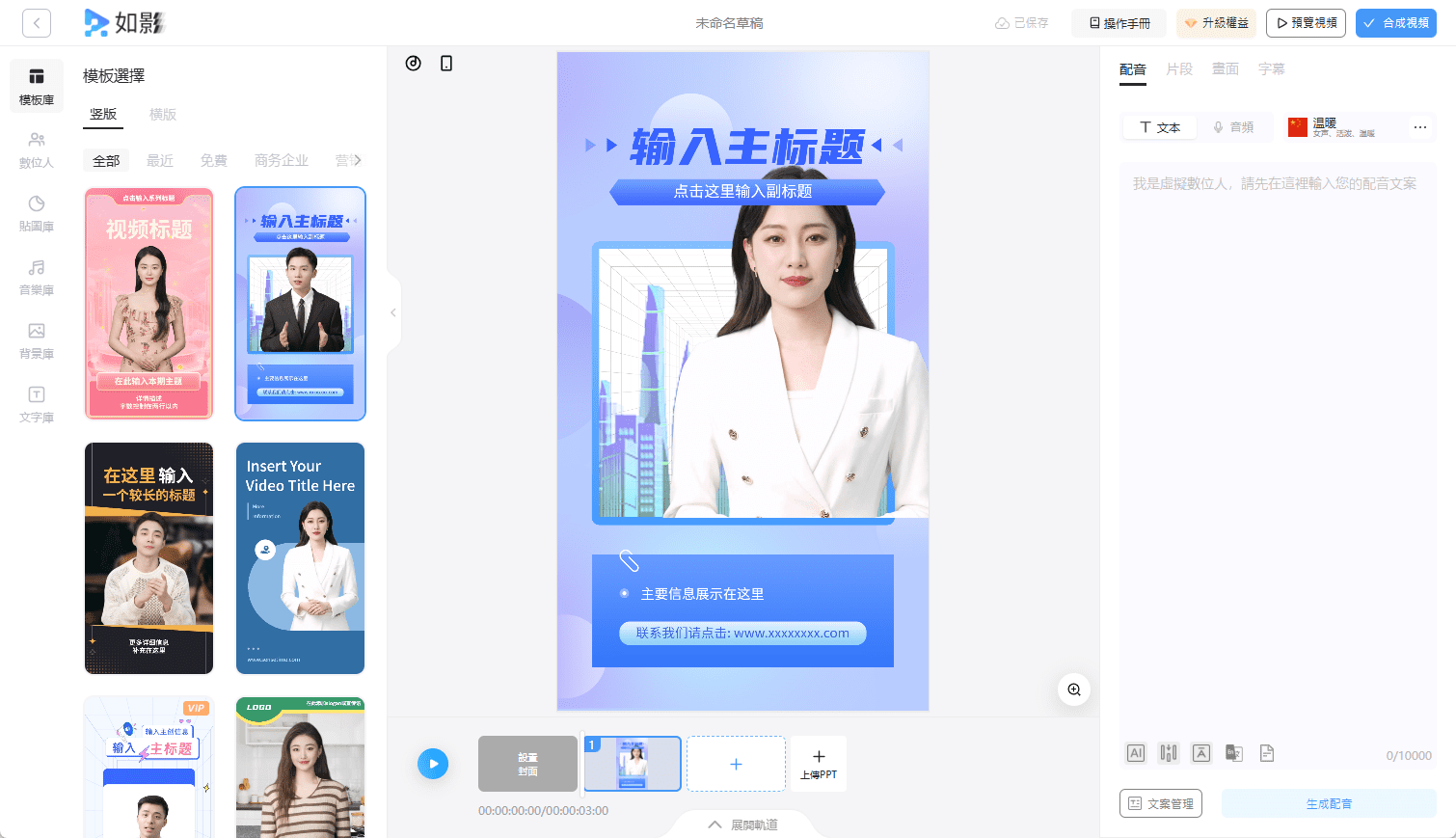

- Video-VerständnisUnterstützt die Analyse langer Videoinhalte, einschließlich geteilter Szenen, Ereigniserkennung und Extraktion von Schlüsselinformationen.

- Multimodale Interaktionsmöglichkeiten::

- Textliche und visuelle IntegrationUnterstützung für die Generierung von Bildern aus Textbeschreibungen bzw. von Textbeschreibungen aus Bildern.

- Modalübergreifende ErzeugungDie Fähigkeit, visuelle Inhalte in Text oder Textinhalte in visuelle Inhalte umzuwandeln.

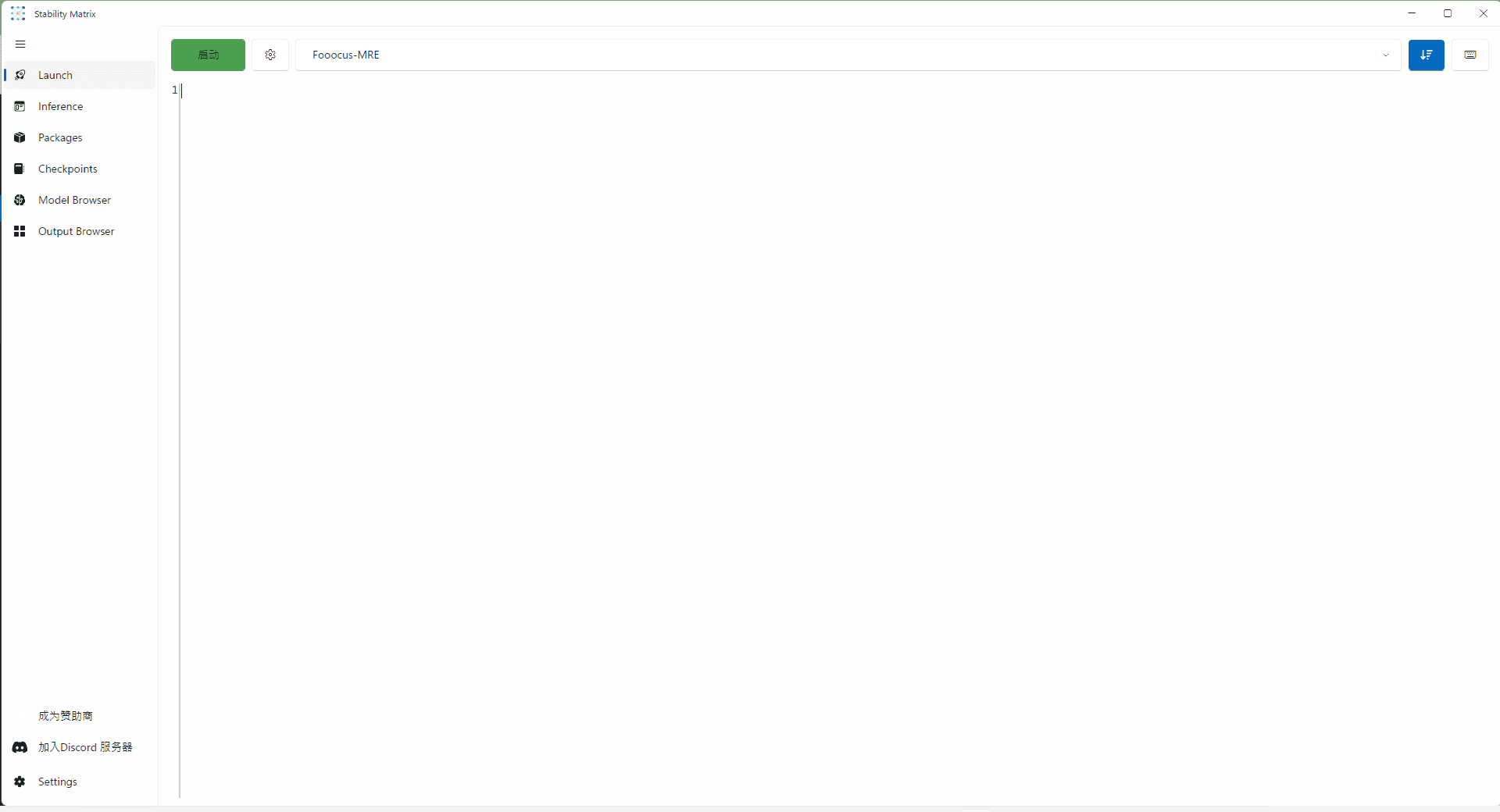

- Web-Frontend-ReplikEs kann Front-End-Code auf der Grundlage von Webdesign-Zeichnungen für eine schnelle Webentwicklung generieren. Benutzer müssen nur Screenshots von Webseiten oder interaktive Videos hochladen, und das Modell kann vollständigen HTML-, CSS- und JavaScript-Code generieren.

- Touhou-SpieleUnterstützt bildbasierte Such- und Abgleichsaufgaben. Zum Beispiel das schnelle Auffinden bestimmter Zielbilder in komplexen Szenen, geeignet für Sicherheitsüberwachung, intelligenten Einzelhandel und die Entwicklung von Unterhaltungsspielen.

- Komplexe Dokumentation InterpretationFähigkeit, mit langen Dokumenten und komplexen Diagrammen zu arbeiten, Informationen zu extrahieren, zusammenzufassen und zu übersetzen. Unterstützt den Export Ihrer eigenen "Sichtweise", nicht nur die einfache Extraktion von Informationen.

Die wichtigsten Vorteile des GLM-4.5V

- Ausgeprägtes visuelles Verständnis und logisches DenkenKann komplexe visuelle Inhalte, einschließlich Bilder, Videos und Dokumente, umfassend verstehen. Kann nicht nur Objekte, Szenen und Beziehungen zwischen Menschen erkennen, sondern auch fortgeschrittene Schlussfolgerungen ziehen, z. B. aus subtilen Hinweisen in einem Bild auf Kontextinformationen schließen.

- Multimodale Interaktion und GenerierungsmöglichkeitenUnterstützung für die nahtlose Integration von Text und visuellen Inhalten, mit der Möglichkeit, Bilder aus Textbeschreibungen oder Textbeschreibungen aus Bildern zu generieren. Das Modell unterstützt die Implementierung der cross-modalen Generierung, z. B. die Umwandlung von visuellen Inhalten in Text oder von Textinhalten in visuelle Inhalte.

- Effiziente Aufgabenanpassung und Reasoning-ModellDurch effizientes hybrides Training ist es mit visuellen Schlußfolgerungsfähigkeiten ausgestattet und kann eine breite Palette von Aufgaben bewältigen, wie z.B. Bildschlussfolgerungen, Videoverständnis, GUI-Aufgaben und Parsing von komplexen Diagrammen und langen Dokumenten.

- Kostengünstige und schnelle BereitstellungInferenzgeschwindigkeit und Bereitstellungskosten unter Beibehaltung einer hohen Genauigkeit ausgleichen. Der Preis für den API-Aufruf liegt bei nur 2 Mio. $ für die Eingabe und 6 Mio. $ für die Ausgabe, bei einer Antwortgeschwindigkeit von 60-80 Token/s.

- Open Source und breite Unterstützung durch die GemeinschaftBereitstellung mehrerer Kanäle, wie z. B. GitHub-Repository, Hugging Face Model Repository und Magic Ride-Community, um Entwicklern den Schnellstart und die Sekundärentwicklung zu erleichtern, und Bereitstellung einer Desktop-Assistenten-Anwendung zur Unterstützung von Screenshots und Bildschirmaufnahmen in Echtzeit, um Entwicklern die Erfahrung mit der Modellfähigkeit zu erleichtern.

- Breite Palette von AnwendungsszenarienFür eine Vielzahl von realen Anwendungsszenarien, einschließlich der Replikation von Web-Frontends, visuellem Quiz, Graphen-Suchspielen, Videoverstehen, Generierung von Bildbeschreibungen und der Interpretation komplexer Dokumente.

Wie lautet die offizielle Website von GLM-4.5V?

- GitHub-Repository:: https://github.com/zai-org/GLM-V/

- HuggingFace-Modellbibliothek:: https://huggingface.co/collections/zai-org/glm-45v-68999032ddf8ecf7dcdbc102

- Technische Papiere:: https://github.com/zai-org/GLM-V/tree/main/resources/GLM-4.5V_technical_report.pdf

- Desktop-Assistent Anwendung:: https://huggingface.co/spaces/zai-org/GLM-4.5V-Demo-App

Personen, für die GLM-4.5V geeignet ist

- EntwicklerBietet Entwicklern leistungsstarke multimodale Entwicklungsfunktionen, mit denen sie schnell Anwendungen wie visuelle Quizze, Bilderzeugung, Videoanalyse und mehr erstellen können.

- GeschäftskundeUnternehmen nutzen die Möglichkeiten des visuellen Verständnisses zur Optimierung von Geschäftsszenarien wie Sicherheit und Überwachung, intelligenter Einzelhandel und Videoempfehlungen.

- ForschungsmitarbeiterForscher nutzen die Open-Source-Modelle und -Datensätze von GLM-4.5V, um Spitzenforschung in den Bereichen multimodale Argumentation, visuelle Sprachfusion und mehr zu betreiben.

- regelmäßiger BenutzerGewöhnliche Nutzer verwenden Funktionen wie Bildbeschreibungen und Videoverständnis, um die Effizienz der Inhaltserstellung und den Informationszugang zu verbessern.

- Lehrkräfte und StudentenPädagogen und Studenten, um das Lehren und Lernen zu unterstützen und die Bildungserfahrung zu verbessern.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Verwandte Beiträge

Keine Kommentare...