Gemini Cursor: ein intelligenter KI-Desktop-Assistent, der auf Gemini aufbaut und sehen, hören und sprechen kann

Allgemeine Einführung

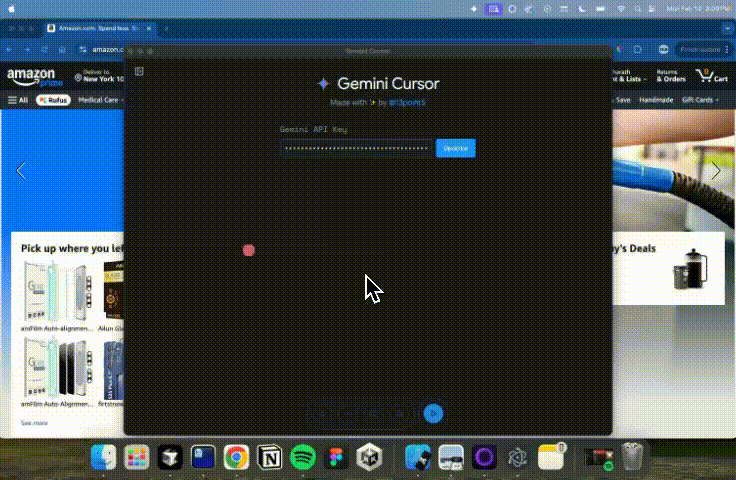

ZwillingeCursor ist ein intelligenter Desktop-Assistent, der auf dem (experimentellen) Gemini 2.0 Flash-Modell von Google basiert. Er ermöglicht visuelle, auditive und sprachliche Interaktionen über eine multimodale API und bietet eine Echtzeit-Nutzererfahrung mit geringer Latenzzeit. Das von @13point5 ins Leben gerufene Projekt zielt darauf ab, den KI-Assistenten zu nutzen, um Nutzern zu helfen, komplexe Aufgaben effizienter auszuführen, wie z. B. das Verstehen komplexer Diagramme in Forschungsarbeiten, das Ausführen von Aufgaben auf Websites (z. B. das Hinzufügen von Zahlungsmethoden auf Amazon) und das Unterrichten als KI-Lehrer in Echtzeit unter Verwendung eines Whiteboards.

Funktionsliste

- AI intelligenter AssistentFügen Sie Ihrem Desktop einen intelligenten Assistenten hinzu, der den Bildschirm sehen, den Benutzer hören und mit ihm sprechen kann.

- multimodale InteraktionUnterstützt visuelle, auditive und sprachliche Interaktionen für eine natürlichere Benutzererfahrung.

- Niedrige Latenzzeit in EchtzeitGeringe Latenzzeit bei Interaktionen, um das Benutzererlebnis zu verbessern.

- Komplexe AufgabennavigationHilfe bei der Durchführung von Aufgaben auf komplexen Websites, z. B. beim Hinzufügen von Zahlungsmitteln.

- KI-Lehrer in EchtzeitEchtzeit-Unterricht durch Whiteboard-Funktionen zum Verständnis komplexer Diagramme und Architekturkarten.

Hilfe verwenden

Einbauverfahren

- Klon-Lager::

git clone https://github.com/13point5/gemini-cursor.git

cd gemini-cursor

- Installation von Abhängigkeiten::

npm install

- Ausführen der Anwendung::

npm run start

- API-Schlüssel konfigurieren::

- Geben Sie in der Anwendung Zwillings-API Schlüssel.

- Klicken Sie auf die Schaltfläche Abspielen und auf die Schaltfläche Bildschirm freigeben.

- Minimieren Sie die App und legen Sie los.

Funktion Betriebsanleitung

- AI intelligenter Assistent::

- Wenn Sie die App starten, erscheint der KI-Assistent auf Ihrem Desktop.

- Der Assistent ist in der Lage, den Bildschirminhalt zu sehen, die Sprachbefehle des Benutzers zu hören und mit dem Benutzer per Sprache zu interagieren.

- multimodale Interaktion::

- Die App unterstützt die Aufnahme von Bildschirminhalten über die Kamera und den Empfang von Sprachbefehlen über das Mikrofon.

- Benutzer können den Assistenten über Sprachbefehle steuern, um verschiedene Vorgänge auszuführen, wie z. B. das Öffnen von Dateien und das Surfen im Internet.

- Komplexe Aufgabennavigation::

- Nutzer können dem Assistenten per Sprachbefehl erlauben, Aufgaben auf komplexen Websites auszuführen.

- Beim Hinzufügen einer Zahlungsmethode auf Amazon beispielsweise teilt der Nutzer dem Assistenten einfach die auszuführenden Schritte mit, und der Assistent navigiert automatisch und führt die Aktion aus.

- KI-Lehrer in Echtzeit::

- Nach dem Starten der Whiteboard-Funktion können die Nutzer den Assistenten per Sprachbefehl Diagramme, Markierungen usw. auf das Whiteboard zeichnen lassen.

- Ideal für den Unterricht und die Veranschaulichung komplexer Konzepte, z. B. Diagramme und Architekturpläne in Forschungsarbeiten.

allgemeine Probleme

- Wie erhalte ich einen Gemini-API-Schlüssel?

- Die Nutzer müssen die Gemini-API-Plattform von Google besuchen, um sich zu registrieren und einen API-Schlüssel zu erhalten.

- Was soll ich tun, wenn ich einen Fehler erhalte, während die Anwendung läuft?

- Stellen Sie sicher, dass die Node.js-Version v16 oder höher ist und dass alle Abhängigkeiten ordnungsgemäß installiert sind.

- Prüfen Sie, ob der API-Schlüssel richtig konfiguriert ist.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...