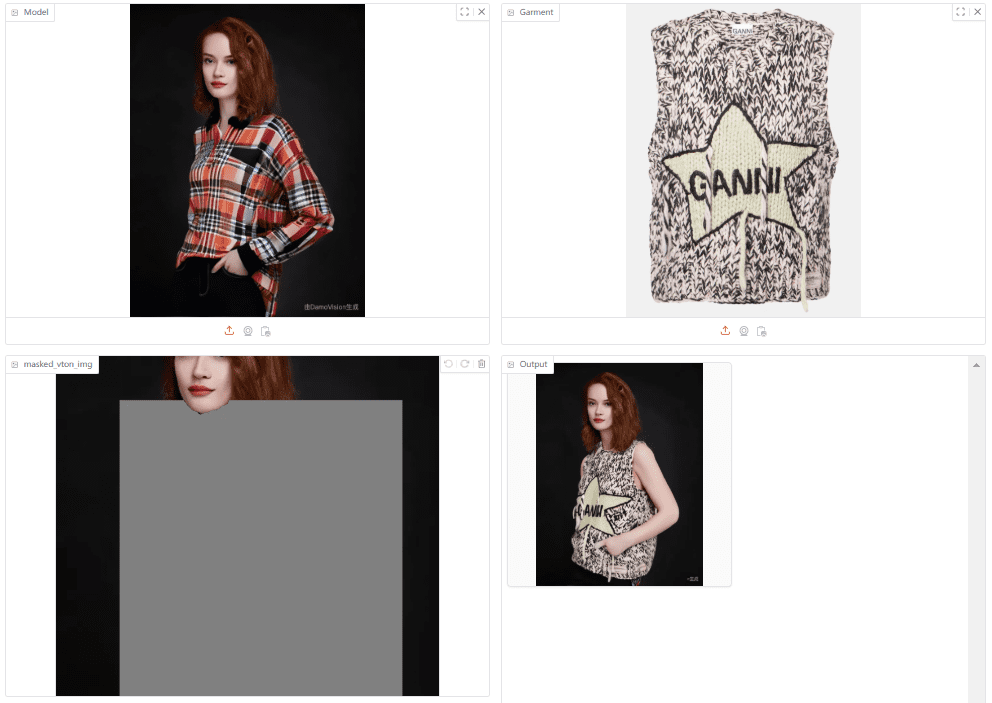

FitDiT: Ein virtuelles Anprobetool mit hoher Wiedergabetreue zur Verbesserung der Authentizität von Kleidungsdetails

Allgemeine Einführung

FitDiT ist ein virtuelles Anprobesystem mit hoher Wiedergabetreue, das auf Diffusionstransformatoren basiert. Das vom Tencent AI Lab entwickelte Projekt zielt darauf ab, die Grenzen herkömmlicher virtueller Anprobesysteme bei der Darstellung von Kleidungsdetails zu überwinden. FitDiT schlägt eine neue algorithmische Architektur vor, die die authentischen Details der Kleidung besser bewahrt und die virtuelle Anprobe realistischer gestaltet. Das Projekt ist vollständig quelloffen und bietet Online-Demos, vortrainierte Modelle und vollständige Code-Implementierungen zur Unterstützung von Forschern und Entwicklern für die akademische Forschung und kommerzielle Vorstudien. Das Projekt veröffentlichte das Papier im November 2024 und öffnete im Dezember 2024 die Online-Demo, den Datensatz und die Modellgewichte, was in der Wissenschaft und der Industrie große Aufmerksamkeit erregte.

Online-Demo: https://huggingface.co/spaces/BoyuanJiang/FitDiT

Funktionsliste

- Vollständig automatisierte Funktion zur Erzeugung virtueller Anproben

- Intelligente Maskenerstellung für den Anpassungsbereich

- Manuelle Maskenanpassung und Bearbeitungswerkzeuge

- Unterstützung von Anpassungseffekten mit mehreren Auflösungen

- Optimierung der Detailtreue von Kleidungsstücken

- Unterstützung einer Online-Präsentationsplattform (Gradio-Schnittstelle)

- Unterstützung der lokalen Bereitstellung (Unterstützung mehrerer Leistungskonfigurationen)

- Complex Virtual Dressing Dataset (CVDD) Datensatz

- Vollständiger Code für Modellschulung und -inferenz

- Hugging Face Model Hosting Integration

Hilfe verwenden

1. online Zugang

FitDiT bietet zwei Möglichkeiten, es online zu nutzen:

- Online-Demo des Hugging Face Space: https://huggingface.co/spaces/BoyuanJiang/FitDiT

- Offizielle Online-Demoplattform: besuchen Sie http://demo.fitdit.byjiang.com/

Schritte zur Anwendung:

Schritt 1: Erzeugen der Maske für den Anpassungsbereich

- Laden Sie ein Bild der Person hoch, deren Kleidung Sie ändern möchten

- Laden Sie ein Bild des Kleidungsstücks hoch, das Sie anprobieren möchten

- Klicken Sie auf die Schaltfläche "Schritt 1: Maske ausführen", um die erste Maske zu erstellen.

- Wenn Sie den Maskenbereich anpassen müssen, können Sie das tun:

- Verwenden Sie den Schieberegler, um den Maskenbereich einzustellen:

- mask offset top: passt den oberen Rand an

- mask offset bottom: passt den unteren Rand an

- mask offset left: passt den linken Rand an

- Maskenversatz rechts: passt den rechten Rand an

- Manuelles Bearbeiten des maskierten Bereichs mit dem Pinselwerkzeug

- Verwenden Sie das Radiergummi-Werkzeug, um die Kanten der Maske zu verfeinern.

- Verwenden Sie den Schieberegler, um den Maskenbereich einzustellen:

Schritt 2: Erzeugen von Anpassungsergebnissen

- Wählen Sie die gewünschte Anpassungsauflösung

- Klicken Sie auf "Step2: Run Try-on", um die Generierung zu starten.

- Warten Sie, bis die Verarbeitung des Modells abgeschlossen ist, um das Ergebnis der Anpassung zu sehen

2) Methodik für den lokalen Einsatz

Umweltanforderungen:

torch==2.3.0

torchvision==0.18.0

diffusers==0.31.0

transformers==4.39.3

gradio==5.8.0

onnxruntime-gpu==1.20.1

Schritte für die Bereitstellung:

- Zugang zu FitDiT-Modellgewichten beantragen:

- Besuchen Sie https://huggingface.co/BoyuanJiang/FitDiT

- Laden Sie das Modell in den lokalen Katalog herunter, nachdem Sie Zugang erhalten haben.

- Führen Sie den lokalen Gradio-Dienst aus:

Bietet vier Betriebsmodi, die Sie je nach Ihrer Hardwarekonfiguration auswählen können:# 最快速模式(需要较大显存): python gradio_sd3.py --model_path local_model_dir # FP16精度模式: python gradio_sd3.py --model_path local_model_dir --fp16 # CPU辅助模式(中等速度,适中显存): python gradio_sd3.py --model_path local_model_dir --fp16 --offload # 激进CPU负载模式(速度最慢,显存占用最少): python gradio_sd3.py --model_path local_model_dir --fp16 --aggressive_offload

3 Anweisungen für die Verwendung durch Entwickler

- Das Projekt steht unter der CC BY-NC-SA-4.0-Lizenz

- Nur für nicht-kommerzielle Zwecke

- Für kommerzielle Lizenzen wenden Sie sich bitte an byronjiang@tencent.com.

- Der vollständige Code für das Modelltraining und der Datensatz sind quelloffen

- Unterstützt die Verwendung von vortrainierten Modellen über Hugging Face

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...