fal: Generative Makromodellierungs-API für Entwickler von Rich-Media-Klassen

Allgemeine Einführung

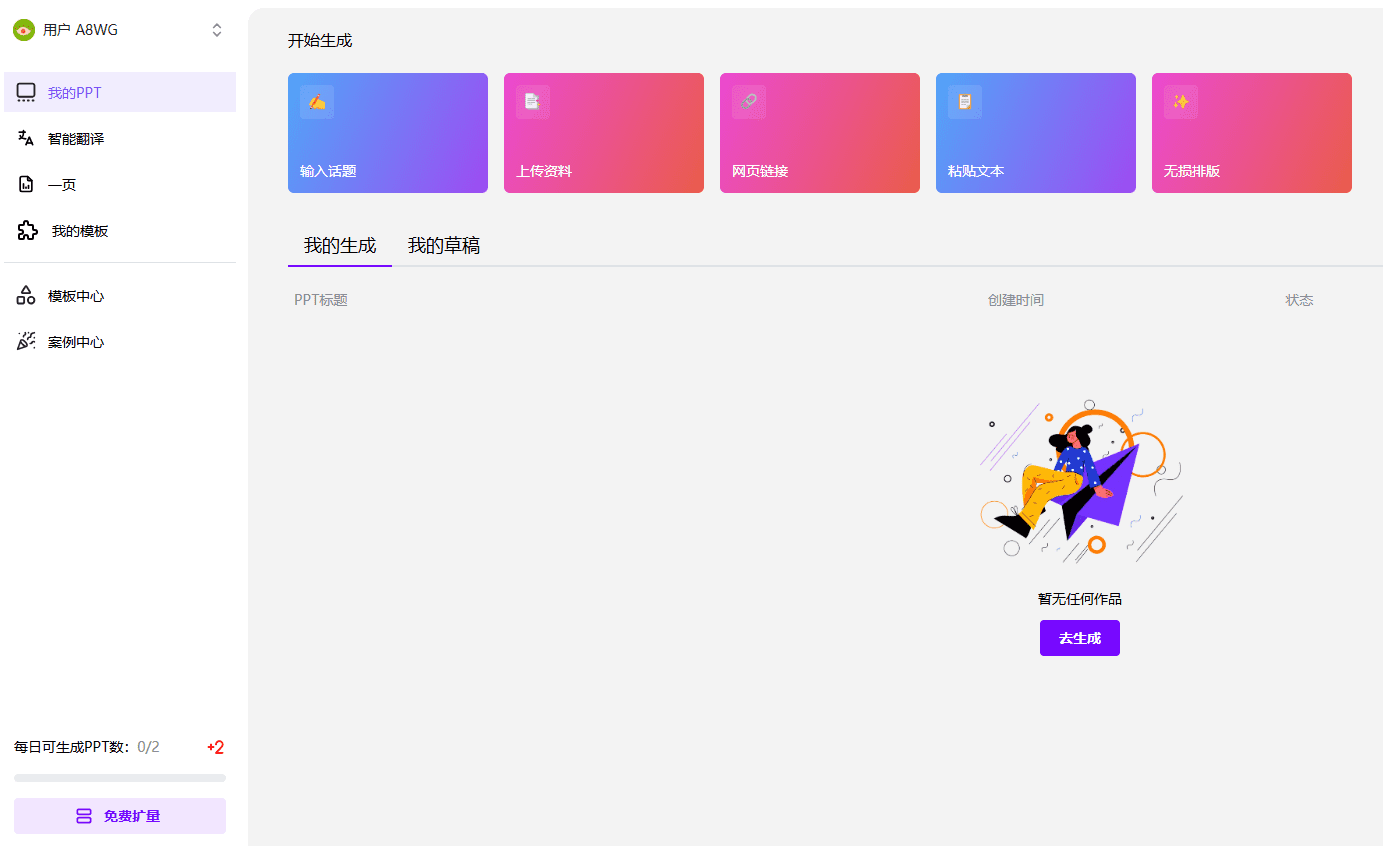

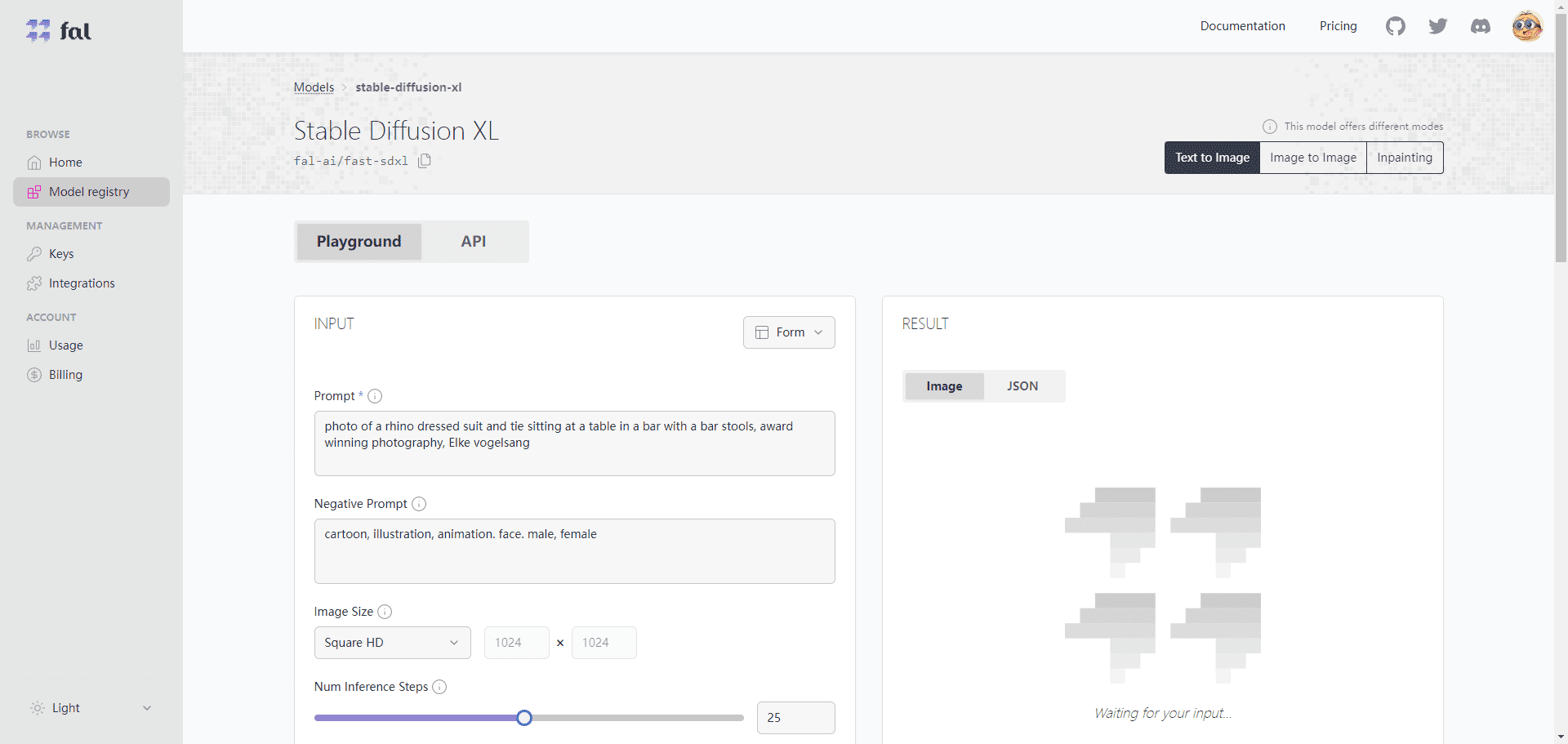

fal ist eine Online-KI-Plattform, die Nutzern hilft, Echtzeit-KI-Anwendungen mit hochwertigen generativen Medienmodellen zu erstellen, einschließlich Bildern, Video und Audio. Kein Kaltstart erforderlich, pay-as-you-go. fal bietet eine Vielzahl von vortrainierten generativen Modellen wie Stable Diffusion XL, Stable Diffusion with LoRAs, Optimised Latent Consistency (SDv1.5), usw., die es den Nutzern ermöglichen, mit einfachen Textbeschreibungen und Kritzelskizzen schnell Bilder zu erzeugen.

fal unterstützt auch das Hochladen benutzerdefinierter Modelle oder die Verwendung gemeinsam genutzter Modelle mit feiner Steuerung und der Möglichkeit, automatisch hoch- und runterzuskalieren. fal unterstützt eine Vielzahl von Maschinentypen und -spezifikationen wie GPU-A100, GPU-A10G, GPU-T4 usw., die unterschiedliche Leistungs- und Kostenanforderungen erfüllen können. fal verfügt über eine ausführliche Dokumentation und Beispiele, die den Benutzern den Einstieg und den schnellen Einsatz erleichtern.

Angetrieben von der proprietären fal-Inferenz-Engine ist die Plattform in der Lage, Diffusionsmodelle bis zu viermal schneller als andere Alternativen auszuführen und so neue Echtzeit-KI-Erfahrungen zu ermöglichen. fal.ai, gegründet 2021 mit Hauptsitz in San Francisco, hat es sich zur Aufgabe gemacht, die Hürden für kreativen Ausdruck zu senken, indem die Geschwindigkeit und Effizienz der Inferenz optimiert wird.

Funktionsliste

- Effiziente InferenzmaschineBietet die weltweit schnellste Inferenzmaschine für Diffusionsmodelle mit einer Inferenzgeschwindigkeit von bis zu 400%.

- Modelle mit mehreren GenerationenUnterstützt eine Vielzahl von vortrainierten generativen Modellen wie Stable Diffusion 3.5 und FLUX.1.

- LoRA-SchulungBietet das branchenweit beste LoRA-Trainingstool mit der Möglichkeit, einen neuen Stil in weniger als 5 Minuten zu personalisieren oder zu trainieren.

- API-IntegrationEine Vielzahl von clientseitigen Bibliotheken wie JavaScript, Python und Swift sind für eine einfache Integration durch Entwickler verfügbar.

- Online-DarstellungUnterstützt die Echtzeit-Generierung von Medieninferenzen für kreative Werkzeuge und Kameraeingaben in Echtzeit.

- KostenoptimierungPay-per-Use, um kostengünstige Berechnungen zu gewährleisten.

Hilfe verwenden

Installation und Integration

- ein Konto registrieren: Besuchen Sie fal.ai und melden Sie sich für ein Entwicklerkonto an.

- Abrufen des API-SchlüsselsNach der Anmeldung generieren und erhalten Sie Ihren API-Schlüssel auf der Seite "API-Schlüssel".

- Installation von Client-Bibliotheken::

- JavaScript::

import { fal } from "@fal-ai/client"; const result = await fal.subscribe("fal-ai/fast-sdxl", { input: { prompt: "photo of a cat wearing a kimono" }, logs: true, onQueueUpdate: (update) => { if (update.status === "IN_PROGRESS") { update.logs.map((log) => log.message).forEach(console.log); } }, }); - Python::

from fal import Client client = Client(api_key="YOUR_API_KEY") result = client.subscribe("fal-ai/fast-sdxl", input={"prompt": "photo of a cat wearing a kimono"}) print(result) - Schnell::

import FalAI let client = FalClient(apiKey: "YOUR_API_KEY") client.subscribe(model: "fal-ai/fast-sdxl", input: ["prompt": "photo of a cat wearing a kimono"]) { result in print(result) }

- JavaScript::

Verwendung generativer Modelle

- Modell auswählenWählen Sie ein Modell aus der Modellbibliothek von fal.ai, das für Ihr Projekt geeignet ist, wie z.B. Stable Diffusion 3.5 oder FLUX.1.

- KonfigurationsparameterKonfigurieren Sie die Modellparameter, wie z. B. die Anzahl der Inferenzschritte, die Größe des Eingabebildes usw., entsprechend den Projektanforderungen.

- logische SchlussfolgerungAPI-Aufrufe verwenden, um Schlussfolgerungen zu ziehen und generierte Medieninhalte abzurufen.

- Optimierung und AnpassungAnhand der generierten Ergebnisse können Sie die Parameter anpassen oder ein anderes Modell für die Optimierung auswählen.

LoRA-Schulung

- Daten hochladenBereiten Sie die Trainingsdaten vor und laden Sie sie auf die fal.ai-Plattform hoch.

- Auswahl des TrainingsmodellsWählen Sie ein geeignetes LoRA-Trainingsmodell wie z.B. FLUX.1.

- Konfigurieren Sie die TrainingsparameterEinstellen von Trainingsparametern wie Lernrate, Anzahl der Trainingsschritte, usw.

- Beginn der AusbildungStarten Sie den Trainingsprozess und die Plattform wird das Training abschließen und in kurzer Zeit ein neues Stilmodell erstellen.

- Anwendung des neuen ModellsInferenz unter Verwendung neu trainierter Modelle zur Erstellung personalisierter Medieninhalte.

Alle Modelle sind in Debugging-Schnittstelle und API zwei Teile geteilt, können Sie in der Debugging-Schnittstelle kein Problem beim Aufruf der API zu verwenden:

fal Optionale Modelle

| Name des Modells | Einführung in das Modell | Modell-Kategorie | Ausführliche Beschreibung |

| Stabile Diffusion mit LoRAs | Führen Sie ein beliebiges stabiles Diffusionsmodell mit benutzerdefinierten LoRA-Gewichten aus. | Text zu Bild | LoRA ist eine Technik zur Verbesserung der Qualität und Vielfalt eines Bildes, bei der verschiedene Gewichtungen vorgenommen werden, um den Stil und die Details des Bildes zu steuern. |

| Stabile Diffusion XL | SDXL läuft mit Lichtgeschwindigkeit | Text zu Bild | SDXL ist eine auf einem Diffusionsmodell basierende Bilderzeugungsmethode, die in wenigen Inferenzschritten qualitativ hochwertige Bilder erzeugt und schneller und stabiler ist als herkömmliche GAN-Methoden |

| Stabile Kaskade | Bilderzeugung auf kleineren und billigeren potenziellen Flächen | Text zu Bild | Stable Cascade ist eine Methode zur Bilderzeugung, die mehrere Schichten des latenten Raums nutzt, um hochauflösende Bilder mit geringen Rechenkosten zu erzeugen, die sich für mobile Geräte und Edge Computing eignen. |

| Kreativer Upscaler | Kreative vergrößerte Bilder erstellen | Bild-zu-Bild | Creative Upscaler ist eine Methode zur Bildvergrößerung, mit der kreative Elemente wie Texturen, Farben, Formen usw. hinzugefügt werden können, ohne die Bildschärfe zu beeinträchtigen! |

| CCSR Upscaler | Bildverstärker auf dem neuesten Stand der Technik | Bild-zu-Bild | CCSR Upscaler ist eine auf Deep Learning basierende Bildvergrößerungsmethode, die ein Bild auf das Vierfache der ursprünglichen Auflösung oder mehr vergrößern kann, ohne Unschärfe und Verzerrungen zu verursachen. |

| PhotoMaker | Realistische Charakterfotos durch Stapeln von ID-Einbettungen anpassen | Bild-zu-Bild | PhotoMaker ist eine Methode zur Erzeugung von Charakterfotos, die es dem Benutzer ermöglicht, das Aussehen, den Ausdruck, die Pose, den Hintergrund usw. des Charakters zu kontrollieren, indem er verschiedene ID-Einbettungen anpasst, um realistische Charakterfotos zu erzeugen |

| Flüstern | Whisper ist ein Modell für die Transkription und Übersetzung von Sprache | Sprache-zu-Text | Whisper ist ein auf Transformer basierendes End-to-End-Spracherkennungs- und Übersetzungsmodell, das Sprache in verschiedenen Sprachen in einem einzigen Schritt in Text umwandelt und mehrere Sprachen und Dialekte unterstützt. |

| Latente Konsistenz (SDXL & SDv1.5) | Erzeugen Sie qualitativ hochwertige Bilder mit minimalen Ableitungsschritten | Text zu Bild | Latente Konsistenz ist eine Technik zur Verbesserung der Effizienz und Qualität der Bilderzeugung durch die Erzeugung qualitativ hochwertiger Bilder in weniger Schritten bei gleichzeitiger Wahrung der latenten räumlichen Konsistenz und Interpretierbarkeit |

| Optimierte latente Konsistenz (SDv1.5) | Erzeugt qualitativ hochwertige Bilder mit minimalen Inferenzschritten. Optimiert für eine Eingabebildgröße von 512×512 | Bild-zu-Bild | Optimierte latente Konsistenz ist eine Methode zur Bilderzeugung, die für eine bestimmte Eingangsbildgröße optimiert ist, um in weniger Schritten qualitativ hochwertige Bilder zu erzeugen und gleichzeitig die Konsistenz des latenten Raums und die Interpretierbarkeit zu erhalten. |

| Fokussierung | Verwendung von Standardparametern zur automatischen Optimierung und Qualitätsverbesserung | Text zu Bild | Fooocus ist eine Methode zur Bilderzeugung, die es dem Benutzer ermöglicht, qualitativ hochwertige Bilder zu erzeugen, ohne dass er irgendwelche Parameter anpassen muss, während er automatische Optimierungs- und Qualitätsverbesserungstechniken einsetzt, um die erzeugten Ergebnisse zu verbessern |

| InstantID | Identitätserhaltende Generierung mit Nullproben | Bild-zu-Bild | InstantID ist eine Methode zur Erzeugung von identitätserhaltenden Bildern, die es dem Benutzer ermöglicht, ohne Trainingsdaten Bilder mit der gleichen Identität wie das Originalbild zu erzeugen, aber mit der Möglichkeit, andere Attribute wie Frisuren, Kleidung, Hintergründe usw. zu ändern. |

| AnimateDiff | Animieren Sie Ihre Ideen mit AnimateDiff! | Text zu Video | AnimateDiff ist eine Methode zur Erstellung von Animationen, die es dem Benutzer ermöglicht, kurze Videoclips durch die Eingabe einer Textbeschreibung zu erstellen. Dabei wird eine Vielzahl von Stilen und Themen unterstützt, wie z. B. Zeichentrick, realistisch, abstrakt und mehr! |

| AnimateDiff Video zu Video | Verleihen Sie Ihren Videos mit AnimateDiff mehr Stil | Video-zu-Video | AnimateDiff Video to Video ist eine Methode zur Konvertierung von Videostilen, die es dem Benutzer ermöglicht, ein neues Video zu erstellen, indem er ein Video und eine Stilbeschreibung eingibt, wobei eine Vielzahl von Stilen und Themen wie Zeichentrick, realistisch, abstrakt usw. unterstützt wird. |

| MetaVoice | MetaVoice-1B ist ein Basismodell mit 1,2 Milliarden Parametern für TTS (Text-to-Speech), das anhand von 100.000 Stunden Sprachaufnahmen trainiert wurde. | Text-to-Speech | MetaVoice ist eine Methode zur Spracherzeugung, die es dem Benutzer ermöglicht, durch Texteingabe Sprache in verschiedenen Sprachen und Klängen zu erzeugen, wobei mehrere Sprachen und Dialekte sowie eine Vielzahl von Stimmcharakteristika wie Tonhöhe, Rhythmus, Emotion usw. unterstützt werden. |

| MusicGen | Erstellen Sie hochwertige Musik mit Textbeschreibungen oder melodischen Stichworten | Text-zu-Audio | MusicGen ist eine Methode zur Erzeugung von Musik, die es dem Benutzer ermöglicht, Musik in verschiedenen Stilen und Themen zu erzeugen, indem er Textbeschreibungen oder melodische Hinweise eingibt. Dabei wird eine breite Palette von Instrumenten und Klangfarben sowie eine Vielzahl von musikalischen Merkmalen wie Beats, Akkorde, Melodien und mehr unterstützt! |

| Illusion Diffusion | Illusionen aus Bildern erzeugen | Text zu Bild | Illusion Diffusion ist eine Methode zur Erzeugung von Illusionen, die es dem Benutzer ermöglicht, neue Bilder zu erzeugen, indem er ein Bild und eine Beschreibung der Illusion eingibt. Dabei werden mehrere Arten von Illusionen unterstützt, wie z.B. visuelle, auditive, taktile und mehr! |

| Stabile Diffusion XL Bild zu Bild | SDXL Bild-zu-Bild mit Lichtgeschwindigkeit ausführen | Bild-zu-Bild | Stable Diffusion XL Image to Image ist eine Bild-zu-Bild-Methode, die es dem Benutzer ermöglicht, aus einem Eingabebild ein neues Bild zu erzeugen. Sie unterstützt eine Vielzahl von Bild-zu-Bild-Aufgaben wie Stilkonvertierung, Super-Resolution, Bildrestaurierung und vieles mehr! |

| Gemütlich Arbeitsablauf Testamentsvollstrecker | Ausführen von Comfy-Workflows in fal | json-zu-bild | Comfy Workflow Executor ist eine Methode zur Ausführung von Comfy-Workflows, die es Benutzern ermöglicht, Bilder durch Eingabe von Workflows im JSON-Format zu generieren, mit Unterstützung für eine Vielzahl von Workflow-Komponenten wie Daten, Modelle, Operationen, Ausgaben und mehr! |

| Segment Irgendwas Modell | SAM-Modell | Bild-zu-Bild | Segment Anything Model ist eine Methode zur Bildsegmentierung, die es dem Benutzer ermöglicht, durch Eingabe eines Bildes eine Segmentierungskarte zu erstellen, die eine Vielzahl von Bildsegmentierungsaufgaben unterstützt, z. B. semantische Segmentierung, Instanzsegmentierung, Gesichtssegmentierung usw. |

| TinySAM | Distilled Segment Anything Model TinySAM | Bild-zu-Bild | TinySAM ist eine Methode zur Bildsegmentierung, die eine destillierte Version des Segment Anything Model ist, das ähnliche Segmentierungsergebnisse wie das ursprüngliche Modell bei kleinerer Modellgröße und schnellerer Inferenzgeschwindigkeit erzielen kann |

| Midas-Tiefenabschätzung | Erstellen von Tiefenkarten mit der Midas-Tiefenschätzung | Bild-zu-Bild | Midas Depth Estimation ist eine Methode zur Erzeugung von Tiefenkarten, die es dem Benutzer ermöglicht, Tiefenkarten aus einem Eingabebild zu erzeugen, wobei eine Vielzahl von Tiefenkartenformaten wie Graustufen, Farbe, Pseudofarbe usw. unterstützt wird. |

| Hintergrund entfernen | Hintergrund aus dem Bild entfernen | Bild-zu-Bild | Remove Background ist eine Methode zur Entfernung des Hintergrunds eines Bildes, die es dem Benutzer ermöglicht, durch Eingabe eines Bildes ein Bild mit entferntem Hintergrund zu erzeugen, wobei eine Vielzahl von Hintergrundtypen unterstützt wird, z. B. natürliche Landschaften, Innenraumszenen, komplexe Objekte usw. |

| Gehobene Bilder | Vergrößern des Bildes um einen bestimmten Faktor | Bild-zu-Bild | Upscale Images ist eine Methode zur Bildvergrößerung, die es dem Benutzer ermöglicht, durch Eingabe eines Bildes und eines Zoomfaktors ein neues Bild zu erzeugen, und unterstützt eine Vielzahl von Bildformaten, wie JPG, PNG, BMP usw. |

| ControlNet SDXL | Bilderzeugung mit ControlNet | Bild-zu-Bild | ControlNet SDXL ist eine Methode zur Bilderzeugung, die es dem Benutzer ermöglicht, neue Bilder durch Eingabe eines Bildes und von Steuervektoren zu erzeugen, wobei eine breite Palette von Steuervektortypen wie Stil, Farbe, Form usw. unterstützt wird. |

| Einfärben von sdxl und sd | Reparieren von Bildern mit SD und SDXL | Bild-zu-Bild | Inpainting sdxl und sd ist eine Methode zur Bildrestaurierung, die es dem Benutzer ermöglicht, durch Eingabe eines Bildes und einer Maske ein restauriertes Bild zu erzeugen, das eine Vielzahl von Bildrestaurierungsaufgaben wie das Entfernen von Wasserzeichen, das Auffüllen von Lücken, das Entfernen von Rauschen usw. unterstützt. |

| Animationsdiff LCM | Beleben Sie Ihren Text mit einem latenten Kohärenzmodell | Text zu Bild | Animatediff LCM ist eine Methode zur Erstellung von Animationen, die es dem Benutzer ermöglicht, kurze Videoclips durch die Eingabe von Text und Frames zu generieren, und unterstützt eine Vielzahl von latenten Konsistenzmodellen, wie SDXL, SDv1.5, SDv1.0, usw. |

| Animatediff SparseCtrl LCM | Animieren Sie Ihre Zeichnungen mit einem latenten Kohärenzmodell | Text zu Video | Animatediff SparseCtrl LCM ist eine Methode zur Erzeugung von Animationen, die es dem Benutzer ermöglicht, kurze Videoclips durch die Eingabe von Zeichnungen und Bildzahlen zu erzeugen, und unterstützt eine breite Palette von latenten Konsistenzmodellen wie SDXL, SDv1.5, SDv1.0 usw. |

| Kontrolliert Stabiles Video Diffusion | Erzeugen Sie kurze Videoclips aus Ihren Bildern | Bild-zu-Bild | Controlled Stable Video Diffusion ist eine Methode zur Erzeugung von Videos, die es dem Benutzer ermöglicht, kurze Videoclips durch Eingabe von Bildern und Kontrollvektoren zu erzeugen, wobei mehrere Arten von Kontrollvektoren wie Bewegung, Winkel, Geschwindigkeit usw. unterstützt werden. |

| Magische Animationen | Erzeugen kurzer Videoclips aus Bewegungsabläufen | Bild-zu-Bild | Magic Animate ist eine Methode zur Erstellung von Videos, die es dem Benutzer ermöglicht, kurze Videoclips durch die Eingabe von Bildern und Bewegungsabläufen zu erzeugen, wobei eine Vielzahl von Bewegungsablaufformaten wie Text, Symbole, Gesten und vieles mehr unterstützt wird! |

| Gesicht tauschen | Gesichter zwischen zwei Bildern austauschen | Bild-zu-Bild | Swap Face ist eine Methode zum Tauschen von Gesichtern, die es dem Benutzer ermöglicht, ein neues Bild zu erzeugen, indem er zwei Bilder eingibt, wobei eine breite Palette von Bildtypen wie Menschen, Tiere, Cartoons usw. unterstützt wird. |

| IP-Adapter Gesichtserkennung | Hochwertige Nullmuster-Personalisierung | Bild-zu-Bild | IP Adapter Face ID ist eine Methode zur Erzeugung personalisierter Bilder, die es den Nutzern ermöglicht, durch Eingabe eines Bildes und einer personalisierten Beschreibung neue Bilder zu erzeugen, wobei eine breite Palette von Personalisierungsarten wie Frisuren, Kleidung, Hintergründe usw. unterstützt wird. |

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...