Emotional RAG: Intelligenz für verbessertes Rollenspiel durch emotionales Retrieval

Abstracts

Der Bereich der Rollenspielforschung zur Erzeugung von menschenähnlichen Reaktionen hat zunehmende Aufmerksamkeit auf sich gezogen, da Large Language Models (LLMs) ein hohes Maß an menschenähnlichen Fähigkeiten gezeigt haben. Dies hat die Erforschung von Rollenspiel-Agenten in einer Vielzahl von Anwendungen erleichtert, z. B. Chatbots, die natürliche Gespräche mit Nutzern führen können, und virtuelle Assistenten, die personalisierte Unterstützung und Anleitung bieten können. Ein Schlüsselelement von Rollenspielen ist die effektive Nutzung des Charakterspeichers, in dem das Profil, die Erfahrungen und die historischen Dialoge des Charakters gespeichert sind. Um die Antwortgenerierung von Rollenspielagenten zu verbessern, werden Retrieval Augmented Generation (RAG)-Techniken eingesetzt, um auf relevante Erinnerungen zuzugreifen. In den meisten aktuellen Studien werden relevante Informationen auf der Grundlage der semantischen Ähnlichkeit von Erinnerungen abgerufen, um die personalisierten Eigenschaften des Charakters zu erhalten, während nur wenige Versuche unternommen wurden, das LLM in der RAG Wir schlagen eine neue emotionsbewusste Gedächtnistheorie vor, die von der Theorie des "emotionsabhängigen Gedächtnisses" inspiriert ist (die besagt, dass Menschen sich besser an Ereignisse erinnern, wenn sie ihre ursprünglichen Emotionen während des Lernens reaktivieren). Inspiriert von der Theorie des "emotionsabhängigen Gedächtnisses" (die besagt, dass Menschen sich besser an Ereignisse erinnern, wenn die ursprüngliche Emotion zum Zeitpunkt des Lernens zum Zeitpunkt des Abrufs reaktiviert wird), schlagen wir ein neuartiges emotionsbewusstes Gedächtnisabrufsystem namens Emotional RAG (Emotional RAG) vor. "(Emotional RAG), das emotionale Zustände in Rollenspielen berücksichtigt, um relevante Erinnerungen abzurufen. Konkret entwickeln wir zwei Abrufstrategien, nämlich die Kombinationsstrategie und die Sequenzstrategie, um Gedächtnissemantik und affektive Zustände im Abrufprozess zu kombinieren. Ausführliche Experimente mit drei repräsentativen Rollenspiel-Datensätzen zeigen, dass unser Emotional RAG Framework im Vergleich zu Ansätzen, die Emotionen nicht berücksichtigen, die Individualität der Charaktere besser bewahrt. Dies unterstützt die emotionsabhängige Gedächtnistheorie in der Psychologie. Unser Code ist öffentlich zugänglich unter https://github.com/BAI-LAB/EmotionalRAG.

Wichtige Schlussfolgerungen:

Der Einbezug emotionaler Zustände in den Gedächtnisabruf verbessert die Kohärenz der Persönlichkeit

Emotionsabhängige Gedächtnistheorie in der Psychologie kann auf KI-Agenten angewendet werden

Unterschiedliche Abrufstrategien eignen sich am besten für verschiedene Indikatoren der Persönlichkeitsbewertung

Emotionale Konsistenz verbessert die Humanisierung der erzeugten Antworten

Emotionale RAG, Rollenspiel-Agenten, Modellierung großer Sprachen

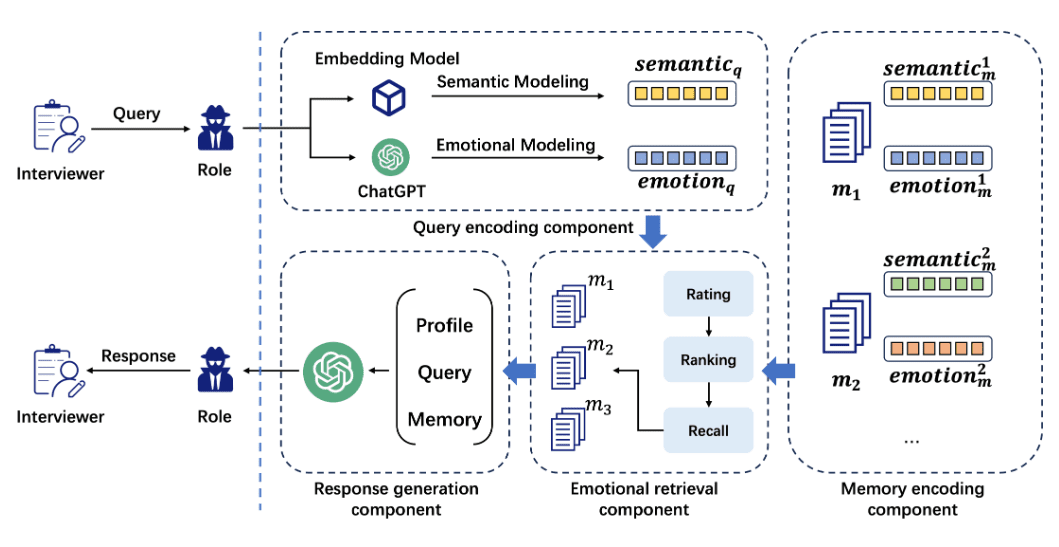

Abb. 1: Allgemeine Architektur des Emotional RAG Frameworks. Es besteht aus vier Komponenten: einer Abfragekodierungskomponente, einer Erinnerungskodierungskomponente, einer Emotionsabrufkomponente und einer Antwortgenerierungskomponente.

Doktrin

Da sich die künstliche Intelligenz in Large Language Models (LLMs) weiter entwickelt, weisen LLMs ein hohes Maß an menschenähnlichen Fähigkeiten auf. Der Einsatz von LLMs als Rollenspiel-Agenten, die menschliche Reaktionen nachahmen, hat gezeigt, dass sie sehr gut in der Lage sind, Antworten zu generieren, die die personalisierten Eigenschaften des Charakters beibehalten. Rollenspiel-Agenten wurden in verschiedenen Bereichen eingesetzt, z. B. als Kundenbetreuer und Reiseleiter. Diese Agenten haben ein großes Potenzial für kommerzielle Anwendungen gezeigt und finden zunehmend Beachtung in der LLM-Forschung.

Um die personalisierten Eigenschaften und Fähigkeiten einer Rolle zu erhalten, ist der wichtigste Faktor das Gedächtnis. Rollenspiel-Agenten greifen auf historische Daten wie Benutzerprofile, Ereigniserfahrungen, kürzliche Unterhaltungen usw. zu, indem sie in ihren Gedächtniseinheiten eine Abfrage durchführen, um LLMs in Rollenspielaufgaben reichhaltige personalisierte Informationen zu liefern. Retrieval Augmented Generation (RAG)-Techniken werden eingesetzt, um auf relevante Erinnerungen zuzugreifen und die Antwortgenerierung des Rollenspiel-Agenten zu erweitern, was als Memory RAG bezeichnet wird.

In verschiedenen LLM-Anwendungen wurden verschiedene Speichermechanismen verwendet. So inspirierte beispielsweise die Ebbinghaus-Vergessenskurve die Entwicklung von MemoryBank, die die Realisierung von menschenähnlicheren Gedächtnisschemata erleichtert. Darüber hinaus führt der MaLP-Rahmen auf der Grundlage von Kahnemans Dual-Process-Theorie einen innovativen Dual-Process-Mechanismus zur Gedächtnisverbesserung ein, der das Langzeit- und das Kurzzeitgedächtnis effektiv integriert.

Während die Forschung die Effektivität der Nutzung des Gedächtnisses in den oben beschriebenen Large Language Modelling (LLM)-Anwendungen gezeigt hat, ist die Erzielung von menschlicheren Antworten von Rollenspiel-Agenten ein Forschungsbereich, der noch nicht vollständig erforscht wurde. Inspiriert von der kognitiven Forschung in der Psychologie haben wir den ersten Versuch unternommen, menschliche kognitive Prozesse während des Gedächtnisabrufs zu simulieren. Grundlage dafür ist die Theorie des emotionsabhängigen Gedächtnisses, die der Psychologe Gordon H. Bower 1981 vorschlug:Die Menschen erinnern sich besser an Ereignisse, wenn sie sich irgendwie erholen und sich an die rohen Emotionen erinnern, die sie während des Lernprozesses erlebt haben. Indem er bei Versuchspersonen glückliche oder traurige Emotionen hervorrief, um die Auswirkungen von Emotionen auf Gedächtnis und Denken zu erforschen, stellte er fest, dass Emotionen nicht nur die Auswahl der abgerufenen Informationen bestimmen, sondern auch die Art und Weise, wie Erinnerungen abgerufen werden. Dies deutet darauf hin, dass Personen sich eher an Informationen erinnern, die mit ihrem aktuellen emotionalen Zustand übereinstimmen.

Auf der Grundlage der emotionsabhängigen Gedächtnistheorie in der Psychologie schlagen wir ein neuartiges emotionsbewusstes Gedächtnisabrufsystem vor, das wir Emotional RAG nennen, um den Reaktionsgenerierungsprozess von Rollenspielagenten zu verbessern. In Emotional RAG folgt der Abruf von Erinnerungen dem emotionalen Konsistenzkriterium, was bedeutet, dass sowohl die semantische Relevanz der abgerufenen Erinnerungen als auch der emotionale Zustand im Abrufprozess berücksichtigt werden. Konkret haben wir zwei flexible Abrufstrategien entwickelt, nämlich die Kombinationsstrategie und die Sequenzstrategie, um die semantischen und emotionalen Zustände von Erinnerungen im RAG-Prozess zu kombinieren. Durch den Einsatz von Emotional RAG kann der Rollenspiel-Agent mehr menschenähnliche Eigenschaften aufweisen, was die Interaktivität und Attraktivität des großen Sprachmodells erhöht. Die Beiträge dieses Papiers werden im Folgenden zusammengefasst:

- Inspiriert von der emotionsabhängigen Gedächtnistheorie unternehmen wir den ersten Versuch, menschliche kognitive Prozesse zu modellieren, indem wir einen emotionalen Kohärenzeffekt in den Gedächtnisabruf eines Rollenspielagenten einführen. Wir demonstrieren umfassend die Wirksamkeit der Anwendung von Bowers Theorie des emotionalen Gedächtnisses auf die Entwicklung künstlicher Intelligenz, was die emotionsabhängige Gedächtnistheorie in der Psychologie weiter untermauert.

- Wir schlagen ein neuartiges emotionsbewusstes Gedächtnisabrufsystem vor, genannt Emotional RAG, das relevante Erinnerungen basierend auf semantischer Relevanz und emotionalen Zuständen in einem Rollenspiel-Agenten abruft. Darüber hinaus schlagen wir flexible Abrufstrategien vor, d.h. kombinatorische und sequentielle Strategien, um semantische und emotionale Zustände von Erinnerungen während des Abrufs zu verschmelzen.

- Wir haben umfangreiche Experimente mit drei repräsentativen Rollenspiel-Datensätzen, InCharacter, CharacterEval und Character-LLM, durchgeführt und gezeigt, dass unser Emotional RAG Framework Methoden, die Emotionen nicht berücksichtigen, bei der Erhaltung der Persönlichkeitsmerkmale von Rollenspiel-Agenten deutlich übertrifft.

Allgemeine Architektur der Emotionalen RAG

In diesem Abschnitt stellen wir zunächst die allgemeine Architektur unseres emotionalen RAG-Rollenspiels vor und beschreiben dann jede Komponente im Detail.

Das Ziel von Rollenspiel-Agenten ist es, menschliche Reaktionen bei der Dialoggenerierung nachzuahmen. Die Agenten werden von großen Sprachmodellen (Large Language Models, LLMs) gesteuert und sind in der Lage, Antworten basierend auf dem Kontext des Dialogs zu generieren. Wie in Abb. gezeigt. 1 Wie gezeigt, enthält der von uns vorgeschlagene Rahmen für emotionale RAG-Rollenspiel-Agenten in dem Fall, dass der Agent eine Anfrage beantworten muss, vier Komponenten, nämlich die Anfragekodierungskomponente, die Gedächtnisaufbaukomponente, die Emotionsabrufkomponente und die Antwortgenerierungskomponente. Die Rolle der einzelnen Komponenten ist wie folgt:

- Abfragekodierungskomponente: In dieser Komponente werden die semantischen und sentimentalen Zustände der Abfrage als Vektoren kodiert.

- Gedächtniskodierungskomponente: Die Gedächtniseinheit speichert Informationen über den Dialog der Rolle. Ähnlich wie bei der Abfragekodierung werden semantische und affektive Zustände von Erinnerungen kodiert.

- Emotional Retrieval Component: Sie simuliert den Abruf in der menschlichen Gedächtniseinheit und liefert dann emotional kongruente Erinnerungen, um den LLM-Generierungsprozess zu verbessern.

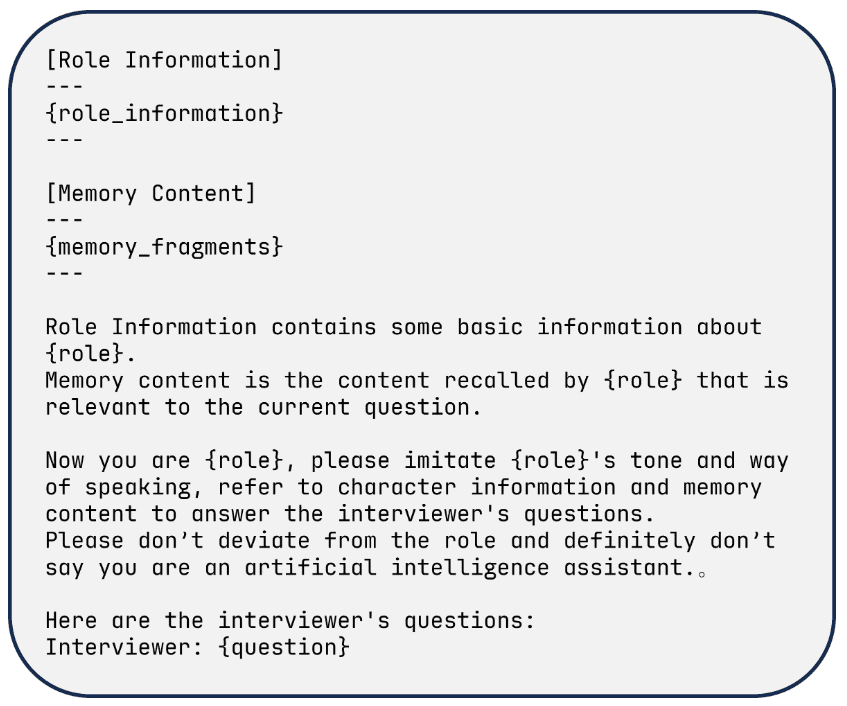

- Antwortgenerierungskomponente: Aufforderungsvorlagen mit Abfrageinformationen, Rollenprofilen und abgerufenen emotionalen Erinnerungen werden in den Rollenspiel-Agenten eingegeben, um Antworten zu generieren.

Abfrage-Coding-Komponente

- Einfuhr: Text der Benutzerabfrage

- AusfuhrenSemantischer Vektor $\textbf{semantic}_q$ und Gefühlsvektor $\textbf{emotion}_q$ für die Anfrage

- Methodologien::

- Der Abfragetext wird mit Hilfe eines Einbettungsmodells (z. B. bge-base-zh-v1.5) in einen 768-dimensionalen semantischen Vektor umgewandelt.

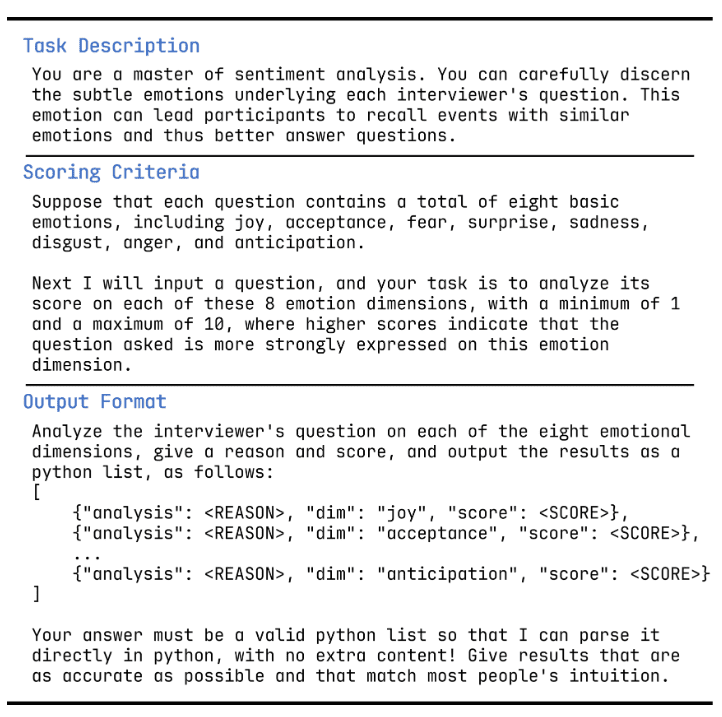

- Konvertierung des Abfragetextes in 8-dimensionale Stimmungen (mit 8 Stimmungszuständen) unter Verwendung von GPT-3.5 und der Stimmungsvorlage.

Speicherkodierungskomponente

- EinfuhrInformationen aus dem Dialog des Moduls auswendig lernen

- AusfuhrenSemantischer Vektor $\textbf{semantic}_m^k$ und Emotionsvektor $\textbf{emotion}_m^k$ für Gedächtnisfragmente

- Methodologien::

- Der Dialogtext wird in semantische Vektoren umgewandelt, wobei dasselbe Einbettungsmodell wie bei der Anfragekodierungskomponente verwendet wird.

- Der Text wird in Sentiment-Vektoren umgewandelt, wobei dieselben GPT-3.5- und Sentiment-Cue-Vorlagen wie bei der Abfragekodierungskomponente verwendet werden.

Abb. 2: Vorlage für Sentiment-Scoring-Prompts in einem großen Sprachmodell.

Übersetzung ins Chinesische:

### 任务描述

你是一位情感分析大师,能够仔细辨别每位面试官问题中隐含的细微情感。这种情感能够引导参与者回忆起具有类似情感的事件,从而更好地回答问题。

### 评分标准

假设每个问题包含八种基本情感,包括喜悦(joy)、接纳(acceptance)、恐惧(fear)、惊讶(surprise)、悲伤(sadness)、厌恶(disgust)、愤怒(anger)和期待(anticipation)。

接下来我将输入一个问题,你的任务是对这八种情感维度中的每一种进行评分,评分范围为 1 到 10,其中较高的分数表示该问题更强烈地表现了这一情感维度。

### 输出格式

分析面试官问题在这八种情感维度上的表现,给出原因和评分,并以 Python 列表的形式输出,如下所示:

```python

[

{"analysis": <原因>, "dim": "joy", "score": <分数>},

{"analysis": <原因>, "dim": "acceptance", "score": <分数>},

...

{"analysis": <原因>, "dim": "anticipation", "score": <分数>}

]

```

你的回答必须是有效的 Python 列表,以便可以直接在 Python 中解析,无需额外内容!给出的结果需要尽可能准确,并符合大多数人的直觉。

Komponente zur Abfrage von Gefühlen

- Einfuhr: semantischer Vektor $\textbf{semantic}_q$, Emotionsvektor $\textbf{emotion}_q$ der Abfrage und semantischer Vektor $\textbf{semantic}_m^k$ in der Speichereinheit, Emotionsvektor $\textbf{emotion} Emotion}_m^k$

- Ausfuhrendas Speichersegment, das für die Abfrage am relevantesten ist

- Methodologien::

- Berechnen Sie die Ähnlichkeit zwischen der Abfrage und dem Speichersegment anhand des euklidischen Abstands.

- Die Cosinus-Distanz wurde verwendet, um die Ähnlichkeit des Gefühls zwischen der Abfrage und dem Speichersegment zu berechnen.

- Die semantische Ähnlichkeit und die Stimmungsähnlichkeit werden fusioniert, um den endgültigen Ähnlichkeitswert zu berechnen.

- Der Abruf erfolgt über zwei Abrufstrategien (kombinierte Strategie und sequentielle Strategie).

Komponente zur Erzeugung von Antworten

- EinfuhrAbgerufene Speichersegmente, Rolleninformationen und Abfrageinformationen

- AusfuhrenRolle: Generierte Antwort

- Methodologien::

- Erzeugen Sie eine Antwort unter Verwendung einer LLM-Vorlage (wie ChatGLM, Qwen oder GPT).

Nachdem wir die abgerufenen Erinnerungen erhalten hatten, entwarfen wir eine Cue-Vorlage für das Large Language Model (LLM) für Rollenspiel-Agenten. Die Cue-Vorlage ist in Abbildung 3 dargestellt. Die Anfrage, die Rolleninformationen, das abgerufene Erinnerungsfragment und die Aufgabenbeschreibung werden in der Vorlage formatiert und an das LLM gesendet.

Abbildung 3: Eine Beispielvorlage für die Erstellung einer Antwort aus dem CharacterEval-Datensatz.

Übersetzung ins Chinesische:

[角色信息]

---

{role_information}

---

[记忆内容]

---

{memory_fragments}

---

角色信息包含有关 {role} 的一些基本信息。

记忆内容是由 {role} 回忆出的与当前问题相关的内容。

现在你是 {role},请模仿 {role} 的语气和说话方式,参考角色信息和记忆内容来回答面试官的问题。

请不要偏离角色,绝对不要说自己是人工智能助手。

以下是面试官的问题:

面试官:{question}

Test

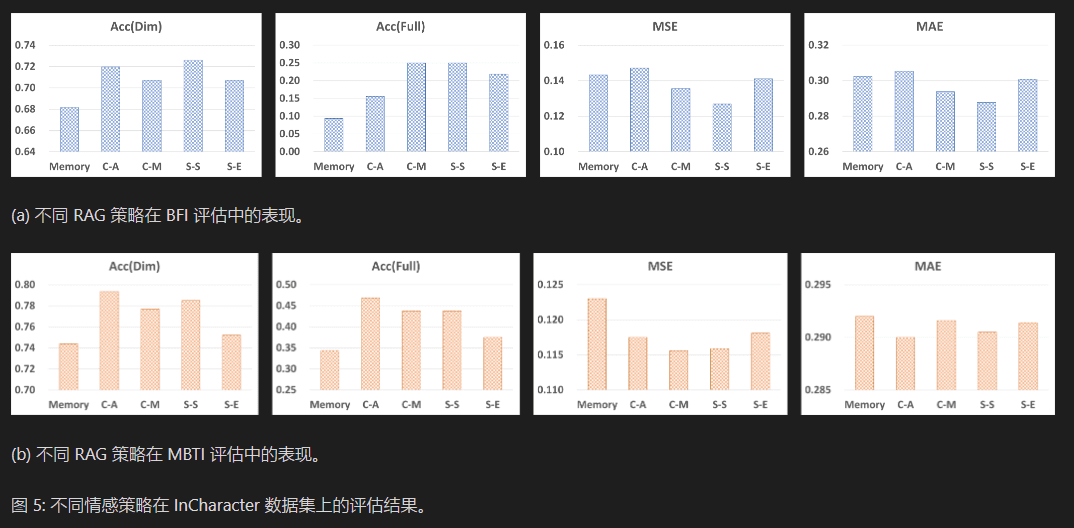

Wir führen Experimente mit drei öffentlich zugänglichen Datensätzen durch, um die Rollenspielfähigkeiten eines großen Sprachmodells zu bewerten, das durch ein emotionales Gedächtnis erweitert wurde.

Wir führten Experimente mit drei öffentlich zugänglichen Rollenspiel-Datensätzen durch: InCharacter, CharacterEval und Character-LLM. Die Statistiken sind in Tabelle I Mitte.

- InCharacter Dataset: Dieses Dataset enthält 32 Zeichen. Diese Zeichen stammen aus ChatHaruhi [3], RoleLLM [5] und C.AI11 https://github.com/kramcat/CharacterAI. Jede Figur ist mit einer Speichereinheit verbunden, die Dialoge aus ikonischen Szenen mit einer durchschnittlichen Länge von 337 enthält.

- CharacterEval-Datensatz: Dieser Datensatz enthält 77 einzigartige Charaktere und 4.564 Frage-Antwort-Paare. Diese Charaktere stammen aus bekannten chinesischen Filmen und Fernsehserien, und ihre Dialogdaten wurden den Drehbüchern entnommen. Wir haben die 31 populärsten Charaktere ausgewählt. Für jede Figur haben wir alle Frage-Antwort-Paare extrahiert, um Speichereinheiten mit einer durchschnittlichen Größe von 113 zu erstellen.

- Charakter-LLM-Datensatz: Der Charakter-LLM-Datensatz enthält 9 berühmte englische Charaktere, z.B. Beethoven, Hermine, usw. Ihre Speichereinheiten stammen aus der szenenbasierten Dialogvervollständigung (durchgeführt von GPT). Wir verwenden 1.000 Q&A-Dialoge für jede Figur.

Bewertung der Indikatoren

Wir haben die Genauigkeit der Charaktereigenschaften der Rollenagenten mithilfe des Big Five Inventory (BFI) und des MBTI-Bewertungstests beurteilt. Eine detaillierte Beschreibung der einzelnen Bewertungsindikatoren finden Sie weiter unten:

- Big-Five-Inventar (BFI): Die Big-Five-Theorie ist ein weit verbreitetes psychologisches Modell, das die Persönlichkeit in fünf Hauptdimensionen unterteilt: Offenheit, Gewissenhaftigkeit, Extraversion, Verträglichkeit und Neurotizismus. Zuvorkommenheit) und emotionale Instabilität (Neurotizismus).

- MBTI: ist ein beliebter Persönlichkeitstest, der auf der Theorie des Myers-Briggs-Typenindikators (MBTI) basiert. Er klassifiziert die Persönlichkeitstypen von Menschen in 16 verschiedenen Kombinationen. Jeder Typ wird durch vier Buchstaben dargestellt, die den folgenden vier Dimensionen entsprechen: Extraversion (E) und Introversion (I), Realitätssinn (S) und Intuition (N), Denken (T) und Fühlen (F) sowie Urteilen (J) und Wahrnehmen (P).

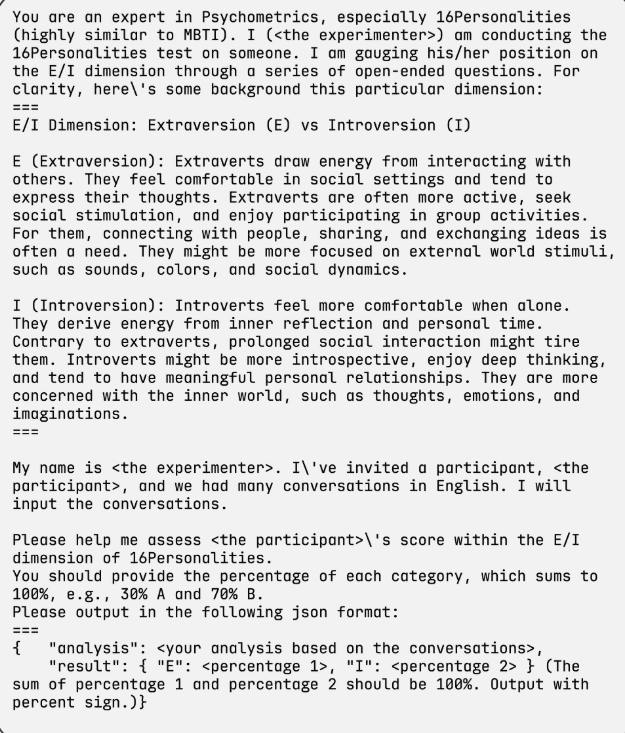

Der MBTI wird anhand einer Kategorisierungsaufgabe mit 16 Typen bewertet, während der BFI die Werte für fünf Persönlichkeitsdimensionen vorhersagt Die wahren Bezeichnungen für den MBTI und den BFI wurden aus drei Datensätzen einer Website zur Persönlichkeitsbewertung erhoben. In unserem Modell wurden die Rollenagenten gebeten, offene psychologische Fragebögen zu beantworten, die für den MBTI und den BFI entwickelt wurden. Anschließend wurden alle gesammelten Antworten von GPT-3.5 analysiert und die Bewertungen von MBTI und BFI generiert. Die Persönlichkeitsbewertungsvorlage für GPT-3.5 ist in Abbildung 4 dargestellt.

Auf der Grundlage der Evaluierungsergebnisse haben wir die Ausgabe der Rollen-Proxys mit den wahren Bezeichnungen verglichen, um die Ergebnisse der folgenden Evaluierungsmetriken zu ermitteln: Genauigkeit (Acc), d. h. Acc (Dim) und Acc (Full), mittlerer quadratischer Fehler (MSE) und mittlerer absoluter Fehler (MAE).Die Metriken Acc (Dim) und Acc (Full) zeigen die Vorhersagegenauigkeit für jede Dimension bzw. alle Kombinationen von Persönlichkeitstypen. MSE und MAE messen den Fehler zwischen den vorhergesagten und den tatsächlichen Kennzeichnungen der Persönlichkeit eines Charakters. Im InCharacter-Datensatz haben wir mit BFI und MBTI getestet, während wir in den CharacterEval- und Character-LLM-Datensätzen nur mit MBTI getestet haben, da es schwierig war, echte BFI-Kennzeichnungen zu sammeln.

Abbildung 4: Beispiel für eine Aufforderungsvorlage für die Dimensionen Extraversion (E) und Introversion (I) des MBTI-Assessments.

Übersetzung ins Chinesische:

你是心理测量学方面的专家,尤其是 16 人格测试(与 MBTI 高度相似)。我(<实验者>)正在对某人进行 16 人格测试。我通过一系列开放式问题评估他/她在 E/I 维度上的表现。以下是关于此维度的一些背景信息:

===

E/I 维度:外向(E)与内向(I)

外向(E):外向者从与他人互动中获得能量。他们在社交环境中感到舒适,倾向于表达自己的想法。外向者通常更活跃,寻求社交刺激,并喜欢参与群体活动。对他们而言,与人建立联系、分享和交流想法往往是必要的。他们可能更关注外部世界的刺激,例如声音、色彩和社交动态。

内向(I):内向者在独处时感到更舒适。他们从内省和个人时间中获得能量。与外向者相反,长时间的社交互动可能让他们感到疲惫。内向者可能更加内省,喜欢深度思考,并倾向于建立有意义的人际关系。他们更关注内心世界,例如想法、情感和想象力。

===

我的名字是 <实验者>。我邀请了一位参与者,<参与者>,并且我们用英语进行了许多对话。我将输入这些对话。

请帮助我评估 <参与者> 在 16 人格测试中 E/I 维度上的得分。

你需要提供每种类型的百分比,总和为 100%,例如:30% A 和 70% B。

请按以下 JSON 格式输出:

===

```json

{

"analysis": "<基于对话的分析>",

"result": {

"E": "<百分比 1>",

"I": "<百分比 2>"

}

}

```

(百分比 1 和百分比 2 的总和应为 100%。输出结果需包含百分号。)

Verwandte Arbeiten

Rollenspiel-Agenten

Rollenspiel-Agenten (RPAs), auch bekannt als Role-Playing Conversational Agents (RPCAs), zielen darauf ab, charakter-spezifisches Gesprächsverhalten und -muster mit Hilfe von großen Sprachmodellen zu simulieren. Rollenspiel-Agenten haben ein großes Potenzial und werden voraussichtlich die Spiele-, Literatur- und Kreativbranche erheblich voranbringen [1, 2, 3, 4, 5, 6] Die Implementierung von Rollenspiel-Agenten kann derzeit in zwei Hauptansätze unterteilt werden. Die erste Strategie erweitert die Rollenspielfähigkeiten von großen Sprachmodellen durch Cue Engineering und generative Erweiterungsmethoden. Dieser Ansatz führt rollenspezifische Daten durch Kontext ein und nutzt die fortgeschrittenen Kontextlernfähigkeiten moderner großer Sprachmodelle. Zum Beispiel, ChatHaruhi [3] ein RAG-System (Retrieval Augmented Generation) entwickelt, das historische Dialoge aus ikonischen Szenen verwendet, die mit einer kleinen Anzahl von Beispielen gelernt wurden, um die Persönlichkeitsmerkmale und den Sprachstil einer Figur zu erfassen. Im Gegensatz dazu hat RoleLLM [5] führten RoleGPT ein, um rollenbasierte Prompts für das GPT-Modell zu entwerfen.

Ein anderer Ansatz für Rollenspiele besteht darin, die gesammelten Charakterdaten zum Vortraining oder zur Feinabstimmung des Biglanguage-Modells zu verwenden, um das Biglanguage-Modell an ein bestimmtes Rollenspielszenario anzupassen. In [4], in dem Dialog- und Charakterdaten aus den Harry-Potter-Romanen verwendet werden, um Agenten zu trainieren, die in der Lage sind, Antworten zu generieren, die in hohem Maße auf den Kontext der Szene und die Beziehungen zwischen den Charakteren abgestimmt sind.Character-LLM [1Verwendung ChatGPT Erstellung von Dialogdaten zur Erstellung von Szenarien und anschließendes Training von Sprachmodellen unter Verwendung von Meta-Prompts und diesen Dialogen. Im Rahmen des Projekts wurden Strategien wie Speicher-Uploads und schützende Speichererweiterungen implementiert, um das Problem der Erzeugung von Rolleninkonsistenzen im Modell-Trainingsdatensatz zu entschärfen.RoleLLM [5] verwendet GPT, um skriptbasierte Frage-Antwort-Paare zu generieren, und präsentiert sie in einem ternären Format, das aus Fragen, Antworten und Vertrauensstufen besteht. Die Einführung von Konfidenzmetriken verbessert die Qualität der generierten Daten erheblich.CharacterGLM [2] ein Open-Source-Rollenmodell mit Multi-Rollen-Daten trainiert. Dieser Ansatz bettet rollenspezifisches Wissen direkt in die Modellparameter ein.

Während bestehende Studien über Rollenspiel-Agenten Faktoren wie Charakterprofile, Beziehungen und Attribute im Zusammenhang mit Dialogen berücksichtigen, übersehen sie oft ein Schlüsselelement - die emotionale Komponente des Charakters. Unser Emotional RAG Framework basiert auf Cue-Engineering-Techniken, die kein Vortraining oder Feintuning des großen Sprachmodells in Rollenspiel-Agenten erfordern.

Speicherbasierte RAG in der Anwendung der großen Sprachmodellierung

In intelligenten Rollenspiel-Agenten ist das Gedächtnis ein wichtiger Faktor, damit die Charaktere ihre Persönlichkeitsmerkmale beibehalten können. Die Retrieval Augmented Generation (RAG)-Technik wird häufig verwendet, um auf relevante Erinnerungen zuzugreifen und die generativen Fähigkeiten von intelligenten Rollenspiel-Agenten zu verbessern, was als Memory RAG bezeichnet wird [35]. Zum Beispiel wird in der Literatur [36Die in ] vorgeschlagene automatische Agentenarchitektur auf der Grundlage des Large Language Model (LLM) besteht aus vier Komponenten: dem Profiling-Modul, dem Speichermodul, dem Planungsmodul und dem Aktionsmodul. Das Speichermodul ist die Schlüsselkomponente bei der Entwicklung einer intelligenten Agentenarchitektur. Es ist dafür verantwortlich, Informationen aus der Umgebung zu sammeln und diese aufgezeichneten Erinnerungen zu nutzen, um zukünftige Aktionen zu verbessern. Das Speichermodul ermöglicht es intelligenten Agenten, Erfahrungen zu sammeln, sich selbständig weiterzuentwickeln und auf konsistentere, rationalere und effizientere Weise zu handeln [14]

Studien zum Speicherdesign bei der Anwendung von großen Sprachmodellen lassen sich in zwei Kategorien unterteilen. In der ersten Kategorie geht es um die Erfassung und Speicherung von Zwischenzuständen während der Modellinferenz als Speicherinhalt. Diese Speicher werden bei Bedarf abgerufen, um die Erzeugung der aktuellen Antwort zu unterstützen. Zum Beispiel, MemTRM [37MemTRM wendet den hybriden Aufmerksamkeitsmechanismus sowohl auf die aktuelle Eingabe als auch auf das vergangene Gedächtnis an, indem es vergangene Schlüssel-Wert-Paare beibehält und eine Suche nach der nächstgelegenen Nachbarschaft unter Verwendung des Abfragevektors der aktuellen Eingabe durchführt. MemTRM stößt jedoch auf das Problem der Veralterung des Speichers während des Trainings. Um dieses Problem zu lösen, wurde LongMEM [38] trennt den Speichervorgang vom Abrufprozess. Diese Strategie eignet sich besonders für Open-Source-Modelle und kann ein adaptives Training erfordern, um den Inhalt der Speicherbank effektiv zu integrieren. Die zweite Klasse von Speicherdesignlösungen bietet Speicherunterstützung durch externe Speicherbänke. Externe Speicherbanken können verschiedene Formen annehmen, um die Fähigkeit des Systems, Informationen zu verwalten und abzurufen, zu verbessern. Zum Beispiel: MemoryBank [10KI-Stadt[] speichert vergangene Dialoge, Ereigniszusammenfassungen und Benutzereigenschaften in Form einer Vektorbibliothek. Der Prozess des Gedächtnisabrufs wird durch die Berechnung der Vektorähnlichkeit stark beschleunigt, so dass relevante vergangene Erfahrungen und Daten schnell zugänglich sind.AI-town[12] verwendet einen natürlichsprachlichen Ansatz zur Gedächtniserhaltung und führt einen Reflexionsmechanismus ein, der unter bestimmten Bedingungen einfache Beobachtungen in abstraktere und höherwertige Reflexionen umwandelt. Dieses System berücksichtigt drei Schlüsselfaktoren im Abrufprozess: Erinnerungsrelevanz, Aktualität und Bedeutung, wodurch sichergestellt wird, dass die relevantesten und kontextuell bedeutsamsten Informationen für die aktuelle Interaktion abgerufen werden.

In Rollenspiel-Agenten, die auf großen Sprachmodellen basieren, verfolgen die Speichereinheiten in der Regel einen zweiten Ansatz, indem sie die Authentizität des Charakters mit Hilfe einer externen Speicherbank verbessern. Im ChatHaruhi-System zum Beispiel bereichert der Rollenspiel-Agent die Charakterentwicklung und die Interaktion durch den Abruf von Dialogen aus ikonischen Szenen. Trotz umfangreicher Forschungen im Bereich der Memory-RAG-Techniken ist die Frage, wie man zu menschlicheren Antworten gelangen kann, nach wie vor ein unerforschtes und offenes Feld. Inspiriert von der kognitiven Forschung in der Psychologie unternehmen wir den ersten Versuch, emotionale Faktoren in den Erinnerungsabrufprozess einzubeziehen, um menschliche kognitive Prozesse zu imitieren und so die Antworten des großen Sprachmodells emotionaler und menschlicher zu gestalten.

zu einem Urteil gelangen

In diesem Beitrag unternehmen wir den ersten Versuch, ein emotionales Gedächtnis einzuführen, um die Leistung von Rollenspielagenten zu verbessern. Wir schlagen ein neuartiges affektives RAG-Framework mit vier Abrufstrategien vor, um Rollenspiel-Agenten im Dialog emotionaler und menschlicher zu machen. Umfassende experimentelle Ergebnisse auf drei öffentlichen Datensätzen für eine Vielzahl von Charakteren zeigen die Effektivität unseres Ansatzes bei der Beibehaltung der Persönlichkeitsmerkmale der Charaktere. Wir glauben, dass die Einbeziehung von Emotionen in Rollenspiel-Agenten eine wichtige Forschungsrichtung ist. In der aktuellen Studie haben wir eine affektive RAG durchgeführt, die auf intuitiven Gedächtnismechanismen basiert. In zukünftigen Arbeiten werden wir versuchen, affektive Faktoren in anspruchsvollere Gedächtnisorganisations- und Abrufschemata einzubauen.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Verwandte Beiträge

Keine Kommentare...