Dolphin: Asiatische Spracherkennung und Speech-to-Text-Modelle für asiatische Sprachen

Allgemeine Einführung

Dolphin ist ein Open-Source-Modell, das von DataoceanAI in Zusammenarbeit mit der Tsinghua-Universität entwickelt wurde und sich auf Spracherkennung und Spracherkennung für asiatische Sprachen konzentriert. Es unterstützt 40 Sprachen aus Ostasien, Südasien, Südostasien und dem Nahen Osten sowie 22 chinesische Dialekte. Das Modell wurde auf der Grundlage von über 210.000 Stunden Audiodaten trainiert, wobei eigene und öffentlich zugängliche Datensätze kombiniert wurden.Dolphin kann Sprache in Text umwandeln, Teile von Sprache erkennen (VAD), Audio segmentieren und Sprache erkennen (LID). Dolphin ist so konzipiert, dass es einfach ist. Der Code und einige der Modelle sind für Entwickler auf GitHub frei verfügbar.

Funktionsliste

- Unterstützt Sprache-zu-Text in 40 asiatischen Sprachen und 22 chinesischen Dialekten.

- Bietet Voice Activity Detection (VAD) zum Auffinden von Sprachsegmenten im Audiomaterial.

- Unterstützung von Audio-Splitting, schneiden lange Audio in kleine Segmente für die Verarbeitung.

- Implementieren Sie die Sprachidentifikation (LID), um die Sprache oder den Dialekt der Audiodatei zu bestimmen.

- Offener Quellcode und Modelle, die vom Benutzer geändert und angepasst werden können.

- Es gibt zwei Modelle, Base und Small, für unterschiedliche Bedürfnisse.

- Verwenden Sie ein zweistufiges Kennzeichnungssystem, das zwischen Sprachen und Regionen unterscheidet (z. B.

<zh><CN>).

Hilfe verwenden

Der Installations- und Nutzungsprozess von Dolphin ist einfach und für Benutzer mit grundlegenden Programmierkenntnissen geeignet. Nachfolgend finden Sie die detaillierten Schritte.

Einbauverfahren

- Vorbereiten der Umgebung

Benötigt Python 3.8 oder höher und FFmpeg zur Audioverarbeitung.- Überprüfen von Python: Geben Sie im Terminal

python --versionund bestätigt die Version. - Python ist nicht installiert und kann von python.org heruntergeladen werden.

- Installieren Sie FFmpeg: Führen Sie den Befehl entsprechend Ihrem System aus:

- Ubuntu/Debian:

sudo apt update && sudo apt install ffmpeg - macOS:

brew install ffmpeg - Fenster:

choco install ffmpeg

Nicht installierte Paketverwaltungsprogramme können von der FFmpeg-Website heruntergeladen werden.

- Ubuntu/Debian:

- Überprüfen von Python: Geben Sie im Terminal

- Installation von Dolphin

Es gibt zwei Möglichkeiten:- Installieren mit pip

Geben Sie ihn in das Terminal ein:pip install -U dataoceanai-dolphinDadurch wird die neueste stabile Version installiert.

- Installation aus dem Quellcode

Um die neueste Entwicklungsversion zu verwenden, laden Sie sie von GitHub herunter:- Klon-Lagerhaus:

git clone https://github.com/DataoceanAI/Dolphin.git - Besuchen Sie den Katalog:

cd Dolphin - Einbau:

pip install .

- Klon-Lagerhaus:

- Installieren mit pip

- Modelle herunterladen

Dolphin verfügt über 4 Modelle, von denen derzeit das Basismodell (140 Mio. Parameter) und das kleine Modell (372 Mio. Parameter) zum kostenlosen Download zur Verfügung stehen.- durch (eine Lücke) Gesicht umarmen Holen Sie die Modelldatei.

- Speichern unter dem angegebenen Pfad, z. B.

/data/models/dolphin/. - Das Basismodell ist schneller und das kleine Modell ist genauer.

Verwendung

Befehlszeilen- und Python-Operationen werden unterstützt.

Befehlszeilenbetrieb

- Sprache zu Text

Bereiten Sie die Audiodatei vor (z. B.audio.wav), eingeben:

dolphin audio.wav

Das System lädt automatisch das Standardmodell herunter und gibt den Text aus. Der Ton sollte im WAV-Format vorliegen und kann mit FFmpeg konvertiert werden:

ffmpeg -i input.mp3 output.wav

- Angabe von Modellen und Pfaden

Verwenden Sie das kleine Modell:

dolphin audio.wav --model small --model_dir /data/models/dolphin/

- Geben Sie Sprache und Region an

Erkennen von Mandarin-Chinesisch mit doppelschichtigen Markern:

dolphin audio.wav --model small --model_dir /data/models/dolphin/ --lang_sym "zh" --region_sym "CN"

lang_symist der Sprachcode, z. B. "zh" (Chinesisch).region_symist die Ortsvorwahl, z. B. "CN" (Festland China).

Für eine vollständige Liste der Sprachen siehe Sprachen.md.

- Kurzes Audio befüllen

Verfügbar, wenn der Ton weniger als 30 Sekunden dauert--padding_speech trueFüllung:

dolphin audio.wav --model small --model_dir /data/models/dolphin/ --lang_sym "zh" --region_sym "CN" --padding_speech true

Python-Code-Manipulation

- Laden von Audio und Modellen

Läuft in Python:

import dolphin

waveform = dolphin.load_audio("audio.wav") # 加载音频

model = dolphin.load_model("small", "/data/models/dolphin/", "cuda") # 加载模型

"cuda"mit GPU, ohne GPU Wechsel zu"cpu".

- Anerkennung der Führungskräfte

Verarbeitet Audio und gibt es aus:result = model(waveform) # 转文本 print(result.text) # 显示结果 - Geben Sie Sprache und Region an

Parameter hinzufügen:result = model(waveform, lang_sym="zh", region_sym="CN") print(result.text)

Featured Function Bedienung

- Erkennung von Sprachaktivität (VAD)

Erkennt automatisch Sprachsegmente und kennzeichnet sie z. B. mit der Zeit:0.0-2.5s: 你好 3.0-4.5s: 今天天气很好 - Identifizierung von Sprachen (LID)

Bestimmen Sie zum Beispiel die Audiosprache:dolphin audio.wav --model small --model_dir /data/models/dolphin/Ausgabe als

<zh>(Chinesisch) oder<ja>(Japanisch). - zweisprachiger Auszeichnungsprozess

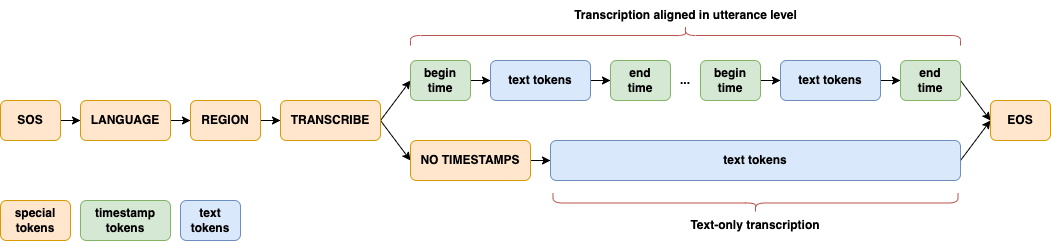

Unterscheiden Sie zwischen Sprachen und Regionen mit einer zweistufigen Kennzeichnung, z. B.<zh><CN>(auf Mandarin-Chinesisch),<zh><TW>(taiwanesisches Mandarin), um die Fähigkeiten zur Verarbeitung asiatischer Sprachen zu verbessern. - Modellarchitektur

Die CTC-Attention-Architektur, mit E-Branchformer für den Encoder und Transformer für den Decoder, ist für asiatische Sprachen optimiert.

Anwendungsszenario

- Verfahren

Konvertiert Aufzeichnungen mehrsprachiger asiatischer Konferenzen in Text, geeignet für internationale oder lokale Meetings. - Dialektstudium

Analyse der phonologischen Merkmale von 22 chinesischen Dialekten und Erstellung von Forschungsdaten. - Entwicklung intelligenter Geräte

Integration in intelligente Geräte zur Sprachsteuerung in asiatischen Sprachen.

QA

- Welche Sprachen werden unterstützt?

Unterstützung von 40 asiatischen Sprachen und 22 chinesischen Dialekten, siehe Sprachen.md. - Brauchen Sie eine GPU?

Nicht erforderlich. CPU kann laufen, GPU (CUDA-Unterstützung) ist schneller. - Was ist der Unterschied zwischen dem Basismodell und dem kleinen Modell?

Das Basismodell ist klein (140M Parameter) mit einer Fehlerquote von 33,31 TP3T; das kleine Modell ist groß (372M Parameter) mit einer Fehlerquote von 25,21 TP3T.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...