Einsatz eines personalisierten "kleinen" Chat-Tools für Low-Cost-Computer

Warum ein privates "Mini"-Modell-Chat-Tool einsetzen?

Viele Menschen haben ChatGPT, Wisdom Spectrum, Beanbag, Claude und andere hervorragende große Sprachmodelle verwendet, und haben die Notwendigkeit, in der Tiefe zu verwenden, wird auch kaufen Dritten kostenpflichtige Dienste, nachdem alle, sie sind sehr hervorragende Leistung. Zum Beispiel ist mein Hauptarbeitsszenario, Artikel zu schreiben, dann werde ich Claude wählen.

Obwohl ich Claude gerne benutze, verwende ich es wirklich täglich und häufig? Die Antwort ist natürlich nein!

Schwellenwerte wie Nutzungsgrenzen, Preisfaktoren, Netzprobleme usw. verringern natürlich die Häufigkeit der Nutzung in unnötigen Situationen. -Wenn ein Werkzeug nicht in jeder Umgebung "mitgenommen und benutzt" werden kann, dann stimmt etwas nicht mit ihm.

In diesem Fall könnte ein "kleines" Modell die bessere Wahl sein, warum?

Merkmale des "kleinen" Modells

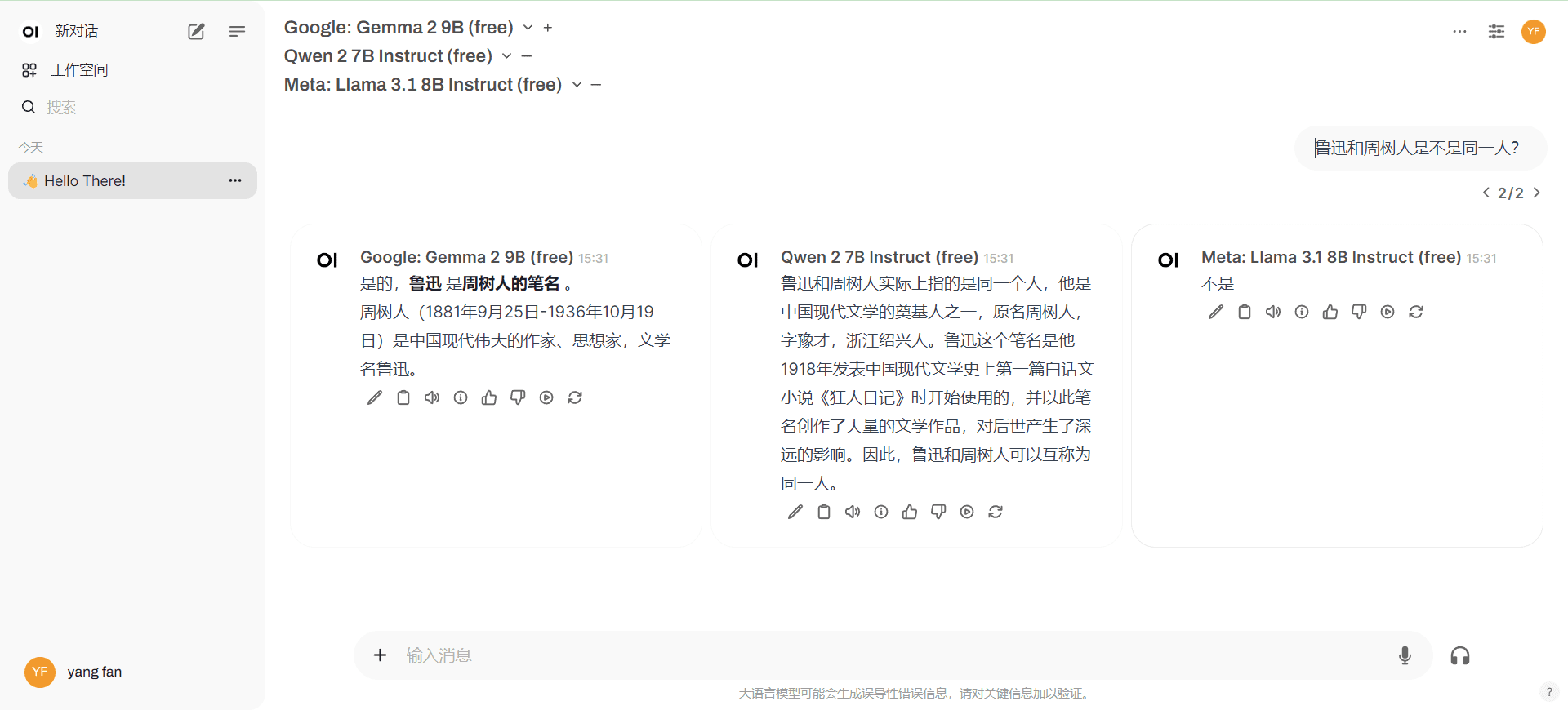

GEMMA2, LLAMA3.1:8b, QWEN2:7b sind klein genug für den täglichen Gebrauch, 32k lange kontextuelle Ein- und Ausgabe, die meisten Befehle werden befolgt, die Fähigkeit, sich auf Chinesisch auszudrücken, Fragen zu beantworten, und insgesamt gut, und es gibt keine "Wenxin Yiyin" Art von Produkt, das nur 2000 Wörter oder ähnliches eingeben kann! Die Einschränkungen... Für den täglichen Gebrauch reicht es aus, und wir werden überlegen, ob wir uns auf spezielle Aufgaben spezialisieren. Die Vorteile der Miniaturen sind wie folgt:

- Unterstützung für Kontextgrößen, die nicht kleiner (oder sogar größer) sind als das größere Modell

- Alltägliche Schreibaufgaben mit nicht minderwertigen Ergebnissen

- unbegrenzte Nutzung

- Für einen einfachen Vergleich können mehrere Miniaturen gleichzeitig Antworten ausgeben.

- Schnellere Ausführung

Was ist ein privater Einsatz?

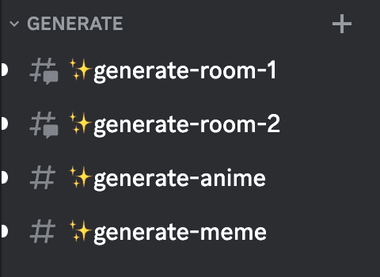

Eine private Chat-WEB-Schnittstelle für eine einfache Anpassung und freien Zugang zu "kleinen" Modellen.

Die klassischste Lösung ist der lokale Einsatz von Ollama+Open WebUI, wobei erstere für die Ausführung der Miniaturen auf dem lokalen Computer zuständig ist und letztere die Chat-Schnittstelle hostet. Erwägen Sie Extranets für die jederzeitige und ortsunabhängige Nutzung dercloudflarevielleichtcpolarOrdnen Sie die Adresse einem externen Netzwerk zu (suchen Sie selbst nach dem Tutorial).

Blickwinkel

- Chat-Daten sind lokal und privat

- Flexibilität bei der Anpassung der lokalen Modelle

Nachteile

- Schwierig, dauerhaft zu laufen (Sie müssen Ihren Computer immer ausschalten, oder?) Schwierige Veröffentlichung in einem Extranet

- Hohe Anforderungen an die Computer-Hardware

zu behandelnde Frage

Es sind die Unzulänglichkeiten, die wir zu beheben versuchen:

1. die eingesetzte KI-Chat-Schnittstelle muss in einem Extranet mit stabilen Zugangs-URLs veröffentlicht werden, damit sie überall und jederzeit genutzt werden kann

(2) Computer-Hardware-Schwelle ist vor allem die Verwendung von Ollama, um das Modell lokal laufen, geändert, um bekannte Hersteller von API-Diensten werden kann, ist der Schutz der Privatsphäre relativ gut und kostenlos. (Allgemeine Computer lokal kann bis kleine Modelle laufen, hat das Netzwerk eine kostenlose API)

Optimales Programm

1. lokaler/cloud-freier Einsatz von Doceker Offene WebUI + Zugang zu "kleinen" Modell-APIs

Nur für den lokalen Gebrauch, die Computer-Hardware muss nur in der Lage sein, doceker auszuführen

2. selbständige Entwicklung/Nutzung von NextChat mit drei Parteien + Zugang zu "kleinen" Modell-APIs

Für die Selbstbereitstellung von NextChat ist ein eigener Domänenname erforderlich, und es besteht die Gefahr, dass Ihre Schlüssel durch die Verwendung eines NextChat-Dreiparteiensystems gefährdet werden.

Dieser Einsatzplan ist nur für erfahrene Leute zu bedienen, unerfahrene weiß nicht empfohlen, eine gute Nutzung von ausgereiften Produkten, oder auftretende abnorme Probleme Verzögerung ist es nicht wert.

Optimale Einsatzmöglichkeit 1

1. der Einsatz von Doceker

Lokal: lokaler Einsatz von doceker tutorials Suche für sich selbst

Cloud: kostenlose Doceker-Ressourcen in der Cloud, bitte selbst suchen, hier verwende ich Koyeb. (Intranet nicht direkt zugänglich, erfordert Wissenschaft und Technologie)

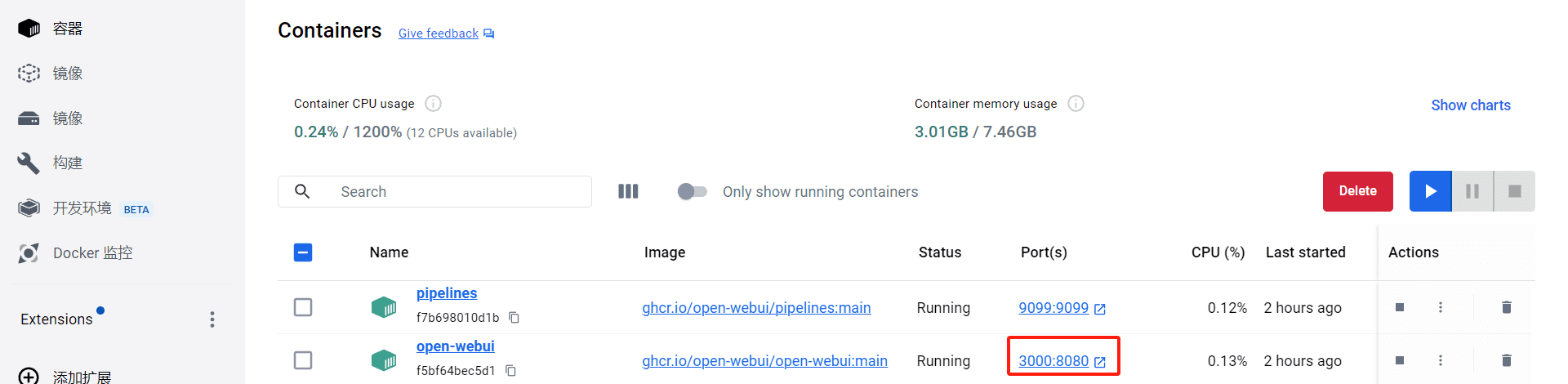

2. die Bereitstellung von Open WebUI in doceker

Lokal: DetailsLesen Sie das DokumentDie folgenden Installationsbefehle werden empfohlen (halten Sie sie auf dem neuesten Stand)

docker run --rm --volume /var/run/docker.sock:/var/run/docker.sock containrrr/watchtower --run-once open-webui

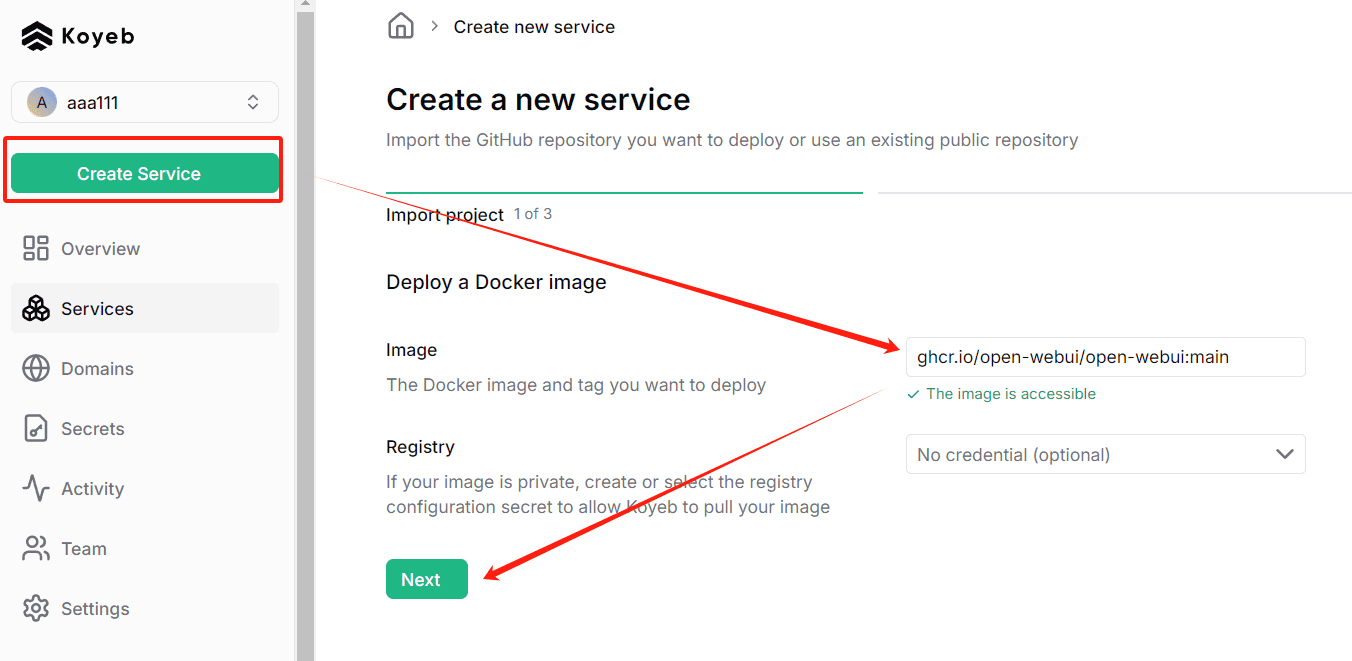

Cloud: RegistrierungKoyebKlicken Sie anschließend auf Dienst erstellen und geben Sie den folgenden Befehl ein

ghcr.io/open-webui/open-webui:main

3. starten WebUI öffnen

Lokaler Start, Standard-Zugangsadresse: http://localhost:3000/

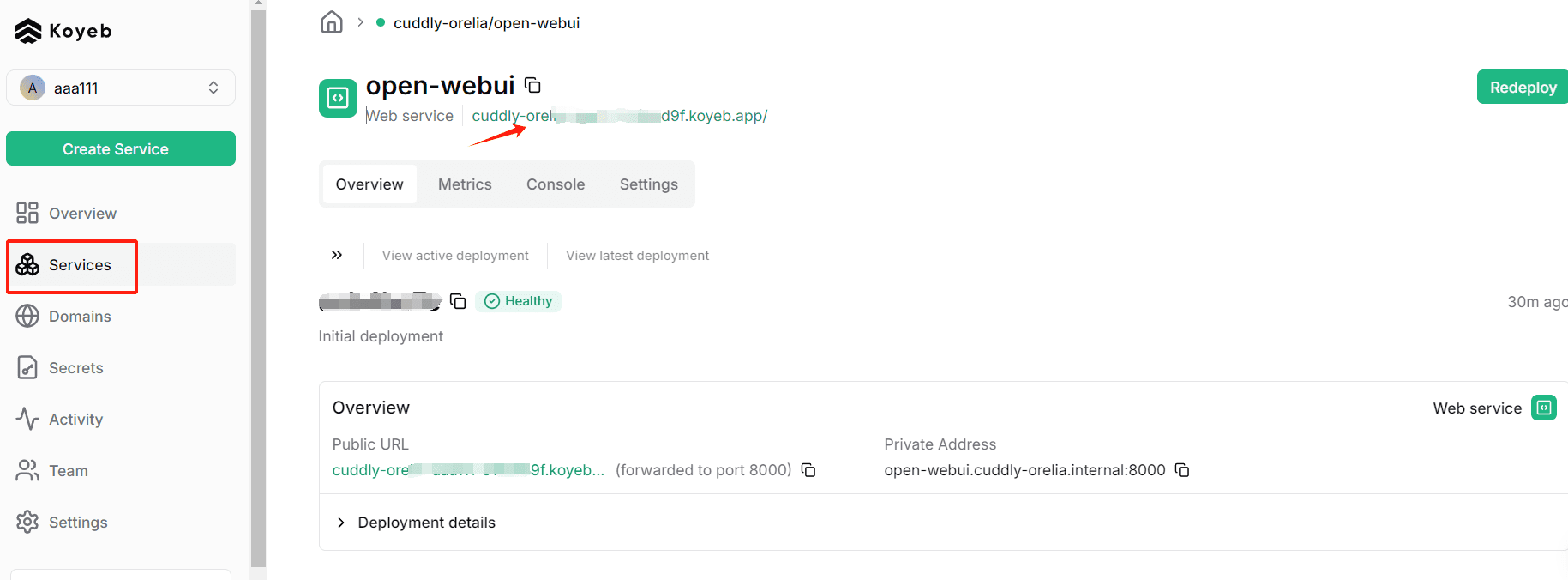

Der Start in der Cloud, nachdem die Bereitstellung von Koyeb abgeschlossen ist, kann hier angeklickt werden (der Nachteil ist, dass dieser Domainname nicht direkt über das Intranet zugänglich ist, die Bindung des Domainnamens erfordert die Eröffnung eines kostenpflichtigen Kontos)

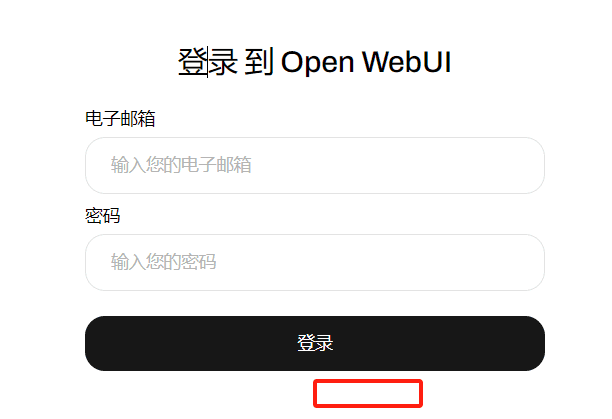

Nach dem Start registrieren Sie ein Konto, standardmäßig ist das erste registrierte Konto das Administratorkonto. Bereits registriert, so dass nur der Login-Bildschirm, der erste Besuch können Sie die "Registrierung" Portal zu sehen

4. eine kostenlose "kleine" Modell-API beantragen

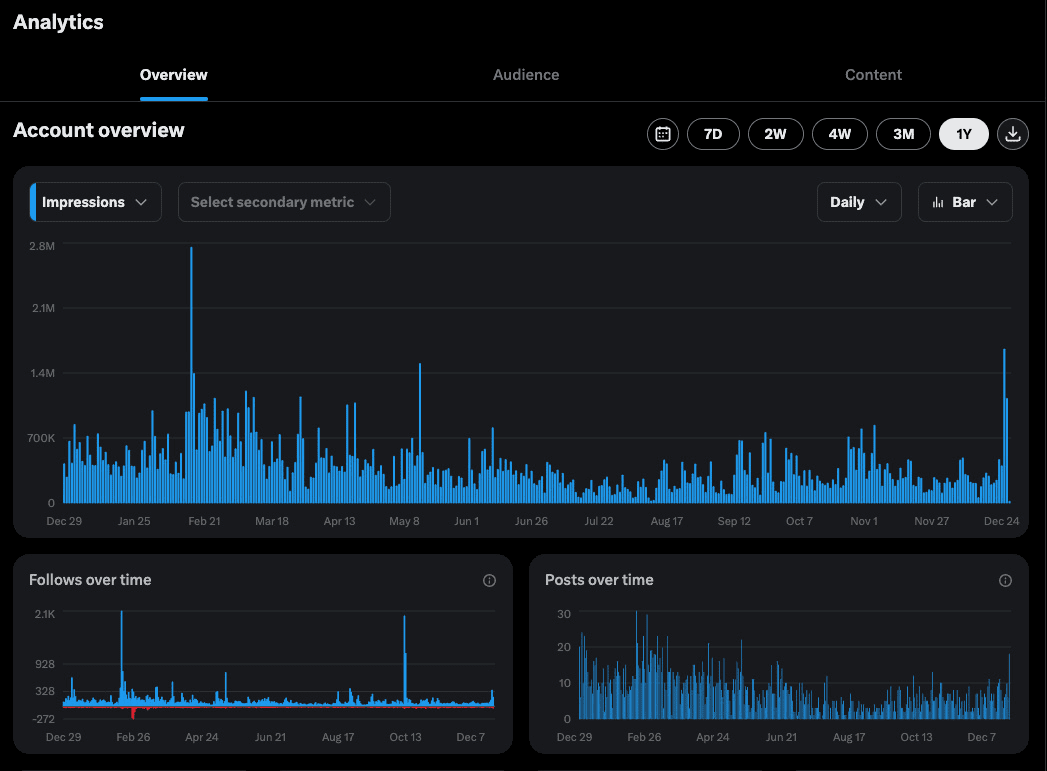

OpenRouter wird empfohlen und ich schreibe seit einem Jahr Romane mit seinen kostenlosen Modellen. Hier ist eine Erklärung, wie man die Modell-APIs von OpenRouter erhält

PS: Inländische kostenlose API-Anbieter für kleine Modelle: Silicon Flow

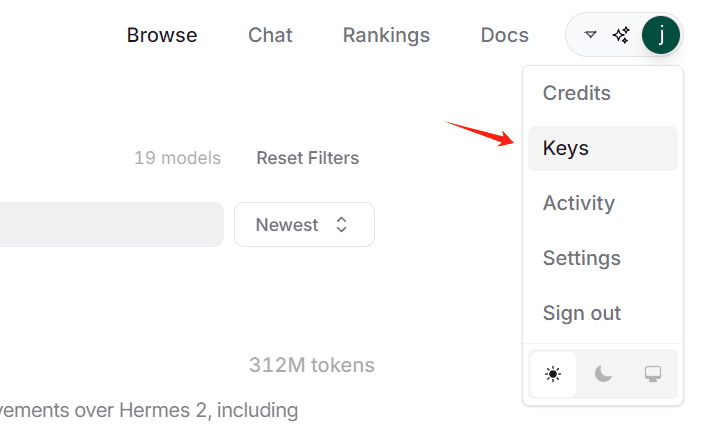

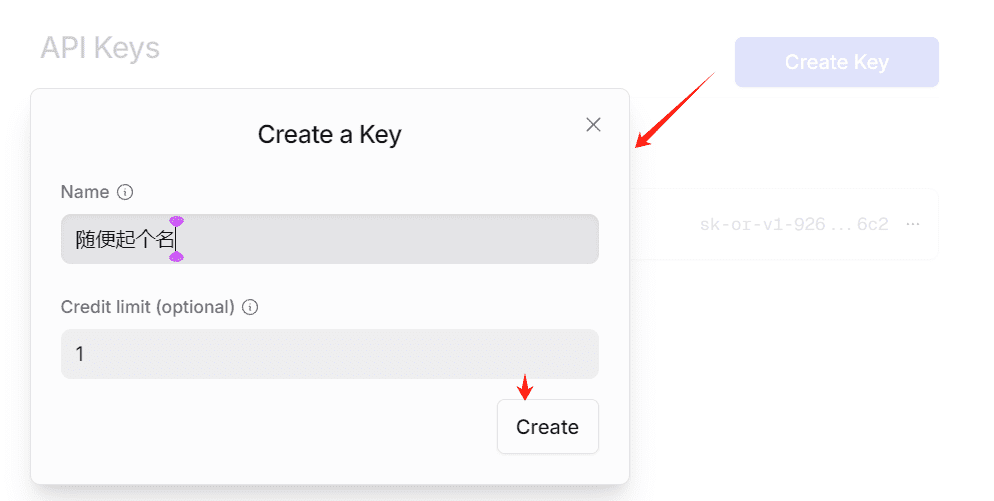

4.1 Erstellen eines KEY

Sie erhalten eine Zeichenfolge, die mit sk- beginnt, dies ist KEY, bitte kopieren Sie sie und speichern Sie sie lokal, Sie können sie nicht erneut kopieren, nachdem die Seite geschlossen wurde.

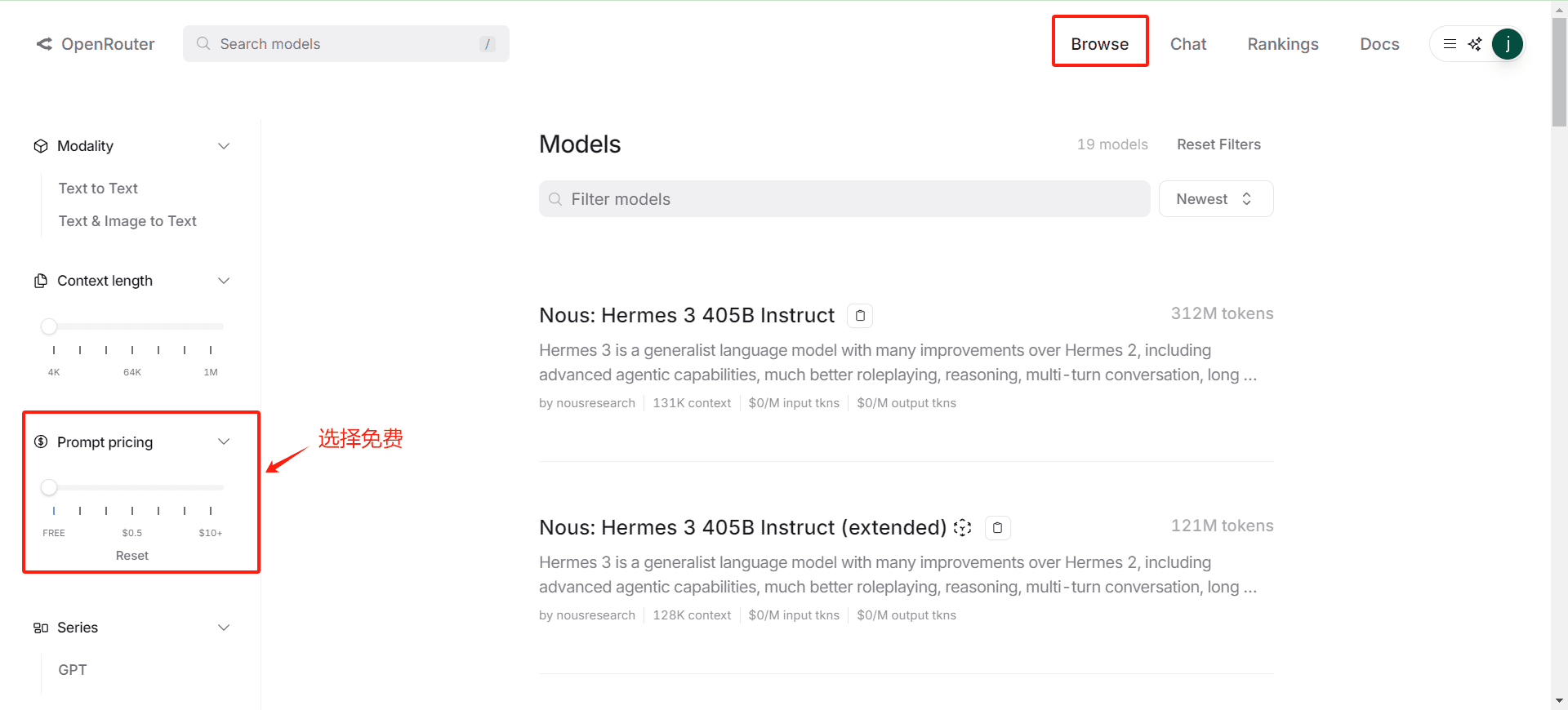

4.2 Bestätigung der Liste der freien Modelle

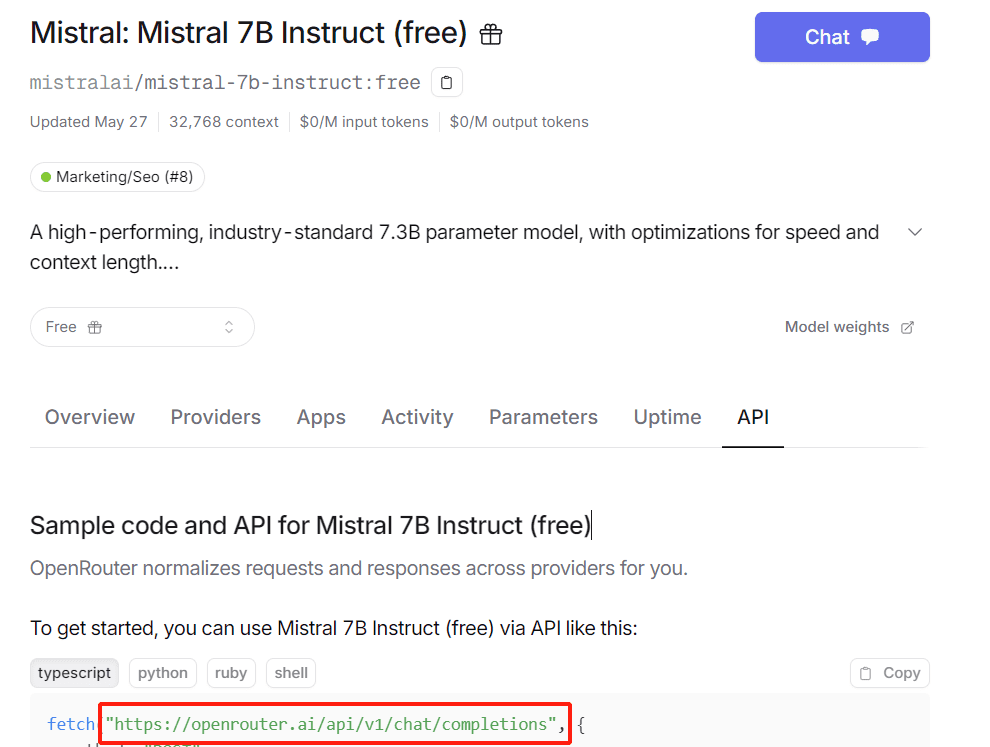

4.3 Abrufen der API-Anforderungs-URL(math.) Gattung

Gehen Sie auf eine beliebige Modellseite, um sie zu sehen, im Allgemeinen: https://openrouter.ai/api/v1/chat/completions

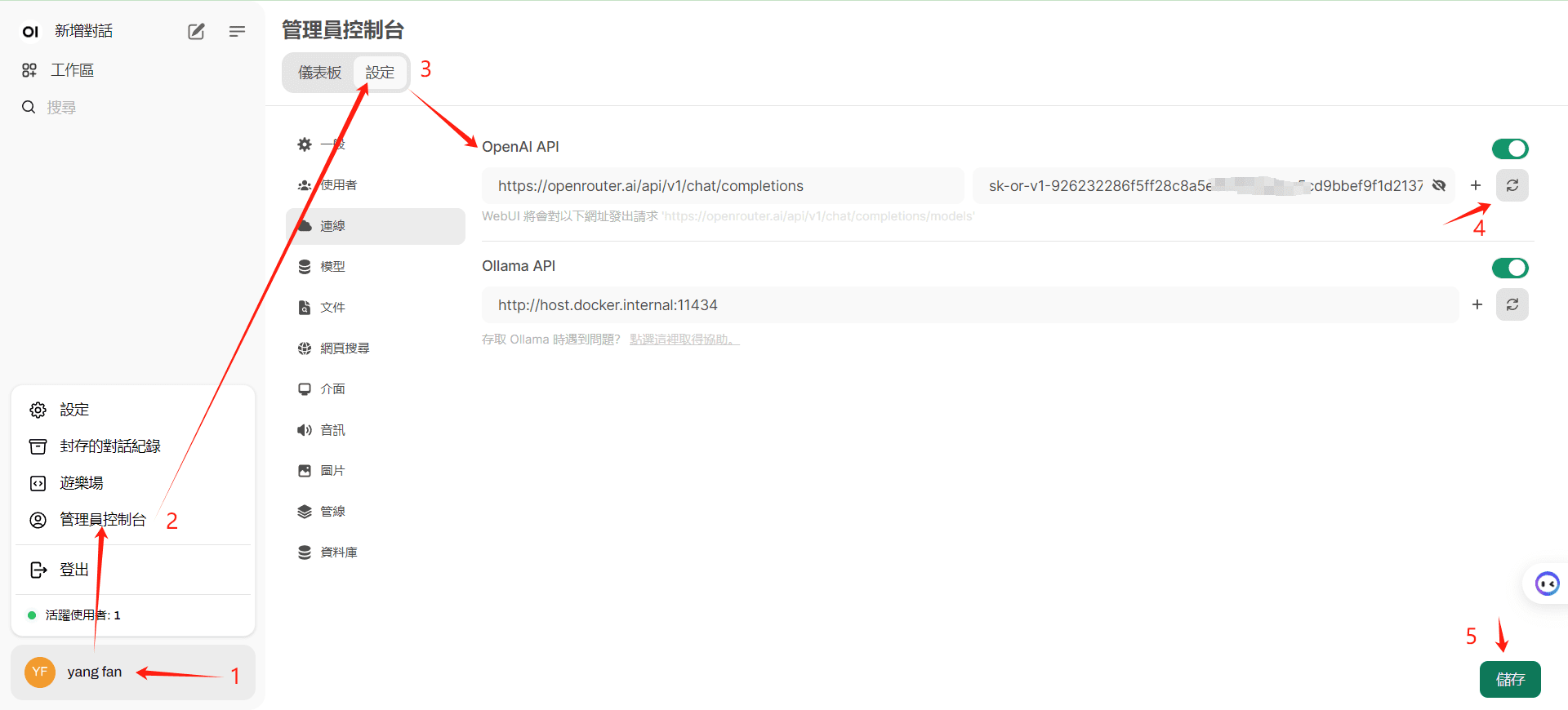

5. das Konfigurationsmodell Open WebUI eingeben

Beachten Sie, dass Sie mit "4" bestätigen, dass der Zugriff auf die Schnittstelle erfolgreich war, bevor Sie auf "Speichern" klicken.

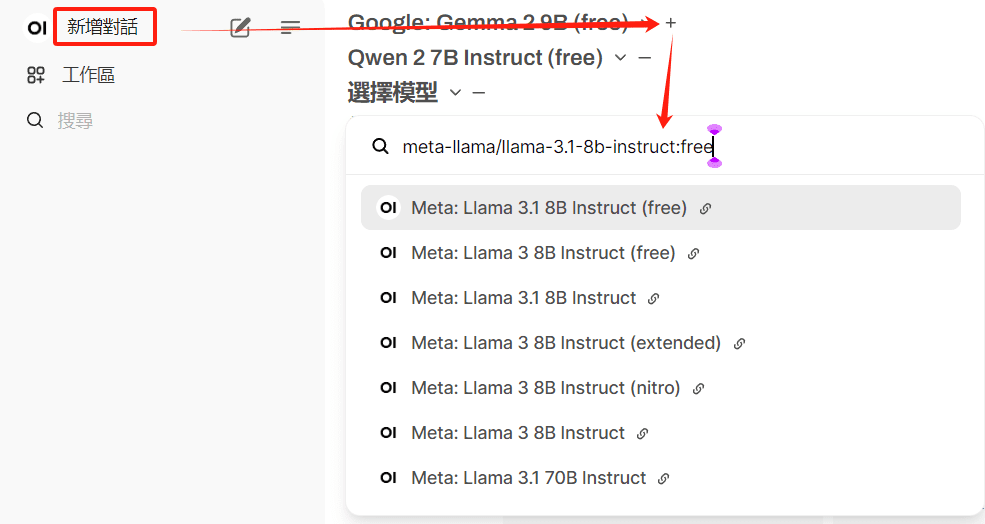

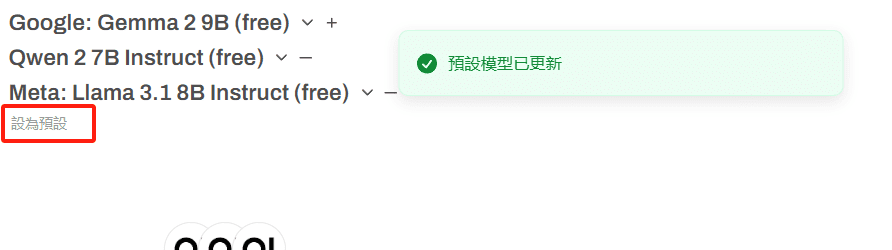

6) Konfigurieren Sie das Standardmodell

Mehrere freie Modelle können ausgewählt werden

Die Verwendung von bezahlten Modellen führt zur Deaktivierung des Kontos.

Klicken Sie auf Voreinstellungen, um häufig verwendete Modelle zu speichern

7. den Versuch eines ersten Dialogs

Optimale Einsatzmöglichkeit 2

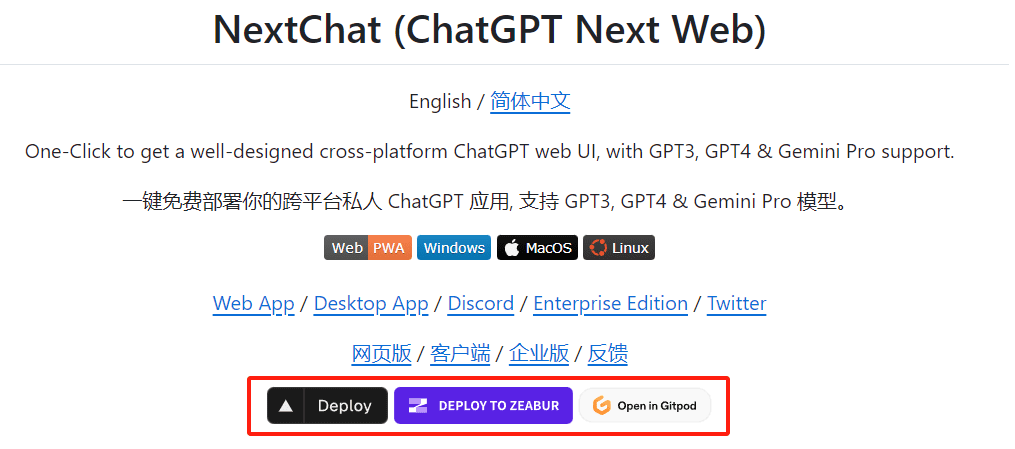

1. die Cloud-Bereitstellung von NextChat

Kostenlose Cloud-Bereitstellung mit einem Klick, sehen Sie sich die Hilfe selbst an: https://github.com/ChatGPTNextWeb/ChatGPT-Next-Web

(2) Hier wird der erste Einsatz von Deploy (vercel) verwendet.

Befolgen Sie einfach das Verfahren, und beachten Sie die folgenden drei Punkte:

- Lesen Sie die Hilfedokumentation sorgfältig durch und befolgen Sie die Anleitung, um Ihr Projekt für die automatische Aktualisierung einzurichten.

- Konfigurieren Sie die KEY-Variable und das Zugangspasswort während der Vercel-Installation, es wird empfohlen, sie im Voraus zu konfigurieren.

- Die Bindung eines eigenen Domänennamens ermöglicht den direkten Zugang zu inländischen Netzen.

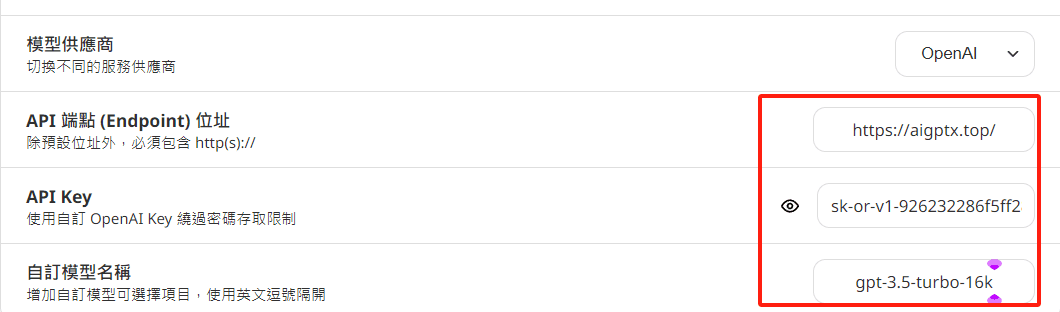

3. die Konfigurationsvariablen

Es ist nicht wie Option 1, die die Modellliste automatisch lesen kann, Sie müssen Ihre eigene freie Modellliste definieren, beachten Sie die Änderung der Schnittstellenadresse

BASE_URL oder OpenAI Endpunkt: Setzen Sie dies auf https://openrouter.ai/api

OPENAI_API_KEY oder OpenAI API Key: Geben Sie Ihren OpenRouter API-Schlüssel hier.

CUSTOM_MODELS oder Benutzerdefinierte Modelle: Geben Sie den Modellnamen so an, wie er in OpenRouter aufgeführt ist.

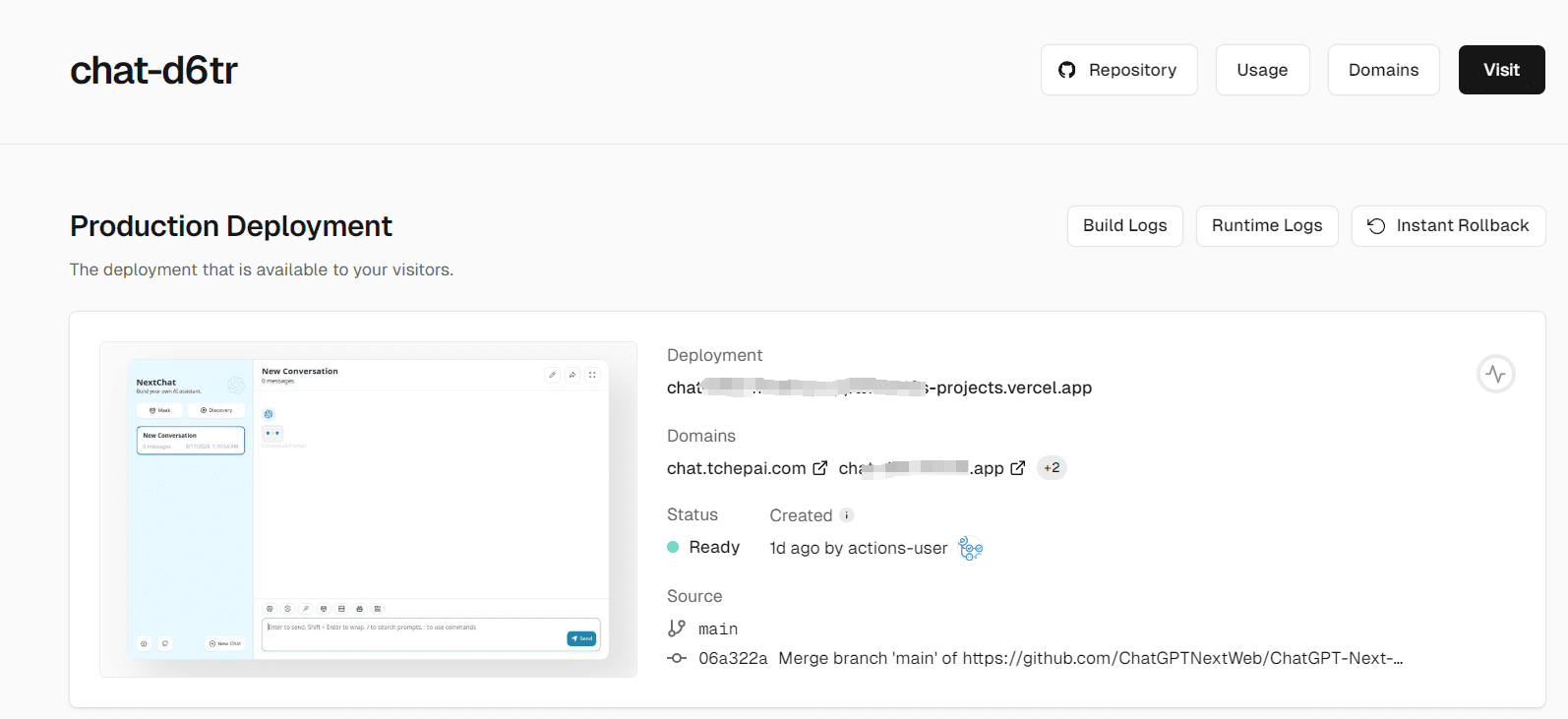

4 Bildschirm zum Abschluss der Bereitstellung

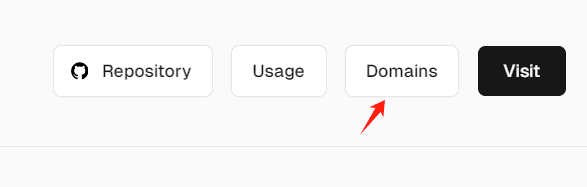

5.Verbindlicher Domänenname

Lösung von Zugangsproblemen im Land

4 Sie können den API KEY eines Modells separat in den Einstellungen konfigurieren.

Sie können eineOhMyGPTEine kleine Menge kostenloser GPT4-Credits pro Tag, eine weitere Adresse für den stabilen Zugang zu API KEY (um missbräuchliches Verstecken zu verhindern):

Ein weiteres kostenloses API KEY Projekt: https://github.com/chatanywhere/GPT_API_free

Eingesetzte NextChat-Adresse (achten Sie darauf, keine sensiblen Informationen einzugeben, geben Sie Ihren eigenen API-KEY ein): https://chat.tchepai.com/

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...