DeepSeek-VL2: ein visuelles Experten-Sprachmodell für fortgeschrittenes multimodales Verstehen

Allgemeine Einführung

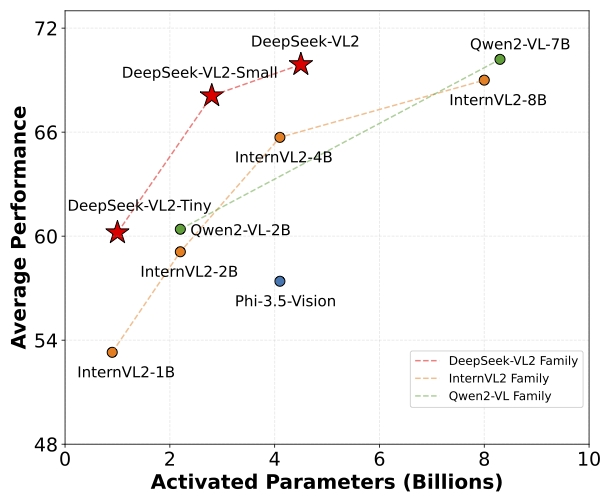

DeepSeek-VL2 ist eine Reihe von fortschrittlichen Mixture-of-Experts (MoE) visuellen Sprachmodellen, die die Leistung des Vorgängers DeepSeek-VL deutlich verbessern. Die DeepSeek-VL2-Familie besteht aus drei Varianten: DeepSeek-VL2-Tiny, DeepSeek-VL2-Small und DeepSeek-VL2, die jeweils 1,0B, 2,8B und 4,5B Aktivierungsparameter haben. Die Modelle erreichen eine vergleichbare oder bessere Leistung als bestehende Open-Source-Density- und MoE-Modelle mit einer ähnlichen oder geringeren Anzahl von Parametern.

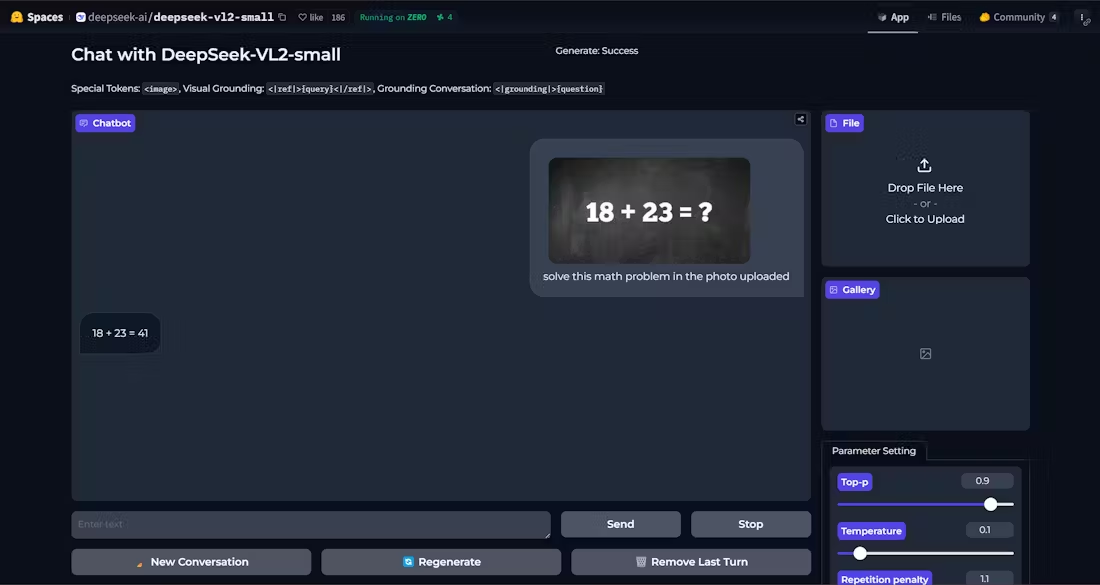

Demo: https://huggingface.co/spaces/deepseek-ai/deepseek-vl2-small

Funktionsliste

- Visuelle Fragen und AntwortenUnterstützt komplexe visuelle Quizaufgaben durch die Bereitstellung genauer Antworten.

- Optische Zeichenerkennung (OCR)Effiziente Erkennung von Textinhalten in Bildern.

- Dokument VerstehenParsing und Verstehen komplexer Dokumentstrukturen und -inhalte.

- Verständnis der FormIdentifizieren und Verarbeiten von Tabellendaten, um nützliche Informationen zu extrahieren.

- Grafisches VerständnisAnalyse und Interpretation von Daten und Trends in Diagrammen und Tabellen.

- visuelle OrientierungGenaue Lokalisierung des Zielobjekts im Bild.

- Multivarianten-UnterstützungEs gibt die Modelle Tiny, Small und Standard für unterschiedliche Bedürfnisse.

- Hohe LeistungReduziert die Anzahl der Aktivierungsparameter bei gleichbleibend hoher Leistung.

Hilfe verwenden

Einbauverfahren

- Stellen Sie sicher, dass die Python-Version >= 3.8 ist.

- Klonen Sie das DeepSeek-VL2-Repository:

git clone https://github.com/deepseek-ai/DeepSeek-VL2.git

- Wechseln Sie in das Projektverzeichnis und installieren Sie die erforderlichen Abhängigkeiten:

cd DeepSeek-VL2

pip install -e .

Anwendungsbeispiel

Beispiel für eine einfache Argumentation

Nachfolgend finden Sie einen Beispielcode für eine einfache Inferenz mit DeepSeek-VL2:

import torch

from transformers import AutoModelForCausalLM

from deepseek_vl2.models import DeepseekVLV2Processor, DeepseekVLV2ForCausalLM

from deepseek_vl2.utils.io import load_pil_images

# 指定模型路径

model_path = "deepseek-ai/deepseek-vl2-tiny"

vl_chat_processor = DeepseekVLV2Processor.from_pretrained(model_path)

vl_model = DeepseekVLV2ForCausalLM.from_pretrained(model_path)

# 加载图像

images = load_pil_images(["path_to_image.jpg"])

# 推理

inputs = vl_chat_processor(images=images, return_tensors="pt")

outputs = vl_model.generate(**inputs)

print(outputs)

Detaillierte Funktionsabläufe

- Visuelle Fragen und Antworten::

- Modelle und Prozessoren laden.

- Geben Sie ein Bild und eine Frage ein, und das Modell liefert die Antwort.

- Optische Zeichenerkennung (OCR)::

- ausnutzen

DeepseekVLV2ProcessorBild laden. - Das Modell wird zur Inferenz aufgerufen, um den Text im Bild zu extrahieren.

- ausnutzen

- Dokument Verstehen::

- Lädt die Eingabe, die das Bild des Dokuments enthält.

- Das Modell analysiert die Dokumentstruktur und gibt das Ergebnis des Parsings zurück.

- Verständnis der Form::

- Geben Sie ein Bild ein, das das Formular enthält.

- Das Modell erkennt die Struktur und den Inhalt des Formulars und extrahiert die wichtigsten Informationen.

- Grafisches Verständnis::

- Laden Sie das Kartenbild.

- Das Modell analysiert grafische Daten und liefert Interpretationen und Trendanalysen.

- visuelle Orientierung::

- Geben Sie eine Beschreibung und ein Bild des Zielobjekts ein.

- Das Modell lokalisiert das Zielobjekt im Bild und gibt die Positionskoordinaten zurück.

Mit den oben genannten Schritten können die Benutzer die Leistungsfähigkeit von DeepSeek-VL2 voll ausschöpfen, um eine Vielzahl komplexer visueller Sprachaufgaben zu lösen.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...