DeepSeek R1 vs. o3-mini: Wer ist das kostengünstigste Inferenzmodell für 2025?

OpenAI o3-mini zusammen mit DeepSeek R1: Ein eingehender Vergleich von fortgeschrittenen KI-Inferenzmodellen, um die Hauptunterschiede zwischen den beiden wichtigsten Inferenzmodellen zu verstehen.

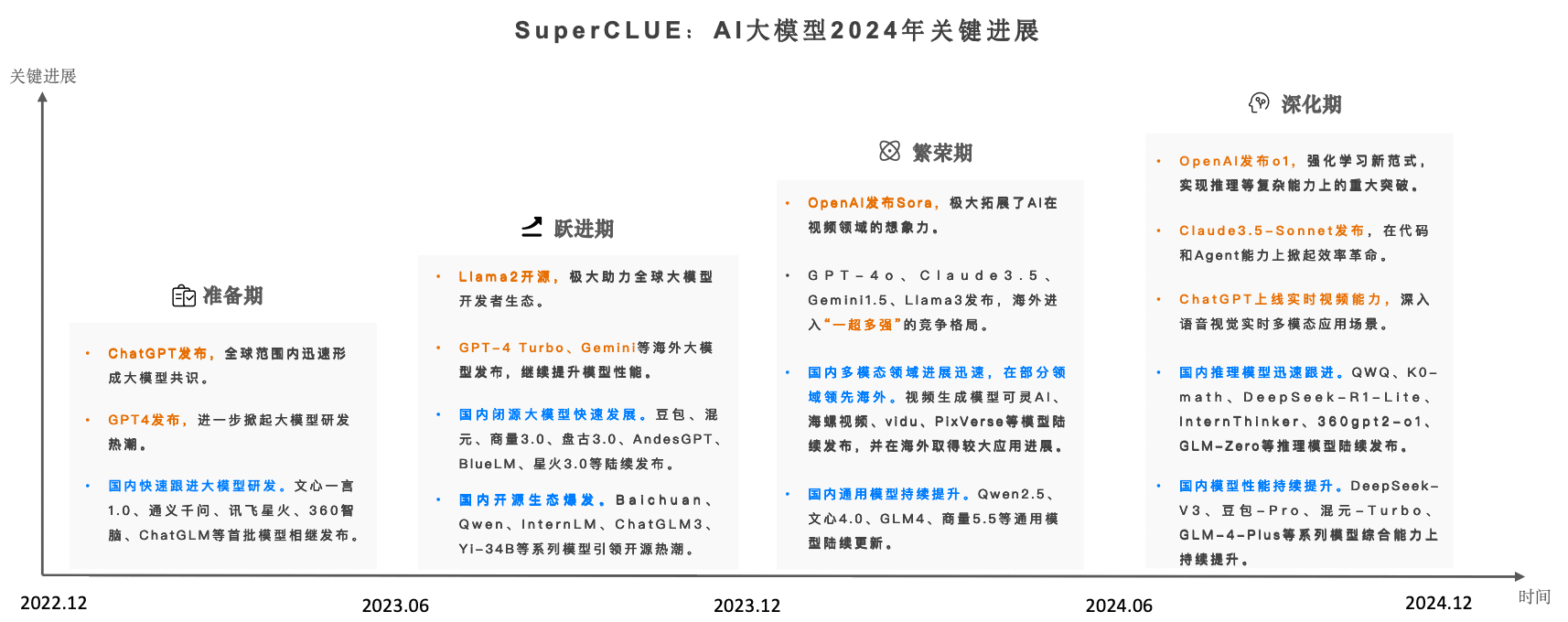

Im sich ständig wandelnden Bereich der Technologie der künstlichen Intelligenz (KI) sind Inferenzmodelle in den Mittelpunkt der technologischen Innovation gerückt. openAIs o3-mini ist das weltweit erste seiner Art, das in einer neuen Technologie eingesetzt wird. DeepSeek R1 auf die gleiche Weise wie dieser Trend Es haben sich zwei herausragende Modelle herauskristallisiert. Beide sind auf die Lösung komplexer Probleme, Programmierherausforderungen und wissenschaftlicher Aufgaben ausgerichtet, unterscheiden sich jedoch erheblich in ihrer Designphilosophie, Leistung, Kostenstruktur und dem Weg zur Realisierung.

Dieser Artikel zielt darauf ab, eine eingehende Analyse der wichtigsten Unterschiede zwischen OpenAI o3-mini und DeepSeek R1 in professioneller und prägnanter Form zu liefern. Der Artikel wird sorgfältig Vergleiche Das architektonische Design, die Leistungsbenchmarks, die Preisstrategien und die typischen Anwendungsszenarien der beiden Modelle sollen dem Leser die Zielsetzung Analysen, die den Lesern helfen, Entscheidungen entsprechend ihren Bedürfnissen zu treffen optimal Wählen Sie aus.

OpenAI o3-mini mit DeepSeek R1

OpenAI o3-mini Übersicht

Die Veröffentlichung von o3-mini Anfang 2025 ist ein wichtiger Teil der Strategie von OpenAI, seine effizienten und genauen Inferenzmodelle weiter zu verfeinern. o3-mini wird Anfang 2025 über das ChatGPT Die Community bietet Nutzern Zugang zu o3-mini, darunter kostenlose Nutzer mit eingeschränktem Zugang sowie Plus-, Team- und Pro-Abonnenten mit höherer Priorität. Kommentar: Die Beschreibung von Technologie-Iterationen in Technologieunternehmen als "kontinuierliche Bemühungen" ist etwas hohl, aber in Wirklichkeit handelt es sich um regelmäßige Upgrades, die durch den Wettbewerb auf dem Markt angetrieben werden. Die Hauptstärke von o3-mini liegt in der Fähigkeit, ein breites Spektrum an Aufgaben schnell und präzise zu bewältigen, mit besonderer Expertise in logischem Denken, Codegenerierung und Problemlösung in MINT-Fächern.

Hauptmerkmale des o3-mini

- Fortgeschrittene Fähigkeiten im logischen Denken. o3-mini wurde entwickelt, um den kognitiven Prozess des "Schritt-für-Schritt-Denkens" zu simulieren und so komplexe Probleme in leichter handhabbare Teilprobleme zu zerlegen, was die Effizienz und Genauigkeit der Problemlösung verbessert. Kommentar: Obwohl "schrittweises Denken" eine anthropomorphe Beschreibung ist, handelt es sich dabei um eine algorithmische Technik, die nicht so überinterpretiert werden sollte, dass KI über menschenähnliches Denken verfügt.

- Schnelle Reaktionszeit. Benchmarks zeigen, dass der o3-mini in der Lage ist, Antworten auf Aufgaben wie Codierungs- und Mathe-Rätsel innerhalb von Sekunden zu liefern, was eine hervorragende Reaktionszeit darstellt.

- Dichte Transformator-Architektur. o3-mini nutzt intensiv Transformator Architektur, jede Eingabe Token werden durch einen vollständigen Satz von Modellparametern behandelt, wodurch sichergestellt wird, dass das Modell für eine Vielzahl von Aufgaben geeignet ist besiedelt Leistung.

- Hervorragende Leistungen im Bereich Coding und MINT. o3-mini hat sich bei der Codegenerierung, beim Lösen von logischen Rätseln und bei der Verarbeitung wissenschaftlicher Abfragen als hervorragend erwiesen, insbesondere im MINT-Bereich, wo es ein großes Anwendungspotenzial aufweist.

- Tief integriert in ChatGPT. Das o3-mini-Modell ist der Kerntreiber der ChatGPT-API und der fortgeschrittenen Funktionen des Webinterfaces und bietet eine solide technische Unterstützung für die intelligente Anwendung von ChatGPT.

Preisgestaltung von o3-mini

Die Preise für den o3-mini lauten ungefähr wie folgt, basierend auf den neuesten vergleichenden Marktdaten:

- 1,10 USD pro Million eingegebener Token

- 4,40 USD pro Million ausgegebener Token

Die Preisgestaltung von o3-mini in Token ist im Vergleich zu einigen der Wettbewerb Etwas höher, aber mit seiner ausgezeichneten Geschwindigkeit und Genauigkeit, ist der viele Fälle zu (einer Entscheidung, Schlussfolgerung usw.) gelangen beweisen Die Angemessenheit dieser Kosten. Anmerkung: Die Formulierung "rechtfertigt in der Regel die Kosten" ist etwas subjektiv, und der Preisfaktor bleibt für budgetbewusste Nutzer entscheidend.

DeepSeek R1 Übersicht

Ziele der Veröffentlichung und Gestaltung

DeepSeek R1 wird vom chinesischen KI-Startup DeepSeek entwickelt, das von Wenfeng Liang gegründet wurde. DeepSeek R1 wird offiziell im Januar 2025 veröffentlicht, und das Unternehmen arbeitet seit über einem Jahrzehnt an der Entwicklung einer neuen KI-Technologie, die in Zukunft eingesetzt werden kann. im Augenblick Es zeichnet sich durch seine Fähigkeit aus, eine wettbewerbsfähige Kostenkontrolle zu erreichen und gleichzeitig fortschrittliche Argumentationsfähigkeiten zu gewährleisten. Darüber hinaus hat sich DeepSeek R1 für ein Open-Source-Modell entschieden, was bedeutet, dass Entwickler freien Zugang zu seinem Quellcode haben und diesen verändern können, um verschiedene Arten Individueller Bedarf. Kommentar: Das Verkaufsargument des DeepSeek R1, er sei "sehr preiswert", könnte darauf hindeuten, dass er einige Abstriche bei der Leistung gemacht hat und dass die Regel "billig ist nicht gut genug" auch in der Welt der Technik gilt.

Hauptmerkmale von DeepSeek R1

- Open-Source-Funktionen. Das Open-Source-Design von DeepSeek R1 macht den Code für jedermann zum Download und zur Integration verfügbar, und dieses hohe Maß an Transparenz ist wichtig für die Unterstützer des Open-Source-Konzepts ist sicherlich von großem Reiz für die Entwickler der

- Hervorragendes Kosten-Nutzen-Verhältnis. DeepSeek R1 im Entwurf Prioritäten setzen überdenken Effizienz. Dank der Mixture-of-Experts (MoE)-Architektur verbraucht DeepSeek R1 zur Laufzeit weniger Rechenressourcen, was die Betriebskosten erheblich senkt.

- Visualisierung der Gedankenkette. Anders als der implizite Inferenzprozess von o3-mini, ist DeepSeek R1 normalerweise im Einzelnen Darstellung der Argumentationsschritte. Einige Nutzer fanden diese "sichtbare Gedankenkette" hilfreich, um ein tieferes Verständnis für die innere Logik der Schlussfolgerungen des Modells zu erlangen. Kommentar: "Visible Chain-of-Thought" scheint eine Stärke von DeepSeek R1 zu sein, aber ein zu detaillierter Argumentationsprozess kann zu Redundanz und sogar zu Verwirrung bei den Nutzern führen.

- Mixture-of-Experts-Architektur. DeepSeek R1 verwendet die MoE-Architektur, bei der das Modell nur einige der Parameter (d. h. "Experten") für jedes Token aktiviert. Diese Designstrategie macht DeepSeek R1 effizienter bei der Bewältigung umfangreicher Aufgaben.

- Fokus auf Effizienz. Aufbau von DeepSeek R1 grundlegend Konzentration auf die Senkung der Kosten für Ausbildung und Argumentation auf ein budgetiertes Endliche Die Vorteile liegen in den Anwendungsszenarien auf der Hand.

Preisgestaltung für den DeepSeek R1

Im Vergleich zu OpenAI o3-mini, DeepSeek R1 in Bezug auf die Token-Kosten statistisch signifikant Tiefer:

- Ca. 0,14 $ pro Million Input-Token (Cache-Treffer), mit einem leichten Preisanstieg, wenn der Cache nicht getroffen wird.

- Ungefähr 2,19 $ pro Million ausgegebener Token.

Vergleich der technischen Architektur

Architektonischer Entwurf von AI-Modellen direkt seine Leistung, Kosten und betriebliche Effizienz beeinflusst. Die folgende Tabelle gut Die wichtigsten Architekturmerkmale von OpenAI o3-mini werden mit DeepSeek R1 verglichen.

Vergleich von Architektur und Preisen

| diagnostische Eigenschaft | OpenAI o3-mini | DeepSeek R1 |

|---|---|---|

| Architektur Typ | Dichter Transformator | Experten-Mischung (MoE) |

| Parameter pro Token | Vollständig intensive Verarbeitung (alle Parameter aktiv) | Teilweise aktiviert (z. B. nur 2 von 16 Experten aktiviert) |

| Kontextfenster | Bis zu 200K Token (abhängig vom jeweiligen Anwendungsfall) | Typischer Wert ist 128K Token |

| Transparenz | Proprietär (geschlossene Quelle) | Offener Quellcode; Code und Schulungsdetails öffentlich verfügbar |

| Eingabe Token Kosten | ~$1,10 pro Million Token | ~$0,14 (zwischengespeicherte Treffer)/etwas höher bei Fehlversuchen |

| Ausgabe Token Kosten | ~$4,40 pro Million Token | ~$2,19 pro Million Token |

| Anwendungsfall | Kodierung, logisches Denken, STEM-Problemlösung | Effiziente Argumentation, kostengünstige Aufgaben |

Benchmarks zur Leistung in der realen Welt

um objektiv Die Forscher bewerteten die Leistung der beiden Modelle in der realen Welt anhand einer Reihe typischer Aufgaben wie Codierung, logisches Denken und MINT-Problemlösung umfassend Prüfung. Im Folgenden finden Sie eine Zusammenfassung und Analyse der wichtigsten Leistungsindikatoren.

Codieraufgabe

In den vergleichenden Übersichten in diesem Abschnitt haben die Forscher den OpenAI o3-mini mit dem DeepSeek R1-Modell gleichzeitig mit dem Einstellungen Die gleiche Kodierungsaufgabe wurde mit dem Ziel durchgeführt, den Leistungsunterschied zwischen den beiden Modellen in Bezug auf die Codegenerierung zu untersuchen. Die Bewertung konzentriert sich auf die zeitaufwändige Codegenerierung und die Genauigkeit des Codes.

- OpenAI o3-mini.

- Die Codegenerierung ist extrem schnell (z. B. dauert eine JavaScript-Animationsaufgabe nur etwa 27 Sekunden).

- Der erzeugte Code ist gut strukturiert, gut organisiert und entspricht genau den Anforderungen der Aufgabe.

- DeepSeek R1.

- Die Codegenerierung dauert relativ lange (etwa 1 Minute 45 Sekunden für die gleiche JavaScript-Animationsaufgabe).

- DeepSeek R1 ist zwar in der Lage, ausführliche Code-Erklärungen zu liefern, aber die Antworten, die es generiert, enthalten manchmal zusätzliche Details oder Funktionen, die nicht explizit vom Benutzer angefordert wurden und die in einigen Szenarien redundant erscheinen können. Anmerkungen: DeepSeek R1 ist bei Codierungsaufgaben langsam und kann redundante Informationen produzieren, was darauf hindeutet, dass es für die Codegenerierung nicht so praktisch ist wie o3-mini.

logische Schlussfolgerung

- OpenAI o3-mini.

- in der Lage sein, einen schrittweisen Argumentationsprozess und eine wirksame Validierung der von ihnen gezogenen Schlussfolgerungen darzulegen.

- Die Antworten sind von hoher Qualität und die Erklärungen sind kurz und bündig.

- DeepSeek R1.

- Präsentation eines detaillierten und dialogorientierten "sichtbaren Gedankenganges".

- Während DeepSeek R1 bei der Genauigkeit des logischen Denkens gut abschneidet OK aber seine ausführliche Erklärung führen zu Längere Reaktionszeit. Kommentar: "Detaillierte und dialogorientierte Sichtbarkeit der Gedankenkette" kann auf Kosten der Geschwindigkeit gehen, und ihr Wert muss gegen spezifische Anwendungsszenarien abgewogen werden.

STEM Problemlösung

- OpenAI o3-mini.

- Lösen Sie MINT-Aufgaben in sehr kurzer Zeit (z. B. dauerte die Berechnung einer RLC-Schaltung nur 11 Sekunden).

- Demonstration klarer und strukturierter Schritte für Berechnungen und, falls erforderlich deutlich Rundung.

- DeepSeek R1.

- Die Bearbeitung ähnlicher STEM-Aufgaben kann Folgendes erfordern länger Zeit, bis zu 80 Sekunden.

- DeepSeek R1 ist ebenfalls in der Lage, eine ausführliche Erklärung zu liefern, aber diese Detaillierungsgrad wird auf Kosten der Rechengeschwindigkeit erreicht. KOMMENTAR: Der DeepSeek R1 bleibt beim Lösen von MINT-Problemen deutlich hinter dem o3-mini zurück, was ein weiterer Beweis für seine mangelnde Leistungsfähigkeit ist.

Zusammenfassung des Leistungsvergleichs in Echtzeit

| Art der Mission | OpenAI o3-mini | DeepSeek R1 |

|---|---|---|

| Kodierung Reaktionszeit | Weniger als 1 Minute | 1 Minute oder so |

| logische Schlussfolgerung | Schnell, übersichtlich, Schritt für Schritt (bis zu ca. 90 Sekunden) | Detaillierte, aber relativ langsame, dialogorientierte Erklärungen |

| STEM Problemlösung | 11 Sekunden, einfache Schritte | 80 Sekunden für eine ausführliche Erklärung |

| Genauigkeit | Sehr genau; die Antworten waren ein weiteres Mal Inspektion und Validierung | Genau, enthält aber manchmal diskret Punkt |

| Sichtbarkeit der Gedankenkette | Ausblenden (nur die endgültigen Antworten werden präsentiert) | sichtbar; zeigen jeden Schritt des Argumentationsprozesses |

Analyse des Arbeitsmechanismus der Gedankenkette

Gedankenketten-Tipps Technologie zulässig Die Modellierung nimmt komplexe Probleme zersetzen als Eine Reihe von kleineren, überschaubaren Schritten. Wenn das Modell in o3-mini ein komplexes Problem erhält, generiert es intern eine Reihe von Argumentationsschritten (auch wenn diese für den Endbenutzer unsichtbar sind) und gibt schließlich die eventuell Antworten. Dieser Mechanismus hilft, präzisere und genauere Antworten auf komplexe Abfragen zu erhalten mit aufwendig Antwort.

Anwendungsfälle und Anwendungsszenarien

Sowohl die OpenAI o3-mini als auch die DeepSeek R1 Modelle erfüllen können (Bedingungen oder Anforderungen) Weit verbreitet in verschiedene Arten des Einsatzszenarios Fähigkeiten . Typische Anwendungsfälle für jedes dieser Systeme sind unten aufgeführt:

Anwendungsfälle für OpenAI o3-mini

- Kodierung und Softwareentwicklung.

- Erzeugen Sie schnell syntaxkonforme Codeschnipsel.

- Nahtlose Integration in IDEs und verschiedene Programmierhilfen zur Verbesserung der Entwicklungseffizienz.

- MINT-Problemlösung.

- Lösen Sie mathematische Rätsel und physikalische Berechnungen effizient.

- Bereitstellung komplexer Abfragen im wissenschaftlichen Bereich inkrementell Erläuterung.

- Aufgaben zum logischen Denken.

- Verwenden Sie klare und prägnante Schritte, um schwierige und logische Probleme effektiv zu lösen.

- Unternehmensanwendungen.

- Unterstützung großer Unternehmen bei der Automatisierung der Datenextraktion und -analyse.

- Sicherheitsüberprüfung.

- Erkennen Sie schnell potenzielle Schwachstellen in Ihrem Code und geben Sie gezielte Empfehlungen zu deren Behebung.

Anwendungsfälle für DeepSeek R1

- Open-Source-Projekt.

- Eine hervorragende Lösung für Entwickler, die anpassbare Open-Source-Lösungen bevorzugen.

- Detaillierte Argumentation Prozessvisualisierung.

- Die "chain of thought"-Visualisierungsfunktion von DeepSeek R1 ist in Anwendungsszenarien von Vorteil, in denen die Transparenz des Denkprozesses erforderlich ist, wie z.B. bei der Fehlersuche oder in der Ausbildung.

- Kostenempfindliche Umgebungen.

- Anwendbar auf Token-Kosten Äußerst empfindlich Anwendungsszenarien und mit einer gewissen Toleranz für Antwortlatenz.

- Groß angelegte Datenverarbeitung.

- Geeignet für Projekte, bei denen eine große Anzahl von Abfragen bearbeitet werden muss, bei denen aber die Kosten für eine einzelne Anfrage streng kontrolliert werden müssen.

- Forschung und Experimentieren.

- Ideal für die akademische Forschung oder experimentelle Projekte, die eine umfassende Anpassung der Modelle erfordern Terrasse.

Beschränkungen und Herausforderungen

OpenAI o3-mini und DeepSeek R1 haben zwar in einer Reihe von Bereichen hervorragende Leistungen gezeigt, aber beide haben auch ihre Grenzen.

Beschränkungen von OpenAI o3-mini

- Höhere Kosten pro Token.

- Der o3-mini hat zwar eine Geschwindigkeit Besitz Vorteil, aber die höheren Kosten pro Token auf lange Sicht Es kann zu hohen Durchsatz Die Anwendung bringt hervorstechend wirtschaftliche Belastung.

- Proprietäre Architektur.

- Da es sich bei o3-mini um einen geschlossenen Quellcode handelt, ist die Flexibilität für Entwickler, die ihre Modelle ändern oder verfeinern möchten, durch die großartig Einschränkung.

- Ressourcenintensiv.

- Die dichte Transformer-Architektur bedeutet, dass o3-mini bei der Verarbeitung jedes Tokens mehr Rechenressourcen verbraucht.

Beschränkungen von DeepSeek R1

- Relativ langsame Reaktionszeit: - Die Reaktionszeit des

- Zeit, die DeepSeek R1 benötigt, um Antworten in mehreren Benchmarks zu generieren länger Dies kann in Anwendungsszenarien mit hohen Echtzeitanforderungen ein Problem darstellen. Unerwünschte Faktoren.

- Potenzial für "Chain-of-Thought"-Sichtbarkeit Ineffizienz :

- Während die Transparenz des Argumentationsprozesses in einigen Fällen von Vorteil sein kann, kann eine langwierige Visualisierung des Argumentationsprozesses die Gesamteffizienz verringern.

- Mögliche Nachteile des Open-Source-Modells.

- die eigenen finanziellen Ressourcen zu erweitern nicht immer Die stabile Zuverlässigkeit des Modells kann in vollem Umfang gewährleistet werden; besonderer Zweck Änderungen des Codes likelihood führen zu Leistungen unvereinbar .

- Kann übermäßige aufwendig Erläuterung.

- Während ausführliche Erklärungen in viele Fälle Sie ist wertvoll, aber manchmal enthalten die von DeepSeek R1 gelieferten Erklärungen Für die endgültige Antwort in Bezug auf (vorangehende Phrase) diskret Informationen. Anmerkungen: Im Vergleich zum o3-mini scheint der DeepSeek R1 mehr Einschränkungen aufzuweisen, insbesondere in Bezug auf Leistung und Reaktionsfähigkeit, was seine Wettbewerbsfähigkeit auf dem Markt weiter beeinträchtigen könnte.

zu einem Urteil gelangen

Befürwortung dieser direkt Der Vergleich der Bewertungen zeigt deutlich die einzigartigen Stärken von OpenAI o3-mini und DeepSeek R1. openAI o3-mini ist aufgrund seiner überlegenen Geschwindigkeit, Genauigkeit und erhöhten Sicherheit die beliebteste Wahl für Zeit und Zuverlässigkeit. Schweregrad der geforderten Einsatzszenarien bei den kaiserlichen Prüfungen den ersten Platz belegen DeepSeek R1 ist eine kosteneffektive, transparente Open-Source-Lösung für Open-Source-Technologie-Enthusiasten und Projekte mit begrenzten Budgets. Attraktive Alternativen . Kommentar: Die Schlussfolgerung des Artikels mag absichtlich ausgewogen zwischen den beiden Modellen sein, aber der Gesamtüberblick scheint zu implizieren, dass OpenAI o3-mini einen größeren Vorteil hat und dass die "Kosteneffizienz" von DeepSeek R1 sein Hauptvorteil sein könnte. Sexappeal. Endgültige Modellauswahl weitgehend abhängen von Spezial Anwendungsszenario definitiv Anforderungen. Wenn Ihr Bewerbungsszenario Prioritäten setzen überdenken Für schnelle, qualitativ hochwertige Antworten auf Codierungs-, Logik- oder MINT-Probleme, und wenn Ihr Budget höhere Token-Kosten zulässt, ist OpenAI o3-mini die beste Wahl. Kommentar: Die Empfehlung "Wenn es das Budget zulässt, sollten Sie sich für den o3-mini entscheiden" impliziert, dass der Hauptvorteil des DeepSeek R1 allein im Preis liegt, was bei KI-Anwendungen, bei denen eine überragende Leistung gefragt ist, von Bedeutung sein kann. unvorteilhaft.

Was sind die wichtigsten architektonischen Unterschiede zwischen o3-mini und DeepSeek R1?

OpenAI o3-mini verwendet ein dichtes Transformer-Modell, das jedes Token mit einem vollständigen Satz von Parametern verarbeitet, verglichen mit DeepSeek R1, das eine Mixture-of-Experts-Architektur verwendet, die nur einige der Parameter pro Token aktiviert. Dies macht o3-mini in Bezug auf die Leistung effizienter. stabilisieren. und schneller, während R1 kostengünstiger ist.

Welches Modell ist schneller für Aufgaben wie Codierung und MINT-Problemlösung?

Benchmarking-Daten zeigen, dass o3-mini in Bezug auf die Reaktionsfähigkeit beständig Bei einer Codierungsaufgabe erzeugt o3-mini beispielsweise Code in etwa 27 Sekunden, verglichen mit 1 Minute 45 Sekunden bei DeepSeek R1, und bei einer MINT-Aufgabe beträgt die Antwortzeit von o3-mini nur 11 Sekunden, verglichen mit 80 Sekunden bei DeepSeek R1.

Worin besteht der wesentliche Unterschied zwischen den Token-Kosten dieser beiden Modelle?

Die Kosten für OpenAI o3-mini liegen bei etwa 1,10 $ pro Million Input-Token und 4,40 $ pro Million Output-Token, während die Kosten für DeepSeek R1 bei etwa 4,40 $ pro Million Output-Token liegen. statistisch signifikant Das sind etwa 0,14 $ pro Million Input-Token (im Falle von Cache-Treffern) und 2,19 $ pro Million Output-Token, was DeepSeek R1 in Bezug auf die Token-Kosten wettbewerbsfähiger macht.

Ist DeepSeek R1 ein Open-Source-Modell?

Ja, DeepSeek R1 ist ein vollständig quelloffenes Modell, dessen Quellcode für Entwickler frei zugänglich ist und verändert werden kann. Diese Transparenz hat viele Menschen angezogen Unterstützer des Open-Source-Konzepts Entwickler, kann aber auch potenzielle Leistungskonsistenz und Sicherheitskontrollen in Bezug auf Ungenauigkeit .

Welches Modell schneidet in Bezug auf Sicherheit und Übereinstimmung mit menschlichen Werten besser ab?

Im Vergleich zu DeepSeek R1 (unsichere Antwortrate von ca. 11.981 TP3T) hat OpenAI o3-mini eine niedrigere unsichere Antwortrate (ca. 1.191 TP3T). o3-mini's Inferenzprozess geschlossen Dadurch verringert sich das Risiko, dass unsichere Zwischenschritte aufgedeckt werden, was o3-mini einen Vorteil in Anwendungsszenarien verschafft, in denen die Sicherheit wichtiger ist.

Für welche typischen Anwendungsfälle ist o3-mini besser geeignet?

Der o3-mini eignet sich hervorragend für Anwendungsszenarien, bei denen es auf Geschwindigkeit und Genauigkeit ankommt, wie z. B. schnelle, präzise codierte Ausgaben, logische Schlussfolgerungen in Echtzeit und STEM-Problemlösungen. Er eignet sich besonders gut für Unternehmensanwendungen und interaktive Anwendungsumgebungen, in denen Geschwindigkeit und Sicherheit entscheidend sind.

Was sind die wichtigsten Einschränkungen von DeepSeek R1?

DeepSeek R1 Obwohl kostengünstig und transparent in Bezug auf Besitz Die Funktion "sichtbare Gedankenkette" kann die allgemeine Reaktionszeit verlängern, und die allgemeine Reaktionszeit ist relativ langsam, insbesondere bei anspruchsvollen Echtzeitaufgaben. Die Funktion "sichtbare Gedankenkette" kann die Reaktionszeit insgesamt verlängern, und die unter bestimmten Umständen Die Antworten können umfassen in Bezug auf zugewandt sein (uns) Mandate diskret Ausführliche Informationen.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...