DeepSeek veröffentlicht die erste quelloffene Version seines v3-Modells, das jetzt die stärkste Codefähigkeit aufweist (in China)

DeepSeek-V3 ist ein leistungsstarkes Mixture-of-Experts (MoE) Sprachmodell mit 671 Milliarden Gesamtparametern und 3,7 Milliarden Parametern, die für jedes Token aktiviert werden. Das Modell verwendet eine innovative MLA-Architektur (Multi-head Latent Attention) zusammen mit der bewährten DeepSeekMoE-Architektur.CogAgent implementiert eine Lastausgleichsstrategie ohne zusätzliche Verluste und schlägt ein Trainingsziel für die Vorhersage mehrerer Token vor, um die Modellleistung erheblich zu verbessern. Es ist auf 14,8 Millionen verschiedenen und qualitativ hochwertigen Token vortrainiert und durchläuft überwachte Feinabstimmungs- und Verstärkungslernphasen, um sein volles Potenzial auszuschöpfen.

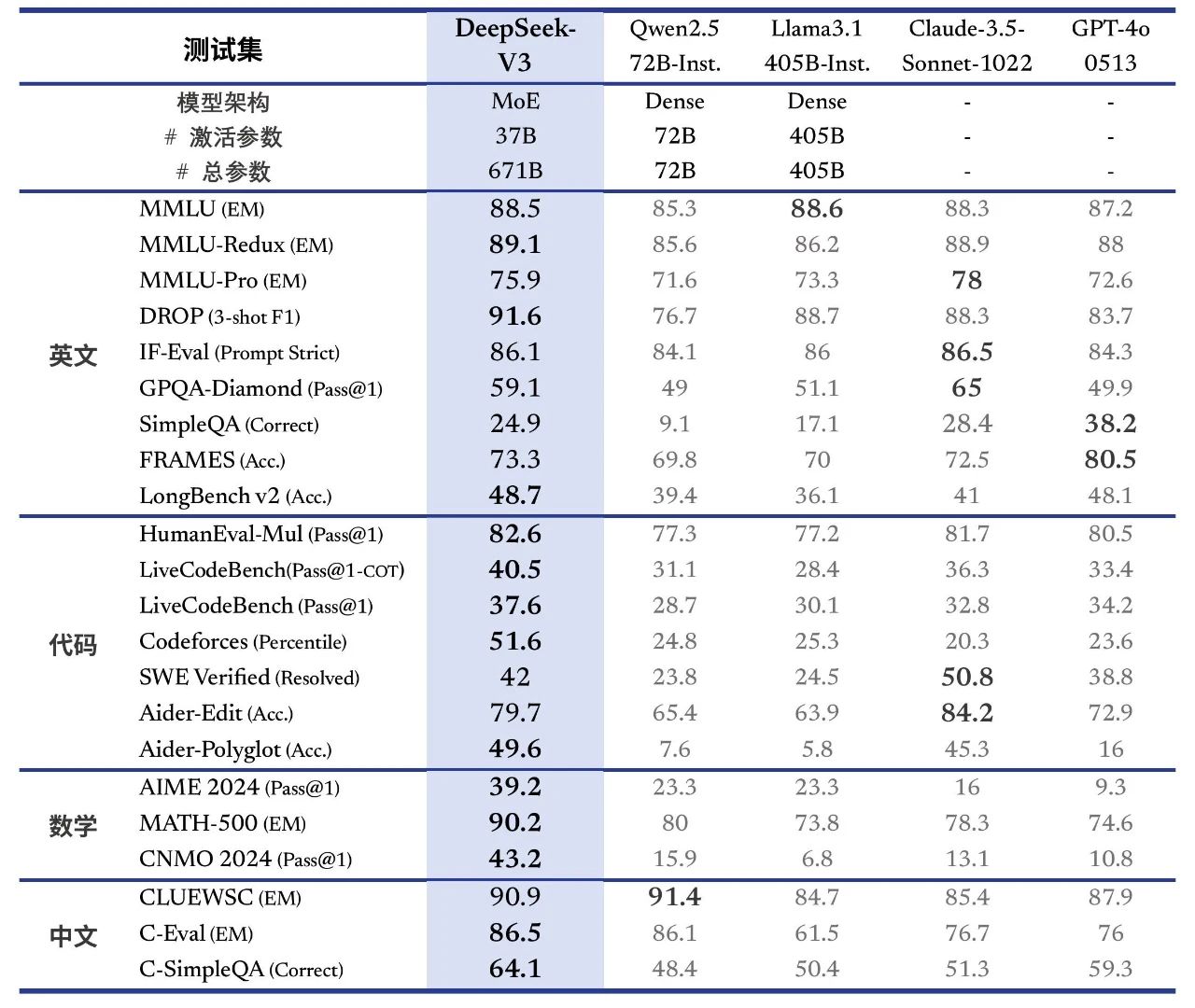

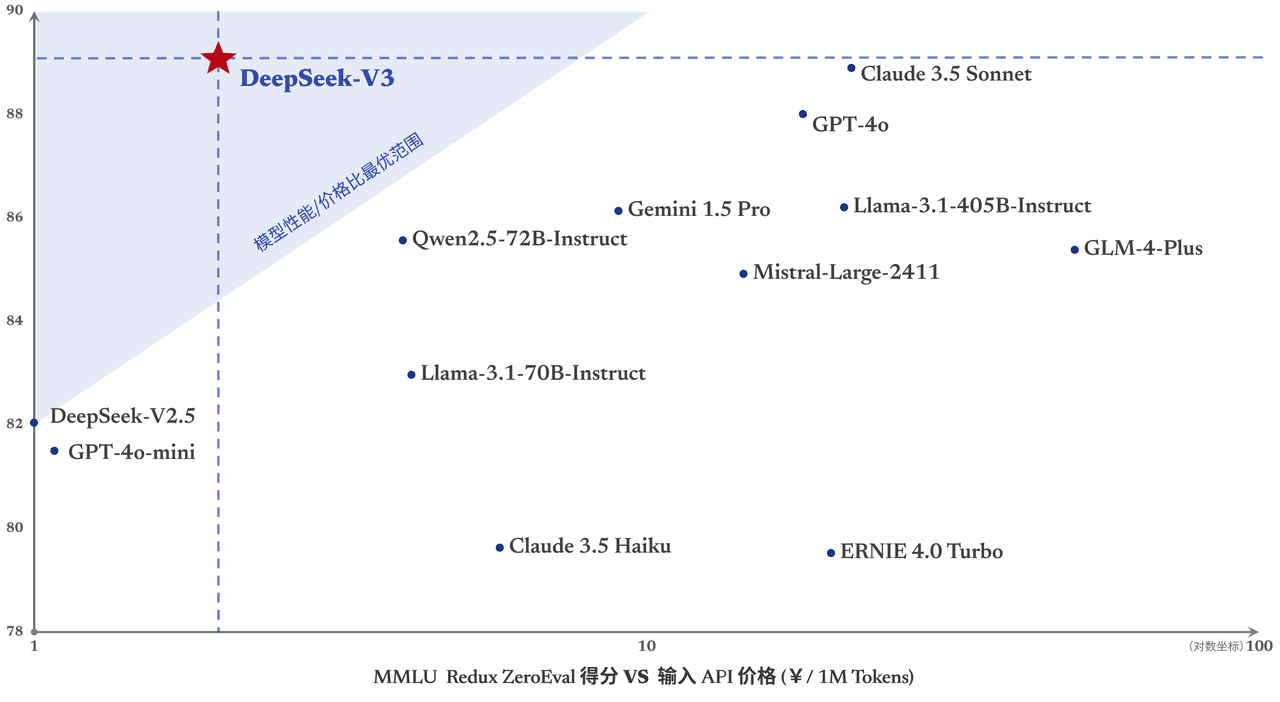

DeepSeek-V3 schneidet in vielen Standard-Benchmarks gut ab, insbesondere bei Mathematik- und Code-Aufgaben. Damit ist es das stärkste derzeit verfügbare Open-Source-Basismodell mit niedrigen Trainingskosten, und seine Stabilität während des Trainings ist hoch anerkannt.

Gestern wurde die erste Version der neuen Modellserie von DeepSeek, DeepSeek-V3, veröffentlicht und gleichzeitig als Open Source zur Verfügung gestellt. Besuchen Sie chat.deepseek.com, um mit der neuesten Version des V3-Modells zu sprechen. Der API-Dienst wurde aktualisiert, so dass die Konfiguration der Schnittstelle nicht geändert werden muss. Die aktuelle Version von DeepSeek-V3 unterstützt keine multimodale Eingabe und Ausgabe.

Leistungsanpassung in Übersee Leader Closed Source Modelle

DeepSeek-V3 ist ein selbst entwickeltes MoE-Modell mit 671B Parametern und 37B Aktivierungen bei 14,8T Token Die Vorschulung wurde auf dem

Link zum Papier:

https://github.com/deepseek-ai/DeepSeek-V3/blob/main/DeepSeek_V3.pdf

DeepSeek-V3 übertrifft in mehreren Tests andere Open-Source-Modelle wie Qwen2.5-72B und Llama-3.1-405B und erreicht die Leistung der weltweit besten Closed-Source-Modelle GPT-4o und Claude-3.5-Sonnet.

- enzyklopädisches WissenDeepSeek-V3: Das Niveau von DeepSeek-V3 bei wissensbasierten Aufgaben (MMLU, MMLU-Pro, GPQA, SimpleQA) ist im Vergleich zu seinem Vorgänger, DeepSeek-V2.5, deutlich verbessert und liegt nahe am derzeit besten Modell, Claude-3.5-Sonnet-1022.

- LangtextDeepSeek-V3 übertrifft im Durchschnitt die anderen Modelle bei DROP, FRAMES und LongBench v2 bei Langtextmessungen.

- Kodierung::DeepSeek-V3 ist allen auf dem Markt erhältlichen Nicht-O1-Modellen in Bezug auf die algorithmische Code-Kraft weit voraus.; und nähert sich Claude-3.5-Sonnet-1022 im Szenario der Ingenieursklasse Code an (SWE-Bench Verified).

- MatheDeepSeek-V3 hat bei der American Mathematics Competition (AIME 2024, MATH) und der National High School Mathematics League (CNMO 2024) alle quelloffenen Closed-Source-Modelle weit übertroffen.

- Chinesische SprachkenntnisseDeepSeek-V3 zeigt ähnliche Leistungen wie Qwen2.5-72B in den Bewertungsbereichen C-Eval und Pronomen-Disambiguierung im Bereich Bildung, ist aber bei C-SimpleQA im Bereich Faktenwissen fortgeschrittener.

Bis zu 3x schnellere Generierung

Durch algorithmische und technische Innovationen erhöht DeepSeek-V3 die Geschwindigkeit der Worterzeugung drastisch von 20 TPS auf 60 TPS, eine dreifache Steigerung im Vergleich zum Modell V2.5, was den Benutzern ein schnelleres und reibungsloseres Erlebnis bietet.

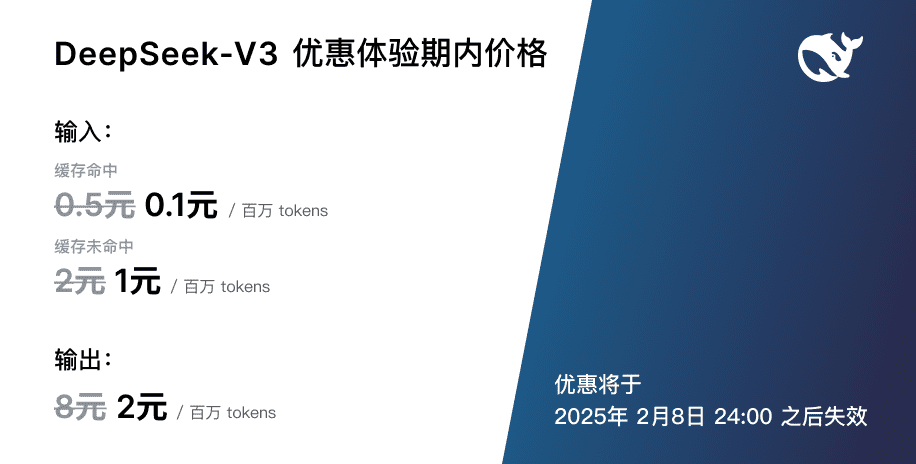

API Service Preisanpassung

Mit der Einführung des leistungsfähigeren und schnelleren DeepSeek-V3-Updates werden auch die Preise für unseren Modell-API-Dienst angepasst.0,5 pro Million Eingabe-Token (Cache-Treffer) / $2 (Cache-Fehlversuche), $8 pro Million Ausgabe-TokenZiel ist es, kontinuierlich bessere Modellierungsdienste für alle anbieten zu können.  Gleichzeitig haben wir uns entschlossen, dem neuen Modell eine 45-tägige Preispause zu gewähren: Von jetzt an bis zum 8. Februar 2025 bleibt der Preis für den API-Service von DeepSeek-V3 der bekannte0,1 pro Million Eingabe-Token (Cache-Treffer) / $1 (Cache-Fehlversuche), $2 pro Million Ausgabe-TokenDie oben genannten ermäßigten Preise gelten sowohl für bestehende Nutzer als auch für neue Nutzer, die sich während dieses Zeitraums anmelden.

Gleichzeitig haben wir uns entschlossen, dem neuen Modell eine 45-tägige Preispause zu gewähren: Von jetzt an bis zum 8. Februar 2025 bleibt der Preis für den API-Service von DeepSeek-V3 der bekannte0,1 pro Million Eingabe-Token (Cache-Treffer) / $1 (Cache-Fehlversuche), $2 pro Million Ausgabe-TokenDie oben genannten ermäßigten Preise gelten sowohl für bestehende Nutzer als auch für neue Nutzer, die sich während dieses Zeitraums anmelden.

Open-Source-Gewichte und lokaler Einsatz

DeepSeek-V3 verwendet FP8-Training und Open-Source native FP8-Gewichte. Dank der Unterstützung der Open-Source-Gemeinschaft unterstützen SGLang und LMDeploy zum ersten Mal die native FP8-Inferenz des V3-Modells, während TensorRT-LLM und MindIE die BF16-Inferenz implementieren. Darüber hinaus stellen wir Konvertierungsskripte von FP8 zu BF16 zur Verfügung, um der Community die Anpassung und Erweiterung der Anwendungsszenarien zu erleichtern.

Der Download von Modellgewichten und weitere Informationen zum Einsatz vor Ort finden Sie unter:

https://huggingface.co/deepseek-ai/DeepSeek-V3-Base

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Verwandte Beiträge

Keine Kommentare...